A kezdőknek szóló videokártyákról szóló útmutatónk első részében a legfontosabb összetevőket néztük meg: interfészek, kimenetek, hűtőrendszer, GPU és videomemória. A második részben a videokártyák funkcióiról és technológiáiról lesz szó.

A videokártya alapvető összetevői:

- kijáratok;

- interfészek;

- hűtőrendszer;

- GPU;

- videó memória.

2. rész (ez a cikk): grafikai technológiák:

- szótár;

- GPU architektúra: jellemzők

csúcs/pixel egységek, shaderek, kitöltési arány, textúra/raszter egységek, csővezetékek; - GPU architektúra: technológia

műszaki folyamat, GPU frekvencia, helyi videomemória (hangerő, busz, típus, frekvencia), megoldások több videokártyával; - vizuális funkciók

DirectX, nagy dinamikatartomány (HDR), teljes képernyős élsimítás, textúra szűrés, nagy felbontású textúrák.

Az alapvető grafikai kifejezések szószedete

Frissítési ráta

Csakúgy, mint a moziban vagy a TV-ben, számítógépe képkockák sorozatának megjelenítésével szimulálja a mozgást a monitoron. A monitor frissítési gyakorisága jelzi, hogy másodpercenként hányszor frissül a kép a képernyőn. Például a 75 Hz-es frekvencia másodpercenként 75 frissítésnek felel meg.

Ha a számítógép gyorsabban dolgozza fel a képkockákat, mint amennyit a monitor ki tud adni, akkor problémák léphetnek fel a játékokban. Például, ha a számítógép másodpercenként 100 képkockát renderel, és a monitor frissítési gyakorisága 75 Hz, akkor az átfedések miatt a monitor csak a kép egy részét tudja megjeleníteni a frissítési periódusa alatt. Ennek eredményeként vizuális műtermékek jelennek meg.

Megoldásként engedélyezheti a V-Sync (vertikális szinkron) funkciót. Korlátozza a számítógép által kiadható képkockák számát a monitor frissítési frekvenciájára, megakadályozva ezzel a műtermékeket. Ha engedélyezi a V-Sync-et, a játékban kiszámított képkockák száma soha nem haladja meg a frissítési gyakoriságot. Ez azt jelenti, hogy 75 Hz-en a számítógép legfeljebb 75 képkockát ad ki másodpercenként.

![]()

A „Pixel” szó jelentése „ kép túra el ement" egy képelem. Ez egy apró pont a kijelzőn, amely egy bizonyos színben világíthat (a legtöbb esetben az árnyalatot három alapszín kombinációja jeleníti meg: piros, zöld és kék). Ha a képernyő felbontása 1024x768, akkor egy 1024 pixel szélességű és 768 pixel magas mátrixot láthat. Az összes pixel együtt alkotja a képet. A képernyőn megjelenő kép másodpercenként 60-ról 120-ra frissül, a kijelző típusától és a videokártya adatkimenetét A katódsugárcsöves monitorok soronként frissítik a megjelenítést, a lapos LCD monitorok pedig minden pixelt külön-külön.

A 3D-s jelenetben lévő összes objektum csúcsokból áll. A csúcs egy pont a háromdimenziós térben, amelynek koordinátái X, Y és Z. Egy sokszögbe több csúcs is csoportosítható: legtöbbször háromszög, de bonyolultabb alakzatok is elképzelhetők. Ezután egy textúra kerül a sokszögre, amely valósághűvé teszi az objektumot. A fenti ábrán látható 3D kocka nyolc csúcsból áll. Az összetettebb objektumok ívelt felülettel rendelkeznek, amelyek valójában nagyon sok csúcsból állnak.

A textúra egyszerűen egy tetszőleges méretű 2D kép, amely egy 3D objektumra van leképezve, hogy szimulálja annak felületét. Például a 3D kockánk nyolc csúcsból áll. A textúra alkalmazása előtt úgy néz ki, mint egy egyszerű doboz. De amikor alkalmazzuk a textúrát, a doboz színes lesz.

A Pixel shader programok lehetővé teszik, hogy a videokártya lenyűgöző hatásokat produkáljon, például, mint például ez a víz Elder Scrolls: Feledés.

Ma kétféle shader létezik: vertex és pixel. A Vertex shader programok módosíthatják vagy átalakíthatják a 3D objektumokat. A Pixel shader programok lehetővé teszik a pixelek színének megváltoztatását bizonyos adatok alapján. Képzeljen el egy fényforrást egy 3D-s jelenetben, amely a megvilágított tárgyakat fényesebben világítja meg, ugyanakkor árnyékot vet más tárgyakra. Mindez a pixelek színinformációinak megváltoztatásával érhető el.

A pixel shaderekkel összetett effektusokat hozhat létre kedvenc játékaiban. Például a shader kód fényesebbé teheti a 3D-s kardot körülvevő pixeleket. Egy másik shader képes feldolgozni egy összetett 3D objektum összes csúcsát, és szimulálni egy robbanást. A játékfejlesztők egyre gyakrabban fordulnak a kifinomult shader programokhoz, hogy valósághű grafikát készítsenek. Szinte minden modern, gazdag grafikával rendelkező játék árnyékolókat használ.

A következő alkalmazásprogramozási felület (API), a Microsoft DirectX 10 megjelenésével egy harmadik típusú shader is megjelenik, az úgynevezett geometriai árnyékolók. Segítségükkel a kívánt eredménytől függően lehetőség nyílik tárgyak törésére, módosítására és akár megsemmisítésére is. A harmadik típusú shader pontosan ugyanúgy programozható, mint az első kettő, de a szerepe más lesz.

Teljesítési arány

Nagyon gyakran a videokártyás dobozon található a kitöltési érték. Alapvetően a kitöltési arány azt jelzi, hogy a GPU milyen gyorsan képes kiadni a képpontokat. A régebbi videokártyák háromszög kitöltési arányúak voltak. Ma azonban kétféle kitöltési arány létezik: a pixelkitöltési arány és a textúrakitöltési arány. Mint már említettük, a pixelkitöltési arány megfelel a pixelkimeneti aránynak. Kiszámítása a raszteres műveletek számának (ROP) és az órajel frekvenciájának szorzata.

A textúra kitöltési arányát az ATi és az nVidia eltérően számítja ki. Az Nvidia úgy véli, hogy a sebességet úgy kapjuk meg, hogy a pixel csővezetékek számát megszorozzuk az órajel frekvenciájával. Az ATi pedig megszorozza a textúra egységek számát az órajellel. Elvileg mindkét módszer helyes, mivel az nVidia pixel shader egységenként egy textúra egységet használ (azaz egy pixel pipeline-onként).

Ezeket a meghatározásokat szem előtt tartva haladjunk tovább, és beszéljük meg a GPU legfontosabb funkcióit, mit csinálnak és miért olyan fontosak.

GPU architektúra: Jellemzők

A 3D grafika valósághűsége nagyban függ a videokártya teljesítményétől. Minél több pixel shader blokkot tartalmaz a processzor, és minél magasabb a frekvencia, annál több effektus alkalmazható a 3D-s jelenetre a vizuális érzékelés javítása érdekében.

A GPU számos különböző funkcionális blokkot tartalmaz. Egyes összetevők száma alapján megbecsülheti a GPU teljesítményét. Mielőtt továbblépnénk, tekintsük át a legfontosabb funkcionális blokkokat.

Vertex processzorok (vertex shader egységek)

A pixel shader egységekhez hasonlóan a vertex processzorok is olyan shader kódot hajtanak végre, amely érinti a csúcsokat. Mivel a nagyobb csúcsköltségvetés bonyolultabb 3D objektumok létrehozását teszi lehetővé, a csúcsprocesszorok teljesítménye nagyon fontos az összetett vagy nagy számú objektumot tartalmazó 3D jeleneteknél. A vertex shader egységek azonban még mindig nem gyakorolnak olyan nyilvánvaló hatást a teljesítményre, mint a pixel processzorok.

Pixel processzorok (pixel shader egységek)

A pixelprocesszor egy grafikus chip egyik összetevője, amely a pixel shader programok feldolgozására szolgál. Ezek a processzorok olyan számításokat végeznek, amelyek csak a pixelekre vonatkoznak. Mivel a pixelek színinformációkat tartalmaznak, a pixel shaderekkel lenyűgöző grafikai hatásokat érhet el. Például a játékokban látható vízeffektusok többsége pixel shaderekkel jön létre. Általában a pixelprocesszorok számát használják a videokártyák pixelteljesítményének összehasonlítására. Ha az egyik kártya nyolc, a másik 16 egységgel rendelkezik, akkor logikus az a feltételezés, hogy egy 16 egységgel rendelkező videokártya gyorsabban képes feldolgozni az összetett pixel shader programokat. Figyelembe kell venni az órajelet is, de ma a pixelprocesszorok számának megduplázása energiahatékonyabb, mint a grafikus chip frekvenciájának megduplázása.

Egységes árnyékolók

Az egységes árnyékolók még nem érkeztek meg a PC-világba, de a hamarosan megjelenő DirectX 10 szabvány is hasonló architektúrára épül. Vagyis a vertex, geometria és pixel programok kódszerkezete ugyanaz lesz, bár a shaderek teljesíteni fognak különféle munkák. Az új specifikáció az Xbox 360-on látható, ahol a GPU-t kifejezetten az ATi tervezte a Microsoft számára. Nagyon érdekes lesz látni, hogy az új DirectX 10 milyen lehetőségeket rejt magában.

Textúra-leképezési egységek (TMU)

A textúrákat ki kell választani és szűrni kell. Ezt a munkát textúra-leképező egységek végzik, amelyek a pixel- és vertex-shader egységekkel együtt működnek. A TMU feladata, hogy textúraműveleteket alkalmazzon a képpontokra. A GPU-ban lévő textúraegységek számát gyakran használják a videokártyák textúra-teljesítményének összehasonlítására. Ésszerű feltételezni, hogy egy több TMU-val rendelkező grafikus kártya jobb textúrateljesítményt biztosít.

Raszteres kezelőegységek (ROP)

A raszteres processzorok felelősek a pixeladatok memóriába írásáért. Ennek a műveletnek a sebessége a kitöltési sebesség. A 3D-s gyorsítók korai idejében a ROP és a kitöltési arány nagyon fontos jellemzői voltak a videokártyáknak. A ROP-munka ma is fontos, de a videokártya teljesítményét már nem korlátozzák ezek a blokkok, mint korábban. Ezért a ROP-ok teljesítményét (és számát) ritkán használják a videokártya sebességének értékelésére.

Szállítószalagok

A csővezetékek a videokártyák architektúrájának leírására szolgálnak, és nagyon világos képet adnak a GPU teljesítményéről.

A szállítószalag nem tekinthető szigorú szakkifejezésnek. A GPU különböző folyamatokat használ, amelyek különböző funkciókat látnak el. Történelmileg a pipeline egy pixel processzort jelentett, amely a textúra leképező egységéhez (TMU) csatlakozik. Például a Radeon 9700 videokártya nyolc pixeles processzort használ, amelyek mindegyike saját TMU-hoz csatlakozik, így a kártya nyolc csővezetékesnek tekinthető.

De a modern processzorokat nagyon nehéz leírni a csővezetékek számával. A korábbi kialakításokhoz képest az új processzorok moduláris, töredezett felépítést alkalmaznak. Ezen a területen újítónak tekinthető az ATi, amely az X1000-es videokártyákkal moduláris felépítésre váltott, ami belső optimalizálás révén tette lehetővé a teljesítménynövekedést. Egyes CPU blokkokat gyakrabban használnak, mint másokat, és a GPU teljesítményének javítása érdekében az ATi megpróbált kompromisszumot találni a szükséges blokkok száma és a kockaterület között (amit nem nagyon lehet növelni). Ebben az architektúrában a "pixel pipeline" kifejezés már értelmét vesztette, mivel a pixelprocesszorok már nincsenek csatlakoztatva saját TMU-jukhoz. Például az ATi Radeon X1600 GPU 12 pixel shader egységgel és csak négy TMU textúra leképező egységgel rendelkezik. Ezért nem lehet azt mondani, hogy ennek a processzornak az architektúrája 12 pixeles csővezetékkel rendelkezik, ahogy azt sem, hogy csak négy van belőlük. A hagyomány szerint azonban a pixelcsővezetékeket még mindig emlegetik.

A fenti feltételezéseket figyelembe véve a videokártyák összehasonlítására gyakran használják a GPU-ban lévő pixelvezetékek számát (az ATi X1x00 vonal kivételével). Például, ha 24 és 16 csővezetékes videokártyákat veszünk, akkor teljesen ésszerű feltételezni, hogy a 24 csővezetékes kártya gyorsabb lesz.

GPU architektúra: technológia

Folyamat technológia

Ez a kifejezés a chip egy elemének (tranzisztorának) méretére és a gyártási folyamat pontosságára vonatkozik. A technikai folyamatok fejlesztése lehetővé teszi kisebb méretű elemek előállítását. Például a 0,18 mikronos eljárás nagyobb tulajdonságokat produkál, mint a 0,13 mikronos eljárás, tehát nem olyan hatékony. A kisebb tranzisztorok alacsonyabb feszültségen működnek. A feszültség csökkenése viszont a hőellenállás csökkenéséhez vezet, ami a keletkező hőmennyiség csökkenését eredményezi. A technikai folyamat fejlesztése lehetővé teszi a chip funkcionális blokkjai közötti távolság csökkentését, és az adatátvitel kevesebb időt vesz igénybe. A rövidebb távolságok, az alacsonyabb feszültségek és egyéb fejlesztések magasabb órajel elérését teszik lehetővé.

A megértést némileg bonyolítja, hogy manapság mikrométereket (μm) és nanométereket (nm) egyaránt használnak egy technikai folyamat megjelölésére. Valójában minden nagyon egyszerű: 1 nanométer egyenlő 0,001 mikrométerrel, tehát a 0,09 μm-es és a 90 nm-es folyamat ugyanaz. Amint fentebb megjegyeztük, a kisebb folyamattechnológia nagyobb órajelet tesz lehetővé. Például, ha összehasonlítjuk a 0,18 mikronos és a 0,09 mikronos (90 nm-es) chipekkel rendelkező videokártyákat, akkor egy 90 nm-es kártyától teljesen ésszerű magasabb frekvenciát várni.

GPU órajel

A GPU órajelét megahertzben (MHz) mérik, ami több millió órajel másodpercenként.

Az órajel közvetlenül befolyásolja a GPU teljesítményét. Minél magasabb, annál több munka másodperc alatt elvégezhető. Vegyük az első példát nVidia videokártyák GeForce 6600 és 6600 GT: A 6600 GT GPU 500 MHz-en, míg a normál 6600-as kártya 400 MHz-en működik. Mivel a processzorok műszakilag azonosak, a 6600 GT 20%-os órajelnövekedése nagyobb teljesítményt eredményez.

De az órajel nem minden. Ne feledje, hogy a teljesítményt nagyban befolyásolja az építészet. A második példaként vegyük a GeForce 6600 GT és GeForce 6800 GT videokártyákat. A 6600 GT GPU órajele 500 MHz, de a 6800 GT mindössze 350 MHz-en. Most vegyük figyelembe, hogy a 6800 GT 16 pixeles csővezetéket használ, míg a 6600 GT csak nyolcat. Ezért egy 6800 GT 16 csővezetékkel 350 MHz-en megközelítőleg ugyanolyan teljesítményt nyújt, mint egy nyolc pipeline processzor és dupla órajel (700 MHz). Ezzel együtt az órajel könnyen használható a teljesítmény összehasonlítására.

Helyi videomemória

A videokártya memóriája nagyban befolyásolja a teljesítményt. De a különböző memóriaparaméterek eltérő hatást fejtenek ki.

Videó memória mérete

A videomemória mennyisége valószínűleg a videokártya leginkább túlbecsült paraméterének nevezhető. A tapasztalatlan fogyasztók gyakran használják a videomemória kapacitását a különböző kártyák összehasonlítására, de a valóságban a kapacitásnak csekély hatása van a teljesítményre olyan paraméterekhez képest, mint a memóriabusz-frekvencia és az interfész (buszszélesség).

A legtöbb esetben egy 128 MB videomemóriával rendelkező kártya majdnem ugyanolyan teljesítményt nyújt, mint a 256 MB-os kártya. Természetesen vannak olyan helyzetek, amikor a több memória javítja a teljesítményt, de ne feledje, hogy a több memória nem vezet automatikusan gyorsabb játéksebességhez.

A hangerő hasznos lehet a nagy felbontású textúrájú játékokban. A játékfejlesztők több textúrakészletet biztosítanak a játékhoz. És minél több memória van a videokártyán, annál nagyobb felbontásúak lehetnek a betöltött textúrák. A nagy felbontású textúrák nagyobb tisztaságot és részletességet biztosítanak a játékban. Ezért teljesen ésszerű nagy mennyiségű memóriával rendelkező kártyát venni, ha minden más kritérium megfelel. Emlékeztetünk még egyszer, hogy a memóriabusz szélessége és frekvenciája sokkal erősebb hatással van a teljesítményre, mint a hangerő. fizikai memória a térképen.

Memóriabusz szélesség

A memóriabusz szélessége a memória teljesítményének egyik legfontosabb szempontja. A modern buszok szélessége 64-256 bit, sőt esetenként 512 bit is lehet. Minél szélesebb a memóriabusz, annál több információt tud átvinni órajelenként. És ez közvetlenül befolyásolja a termelékenységet. Például, ha két azonos frekvenciájú buszt veszünk, akkor elméletileg egy 128 bites busz kétszer annyi adatot továbbít órajelenként, mint egy 64 bites busz. A 256 bites busz pedig kétszer akkora.

A nagyobb buszsávszélesség (bitben vagy bájtban másodpercenként, 1 bájt = 8 bit) nagyobb memóriateljesítményt biztosít. Éppen ezért a memóriabusz sokkal fontosabb, mint a mérete. Egyenlő frekvenciákon a 64 bites memóriabusz a 256 bitesnek csak 25%-ával működik!

Vegyük a következő példát. A 128 MB videomemóriával rendelkező, de 256 bites busszal rendelkező videokártya sokkal nagyobb memóriateljesítményt ad, mint egy 512 MB-os modell 64 bites busszal. Fontos megjegyezni, hogy az ATi X1x00 vonal egyes kártyáinál a gyártók feltüntetik a belső memóriabusz specifikációit, de minket a külső busz paraméterei érdekelnek. Például az X1600-nak van egy belső gyűrűs busza, amely 256 bit széles, a külső pedig csak 128 bit széles. És a valóságban a memóriabusz 128 bites teljesítménnyel működik.

Memória típusok

A memória két fő kategóriába sorolható: SDR (egyszeri adatátvitel) és DDR (kettős adatátvitel), amelyekben órajelenként kétszer gyorsabb adatátvitel történik. Ma az egyátviteli SDR technológia elavult. Mivel a DDR memória kétszer olyan gyorsan továbbítja az adatokat, mint az SDR, fontos megjegyezni, hogy a DDR memóriával rendelkező videokártyák leggyakrabban dupla frekvenciát jeleznek, nem a fizikait. Például, ha a DDR memória 1000 MHz-en van megadva, akkor ez az a effektív frekvencia, amelyen a normál SDR memóriának működnie kell, hogy ugyanazt adja. áteresztőképesség. De valójában a fizikai frekvencia 500 MHz.

Emiatt sokan meglepődnek, amikor videokártyájuk memóriájában 1200 MHz-es DDR-frekvencia van feltüntetve, a közművek pedig 600 MHz-et jeleznek. Szóval meg kell szokni. A DDR2 és GDDR3/GDDR4 memória ugyanazon az elven működik, vagyis kettős adatátvitellel. A DDR, DDR2, GDDR3 és GDDR4 memória közötti különbség a gyártástechnológiában és néhány részletben rejlik. A DDR2 magasabb frekvencián tud működni, mint a DDR memória, a DDR3 pedig még magasabb frekvencián, mint a DDR2.

Memóriabusz frekvencia

A processzorhoz hasonlóan a memória (pontosabban a memóriabusz) meghatározott órajelen működik, megahertzben mérve. Itt az órajelek növelése közvetlenül befolyásolja a memória teljesítményét. A memóriabusz frekvenciája pedig az egyik paraméter, amelyet a videokártyák teljesítményének összehasonlítására használnak. Például, ha az összes többi jellemző (memóriabusz szélessége stb.) megegyezik, akkor teljesen logikus azt mondani, hogy egy 700 MHz-es memóriával rendelkező videokártya gyorsabb, mint az 500 MHz-es.

Ismétlem, az órajel nem minden. A 700 MHz-es memória 64 bites busszal lassabb lesz, mint a 400 MHz-es memória 128 bites busszal. A 400 MHz-es memória teljesítménye 128 bites buszon megközelítőleg megegyezik a 64 bites buszon lévő 800 MHz-es memória teljesítményével. Ne feledje azt is, hogy a GPU és a memória frekvenciája teljesen különböző paraméterek, és általában különböznek egymástól.

Videokártya interfész

A videokártya és a processzor között átvitt összes adat áthalad a videokártya interfészén. Ma háromféle interfészt használnak a videokártyákhoz: PCI, AGP és PCI Express. Sávszélességben és egyéb jellemzőikben különböznek egymástól. Nyilvánvaló, hogy minél nagyobb az áteresztőképesség, annál nagyobb az adatcsere sebessége. Nagy sávszélességet azonban csak a legmodernebb kártyák tudnak használni, és akkor is csak részben. Valamikor az interfész sebessége megszűnt szűk keresztmetszetnek lenni, ma már egyszerűen elegendő.

A leglassabb busz, amelyre videokártyákat gyártottak, a PCI (Peripheral Components Interconnect). A történelembe való belemenés nélkül persze. A PCI nagyon lerontotta a videokártyák teljesítményét, ezért áttértek az AGP (Accelerated Graphics Port) interfészre. De még az AGP 1.0 és 2x specifikációi is korlátozták a teljesítményt. Amikor a szabvány az AGP 4-szeresére növelte a sebességet, elkezdtük megközelíteni a videokártyák által kezelhető sávszélesség gyakorlati határát. Az AGP 8x specifikációja ismét megduplázta az átviteli sebességet az AGP 4x-hez képest (2,16 GB/s), de a grafikus teljesítményben már nem kaptunk észrevehető növekedést.

A legújabb és leggyorsabb busz a PCI Express. Új grafikus kártyákÁltalában a PCI Express x16 interfészt használják, amely 16 PCI Express sávot egyesít, így 4 GB/s teljes átviteli sebességet biztosít (egy irányban). Ez kétszerese az AGP 8x átviteli sebességének. A PCI Express busz mindkét irányban biztosítja az említett sávszélességet (adatátvitel a videokártyára és a videokártyáról). De az AGP 8x szabvány sebessége már elegendő volt, így még nem találkoztunk olyan helyzettel, hogy a PCI Expressre váltás teljesítménynövekedést adna az AGP 8x-hoz képest (ha a többi hardver paraméter megegyezik). Például a GeForce 6800 Ultra AGP változata ugyanúgy fog működni, mint a 6800 Ultra for PCI Express.

Ma a legjobb, ha PCI Express interfésszel rendelkező kártyát vásárolunk, ez még néhány évig a piacon marad. A legerősebb kártyákat már nem az AGP 8x interfésszel gyártják, és a PCI Express megoldások általában könnyebben megtalálhatók, mint az AGP analógok, és olcsóbbak.

Megoldások több videokártyán

Több videokártya használata a grafikus teljesítmény növelésére nem új ötlet. A 3D grafika korai időszakában a 3dfx két párhuzamosan futó grafikus kártyával lépett a piacra. De a 3dfx technológia eltűnésével közös munka számos fogyasztói videokártya a feledés homályába merült, bár az ATI a Radeon 9700 megjelenése óta gyártott hasonló rendszereket professzionális szimulátorokhoz. Néhány évvel ezelőtt a technológia visszatért a piacra: a megoldások megjelenésével nVidia SLIés kicsit később, ATi Crossfire .

Megosztás több videokártya elegendő teljesítményt biztosít a játék kiváló minőségi beállítások melletti futtatásához nagy felbontású. De egyik vagy másik megoldás kiválasztása nem olyan egyszerű.

Kezdjük azzal, hogy a több videokártyára épülő megoldások megkövetelik nagyszámú energiát, tehát a tápegységnek elég erősnek kell lennie. Mindezt a hőt el kell távolítani a videokártyáról, ezért figyelni kell a PC házára és a hűtésére, hogy a rendszer ne melegedjen túl.

Ne feledje továbbá, hogy az SLI/CrossFire megköveteli a megfelelőt alaplap(akár egyik, akár másik technológia esetében), ami általában többe kerül a standard modellekhez képest. Az nVidia SLI konfiguráció csak bizonyos nForce4 kártyákon, az ATi CrossFire kártyák pedig csak CrossFire lapkakészlettel rendelkező alaplapokon vagy bizonyos Intel modelleken működnek. A helyzet bonyolítása érdekében néhány CrossFire konfiguráció megköveteli, hogy az egyik kártya különleges legyen: CrossFire Edition. A CrossFire megjelenése után egyes modellekhez ATI videokártyák lehetővé tette az együttműködési technológiát a PCI Express buszon keresztül, és az új illesztőprogram-verziók megjelenésével a lehetséges kombinációk száma nő. Ennek ellenére a hardveres CrossFire a megfelelő CrossFire Edition kártyával nagyobb teljesítményt biztosít. De a CrossFire Edition kártyák drágábbak is, mint a hagyományos modellek. Tovább Ebben a pillanatban A szoftveres CrossFire módot (CrossFire Edition kártya nélkül) engedélyezheti a Radeon X1300, X1600 és X1800 GTO grafikus kártyákon.

Más tényezőket is figyelembe kell venni. Bár két együtt működő grafikus kártya teljesítménynövekedést biztosít, ez közel sem duplája. De kétszer annyi pénzt fog fizetni. Leggyakrabban a termelékenység növekedése 20-60%. Egyes esetekben pedig az egyeztetés további számítási költségei miatt egyáltalán nincs növekedés. Emiatt a többkártyás konfigurációk valószínűleg nem érik meg az olcsóbb modelleket, mivel a drágább grafikus kártya általában mindig felülmúl néhány olcsóbb kártyát. Általánosságban elmondható, hogy a legtöbb fogyasztó számára nincs értelme az SLI/CrossFire megoldás vásárlásának. De ha szeretné engedélyezni az összes minőségjavítási lehetőséget, vagy extrém felbontáson, például 2560x1600-on szeretne játszani, amikor képkockánként több mint 4 millió pixelt kell számolnia, akkor nem nélkülözheti két vagy négy párosított videokártyát.

Vizuális jellemzők

A tisztán hardveres specifikációk mellett a GPU-k különböző generációi és modelljei a funkciókészletben is eltérhetnek. Például gyakran mondják, hogy az ATi Radeon X800 XT generációs kártyák kompatibilisek a Shader Model 2.0b-vel (SM), míg az nVidia GeForce 6800 Ultra kompatibilis az SM 3.0-val, bár hardverspecifikációik közel állnak egymáshoz (16 pipeline). ). Ezért sok fogyasztó úgy dönt egyik vagy másik megoldás mellett, hogy nem is tudja, mi a különbség. Nos, beszéljünk a vizuális funkciókról és azok fontosságáról a végfelhasználó számára.

Ezeket a neveket leggyakrabban vitákban használják, de kevesen tudják, mit jelentenek valójában. A megértéshez kezdjük a grafikus API-k történetével. A DirectX és az OpenGL grafikus API-k, azaz Application Programming Interfaces – mindenki számára elérhető nyílt kódú szabványok.

A grafikus API-k megjelenése előtt minden GPU-gyártó saját mechanizmusát használta a játékokkal való kommunikációhoz. A fejlesztőknek külön kódot kellett írniuk minden egyes támogatni kívánt GPU-hoz. Nagyon költséges és nem hatékony módszer. A probléma megoldására a 3D grafikus API-kat fejlesztették ki, hogy a fejlesztők egy adott API-hoz írják a kódot, és ne egy adott videokártyához. Ezt követően a kompatibilitási problémák a videokártya-gyártók vállára kerültek, akiknek gondoskodniuk kellett arról, hogy a meghajtók kompatibilisek legyenek az API-val.

Az egyetlen nehézség továbbra is az, hogy ma két különböző API-t használnak, mégpedig a Microsoft DirectX-et és az OpenGL-t, ahol a GL a Graphics Library rövidítése. Mivel manapság a DirectX API népszerűbb a játékokban, erre fogunk összpontosítani. És ez a szabvány erősebb hatással volt a játékok fejlesztésére.

A DirectX az a Microsoft létrehozása. Valójában a DirectX számos API-t tartalmaz, amelyek közül csak egyet használnak 3D-s grafikákhoz. A DirectX API-kat tartalmaz a hanghoz, zenéhez, beviteli eszközökhöz stb. A Direct3D API felelős a DirectX 3D grafikájáért. Amikor videokártyákról beszélnek, ezt értik, tehát ebben a tekintetben a DirectX és a Direct3D fogalmak felcserélhetők.

A DirectX rendszeres időközönként frissül, ahogy a grafikai technológia fejlődik, és a játékfejlesztők új játékprogramozási technikákat vezetnek be. Ahogy a DirectX népszerűsége gyorsan nőtt, a GPU-gyártók új termékkiadásokat kezdtek szabni a DirectX képességekhez. Emiatt a videokártyákat gyakran hardveres támogatáshoz kötik a DirectX egyik vagy másik generációjához (DirectX 8, 9.0 vagy 9.0c).

A helyzetet bonyolítja, hogy a Direct3D API egyes részei idővel változhatnak a DirectX generációk megváltoztatása nélkül. A DirectX 9.0 specifikációja például a Pixel Shader 2.0 támogatását írja elő. De a DirectX 9.0c frissítés tartalmazza a Pixel Shader 3.0-t. Tehát bár a kártyák DirectX 9-osztályúak, különböző funkciókészleteket támogatnak. Például a Radeon 9700 támogatja a Shader Model 2.0-t, a Radeon X1800 pedig a Shader Model 3.0-t, bár mindkét kártya a DirectX 9 generációhoz sorolható.

Ne feledje, hogy új játékok létrehozásakor a fejlesztők figyelembe veszik a régi gépek és videokártyák tulajdonosait, mivel ha figyelmen kívül hagyja ezt a felhasználói szegmenst, az eladások szintje alacsonyabb lesz. Emiatt több kódút is be van építve a játékokba. Egy DirectX 9-es játéknak valószínűleg van DirectX 8 elérési útja, sőt DirectX 7 elérési útja is a kompatibilitás érdekében. Általában ha a régi elérési utat választja, akkor a játék egy része eltűnik virtuális effektusok, amelyek az új videokártyákon vannak. De legalább még régi hardveren is lehet játszani.

Sok új játékhoz a DirectX legújabb verzióját kell telepíteni, még akkor is, ha a videokártya előző generációs. Vagyis egy új játékhoz, amely a DirectX 8 útvonalat használja, továbbra is telepíteni kell a DirectX 9 legújabb verzióját a DirectX 8 osztályú videokártyához.

Mi a különbség a között különböző verziók Direct3D API a DirectX-ben? A DirectX korai verziói – 3, 5, 6 és 7 – viszonylag egyszerűek voltak a Direct3D API képességeit illetően. A fejlesztők kiválaszthatják a vizuális effektusokat egy listából, majd tesztelhetik, hogyan működnek a játékban. A grafikus programozás következő nagy lépése a DirectX 8 volt. Bevezette a videokártya shaderekkel történő programozásának lehetőségét, így a fejlesztők először szabadon programozhatták az effektusokat a kívánt módon. A Pixel Shader 1.0–1.3 és a Vertex Shader 1.0 DirectX 8 által támogatott verziói. DirectX 8.1, frissítve DirectX verzió 8, kapott Pixel Shader 1.4 és Vertex Shader 1.1.

A DirectX 9-ben még összetettebb shader programokat készíthet. A DirectX 9 támogatja a Pixel Shader 2.0-t és a Vertex Shader 2.0-t. A DirectX 9c, a DirectX 9 frissített verziója tartalmazza a Pixel Shader 3.0 specifikációt.

Az új verzióhoz a DirectX 10, egy hamarosan megjelenő API-kiadás érkezik Windows Vista. A DirectX 10 nem telepíthető Windows XP rendszeren.

A HDR a „High Dynamic Range” rövidítése. A HDR megvilágítású játék sokkal valósághűbb képet tud produkálni, mint egy játék nélkül, és nem minden videokártya támogatja a HDR világítást.

A DirectX 9 grafikus kártyák megjelenése előtt a GPU-kat erősen korlátozta világítási számításaik pontossága. A világítást eddig csak 256 (8 bites) belső szinttel lehetett kiszámítani.

Amikor megjelentek a DirectX 9 videokártyák, nagy pontosságú világítást tudtak előállítani – teljes 24 bitet vagy 16,7 millió szintet.

A 16,7 millió szinttel és a DirectX 9/Shader Model 2.0 videokártyák teljesítményének következő lépésével lehetővé vált a HDR világítás a számítógépeken. Ez egy meglehetősen összetett technológia, és dinamikusan kell figyelni. Egyszerűen fogalmazva, a HDR világítás növeli a kontrasztot (a sötét árnyalatok sötétebbnek, a világos árnyalatok világosabbnak tűnnek), miközben növeli a megvilágítás részleteit a sötét és világos területeken. A HDR megvilágítású játék élénkebbnek és valósághűbbnek tűnik, mint nélküle.

A legújabb Pixel Shader 3.0 specifikációval kompatibilis GPU-k nagyobb 32 bites pontosságú megvilágítási számításokat és lebegőpontos keverést tesznek lehetővé. Így az SM 3.0 osztályú videokártyák egy speciális OpenEXR HDR világítási módszert tudnak támogatni, amelyet kifejezetten a filmipar számára fejlesztettek ki.

Egyes játékok, amelyek csak az OpenEXR HDR világítást támogatják, nem futnak HDR világítással a Shader Model 2.0 grafikus kártyákon. Azonban azok a játékok, amelyek nem támaszkodnak az OpenEXR módszerre, bármelyik DirectX 9 grafikus kártyán futnak.Az Oblivion például az OpenEXR HDR módszert használja, és csak a Shader Model 3.0 specifikációt támogató legújabb grafikus kártyákon engedélyezi a HDR megvilágítást. Például nVidia GeForce 6800 vagy ATi Radeon X1800. A Half-Life 2 3D-s motorját használó játékok, köztük a Counter-Strike: Source és a hamarosan megjelenő Half-Life 2: Aftermath, lehetővé teszik a HDR-megjelenítés engedélyezését a régebbi DirectX 9 grafikus kártyákon, amelyek csak a Pixel Shader 2.0-t támogatják. Ilyen például a GeForce 5 vagy az ATi Radeon 9500 vonal.

Végül ne feledje, hogy a HDR-megjelenítés minden formája komoly feldolgozási teljesítményt igényel, és még a legerősebb GPU-kat is térdre kényszerítheti. Ha játszani akarsz legújabb játékok A HDR világítással nem nélkülözheti a nagy teljesítményű grafikát.

A teljes képernyős élsimítás (rövidítve AA) lehetővé teszi a sokszögek határain lévő jellegzetes „létrák” megszüntetését. De figyelembe kell venni, hogy a teljes képernyős élsimítás sok számítási erőforrást emészt fel, ami a képkockasebesség csökkenéséhez vezet.

Az élsimítás nagymértékben függ a videomemória teljesítményétől, így egy nagy sebességű, gyors memóriával rendelkező videokártya képes lesz a teljes képernyős élsimítást kiszámítani, kevésbé befolyásolva a teljesítményt, mint egy olcsó videokártya. Az élsimítás engedélyezhető különféle módok. Például a 4-szeres élsimítás jobb képet fog produkálni, mint a 2-szeres élsimítás, de nagy sikert arat a teljesítményben. Míg a 2x élsimítás megduplázza a vízszintes és függőleges felbontást, a 4x mód megnégyszerezi.

A textúrák a játékban lévő összes 3D objektumra vonatkoznak, és minél nagyobb a megjelenített felület szöge, annál torzabbnak tűnik a textúra. Ennek a hatásnak a kiküszöbölésére a GPU-k textúraszűrőt használnak.

Az első szűrési módszert bilineárisnak nevezték, és jellegzetes csíkokat produkált, amelyek nem voltak túl kellemesek a szemnek. A helyzet a trilineáris szűrés bevezetésével javult. Mindkét lehetőség modern videokártyákon működik, gyakorlatilag teljesítménybüntetés nélkül.

Ma a textúrák szűrésének legjobb módja az anizotróp szűrés (AF). A teljes képernyős élsimításhoz hasonlóan az anizotróp szűrés is különböző szinteken engedélyezhető. Például a 8x AF jobb szűrési minőséget biztosít, mint a 4x AF. A teljes képernyős élsimításhoz hasonlóan az anizotróp szűréshez is szükség van bizonyos feldolgozási teljesítményre, amely az AF-szint növekedésével nő.

Minden 3D-s játék speciális specifikációk figyelembevételével készült, és ezen követelmények egyike határozza meg, hogy a játéknak milyen textúra-memóriára lesz szüksége. Minden szükséges textúrának bele kell férnie a videokártya memóriájába játék közben, különben a teljesítmény jelentősen csökken, mivel a textúra elérése a RAM-hoz jelentős késést okoz, nem beszélve a merevlemezen lévő lapozófájlról. Ezért, ha egy játékfejlesztő 128 MB videomemóriával számol, mint a minimum követelmény, akkor az aktív textúrák halmaza soha nem haladhatja meg a 128 MB-ot.

A modern játékok több textúrakészlettel rendelkeznek, így a játék gond nélkül fut a régebbi, kevesebb videomemóriával rendelkező videokártyákon, valamint az új, több videomemóriával rendelkező kártyákon. Például egy játék három textúrakészletet tartalmazhat: 128 MB, 256 MB és 512 MB számára. Ma már nagyon kevés olyan játék létezik, amely 512 MB videomemóriát támogat, de még mindig ez a legobjektívebb indok, hogy ekkora memóriával videokártyát vásároljunk. Míg a memória növekedése alig vagy egyáltalán nem befolyásolja a teljesítményt, a jobb vizuális minőség hasznára válik, ha a játék támogatja a megfelelő textúrakészletet.

A videokártya alapvető összetevői:

- kijáratok;

- interfészek;

- hűtőrendszer;

- GPU;

- videó memória.

Grafikai technológiák:

- szótár;

- GPU architektúra: jellemzők

csúcs/pixel egységek, shaderek, kitöltési arány, textúra/raszter egységek, csővezetékek; - GPU architektúra: technológia

műszaki folyamat, GPU frekvencia, helyi videomemória (hangerő, busz, típus, frekvencia), megoldások több videokártyával; - vizuális funkciók

DirectX, nagy dinamikatartomány (HDR), teljes képernyős élsimítás, textúra szűrés, nagy felbontású textúrák.

Az alapvető grafikai kifejezések szószedete

Frissítési ráta

Csakúgy, mint a moziban vagy a TV-ben, számítógépe képkockák sorozatának megjelenítésével szimulálja a mozgást a monitoron. A monitor frissítési gyakorisága jelzi, hogy másodpercenként hányszor frissül a kép a képernyőn. Például a 75 Hz-es frekvencia másodpercenként 75 frissítésnek felel meg.

Ha a számítógép gyorsabban dolgozza fel a képkockákat, mint amennyit a monitor ki tud adni, akkor problémák léphetnek fel a játékokban. Például, ha a számítógép másodpercenként 100 képkockát renderel, és a monitor frissítési gyakorisága 75 Hz, akkor az átfedések miatt a monitor csak a kép egy részét tudja megjeleníteni a frissítési periódusa alatt. Ennek eredményeként vizuális műtermékek jelennek meg.

Megoldásként engedélyezheti a V-Sync (vertikális szinkron) funkciót. Korlátozza a számítógép által kiadható képkockák számát a monitor frissítési frekvenciájára, megakadályozva ezzel a műtermékeket. Ha engedélyezi a V-Sync-et, a játékban kiszámított képkockák száma soha nem haladja meg a frissítési gyakoriságot. Ez azt jelenti, hogy 75 Hz-en a számítógép legfeljebb 75 képkockát ad ki másodpercenként.

Pixel

A „Pixel” szó jelentése „ kép túra el ement" - képelem. Ez egy apró pont a kijelzőn, amely egy bizonyos színben világít (a legtöbb esetben az árnyalat három alapszín: piros, zöld és kék kombinációjával jelenik meg). Ha a képernyő felbontása 1024x768, akkor egy 1024 pixel szélességű és 768 pixel magas mátrixot láthat. Az összes pixel együtt alkotja a képet. A képernyőn megjelenő kép másodpercenként 60-ról 120-ra frissül, a kijelző típusától és a videokártya kimenetétől függően. A katódsugárcsöves monitorok soronként frissítik a megjelenítést, míg a lapos LCD-monitorok minden képpontot külön-külön frissíthetnek.

Csúcs

A 3D-s jelenetben lévő összes objektum csúcsokból áll. A csúcs egy pont a háromdimenziós térben, amelynek koordinátái X, Y és Z. Egy sokszögbe több csúcs is csoportosítható: legtöbbször háromszög, de bonyolultabb alakzatok is elképzelhetők. Ezután egy textúra kerül a sokszögre, amely valósághűvé teszi az objektumot. A fenti ábrán látható 3D kocka nyolc csúcsból áll. Az összetettebb objektumok ívelt felülettel rendelkeznek, amelyek valójában nagyon sok csúcsból állnak.

Struktúra

A textúra egyszerűen egy tetszőleges méretű 2D kép, amely egy 3D objektumra van leképezve, hogy szimulálja annak felületét. Például a 3D kockánk nyolc csúcsból áll. A textúra alkalmazása előtt úgy néz ki, mint egy egyszerű doboz. De amikor alkalmazzuk a textúrát, a doboz színes lesz.

Shader

A pixel shader programok lehetővé teszik, hogy a videokártya lenyűgöző hatásokat produkáljon, például, mint ez a víz az Elder Scrolls: Oblivionban.

Ma kétféle shader létezik: vertex és pixel. A Vertex shader programok módosíthatják vagy átalakíthatják a 3D objektumokat. A Pixel shader programok lehetővé teszik a pixelek színének megváltoztatását bizonyos adatok alapján. Képzeljen el egy fényforrást egy 3D-s jelenetben, amely a megvilágított tárgyakat fényesebben világítja meg, ugyanakkor árnyékot vet más tárgyakra. Mindez a pixelek színinformációinak megváltoztatásával érhető el.

A pixel shaderekkel összetett effektusokat hozhat létre kedvenc játékaiban. Például a shader kód fényesebbé teheti a 3D-s kardot körülvevő pixeleket. Egy másik shader képes feldolgozni egy összetett 3D objektum összes csúcsát, és szimulálni egy robbanást. A játékfejlesztők egyre gyakrabban fordulnak a kifinomult shader programokhoz, hogy valósághű grafikát készítsenek. Szinte minden modern, gazdag grafikával rendelkező játék árnyékolókat használ.

A következő alkalmazásprogramozási felület (API), a Microsoft DirectX 10 megjelenésével egy harmadik típusú shader is megjelenik, az úgynevezett geometriai árnyékolók. Segítségükkel a kívánt eredménytől függően lehetőség nyílik tárgyak törésére, módosítására és akár megsemmisítésére is. A harmadik típusú shader pontosan ugyanúgy programozható, mint az első kettő, de a szerepe más lesz.

Teljesítési arány

Nagyon gyakran a videokártyás dobozon található a kitöltési érték. Alapvetően a kitöltési arány azt jelzi, hogy a GPU milyen gyorsan képes kiadni a képpontokat. A régebbi videokártyák háromszög kitöltési arányúak voltak. Ma azonban kétféle kitöltési arány létezik: a pixelkitöltési arány és a textúrakitöltési arány. Mint már említettük, a pixelkitöltési arány megfelel a pixelkimeneti aránynak. Kiszámítása a raszteres műveletek számának (ROP) és az órajel frekvenciájának szorzata.

A textúra kitöltési arányát az ATi és az nVidia eltérően számítja ki. Az Nvidia úgy véli, hogy a sebességet úgy kapjuk meg, hogy a pixel csővezetékek számát megszorozzuk az órajel frekvenciájával. Az ATi pedig megszorozza a textúra egységek számát az órajellel. Elvileg mindkét módszer helyes, mivel az nVidia pixel shader egységenként egy textúra egységet használ (azaz egy pixel pipeline-onként).

Ezeket a meghatározásokat szem előtt tartva haladjunk tovább, és beszéljük meg a GPU legfontosabb funkcióit, mit csinálnak és miért olyan fontosak.

GPU architektúra: Jellemzők

A 3D grafika valósághűsége nagyban függ a videokártya teljesítményétől. Minél több pixel shader blokkot tartalmaz a processzor, és minél magasabb a frekvencia, annál több effektus alkalmazható a 3D-s jelenetre a vizuális érzékelés javítása érdekében.

A GPU számos különböző funkcionális blokkot tartalmaz. Egyes összetevők száma alapján megbecsülheti a GPU teljesítményét. Mielőtt továbblépnénk, tekintsük át a legfontosabb funkcionális blokkokat.

Vertex processzorok (vertex shader egységek)

A pixel shader egységekhez hasonlóan a vertex processzorok is olyan shader kódot hajtanak végre, amely érinti a csúcsokat. Mivel a nagyobb csúcsköltségvetés bonyolultabb 3D objektumok létrehozását teszi lehetővé, a csúcsprocesszorok teljesítménye nagyon fontos az összetett vagy nagy számú objektumot tartalmazó 3D jeleneteknél. A vertex shader egységek azonban még mindig nem gyakorolnak olyan nyilvánvaló hatást a teljesítményre, mint a pixel processzorok.

Pixel processzorok (pixel shader egységek)

A pixelprocesszor egy grafikus chip egyik összetevője, amely a pixel shader programok feldolgozására szolgál. Ezek a processzorok olyan számításokat végeznek, amelyek csak a pixelekre vonatkoznak. Mivel a pixelek színinformációkat tartalmaznak, a pixel shaderekkel lenyűgöző grafikai hatásokat érhet el. Például a játékokban látható vízeffektusok többsége pixel shaderekkel jön létre. Általában a pixelprocesszorok számát használják a videokártyák pixelteljesítményének összehasonlítására. Ha az egyik kártya nyolc, a másik 16 egységgel rendelkezik, akkor logikus az a feltételezés, hogy egy 16 egységgel rendelkező videokártya gyorsabban képes feldolgozni az összetett pixel shader programokat. Figyelembe kell venni az órajelet is, de ma a pixelprocesszorok számának megduplázása energiahatékonyabb, mint a grafikus chip frekvenciájának megduplázása.

Egységes árnyékolók

Az egységes árnyékolók még nem érkeztek meg a PC-világba, de a hamarosan megjelenő DirectX 10 szabvány is hasonló architektúrára épül. Vagyis a csúcs-, geometria- és pixelprogramok kódstruktúrája ugyanaz lesz, bár a shaderek más-más munkát végeznek. Az új specifikáció az Xbox 360-on látható, ahol a GPU-t kifejezetten az ATi tervezte a Microsoft számára. Nagyon érdekes lesz látni, hogy az új DirectX 10 milyen lehetőségeket rejt magában.

Textúra-leképezési egységek (TMU)

A textúrákat ki kell választani és szűrni kell. Ezt a munkát textúra-leképező egységek végzik, amelyek a pixel- és vertex-shader egységekkel együtt működnek. A TMU feladata, hogy textúraműveleteket alkalmazzon a képpontokra. A GPU-ban lévő textúraegységek számát gyakran használják a videokártyák textúra-teljesítményének összehasonlítására. Ésszerű feltételezni, hogy egy több TMU-val rendelkező grafikus kártya jobb textúrateljesítményt biztosít.

Raszteres kezelőegységek (ROP)

A raszteres processzorok felelősek a pixeladatok memóriába írásáért. Ennek a műveletnek a sebessége a kitöltési sebesség. A 3D-s gyorsítók korai idejében a ROP és a kitöltési arány nagyon fontos jellemzői voltak a videokártyáknak. A ROP-munka ma is fontos, de a videokártya teljesítményét már nem korlátozzák ezek a blokkok, mint korábban. Ezért a ROP-ok teljesítményét (és számát) ritkán használják a videokártya sebességének értékelésére.

Szállítószalagok

A csővezetékek a videokártyák architektúrájának leírására szolgálnak, és nagyon világos képet adnak a GPU teljesítményéről.

A szállítószalag nem tekinthető szigorú szakkifejezésnek. A GPU különböző folyamatokat használ, amelyek különböző funkciókat látnak el. Történelmileg a pipeline egy pixel processzort jelentett, amely a textúra leképező egységéhez (TMU) csatlakozik. Például a Radeon 9700 videokártya nyolc pixeles processzort használ, amelyek mindegyike saját TMU-hoz csatlakozik, így a kártya nyolc csővezetékesnek tekinthető.

De a modern processzorokat nagyon nehéz leírni a csővezetékek számával. A korábbi kialakításokhoz képest az új processzorok moduláris, töredezett felépítést alkalmaznak. Ezen a területen újítónak tekinthető az ATi, amely az X1000-es videokártyákkal moduláris felépítésre váltott, ami belső optimalizálás révén tette lehetővé a teljesítménynövekedést. Egyes CPU blokkokat gyakrabban használnak, mint másokat, és a GPU teljesítményének javítása érdekében az ATi megpróbált kompromisszumot találni a szükséges blokkok száma és a kockaterület között (amit nem nagyon lehet növelni). Ebben az architektúrában a „pixel pipeline” kifejezés már értelmét vesztette, mivel a pixelprocesszorok már nincsenek csatlakoztatva saját TMU-jukhoz. Például az ATi Radeon X1600 GPU 12 pixel shader egységgel és csak négy TMU textúra leképező egységgel rendelkezik. Ezért nem lehet azt mondani, hogy ennek a processzornak az architektúrája 12 pixeles csővezetékkel rendelkezik, ahogy azt sem, hogy csak négy van belőlük. A hagyomány szerint azonban a pixelcsővezetékeket még mindig emlegetik.

A fenti feltételezéseket figyelembe véve a videokártyák összehasonlítására gyakran használják a GPU-ban lévő pixelvezetékek számát (az ATi X1x00 vonal kivételével). Például, ha 24 és 16 csővezetékes videokártyákat veszünk, akkor teljesen ésszerű feltételezni, hogy a 24 csővezetékes kártya gyorsabb lesz.

GPU architektúra: technológia

Folyamat technológia

Ez a kifejezés a chip egy elemének (tranzisztorának) méretére és a gyártási folyamat pontosságára vonatkozik. A technikai folyamatok fejlesztése lehetővé teszi kisebb méretű elemek előállítását. Például a 0,18 mikronos eljárás nagyobb tulajdonságokat produkál, mint a 0,13 mikronos eljárás, tehát nem olyan hatékony. A kisebb tranzisztorok alacsonyabb feszültségen működnek. A feszültség csökkenése viszont a hőellenállás csökkenéséhez vezet, ami a keletkező hőmennyiség csökkenését eredményezi. A technikai folyamat fejlesztése lehetővé teszi a chip funkcionális blokkjai közötti távolság csökkentését, és az adatátvitel kevesebb időt vesz igénybe. A rövidebb távolságok, az alacsonyabb feszültségek és egyéb fejlesztések magasabb órajel elérését teszik lehetővé.

A megértést némileg bonyolítja, hogy manapság mikrométereket (μm) és nanométereket (nm) egyaránt használnak egy technikai folyamat megjelölésére. Valójában minden nagyon egyszerű: 1 nanométer egyenlő 0,001 mikrométerrel, tehát a 0,09 μm-es és a 90 nm-es folyamat ugyanaz. Amint fentebb megjegyeztük, a kisebb folyamattechnológia nagyobb órajelet tesz lehetővé. Például, ha összehasonlítjuk a 0,18 mikronos és a 0,09 mikronos (90 nm-es) chipekkel rendelkező videokártyákat, akkor egy 90 nm-es kártyától teljesen ésszerű magasabb frekvenciát várni.

GPU órajel

A GPU órajelét megahertzben (MHz) mérik, ami több millió órajel másodpercenként.

Az órajel közvetlenül befolyásolja a GPU teljesítményét. Minél magasabb, annál több munka végezhető el egy másodperc alatt. Első példának vegyük az nVidia GeForce 6600 és 6600 GT videokártyákat: a 6600 GT GPU 500 MHz-en, míg a normál 6600-as kártya 400 MHz-en működik. Mivel a processzorok műszakilag azonosak, a 6600 GT 20%-os órajelnövekedése nagyobb teljesítményt eredményez.

De az órajel nem minden. Ne feledje, hogy a teljesítményt nagyban befolyásolja az építészet. A második példaként vegyük a GeForce 6600 GT és GeForce 6800 GT videokártyákat. A 6600 GT GPU órajele 500 MHz, de a 6800 GT mindössze 350 MHz-en. Most vegyük figyelembe, hogy a 6800 GT 16 pixeles csővezetéket használ, míg a 6600 GT csak nyolcat. Ezért egy 6800 GT 16 csővezetékkel 350 MHz-en megközelítőleg ugyanolyan teljesítményt nyújt, mint egy nyolc pipeline processzor és dupla órajel (700 MHz). Ezzel együtt az órajel könnyen használható a teljesítmény összehasonlítására.

Helyi videomemória

A videokártya memóriája nagyban befolyásolja a teljesítményt. De a különböző memóriaparaméterek eltérő hatást fejtenek ki.

Videó memória mérete

A videomemória mennyisége valószínűleg a videokártya leginkább túlbecsült paraméterének nevezhető. A tapasztalatlan fogyasztók gyakran használják a videomemória kapacitását a különböző kártyák összehasonlítására, de a valóságban a kapacitásnak csekély hatása van a teljesítményre olyan paraméterekhez képest, mint a memóriabusz-frekvencia és az interfész (buszszélesség).

A legtöbb esetben egy 128 MB videomemóriával rendelkező kártya majdnem ugyanolyan teljesítményt nyújt, mint a 256 MB-os kártya. Természetesen vannak olyan helyzetek, amikor a több memória javítja a teljesítményt, de ne feledje, hogy a több memória nem vezet automatikusan gyorsabb játéksebességhez.

A hangerő hasznos lehet a nagy felbontású textúrájú játékokban. A játékfejlesztők több textúrakészletet biztosítanak a játékhoz. És minél több memória van a videokártyán, annál nagyobb felbontásúak lehetnek a betöltött textúrák. A nagy felbontású textúrák nagyobb tisztaságot és részletességet biztosítanak a játékban. Ezért teljesen ésszerű nagy mennyiségű memóriával rendelkező kártyát venni, ha minden más kritérium megfelel. Emlékeztetünk még egyszer, hogy a memóriabusz szélessége és frekvenciája sokkal erősebb hatással van a teljesítményre, mint a kártyán lévő fizikai memória mennyisége.

Memóriabusz szélesség

A memóriabusz szélessége a memória teljesítményének egyik legfontosabb szempontja. A modern buszok szélessége 64-256 bit, sőt esetenként 512 bit is lehet. Minél szélesebb a memóriabusz, annál több információt tud átvinni órajelenként. És ez közvetlenül befolyásolja a termelékenységet. Például, ha két azonos frekvenciájú buszt veszünk, akkor elméletileg egy 128 bites busz kétszer annyi adatot továbbít órajelenként, mint egy 64 bites busz. A 256 bites busz pedig kétszer akkora.

A nagyobb buszsávszélesség (bitben vagy bájtban másodpercenként, 1 bájt = 8 bit) nagyobb memóriateljesítményt biztosít. Éppen ezért a memóriabusz sokkal fontosabb, mint a mérete. Egyenlő frekvenciákon a 64 bites memóriabusz a 256 bitesnek csak 25%-ával működik!

Vegyük a következő példát. A 128 MB videomemóriával rendelkező, de 256 bites busszal rendelkező videokártya sokkal nagyobb memóriateljesítményt ad, mint egy 512 MB-os modell 64 bites busszal. Fontos megjegyezni, hogy az ATi X1x00 vonal egyes kártyáinál a gyártók feltüntetik a belső memóriabusz specifikációit, de minket a külső busz paraméterei érdekelnek. Például az X1600-nak van egy belső gyűrűs busza, amely 256 bit széles, a külső pedig csak 128 bit széles. És a valóságban a memóriabusz 128 bites teljesítménnyel működik.

Memória típusok

A memória két fő kategóriába sorolható: SDR (egyszeri adatátvitel) és DDR (kettős adatátvitel), amelyekben órajelenként kétszer gyorsabb adatátvitel történik. Ma az egyátviteli SDR technológia elavult. Mivel a DDR memória kétszer olyan gyorsan továbbítja az adatokat, mint az SDR, fontos megjegyezni, hogy a DDR memóriával rendelkező videokártyák leggyakrabban dupla frekvenciát jeleznek, nem a fizikait. Például, ha a DDR-memória 1000 MHz-en van megadva, akkor ez az a tényleges frekvencia, amelyen a normál SDR-memóriának működnie kell, hogy ugyanazt az átviteli sebességet adja. De valójában a fizikai frekvencia 500 MHz.

Emiatt sokan meglepődnek, amikor videokártyájuk memóriájában 1200 MHz-es DDR-frekvencia van feltüntetve, a közművek pedig 600 MHz-et jeleznek. Szóval meg kell szokni. A DDR2 és GDDR3/GDDR4 memória ugyanazon az elven működik, vagyis kettős adatátvitellel. A DDR, DDR2, GDDR3 és GDDR4 memória közötti különbség a gyártástechnológiában és néhány részletben rejlik. A DDR2 magasabb frekvencián tud működni, mint a DDR memória, a DDR3 pedig még magasabb frekvencián, mint a DDR2.

Memóriabusz frekvencia

A processzorhoz hasonlóan a memória (pontosabban a memóriabusz) meghatározott órajelen működik, megahertzben mérve. Itt az órajelek növelése közvetlenül befolyásolja a memória teljesítményét. A memóriabusz frekvenciája pedig az egyik paraméter, amelyet a videokártyák teljesítményének összehasonlítására használnak. Például, ha az összes többi jellemző (memóriabusz szélessége stb.) megegyezik, akkor teljesen logikus azt mondani, hogy egy 700 MHz-es memóriával rendelkező videokártya gyorsabb, mint az 500 MHz-es.

Ismétlem, az órajel nem minden. A 700 MHz-es memória 64 bites busszal lassabb lesz, mint a 400 MHz-es memória 128 bites busszal. A 400 MHz-es memória teljesítménye 128 bites buszon megközelítőleg megegyezik a 64 bites buszon lévő 800 MHz-es memória teljesítményével. Ne feledje azt is, hogy a GPU és a memória frekvenciája teljesen különböző paraméterek, és általában különböznek egymástól.

Videokártya interfész

A videokártya és a processzor között átvitt összes adat áthalad a videokártya interfészén. Ma háromféle interfészt használnak a videokártyákhoz: PCI, AGP és PCI Express. Sávszélességben és egyéb jellemzőikben különböznek egymástól. Nyilvánvaló, hogy minél nagyobb az áteresztőképesség, annál nagyobb az adatcsere sebessége. Nagy sávszélességet azonban csak a legmodernebb kártyák tudnak használni, és akkor is csak részben. Valamikor az interfész sebessége megszűnt szűk keresztmetszetnek lenni, ma már egyszerűen elegendő.

A leglassabb busz, amelyre videokártyákat gyártottak, a PCI (Peripheral Components Interconnect). A történelembe való belemenés nélkül persze. A PCI nagyon lerontotta a videokártyák teljesítményét, ezért áttértek az AGP (Accelerated Graphics Port) interfészre. De még az AGP 1.0 és 2x specifikációi is korlátozták a teljesítményt. Amikor a szabvány az AGP 4-szeresére növelte a sebességet, elkezdtük megközelíteni a videokártyák által kezelhető sávszélesség gyakorlati határát. Az AGP 8x specifikációja ismét megduplázta az átviteli sebességet az AGP 4x-hez képest (2,16 GB/s), de a grafikus teljesítményben már nem kaptunk észrevehető növekedést.

A legújabb és leggyorsabb busz a PCI Express. Az új grafikus kártyák jellemzően a PCI Express x16 interfészt használják, amely 16 PCI Express sávot kombinál 4 GB/s teljes átviteli sebességgel (egy irányban). Ez kétszerese az AGP 8x átviteli sebességének. A PCI Express busz mindkét irányban biztosítja az említett sávszélességet (adatátvitel a videokártyára és a videokártyáról). De az AGP 8x szabvány sebessége már elegendő volt, így még nem találkoztunk olyan helyzettel, hogy a PCI Expressre váltás teljesítménynövekedést adna az AGP 8x-hoz képest (ha a többi hardver paraméter megegyezik). Például a GeForce 6800 Ultra AGP változata ugyanúgy fog működni, mint a 6800 Ultra for PCI Express.

Ma a legjobb, ha PCI Express interfésszel rendelkező kártyát vásárolunk, ez még néhány évig a piacon marad. A legerősebb kártyákat már nem az AGP 8x interfésszel gyártják, és a PCI Express megoldások általában könnyebben megtalálhatók, mint az AGP analógok, és olcsóbbak.

Megoldások több videokártyán

Több videokártya használata a grafikus teljesítmény növelésére nem új ötlet. A 3D grafika korai időszakában a 3dfx két párhuzamosan futó grafikus kártyával lépett a piacra. A 3dfx eltűnésével azonban a feledés homályába merült a több fogyasztói videokártya együttes működtetésének technológiája, bár az ATi a Radeon 9700 megjelenése óta gyártott hasonló rendszereket professzionális szimulátorokhoz. Néhány évvel ezelőtt a technológia visszatért a piac: az nVidia SLI megoldások, majd valamivel később az ATi Crossfire megjelenésével.

Több grafikus kártya együttes használata elegendő teljesítményt biztosít ahhoz, hogy a játék kiváló minőségi beállítások mellett, nagy felbontásban is futhasson. De egyik vagy másik megoldás kiválasztása nem olyan egyszerű.

Kezdjük azzal, hogy a több videokártyára épülő megoldások nagy mennyiségű energiát igényelnek, tehát a tápnak kellően erősnek kell lennie. Mindezt a hőt el kell távolítani a videokártyáról, ezért figyelni kell a PC házára és a hűtésére, hogy a rendszer ne melegedjen túl.

Ne feledje továbbá, hogy az SLI/CrossFire megfelelő alaplapot igényel (akár egyik, akár másik technológiához), ami általában többe kerül, mint a szabványos modellek. Az nVidia SLI konfiguráció csak bizonyos nForce4 kártyákon, az ATi CrossFire kártyák pedig csak CrossFire lapkakészlettel rendelkező alaplapokon vagy bizonyos Intel modelleken működnek. A helyzet bonyolítása érdekében néhány CrossFire konfiguráció megköveteli, hogy az egyik kártya különleges legyen: CrossFire Edition. A CrossFire megjelenése után egyes videokártya-modelleknél az ATi lehetővé tette az együttműködési technológia beépítését a PCI Express buszon keresztül, az új illesztőprogram-verziók megjelenésével pedig megnő a lehetséges kombinációk száma. Ennek ellenére a hardveres CrossFire a megfelelő CrossFire Edition kártyával nagyobb teljesítményt biztosít. De a CrossFire Edition kártyák drágábbak is, mint a hagyományos modellek. Jelenleg a Radeon X1300, X1600 és X1800 GTO grafikus kártyákon engedélyezheti a szoftveres CrossFire módot (CrossFire Edition kártya nélkül).

Más tényezőket is figyelembe kell venni. Bár két együtt működő grafikus kártya teljesítménynövekedést biztosít, ez közel sem duplája. De kétszer annyi pénzt fog fizetni. Leggyakrabban a termelékenység növekedése 20-60%. Egyes esetekben pedig az egyeztetés további számítási költségei miatt egyáltalán nincs növekedés. Emiatt a többkártyás konfigurációk valószínűleg nem érik meg az olcsóbb modelleket, mivel a drágább grafikus kártya általában mindig felülmúl néhány olcsóbb kártyát. Általánosságban elmondható, hogy a legtöbb fogyasztó számára nincs értelme az SLI/CrossFire megoldás vásárlásának. De ha szeretné engedélyezni az összes minőségjavítási lehetőséget, vagy extrém felbontással játszani, például 2560x1600-as felbontással, amikor képkockánként több mint 4 millió pixelt kell számolnia, akkor nem nélkülözheti két vagy négy párosított videokártyát.

Vizuális jellemzők

A tisztán hardveres specifikációk mellett a GPU-k különböző generációi és modelljei a funkciókészletben is eltérhetnek. Például gyakran mondják, hogy az ATi Radeon X800 XT generációs kártyák kompatibilisek a Shader Model 2.0b-vel (SM), míg az nVidia GeForce 6800 Ultra kompatibilis az SM 3.0-val, bár hardverspecifikációik közel állnak egymáshoz (16 pipeline). ). Ezért sok fogyasztó úgy dönt egyik vagy másik megoldás mellett, hogy nem is tudja, mi a különbség.

Microsoft DirectX és Shader Model verziók

Ezeket a neveket leggyakrabban vitákban használják, de kevesen tudják, mit jelentenek valójában. A megértéshez kezdjük a grafikus API-k történetével. A DirectX és az OpenGL grafikus API-k, azaz Application Programming Interfaces – mindenki számára elérhető nyílt kódú szabványok.

A grafikus API-k megjelenése előtt minden GPU-gyártó saját mechanizmusát használta a játékokkal való kommunikációhoz. A fejlesztőknek külön kódot kellett írniuk minden egyes támogatni kívánt GPU-hoz. Nagyon költséges és nem hatékony módszer. A probléma megoldására a 3D grafikus API-kat fejlesztették ki, hogy a fejlesztők egy adott API-hoz írják a kódot, és ne egy adott videokártyához. Ezt követően a kompatibilitási problémák a videokártya-gyártók vállára kerültek, akiknek gondoskodniuk kellett arról, hogy a meghajtók kompatibilisek legyenek az API-val.

Az egyetlen nehézség továbbra is az, hogy ma két különböző API-t használnak, mégpedig a Microsoft DirectX-et és az OpenGL-t, ahol a GL a Graphics Library rövidítése. Mivel manapság a DirectX API népszerűbb a játékokban, erre fogunk összpontosítani. És ez a szabvány erősebb hatással volt a játékok fejlesztésére.

A DirectX egy Microsoft alkotás. Valójában a DirectX számos API-t tartalmaz, amelyek közül csak egyet használnak 3D-s grafikákhoz. A DirectX API-kat tartalmaz a hanghoz, zenéhez, beviteli eszközökhöz stb. A Direct3D API felelős a DirectX 3D grafikájáért. Amikor videokártyákról beszélnek, ezt értik, tehát ebben a tekintetben a DirectX és a Direct3D fogalmak felcserélhetők.

A DirectX rendszeres időközönként frissül, ahogy a grafikai technológia fejlődik, és a játékfejlesztők új játékprogramozási technikákat vezetnek be. Ahogy a DirectX népszerűsége gyorsan nőtt, a GPU-gyártók új termékkiadásokat kezdtek szabni a DirectX képességekhez. Emiatt a videokártyákat gyakran hardveres támogatáshoz kötik a DirectX egyik vagy másik generációjához (DirectX 8, 9.0 vagy 9.0c).

A helyzetet bonyolítja, hogy a Direct3D API egyes részei idővel változhatnak a DirectX generációk megváltoztatása nélkül. A DirectX 9.0 specifikációja például a Pixel Shader 2.0 támogatását írja elő. De a DirectX 9.0c frissítés tartalmazza a Pixel Shader 3.0-t. Tehát bár a kártyák DirectX 9-osztályúak, különböző funkciókészleteket támogatnak. Például a Radeon 9700 támogatja a Shader Model 2.0-t, a Radeon X1800 pedig a Shader Model 3.0-t, bár mindkét kártya a DirectX 9 generációhoz sorolható.

Ne feledje, hogy új játékok létrehozásakor a fejlesztők figyelembe veszik a régi gépek és videokártyák tulajdonosait, mivel ha figyelmen kívül hagyja ezt a felhasználói szegmenst, az eladások szintje alacsonyabb lesz. Emiatt több kódút is be van építve a játékokba. Egy DirectX 9 osztályú játéknak valószínűleg van DirectX 8 elérési útja, sőt DirectX 7 elérési útja is a kompatibilitás érdekében. Általában ha a régi elérési utat választjuk, akkor az új videokártyákon található virtuális effektusok egy része eltűnik a játékból. De legalább még régi hardveren is lehet játszani.

Sok új játékhoz a DirectX legújabb verzióját kell telepíteni, még akkor is, ha a videokártya előző generációs. Vagyis egy új játékhoz, amely a DirectX 8 útvonalat használja, továbbra is telepíteni kell a DirectX 9 legújabb verzióját a DirectX 8 osztályú videokártyához.

Mi a különbség a Direct3D API különböző verziói között a DirectX-ben? A DirectX korai verziói – 3, 5, 6 és 7 – viszonylag egyszerűek voltak a Direct3D API képességeit illetően. A fejlesztők kiválaszthatják a vizuális effektusokat egy listából, majd tesztelhetik, hogyan működnek a játékban. A grafikus programozás következő nagy lépése a DirectX 8 volt. Bevezette a videokártya shaderekkel történő programozásának lehetőségét, így a fejlesztők először szabadon programozhatták az effektusokat a kívánt módon. A Pixel Shader 1.0–1.3 és a Vertex Shader 1.0 DirectX 8 által támogatott verziói. A DirectX 8.1, a DirectX 8 frissített verziója megkapta a Pixel Shader 1.4-et és a Vertex Shader 1.1-et.

A DirectX 9-ben még összetettebb shader programokat készíthet. A DirectX 9 támogatja a Pixel Shader 2.0-t és a Vertex Shader 2.0-t. A DirectX 9c, a DirectX 9 frissített verziója tartalmazza a Pixel Shader 3.0 specifikációt.

A DirectX 10, a hamarosan megjelenő API-verzió az újat fogja kísérni Windows verzió Távlat. A DirectX 10 nem telepíthető Windows XP rendszeren.

HDR világítás és OpenEXR HDR

A HDR a „High Dynamic Range” rövidítése. A HDR megvilágítású játék sokkal valósághűbb képet tud produkálni, mint egy játék nélkül, és nem minden videokártya támogatja a HDR világítást.

A DirectX 9 grafikus kártyák megjelenése előtt a GPU-kat erősen korlátozta világítási számításaik pontossága. A világítást eddig csak 256 (8 bites) belső szinttel lehetett kiszámítani.

Amikor megjelentek a DirectX 9 videokártyák, nagy pontosságú világítást tudtak előállítani – teljes 24 bitet vagy 16,7 millió szintet.

A 16,7 millió szinttel és a DirectX 9/Shader Model 2.0 videokártyák teljesítményének következő lépésével lehetővé vált a HDR világítás a számítógépeken. Ez egy meglehetősen összetett technológia, és dinamikusan kell figyelni. Egyszerűen fogalmazva, a HDR világítás növeli a kontrasztot (a sötét árnyalatok sötétebbnek, a világos árnyalatok világosabbnak tűnnek), miközben növeli a megvilágítás részleteit a sötét és világos területeken. A HDR megvilágítású játék élénkebbnek és valósághűbbnek tűnik, mint nélküle.

A legújabb Pixel Shader 3.0 specifikációval kompatibilis GPU-k nagyobb 32 bites pontosságú megvilágítási számításokat és lebegőpontos keverést tesznek lehetővé. Így az SM 3.0 osztályú videokártyák egy speciális OpenEXR HDR világítási módszert tudnak támogatni, amelyet kifejezetten a filmipar számára fejlesztettek ki.

Egyes játékok, amelyek csak az OpenEXR HDR világítást támogatják, nem futnak HDR világítással a Shader Model 2.0 grafikus kártyákon. Azonban azok a játékok, amelyek nem támaszkodnak az OpenEXR módszerre, bármelyik DirectX 9 grafikus kártyán futnak.Az Oblivion például az OpenEXR HDR módszert használja, és csak a Shader Model 3.0 specifikációt támogató legújabb grafikus kártyákon engedélyezi a HDR megvilágítást. Például nVidia GeForce 6800 vagy ATi Radeon X1800. A Half-Life 2 3D-s motorját használó játékok, köztük a Counter-Strike: Source és a hamarosan megjelenő Half-Life 2: Aftermath, lehetővé teszik a HDR-megjelenítés engedélyezését a régebbi DirectX 9 grafikus kártyákon, amelyek csak a Pixel Shader 2.0-t támogatják. Ilyen például a GeForce 5 vagy az ATi Radeon 9500 vonal.

Végül ne feledje, hogy a HDR-megjelenítés minden formája komoly feldolgozási teljesítményt igényel, és még a legerősebb GPU-kat is térdre kényszerítheti. Ha a legújabb játékokkal szeretne játszani HDR világítással, a nagy teljesítményű grafika elengedhetetlen.

Teljes képernyős élsimítás

A teljes képernyős élsimítás (röviden AA) lehetővé teszi a sokszögek határain lévő jellegzetes „létrák” megszüntetését. De figyelembe kell venni, hogy a teljes képernyős élsimítás sok számítási erőforrást emészt fel, ami a képkockasebesség csökkenéséhez vezet.

Az élsimítás nagymértékben függ a videomemória teljesítményétől, így egy nagy sebességű, gyors memóriával rendelkező videokártya képes lesz a teljes képernyős élsimítást kiszámítani, kevésbé befolyásolva a teljesítményt, mint egy olcsó videokártya. Az élsimítás többféle módban engedélyezhető. Például a 4-szeres élsimítás jobb képet fog produkálni, mint a 2-szeres élsimítás, de nagy sikert arat a teljesítményben. Míg a 2x élsimítás megduplázza a vízszintes és függőleges felbontást, a 4x mód megnégyszerezi.

Textúraszűrés

A textúrák a játékban lévő összes 3D objektumra vonatkoznak, és minél nagyobb a megjelenített felület szöge, annál torzabbnak tűnik a textúra. Ennek a hatásnak a kiküszöbölésére a GPU-k textúraszűrőt használnak.

Az első szűrési módszert bilineárisnak nevezték, és jellegzetes csíkokat produkált, amelyek nem voltak túl kellemesek a szemnek. A helyzet a trilineáris szűrés bevezetésével javult. Mindkét lehetőség modern videokártyákon működik, gyakorlatilag teljesítménybüntetés nélkül.

Ma a textúrák szűrésének legjobb módja az anizotróp szűrés (AF). A teljes képernyős élsimításhoz hasonlóan az anizotróp szűrés is különböző szinteken engedélyezhető. Például a 8x AF jobb szűrési minőséget biztosít, mint a 4x AF. A teljes képernyős élsimításhoz hasonlóan az anizotróp szűréshez is szükség van bizonyos feldolgozási teljesítményre, amely az AF-szint növekedésével nő.

Nagy felbontású textúrák

Minden 3D-s játék speciális specifikációk figyelembevételével készült, és ezen követelmények egyike határozza meg, hogy a játéknak milyen textúra-memóriára lesz szüksége. Minden szükséges textúrának bele kell férnie a videokártya memóriájába játék közben, különben a teljesítmény jelentősen csökken, mivel a textúra elérése a RAM-hoz jelentős késést okoz, nem beszélve a merevlemezen lévő lapozófájlról. Ezért, ha egy játékfejlesztő 128 MB videomemóriával számol minimumkövetelményként, akkor az aktív textúrák készlete soha nem haladhatja meg a 128 MB-ot.

A modern játékok több textúrakészlettel rendelkeznek, így a játék gond nélkül fut a régebbi, kevesebb videomemóriával rendelkező videokártyákon, valamint az új, több videomemóriával rendelkező kártyákon. Például egy játék három textúrakészletet tartalmazhat: 128 MB, 256 MB és 512 MB számára. Ma már nagyon kevés olyan játék létezik, amely 512 MB videomemóriát támogat, de még mindig ez a legobjektívebb indok, hogy ekkora memóriával videokártyát vásároljunk. Míg a memória növekedése alig vagy egyáltalán nem befolyásolja a teljesítményt, a jobb vizuális minőség hasznára válik, ha a játék támogatja a megfelelő textúrakészletet.

Mit kell tudni a videokártyákról?

Kapcsolatban áll

GPU architektúra: Jellemzők

A 3D grafika valósághűsége nagyban függ a videokártya teljesítményétől. Minél több pixel shader blokkot tartalmaz a processzor, és minél magasabb a frekvencia, annál több effektus alkalmazható a 3D-s jelenetre a vizuális érzékelés javítása érdekében.

A GPU számos különböző funkcionális blokkot tartalmaz. Egyes összetevők száma alapján megbecsülheti a GPU teljesítményét. Mielőtt továbblépnénk, tekintsük át a legfontosabb funkcionális blokkokat.

Vertex processzorok (vertex shader egységek)

A pixel shader egységekhez hasonlóan a vertex processzorok is olyan shader kódot hajtanak végre, amely érinti a csúcsokat. Mivel a nagyobb csúcsköltségvetés bonyolultabb 3D objektumok létrehozását teszi lehetővé, a csúcsprocesszorok teljesítménye nagyon fontos az összetett vagy nagy számú objektumot tartalmazó 3D jeleneteknél. A vertex shader egységek azonban még mindig nem gyakorolnak olyan nyilvánvaló hatást a teljesítményre, mint a pixel processzorok.

Pixel processzorok (pixel shader egységek)

A pixelprocesszor egy grafikus chip egyik összetevője, amely a pixel shader programok feldolgozására szolgál. Ezek a processzorok olyan számításokat végeznek, amelyek csak a pixelekre vonatkoznak. Mivel a pixelek színinformációkat tartalmaznak, a pixel shaderekkel lenyűgöző grafikai hatásokat érhet el. Például a játékokban látható vízeffektusok többsége pixel shaderekkel jön létre. Általában a pixelprocesszorok számát használják a videokártyák pixelteljesítményének összehasonlítására. Ha az egyik kártya nyolc, a másik 16 egységgel rendelkezik, akkor logikus az a feltételezés, hogy egy 16 egységgel rendelkező videokártya gyorsabban képes feldolgozni az összetett pixel shader programokat. Figyelembe kell venni az órajelet is, de ma a pixelprocesszorok számának megduplázása energiahatékonyabb, mint a grafikus chip frekvenciájának megduplázása.

Egységes árnyékolók

Az egységes árnyékolók még nem érkeztek meg a PC-világba, de a hamarosan megjelenő DirectX 10 szabvány is hasonló architektúrára épül. Vagyis a csúcs-, geometria- és pixelprogramok kódstruktúrája ugyanaz lesz, bár a shaderek más-más munkát végeznek. Az új specifikáció az Xbox 360-on látható, ahol a GPU-t kifejezetten az ATi tervezte a Microsoft számára. Nagyon érdekes lesz látni, hogy az új DirectX 10 milyen lehetőségeket rejt magában.

Textúra-leképezési egységek (TMU)

A textúrákat ki kell választani és szűrni kell. Ezt a munkát textúra-leképező egységek végzik, amelyek a pixel- és vertex-shader egységekkel együtt működnek. A TMU feladata, hogy textúraműveleteket alkalmazzon a képpontokra. A GPU-ban lévő textúraegységek számát gyakran használják a videokártyák textúra-teljesítményének összehasonlítására. Ésszerű feltételezni, hogy egy több TMU-val rendelkező grafikus kártya jobb textúrateljesítményt biztosít.

Raszteres kezelőegységek (ROP)

A raszteres processzorok felelősek a pixeladatok memóriába írásáért. Ennek a műveletnek a sebessége a kitöltési sebesség. A 3D-s gyorsítók korai idejében a ROP és a kitöltési arány nagyon fontos jellemzői voltak a videokártyáknak. A ROP-munka ma is fontos, de a videokártya teljesítményét már nem korlátozzák ezek a blokkok, mint korábban. Ezért a ROP-ok teljesítményét (és számát) ritkán használják a videokártya sebességének értékelésére.

Szállítószalagok

A csővezetékek a videokártyák architektúrájának leírására szolgálnak, és nagyon világos képet adnak a GPU teljesítményéről.

A szállítószalag nem tekinthető szigorú szakkifejezésnek. A GPU különböző folyamatokat használ, amelyek különböző funkciókat látnak el. Történelmileg a pipeline egy pixel processzort jelentett, amely a textúra leképező egységéhez (TMU) csatlakozik. Például a Radeon 9700 videokártya nyolc pixeles processzort használ, amelyek mindegyike saját TMU-hoz csatlakozik, így a kártya nyolc csővezetékesnek tekinthető.

De a modern processzorokat nagyon nehéz leírni a csővezetékek számával. A korábbi kialakításokhoz képest az új processzorok moduláris, töredezett felépítést alkalmaznak. Ezen a területen újítónak tekinthető az ATi, amely az X1000-es videokártyákkal moduláris felépítésre váltott, ami belső optimalizálás révén tette lehetővé a teljesítménynövekedést. Egyes CPU blokkokat gyakrabban használnak, mint másokat, és a GPU teljesítményének javítása érdekében az ATi megpróbált kompromisszumot találni a szükséges blokkok száma és a kockaterület között (amit nem nagyon lehet növelni). Ebben az architektúrában a "pixel pipeline" kifejezés már értelmét vesztette, mivel a pixelprocesszorok már nincsenek csatlakoztatva saját TMU-jukhoz. Például az ATi Radeon X1600 GPU 12 pixel shader egységgel és csak négy TMU textúra leképező egységgel rendelkezik. Ezért nem lehet azt mondani, hogy ennek a processzornak az architektúrája 12 pixeles csővezetékkel rendelkezik, ahogy azt sem, hogy csak négy van belőlük. A hagyomány szerint azonban a pixelcsővezetékeket még mindig emlegetik.

A fenti feltételezéseket figyelembe véve a videokártyák összehasonlítására gyakran használják a GPU-ban lévő pixelvezetékek számát (az ATi X1x00 vonal kivételével). Például, ha 24 és 16 csővezetékes videokártyákat veszünk, akkor teljesen ésszerű feltételezni, hogy a 24 csővezetékes kártya gyorsabb lesz.

|

|||

|

| |||

Fórumunkon nap mint nap több tucatnyian kérnek tanácsot gépeik korszerűsítéséhez, amiben szívesen segítünk nekik. Nap mint nap „az összeállítást értékelve” és az ügyfeleink által kiválasztott komponensek kompatibilitását ellenőrizve azt tapasztaltuk, hogy a felhasználók elsősorban más, kétségtelenül fontos alkatrészekre figyelnek. És ritkán emlékszik valaki arra, hogy a számítógép frissítése során egy ugyanolyan fontos részt kell frissíteni -. És ma elmondjuk és megmutatjuk, miért nem szabad megfeledkezni erről.

“...a gépemet szeretném frissíteni, hogy minden repüljön, vettem egy i7-3970X és egy ASRock X79 Extreme6 alaplapot, plusz egy RADEON HD 7990 6GB-os videókártyát. Mi más az a nan????777"

- így kezdődik a frissítéssel kapcsolatos üzenetek körülbelül fele asztali számítógép. A felhasználók a saját vagy családi költségvetésük alapján igyekeznek kiválasztani a leggyorsabb, leggyorsabb és legszebb memóriamodulokat. Ugyanakkor naivan azt hinni, hogy a régi, 450 W-osuk egyszerre megbirkózik az energiaéhes videokártyával és a túlhúzás során „forró” processzorral is.

Mi a magunk részéről már nem egyszer írtunk az áramellátás fontosságáról - de valljuk be, ez valószínűleg nem volt elég egyértelmű. Ezért ma kijavítottuk magunkat, és készítettünk egy emlékeztetőt arról, hogy mi fog történni, ha számítógépe frissítésekor elfelejtkezik róla – képekkel és részletes leírásokkal.

Ezért úgy döntöttünk, hogy frissítjük a konfigurációt...

Kísérletünkhöz úgy döntöttünk, veszünk egy teljesen új átlagos számítógépet, és frissítjük a „játékgép” szintre. A konfiguráción nem kell sokat változtatni – elég lesz a memóriát és a videokártyát cserélni, hogy lehetőségünk legyen többé-kevésbé modern játékokat játszani megfelelő részletbeállításokkal. Számítógépünk kezdeti konfigurációja a következő:

Tápegység: ATX 12V 400W

Egyértelmű, hogy játékoknál ez a konfiguráció enyhén szólva is gyenge. Szóval ideje változtatni valamit! Ugyanazzal kezdjük, ahol a „frissítésre” éhesek többsége – azzal. Az alaplapot nem cseréljük – amíg megfelel nekünk.

Mivel úgy döntöttünk, hogy nem nyúlunk hozzá az alaplaphoz, az FM2 foglalattal kompatibilist választunk ki (szerencsére a NICS honlapján az alaplap leírás oldalán található erre egy speciális gomb). Ne legyünk kapzsi – vegyünk egy megfizethető, de gyors és erős processzor 4,1 GHz-es frekvenciával (Turbo CORE módban 4,4 GHz-ig) és feloldatlan szorzóval - mi is szeretünk túlhúzni, semmi emberi dolog nem idegen tőlünk. Íme az általunk választott processzor jellemzői:

| Jellemzők | CPU busz frekvencia | 5000 MHz | Teljesítménydisszipáció | 100 W | Processzor frekvencia | 4,1 GHz vagy akár 4,4 GHz Turbo CORE módban | Mag | Richland | L1 gyorsítótár | 96 KB x2 | L2 gyorsítótár | 2048 KB x2, processzorsebességgel fut | 64 bites támogatás | Igen | Magok száma | 4 | Szorzás | 41, zárolatlan szorzó | Processzor videó mag | AMD Radeon HD 8670D 844 MHz frekvenciával; Shader Model 5 támogatás | Max hangerő véletlen hozzáférésű memória | 64 GB | Max. csatlakoztatott monitorok száma | 3 közvetlenül csatlakoztatott vagy akár 4 monitor a DisplayPort elosztók segítségével |

Egy 4 GB-os pendrive nem a mi választásunk. Először is 16 GB-ot akarunk, másodszor pedig használnunk kell kétcsatornás mód munkát, amelyhez két darab 8 GB-os memóriamodult telepítünk a számítógépünkbe. A nagy áteresztőképesség, a radiátorok hiánya és a tisztességes ár miatt ezek a „legfinomabb” választások számunkra. Ezenkívül az AMD weboldaláról letöltheti a Radeon RAMDisk programot, amellyel szupergyorsan készíthetünk virtuális meghajtó 6 GB-ig teljesen ingyenes – és mindenki szereti az ingyenes hasznos dolgokat.

| Jellemzők | |

| memória | 8 GB |

| Modulok száma | 2 |

| Memória szabvány | PC3-10600 (DDR3 1333 MHz) |

| Működési frekvencia | 1333 MHz-ig |

| Időzítések | 9-9-9-24 |

| Tápfeszültség | 1,5 V |

| Sávszélesség | 10667 Mb/sec |

A beépített videón csak az „aknakeresőben” lehet kényelmesen játszani. Ezért, hogy számítógépét játékszintre fejleszthessük, egy modern és erős, de nem a legdrágábbat választottunk.

2 GB videomemóriával, DirectX 11 és OpenGL 4.x támogatással érkezett. és egy kiváló Twin Frozr IV hűtőrendszer. Teljesítménye bőven elegendő ahhoz, hogy élvezhessük a legnépszerűbb játékfranchise legújabb részeit, mint például a Tomb Raider, a Crysis, a Hitman és a Far Cry. Az általunk választott jellemzők a következők:

| Jellemzők | |

| GPU | GeForce GTX 770 |

| GPU frekvencia | 1098 MHz vagy akár 1150 MHz GPU Boost módban |

| Shader processzorok száma | 1536 |

| Videó memória | 2 GB |

| Videó memória típusa | GDDR5 |

| Videó memória busz szélessége | 256 bites |

| Videó memória frekvenciája | 1753 MHz (7,010 GHz QDR) |

| Pixel csővezetékek száma | 128, 32 textúra mintavételi egység |

| Felület | PCI Express 3.0 16x (kompatibilis a PCI Express 2.x/1.x-szel) SLI használatával kombinálható kártyákkal. |

| Portok | DisplayPort, DVI-D, DVI-I, HDMI, D-Sub adapter mellékelve |

| A videokártya hűtése | Aktív (hűtőborda + 2 Twin Frozr IV ventilátor a tábla elülső oldalán) |

| Konnektor | 8 tűs + 8 tűs |

| API támogatás | DirectX 11 és OpenGL 4.x |

| Videokártya hossza (NICS-ben mérve) | 263 mm |

| Az általános célú GPU-számítás támogatása | DirectCompute 11, NVIDIA PhysX, CUDA, CUDA C++, OpenCL 1.0 |

| Maximális fogyasztás FurMark+WinRar | 255 W |

| teljesítmény-értékelés | 61.5 |

Váratlan nehézségek

Most már minden megvan, ami a számítógépünk frissítéséhez szükséges. A meglévő házunkba új alkatrészeket építünk be.

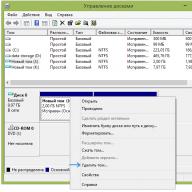

Elindítjuk és nem működik. És miért? Hanem azért, mert a pénztárcabarát tápegységek fizikailag nem alkalmasak arra, hogy bármilyen tápellátással működtessenek egy számítógépet. A helyzet az, hogy esetünkben a tápellátáshoz két 8 tűs csatlakozó szükséges, a tápegységnek pedig csak egy 6 tűs videokártya tápcsatlakozója van a talpában. Figyelembe véve, hogy sokaknak még több csatlakozóra van szükségük, mint nálunk, egyértelművé válik, hogy tápcserére szorul.

De ez nem olyan rossz. Gondolj csak bele, nincs tápcsatlakozó! Tesztlaboratóriumunkban meglehetősen ritka adaptereket találtunk 6 tűsről 8 tűsre és molexről 6 tűsre. Mint ezek:

Érdemes megjegyezni, hogy még a pénztárcabarát modern tápegységeken is a Molex csatlakozók minden egyes új kiadásával egyre kevesebb a Molex csatlakozó – tehát szerencsésnek mondhatjuk magunkat.