Pentru ce sunt sistemele de stocare (SHD) și pentru ce sunt ele? Care este diferența dintre iSCSI și FiberChannel? De ce această frază a devenit cunoscută doar în ultimii ani a unui cerc larg de specialiști IT și de ce problemele sistemelor de stocare a datelor sunt din ce în ce mai îngrijorătoare minți gânditoare?

Cred că mulți oameni au observat tendințele de dezvoltare în lumea computerelor care ne înconjoară - trecerea de la un model de dezvoltare extensiv la unul intensiv. Creșterea procesoarelor de megahertz nu mai dă un rezultat vizibil, iar dezvoltarea de unități nu ține pasul cu informația. Dacă în cazul procesoarelor totul este mai mult sau mai puțin clar - este suficient să asamblezi sisteme multiprocesoare și / sau să folosești mai multe nuclee într-un singur procesor, atunci în cazul problemelor de stocare și procesare a informațiilor, nu este atât de ușor să scapi de probleme. Panaceea actuală pentru epidemia informațională este stocarea. Numele se referă la Storage Area Network sau Storage System. În orice caz, este special

Principalele probleme rezolvate prin depozitare

Deci, ce sarcini este rezolvat sistemul de stocare? Luați în considerare problemele tipice asociate cu volumul tot mai mare de informații din orice organizație. Să presupunem că acestea sunt cel puțin câteva zeci de calculatoare și mai multe birouri distanțate geografic.

1. Descentralizarea informațiilor - dacă mai devreme toate datele ar putea fi stocate literalmente pe un hard disk, acum orice sistem funcțional necesită o stocare separată - de exemplu, servere poștă electronică, DBMS, domeniu și așa mai departe. Situația este complicată în cazul birourilor (sucursalelor) distribuite.

2. Creșterea informațiilor în formă de avalanșă - Adesea, numărul de hard disk-uri pe care le puteți instala pe un anumit server nu poate acoperi capacitatea sistemului. Drept urmare:

Incapacitatea de a proteja complet datele stocate este într-adevăr, deoarece este destul de dificil să chiar și datele de rezervă care nu sunt doar pe servere diferite, ci și dispersate geografic.

Viteza de procesare informațională insuficientă - canalele de comunicare între site-urile îndepărtate lasă mult de dorit, dar chiar și cu un canal suficient de „gros” nu este întotdeauna posibilă utilizarea rețelelor existente, de exemplu, IP, pentru lucru.

Complexitatea copiei de rezervă - dacă datele sunt citite și scrise în blocuri mici, atunci poate fi nerealist să se facă o arhivare completă a informațiilor de pe un server de la distanță prin canalele existente - este necesar să se transfere întreaga cantitate de date. Arhivarea locală este adesea imposibilă din motive financiare - sisteme de rezervă (de exemplu, unități de bandă), software special (care poate costa foarte mulți bani) și personal instruit și calificat.

3. Este dificil sau imposibil să prezici volumul necesar spațiu pe disc la implementarea unui sistem informatic. Drept urmare:

Există probleme de extindere a capacităților de disc - este destul de dificil să obțineți capacități terabyte pe server, mai ales dacă sistemul rulează deja pe discuri de capacitate mică - cel puțin, este necesară o oprire a sistemului și investiții financiare ineficiente.

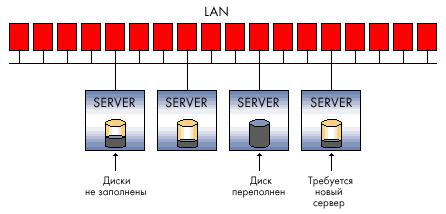

Utilizarea ineficientă a resurselor - uneori nu puteți ghici ce server datele vor crește mai rapid. O cantitate foarte mică de spațiu pe disc poate fi gratuită pe serverul de e-mail, în timp ce o altă unitate va utiliza doar 20% din volumul unui subsistem de disc scump (de exemplu, SCSI).

4. Confidențialitate scăzută a datelor distribuite - este imposibil de controlat și restricționat accesul în conformitate cu politica de securitate a întreprinderii. Acest lucru se aplică atât accesului la date pe canalele existente pentru aceasta (rețeaua locală), cât și accesului fizic la mass-media - de exemplu, furtul hard disk-urilor și distrugerea lor nu sunt excluse (pentru a complica activitatea organizației). Acțiunile necalificate ale utilizatorilor și ale personalului de întreținere pot fi și mai nocive. Atunci când o companie din fiecare birou este obligată să rezolve mici probleme de securitate locală, acest lucru nu dă rezultatul dorit.

5. Complexitatea gestionării fluxurilor de informații distribuite - orice acțiuni care au ca scop schimbarea datelor din fiecare ramură care conține o parte din datele distribuite creează anumite probleme, de la complexitatea sincronizării diferitelor baze de date, versiuni ale fișierelor de dezvoltatori până la duplicarea inutilă a informațiilor.

6. Efectul economic scăzut al introducerii de soluții „clasice” - odată cu creșterea rețelei de informații, cantități mari de date și o structură din ce în ce mai distribuită a întreprinderii, investițiile financiare nu sunt atât de eficiente și de multe ori nu pot rezolva problemele care apar.

7. Costurile ridicate ale resurselor utilizate pentru menținerea sănătății întregului sistem informațional al întreprinderii - de la necesitatea menținerii unui personal numeros de personal calificat la numeroase soluții hardware scumpe, concepute pentru a rezolva problema volumelor și a vitezei de acces la informație, împreună cu stocarea fiabilă și protecția împotriva eșecurilor.

În lumina problemelor de mai sus, care mai devreme sau mai târziu, depășesc complet sau parțial orice companie în curs de dezvoltare dinamică, vom încerca să descrie sistemele de stocare - așa cum ar trebui să fie. Luați în considerare schemele de conexiune tipice și tipurile de sisteme de stocare.

Megabytes / tranzacții?

Dacă hard disk-urile anterioare erau în interiorul computerului (serverului), acum au devenit înghesuite și nu sunt foarte sigure acolo. Cea mai simplă soluție (dezvoltată cu mult timp în urmă și folosită peste tot) este tehnologia RAID.

imagini \\ RAID \\ 01.jpg

Atunci când organizăm RAID în orice sisteme de stocare, pe lângă protejarea informațiilor, obținem mai multe avantaje incontestabile, dintre care unul este viteza de acces la informații.

Din punctul de vedere al utilizatorului sau al software-ului, viteza este determinată nu numai de capacitatea sistemului (MB / s), ci și de numărul de tranzacții - adică de numărul de operațiuni I / O pe unitate de timp (IOPS). În mod logic, un număr mai mare de discuri și acele tehnici de îmbunătățire a performanței pe care le oferă un controler RAID (cum ar fi cache) contribuie la IOPS.

Dacă debitul general este mai important pentru vizualizarea fluxului video sau organizarea unui server de fișiere, atunci pentru aplicațiile DBMS și orice aplicații OLTP (tranzacție online), este esențial numărul de tranzacții care este capabil să prelucreze sistemul. Și cu această opțiune, hard disk-urile moderne nu sunt atât de pline de roșu ca în cazul volumelor în creștere și, în parte, cu viteze. Toate aceste probleme sunt destinate să fie rezolvate chiar de sistemul de stocare.

Niveluri de protecție

Trebuie să înțelegeți că baza tuturor sistemelor de stocare este practica protejării informațiilor bazate pe tehnologia RAID - fără aceasta, orice sistem avansat de stocare tehnic nu va fi inutil, deoarece hard disk-urile din acest sistem sunt componenta cea mai nesigură. Organizarea discurilor în RAID este „legătura inferioară”, primul eșalon al protecției informațiilor și viteza crescută de procesare.

Cu toate acestea, pe lângă schemele RAID, există o protecție a datelor de nivel inferior implementată „de sus” a tehnologiilor și soluțiilor încorporate în hard disk însuși de către producătorul său. De exemplu, unul dintre cei mai importanți producători de stocare, EMC, are o metodologie pentru analiza suplimentară a integrității datelor la nivelul sectorului de acționare.

După ce ne-am ocupat de RAID, să trecem la structura sistemelor de stocare. În primul rând, sistemele de stocare sunt împărțite în funcție de tipul de interfețe de conectare gazdă (server) utilizate. Interfețele de conexiune externe sunt în principal SCSI sau FibreChannel, precum și standardul iSCSI destul de tânăr. De asemenea, nu reduceți mici magazine inteligente care pot fi chiar conectate prin USB sau FireWire. Nu vom considera interfețe mai rare (uneori pur și simplu nereușite într-un fel sau altul), cum ar fi IBM SSA sau interfețe dezvoltate pentru cadre principale - de exemplu, FICON / ESCON. Stocare NAS independentă, conectată la rețeaua Ethernet. Cuvântul „interfață” înseamnă practic un conector extern, dar nu uitați că conectorul nu determină protocolul de comunicare al celor două dispozitive. Ne vom lăsa pe aceste caracteristici un pic mai jos.

imagini \\ RAID \\ 02.gif

Reprezintă Interfața Sistemului Mic de Calcul (citiți „spuneți”) - o interfață paralelă semi-duplex. În sistemele de stocare moderne, este cel mai adesea reprezentat de un conector SCSI:

imagini \\ RAID \\ 03.gif

imagini \\ RAID \\ 04.gif

Și un grup de protocoale SCSI, și mai precis - SCSI-3 Parallel Interface. Diferența dintre SCSI și IDE familiar este un număr mai mare de dispozitive pe canal, o lungime mai lungă a cablului, o rată de transfer de date mai mare, precum și caracteristici „exclusiviste” precum semnalizarea diferențială de înaltă tensiune, cheful de comandă și altele - nu vom intra în această problemă.

Dacă vorbim despre principalii producători de componente SCSI, cum ar fi adaptoare SCSI, controlere RAID cu interfață SCSI, atunci orice specialist își va aminti imediat două nume - Adaptec și LSI Logic. Cred că acest lucru este suficient, nu au existat revoluții pe această piață de mult timp și, probabil, nu este de așteptat.

Interfață FibreChannel

Interfață serial complet duplex. Cel mai adesea, în echipamentele moderne este reprezentat de conectori optici externi, precum LC sau SC (LC - dimensiuni mai mici):

imagini \\ RAID \\ 05.jpg

imagini \\ RAID \\ 06.jpg

... și protocoalele FibreChannel (FCP). Există mai multe scheme de comutare a dispozitivelor FibreChannel:

Punct-la-punct - conexiune directă a dispozitivelor între ele:

imagini \\ RAID \\ 07.gif

Crosspoint comutat - conectarea dispozitivelor la comutatorul FibreChannel (similar implementării rețelei Ethernet pe comutatoare):

imagini \\ RAID \\ 08.gif

Bucla arbitrată - FC-AL, buclă cu acces de arbitraj - toate dispozitivele sunt conectate între ele într-un inel, circuitul amintește oarecum de Token Ring. Se poate utiliza și un comutator - apoi topologia fizică va fi implementată conform schemei „stele”, iar cea logică - în conformitate cu schema „buclă” (sau „inel”):

imagini \\ RAID \\ 09.gif

Conexiunea conform schemei FibreChannel Switched este cea mai frecventă schemă, în termeni de FibreChannel o astfel de conexiune se numește Fabric - în limba rusă există o hârtie de urmărire din ea - „fabrică”. Trebuie remarcat faptul că comutatoarele FibreChannel sunt dispozitive destul de avansate, din punct de vedere al complexității umplerii, sunt aproape de comutatoare IP de nivelul 3. Dacă întrerupătoarele sunt interconectate, atunci acestea funcționează într-o singură fabrică, având un set de setări valabile pentru întreaga fabrică simultan. Schimbarea unor opțiuni pe unul dintre comutatoare poate duce la o schimbare a întregii fabrici, fără a menționa setările de autorizare de acces, de exemplu. Pe de altă parte, există scheme SAN care implică mai multe fabrici în cadrul unei singure rețea SAN. Astfel, o fabrică poate fi numită doar un grup de comutatoare interconectate - două sau mai multe dispozitive care nu sunt interconectate, introduse în SAN pentru a crește toleranța la erori, pentru a forma două sau mai multe fabrici diferite.

Componentele care permit combinarea gazdelor și sistemelor de stocare într-o singură rețea sunt denumite în mod obișnuit „conectivitate”. Conectivitatea este, desigur, cabluri de conexiune duplex (de obicei cu o interfață LC), întrerupătoare și adaptoare FibreChannel (HBA, adaptoare de bază pentru gazdă) - adică carduri de expansiune care, atunci când sunt instalate în gazde, vă permit să conectați gazda la rețea. SAN. HBA-urile sunt de obicei implementate ca carduri PCI-X sau PCI-Express.

imagini \\ RAID \\ 10.jpg

Nu confundați fibra și fibra - mediul de propagare a semnalului poate fi diferit. FiberChannel poate funcționa pe „cupru”. De exemplu, toate hard disk-urile FibreChannel au contacte metalice, iar comutarea obișnuită a dispozitivelor prin cupru nu este neobișnuită, ele trec doar treptat la canale optice ca cea mai promițătoare tehnologie și înlocuire funcțională a cuprului.

Interfață ISCSI

De obicei reprezentat de un conector RJ-45 extern pentru conectarea la o rețea Ethernet și protocolul însuși iSCSI (Internet Small Computer System Interface). Prin definiția SNIA: „iSCSI este un protocol care se bazează pe TCP / IP și este conceput pentru a stabili interoperabilitatea și a gestiona sisteme, servere și clienți de stocare.” Vom rămâne pe această interfață mai detaliat, numai dacă fiecare utilizator este capabil să utilizeze iSCSI chiar și într-o rețea obișnuită „acasă”.

Trebuie să știți că iSCSI definește cel puțin protocolul de transport pentru SCSI, care rulează în topul TCP, și tehnologia pentru încapsularea comenzilor SCSI într-o rețea bazată pe IP. Mai simplu spus, iSCSI este un protocol care permite accesul la blocarea datelor folosind comenzile SCSI trimise printr-o rețea cu un stivă TCP / IP. iSCSI a apărut ca un înlocuitor pentru FibreChannel, iar în sistemele moderne de stocare are mai multe avantaje față de acesta - capacitatea de a combina dispozitivele pe distanțe lungi (folosind rețele IP existente), capacitatea de a furniza un nivel specific QoS (Calitatea serviciului, calitatea serviciului), conectivitate cu costuri mai mici. Cu toate acestea, principala problemă a utilizării iSCSI ca înlocuitor pentru FibreChannel este întârzierile mari de timp care apar în rețea datorită particularităților implementării stivelor TCP / IP, care neagă unul dintre avantajele importante ale utilizării sistemelor de stocare - viteza de acces la informații și latența scăzută. Acesta este un minus grav.

O mică remarcă despre gazde - ele pot utiliza atât carduri de rețea obișnuite (apoi procesarea iSCSI a stivelor și încapsularea comenzilor se vor face prin software), cât și carduri specializate care susțin tehnologii similare cu TOE (TCP / IP Offload Engines). Această tehnologie asigură procesarea hardware a părții corespunzătoare din stiva de protocol iSCSI. Metoda software mai ieftin, dar încarcă mai mult procesorul central al serverului și, teoretic, poate duce la întârzieri mai mari decât un procesor hardware. Cu viteza actuală a rețelelor Ethernet la 1 Gbit / s, se poate presupune că iSCSI va funcționa exact de două ori mai lent decât FibreChannel la o viteză de 2 Gbit, dar în utilizarea reală, diferența va fi și mai vizibilă.

Pe lângă cele deja discutate, menționăm pe scurt câteva protocoale care sunt mai rare și sunt concepute pentru a furniza servicii suplimentare rețelelor de spațiu de stocare (SAN) existente:

FCIP (Fibre Channel prin IP) - Protocol de tunel construit pe TCP / IP și conceput pentru conectarea SAN-urilor dispersate geografic printr-un mediu IP standard. De exemplu, puteți combina două SAN-uri într-unul pe Internet. Acest lucru este realizat folosind un gateway FCIP care este transparent pentru toate dispozitivele din SAN.

iFCP (Internet Fibre Channel Protocol) - Un protocol care vă permite să combinați dispozitivele cu interfețele FC prin rețele IP. O diferență importantă față de FCIP este că este posibilă unirea dispozitivelor FC printr-o rețea IP, ceea ce permite ca o pereche de conexiuni diferite să aibă un nivel diferit de QoS, ceea ce nu este posibil atunci când se face tunel prin FCIP.

Am examinat pe scurt interfețele fizice, protocoalele și tipurile de comutare pentru sistemele de stocare, fără a ne opri la listarea tuturor opțiuni posibile. Acum să încercăm să ne imaginăm ce parametri caracterizează sistemele de stocare a datelor?

Principalii parametri hardware de stocare

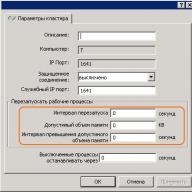

Unele dintre ele au fost enumerate mai sus - acestea sunt tipul de interfețe și tipuri de conexiuni externe unități interne (hard disk-uri). Următorul parametru, care are sens să se țină cont de cei doi de mai sus atunci când alegem un sistem de stocare pe disc, este fiabilitatea acestuia. Fiabilitatea poate fi evaluată nu de orele de rulare banale ale eșecului componentelor individuale (faptul că acest timp este aproximativ egal pentru toți producătorii), ci de arhitectura internă. Un sistem de stocare „obișnuit” adesea „extern” este un raft cu disc (pentru montarea într-un dulap de 19 inch) cu hard disk-uri, interfețe externe pentru conectarea gazdelor, mai multe surse de alimentare. În interior, de obicei, tot ce asigură sistemul de stocare este instalat - unități de procesare, controlere de disc, porturi de intrare-ieșire, memorie cache și așa mai departe. De obicei, suportul este controlat de la linie de comandă sau prin intermediul interfeței web, configurația inițială necesită adesea o conexiune serială. Utilizatorul poate „împărți” discurile din sistem în grupuri și le poate combina în RAID (de niveluri diferite), spațiul de disc rezultat este împărțit într-una sau mai multe unități logice (LUN-uri), la care gazdele (serverele) au acces și le „văd” ca hard disk-uri locale. Numărul de grupuri RAID, LUN-uri, logica cache-ului, disponibilitatea LUN-urilor pentru anumite servere și orice altceva este configurat de administratorul de sistem. De obicei, sistemele de stocare sunt concepute pentru a se conecta la ele nu la unul, ci la mai multe servere (până la sute, în teorie) - prin urmare, un astfel de sistem ar trebui să aibă performanțe ridicate, un sistem flexibil de control și monitorizare și instrumente bine gândite de protecție a datelor. Protecția datelor este asigurată în mai multe moduri, cea mai ușoară dintre care știi deja - combinația de discuri în RAID. Cu toate acestea, datele trebuie să fie și ele în permanență accesibile - până la urmă, oprirea unui singur sistem de stocare a datelor central al întreprinderii poate provoca pierderi semnificative. Cu cât mai multe sisteme stochează date pe sistemul de stocare, cu atât trebuie să se asigure un acces mai fiabil la sistem - deoarece în caz de accident, sistemul de stocare nu mai funcționează imediat pe toate serverele care stochează datele de acolo. Disponibilitatea ridicată a rack-ului este asigurată prin duplicarea internă completă a tuturor componentelor sistemului - căi de acces către rack (porturi FibreChannel), module procesor, memorie cache, surse de alimentare etc. Vom încerca să explicăm principiul redundanței 100% (duplicare) cu următoarea cifră:

imagini \\ RAID \\ 11.gif

1. Controlerul (modulul procesorului) al sistemului de stocare, inclusiv:

* procesor central (sau procesoare) - de obicei software special rulează pe sistem, îndeplinind rolul de " sistem de operare»;

* interfețe pentru comutarea cu hard disk-uri - în cazul nostru, acestea sunt plăci care asigură conectarea discurilor FibreChannel conform schemei de bucle de acces arbitraj (FC-AL);

* memorie cache;

* Controlere port externe FibreChannel

2. Interfața externă a FC; după cum vedem, există 2 dintre ele pentru fiecare modul de procesare;

3. Hard disk-uri - capacitatea este extinsă cu rafturi suplimentare pe disc;

4. Memoria de memorie cache într-o astfel de schemă este de obicei oglindită pentru a nu pierde datele stocate acolo atunci când orice modul eșuează.

În ceea ce privește hardware-ul, rafturile cu discuri pot avea interfețe diferite pentru conectarea gazdelor, diferite interfețe ale hard disk-urilor, scheme de conectare diferite pentru rafturi suplimentare, care servesc la creșterea numărului de discuri din sistem, precum și alți „parametri de fier”.

software-ul SAN

În mod firesc, puterea hardware a sistemelor de stocare trebuie gestionată într-un fel, iar sistemele de stocare în sine sunt pur și simplu obligate să ofere un nivel de servicii și funcționalități care nu este disponibil în schemele convenționale server-client. Dacă priviți figura „Schema structurală a unui sistem de stocare a datelor”, devine clar că atunci când serverul este conectat direct la rack în două moduri, acestea trebuie conectate la porturile FC ale diferitelor module de procesor pentru ca serverul să continue să funcționeze dacă întregul modul de procesor eșuează imediat. Desigur, pentru a utiliza multipathing, suportul pentru această funcționalitate ar trebui să fie oferit de hardware și software la toate nivelurile implicate în transferul de date. Desigur, backup-ul complet fără monitorizare și alertare nu are sens - prin urmare, toate sistemele de stocare serioase au astfel de capacități. De exemplu, notificarea oricăror evenimente critice poate avea loc prin diferite mijloace - o alertă prin e-mail, un apel automat de modem către centrul de asistență tehnică, un mesaj către un pager (acum mai relevant decât SMS), mecanisme SNMP și multe altele.

Ei bine, și așa cum am menționat deja, există controale puternice pentru toată această măreție. De obicei, aceasta este o interfață bazată pe web, o consolă, posibilitatea de a scrie scripturi și de a integra controlul în pachetele software externe. Vom menționa doar pe scurt despre mecanismele care asigură performanțe ridicate ale sistemelor de stocare - arhitectură care nu blochează cu mai multe autobuze interne și un număr mare de hard disk-uri, procesoare centrale puternice, un sistem de control specializat (OS), o cantitate mare de memorie cache și multe interfețe de I / O externe.

Serviciile furnizate de sistemele de stocare sunt de obicei determinate de software-ul care rulează pe suportul de discuri în sine. Aproape întotdeauna, acestea sunt pachete software complexe achiziționate sub licențe separate care nu sunt incluse în costul de stocare în sine. Menționați imediat software-ul familiar pentru furnizarea multipathing - aici funcționează doar pe gazde, și nu pe rack-ul în sine.

Următoarea soluție cea mai populară este software-ul pentru crearea copiilor instantanee și complete ale datelor. Diferenți producători au denumiri diferite pentru produsele lor software și mecanisme de creare a acestor copii. Pentru a rezuma, putem manipula cuvintele instantanee și clonă. O clonă este realizată folosind suportul de disc din interiorul rack-ului propriu-zis - aceasta este o copie internă completă a datelor. Domeniul de aplicare este destul de larg - de la backup la crearea unei „versiuni de testare” a datelor sursă, de exemplu, pentru upgrade-uri riscante în care nu există încredere și care nu este sigur de utilizat pe datele curente. Oricine a urmărit îndeaproape toate farmecele de stocare pe care le-am analizat aici, va întreba - de ce aveți nevoie de o copie de rezervă în interiorul rackului dacă are o fiabilitate atât de ridicată? Răspunsul la această întrebare este că nimeni nu este imun la erorile umane. Datele sunt stocate în mod fiabil, dar dacă operatorul a făcut ceva greșit, de exemplu, a șters tabelul dorit din baza de date, niciun truc hardware nu îl va salva. Clonarea datelor se face de obicei la nivelul LUN. Funcționalitatea mai interesantă este oferită de mecanismul de instantanee. Într-o anumită măsură, obținem toate farmecele unei copii interne complete a datelor (clonă), în timp ce nu preluăm 100% din cantitatea de date copiate în suportul propriu-zis, deoarece un astfel de volum nu ne este întotdeauna disponibil. De fapt, snapshot este o „instantanee” instantanee de date care nu necesită timp și resurse de stocare ale procesorului.

Desigur, nu se poate menționa software-ul de replicare a datelor, care este adesea numit mirroring. Acesta este un mecanism de replicare sincronă sau asincronă (duplicare) a informațiilor de la un sistem de stocare la unul sau mai multe sisteme de stocare la distanță. Replicarea este posibilă prin diferite canale - de exemplu, rafturile cu interfețe FibreChannel pot fi replicate la un alt sistem de stocare în mod asincron, prin Internet și pe distanțe lungi. Această soluție oferă stocare fiabilă de informații și protecție împotriva dezastrelor.

În plus față de toate cele de mai sus, există un număr mare de alte mecanisme software pentru manipularea datelor ...

DAS & NAS & SAN

După ce am făcut cunoștință cu sistemele de stocare a datelor în sine, principiile construcției lor, capacitățile oferite de acestea și protocoalele de funcționare, este timpul să încercați să combinați cunoștințele dobândite într-o schemă de lucru. Să încercăm să luăm în considerare tipurile de sisteme de stocare și topologia conexiunii lor la o singură infrastructură de lucru.

dispozitive DAS (stocare directă atașată) - sisteme de stocare care se conectează direct la server. Aceasta include atât cele mai simple sisteme SCSI conectate la controlerul SCSI / RAID al serverului, cât și dispozitivele FibreChannel conectate direct la server, deși sunt proiectate pentru SAN-uri. În acest caz, topologia DAS este un SAN degenerat (rețea de spațiu de stocare):

imagini \\ RAID \\ 12.gif

În această schemă, unul dintre servere are acces la datele stocate pe sistemul de stocare. Clienții accesează datele accesând acest server prin rețea. Adică, serverul are acces în bloc la datele din sistemul de stocare, iar clienții folosesc deja accesul la fișiere - acest concept este foarte important pentru înțelegere. Dezavantajele unei astfel de topologii sunt evidente:

* Fiabilitate scăzută - în caz de probleme de rețea sau de blocare a serverului, datele devin inaccesibile tuturor.

* Latență ridicată datorită procesării tuturor cererilor de către un server și a transportului utilizat (cel mai adesea - IP).

* Sarcină mare de rețea, care definește adesea limitele de scalabilitate prin adăugarea de clienți.

* Gestibilitate slabă - întreaga capacitate este disponibilă pentru un singur server, ceea ce reduce flexibilitatea distribuției datelor.

* Utilizarea scăzută a resurselor - este dificil de prezis volumele de date necesare, unele dispozitive DAS dintr-o organizație pot avea un exces de capacitate (discuri), altele pot lipsi - redistribuirea este adesea imposibilă sau necesită mult timp.

dispozitive NAS (Network Attached Storage) - dispozitive de stocare conectate direct la rețea. Spre deosebire de alte sisteme, NAS oferă acces la fișiere la date și nimic altceva. Dispozitivele NAS sunt o combinație între sistemul de stocare și serverul la care este conectat. În forma sa cea mai simplă, un server de rețea obișnuit care furnizează resurse de fișiere este un dispozitiv NAS:

imagini \\ RAID \\ 13.gif

Toate dezavantajele unei astfel de scheme sunt similare cu topologia DAS, cu unele excepții. Dintre minusurile care au fost adăugate, remarcăm un cost crescut, și adesea semnificativ - totuși, costul este proporțional cu funcționalitatea, iar aici există deseori „ceva de plătit”. Dispozitivele NAS pot fi cele mai simple „cutii” cu un port Ethernet și două hard disk-uri în RAID1, permițând accesul la fișiere folosind un singur protocol CIFS (Common Internet File System) la sisteme uriașe în care pot fi instalate sute de hard disk-uri și acces la fișiere. furnizate de o duzină de servere specializate în cadrul sistemului NAS. Numărul de porturi externe Ethernet poate atinge multe zeci, iar capacitatea datelor stocate este de câteva sute de terabyți (de exemplu, EMC Celerra CNS). Fiabilitatea și performanța unor astfel de modele pot ocoli multe dispozitive SAN de nivel mediu. Interesant este că dispozitivele NAS pot face parte dintr-o rețea SAN și nu au propriile unități, ci asigură doar accesul la fișiere la datele stocate pe dispozitivele de stocare bloc. În acest caz, NAS își asumă funcția unui server specializat puternic, iar SAN presupune dispozitivul de stocare, adică obținem topologia DAS, compusă din componente NAS și SAN.

Dispozitivele NAS sunt foarte bune într-un mediu eterogen în care ai nevoie de acces rapid la fișiere la date pentru mulți clienți în același timp. Oferă de asemenea fiabilitate excelentă de stocare și flexibilitate de gestionare a sistemului împreună cu ușurința de întreținere. Nu ne vom baza pe fiabilitate - acest aspect al stocării este discutat mai sus. În ceea ce privește un mediu eterogen, accesul la fișierele dintr-un singur sistem NAS poate fi obținut prin TCP / IP, CIFS, NFS, FTP, TFTP și altele, inclusiv capacitatea de a lucra ca țintă NAS iSCSI, care asigură funcționarea cu diferite sisteme de operare, instalat pe gazde. În ceea ce privește ușurința de întreținere și flexibilitatea de gestionare, aceste funcții sunt furnizate de un sistem de operare specializat, care este greu de dezactivat și nu trebuie întreținut, precum și ușurința de a delimita permisiunile de fișiere. De exemplu, este posibil să lucrați în mediul Windows Active Directory cu suport pentru funcționalitatea necesară - poate fi LDAP, autentificare Kerberos, DNS dinamic, ACL, cote (cote), obiecte de politică de grup și istoric SID. Deoarece accesul este furnizat fișierelor, iar numele lor pot conține simboluri din diferite limbi, multe NAS oferă suport pentru codificările UTF-8, Unicode. Alegerea NAS ar trebui abordată cu mai multă atenție decât dispozitivelor DAS, deoarece este posibil ca astfel de echipamente să nu suporte serviciile de care aveți nevoie, de exemplu, Criptarea sistemelor de fișiere (EFS) de la Microsoft și IPSec. Apropo, se poate observa că NAS-urile sunt mult mai puțin răspândite decât dispozitivele SAN, dar procentul acestor sisteme este în permanență, deși încet, în creștere - în principal datorită aglomerării din DAS.

Dispozitive la care să vă conectați SAN (Rețea de spațiu de stocare) - dispozitive pentru conectarea la o rețea de stocare a datelor. O rețea de zonă de stocare (SAN) nu trebuie confundată cu o rețea de zonă locală - acestea sunt rețele diferite. Cel mai adesea, SAN se bazează pe stiva de protocol FibreChannel și, în cel mai simplu caz, este format din sisteme de stocare, comutatoare și servere conectate prin canale de comunicare optică. În figura vedem o infrastructură extrem de fiabilă în care serverele sunt incluse simultan rețea locală (stânga) și către rețeaua de stocare (dreapta):

imagini \\ RAID \\ 14.gif

După o discuție destul de detaliată a dispozitivelor și a principiilor lor de funcționare, ne va fi destul de ușor să înțelegem topologia SAN. În figură, vedem un singur sistem de stocare pentru întreaga infrastructură, la care sunt conectate două servere. Serverele au căi de acces redundante - fiecare are două HBA (sau un port dublu, ceea ce reduce toleranța la erori). Dispozitivul de stocare are 4 porturi prin care este conectat la 2 comutatoare. Presupunând că există două module de procesor redundante în interior, este ușor de ghicit că cea mai bună schemă de conexiune este atunci când fiecare comutator este conectat atât la primul, cât și la al doilea modul de procesor. O astfel de schemă oferă acces la orice date localizate pe sistemul de stocare în cazul eșecului oricărui modul de procesare, comutator sau cale de acces. Am studiat deja fiabilitatea sistemelor de stocare, două întrerupătoare și două fabrici cresc în continuare disponibilitatea topologiei, astfel încât dacă una dintre unitățile de comutare eșuează brusc din cauza unei defecțiuni sau a unei erori de administrator, a doua va funcționa normal, deoarece aceste două dispozitive nu sunt interconectate.

Conexiunea la server afișată se numește conexiune de înaltă disponibilitate, deși un număr și mai mare de HBA-uri pot fi instalate pe server, dacă este necesar. Fizic, fiecare server are doar două conexiuni în SAN, dar logic, sistemul de stocare este accesibil prin patru căi - fiecare HBA oferă acces la două puncte de conexiune pe sistemul de stocare, separat pentru fiecare modul de procesor (această caracteristică oferă o dublă conexiune a comutatorului la sistemul de stocare). În această diagramă, dispozitivul cel mai de încredere este serverul. Două comutatoare asigură fiabilitatea ordinului de 99,99%, dar serverul poate să eșueze din diverse motive. Dacă este necesară o funcționare extrem de fiabilă a întregului sistem, serverele sunt combinate într-un cluster, diagrama de mai sus nu necesită nicio adăugare hardware pentru a organiza astfel de lucrări și este considerată schema de referință a organizației SAN. Cel mai simplu caz este serverele conectate într-un singur mod printr-un comutator la sistemul de stocare. Cu toate acestea, sistemul de stocare cu două module de procesor trebuie conectat la comutator cu cel puțin un canal pentru fiecare modul - porturile rămase pot fi utilizate pentru conectarea directă a serverelor la sistemul de stocare, ceea ce este uneori necesar. Și nu uitați că este posibil să construiți un SAN nu numai pe baza FibreChannel, ci și pe baza protocolului iSCSI - în același timp, puteți utiliza numai dispozitive Ethernet standard pentru comutare, ceea ce reduce costul sistemului, dar are o serie de minusuri suplimentare (specificate în secțiunea despre iSCSI ). Interesantă este și capacitatea de a încărca serverele din sistemul de stocare - nici măcar nu este necesar să existe unități de discuri interne pe server. Astfel, sarcina de stocare a datelor este în cele din urmă eliminată de pe servere. În teorie, un server specializat poate fi transformat într-un concasor de numere obișnuit fără unități, ale căror blocuri definitorii sunt procesoare centrale, memorie, precum și interfețe pentru interacțiunea cu lumea exterioară, precum porturile Ethernet și FibreChannel. Unele aspecte de astfel de dispozitive sunt servere cu lamă moderne.

Aș dori să notez că dispozitivele care pot fi conectate la SAN nu sunt limitate numai la sistemele de stocare a discurilor - ele pot fi bibliotecile de disc, bibliotecile cu bandă (unități cu bandă), dispozitivele pentru stocarea datelor pe discurile optice (CD / DVD, etc.) și multe altele.

Dintre minusurile SAN, notăm doar costul ridicat al componentelor sale, dar avantajele sunt incontestabile:

* Fiabilitate ridicată a accesului la date localizate pe sisteme de stocare externe. Independența topologiei SAN de sistemele și serverele de stocare folosite.

* Stocare centralizată de date (fiabilitate, securitate).

* Gestionarea convenabilă centralizată a comutării și a datelor.

* Transferați trafic intens de I / O într-o rețea separată, descărcând LAN.

* Viteză mare și latență scăzută.

* Scalabilitate și flexibilitate structură logică SAN

* Din punct de vedere geografic, dimensiunile SAN, spre deosebire de DAS-urile clasice, sunt practic nelimitate.

* Abilitatea de a distribui rapid resursele între servere.

* Abilitatea de a construi soluții de cluster care tolerează erorile, fără costuri suplimentare, bazate pe SAN-ul existent.

* Schema de backup simplă - toate datele sunt la un loc.

* Prezența funcțiilor și serviciilor suplimentare (instantanee, replicare la distanță).

* SAN de înaltă securitate.

În concluzie

Cred că am acoperit în mod adecvat gama principală de probleme legate de sistemele moderne de stocare. Să sperăm că astfel de dispozitive se vor dezvolta și mai rapid funcțional, iar numărul mecanismelor de gestionare a datelor va crește doar.

În concluzie, putem spune că soluțiile NAS și SAN se confruntă cu un adevărat boom. Numărul producătorilor și varietatea soluțiilor cresc, iar alfabetizarea tehnică a consumatorilor este în creștere. Putem presupune în siguranță că, în viitorul apropiat, în aproape fiecare mediu de calcul, va apărea unul sau alt sistem de stocare a datelor.

Orice date apar înaintea noastră sub formă de informații. Semnificația activității oricăror dispozitive de calcul este procesarea informațiilor. recent, volumele sale de creștere sunt uneori înfricoșătoare, astfel încât sistemele de stocare și software-ul specializat vor fi, fără îndoială, cele mai căutate produse IT în următorii ani.

Cum se poate clasifica arhitectura sistemelor de stocare? Mi se pare că relevanța acestei probleme va crește doar în viitor. Cum să înțelegeți toată această varietate de oferte disponibile pe piață? Vreau să vă avertizez imediat că această postare nu este destinată celor leneși sau celor care nu vor să citească mult.

Este posibilă clasificarea sistemelor de stocare destul de cu succes, similar cu modul în care biologii construiesc legături de familie între speciile de organisme vii. Dacă doriți, îl puteți numi „arborele vieții” din lumea tehnologiilor de stocare a informațiilor.

Construirea unor astfel de copaci ajută la o mai bună înțelegere a lumii. În special, puteți construi o diagramă a originii și dezvoltării oricăror tipuri de sisteme de stocare și puteți înțelege rapid ce se află la baza oricărei noi tehnologii care apare pe piață. Acest lucru vă permite să determinați imediat punctele forte și punctele slabe ale unei soluții.

Depozitele care vă permit să lucrați cu informații de orice fel, arhitectural, pot fi împărțite în 4 grupuri principale. Principalul lucru este să nu te agăți de anumite lucruri care sunt confuze. Mulți oameni tind să clasifice platformele pe baza unor astfel de criterii „fizice” ca interconectare („Toți au un bus intern între noduri!”), Sau un protocol („Acesta este un bloc, sau NAS, sau un sistem multi-protocol!”), sau împărțit în hardware și software („Acesta este doar software pe server!”).

Este abordare complet greșită la clasificare. Singurul criteriu adevărat este arhitectura software folosită într-o anumită soluție, deoarece toate caracteristicile de bază ale sistemului depind de aceasta. Componentele rămase ale sistemului de stocare depind de arhitectura software aleasă de dezvoltatori. Și din acest punct de vedere, sistemele „hardware” și „software” nu pot fi decât variații ale acestei sau acelei arhitecturi.

Dar nu mă înțelegeți greșit, nu vreau să spun că diferența dintre ele este mică. Nu este fundamental.

Și vreau să clarific altceva înainte să mă apuc de treabă. Este obișnuit ca natura noastră să punem întrebările „Și care dintre acestea este cea mai bună / corectă?”. Există un singur răspuns la acest lucru: „Există soluții mai bune pentru situații specifice sau tipuri de sarcină de muncă, dar nu există o soluție ideală universală”. și anume caracteristicile încărcării dictează alegerea arhitecturii, și nimic altceva.

Apropo, am participat recent la o conversație amuzantă pe tema centrelor de date care funcționează exclusiv pe unități flash. Sunt impresionat de pasiune în orice manifestări și este clar că blițul este dincolo de concurență în situațiile în care performanța și latența joacă un rol decisiv (printre mulți alți factori). Dar trebuie să recunosc că interlocutorii mei au greșit. Avem un singur client, mulți oameni își folosesc serviciile în fiecare zi fără să-și dea seama. Poate să treacă la bliț complet? Nu.

Acesta este un client excelent. Și iată un alt, ÎNVĂȚAT, de 10 ori mai mult. Și din nou, nu sunt de acord că acest client poate trece exclusiv la bliț:

De obicei, ca contraargument, ei spun că la sfârșit blițul va atinge un astfel de nivel de dezvoltare încât va eclipsa actionari magnetice. Cu avizul respectiv, blițul va fi folosit în pereche cu deduplicarea. Dar nu în toate cazurile este recomandabil să se aplice deduplicarea, precum și compresia.

Ei bine, pe de o parte, memoria flash va deveni mai ieftină, până la o anumită limită. Mi s-a părut că acest lucru se va întâmpla ceva mai rapid, dar SSD-urile cu o capacitate de 1 TB pentru 550 USD sunt deja disponibile, acesta este un progres mare. Desigur, dezvoltatorii de hard disk-uri tradiționale nu sunt de asemenea inactivi. În regiunea 2017-2018, concurența ar trebui să se intensifice, deoarece vor fi introduse noi tehnologii (cel mai probabil, schimbarea fazelor și nanotuburile de carbon). Însă ideea nu este deloc confruntarea dintre flash și hard disk-uri, sau chiar soluții software și hardware, principalul lucru este arhitectură.

Este atât de important încât este aproape imposibil să schimbi arhitectura de stocare fără a modifica aproape totul. Aceasta este, de fapt, fără a crea un sistem nou. Prin urmare, depozitele sunt de obicei create, dezvoltate și mor în cadrul unei arhitecturi unice selectate inițial.

Patru tipuri de stocare

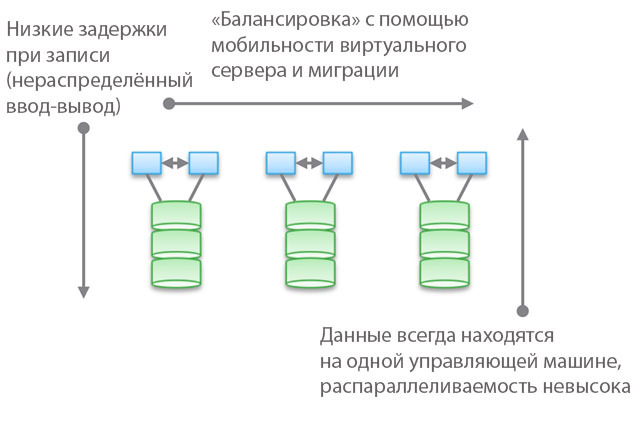

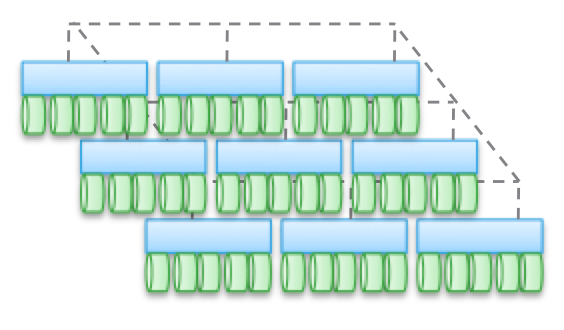

Tipul 1. Arhitectură grupată. Nu sunt concepute pentru utilizarea în comun noduri de memorie, de fapt, toate datele sunt într-un singur nod. Una dintre caracteristicile arhitecturii este că uneori dispozitivele „se intersectează” (pasaj), chiar dacă sunt „accesibile din mai multe noduri”. O altă caracteristică este că puteți selecta o mașină, spuneți-i unele unități și spuneți „această mașină are acces la datele de pe aceste suporturi”. Albastrul din figură indică sistemul CPU / memorie / intrare-ieșire, iar verde indică suportul pe care sunt stocate datele (bliț sau unități magnetice).

Acest tip de arhitectură se caracterizează printr-un acces direct și foarte rapid la date. Vor fi întârzieri ușoare între mașini, deoarece oglindirea I / O și cache-ul sunt utilizate pentru a asigura o disponibilitate ridicată. Dar, în general, accesul relativ direct este oferit de-a lungul ramurii de cod. Depozitele software sunt destul de simple și au o latență scăzută, astfel încât acestea au adesea o funcționalitate bogată, serviciile de date sunt ușor de adăugat. Nu este surprinzător, cele mai multe startup-uri încep cu astfel de depozite.

Vă rugăm să rețineți că una dintre varietățile acestui tip de arhitectură este echipamentul PCIe pentru serverele care nu sunt HA (Fusion-IO, carduri de expansiune XtremeCache). Dacă adăugăm software de stocare distribuit, coerență și un model HA, atunci astfel de stocare software va corespunde unuia dintre cele patru tipuri de arhitecturi descrise în acest post.

Utilizarea „modelelor federate” ajută la îmbunătățirea scalabilității orizontale a acestui tip de arhitectură din punct de vedere al managementului. Aceste modele pot utiliza diferite abordări pentru creșterea mobilității datelor pentru a reechilibra între mașinile gazdă și stocare. De exemplu, în cadrul VNX, aceasta înseamnă „mobilitatea VDM”. Dar cred că numirea „arhitectură scalabilă orizontală” va fi o întindere. Și, din experiența mea, majoritatea clienților împărtășesc acest punct de vedere. Motivul pentru aceasta este amplasarea datelor pe un singur aparat de control, uneori - „într-un dulap hardware” (în spatele unei cutii). Pot fi mutați, dar vor fi întotdeauna într-un singur loc. Pe de o parte, acest lucru vă permite să reduceți numărul de cicluri și întârzierea înregistrării. Pe de altă parte, toate datele dvs. sunt furnizate de o singură mașină de control (este posibil accesul indirect de la o altă mașină). Spre deosebire de al doilea și al treilea tip de arhitecturi, despre care vom discuta mai jos, echilibrarea și reglarea joacă un rol important aici.

Obiectiv vorbind, acest nivel federal abstract implică o ușoară creștere a latenței, deoarece utilizează redirecționarea software-ului. Acest lucru este similar cu complicarea codului și creșterea latenței în tipurile de arhitecturi 2 și 3 și elimină parțial avantajele primului tip. Ca exemplu concret, UCS Invicta, un fel de „routere de stocare a siliconului”. În cazul NetApp FAS 8.x, care funcționează în modul cluster, codul este destul de complicat prin introducerea unui model federat.

Produse care folosesc arhitecturi de cluster - VNX sau NetApp FAS, Pure, Tintri, Nimble, Nexenta și (cred) UCS Invicta / UCS. Unele sunt soluții „hardware”, altele sunt „software pur”, iar altele „software sub formă de complexe hardware”. Toate sunt FOARTE diferite în ceea ce privește procesarea datelor (în Pure și UCS Invicta / Whiptail, se folosesc doar unități flash). Însă arhitectural, toate produsele enumerate sunt legate. De exemplu, configurați servicii de procesare a datelor exclusiv pentru backup, stiva software devine Domeniul de date, NAS-ul dvs. acționează ca cel mai bun instrument de rezervă din lume - și acesta este și arhitectura „de prim tip”.

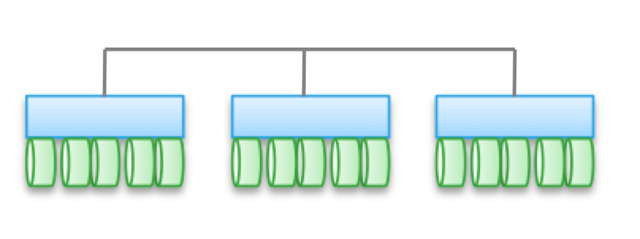

Tipul 2. Arhitecturi slab interfațate, la scară orizontală. Nodurile nu partajează memoria, dar datele în sine sunt pentru mai multe noduri. Această arhitectură presupune utilizarea mai mult conexiuni interne pentru înregistrarea datelor, ceea ce crește numărul de cicluri. Deși operațiunile de scriere sunt distribuite, ele sunt întotdeauna coerente.

Rețineți că aceste arhitecturi nu oferă o mare disponibilitate pentru nod datorită operațiunilor de copiere și distribuție a datelor. Din același motiv, există întotdeauna mai multe operații de I / O în comparație cu arhitecturile simple de cluster. Deci performanța este ușor mai mică, în ciuda nivelului mic de întârziere de înregistrare (NVRAM, SSD etc.).

În unele varietăți de arhitecturi, nodurile sunt adesea asamblate în subgrupuri, în timp ce restul sunt utilizate pentru a gestiona subgrupuri (noduri de metadate). Dar efectele descrise mai sus pentru „modele federate” sunt manifestate aici.

Astfel de arhitecturi sunt destul de ușor de dimensionat. Deoarece datele sunt stocate în mai multe locuri și pot fi procesate de mai multe noduri, aceste arhitecturi pot fi foarte bune pentru sarcini atunci când este necesară citirea distribuită. În plus, se combină bine cu software-ul server / stocare. Dar cel mai bine este să folosiți arhitecturi similare în sarcini tranzacționale: datorită naturii lor distribuite, nu puteți utiliza un server HA, iar conjugarea slabă vă permite să ocoliți Ethernet.

Acest tip de arhitectură este utilizat în produse precum EMC ScaleIO și Isilon, VSAN, Nutanix și Simplivity. Ca și în cazul tipului 1, toate aceste soluții sunt complet diferite între ele.

Conectivitate slabă înseamnă că de multe ori aceste arhitecturi pot crește semnificativ numărul de noduri. Dar, să vă reamintesc, NU folosesc memoria împreună, codul fiecărui nod funcționează independent de ceilalți. Dar diavolul, cum se spune, în detaliu:

- Cu cât sunt distribuite mai multe operațiuni de înregistrare, cu atât latența este mai mare și eficiența IOP. De exemplu, în Isilon, nivelul de distribuție este foarte ridicat pentru fișiere și, deși cu fiecare actualizare, întârzierile sunt reduse, dar totuși nu va demonstra niciodată cea mai mare performanță. Dar Isilon este extrem de puternic în ceea ce privește paralelizarea.

- Dacă reduceți gradul de distribuție (deși cu un număr mare de noduri), atunci întârzierile pot scădea, dar, în același timp, vă veți reduce capacitatea de a paralela citirea datelor. De exemplu, VSAN folosește modelul „mașină virtuală ca obiect”, care vă permite să rulați mai multe copii. S-ar părea că o mașină virtuală ar trebui să fie accesibilă pentru o anumită gazdă. Dar, de fapt, în VSAN „trece” spre nodul care stochează datele sale. Dacă utilizați această soluție, puteți vedea singur cum crește numărul de copii ale unui obiect afectează latența și operațiunile de I / O în întregul sistem. Sugestie: mai multe copii \u003d sarcină mai mare pe întregul sistem, iar dependența este neliniară, așa cum vă așteptați. Dar pentru VSAN, aceasta nu este o problemă datorită avantajelor mașinii virtuale ca model de obiect.

- Este posibil să se obțină latență scăzută în condiții de scalare și paralelizare ridicate în timpul lecturii, dar numai dacă datele și scrierea sunt separate în mod precis. un număr mare copii. Această abordare este utilizată în ScaleIO. Fiecare volum este împărțit într-un număr mare de fragmente (1 MB implicit), care sunt distribuite pe toate nodurile implicate. Rezultatul este o viteză de redistribuire extrem de mare și o paralelizare puternică. Întârzierea de scriere poate fi mai mică de 1 ms atunci când folosiți infrastructura de rețea corespunzătoare și SSD / PCIe Flash în nodurile clusterului. Cu toate acestea, fiecare operație de scriere este efectuată în două noduri. Desigur, spre deosebire de VSAN, o mașină virtuală nu este considerată un obiect aici. Dar dacă este luată în considerare, atunci scalabilitatea ar fi mai slabă.

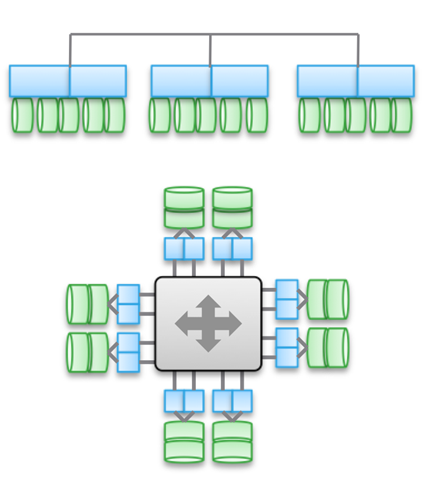

Tipul 3. Arhitecturi puternic interfațate, la scară orizontală. Aceasta folosește partajarea memoriei (pentru memorie în cache și unele tipuri de metadate). Datele sunt distribuite pe diverse noduri. Acest tip de arhitectură implică utilizarea unui număr foarte mare de conexiuni de internode pentru toate tipurile de operații.

Partajarea memoriei este piatra de temelie a acestor arhitecturi. Istoric, prin toate mașinile de control se pot efectua operații simetrice de I / O (a se vedea ilustrația). Acest lucru vă permite să reechilibrați încărcarea în cazul unor defecțiuni. Această idee a fost pusă la baza produselor precum Symmetrix, IBM DS, HDS USP și VSP. Acestea oferă acces partajat la cache, astfel încât procedura I / O poate fi controlată de pe orice aparat.

Diagrama de sus din ilustrație reflectă arhitectura EMC XtremIO. La prima vedere, este similar cu tipul 2, dar nu este. În acest caz, modelul de metadate distribuite partajate implică utilizarea IB și acces la memorie directă de la distanță, astfel încât toate nodurile să aibă acces la metadate. În plus, fiecare nod este o pereche HA. După cum puteți vedea, Isilon și XtremIO sunt foarte diferite din punct de vedere arhitectural, deși acest lucru nu este atât de evident. Da, ambele au arhitecturi la scară orizontală și ambele folosesc IB pentru interconectare. Dar în Isilon, spre deosebire de XtremIO, acest lucru este realizat pentru a minimiza latența atunci când se face schimb de date între noduri. Este de asemenea posibil să utilizați Ethernet în Isilon pentru comunicarea între noduri (de fapt, așa funcționează o mașină virtuală), dar acest lucru crește întârzierile în operațiile de intrare-ieșire. În ceea ce privește XtremIO, accesul la memorie directă de la distanță are o importanță deosebită pentru performanțele sale.

Apropo, nu vă lăsați păcăliți de prezența a două diagrame în ilustrație - de fapt, sunt aceleași din punct de vedere arhitectural. În ambele cazuri, se utilizează perechi de controlere HA, memorie partajată și interconectări cu latență foarte mică. Apropo, VMAX folosește o magistrală inter-componentă proprie, dar în viitor va fi posibilă utilizarea IB.

Arhitecturile puternic cuplate se caracterizează prin complexitatea ridicată a codului programului. Acesta este unul dintre motivele prevalenței lor scăzute. Complexitatea software-ului excesiv afectează și numărul de servicii de procesare a datelor care sunt adăugate, deoarece aceasta este o sarcină de calcul mai dificilă.

Avantajele acestui tip de arhitectură includ toleranța la erori (I / O simetrice în toate mașinile de control), precum și, în cazul XtremIO, oportunități excelente în domeniul AFA. După ce vorbim din nou despre XtremIO, este de menționat că arhitectura sa implică distribuirea tuturor serviciilor de prelucrare a datelor. De asemenea, este singura soluție AFA de pe piață, cu o arhitectură la scară orizontală, deși adăugarea / dezactivarea dinamică a nodurilor nu a fost încă implementată. Printre altele, XtremIO folosește deduplicarea „naturală”, adică este permanent activă și „liberă” din punct de vedere al performanței. Este adevărat, toate acestea cresc complexitatea întreținerii sistemului.

Este important să înțelegem diferența fundamentală între tipul 2 și tipul 3. Cu cât arhitectura este mai interconectată, cu atât este mai bună și mai previzibilă pentru a asigura o latență scăzută. Pe de altă parte, în cadrul unei astfel de arhitecturi, este mai dificil să adăugați noduri și să scalați sistemul. La urma urmei, atunci când utilizați acces partajat la memorie, este un sistem distribuit unic, foarte conjugat. Complexitatea deciziilor este în creștere și, odată cu aceasta, riscul de erori. Prin urmare, VMAX poate avea până la 16 mașini de control în 8 motoare, iar XtemIO - până la 8 mașini în 4 X-Brick (va crește în curând la 16 mașini în 8 blocuri). Quadruplarea, sau chiar dublarea acestor arhitecturi este o provocare inginerească extrem de dificilă. Pentru comparație, VSAN poate fi scalat la „dimensiunea clusterului vSphere” (acum 32 noduri), Isilon poate conține mai mult de 100 de noduri, iar ScaleIO vă permite să creați un sistem cu mai mult de 1000 de noduri. Mai mult, toate acestea sunt o arhitectură de al doilea tip.

Din nou, vreau să subliniez că arhitectura este independentă de implementare. Produsele de mai sus folosesc atât Ethernet cât și IB. Unele sunt soluții software, altele sunt complexe hardware-software, dar în același timp sunt unite prin scheme arhitecturale.

În ciuda varietății de interconectări, utilizarea înregistrărilor distribuite joacă un rol important în toate exemplele date. Acest lucru vă permite să obțineți tranzacționalitate și atomicitate, dar este necesară o monitorizare atentă a integrității datelor. De asemenea, este necesar să se rezolve problema creșterii „zonei de avarie”. Aceste două puncte limitează gradul maxim de scalare a tipurilor de arhitecturi descrise.

O mică verificare a cât de atent citiți toate cele de mai sus: Ce tip de Cisco UCS Invicta - 1 sau 3 aparține? Din punct de vedere fizic, arată ca tipul 3, dar acesta este un set de servere USC din seria C conectate prin Ethernet, care rulează stiva de software Invicta (fostă Whiptail). Sugestie: priviți arhitectura, nu implementarea specifică 🙂

În cazul UCS Invicta, datele sunt stocate în fiecare nod (serverul UCS cu unități flash bazate pe MLC). Un singur nod non-HA, care este un server separat, poate transmite direct un număr de unitate logic (LUN). Dacă vă hotărâți să adăugați mai multe noduri, este posibil ca sistemul să cântărească slab, cum ar fi ScaleIO sau VSAN. Toate acestea ne aduc la tipul 2.

Cu toate acestea, creșterea numărului de noduri, se pare, prin configurare și migrare la „Invicta Scaling Appliance”. Cu această configurație, aveți mai multe „Routere de stocare din silicon” (SSR) și o adresă de stocare a mai multor noduri hardware. Datele sunt accesate printr-un singur nod SSR, dar acest lucru poate fi realizat printr-un alt nod care funcționează ca pereche HA. Datele în sine sunt întotdeauna pe singurul nod UCS din seria C. Deci ce arhitectură este aceasta? Indiferent cum arată soluția din punct de vedere fizic, este de tip 1. SSR este un cluster (poate mai mult de 2). În configurația Scaling Appliance, fiecare server UCS cu unități MLC îndeplinește o funcție similară cu VNX sau NetApp FAS - stocare pe disc. Deși nu este conectată prin SAS, arhitectura este similară.

Tipul 4. Arhitecturi distribuite fără partajarea resurselor. În ciuda faptului că datele sunt distribuite pe diferite noduri, aceasta se face fără nicio tranzacționalitate. De obicei, datele sunt stocate pe un singur nod și trăiesc acolo, iar din când în când se fac copii pe alte noduri, din motive de securitate. Dar aceste copii nu sunt tranzacționale. Aceasta este diferența cheie între acest tip de arhitectură și tipul 2 și 3.

Comunicarea între nodurile non-HA se face prin Ethernet, deoarece este ieftină și universală. Distribuția pe noduri este obligatorie și din când în când. „Corectitudinea” datelor nu este întotdeauna respectată, dar stiva software este verificată destul de des pentru a asigura corectitudinea datelor utilizate. Pentru unele tipuri de încărcare (de exemplu, HDFS), datele sunt distribuite astfel încât să fie în memorie în același timp cu procesul pentru care este necesar. Această proprietate ne permite să considerăm acest tip de arhitectură drept cea mai scalabilă dintre toate cele patru.

Dar acest lucru este departe de singurul avantaj. Astfel de arhitecturi sunt extrem de simple, sunt foarte ușor de gestionat. Nu sunt în niciun fel dependenți de echipamente și pot fi dislocate pe cele mai ieftine echipamente. Acestea sunt aproape întotdeauna soluții software exclusiv. Acest tip de arhitectură este la fel de ușor de manevrat cu petabytes de date ca terabytes cu alte date. Obiecte și sisteme de fișiere non-POSIX sunt utilizate aici și ambele sunt adesea localizate în partea de sus a sistemului de fișiere local al fiecărui nod obișnuit.

Aceste arhitecturi pot fi combinate cu blocuri și modele tranzacționale de prezentare a datelor bazate pe NAS, dar acest lucru le limitează foarte mult capacitățile. Nu este necesară crearea unei stive tranzacționale prin plasarea tipului 1, 2 sau 3 deasupra tipului 4.

Cel mai bine, aceste arhitecturi sunt „dezvăluite” pentru acele sarcini pentru care unele restricții nu sunt particulare.

Mai sus, am dat un exemplu cu un client foarte mare, cu 200.000 de unități. Serviciile precum Dropbox, Syncplicity, iCloud, Facebook, eBay, YouTube și aproape toate proiectele Web 2.0 se bazează pe depozite construite folosind al patrulea tip de arhitectură. Toate informațiile procesate din clusterele Hadoop sunt de asemenea conținute în spațiile de stocare de tip 4. În general, în segmentul corporativ acestea nu sunt arhitecturi foarte frecvente, dar câștigă repede popularitate.

Tipul 4 stă la baza unor produse precum AWS S3 (apropo, nimeni din afara AWS nu știe cum funcționează EBS, dar sunt dispus să argumentez că este tipul 3), Haystack (folosit pe Facebook), Atmos, ViPR, Ceph, Swift ( folosit în Openstack), HDFS, Centera. Multe dintre produsele enumerate pot lua o formă diferită, tipul implementării specifice este determinat folosind API-ul lor. De exemplu, stiva de obiect ViPR poate fi implementată prin intermediul API-urilor obiectelor S3, Swift, Atmos și chiar HDFS! Și în viitor, Centera va fi și ea pe această listă. Pentru unii, acest lucru va fi evident, însă Atmos și Centera vor fi utilizate pentru o lungă perioadă de timp, însă, sub formă de API, și nu produse specifice. Implementările se pot schimba, dar API-urile rămân neschimbabile, ceea ce este foarte bun pentru clienți.

Vreau să vă atrag atenția încă o dată asupra faptului că „întruchiparea fizică” vă poate confunda și veți clasifica greșit arhitecturile de tip 4 ca de tip 2, deoarece acestea arată adesea la fel. La nivel fizic, o soluție poate arăta ca ScaleIO, VSAN sau Nutanix, deși acestea vor fi doar servere Ethernet. Și prezența sau absența tranzacționalității va ajuta la clasificarea corectă a unei anumite soluții.

Și acum vă ofer un al doilea test de verificare. Să ne uităm la arhitectura UCS Invicta. Din punct de vedere fizic, acest produs arată ca tipul 4 (servere conectate prin Ethernet), dar nu poate fi scalat arhitectural la încărcările corespunzătoare, deoarece este de fapt tipul 1. Mai mult, Invicta, la fel ca Pure, a fost dezvoltat pentru AFA.

Vă rugăm să acceptați recunoștința mea sinceră pentru timpul și atenția dvs. dacă ați citit până în acest loc. Am citit mai sus - este uimitor că am reușit să mă căsătoresc și să am copii 🙂

De ce am scris toate acestea?

În lumea stocării IT, acestea ocupă un loc foarte important, un fel de „regat al ciupercilor”. Varietatea produselor oferite este foarte mare, iar acest lucru nu face decât să beneficieze întreaga afacere. Dar trebuie să fii capabil să înțelegi toate acestea, să nu-ți permiți mintea cu sloganuri de marketing și nuanțe de poziționare. În beneficiul atât al clienților, cât și al industriei în sine, este necesar să se simplifice procesul de depozitare a clădirilor. De aceea, ne străduim să facem din controlerul ViPR o platformă deschisă și liberă.

Dar depozitul în sine este cu greu interesant. Ce vreau sa spun? Imaginați-vă un fel de piramidă abstractă, pe deasupra căreia se află un „utilizator”. Mai jos sunt "aplicațiile" proiectate pentru a servi "utilizatorului". Și mai mică este „infrastructura” (inclusiv SDDC) care servește „aplicațiile” și, în consecință, „utilizatorul”. Iar în partea de jos a „infrastructurii” se află depozitul.

Adică vă puteți imagina ierarhia în această formă: User-\u003e Application / SaaS-\u003e PaaS-\u003e IaaS-\u003e Infrastructure. Deci: în final, orice aplicație, orice stivă PaaS trebuie să calculeze sau să proceseze un fel de informație. Iar aceste patru tipuri de arhitecturi sunt concepute pentru a lucra cu diferite tipuri de informații, diferite tipuri de încărcare. În ierarhia importanței, informațiile urmăresc imediat utilizatorul. Scopul existenței aplicației este de a permite utilizatorului să interacționeze cu informațiile de care are nevoie. De aceea, arhitectura de stocare este atât de importantă în lumea noastră.

Această intrare a fost postată în Necategorizată de autor. Marcați-l.Și alte lucruri, suportul de transmisie de date și serverele conectate la acesta. Este de obicei utilizat de companii suficient de mari cu infrastructură IT bine dezvoltată pentru stocarea fiabilă a datelor și accesul de mare viteză la acestea.

Simplificat, stocarea este un sistem care vă permite să distribuiți servere fiabile unități rapide capacitate variabilă cu diferite dispozitive stocarea datelor

Un pic de teorie.

Serverul poate fi conectat la depozitul de date în mai multe moduri.

Primul și cel mai simplu este DAS, Direct Attached Storage (conexiune directă), introducem unități în server sau un tablou în adaptorul serverului și obținem o mulțime de gigabyte de spațiu pe disc cu relativ acces rapidși când folosiți un tablou RAID - fiabilitate suficientă, deși sulițele pe tema fiabilității se rup de mult timp.

Totuși, această utilizare a spațiului pe disc nu este optimă - pe un server locul se termină, pe celălalt există încă o mulțime de lucruri. Soluția la această problemă este NAS, Network Attached Storage (stocare atașată la rețea). Cu toate acestea, cu toate avantajele acestei soluții - flexibilitate și gestionare centralizată - există un dezavantaj semnificativ - viteza de acces, rețeaua de 10 gigabits nu este încă implementată în toate organizațiile. Și ne apropiem de o rețea de stocare.

Principala diferență între un SAN și un NAS (pe lângă ordinea literelor în abrevieri) este modul în care resursele conectate sunt văzute pe server. Dacă resursele NAS sunt conectate la protocoalele NFS sau SMB, în SAN obținem o conexiune la disc, cu care putem lucra la nivelul operațiunilor de I / O de bloc, care este mult mai rapid conexiune la rețea (plus un controler de matrice cu un cache mare adaugă viteză la multe operațiuni).

Folosind SAN, combinăm avantajele DAS - viteză și simplitate și NAS - flexibilitate și controlabilitate. În plus, obținem capacitatea de a scala sistemele de depozitare până când sunt suficienți bani, în timp ce omorâm simultan alte câteva păsări cu o piatră, care nu sunt vizibile imediat:

* eliminați restricțiile privind raza de conectare a dispozitivelor SCSI, care sunt de obicei limitate la un fir de 12 metri,

* reduce timpul de rezervă,

* putem porni de la SAN,

* în caz de refuz de la NAS descărcăm o rețea,

* obținem o viteză mare de intrare-ieșire datorită optimizării din partea sistemului de stocare,

* avem ocazia de a conecta mai multe servere la o singură resursă, aceasta ne oferă următoarele două păsări cu o singură piatră:

- folosim pe deplin capabilitățile VMWare - de exemplu, VMotion (migrația mașinii virtuale între mașini fizice) și altele ca acestea,

- putem construi clustere care să tolereze erorile și să organizăm rețele distribuite geografic.

Ce dă?

În plus față de dezvoltarea bugetului pentru optimizarea sistemului de stocare, avem, pe lângă ceea ce am scris mai sus:

* creșterea productivității, echilibrarea sarcinii și disponibilitatea ridicată a sistemelor de stocare datorită mai multor modalități de accesare a tablelor;

* economii pe discuri prin optimizarea locației informațiilor;

* recuperare accelerată din eșecuri - puteți crea resurse temporare, implementa backup la ele și conectați serverele la acestea și puteți restaura informațiile singuri fără grabă sau puteți transfera resurse pe alte servere și puteți trata calm cu fierul mort;

* Timp de rezervă redus - datorită vitezei mari de transfer, puteți face backup la biblioteca de bandă mai rapid sau chiar lua o instantanee (instantanee) din sistemul de fișiere și arhivând-o în siguranță;

* spațiu pe disc la cerere - atunci când avem nevoie de acesta - puteți adăuga întotdeauna câteva rafturi în sistemul de stocare.

* reducerea costului de stocare a unui megabyte de informații - desigur, există un anumit prag din care aceste sisteme sunt rentabile.

* Un loc de încredere pentru stocarea datelor critice pentru misiune și pentru afaceri (fără de care organizația nu poate exista și funcționează normal).

* Vreau să menționez separat VMWare - toate cipurile precum migrarea mașinilor virtuale de la server la server și alte bunătăți sunt disponibile doar pe SAN.

În ce constă?

După cum am scris mai sus - SHD constă din dispozitive de stocare, suporturi de transmisie și servere conectate. Să luăm în considerare:

Sisteme de stocare a datelor de obicei constau din hard disk-uri și controlere, într-un sistem cu respectare de sine, de obicei doar 2 - 2 controlere, 2 căi la fiecare unitate, 2 interfețe, 2 surse de alimentare, 2 administratori. Printre cei mai respectați producători de sistem, trebuie menționate HP, IBM, EMC și Hitachi. Aici voi cita un reprezentant al EMC la seminar - „HP face imprimante excelente. Ei bine, las-o să le facă! ”Bănuiesc că HP iubește și EMC. Concurența între producători este gravă, ca și în alte părți. Consecințele concurenței sunt, uneori, prețuri sănătoase pe megabyte de sistem de stocare și probleme cu compatibilitatea și suportul standardelor concurenților, în special pentru echipamentele vechi.

Mediu de transfer de date.

De obicei, SAN-urile sunt construite pe optică, ceea ce în prezent oferă o viteză de 4, uneori 8 gigabit pe canal. Când a fost construit, hub-uri specializate au fost folosite înainte, acum există mai multe switch-uri, în principal de la Qlogic, Brocade, McData și Cisco (nu am văzut niciodată ultimele două pe site-uri). Cablurile sunt utilizate tradițional pentru rețelele optice - un singur mod și multi-mod, un singur mod mai mult.

În interior se folosește FCP - Fibre Channel Protocol, un protocol de transport. De obicei, SCSI clasic rulează în interiorul său, iar FCP oferă adresare și livrare. Există o opțiune cu conectarea printr-o rețea obișnuită și iSCSI, dar utilizează de obicei (și încarcă foarte mult) o rețea locală și nu este dedicată pentru rețeaua de transfer de date și necesită adaptoare cu suport iSCSI, bine, viteza este mai lentă decât în \u200b\u200boptică.

Există, de asemenea, o topologie inteligentă a cuvintelor, care se găsește în toate manualele de pe SAN. Există mai multe topologii, cea mai simplă opțiune este punct la punct, conectăm 2 sisteme. Acesta nu este DAS, dar un cal sferic în vid este cea mai simplă versiune a SAN. Apoi vine bucla controlată (FC-AL), funcționează pe principiul „trece mai departe” - transmițătorul fiecărui dispozitiv este conectat la receptorul celui următor, dispozitivele sunt închise într-un inel. Lanțurile lungi tind să se inițialeze mult timp.

Ei bine, opțiunea finală este o țesătură comutată (Fabric), este creată folosind switch-uri. Structura conexiunilor este construită în funcție de numărul de porturi conectate, ca și în construcția unei rețele locale. Principiul de bază al construcției este că toate căile și conexiunile sunt duplicate. Aceasta înseamnă că există cel puțin 2 căi diferite pentru fiecare dispozitiv din rețea. Aici se folosește și cuvântul topologie, în sensul organizării unei diagrame de conectare a dispozitivului și conectarea comutatoarelor. În acest caz, de regulă, comutatoarele sunt configurate astfel încât serverele să nu vadă altceva decât resursele destinate acestora. Acest lucru se realizează prin crearea de rețele virtuale și se numește zonare, cea mai apropiată analogie este VLAN. Fiecărui dispozitiv din rețea i se atribuie o adresă MAC analogică din rețeaua Ethernet, se numește WWN - World Wide Name. Este alocat fiecărei interfețe și fiecărei resurse (LUN) a sistemelor de stocare. Array-urile și comutatoarele pot distinge accesul WWN pentru servere.

server de Conectați-vă la spațiu de stocare prin HBA - Host Bus Adapters. Prin analogie cu plăci de rețea, există adaptoare cu un, doi și patru porturi. Cei mai buni „crescători de câini” recomandă instalarea a 2 adaptoare pe server, ceea ce permite atât echilibrarea încărcării, cât și fiabilitatea.

Și apoi resursele sunt tăiate în sistemele de stocare, sunt LUN-urile pentru fiecare server și un loc este lăsat în rezervă, totul este pornit, instalatorii de sistem prescriu topologia, prind glitches în configurația comutatoarelor și accesului, totul începe și toată lumea trăiește fericită până la *.

În mod special nu ating mai multe tipuri de porturi din rețeaua optică, oricine are nevoie - știe deja sau citește, cine nu are nevoie - ciocăni doar capul. Dar, ca de obicei, dacă tipul de port este setat incorect, nimic nu va funcționa.

Din experiență.

De obicei, atunci când se creează un SAN, se comandă tablouri cu mai multe tipuri de discuri: FC pentru aplicații de mare viteză și SATA sau SAS pentru cele nu foarte rapide. Astfel, se obțin 2 grupuri de discuri cu costuri diferite de megabyte - scumpe și rapide și ieftine și triste. De obicei, toate bazele de date și alte aplicații cu I / O active și rapide sunt agățate de cea rapidă, în timp ce resursele de fișiere și toate celelalte sunt agățate de cea lentă.

Dacă un SAN este creat de la zero, are sens să îl construim pe baza soluțiilor unui singur producător. Cert este că, în ciuda conformității declarate cu standardele, există probleme de compatibilitate a echipamentelor, în mod subacvatic, și nu faptul că o parte a echipamentului va funcționa unul cu celălalt fără a dansa cu un tamburin și a se consulta cu producătorii. De obicei, pentru a rezolva astfel de probleme, este mai ușor să apelați la un integrator și să-i dați bani decât să comunicați cu producătorii care comută săgeți.

Dacă SAN este creat pe baza infrastructurii existente, totul poate fi complicat, mai ales dacă există tablouri SCSI vechi și o grădină zoologică veche de la diferiți producători. În acest caz, are sens să solicităm ajutor din partea bestiei cumplite a unui integrator care va dezvălui problemele de compatibilitate și va face o a treia vilă în Insulele Canare.

Adesea, atunci când creează sisteme de stocare, firmele nu comandă asistență pentru producători pentru acest sistem. De obicei, acest lucru este justificat dacă compania are un personal format din admin-uri competenți competenți (care mi-au numit deja un ceainic de 100 de ori) și o cantitate justă de capital, ceea ce face posibilă achiziționarea de piese de schimb în cantitățile necesare. Cu toate acestea, administratorii competenți sunt de obicei ademeniți de către integratori (am văzut-o eu însămi), dar nu alocă bani pentru achiziție, iar după eșecuri, un circ începe cu strigătele „Lasă-mă să dau foc tuturor!”, În loc să cheme asistența și inginerul care sosește cu o piesă de rezervă.

Suportul se reduce de obicei la înlocuirea discurilor și a controlerelor moarte și la adăugarea de rafturi de disc și servere noi la sistem. O mulțime de probleme se întâmplă după o prevenire bruscă a sistemului de către specialiștii locali, în special după o oprire completă și demontare-asamblare a sistemului (și acest lucru se întâmplă).

Despre VMWare. Din câte știu (specialiștii în virtualizare mă corectează), doar VMWare și Hyper-V au funcționalitate care vă permite să transferați mașini virtuale între serverele fizice din zbor. Și pentru implementarea sa, este necesar ca toate serverele între care se deplasează mașina virtuală să fie conectate la același disc.

Despre clustere. La fel ca în cazul VMWare, sistemele pe care le cunosc de a construi clustere de reîncărcare (Sun Cluster, Veritas Cluster Server) despre care știu necesită stocare conectată la toate sistemele.

În timp ce scriam un articol - m-au întrebat - în ce RAID se combină de obicei unitățile?

În practica mea, ei făceau de obicei fie RAID 1 + 0 pe fiecare raft cu discuri FC, lăsând 1 disc de rezervă (Hot Spare) și tăiau LUN-uri din această piesă pentru sarcini, fie făceau RAID5 din discuri lente, lăsând din nou 1 disc pentru înlocuire. Dar aici întrebarea este complexă și, de obicei, modul de organizare a discurilor într-un tablou este selectat pentru fiecare situație și justificat. Același EMC, de exemplu, merge și mai departe, și au setare suplimentară matricea pentru aplicațiile care lucrează cu acesta (de exemplu, sub OLTP, OLAP). Nu am săpat atât de adânc cu ceilalți vânzători, dar cred că toată lumea are un reglaj fin.

* înainte de primul eșec major, după care suportul este de obicei cumpărat de la producătorul sau furnizorul sistemului.

DAS, SAN, NAS - prescurtări magice, fără de care nu poate face un singur articol sau un singur studiu analitic al sistemelor de stocare. Ele servesc ca denumire a principalelor tipuri de conexiuni între sisteme de stocare și sisteme de calcul.

DAS (stocare directă atașată) - dispozitiv memoria externăconectat direct la computerul principal și folosit doar de acesta. Cel mai simplu exemplu de DAS este încorporat hard disk. Pentru a conecta gazda cu memorie externă într-o configurație DAS tipică, se utilizează SCSI, ale cărui comenzi vă permit să selectați un bloc de date specific pe un disc specific sau să montați un cartuș specific într-o bibliotecă cu benzi.

Configurațiile DAS sunt acceptabile pentru cerințe de stocare, capacitate și fiabilitate. DAS nu oferă posibilitatea de a partaja capacitatea de stocare între diferite gazde și cu atât mai puțin capacitatea de a partaja date. Instalarea unor astfel de dispozitive de stocare este o opțiune mai ieftină în comparație cu configurațiile rețelei, cu toate acestea, având în vedere organizațiile mari, acest tip de infrastructură de stocare nu poate fi considerat optim. Multe conexiuni DAS înseamnă insule de memorie externă care sunt împrăștiate și împrăștiate în întreaga companie, excesul de care nu pot fi utilizate de alte computere gazdă, ceea ce duce la o pierdere ineficientă a capacității de stocare în general.

În plus, cu o astfel de organizație de stocare, nu există nicio modalitate de a crea un singur punct de gestionare a memoriei externe, ceea ce complică inevitabil procesele de rezervă / recuperare a datelor și creează o problemă serioasă de protecție a informațiilor. Drept urmare, costul total de proprietate al unui astfel de sistem de stocare poate fi semnificativ mai mare decât cel mai complex la prima vedere și configurația inițial mai scumpă a rețelei.

SAN

Astăzi, vorbind despre un sistem de stocare la nivel de întreprindere, ne referim la stocarea rețelei. Mai bine cunoscut publicului larg este rețeaua de stocare - SAN (rețeaua de stocare). SAN este o rețea dedicată de dispozitive de stocare care permite mai multor servere să utilizeze resursa totală a memoriei externe fără încărcarea în rețeaua locală.

SAN este independent de mediul de transmisie, dar momentan standardul actual este tehnologia Fibre Channel (FC), oferind o rată de transfer de date de 1-2 Gb / s. Spre deosebire de suportul de transmisie tradițional bazat pe SCSI, care oferă conectivitate de cel mult 25 de metri, Fiber Channel vă permite să lucrați la distanțe de până la 100 km. Mediile de rețea Fibre Channel pot fi fie cupru, fie fibre.

Discul se poate conecta la rețeaua de stocare tablouri RAID, tablouri de discuri simple, (așa-numitele Doamne buchete de discuri - JBOD), biblioteci de bandă sau magneto-optice pentru backup și arhivare a datelor. Principalele componente pentru organizarea unei rețele SAN în plus față de dispozitivele de stocare în sine sunt adaptoarele pentru conectarea serverelor la o rețea Fibre Channel (adaptor autobuz gazdă - NVA), dispozitive de rețea pentru a susține una sau alta topologie a rețelei FC și instrumente software specializate pentru gestionarea unei rețele de stocare. acestea sisteme software poate fi efectuat atât pe un server cu scop general, cât și pe dispozitivele de stocare în sine, deși uneori unele funcții sunt transferate către un server subțire specializat pentru gestionarea rețelei de stocare (aparatul SAN).

Scopul software-ului SAN este în primul rând gestionarea centrală a rețelei de stocare, inclusiv configurarea, monitorizarea, controlul și analizarea componentelor rețelei. Una dintre cele mai importante este funcția de control de acces la matricile de disc, dacă serverele eterogene sunt stocate în SAN. Rețelele de stocare permit mai multor servere să acceseze simultan mai multe subsisteme de discuri, mapând fiecare gazdă pe discuri specifice pe o matrice de disc specifică. Pentru diferite sisteme de operare, este necesară stratificarea tabloului de discuri în „unități logice” (unități logice - LUN-uri), pe care le vor utiliza fără conflicte. Poate fi necesară alocarea de zone logice pentru organizarea accesului la aceleași date pentru un anumit grup de servere, de exemplu, serverele aceluiași grup de lucru. Modulele software speciale sunt responsabile pentru susținerea tuturor acestor operațiuni.

Atractivitatea rețelelor de stocare se explică prin avantajele pe care le pot oferi organizațiilor care solicită eficiența de a lucra cu volume mari de date. O rețea de stocare dedicată descarcă rețeaua principală (locală sau globală) de servere de calcul și stații de lucru client, eliberându-l de fluxurile de intrare / ieșire a datelor.

Acest factor, precum și mediul de transmisie de mare viteză utilizat pentru SAN, asigură o productivitate crescută a proceselor de schimb de date cu sisteme de stocare externe. SAN înseamnă consolidarea sistemelor de stocare, crearea unui singur grup de resurse pe diferite suporturi, care vor fi împărtășite de toată puterea de calcul și, ca urmare, capacitatea de memorie externă necesară poate fi furnizată cu mai puține subsisteme. În SAN, datele sunt copiate de la subsistemele de disc la casetele din afara rețelei locale și, prin urmare, devin mai eficiente - o bibliotecă cu bandă poate fi folosită pentru a face copii de rezervă din mai multe subsisteme de disc. În plus, cu suportul software-ului corespunzător, este posibilă implementarea de rezervă directă în SAN fără participarea serverului, descărcând astfel procesorul. Posibilitatea de a implementa servere și memorie pe distanțe lungi răspunde nevoilor de a îmbunătăți fiabilitatea depozitelor de date ale întreprinderii. Stocarea de date consolidată în scala SAN este mai bună, deoarece vă permite să creșteți capacitatea de stocare independent de servere și fără a le întrerupe. În cele din urmă, SAN permite gestionarea centralizată a unui singur grup de memorie externă, ceea ce simplifică administrarea.