NAS NAS

Die Informations- und Datenmengen, mit denen moderne Unternehmen arbeiten, liegen weit über dem Niveau eines Jahrzehnts oder sogar vor fünf Jahren. Technische Lösungen, die es uns ermöglichen, eine solche Größenordnung von Unternehmensdaten effizient zu verarbeiten, unterscheiden sich erheblich von Systemen, die unter den Bedingungen des "Haushaltsgebrauchs" betrieben werden. Für das Geschäftsleben werden bereits mehrere Server benötigt, die gleichzeitig verschiedene Aufgaben ausführen: Terminal, Mail, DNS, Proxy-Server und andere, oft nicht zu einem Clustersystem zusammengefasst. Bei dieser Verteilung besteht das Problem der Online-Verarbeitung und Sicherung von Daten von verschiedenen Geräten. Um dieses Problem zu lösen, werden Datenspeichersysteme (SHD) verwendet, die unser Unternehmen zur Auswahl und zum Kauf anbietet.

Vorteile der Verwendung von externem Netzwerkspeicher

Ein solches Datenspeichersystem (SHD) für die Arbeit mit Daten ist eine umfassende Lösung, mit der Sie jede Menge Informationen zentral speichern und so die Zuverlässigkeit des Schutzes, die Verarbeitungsgeschwindigkeit und die vollständige Archivierung sicherstellen können. Der Netzwerkspeicher bietet gegenüber klassischen Lösungen für die Verteilung von Informationen auf mehrere Server mehrere weitere Vorteile. Fehlertoleranz wird durch die Möglichkeit der teilweisen und vollständigen Redundanz von Netzwerkspeicherkomponenten erreicht. Externe Netzwerkdatenspeicherung zeichnet sich durch eine leistungsfähigere Leistung und eine schnellere Datenübertragung aus. Sie passt sich problemlos an die Geschäftsanforderungen des Unternehmens an, da sie sich problemlos skalieren und an Änderungen des Volumens des Informationsdatenflusses im Unternehmen anpassen lässt. Das Data Warehouse kann im Gegensatz zu Standarddatenbanken nicht nur zur Abwicklung von Transaktionen verwendet werden, sondern auch zur Analyse der Verkaufsdynamik über mehrere Jahre, zur Erstellung von Berichten in verschiedenen Formaten und zur Integration von Daten aus verschiedenen Registrierungssystemen.

Es gibt vier Arten der Datenspeicherung:

- NAS Zuverlässige, kostengünstige und einfach anpassbare Systeme.

- DAS. Schemata mit einem externen Trunk, der es ermöglicht, eine unbegrenzte Anzahl von Festplatten anzuschließen.

- SAN. Gut geeignet zum Speichern von Mail-Datenbanken und für den schnellen Zugriff auf Informationen.

- Fehlertolerantes Data Warehousing. Kombiniert in einem Cluster-Schema und bieten die höchste Zuverlässigkeit und Datenübertragungsrate.

Externe Data Warehouses werden zum Speichern interner Daten verwendet speicherplatz, verhindern Sie Datenverlust, stellen Sie die Sicherheit und Verfügbarkeit von Inhalten jederzeit sicher.

Online-Speicher zu einem guten Preis kaufen? Zu dir hier!

Wenn Sie sich für den Kauf eines Netzwerkspeichers für Ihr Unternehmen entscheiden, bietet Trinity Ihrem Unternehmen zuverlässige und leistungsstarke Datenspeichersysteme. In unserem Sortiment gibt es verschiedene Konfigurationen von Speichersystemen. Wir sind die offiziellen Vertreter der führenden Hersteller von IT-Geräten auf dem Weltmarkt und können das Data Warehouse jeder Konfiguration schnell vervollständigen. Wir bieten Speichersysteme von Herstellern wie Dell, HP, Lenovo, EMC usw. an.

Abhängig von den Anforderungen und Aufgabenstellungen des jeweiligen Unternehmens helfen Ihnen unsere Experten bei der Auswahl oder Zusammenstellung eines individuellen Datenspeichersystems, das für die Größe, das Budget und die vorhandene Netzwerkinfrastruktur optimal ist. Der Preis für das ausgewählte Datenspeichersystem hängt von der Konfiguration ab. Die Kosten für das Entwerfen des Data Warehouse können Sie abhängig von den Aufgaben bei unseren Spezialisten erfragen.

Unsere Firma beschäftigt sich mit der Analyse des aktuellen Zustands der technischen Basis, der Auswahl der erforderlichen Ausrüstung und der Installation der Ausrüstung. Sie müssen nur eine Anfrage an unsere Spezialisten senden.

Darüber hinaus bieten wir technischen Support für die gelieferten Geräte. Unsere Mitarbeiter sind hochqualifizierte Ingenieure, Installateure, IT-Spezialisten stehen Ihnen jederzeit kompetent zur Seite. Von der professionellen Beratung bis zur Modernisierung und Weiterentwicklung der Geräte.

Nie zuvor war das Problem der Dateispeicherung so akut wie heute.

Aussehen festplatten Blu-ray-Discs mit einer Kapazität von 25 bis 50 GB und einem Volumen von 3 oder sogar 4 TB cloud-Speicher - löst das Problem nicht. Um uns herum gibt es immer mehr Geräte, die umfangreiche Inhalte erzeugen: Fotos und Videokameras, Smartphones, HD-TV und -Video, Spielekonsolen usw. Wir erzeugen und verbrauchen (hauptsächlich aus dem Internet) Hunderte und Tausende von Gigabyte.

Dies führt dazu, dass der Computer eines durchschnittlichen Benutzers eine große Anzahl von Dateien, Hunderte von Gigabyte, speichert: ein Fotoarchiv, eine Sammlung von Lieblingsfilmen, Spielen, Programmen, Arbeitsdokumenten usw.

All dies muss nicht nur gespeichert, sondern auch vor Ausfällen und anderen Bedrohungen geschützt werden.

Pseudo-Lösungen

Sie können Ihren Computer mit ausreichend Platz ausstatten festplatte. In diesem Fall stellt sich jedoch die Frage, wie und wo Daten von einem 3-Terabyte-Laufwerk archiviert werden sollen.

Sie können zwei Festplatten einsetzen und im RAID-Spiegelmodus verwenden oder einfach regelmäßig von einer zur anderen Sicherungskopie erstellen. Dies ist auch nicht die beste Option. Angenommen, ein Computer wird von Viren angegriffen: Wahrscheinlich infizieren sie Daten auf beiden Festplatten.

Sie können wichtige Daten auf optischen Datenträgern speichern, indem Sie ein Blu-ray-Heimarchiv einrichten. Die Verwendung ist jedoch äußerst umständlich.

Network Attached Storage - Lösung! Teilweise ...

Network Attached Storage (NAS) - Netzwerkdateispeicher. Aber es kann noch einfacher erklärt werden:

Angenommen, Sie haben zwei oder drei Computer zu Hause. Höchstwahrscheinlich sind sie mit dem lokalen Netzwerk (verkabelt oder drahtlos) und dem Internet verbunden. Der Netzwerkspeicher ist ein spezialisierter Computer, der sich in Ihr Heimnetzwerk einfügt und eine Verbindung zum Internet herstellt.

Auf diese Weise kann der NAS alle Ihre Daten speichern und Sie können von jedem Heim-PC oder Laptop aus darauf zugreifen. Mit Blick auf die Zukunft sollte gesagt werden, dass das lokale Netzwerk modern genug sein muss, damit Sie schnell und einfach Dutzende und Hunderte von Gigabyte zwischen Server und Computern herunterladen können. Aber dazu später mehr.

Wo bekomme ich ein NAS?

Der erste Weg: Kauf. Mehr oder weniger anständiges NAS 2 oder 4 festplatte kann für 500-800 Dollar gekauft werden. Ein solcher Server wird in einem kleinen Karton verpackt und ist sofort einsatzbereit, sozusagen "out of the box".

Der erste Weg: Kauf. Mehr oder weniger anständiges NAS 2 oder 4 festplatte kann für 500-800 Dollar gekauft werden. Ein solcher Server wird in einem kleinen Karton verpackt und ist sofort einsatzbereit, sozusagen "out of the box".

Zu diesen 500-800 Dollar kommen jedoch noch die Kosten für Festplatten hinzu! Da NAS in der Regel ohne sie verkauft wird.

Vorteile: Sie erhalten ein fertiges Gerät und verbringen ein Minimum an Zeit.

Die Nachteile dieser Lösung: NAS ähnelt einem Desktop-Computer, verfügt jedoch über unvergleichlich weniger Funktionen. Es ist eigentlich nur ein Netzwerk externes Laufwerk für viel Geld. Für eine ganze Menge Geld erhalten Sie eine begrenzte, nachteilige Reihe von Funktionen.

Meine Lösung: Selbstmontage!

Dies ist viel billiger als der Kauf eines separaten NAS, allerdings etwas länger, weil Sie das Auto selbst zusammenbauen. Sie werden jedoch voll heimserver, die auf Wunsch im gesamten Leistungsspektrum eingesetzt werden können.

ACHTUNG!Ich rate dringend davon ab, einen Heimserver mit zu bauen alter Computer oder alte, gebrauchte Teile. Vergessen Sie nicht, dass der Dateiserver das Repository Ihrer Daten ist. Seien Sie nicht geizig, um es so zuverlässig wie möglich zu machen, damit eines Tages nicht alle Ihre Dateien zusammen mit Festplatten „ausbrennen“, z. B. aufgrund eines Fehlers im Stromkreis der Systemplatine ...

Also haben wir uns entschlossen, einen Home File Server zu bauen. Computer, festplatten die in Ihrem Heim-LAN zur Verfügung steht. Dementsprechend brauchen wir einen solchen Computer, der sparsam im Energieverbrauch ist, leise und kompakt, nicht viel Wärme erzeugt und eine ausreichende Leistung aufweist.

Die ideale Lösung auf dieser Basis ist ein Motherboard mit eingebautem Prozessor und passiver Kühlung, kompakte Größe.

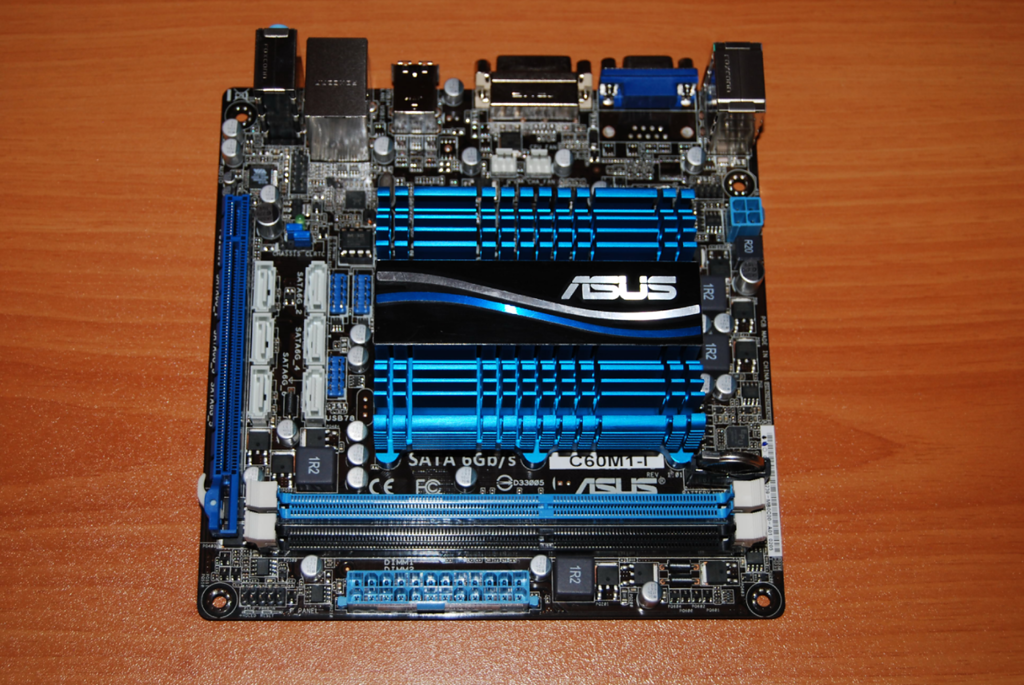

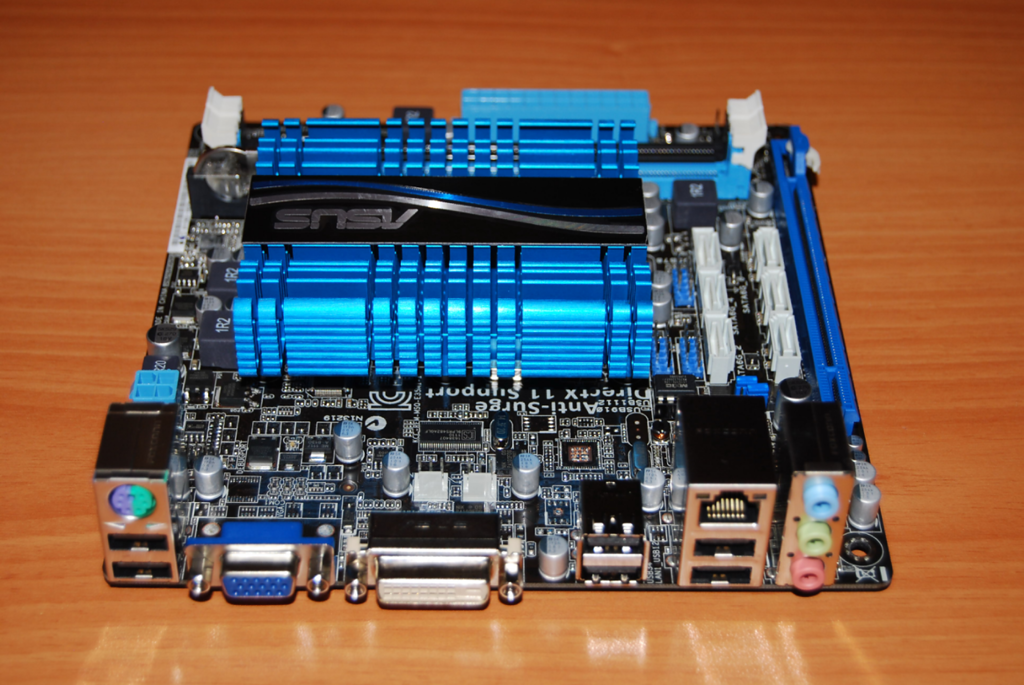

Ich habe das Motherboard gewählt ASUS S-60M1-I . Es wurde im Online-Shop dostavka.ru gekauft:

Das Paket enthält eine hochwertige Bedienungsanleitung, eine Treiber-CD, einen Aufkleber auf dem Gehäuse, 2 SATA-Kabel und eine Rückseite für das Gehäuse:

ASUS hat das Board wie immer sehr großzügig ausgestattet. Die vollständigen Board-Spezifikationen finden Sie hier: http://www.asus.com/Motherboard/C60M1I/#specifications. Ich werde nur auf einige wichtige Punkte eingehen.

Zu einem Preis von nur 3300 Rubel - Es bietet 80% von allem, was wir für den Server benötigen.

An Bord befindet sich ein Dual-Core-Prozessor AMD C-60 mit integriertem Grafikchip. Der Prozessor hat eine Frequenz 1 GHz(Kann automatisch auf 1,3 GHz ansteigen). Heute ist es in einigen Netbooks und sogar Laptops installiert. Prozessorklasse Intel Atom D2700. Aber jeder weiß, dass Atom Probleme mit dem parallelen Rechnen hat, was seine Leistung oft auf nichts reduziert. Der C-60 hat diesen Nachteil jedoch nicht und ist darüber hinaus mit einer recht leistungsstarken Grafik für diese Klasse ausgestattet.

Zwei Speicherplätze verfügbar DDR3-1066, mit der Möglichkeit, bis zu 8 GB Arbeitsspeicher zu installieren.

Die Karte enthält 6 Ports SATA 6 Gbit / s. Auf diese Weise können Sie bis zu 6 Festplatten (!) An das System anschließen und nicht nur 4, wie dies bei einem normalen NAS für zu Hause der Fall ist.

Was ist das Wichtigste? - Der Vorstand basiert auf UEFI, aber nicht das übliche BIOS. Dies bedeutet, dass das System normal mit Festplatten mit mehr als 2,2 TB arbeiten kann. Sie wird ihr gesamtes Volumen "sehen". BIOS-Motherboards können ohne spezielle „Krückendienstprogramme“ nicht mit Festplatten mit mehr als 2,2 GB betrieben werden. Die Verwendung solcher Dienstprogramme ist natürlich nicht akzeptabel, wenn es um die Zuverlässigkeit der Datenspeicherung und der Server geht.

Der S-60 ist ein eher kalter Prozessor, daher wird er nur mit einem Aluminiumkühler gekühlt. Dies reicht aus, damit die Prozessortemperatur auch bei Volllast nicht über 50-55 Grad steigt. Was ist die Norm.

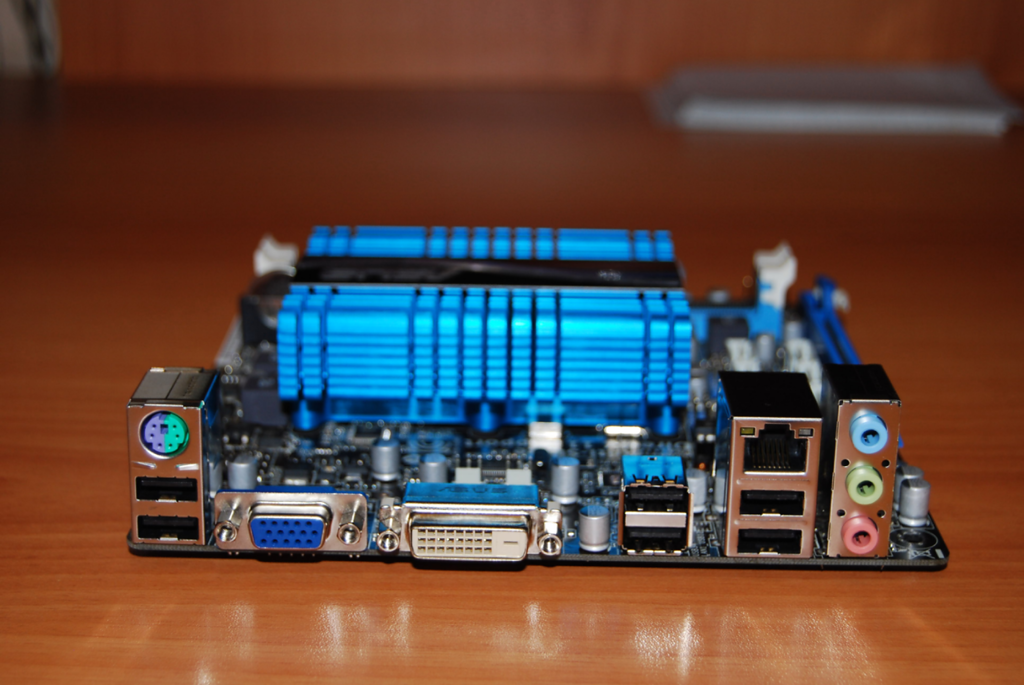

Das Port-Set ist Standard, nur das Fehlen eines neuen USB 3.0-Upsets. Und ich möchte vor allem das Vorhandensein eines vollständigen Gigabit-Netzwerkports beantworten:

Auf diesem Board habe ich 2 2 GB DDR3-1333-Module von Patriot installiert:

Windows 7 Ultimate wurde auf installiert festplatte WD 500 GB, grün, und für die Daten habe ich eine 3-TB-Hitachi-Toshiba-Festplatte gekauft:

Alle diese Geräte werden von einem 400-W-FSP-Netzteil mit Strom versorgt, was natürlich ein Gewinn ist.

Der letzte Schritt bestand darin, all diese Geräte zu einem Mini-ATX-Chassis zusammenzubauen.

Sofort nach der Montage habe ich auf installiert windows-Computer 7 Ultimate (die Installation dauerte ungefähr 2 Stunden, was angesichts der geringen Prozessorgeschwindigkeit normal ist).

Nach all dem habe ich Tastatur, Maus und Monitor vom Computer getrennt. Tatsächlich war nur eine Systemeinheit über ein Kabel mit dem LAN verbunden.

Es reicht aus, sich die lokale IP-Adresse dieses PCs im Netzwerk zu merken, um von einem beliebigen Computer über das Standard-Windows-Dienstprogramm „Remotedesktopverbindung“ eine Verbindung zu diesem Computer herzustellen:

Ich habe absichtlich keine speziellen Betriebssysteme für die Organisation der Dateispeicherung wie FreeNAS installiert. In diesem Fall wäre es in der Tat nicht sinnvoll, einen separaten PC für diese Anforderungen zusammenzustellen. Man könnte einfach ein NAS kaufen.

Interessanter ist aber ein separater Home-Server, der nachts und links mit Arbeit beladen werden kann. Darüber hinaus ist die vertraute Oberfläche von Windows 7 bequem zu verwalten.

Die Gesamtkosten für einen Heimserver OHNE Festplatten betrugen 6.000 Rubel.

Wichtiger Zusatz

Bei der Verwendung von Netzwerkspeicher ist die Netzwerkbandbreite sehr wichtig. Darüber hinaus ist selbst das übliche 100-Megabit-Kabelnetzwerk nicht begeistert, wenn Sie beispielsweise die Archivierung von Ihrem Computer auf Ihren Heimserver durchführen. Die Übertragung von 100 GB über ein 100-Mbit / s-Netzwerk dauert bereits mehrere Stunden.

Was soll ich über Wi-Fi sagen? Wenn Sie Wi-Fi 802.11n verwenden, liegt die Netzwerkgeschwindigkeit in diesem Fall bei 100 Megabits. Und wenn der Standard 802.11g ist, wo ist die Geschwindigkeit selten größer als 30 Megabit? Es ist sehr, sehr klein.

Ideal, wenn der Server über ein Kabelnetzwerk kommuniziert Gigabit-Ethernet. In diesem Fall ist es sehr schnell.

In einem separaten Artikel werde ich jedoch erläutern, wie Sie ein solches Netzwerk schnell und kostengünstig erstellen können.

Wie klassifiziere ich die Architektur von Speichersystemen? Mir scheint, dass die Relevanz dieses Themas in Zukunft noch zunehmen wird. Wie kann man die Vielfalt der auf dem Markt verfügbaren Angebote verstehen? Ich möchte Sie sofort warnen, dass dieser Beitrag nicht für die Faulen oder diejenigen gedacht ist, die nicht viel lesen wollen.

Es ist möglich, Speichersysteme recht erfolgreich zu klassifizieren, ähnlich wie Biologen familiäre Bindungen zwischen Arten lebender Organismen herstellen. Wenn Sie möchten, können Sie es den "Baum des Lebens" der Welt der Informationsspeichertechnologien nennen.

Der Bau solcher Bäume hilft, die Welt besser zu verstehen. Insbesondere können Sie ein Diagramm über die Herkunft und Entwicklung von Speichersystemen aller Art erstellen und schnell nachvollziehen, worauf die Grundlage jeder neuen Technologie auf dem Markt beruht. So können Sie sofort die Stärken und Schwächen einer Lösung ermitteln.

Repositorys, mit denen Sie architektonisch mit Informationen jeder Art arbeiten können, können in vier Hauptgruppen unterteilt werden. Die Hauptsache ist, sich nicht auf verwirrende Dinge einzulassen. Viele Leute neigen dazu, Plattformen nach solchen „physikalischen“ Kriterien wie Verbindung („Sie haben alle einen internen Bus zwischen Knoten!“) Oder einem Protokoll („Dies ist ein Block- oder NAS- oder Multiprotokollsystem!“) Zu klassifizieren. oder unterteilt in Hardware und Software ("Dies ist nur Software auf dem Server!").

Das völlig falscher Ansatz zur Klassifizierung. Das einzig wahre Kriterium ist die in einer bestimmten Lösung verwendete Softwarearchitektur, da alle grundlegenden Merkmale des Systems davon abhängen. Die übrigen Komponenten des Speichersystems hängen davon ab, welche Softwarearchitektur von den Entwicklern ausgewählt wurde. Unter diesem Gesichtspunkt können "Hardware" - und "Software" -Systeme nur Variationen dieser oder jener Architektur sein.

Aber versteh mich nicht falsch, ich möchte nicht sagen, dass der Unterschied zwischen ihnen klein ist. Es ist einfach nicht grundlegend.

Und ich möchte noch etwas klarstellen, bevor ich zur Sache komme. In unserer Natur ist es üblich, die Fragen zu stellen: „Und welches davon ist das Beste / Richtige?“. Darauf gibt es nur eine Antwort: "Es gibt bessere Lösungen für bestimmte Situationen oder Arten von Arbeitsbelastungen, aber es gibt keine universelle ideale Lösung." Genau merkmale der Last bestimmen die Wahl der Architekturund sonst nichts.

Übrigens habe ich kürzlich an einem lustigen Gespräch zum Thema Rechenzentren teilgenommen, die ausschließlich mit Flash-Laufwerken arbeiten. Ich bin beeindruckt von Leidenschaft in allen Erscheinungsformen, und es ist klar, dass Flash in Situationen, in denen Leistung und Latenz eine entscheidende Rolle spielen (neben vielen anderen Faktoren), konkurrenzlos ist. Aber ich muss zugeben, dass meine Gesprächspartner sich geirrt haben. Wir haben einen Kunden, viele Menschen nutzen seine Dienste jeden Tag, ohne es zu merken. Kann er komplett auf Flash umstellen? Nein.

Dies ist ein großartiger Kunde. Und hier ist noch einer, RIESIG, zehnmal mehr. Auch hier kann ich nicht zustimmen, dass dieser Client ausschließlich auf Flash umsteigen kann:

Normalerweise wird als Gegenargument angegeben, dass der Blitz am Ende einen solchen Entwicklungsstand erreicht, dass er in den Hintergrund tritt magnetische Antriebe. Mit der Einschränkung, dass Flash zusammen mit Deduplizierung verwendet wird. Es ist jedoch nicht in allen Fällen ratsam, sowohl Deduplizierung als auch Komprimierung anzuwenden.

Einerseits wird der Flash-Speicher bis zu einem gewissen Grad billiger. Es schien mir, dass dies etwas schneller passieren würde, aber SSDs mit einer Kapazität von 1 TB für 550 US-Dollar sind bereits verfügbar, dies ist ein großer Fortschritt. Natürlich sind die Entwickler traditioneller Festplatten auch nicht untätig. In der Region 2017-2018 sollte sich der Wettbewerb verschärfen, da neue Technologien eingeführt werden (höchstwahrscheinlich Phasenverschiebung und Kohlenstoffnanoröhren). Es geht aber überhaupt nicht um die Konfrontation zwischen Flash- und Festplattenlaufwerken oder gar Software- und Hardwarelösungen. Hauptsache architektur.

Es ist so wichtig, dass es fast unmöglich ist, die Speicherarchitektur zu ändern, ohne fast alles zu ändern. Das heißt in der Tat, ohne ein neues System zu schaffen. Aus diesem Grund werden Speicher normalerweise im Rahmen einer einzelnen, anfänglich ausgewählten Architektur erstellt, entwickelt und gelöscht.

Vier Arten von Speicher

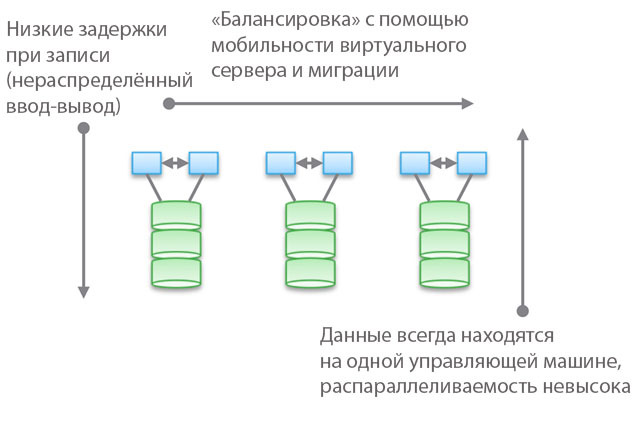

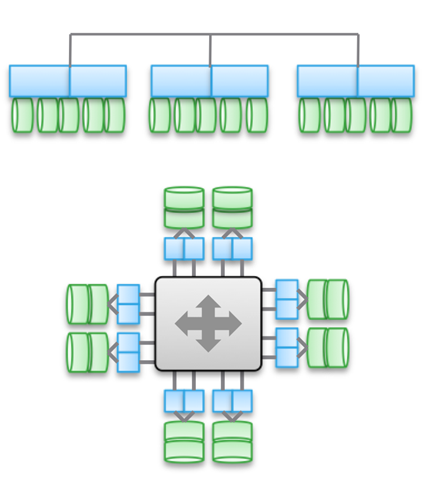

Typ 1. Clustered Architecture. Sie sind nicht vorgesehen für teilen Speicherknoten, in der Tat sind alle Daten in einem Knoten. Eines der Merkmale der Architektur ist, dass sich Geräte manchmal „überschneiden“ (Missbrauch), auch wenn sie „von mehreren Knoten aus zugänglich“ sind. Eine weitere Funktion ist, dass Sie einen Computer auswählen, ihm einige Laufwerke mitteilen und sagen können, dass dieser Computer Zugriff auf Daten auf diesen Medien hat. Das Blau in der Abbildung zeigt das CPU- / Speicher- / Eingabe- / Ausgabesystem an, und das Grün zeigt das Medium an, auf dem die Daten gespeichert sind (Flash- oder Magnetlaufwerke).

Diese Art von Architektur zeichnet sich durch direkte und sehr schneller Zugriff zu den Daten. Zwischen den Computern treten geringfügige Verzögerungen auf, da die E / A-Spiegelung und das Caching verwendet werden, um eine hohe Verfügbarkeit sicherzustellen. Im Allgemeinen wird jedoch ein relativ direkter Zugriff entlang des Code-Zweigs bereitgestellt. Software-Speicher sind recht einfach und weisen eine geringe Latenz auf, sodass sie häufig über umfangreiche Funktionen verfügen und Datendienste problemlos hinzugefügt werden können. Es überrascht nicht, dass die meisten Startups mit solchen Repositories beginnen.

Beachten Sie, dass eine der Varianten dieser Art von Architektur PCIe-Geräte für Nicht-HA-Server (Fusion-IO-, XtremeCache-Erweiterungskarten) sind. Wenn wir verteilte Speichersoftware, Kohärenz und ein HA-Modell hinzufügen, entspricht ein solcher Softwarespeicher einer der vier in diesem Beitrag beschriebenen Architekturen.

Die Verwendung von „Verbundmodellen“ trägt dazu bei, die horizontale Skalierbarkeit dieser Art von Architektur unter Verwaltungsgesichtspunkten zu verbessern. Diese Modelle können verschiedene Ansätze zur Erhöhung der Datenmobilität verwenden, um das Gleichgewicht zwischen Hostcomputern und Speicher wieder herzustellen. In VNX bedeutet dies beispielsweise "VDM-Mobilität". Ich denke jedoch, dass die Bezeichnung "horizontal skalierbare Architektur" eine Strecke sein wird. Und meiner Erfahrung nach teilen die meisten Kunden diese Ansicht. Der Grund dafür ist der Speicherort der Daten auf einer Steuerungsmaschine, manchmal "in einem Hardwareschrank" (hinter einem Gehäuse). Sie können verschoben werden, befinden sich jedoch immer an einem Ort. Auf diese Weise können Sie zum einen die Anzahl der Zyklen und die Aufzeichnungsverzögerung verringern. Auf der anderen Seite werden alle Ihre Daten von einer einzigen Steuerungsmaschine bereitgestellt (ein indirekter Zugriff von einer anderen Maschine aus ist möglich). Im Gegensatz zu der zweiten und dritten Art von Architekturen, auf die wir im Folgenden eingehen werden, spielen Balancing und Tuning hier eine wichtige Rolle.

Objektiv gesehen bedeutet diese abstrakte Bundesebene eine leichte Erhöhung der Latenz, da die Software-Umleitung verwendet wird. Dies ist vergleichbar mit der Komplizierung des Codes und der Erhöhung der Latenz in den Architekturen 2 und 3 und beseitigt teilweise die Vorteile des ersten Typs. Als konkretes Beispiel dient UCS Invicta, eine Art "Silicon Storage Router". Im Falle von NetApp FAS 8.x im Cluster-Modus ist der Code durch die Einführung eines Verbundmodells ziemlich kompliziert.

Produkte mit Cluster-Architekturen - VNX oder NetApp FAS, Pure, Tintri, Nimble, Nexenta und (glaube ich) UCS Invicta / UCS. Einige sind "Hardware" -Lösungen, andere "reine Software" und andere "Software in Form von Hardwarekomplexen". Alle von ihnen sind sehr unterschiedlich in Bezug auf die Datenverarbeitung (in Pure und UCS Invicta / Whiptail werden nur Flash-Laufwerke verwendet). Aber architektonisch sind alle aufgeführten Produkte miteinander verwandt. Beispielsweise konfigurieren Sie Datendienste ausschließlich für sicherungWenn der Software-Stack zur Datendomäne wird, fungiert Ihr NAS als das beste Backup-Tool der Welt - und dies ist auch die Architektur des „ersten Typs“.

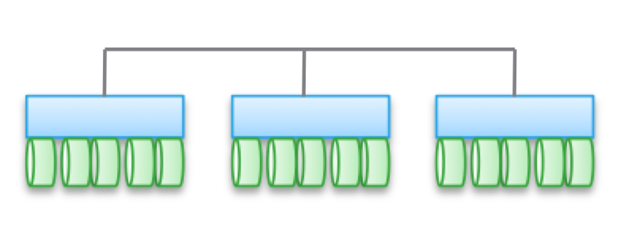

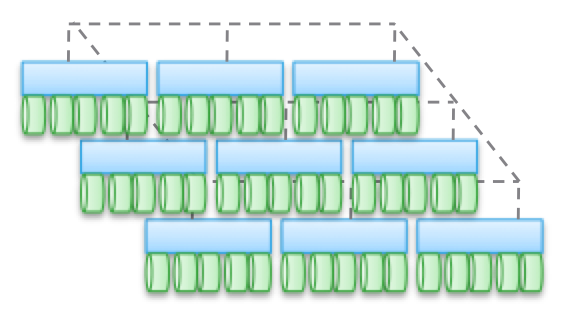

Typ 2. Schwach verbundene, horizontal skalierte Architekturen. Knoten teilen sich keinen Speicher, aber die Daten selbst sind für mehrere Knoten. Diese Architektur impliziert die Verwendung von mehr Interne Verbindungen zum Aufzeichnen von Daten, wodurch die Anzahl der Zyklen erhöht wird. Obwohl Schreibvorgänge verteilt sind, sind sie immer kohärent.

Beachten Sie, dass diese Architekturen aufgrund von Kopier- und Datenverteilungsvorgängen keine hohe Verfügbarkeit für den Knoten bieten. Aus demselben Grund gibt es im Vergleich zu einfachen Clusterarchitekturen immer mehr E / A-Vorgänge. Daher ist die Leistung trotz der geringen Aufzeichnungsverzögerung (NVRAM, SSD usw.) etwas geringer.

In einigen Architekturvarianten werden Knoten häufig zu Untergruppen zusammengefasst, während der Rest zum Verwalten von Untergruppen (Metadatenknoten) verwendet wird. Hier zeigen sich jedoch die oben für „Verbundmodelle“ beschriebenen Effekte.

Solche Architekturen sind recht einfach zu skalieren. Da Daten an mehreren Stellen gespeichert und von mehreren Knoten verarbeitet werden können, eignen sich diese Architekturen hervorragend für Aufgaben, bei denen verteiltes Lesen erforderlich ist. Darüber hinaus lassen sie sich gut mit Server- / Speichersoftware kombinieren. Es ist jedoch am besten, ähnliche Architekturen bei Transaktionslasten zu verwenden: Aufgrund ihrer verteilten Struktur können Sie keinen HA-Server verwenden und durch schwache Konjugation können Sie Ethernet umgehen.

Diese Art von Architektur wird in Produkten wie EMC ScaleIO und Isilon, VSAN, Nutanix und Simplivity verwendet. Wie beim Typ 1 unterscheiden sich alle diese Lösungen grundlegend voneinander.

Eine schwache Konnektivität bedeutet, dass diese Architekturen häufig die Anzahl der Knoten erheblich erhöhen können. Aber lassen Sie mich daran erinnern, dass sie NICHT gemeinsam Speicher belegen. Der Code jedes Knotens funktioniert unabhängig von den anderen. Aber der Teufel, wie sie im Detail sagen:

- Je mehr Aufzeichnungsvorgänge verteilt werden, desto höher ist die Latenz und desto geringer ist die Effizienz des IOP. In Isilon beispielsweise ist die Verteilungsebene für Dateien sehr hoch, und mit jedem Update werden die Verzögerungen zwar verringert, es wird jedoch nie die höchste Leistung erzielt. Aber Isilon ist extrem stark in Bezug auf Parallelisierung.

- Wenn Sie den Verteilungsgrad verringern (wenn auch mit einer großen Anzahl von Knoten), können sich die Verzögerungen verringern, gleichzeitig verringern Sie jedoch Ihre Fähigkeit, das Datenlesen zu parallelisieren. Beispielsweise verwendet VSAN das Modell "Virtuelle Maschine als Objekt", mit dem Sie mehrere Kopien ausführen können. Es scheint, dass eine virtuelle Maschine für einen bestimmten Host zugänglich sein sollte. Tatsächlich „verschiebt“ sich VSAN jedoch in Richtung des Knotens, auf dem seine Daten gespeichert sind. Wenn Sie diese Lösung verwenden, können Sie selbst sehen, wie sich das Erhöhen der Kopienanzahl eines Objekts auf die Latenz und die E / A-Vorgänge im gesamten System auswirkt. Hinweis: Mehr Kopien \u003d höhere Systemlast, und die Abhängigkeit ist erwartungsgemäß nicht linear. Für VSAN ist dies jedoch aufgrund der Vorteile der virtuellen Maschine als Objektmodell kein Problem.

- Es ist möglich, eine geringe Latenzzeit unter Bedingungen hoher Skalierung und Parallelisierung beim Lesen zu erreichen, jedoch nur, wenn Daten und Schreiben genau voneinander getrennt sind. eine große Anzahl Kopien. Dieser Ansatz wird in ScaleIO verwendet. Jedes Volume ist in eine große Anzahl von Fragmenten (standardmäßig 1 MB) unterteilt, die auf alle beteiligten Knoten verteilt sind. Das Ergebnis ist eine extrem hohe Lese- und Umverteilungsgeschwindigkeit sowie eine leistungsstarke Parallelisierung. Die Schreibverzögerung kann weniger als 1 ms betragen, wenn die entsprechende Netzwerkinfrastruktur und SSD / PCIe-Flash in den Clusterknoten verwendet werden. Jede Schreiboperation wird jedoch in zwei Knoten ausgeführt. Im Gegensatz zu VSAN wird eine virtuelle Maschine hier natürlich nicht als Objekt betrachtet. Wenn dies jedoch berücksichtigt wird, ist die Skalierbarkeit schlechter.

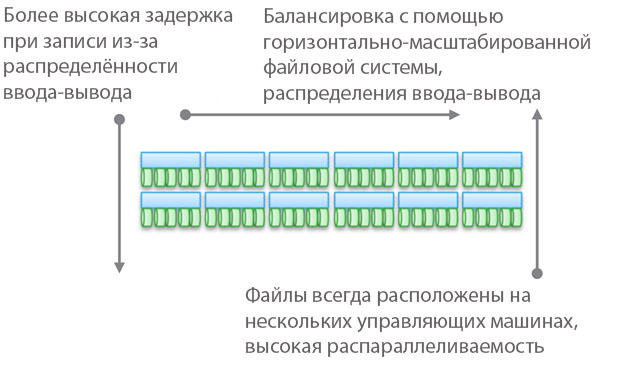

Typ 3. Stark gekoppelte, horizontal skalierte Architekturen. Hierbei wird die gemeinsame Nutzung des Arbeitsspeichers verwendet (zum Zwischenspeichern und für einige Arten von Metadaten). Daten werden auf verschiedene Knoten verteilt. Diese Art von Architektur beinhaltet die Verwendung einer sehr großen Anzahl von Intern-Knoten-Verbindungen für alle Arten von Operationen.

Das Teilen von Speicher ist der Eckpfeiler dieser Architekturen. Historisch gesehen können über alle Steuerungsmaschinen symmetrische E / A-Operationen ausgeführt werden (siehe Abbildung). Auf diese Weise können Sie die Last im Falle von Fehlfunktionen neu verteilen. Diese Idee wurde bei Produkten wie Symmetrix, IBM DS, HDS USP und VSP verwirklicht. Sie bieten gemeinsamen Zugriff auf den Cache, sodass die E / A-Prozedur von jedem Computer aus gesteuert werden kann.

Das obere Diagramm in der Abbildung zeigt die EMC XtremIO-Architektur. Auf den ersten Blick ähnelt es Typ 2, ist es aber nicht. In diesem Fall impliziert das Modell der gemeinsam genutzten verteilten Metadaten die Verwendung von IB und den direkten Remote-Speicherzugriff, sodass alle Knoten Zugriff auf die Metadaten haben. Außerdem ist jeder Knoten ein HA-Paar. Wie Sie sehen, sind Isilon und XtremIO architektonisch sehr unterschiedlich, obwohl dies nicht so offensichtlich ist. Ja, beide haben horizontal skalierte Architekturen und beide verwenden IB für die Verbindung. In Isilon wird dies im Gegensatz zu XtremIO ausgeführt, um die Latenz beim Datenaustausch zwischen Knoten zu minimieren. Es ist auch möglich, Ethernet in Isilon für die Kommunikation zwischen Knoten zu verwenden (tatsächlich funktioniert eine virtuelle Maschine auf diese Weise), dies erhöht jedoch die Verzögerungen bei Eingabe- / Ausgabe-Vorgängen. Bei XtremIO ist der direkte Remote-Speicherzugriff für die Leistung von großer Bedeutung.

Lassen Sie sich übrigens nicht durch das Vorhandensein von zwei Diagrammen in der Abbildung täuschen - tatsächlich sind sie architektonisch identisch. In beiden Fällen werden Paare von HA-Controllern, gemeinsam genutztem Speicher und Verbindungen mit sehr geringer Latenz verwendet. Übrigens verwendet VMAX einen proprietären Inter-Component-Bus, aber in Zukunft wird es möglich sein, IB zu verwenden.

Hochgekoppelte Architekturen zeichnen sich durch die hohe Komplexität des Programmcodes aus. Dies ist einer der Gründe für ihre niedrige Prävalenz. Eine übermäßige Softwarekomplexität wirkt sich auch auf die Anzahl der hinzugefügten Datenverarbeitungsdienste aus, da dies eine schwierigere Rechenaufgabe ist.

Zu den Vorteilen dieser Art von Architektur zählen Fehlertoleranz (symmetrische E / A in allen Steuerungsmaschinen) sowie im Fall von XtremIO große Chancen auf dem Gebiet der AFA. Wenn wir noch einmal über XtremIO sprechen, ist es erwähnenswert, dass seine Architektur die Verteilung aller Datenverarbeitungsdienste impliziert. Es ist auch die einzige AFA-Lösung auf dem Markt mit einer horizontal skalierten Architektur, obwohl das dynamische Hinzufügen / Deaktivieren von Knoten noch nicht implementiert wurde. XtremIO verwendet unter anderem die "natürliche" Deduplizierung, das heißt, es ist ständig aktiv und in Bezug auf die Leistung "frei". All dies erhöht zwar die Komplexität der Systemwartung.

Es ist wichtig, den grundlegenden Unterschied zwischen Typ 2 und Typ 3 zu verstehen. Je stärker die Architektur miteinander verbunden ist, desto besser und vorhersehbarer ist es, eine niedrige Latenz sicherzustellen. Andererseits ist es im Rahmen einer solchen Architektur schwieriger, Knoten hinzuzufügen und das System zu skalieren. Wenn Sie den gemeinsamen Speicherzugriff verwenden, handelt es sich um ein einzelnes, stark konjugiertes verteiltes System. Die Komplexität von Entscheidungen und damit die Wahrscheinlichkeit von Fehlern nimmt zu. Daher kann VMAX bis zu 16 Steuerfahrzeuge in 8 Motoren und XtemIO - bis zu 8 Fahrzeuge in 4 X-Brick (es wird sich bald auf 16 Fahrzeuge in 8 Blöcken erhöhen). Das Vervierfachen oder sogar Verdoppeln dieser Architekturen ist eine unglaublich schwierige technische Herausforderung. Zum Vergleich kann VSAN auf die „vSphere-Clustergröße“ (jetzt 32 Knoten) skaliert werden, Isilon kann mehr als 100 Knoten enthalten und ScaleIO ermöglicht das Erstellen eines Systems mit mehr als 1000 Knoten. Darüber hinaus ist dies alles eine Architektur des zweiten Typs.

Ich möchte noch einmal betonen, dass Architektur implementierungsunabhängig ist. Die oben genannten Produkte verwenden sowohl Ethernet als auch IB. Einige sind reine Softwarelösungen, andere sind Hardware-Software-Komplexe, die sich jedoch durch Architekturschemata verbinden.

Trotz der Vielzahl von Verbindungen spielt die Verwendung von verteilten Aufzeichnungen in allen Beispielen eine wichtige Rolle. Auf diese Weise können Sie Transaktionalität und Atomizität erzielen. Eine sorgfältige Überwachung der Datenintegrität ist jedoch erforderlich. Es ist auch notwendig, das Problem des Wachstums des „Versagensbereichs“ zu lösen. Diese beiden Punkte begrenzen den maximal möglichen Skalierungsgrad der beschriebenen Architekturarten.

Eine kleine Überprüfung, wie sorgfältig Sie alle oben genannten Informationen gelesen haben: Zu welchem \u200b\u200bTyp von Cisco UCS Invicta - 1 oder 3 gehört? Physisch sieht es wie Typ 3 aus, aber dies ist eine Reihe von USC-Servern der C-Serie, die über Ethernet verbunden sind und den Invicta-Software-Stack (früher Whiptail) ausführen. Hinweis: Sehen Sie sich die Architektur an, nicht die spezifische Implementierung

Bei UCS Invicta werden die Daten in jedem Knoten gespeichert (UCS-Server mit Flash-Laufwerken basierend auf MLC). Ein einzelner Nicht-HA-Knoten, bei dem es sich um einen separaten Server handelt, kann direkt eine LUN (Logical Unit Number) übertragen. Wenn Sie weitere Knoten hinzufügen möchten, skaliert das System möglicherweise schlecht, z. B. ScaleIO oder VSAN. All dies bringt uns zu Typ 2.

Die Erhöhung der Anzahl der Knoten erfolgt jedoch offensichtlich durch Konfiguration und Migration auf die „Invicta Scaling Appliance“. Mit dieser Konfiguration verfügen Sie über mehrere „Silicon Storage Router“ (SSRs) und einen Adressspeicher für mehrere Hardware-Knoten. Der Zugriff auf Daten erfolgt über einen einzelnen SSR-Knoten. Dies kann jedoch auch über einen anderen Knoten erfolgen, der als HA-Paar fungiert. Die Daten selbst befinden sich immer auf dem einzigen UCS-Knoten in der C-Serie. Um welche Architektur handelt es sich also? Unabhängig davon, wie die Lösung physisch aussieht, handelt es sich um Typ 1. Das SSR ist ein Cluster (möglicherweise mehr als 2). In der Konfiguration der Scaling Appliance führt jeder UCS-Server mit MLC-Laufwerken eine ähnliche Funktion aus wie VNX- oder NetApp FAS-Plattenspeicher. Obwohl nicht über SAS verbunden, ist die Architektur ähnlich.

Typ 4. Verteilte Architekturen ohne gemeinsame Nutzung von Ressourcen. Trotz der Tatsache, dass die Daten auf verschiedene Knoten verteilt sind, erfolgt dies ohne jegliche Transaktionalität. Normalerweise werden Daten auf einem Knoten gespeichert und befinden sich dort. Von Zeit zu Zeit werden aus Sicherheitsgründen Kopien auf anderen Knoten erstellt. Diese Kopien sind jedoch keine Transaktionskopien. Dies ist der Hauptunterschied zwischen dieser Art von Architektur und Typ 2 und 3.

Die Kommunikation zwischen Nicht-HA-Knoten erfolgt über Ethernet, da es billig und universell ist. Die Verteilung nach Knoten ist von Zeit zu Zeit obligatorisch. Die „Richtigkeit“ der Daten wird nicht immer eingehalten, aber der Software-Stack wird häufig überprüft, um die Richtigkeit der verwendeten Daten sicherzustellen. Bei einigen Lasttypen (z. B. HDFS) werden Daten so verteilt, dass sie sich gleichzeitig mit dem Prozess, für den sie erforderlich sind, im Speicher befinden. Diese Eigenschaft ermöglicht es uns, diese Art von Architektur als die am besten skalierbare unter allen vier zu betrachten.

Dies ist jedoch keineswegs der einzige Vorteil. Solche Architekturen sind extrem einfach und sehr einfach zu verwalten. Sie sind in keiner Weise geräteabhängig und können auf der günstigsten Hardware eingesetzt werden. Hierbei handelt es sich fast immer ausschließlich um Softwarelösungen. Diese Art von Architektur ist mit Petabytes an Daten genauso einfach zu handhaben wie mit Terabytes an anderen Daten. Hier werden Objekte und Nicht-POSIX-Dateisysteme verwendet, und beide befinden sich häufig über dem lokalen Dateisystem jedes normalen Knotens.

Diese Architekturen können mit Blöcken und Transaktionsmodellen der auf NAS basierenden Datenpräsentation kombiniert werden, was jedoch ihre Fähigkeiten stark einschränkt. Sie müssen keinen Transaktionsstapel erstellen, indem Sie Typ 1, 2 oder 3 auf Typ 4 platzieren.

Das Beste ist jedoch, dass diese Architekturen für Aufgaben "aufgedeckt" werden, für die einige Einschränkungen nicht besonders sind.

Oben habe ich ein Beispiel mit einem sehr großen Client mit 200.000 Laufwerken gegeben. Dienste wie Dropbox, Syncplicity, iCloud, Facebook, eBay, YouTube und fast alle Web 2.0-Projekte basieren auf Repositorys, die mit dem vierten Architekturtyp erstellt wurden. Alle verarbeiteten Informationen in Hadoop-Clustern sind auch in Repositorys des Typs 4 enthalten. Im Allgemeinen sind dies im Unternehmenssegment keine sehr verbreiteten Architekturen, sie gewinnen jedoch schnell an Beliebtheit.

Typ 4 liegt Produkten wie AWS S3 zugrunde (übrigens weiß niemand außerhalb von AWS, wie EBS funktioniert, aber ich bin bereit zu argumentieren, dass es sich um Typ 3 handelt), Haystack (auf Facebook verwendet), Atmos, ViPR, Ceph, Swift ( verwendet in Openstack), HDFS, Centera. Viele der aufgelisteten Produkte können eine andere Form haben. Die Art der spezifischen Implementierung wird mithilfe ihrer API festgelegt. Beispielsweise kann der ViPR-Objektstapel über die S3-, Swift-, Atmos- und sogar HDFS-Objekt-APIs implementiert werden! Auch Centera wird in Zukunft auf dieser Liste stehen. Für einige wird dies offensichtlich sein, aber Atmos und Centera werden für eine lange Zeit verwendet, jedoch in Form von APIs und nicht in Form spezifischer Produkte. Die Implementierungen können sich ändern, aber die APIs bleiben unerschütterlich, was für Kunden sehr gut ist.

Ich möchte Ihre Aufmerksamkeit noch einmal auf die Tatsache lenken, dass die „physikalische Verkörperung“ verwirrend sein kann und Sie Typ 4-Architekturen fälschlicherweise als Typ 2 klassifizieren werden, da sie oft gleich aussehen. Auf der physischen Ebene sieht eine Lösung möglicherweise wie ScaleIO, VSAN oder Nutanix aus, obwohl dies nur Ethernet-Server sind. Das Vorhandensein oder Fehlen von Transaktionalität hilft dabei, eine bestimmte Lösung richtig zu klassifizieren.

Und jetzt biete ich Ihnen einen zweiten Verifikationstest an. Schauen wir uns die UCS Invicta-Architektur an. Physisch sieht dieses Produkt wie Typ 4 aus (Server, die über Ethernet verbunden sind), aber es ist unmöglich, es architektonisch auf die entsprechenden Lasten zu skalieren, da es tatsächlich Typ 1 ist. Darüber hinaus wurde Invicta wie Pure für AFA entwickelt.

Bitte nehmen Sie meine aufrichtige Dankbarkeit für Ihre Zeit und Aufmerksamkeit, wenn Sie bis zu diesem Ort gelesen haben. Ich habe das Obige noch einmal gelesen - es ist erstaunlich, dass ich heiraten und Kinder haben konnte 🙂

Warum habe ich das alles geschrieben?

In der Welt der IT-Speicherung nehmen sie einen sehr wichtigen Platz ein, eine Art "Königreich der Pilze". Die Vielfalt der angebotenen Produkte ist sehr groß und kommt nur dem gesamten Unternehmen zugute. Aber Sie müssen in der Lage sein, all dies zu verstehen, und sich nicht erlauben, Ihren Verstand mit Marketing-Slogans und Positionierungsnuancen zu trüben. Zum Nutzen sowohl der Kunden als auch der Industrie selbst ist es notwendig, den Prozess der Gebäudelagerung zu vereinfachen. Aus diesem Grund arbeiten wir intensiv daran, den ViPR-Controller zu einer offenen, kostenlosen Plattform zu machen.

Aber das Repository selbst ist kaum aufregend. Was meine ich Stellen Sie sich eine Art abstrakte Pyramide vor, auf der sich ein "Benutzer" befindet. Nachfolgend sind die "Anwendungen" aufgeführt, die dem "Benutzer" dienen sollen. Noch niedriger ist die „Infrastruktur“ (einschließlich SDDC), die die „Anwendungen“ und dementsprechend den „Benutzer“ bedient. Ganz unten in der "Infrastruktur" befindet sich das Repository.

Das heißt, Sie können sich die Hierarchie in dieser Form vorstellen: Benutzer-\u003e Anwendung / SaaS-\u003e PaaS-\u003e IaaS-\u003e Infrastruktur. Also: Am Ende muss jede Anwendung, jeder PaaS-Stack, irgendeine Art von Information berechnen oder verarbeiten. Und diese vier Arten von Architekturen sind so konzipiert, dass sie mit unterschiedlichen Arten von Informationen und Belastungen arbeiten. In der Wichtigkeitshierarchie folgen Informationen unmittelbar dem Benutzer. Der Zweck des Vorhandenseins der Anwendung besteht darin, dem Benutzer die Möglichkeit zu geben, mit den von ihm benötigten Informationen zu interagieren. Aus diesem Grund ist die Speicherarchitektur in unserer Welt so wichtig.

Dieser Eintrag wurde veröffentlicht in Allgemein vom Autor. Lesezeichen setzen.SAS, NAS, SAN: ein Schritt in Richtung Speichernetzwerke

Eintrag

Mit der alltäglichen Komplikation von Netzwerkcomputersystemen und globalen Unternehmenslösungen begann die Welt Technologien zu fordern, die die Wiederbelebung von Unterneh(Speichersystemen) ankurbeln würden. Und jetzt bringt eine einheitliche Technologie beispiellose Leistung, enorme Skalierbarkeit und außergewöhnliche Vorteile der Gesamtbetriebskosten in das weltweite Leistungsspektrum auf dem Gebiet des Vertriebs. Die Umstände, die sich mit dem FC-AL-Standard (Fibre Channel - Arbitrated Loop) und dem darauf aufbauenden SAN (Storage Area Network) ergeben haben, versprechen eine Revolution der datenorientierten Computertechnologien.

"Die bedeutendste Speicherentwicklung, die wir in 15 Jahren gesehen haben"

Data Communications International, 21. März 1998

Die formale Definition von SAN in der Interpretation der Storage Network Industry Association (SNIA):

„Ein Netzwerk, dessen Hauptaufgabe darin besteht, Daten zwischen Computersystemen und Datenspeichern sowie zwischen den Speichersystemen selbst zu übertragen. Das SAN besteht aus einer Kommunikationsinfrastruktur, die physische Konnektivität bietet, und ist auch für die Managementebene verantwortlich, die Kommunikations-, Speicher- und Computersysteme integriert und Daten sicher und sicher überträgt. “

SNIA Technical Dictionary, Copyright der Storage Network Industry Association, 2000

Optionen zum Organisieren des Zugriffs auf Speichersysteme

Es gibt drei Hauptoptionen für die Organisation des Zugriffs auf Speichersysteme:

- SAS (Server Attached Storage), mit dem Server verbundener Speicher;

- NAS (Network Attached Storage), Netzwerkspeicher;

- SAN (Storage Area Network), ein Storage Area Network.

Betrachten wir die Topologien der entsprechenden Speichersysteme und ihre Merkmale.

SAS

Speichersystem an den Server angeschlossen. Allen geläufig ist die herkömmliche Art, das Speichersystem an eine Him Server anzuschließen, normalerweise an eine parallele SCSI-Schnittstelle.

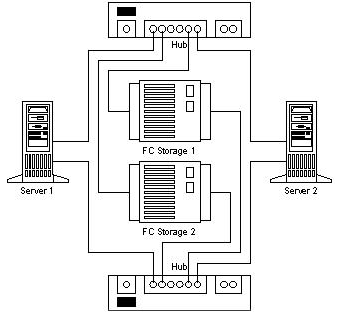

Abbildung 1. Server Attached Storage

Die Verwendung eines separaten Gehäuses für das Speichersystem in der SAS-Topologie ist optional.

Der Hauptvorteil des mit dem Server verbundenen Speichers im Vergleich zu anderen Optionen ist der niedrige Preis und die hohe Geschwindigkeit bei der Berechnung eines Speichers für einen Server. Eine solche Topologie ist am besten geeignet, wenn ein einzelner Server verwendet wird, über den der Zugriff auf das Datenarray organisiert wird. Sie hat jedoch immer noch eine Reihe von Problemen, die Designer dazu veranlassten, nach anderen Optionen für die Organisation des Zugriffs auf Speichersysteme zu suchen.

Die Funktionen von SAS umfassen:

- Der Zugriff auf Daten hängt vom Betriebssystem und dem Dateisystem ab (im Allgemeinen).

- Die Komplexität der Organisation von Systemen mit hoher Verfügbarkeit;

- Niedrige Kosten;

- Hohe Leistung in einem einzelnen Knoten;

- Reduzieren der Antwortgeschwindigkeit beim Laden des Servers, der den Speicher bereitstellt.

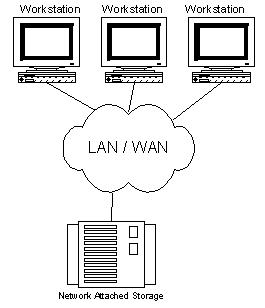

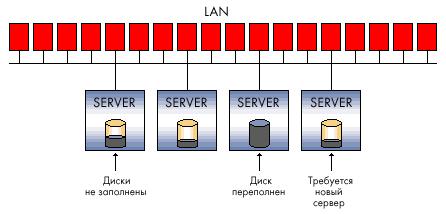

NAS

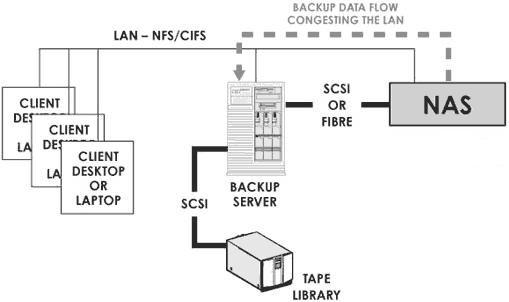

Speichersystem mit dem Netzwerk verbunden. Diese Option zum Organisieren des Zugriffs wurde vor relativ kurzer Zeit eingeführt. Sein Hauptvorteil ist die Bequemlichkeit der Integration eines zusätzlichen Speichersystems in vorhandene Netzwerke, die jedoch für sich genommen keine radikalen Verbesserungen der Speicherarchitektur mit sich bringt. Tatsächlich handelt es sich beim NAS um einen sauberen Dateiserver. Heute sind viele neue Implementierungen von NAS-Speichern zu sehen, die auf der Thin Server-Technologie (Thin Server) basieren.

Abbildung 2. Network Attached Storage.

Merkmale des NAS:

- Dedizierter Dateiserver;

- Der Zugriff auf Daten hängt nicht vom Betriebssystem und der Plattform ab.

- Bequemlichkeit der Verwaltung;

- Maximale Installationsfreundlichkeit;

- Geringe Skalierbarkeit;

- Konflikt mit LAN / WAN-Verkehr.

Der auf NAS-Technologie basierende Speicher ist ideal für kostengünstige Server mit einem Minimum an Funktionen.

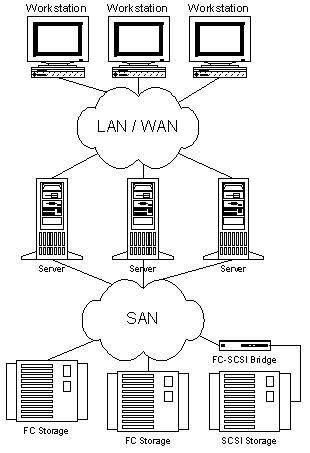

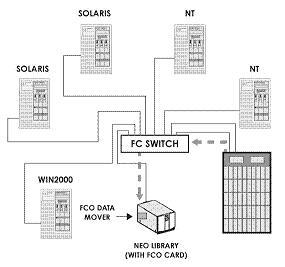

San

Speichernetzwerke begannen sich intensiv zu entwickeln und wurden erst 1999 eingeführt. Grundlage des SAN ist ein vom LAN / WAN getrenntes Netzwerk, das den Zugriff auf die Daten von Servern und Workstations organisiert, die an deren direkter Verarbeitung beteiligt sind. Ein solches Netzwerk basiert auf dem Fibre Channel-Standard, der Speichersystemen die Vorteile von LAN / WAN-Technologien und die Möglichkeit bietet, Standardplattformen für Systeme mit hoher Verfügbarkeit und hoher Abfrageintensität zu organisieren. Fast der einzige Nachteil von SAN sind heutzutage die relativ hohen Kosten für Komponenten, aber die Gesamtbetriebskosten für Unternehmenssysteme, die mithilfe von Storage Area Network-Technologie erstellt wurden, sind recht niedrig.

Abbildung 3. Storage Area Network.

Zu den Hauptvorteilen von SAN zählen fast alle Funktionen:

- Unabhängigkeit der SAN-Topologie von Speichersystemen und Servern;

- Bequeme zentrale Verwaltung;

- Kein Konflikt mit LAN / WAN-Verkehr;

- Bequeme Datensicherung ohne Laden des lokalen Netzwerks und der Server;

- Hohe Geschwindigkeit;

- Hohe Skalierbarkeit

- Hohe Flexibilität;

- Hohe Verfügbarkeit und Fehlertoleranz.

Es sollte auch beachtet werden, dass diese Technologie noch recht jung ist und in naher Zukunft zahlreiche Verbesserungen im Bereich der Standardisierung des Managements und der Interaktionsmethoden von SAN-Subnetzen erfahren sollte. Wir können aber hoffen, dass dies den Pionieren nur mit zusätzlichen Aussichten für die Meisterschaft droht.

FC als Basis für den Aufbau eines SAN

Wie ein LAN kann ein SAN mit verschiedenen Topologien und Trägern erstellt werden. Wenn Sie ein SAN erstellen, können Sie entweder eine parallele SCSI-Schnittstelle oder einen Fibre Channel oder beispielsweise SCI (Scalable Coherent Interface) verwenden, aber Fibre Channel verdankt seine stetig wachsende Beliebtheit dem SAN. Spezialisten mit großer Erfahrung in der Entwicklung von Kanal- und Netzwerkschnittstellen haben am Design dieser Schnittstelle teilgenommen und es geschafft, alle wichtigen positiven Merkmale beider Technologien zu kombinieren, um etwas wirklich Revolutionäres zu erhalten. Was genau?

Die wichtigsten hauptmerkmale Kanal:

- Geringe Latenz

- Hohe geschwindigkeiten

- Hohe Zuverlässigkeit

- Punkt-zu-Punkt-Topologie

- Kurze Abstände zwischen Knoten

- Plattformabhängigkeit

- Mehrpunkttopologien

- Lange Distanzen

- Hohe Skalierbarkeit

- Niedrige Geschwindigkeiten

- Große Verspätungen

- Hohe geschwindigkeiten

- Protokollunabhängigkeit (Stufen 0-3)

- Lange Distanzen

- Geringe Latenz

- Hohe Zuverlässigkeit

- Hohe Skalierbarkeit

- Mehrpunkttopologien

Herkömmlicherweise waren Speicherschnittstellen (was zwischen dem Host und den Speichergeräten liegt) ein Hindernis für das Anwachsen der Geschwindigkeit und die Zunahme des Volumens von Speichersystemen. Gleichzeitig erfordern angewandte Aufgaben eine erhebliche Erhöhung der Hardwarekapazitäten, was wiederum die Notwendigkeit nach sich zieht, den Durchsatz von Schnittstellen für die Kommunikation mit Speichersystemen zu erhöhen. Es sind die Probleme beim Aufbau eines flexiblen Hochgeschwindigkeits-Datenzugriffs, bei deren Lösung Fibre Channel hilft.

In den letzten Jahren (1997 bis 1999) wurde schließlich der Fibre-Channel-Standard definiert, in dem die Zusammenarbeit der Hersteller verschiedener Komponenten immens koordiniert und alles getan wurde, um sicherzustellen, dass aus Fibre-Channel eine rein konzeptionelle Technologie wurde real, die Unterstützung in Form von Installationen in Labors und Rechenzentren erhielten. Im Jahr 1997 wurden die ersten kommerziellen Entwürfe der Grundsteinkomponenten für den Bau von FC-basierten SANs wie Adapter, Hubs, Switches und Bridges entworfen. So wird FC seit 1998 im gewerblichen Bereich, in der Produktion und in Großprojekten zu kommerziellen Zwecken für die Implementierung kritischer Fehlersysteme eingesetzt.

Fibre Channel ist ein offener Industriestandard für serielle Hochgeschwindigkeitsschnittstellen. Es ermöglicht die Verbindung von Servern und Speichersystemen in einer Entfernung von 10 km (mit Standardausrüstung) mit einer Geschwindigkeit von 100 MB / s (auf der Cebit 2000 wurden Produktbeispiele vorgestellt, die den neuen Fibre Channel-Standard mit einer Geschwindigkeit von 200 MB / s verwenden ring und im Labor sind bereits Implementierungen des neuen Standards mit einer Geschwindigkeit von 400 MB / s, dh 800 MB / s bei Verwendung eines Doppelrings, in Betrieb .) Fibre Channel gleichzeitig o Unterstützt eine Reihe von Standardprotokollen (einschließlich TCP / IP und SCSI-3), wenn eines verwendet wird physische MedienDies vereinfacht möglicherweise den Aufbau der Netzwerkinfrastruktur und bietet darüber hinaus die Möglichkeit, die Installations- und Wartungskosten zu senken. Die Verwendung separater Subnetze für LAN / WAN und SAN bietet jedoch mehrere Vorteile und wird standardmäßig empfohlen.

Einer der wichtigsten Vorteile von Fibre Channel zusammen mit Hochgeschwindigkeitsparametern (die übrigens für SAN-Benutzer nicht immer wichtig sind und mit anderen Technologien implementiert werden können) ist die Fähigkeit, über große Entfernungen zu arbeiten, und die Flexibilität der Topologie, die von den Netzwerktechnologien zu einem neuen Standard geworden ist. Daher basiert das Konzept zum Aufbau einer Speichernetzwerktopologie auf denselben Prinzipien wie herkömmliche Netzwerke, die in der Regel auf Hubs und Switches basieren. Dadurch wird ein Geschwindigkeitsabfall mit zunehmender Anzahl von Knoten verhindert und die Möglichkeit geschaffen, Systeme ohne einen einzigen Ausfallpunkt komfortabel zu organisieren.

Zum besseren Verständnis der Vorteile und Merkmale dieser Schnittstelle geben wir vergleichscharakteristik FC und Parallel SCSI als Tabelle.

Tabelle 1. Vergleich von Fibre Channel- und parallelen SCSI-Technologien

Der Fibre Channel-Standard setzt die Verwendung einer Vielzahl von Topologien voraus, z. B. Punkt-zu-Punkt-, Ring- oder FC-AL-Hub (Loop oder Hub FC-AL), Trunk-Switch (Fabric / Switch).

Die Punkt-zu-Punkt-Topologie wird verwendet, um ein einzelnes Speichersystem mit dem Server zu verbinden.

Loop oder Hub FC-AL - zum Verbinden mehrerer Gerätespeicher mit mehreren Hosts. Mit der Organisation eines Doppelrings erhöhen sich die Geschwindigkeit und die Fehlertoleranz des Systems.

Switches bieten maximale Leistung und Fehlertoleranz für komplexe, große und verzweigte Systeme.

Dank der Netzwerkflexibilität verfügt SAN über eine äußerst wichtige Funktion - eine komfortable Möglichkeit, fehlertolerante Systeme zu erstellen.

SAN bietet alternative Speicherlösungen und die Möglichkeit, mehrere Speicherredundanzspeicher zu kombinieren, und trägt so zum Schutz von Hardware- und Softwaresystemen vor Hardwareausfällen bei. Zur Veranschaulichung geben wir ein Beispiel für die Erstellung eines Zwei-Einzel-Systems ohne Fehlerstellen.

Abbildung 4. Kein einzelner Fehlerpunkt.

Drei oder mehr Knotensysteme werden erstellt, indem einfach zusätzliche Server zum FC-Netzwerk hinzugefügt und an beide Hubs / Switches angeschlossen werden.

Mit FC wird der Aufbau von katastrophentoleranten Systemen transparent. Netzwerkkanäle für sowohl Speicher als auch lokales Netzwerk können auf der Basis von Glasfasern (bis zu 10 km oder mehr mit Signalverstärkern) als physikalischer Träger für FC unter Verwendung von Standardausrüstung verlegt werden, die es ermöglicht, die Kosten solcher Systeme erheblich zu senken.

Durch die Möglichkeit, von überall auf alle SAN-Komponenten zuzugreifen, erhalten wir ein äußerst flexibles Datennetzwerk. Es ist zu beachten, dass das SAN Transparenz (Sichtbarkeit) für alle Komponenten bis hin zu Festplatten in Speichersystemen bietet. Diese Funktion ermutigte Komponentenhersteller, ihre umfangreichen Erfahrungen mit Gebäudemanagementsystemen für LAN / WAN zu nutzen, um umfassende Überwachungs- und Verwaltungsfunktionen für alle SAN-Komponenten bereitzustellen. Diese Funktionen umfassen die Überwachung und Verwaltung einzelner Knoten, Komponentenspeicher, Gehäuse, Netzwerkgeräte und Netzwerkunterstrukturen.

Das SAN-Verwaltungs- und Überwachungssystem verwendet offene Standards wie:

- SCSI-Befehlssatz

- SCSI-Gehäusedienste (SES)

- SCSI-Technologie für die Selbstüberwachung, Analyse und Berichterstellung (S.M.A.R.T.)

- SAF-TE (SCSI Accessed Fault Tolerant Enclosures)

- Simple Network Management Protocol (SNMP)

- Webbasiertes Unternehmensmanagement (WBEM)

Mithilfe von SAN-Technologien erstellte Systeme bieten dem Administrator nicht nur die Möglichkeit, die Entwicklung und den Status von Ressourcenressourcen zu überwachen, sondern bieten auch Möglichkeiten zur Überwachung und Steuerung des Datenverkehrs. Dank dieser Ressourcen implementiert die SAN-Verwaltungssoftware die effektivsten Schemata zur Planung des Umsatzvolumens und zum Lastausgleich für Systemkomponenten.

Speichernetzwerke lassen sich nahtlos in vorhandene Informationsinfrastrukturen integrieren. Ihre Implementierung erfordert keine Änderungen an den vorhandenen LAN- und WAN-Netzwerken, sondern erweitert lediglich die Funktionen vorhandener Systeme und erspart ihnen Aufgaben, die auf die Übertragung großer Datenmengen abzielen. Darüber hinaus ist es bei der Integration und Verwaltung des SAN sehr wichtig, dass die Schlüsselelemente des Netzwerks Hot-Swap und Installation mit Funktionen unterstützen dynamische Konfiguration. So kann der Administrator die eine oder andere Komponente hinzufügen oder ersetzen, ohne das System herunterzufahren. Der gesamte Integrationsprozess kann in einem grafischen SAN-Managementsystem visuell dargestellt werden.

Unter Berücksichtigung der oben genannten Vorteile können wir eine Reihe von wichtigen Punkten hervorheben, die einen der Hauptvorteile des Storage Area Network direkt betreffen - die Gesamtbetriebskosten (Total Cost Ownership).

Dank der unglaublichen Skalierbarkeit kann ein Unternehmen, das SAN verwendet, bei Bedarf in Server und Speicher investieren. Und auch, um beim Wechsel der technologischen Generationen Investitionen in bereits installierte Geräte zu sparen. Jeden neuer Server Es wird die Möglichkeit bieten, einen Hochgeschwindigkeitszugriff auf die Speicher bereitzustellen, und jedes zusätzliche Gigabyte Speicher steht allen Subnetzservern auf Befehl des Administrators zur Verfügung.

Hervorragende Funktionen zum Aufbau von Ausfallsicherheit können direkte wirtschaftliche Vorteile bringen, indem Ausfallzeiten minimiert und das System im Falle einer Naturkatastrophe oder einer anderen Katastrophe gerettet werden.

Die Steuerbarkeit der Komponenten und die Transparenz des Systems ermöglichen die zentrale Verwaltung aller Ressourcen, was wiederum die Kosten für deren Support erheblich senkt, deren Kosten in der Regel mehr als 50% der Gerätekosten betragen.

Auswirkungen von SAN auf Anwendungen

Um unseren Lesern zu verdeutlichen, wie praktisch die in diesem Artikel diskutierten Technologien sind, geben wir einige Beispiele für angewandte Aufgaben, die ohne Speichernetzwerke ineffizient gelöst würden, enorme finanzielle Investitionen erfordern würden oder mit Standardmethoden überhaupt nicht gelöst würden.

Datensicherung und Wiederherstellung

Über die herkömmliche SCSI-Schnittstelle stößt der Benutzer beim Erstellen von Sicherungs- und Wiederherstellungssystemen auf eine Reihe komplexer Probleme, die mit SAN- und FC-Technologien sehr einfach gelöst werden können.

Durch die Verwendung von Speichernetzwerken wird die Lösung für die Sicherungs- und Wiederherstellungsaufgaben auf ein neues Niveau gebracht und die Möglichkeit geboten, mehrmals schneller als zuvor zu sichern, ohne das lokale Netzwerk und die Server mit Datensicherungsarbeiten zu belasten.

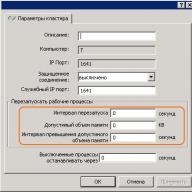

Server-Clustering

Eine der typischen Aufgaben, für die SAN effektiv verwendet wird, ist das Server-Clustering. Da einer der Schlüsselpunkte bei der Organisation von Hochgeschwindigkeits-Clustersystemen, die mit Daten arbeiten, der Zugriff auf den Speicher ist, wird mit dem Aufkommen von SAN der Aufbau von Multimode-Clustern auf Hardwareebene durch einfaches Hinzufügen eines Servers mit einer Verbindung zum SAN gelöst (dies kann durchgeführt werden, ohne das System herunterzufahren, da FC-Switches unterstützen Hot-Plug). Bei Verwendung einer parallelen SCSI-Schnittstelle, deren Konnektivität und Skalierbarkeit viel schlechter ist als die von FC, wäre es schwierig, datenorientierte Cluster mit mehr als zwei Knoten zu erstellen. Parallele SCSI-Switches sind sehr komplexe und teure Geräte und für FC eine Standardkomponente. Um einen Cluster zu erstellen, der keinen einzigen Ausfallpunkt aufweist, ist es ausreichend, ein gespiegeltes SAN (DUAL Path-Technologie) in das System zu integrieren.

Im Zusammenhang mit Clustering scheint eine der RAIS-Technologien (Redundant Array of Inexpensive Server) besonders attraktiv für den Aufbau leistungsfähiger skalierbarer E-Commerce-Systeme und anderer Arten von Aufgaben mit hohem Leistungsbedarf zu sein. Laut Alistair A. Croll, Mitbegründer von Networkshop Inc, ist die Verwendung von RAIS recht effektiv: „Für 12.000 bis 15.000 US-Dollar kann man beispielsweise ungefähr sechs kostengünstige Single-Dual-Prozessor-Linux / Apache-Server (Pentium III) kaufen. Die Leistung, Skalierbarkeit und Fehlertoleranz eines solchen Systems ist erheblich höher als zum Beispiel bei einem einzelnen Server mit vier Prozessoren, der auf Xeon-Prozessoren basiert. Die Kosten sind jedoch gleich. “

Gleichzeitiger Zugriff auf Video und Datenverteilung (gleichzeitiges Video-Streaming, Datenaustausch)

Stellen Sie sich eine Aufgabe vor, wenn Sie Videos bearbeiten oder nur an mehreren Stationen (z. B.\u003e 5) große Datenmengen bearbeiten müssen. Das Übertragen einer 100-GB-Datei über ein lokales Netzwerk dauert einige Minuten, und das gemeinsame Bearbeiten ist eine sehr schwierige Aufgabe. Bei Verwendung von SAN greifen alle Arbeitsstationen und Netzwerkserver mit einer Geschwindigkeit auf die Datei zu, die einer lokalen Hochgeschwindigkeitsfestplatte entspricht. Wenn Sie eine andere Station / einen anderen Server für die Datenverarbeitung benötigen, können Sie diese / n dem SAN hinzufügen, ohne das Netzwerk auszuschalten. Verbinden Sie einfach die Station mit dem SAN-Switch und gewähren Sie ihr Zugriffsrechte auf den Speicher. Wenn Sie mit der Leistung des Datensubsystems nicht mehr zufrieden sind, können Sie einfach einen weiteren Speicher hinzufügen und mithilfe der Datenverteilungstechnologie (z. B. RAID 0) die Leistung verdoppeln.

SAN-Kernkomponenten

Mittwoch

Fibre Channel verwendet Kupfer- und optische Kabel, um Komponenten zu verbinden. Beide Kabeltypen können beim Aufbau eines SAN gleichzeitig verwendet werden. Die Schnittstellenkonvertierung erfolgt mit GBIC (Gigabit Interface Converter) und MIA (Media Interface Adapter). Beide Kabeltypen bieten heute die gleiche Datenrate. Kupferkabel werden für kurze Entfernungen (bis zu 30 Meter), optische Kabel für kurze Entfernungen und Entfernungen von bis zu 10 km und mehr verwendet. Verwenden Sie optische Multimode- und Singlemode-Kabel. Multimode-Kabel werden für kurze Entfernungen (bis zu 2 km) verwendet. Der Innendurchmesser des Multimode-Glasfaserkabels beträgt 62,5 oder 50 Mikrometer. Um eine Übertragungsgeschwindigkeit von 100 MB / s (200 MB / s im Duplexmodus) bei Verwendung von Multimode-Glasfasern zu gewährleisten, sollte die Kabellänge 200 Meter nicht überschreiten. Singlemode-Kabel wird für lange Strecken verwendet. Die Länge eines solchen Kabels ist durch die Leistung des im Signalgeber verwendeten Lasers begrenzt. Der Innendurchmesser eines Singlemode-Kabels beträgt 7 oder 9 Mikrometer, es liefert einen einzigen Strahlengang.

Steckverbinder, Adapter

Zum Anschließen von Kupferkabeln werden DB-9- oder HSSD-Stecker verwendet. HSSD gilt als zuverlässiger, aber der DB-9 wird genauso oft verwendet, weil er einfacher und billiger ist. Der Standardstecker (am häufigsten verwendet) für optische Kabel ist der SC-Stecker, der eine qualitativ hochwertige und klare Verbindung bietet. Bei normalen Verbindungen werden Multimode-SC-Anschlüsse und bei Remoteverbindungen Single-Mode-SC-Anschlüsse verwendet. Multiport-Adapter verwenden Mikroanschlüsse.

Die gängigsten Adapter für FC befinden sich unter dem PCI-64-Bit-Bus. Außerdem werden viele FC-Adapter unter dem S-BUS hergestellt, für den speziellen Einsatz sind Adapter für MCA, EISA, GIO, HIO, PMC und Compact PCI erhältlich. Am beliebtesten sind Single-Port-, Zwei- und Vier-Port-Karten. Bei PCI-Adaptern werden in der Regel DB-9-, HSSD- und SC-Anschlüsse verwendet. Es gibt auch GBIC-basierte Adapter, die mit oder ohne GBIC-Module geliefert werden. Fibre Channel-Adapter unterscheiden sich durch die von ihnen unterstützten Klassen und eine Vielzahl von Funktionen. Um die Unterschiede zu verstehen, geben wir eine Vergleichstabelle der von QLogic hergestellten Adapter an.

| Fibre Channel Host Bus Adapter-Produktfamilie | ||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Sanblade | 64 bit | FCAL Publ. Pvt-Schleife | Fl port | Klasse 3 | F port | Klasse 2 | Punkt zu Punkt | IP / SCSI | Vollduplex | FC-Band | PCI 1.0 Hot Plug-Spezifikation | Solaris Dynamic Reconfig | VIB | 2 gb |

| 2100 Series | 33 & 66 MHz PCI | X | X | X | ||||||||||

| 2200 Series | 33 & 66 MHz PCI | X | X | X | X | X | X | X | X | X | ||||

| 33 MHz PCI | X | X | X | X | X | X | X | X | X | X | ||||

| 25 MHz Sbus | X | X | X | X | X | X | X | X | X | X | ||||

| 2300 Series | 66 MHz PCI / 133 MHz PCI-X | X | X | X | X | X | X | X | X | X | X | X | ||

Naben

Fibre-Channel-Hubs (Hubs) werden zum Verbinden von Knoten mit dem FC-Ring (FC-Loop) verwendet und haben eine ähnliche Struktur wie Token-Ring-Hubs. Da ein Ringbruch zu einer Netzwerkunterbrechung führen kann, verwenden moderne FC-Hubs PBC-Port-Bypass-Schaltkreise, mit denen Sie den Ring automatisch öffnen / schließen können (Verbinden / Trennen von mit dem Hub verbundenen Systemen). In der Regel unterstützen FC-HUBs bis zu 10 Verbindungen und können bis zu 127 Ports pro Ring stapeln. Alle an den HUB angeschlossenen Geräte erhalten eine gemeinsame Bandbreite, die sie untereinander teilen können.

Schalter

Fibre Channel-Switches (Switches) haben dieselben Funktionen wie die LAN-Switches des Readers. Sie bieten eine schnelle, nicht blockierende Verbindung zwischen Knoten. Jeder an einen FC-Switch angeschlossene Knoten erhält die volle Bandbreite (mit Skalierbarkeit). Mit zunehmender Anzahl der Ports eines Switch-Netzwerks steigt dessen Durchsatz. Switches können zusammen mit Hubs (die für Abschnitte verwendet werden, die kein dediziertes Durchlassband für jeden Knoten erfordern) verwendet werden, um das optimale Preis- / Leistungsverhältnis zu erzielen. Aufgrund der Kaskadierung können mit Switches möglicherweise FC-Netzwerke mit 2 bis 24 Adressen (über 16 Millionen) erstellt werden.

Brücken

FC-Bridges (Bridges oder Multiplexer) dienen zum Verbinden von Geräten mit parallelem SCSI mit dem FC-basierten Netzwerk. Sie bieten die Übersetzung von SCSI-Paketen zwischen Fibre Channel- und Parallel SCSI-Geräten, beispielsweise Solid State Disk (SSD) oder Bandbibliotheken. Es sei darauf hingewiesen, dass in in letzter Zeit Fast alle Geräte, die im Rahmen des SAN entsorgt werden können, werden von den Herstellern mit einer integrierten FC-Schnittstelle für den direkten Anschluss an Speichernetzwerke hergestellt.

Server und Speicher

Trotz der Tatsache, dass Server und Speicher weit von den am wenigsten wichtigen SAN-Komponenten entfernt sind, werden wir uns nicht mit deren Beschreibung befassen, da wir sicher sind, dass alle unsere Leser mit ihnen vertraut sind.

Abschließend möchte ich hinzufügen, dass dieser Artikel nur der erste Schritt zu Speichernetzwerken ist. Um das Thema vollständig zu verstehen, sollte der Leser den Funktionen der Implementierung von Komponenten durch SAN-Hersteller und Verwaltungssoftware große Aufmerksamkeit widmen, da das Storage Area Network ohne diese nur eine Reihe von Elementen zum Wechseln von Speichersystemen darstellt, die Ihnen nicht den vollen Nutzen der Implementierung eines Speichernetzwerks bringen.

Fazit

Heute ist das Storage Area Network eine relativ neue Technologie, die sich bei Unternehmenskunden bald verbreiten kann. In Europa und den USA beginnen Unternehmen mit einer relativ großen Flotte installierter Speichersysteme bereits, auf Speichernetzwerke umzusteigen, um Speicher mit dem besten Indikator für die Gesamtbetriebskosten zu organisieren.

Laut Analysten wird 2005 eine beträchtliche Anzahl von Servern der mittleren und höchsten Ebene mit einer vorinstallierten Fibre-Channel-Schnittstelle ausgeliefert (dieser Trend ist heute zu erkennen), und nur eine parallele SCSI-Schnittstelle wird für die interne Festplattenverbindung in den Servern verwendet. Schon heute, beim Aufbau von Speichersystemen und beim Erwerb von Servern der mittleren und oberen Ebene, sollte man auf diese vielversprechende Technologie achten, zumal es heute möglich ist, eine Reihe von Aufgaben viel billiger umzusetzen als mit speziellen Lösungen. Wenn Sie heute in SAN-Technologie investieren, werden Sie Ihre Investitionen morgen nicht verlieren, da die Funktionen von Fibre Channel hervorragende Möglichkeiten für die zukünftige Nutzung von Investitionen heute schaffen.

P.S.

Die vorherige Version des Artikels wurde im Juni 2000 verfasst, aber aufgrund des fehlenden Masseninteresses an der Technologie von Speichernetzwerken wurde die Veröffentlichung für die Zukunft verschoben. Diese Zukunft ist heute gekommen, und ich hoffe, dass dieser Artikel den Leser ermutigen wird, die Notwendigkeit zu erkennen, auf Speichernetzwerktechnologie als fortschrittliche Technologie zum Aufbau von Speichersystemen und zum Organisieren des Zugriffs auf Daten umzusteigen.

DAS, SAN, NAS - magische Abkürzungen, ohne die kein einziger Artikel oder eine einzige analytische Untersuchung von Speichersystemen auskommt. Sie dienen als Bezeichnung der Hauptverbindungsarten zwischen Speichersystemen und Rechnersystemen.

Das (direkt angeschlossener Speicher) - Gerät externer Speicherdirekt mit dem Hauptcomputer verbunden und nur von ihm verwendet. Das einfachste Beispiel für DAS ist eine integrierte Festplatte. Um den Host in einer typischen DAS-Konfiguration mit externem Speicher zu verbinden, wird SCSI verwendet, mit dessen Befehlen Sie einen bestimmten Datenblock auf einer bestimmten Festplatte auswählen oder eine bestimmte Kassette in eine Bandbibliothek einbinden können.

DAS-Konfigurationen sind für die Anforderungen an Speicher, Kapazität und Zuverlässigkeit akzeptabel. DAS bietet nicht die Möglichkeit, Speicherkapazität zwischen verschiedenen Hosts gemeinsam zu nutzen, und noch weniger die Möglichkeit, Daten gemeinsam zu nutzen. Die Installation solcher Speichergeräte ist im Vergleich zu Netzwerkkonfigurationen eine kostengünstigere Option. Angesichts der großen Unternehmen kann diese Art der Speicherinfrastruktur jedoch nicht als optimal angesehen werden. Bei vielen DAS-Verbindungen handelt es sich um Inseln mit externem Speicher, die im gesamten Unternehmen verstreut sind und deren Überschuss nicht von anderen Hostcomputern verwendet werden kann, was im Allgemeinen zu einer ineffizienten Verschwendung von Speicherkapazität führt.

Darüber hinaus gibt es bei einer solchen Speicherorganisation keine Möglichkeit, einen einzigen Verwaltungspunkt für den externen Speicher zu schaffen, was die Prozesse der Datensicherung / -wiederherstellung unweigerlich verkompliziert und ein ernstes Problem des Informationsschutzes schafft. Infolgedessen können die Gesamtbetriebskosten eines solchen Speichersystems erheblich höher sein als die auf den ersten Blick komplexeren und anfangs teureren Netzwerkkonfigurationen.

San

Wenn wir heute von einem Speichersystem auf Unternehmensebene sprechen, meinen wir Netzwerkspeicher. Der Öffentlichkeit besser bekannt ist das Speichernetz - SAN (Storage Area Network). SAN ist ein dediziertes Netzwerk von Speichergeräten, mit dem mehrere Server die gesamte Ressource des externen Speichers nutzen können, ohne das lokale Netzwerk zu belasten.

SAN ist unabhängig vom Übertragungsmedium, derzeit ist jedoch die Fibre Channel (FC) -Technologie der Standard, die eine Datenübertragungsrate von 1 bis 2 Gbit / s bietet. Im Gegensatz zu herkömmlichen SCSI-basierten Übertragungsmedien können Sie mit Fibre Channel bei einer Konnektivität von nicht mehr als 25 Metern in Entfernungen von bis zu 100 km arbeiten. Fibre Channel-Netzwerkmedien können entweder Kupfer oder Glasfaser sein.

Die Festplatte kann eine Verbindung zum Speichernetzwerk herstellen rAID-Arrays, einfache Disk-Arrays (das sogenannte Just a Bunch of Disks - JBOD), Band- oder magnetooptische Bibliotheken zur Datensicherung und -archivierung. Die Hauptkomponenten für eine Organisation sAN Neben den Speichergeräten selbst gibt es Adapter zum Verbinden von Servern mit dem Fibre Channel-Netzwerk (Host Bus Adapter - NVA), Netzwerkgeräte zur Unterstützung der einen oder anderen FC-Netzwerktopologie und spezielle Softwaretools zum Verwalten des Speichernetzwerks. Diese Softwaresysteme können sowohl auf dem Allzweck-Server als auch auf den Speichergeräten selbst ausgeführt werden. Manchmal werden jedoch einige Funktionen zur Verwaltung des Speichernetzwerks (SAN-Appliance) auf einen speziellen Thin Server übertragen.

Das Ziel der SAN-Software ist in erster Linie die zentrale Verwaltung des Speichernetzwerks, einschließlich der Konfiguration, Überwachung, Steuerung und Analyse von Netzwerkkomponenten. Eine der wichtigsten Funktionen ist die Zugriffssteuerung auf Festplatten-Arrays, wenn heterogene Server im SAN gespeichert sind. In Speichernetzwerken können mehrere Server gleichzeitig auf mehrere Festplattensubsysteme zugreifen und jeden Host bestimmten Festplatten in einem bestimmten Festplattenarray zuordnen. Für verschiedene Betriebssysteme ist es erforderlich, das Festplatten-Array in logische Einheiten (LUNs) zu unterteilen, die sie ohne Konflikte verwenden. Die Zuweisung logischer Bereiche kann erforderlich sein, um den Zugriff auf dieselben Daten für einen bestimmten Serverpool zu organisieren, z. B. für Server derselben Arbeitsgruppe. Spezielle Softwaremodule sind für die Unterstützung all dieser Vorgänge verantwortlich.

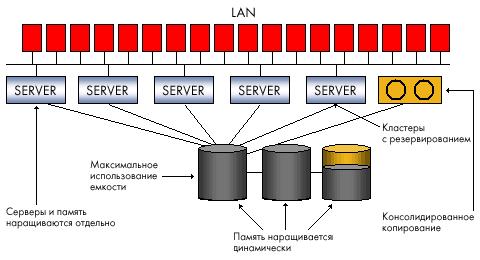

Die Attraktivität von Speichernetzwerken erklärt sich aus den Vorteilen, die sie Unternehmen bieten können, die die Effizienz der Arbeit mit großen Datenmengen fordern. Ein dediziertes Speichernetzwerk entlastet das Hauptnetzwerk (lokal oder global) von Computerservern und Client-Arbeitsstationen und befreit es von Dateneingabe- / -ausgabestreams.

Dieser Faktor sowie das für SAN verwendete Hochgeschwindigkeitsübertragungsmedium sorgen für eine höhere Produktivität der Datenaustauschprozesse mit externen Speichersystemen. SAN bedeutet die Konsolidierung von Speichersystemen, die Erstellung eines einzigen Ressourcenpools auf verschiedenen Medien, der von der gesamten Rechenleistung gemeinsam genutzt wird. Infolgedessen kann die erforderliche externe Speicherkapazität mit weniger Subsystemen bereitgestellt werden. In SAN werden Daten von Festplattensubsystemen auf Bändern außerhalb des lokalen Netzwerks gesichert und sind daher effizienter. Eine Bandbibliothek kann zum Sichern von Daten von mehreren Festplattensubsystemen verwendet werden. Darüber hinaus ist es mit der Unterstützung der entsprechenden Software möglich, eine direkte Sicherung im SAN ohne Beteiligung des Servers zu implementieren, wodurch der Prozessor entladen wird. Die Möglichkeit, Server und Speicher über große Entfernungen bereitzustellen, erfüllt die Anforderungen zur Verbesserung der Zuverlässigkeit von Enterprise Data Warehouses. Die konsolidierte Datenspeicherung im SAN lässt sich besser skalieren, da Sie die Speicherkapazität unabhängig von Servern erhöhen können, ohne deren Arbeit zu unterbrechen. Schließlich ermöglicht das SAN die zentrale Verwaltung eines einzelnen Pools von externem Speicher, wodurch die Verwaltung vereinfacht wird.

Speichernetzwerke sind natürlich eine teure und schwierige Lösung, und obwohl heute alle führenden Anbieter SAN-Geräte auf Fibre-Channel-Basis herstellen, ist ihre Kompatibilität nicht garantiert, und die Auswahl der richtigen Geräte ist für die Benutzer problematisch. Für die Organisation eines dedizierten Netzwerks und den Kauf von Verwaltungssoftware fallen zusätzliche Kosten an. Die anfänglichen Kosten für das SAN sind höher als für die Organisation des Speichers mithilfe von DAS, die Gesamtbetriebskosten sollten jedoch niedriger sein.

NAS

Im Gegensatz zu SAN ist NAS (Network Attached Storage) kein Netzwerk, sondern ein Netzwerkspeichergerät, genauer gesagt ein dedizierter Dateiserver, an den ein Festplattensubsystem angeschlossen ist. Manchmal ist in der NAS-Konfiguration eine optische Bibliothek oder eine Bandbibliothek enthalten. Das NAS-Gerät (NAS-Gerät) ist direkt mit dem Netzwerk verbunden und ermöglicht dem Host den Zugriff auf Dateien auf seinem integrierten externen Speichersubsystem. Das Aufkommen dedizierter Dateiserver ist mit der Entwicklung des NFS-Netzwerkdateisystems durch Sun Microsystems in den frühen 90er-Jahren verbunden, mit dem Clientcomputer im lokalen Netzwerk Dateien auf einem Remoteserver verwenden konnten. Dann entwickelte Microsoft ein ähnliches System für die Windows-Umgebung - das Common Internet File System. NAS-Konfigurationen unterstützen beide Systeme sowie andere IP-basierte Protokolle und ermöglichen die gemeinsame Nutzung von Dateien für Clientanwendungen.

Das NAS-Gerät ähnelt der DAS-Konfiguration, unterscheidet sich jedoch grundlegend davon, indem es den Zugriff auf Dateiebene und nicht auf Datenblöcke ermöglicht und es allen Anwendungen im Netzwerk ermöglicht, Dateien auf ihren Datenträgern gemeinsam zu nutzen. NAS gibt eine Datei im Dateisystem, den Versatz in dieser Datei (der als Folge von Bytes dargestellt wird) und die Anzahl der zu lesenden oder zu schreibenden Bytes an. Eine Anfrage an ein NAS-Gerät ermittelt nicht das Volume oder den Sektor auf der Festplatte, auf der sich die Datei befindet. Herausforderung betriebssystem NAS-Geräte übersetzen den Zugriff auf eine bestimmte Datei in eine Anforderung auf Datenblockebene. Der Dateizugriff und die Möglichkeit, Informationen gemeinsam zu nutzen, sind praktisch für Anwendungen, die viele Benutzer gleichzeitig bedienen sollen, jedoch nicht das Herunterladen sehr großer Datenmengen für jede Anforderung erfordern. Daher ist es gängige Praxis, NAS für Internetanwendungen, Webdienste oder CAD zu verwenden, bei denen Hunderte von Spezialisten an einem Projekt arbeiten.

Die NAS-Option ist einfach zu installieren und zu verwalten. Im Gegensatz zum Speichernetzwerk erfordert die Installation eines NAS-Geräts keine spezielle Planung und die Kosten für zusätzliche Verwaltungssoftware. Verbinden Sie einfach den Dateiserver mit dem lokalen Netzwerk. Der NAS befreit Server im Netzwerk von Speicherverwaltungsaufgaben, verlagert jedoch nicht den Netzwerkverkehr, da Daten zwischen Allzweckservern und dem NAS im selben lokalen Netzwerk ausgetauscht werden. Einer oder mehrere können auf dem NAS konfiguriert werden dateisysteme, denen jeweils ein bestimmter Satz von Datenträgern auf der Festplatte zugewiesen ist. Allen Benutzern desselben Dateisystems wird bei Bedarf Speicherplatz zugewiesen. Somit bietet der NAS eine effizientere Organisation und Verwendung von Speicherressourcen als DAS, da das direkt verbundene Speichersubsystem nur eine Rechenressource bedient und es vorkommen kann, dass ein Server im lokalen Netzwerk zu viel externen Speicher hat Ein anderer hat nicht mehr genügend Speicherplatz. Sie können jedoch nicht einen einzigen Pool von Speicherressourcen von mehreren NAS-Geräten aus erstellen. Eine Erhöhung der Anzahl der NAS-Knoten im Netzwerk erschwert daher die Verwaltungsaufgabe.

NAS + SAN \u003d?

Welche Art von Speicherinfrastruktur soll gewählt werden: NAS oder SAN? Die Antwort hängt von den Fähigkeiten und Bedürfnissen des Unternehmens ab. Es ist jedoch grundsätzlich falsch, diese zu vergleichen oder sogar gegenüberzustellen, da diese beiden Konfigurationen unterschiedliche Probleme lösen. Der Dateizugriff und die gemeinsame Nutzung von Informationen für Anwendungen auf heterogenen Serverplattformen im lokalen Netzwerk ist der NAS. Leistungsstarker Blockzugriff auf Datenbanken, Speicherkonsolidierung, Gewährleistung der Zuverlässigkeit und Effizienz - das sind SANs. Im Leben ist jedoch alles komplizierter. NAS und SAN existieren häufig bereits zusammen oder müssen gleichzeitig in der verteilten IT-Infrastruktur des Unternehmens implementiert werden. Dies führt zwangsläufig zu Problemen bei der Verwaltung und Speichernutzung.

Heute suchen Hersteller nach Möglichkeiten, beide Technologien in eine einzige Netzwerkspeicherinfrastruktur zu integrieren, die Daten konsolidiert, Sicherungen zentralisiert, die allgemeine Verwaltung, Skalierbarkeit und den Datenschutz vereinfacht. Die Konvergenz von NAS und SAN ist einer der wichtigsten Trends der letzten Zeit.

Über das Speichernetzwerk können Sie einen einzelnen Pool von Speicherressourcen erstellen und auf physischer Ebene das erforderliche Kontingent an Speicherplatz für jeden mit dem SAN verbundenen Host zuweisen. Der NAS-Server ermöglicht die gemeinsame Nutzung von Daten im Dateisystem durch Anwendungen auf verschiedenen Betriebssystemen und löst so die Probleme bei der Interpretation der Dateisystemstruktur sowie bei der Synchronisierung und Kontrolle des Zugriffs auf dieselben Daten. Wenn wir dem Speichernetzwerk daher die Möglichkeit hinzufügen möchten, nicht nur physische Datenträger, sondern auch Datenträger zu trennen logische Struktur Für Dateisysteme benötigen wir einen Zwischenverwaltungsserver, um alle Funktionen von Netzwerkprotokollen für die Verarbeitung von Anforderungen auf Dateiebene zu implementieren. Daher der allgemeine Ansatz zum Kombinieren von SAN und NAS mit einem NAS-Gerät ohne integriertes Festplattensubsystem, aber mit der Möglichkeit, Speichernetzwerkkomponenten anzuschließen. Solche Geräte, die von einigen Herstellern als NAS-Gateways und von anderen NAS-Kopfgeräten bezeichnet werden, werden zu einer Art Puffer dazwischen lokales Netzwerk und SAN: Bereitstellung des Zugriffs auf Daten im SAN auf Dateiebene und gemeinsame Nutzung von Informationen im gesamten Speichernetzwerk.

Zusammenfassung