Was speichersysteme Daten (SHD) und wofür ist es? Was ist der Unterschied zwischen iSCSI und FiberChannel? Warum wurde dieser Satz erst in den letzten Jahren einem breiten Kreis von IT-Spezialisten bekannt und warum sind die Probleme mit Datenspeichersystemen immer besorgniserregender fürsorglicher?

Ich denke, viele Menschen haben Entwicklungstrends in der uns umgebenden Computerwelt bemerkt - den Übergang von einem umfassenden zu einem intensiven Entwicklungsmodell. Die Zunahme der Megahertz-Prozessoren führt nicht mehr zu sichtbaren Ergebnissen, und die Entwicklung der Laufwerke entspricht nicht mehr der Informationsmenge. Wenn bei Prozessoren alles mehr oder weniger klar ist - es genügt, Multiprozessorsysteme zusammenzusetzen und / oder mehrere Kerne in einem Prozessor zu verwenden, ist es bei Problemen mit der Speicherung und Verarbeitung von Informationen nicht so einfach, Probleme zu beseitigen. Das derzeitige Allheilmittel für die Informationsepidemie ist die Speicherung. Der Name steht für Storage Area Network oder Storage System. In jedem Fall ist es etwas Besonderes

Hauptprobleme durch Lagerung gelöst

Welche Aufgaben löst das Speichersystem? Betrachten Sie die typischen Probleme, die mit dem wachsenden Informationsvolumen in einer Organisation verbunden sind. Angenommen, dies sind mindestens ein paar Dutzend Computer und mehrere geografisch verteilte Büros.

1. Dezentralisierung von Informationen - Wenn früher alle Daten buchstäblich auf einer Festplatte gespeichert werden konnten, ist jetzt für jedes funktionierende System ein separater Speicher erforderlich, z. B. für Server e-Mail, DBMS, Domain und so weiter. Bei verteilten Büros (Filialen) ist die Situation kompliziert.

2. Lawinenartiges Informationswachstum - Häufig kann die Anzahl der Festplatten, die Sie in einem bestimmten Server installieren können, nicht die vom System benötigte Kapazität abdecken. Als Konsequenz:

Die Unfähigkeit, die gespeicherten Daten vollständig zu schützen, liegt in der Tat daran, dass es ziemlich schwierig ist, Daten zu sichern, die nicht nur auf verschiedenen Servern, sondern auch geografisch verteilt sind.

Unzureichende Geschwindigkeit der Informationsverarbeitung - Kommunikationskanäle zwischen Remote-Standorten lassen immer noch zu wünschen übrig, aber selbst mit einem ausreichend „dicken“ Kanal ist es nicht immer möglich, vorhandene Netzwerke, z. B. IP, vollständig für die Arbeit zu nutzen.

Schwierigkeit sicherung - Wenn die Daten in kleinen Blöcken gelesen und geschrieben werden, kann es unrealistisch sein, Informationen von einem Remote-Server über vorhandene Kanäle vollständig zu archivieren. - Es ist erforderlich, die gesamte Datenmenge zu übertragen. Lokale Archivierung ist häufig aus finanziellen Gründen unpraktisch - Sie benötigen Backup-Systeme (z. B. Bandlaufwerke), spezielle Software (die viel Geld kosten kann) sowie geschultes und qualifiziertes Personal.

3. Es ist schwierig oder unmöglich, das erforderliche Volumen vorherzusagen speicherplatz bei der Bereitstellung eines Computersystems. Als Konsequenz:

Es gibt Probleme bei der Erweiterung der Festplattenkapazitäten - es ist ziemlich schwierig, Terabyte-Kapazitäten auf dem Server zu erhalten, insbesondere wenn das System bereits auf vorhandenen Festplatten mit geringer Kapazität ausgeführt wird -, zumindest sind ein Herunterfahren des Systems und ineffiziente Finanzinvestitionen erforderlich.

Ineffiziente Ressourcennutzung - Manchmal können Sie nicht erraten, auf welchem \u200b\u200bServer die Daten schneller wachsen. Auf dem E-Mail-Server ist möglicherweise nur sehr wenig Speicherplatz verfügbar, während eine andere Einheit nur 20% des Volumens eines teuren Festplattensubsystems (z. B. SCSI) belegt.

4. Geringe Vertraulichkeit verteilter Daten - Es ist unmöglich, den Zugriff gemäß den Sicherheitsrichtlinien des Unternehmens zu kontrollieren und einzuschränken. Dies gilt sowohl für den Zugriff auf Daten auf den dafür vorhandenen Kanälen (lokales Netzwerk) als auch für den physischen Zugriff auf Medien - beispielsweise Diebstahl von Festplatten und deren Zerstörung sind nicht ausgeschlossen (um das Geschäft der Organisation zu erschweren). Unqualifizierte Handlungen von Benutzern und Wartungspersonal können noch schädlicher sein. Wenn das Unternehmen in jedem Büro gezwungen ist, kleine lokale Sicherheitsprobleme zu lösen, führt dies nicht zum gewünschten Ergebnis.

5. Die Komplexität der Verwaltung verteilter Informationsflüsse - Alle Aktionen, die darauf abzielen, Daten in jedem Zweig zu ändern, der einen Teil der verteilten Daten enthält, verursachen bestimmte Probleme, die von der Komplexität der Synchronisierung verschiedener Datenbanken über Versionen von Entwicklerdateien bis hin zu unnötiger Vervielfältigung von Informationen reichen.

6. Geringe wirtschaftliche Auswirkung der Einführung "klassischer" Lösungen - Mit dem Wachstum des Informationsnetzwerks, großen Datenmengen und einer zunehmend verteilten Unternehmensstruktur sind Finanzinvestitionen nicht so effektiv und können die auftretenden Probleme oft nicht lösen.

7. Die hohen Kosten der für die Aufrechterhaltung der Effizienz des gesamten Unternehmensinformationssystems verwendeten Ressourcen - von der Notwendigkeit der Aufrechterhaltung eines großen Personals qualifizierten Personals bis hin zu zahlreichen teuren Hardwarelösungen, die das Problem des Datenträgers und der Zugriffsgeschwindigkeit auf Informationen lösen sollen, verbunden mit zuverlässiger Speicherung und Schutz vor Ausfällen.

Angesichts der oben genannten Probleme, die früher oder später ein sich dynamisch entwickelndes Unternehmen ganz oder teilweise überholen, werden wir versuchen, die Speichersysteme so zu beschreiben, wie sie sein sollten. Betrachten Sie typische Verbindungsschemata und Arten von Speichersystemen.

Megabyte / Transaktionen?

Wenn sich vorher Festplatten im Computer befanden (Server), werden sie jetzt überfüllt und sind dort nicht mehr sehr zuverlässig. Die einfachste Lösung (die vor langer Zeit entwickelt und überall eingesetzt wurde) ist die RAID-Technologie.

images \\ RAID \\ 01.jpg

Wenn wir RAID in Speichersystemen organisieren, erhalten wir neben dem Schutz von Informationen einige unbestreitbare Vorteile, darunter die Geschwindigkeit des Zugriffs auf Informationen.

Aus Sicht des Benutzers oder der Software wird die Geschwindigkeit nicht nur von der Systemkapazität (MB / s) bestimmt, sondern auch von der Anzahl der Transaktionen, dh der Anzahl der E / A-Vorgänge pro Zeiteinheit (IOPS). Die größere Anzahl von Festplatten und die vom RAID-Controller bereitgestellten Techniken zur Leistungsverbesserung (z. B. Caching) tragen logischerweise zu IOPS bei.

Wenn der Gesamtdurchsatz für die Anzeige von Streaming-Videos oder die Organisation eines Dateiservers für das DBMS und alle OLTP-Anwendungen (Online Transaction Processing) wichtiger ist, ist die Anzahl der Transaktionen, die das System verarbeiten kann, von entscheidender Bedeutung. Und mit dieser Option sind moderne Festplatten nicht so rosig wie mit wachsenden Volumina und teilweise Geschwindigkeiten. All diese Probleme sollen das Speichersystem selbst lösen.

Schutzstufen

Sie müssen verstehen, dass die Grundlage aller Speichersysteme der Schutz von Informationen auf der Grundlage der RAID-Technologie ist. Ohne diese Vorgehensweise ist jedes technisch fortgeschrittene Speichersystem unbrauchbar, da die Festplatten in diesem System die unzuverlässigste Komponente sind. Das Organisieren von Datenträgern in RAID ist die "untere Verbindung", die erste Stufe des Informationsschutzes und der Erhöhung der Verarbeitungsgeschwindigkeit.

Zusätzlich zu RAID-Schemata gibt es jedoch einen Datenschutz auf niedrigerer Ebene, der "zusätzlich" zu den Technologien und Lösungen implementiert ist, die der Hersteller auf der Festplatte selbst installiert hat. Beispielsweise verfügt einer der führenden Speicherhersteller, EMC, über eine Methodik zur zusätzlichen Datenintegritätsanalyse auf Laufwerksektorebene.

Nachdem wir uns mit RAID befasst haben, gehen wir zur Struktur der Speichersysteme selbst über. Zunächst werden Speichersysteme nach dem Typ der verwendeten Host- (Server-) Verbindungsschnittstellen unterteilt. Externe Verbindungsschnittstellen sind hauptsächlich SCSI oder FibreChannel sowie der relativ junge iSCSI-Standard. Diskontieren Sie auch keine kleinen intelligenten Geschäfte, die sogar über USB oder FireWire angeschlossen werden können. Wir werden seltenere (manchmal auf die eine oder andere Weise einfach erfolglose) Schnittstellen wie IBM SSA oder für Mainframes konzipierte Schnittstellen - zum Beispiel FICON / ESCON - nicht in Betracht ziehen. Eigenständiger NAS-Speicher, der mit dem Ethernet-Netzwerk verbunden ist. Das Wort „Schnittstelle“ bedeutet im Grunde genommen einen externen Anschluss, aber vergessen Sie nicht, dass der Anschluss das Kommunikationsprotokoll der beiden Geräte nicht bestimmt. Wir werden uns mit diesen Merkmalen etwas näher befassen.

images \\ RAID \\ 02.gif

Es steht für Small Computer System Interface (lesen Sie "Tell") - eine parallele Halbduplex-Schnittstelle. In modernen Speichersystemen wird es am häufigsten durch einen SCSI-Anschluss dargestellt:

images \\ RAID \\ 03.gif

images \\ RAID \\ 04.gif

Und eine Gruppe von SCSI-Protokollen, insbesondere SCSI-3 Parallel Interface. Der Unterschied zwischen SCSI und der bekannten IDE besteht darin, dass es mehr Geräte pro Kanal, längere Kabellängen, schnellere Datenübertragungsraten sowie „exklusive“ Funktionen wie Hochspannungsdifferentialsignalisierung, Befehlswarteschlangen und einige andere gibt - wir werden uns nicht mit diesem Problem befassen.

Wenn wir über die wichtigsten Hersteller von SCSI-Komponenten sprechen, wie SCSI-Adapter, RAID-Controller mit SCSI-Schnittstelle, wird sich jeder Fachmann sofort an zwei Namen erinnern - Adaptec und LSI Logic. Ich denke, das ist genug, es hat seit langem keine Revolutionen auf diesem Markt gegeben und es wird wahrscheinlich nicht damit gerechnet.

FiberChannel-Schnittstelle

Serielle Vollduplexschnittstelle. In modernen Geräten werden meistens externe optische Anschlüsse wie LC oder SC (LC - kleiner) verwendet:

images \\ RAID \\ 05.jpg

images \\ RAID \\ 06.jpg

... und FibreChannel Protocols (FCP). Es gibt verschiedene FibreChannel-Geräteschaltschemata:

Punkt zu Punkt - direkte Punkt-zu-Punkt-Verbindung von Geräten untereinander:

images \\ RAID \\ 07.gif

Crosspoint geschaltet - Anschließen von Geräten an den FibreChannel-Switch (ähnlich der Ethernet-Netzwerkimplementierung auf den Switches):

images \\ RAID \\ 08.gif

Arbitrated-Schleife - FC-AL, Schleife mit Arbitrierungszugriff - alle Geräte sind ringförmig miteinander verbunden, die Schaltung erinnert etwas an Token Ring. Es kann auch ein Switch verwendet werden - dann wird die physikalische Topologie nach dem "Stern" -Schema und die logische nach dem "Ring" -Schema implementiert:

images \\ RAID \\ 09.gif

Die Verbindung nach dem FibreChannel Switched-Schema ist das gängigste Schema. In Bezug auf FibreChannel wird eine solche Verbindung als Fabric bezeichnet - auf Russisch gibt es ein Transparentpapier davon - "Fabrik". Es ist zu beachten, dass FibreChannel-Switches in Bezug auf die Komplexität der Befüllung recht fortschrittliche Geräte sind und sich in der Nähe von IP-Switches der Stufe 3 befinden. Wenn die Switches miteinander verbunden sind, arbeiten sie in einer einzigen Fabrik mit einem Pool von Einstellungen, die für die gesamte Fabrik auf einmal gültig sind. Das Ändern einiger Optionen an einem der Switches kann zu einem erneuten Umschalten der gesamten Fabrik führen, von den Zubeispielsweise ganz zu schweigen. Andererseits gibt es SAN-Schemata, an denen mehrere Fabriken in einem einzigen SAN beteiligt sind. Aus diesem Grund kann eine Factory nur als Gruppe miteinander verbundener Switches bezeichnet werden - zwei oder mehr nicht verbundene Geräte, die in das SAN eingeführt wurden, um die Fehlertoleranz von zwei oder mehr verschiedenen Fabriken zu erhöhen.

Komponenten, mit denen Hosts und Speichersysteme in einem einzigen Netzwerk kombiniert werden können, werden im Allgemeinen als "Konnektivität" bezeichnet. Bei der Konnektivität handelt es sich natürlich um Duplex-Verbindungskabel (normalerweise mit einer LC-Schnittstelle), Switches (Switches) und FibreChannel-Adapter (HBA, Host Base Adapter), dh um Erweiterungskarten, mit denen Sie den Host bei Installation auf den Hosts mit dem Netzwerk verbinden können SAN. HBAs werden normalerweise als PCI-X- oder PCI-Express-Karten implementiert.

images \\ RAID \\ 10.jpg

Verwechseln Sie nicht Faser und Faser - das Signalübertragungsmedium kann unterschiedlich sein. FiberChannel kann mit "Kupfer" arbeiten. Beispielsweise haben alle FibreChannel-Festplatten Metallkontakte, und das übliche Schalten von Geräten über „Kupfer“ ist keine Seltenheit. Sie schalten nur allmählich auf optische Kanäle um, da dies die vielversprechendste Technologie und der funktionale Ersatz von „Kupfer“ ist.

ISCSI-Schnittstelle

Wird in der Regel durch einen externen RJ-45-Anschluss für die Verbindung mit einem Ethernet-Netzwerk und dem Protokoll selbst dargestellt. ISCSI (Internet Small Computer System Interface). Nach der Definition von SNIA: „iSCSI ist ein Protokoll, das auf TCP / IP basiert und darauf ausgelegt ist, Interoperabilität herzustellen und Speichersysteme, Server und Clients zu verwalten.“ Lassen Sie uns näher auf diese Schnittstelle eingehen, schon allein deshalb, weil jeder Benutzer iSCSI auch in einem normalen Heimnetzwerk verwenden kann.

Sie müssen wissen, dass iSCSI mindestens das Transportprotokoll für SCSI definiert, das auf TCP ausgeführt wird, sowie die Technologie zur Kapselung von SCSI-Befehlen in einem IP-basierten Netzwerk. Einfach ausgedrückt ist iSCSI ein Protokoll, das den Blockzugriff auf Daten mithilfe von SCSI-Befehlen ermöglicht, die über ein Netzwerk mit einem TCP / IP-Stack gesendet werden. iSCSI trat als Ersatz für FibreChannel auf und bietet in modernen Speichersystemen mehrere Vorteile: Die Möglichkeit, Geräte über große Entfernungen (unter Verwendung vorhandener IP-Netzwerke) zu kombinieren, die Möglichkeit, ein bestimmtes QoS-Niveau (Quality of Service, Servicequalität) bereitzustellen, kostengünstigere Konnektivität. Das Hauptproblem bei der Verwendung von iSCSI als Ersatz für FibreChannel sind jedoch die langen Verzögerungen im Netzwerk aufgrund der Besonderheiten der TCP / IP-Stack-Implementierung, die einen der wichtigen Vorteile der Verwendung von Speichersystemen zunichte machen - die Geschwindigkeit des Informationszugriffs und die geringe Latenz. Das ist ein ernstes Minus.

Eine kleine Bemerkung zu Hosts: Sie können sowohl normale Netzwerkkarten (dann wird die iSCSI-Stapelverarbeitung und die Kapselung von Befehlen von der Software durchgeführt) als auch spezielle Karten verwenden, die Technologien unterstützen, die TOE (TCP / IP Offload Engines) ähneln. Diese Technologie ermöglicht die Hardware-Verarbeitung des entsprechenden Teils des iSCSI-Protokollstapels. Software-Methode billiger, belastet aber den Zentralprozessor des Servers mehr und kann theoretisch zu mehr Verzögerungen führen als ein Hardwareprozessor. Bei der aktuellen Geschwindigkeit von Ethernet-Netzwerken mit 1 Gbit / s kann davon ausgegangen werden, dass iSCSI mit einer Geschwindigkeit von 2 Gbit genau doppelt so langsam wie der FibreChannel arbeitet. Im realen Einsatz wird der Unterschied jedoch noch deutlicher.

Zusätzlich zu den bereits besprochenen erwähnen wir kurz einige Protokolle, die seltener sind und zusätzliche Dienste für vorhandene Storage Area Networks (SANs) bereitstellen sollen:

FCIP (Fibre Channel over IP) - Ein auf TCP / IP basierendes Tunnelprotokoll, mit dem geografisch verteilte SANs über eine Standard-IP-Umgebung verbunden werden können. Beispielsweise können Sie zwei SANs über das Internet zu einem SAN kombinieren. Dies wird durch die Verwendung eines FCIP-Gateways erreicht, das für alle Geräte im SAN transparent ist.

iFCP (Internet Fibre Channel Protocol) - Ein Protokoll, mit dem Sie Geräte mit FC-Schnittstellen über IP-Netzwerke kombinieren können. Ein wichtiger Unterschied zu FCIP besteht darin, dass FC-Geräte über ein IP-Netzwerk kombiniert werden können, sodass ein anderes Verbindungspaar eine andere QoS-Stufe aufweist, was beim Tunneln über FCIP nicht möglich ist.

Wir haben kurz die physischen Schnittstellen, Protokolle und Switching-Typen für Speichersysteme untersucht, ohne alle aufzulisten mögliche Optionen. Versuchen wir uns nun vorzustellen, welche Parameter Datenspeichersysteme auszeichnen.

Haupthardware-Parameter des Speichers

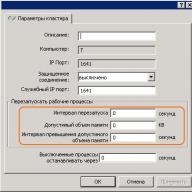

Einige von ihnen wurden oben aufgeführt - dies sind die Typen der externen Verbindungsschnittstellen und -typen interne Laufwerke (Festplatten). Der nächste Parameter, der bei der Auswahl eines Plattenspeichersystems nach den beiden oben genannten zu berücksichtigen ist, ist seine Zuverlässigkeit. Die Zuverlässigkeit kann nicht anhand der banalen Betriebszeit zwischen dem Ausfall einzelner Komponenten (die Tatsache, dass diese Zeit für alle Hersteller in etwa gleich ist) beurteilt werden, sondern anhand der internen Architektur. Ein „normales“ Speichersystem ist häufig ein Festplattenfach (zum Einbau in ein 19-Zoll-Gehäuse) mit Festplatten, externen Schnittstellen zum Anschließen von Hosts und mehreren Netzteilen. Im Inneren ist normalerweise alles installiert, was das Speichersystem bereitstellt - Prozessoreinheiten, Festplattencontroller, Eingabe- / Ausgabeports, Cache-Speicher usw. In der Regel wird das Rack über die Befehlszeile oder über die Webschnittstelle verwaltet. Die Erstkonfiguration erfordert häufig eine serielle Verbindung. Der Benutzer kann die Festplatten im System in Gruppen "aufteilen" und diese zu RAID (verschiedener Ebenen) zusammenfassen. Der resultierende Festplattenspeicher wird in eine oder mehrere logische Einheiten (LUNs) aufgeteilt, auf die Hosts (Server) Zugriff haben und diese als "sehen" lokale Festplatten. Die Anzahl der RAID-Gruppen, LUNs, die Logik des Caches, die Verfügbarkeit von LUNs für bestimmte Server und alles andere werden vom Systemadministrator konfiguriert. In der Regel sind Speichersysteme so konzipiert, dass sie nicht nur einen, sondern mehrere (theoretisch bis zu Hunderte) Server mit ihnen verbinden. Daher sollte ein solches System über eine hohe Leistung, ein flexibles Steuerungs- und Überwachungssystem und durchdachte Datenschutzwerkzeuge verfügen. Der Datenschutz wird auf viele Arten bereitgestellt, von denen Ihnen die einfachste bereits bekannt ist - die Kombination von Festplatten in RAID. Die Daten müssen aber auch ständig zugänglich sein - schließlich kann das Stoppen eines zentralen Datenspeichers im Unternehmen zu erheblichen Verlusten führen. Je mehr Systeme Daten auf dem Speichersystem speichern, desto zuverlässiger muss der Zugriff auf das System sein - denn im Falle eines Unfalls funktioniert das Speichersystem auf allen Servern, auf denen Daten gespeichert sind, sofort nicht mehr. Eine hohe Rack-Verfügbarkeit wird durch vollständige interne Duplizierung aller Systemkomponenten sichergestellt - Rack-Zugriffspfade (FibreChannel-Ports), Prozessormodule, Cache-Speicher, Netzteile usw. Wir werden versuchen, das Prinzip der 100% igen Redundanz (Duplizierung) mit der folgenden Abbildung zu erklären:

images \\ RAID \\ 11.gif

1. Der Controller (Prozessormodul) des Speichersystems, einschließlich:

* Zentralprozessor (oder Prozessoren) - Auf dem System wird normalerweise eine spezielle Software ausgeführt, die als "Betriebssystem" fungiert.

* Schnittstellen zum Umschalten mit Festplatten - in unserem Fall handelt es sich um Karten, die den Anschluss von FibreChannel-Festplatten nach dem Arbitration Access Loop-Schema (FC-AL) ermöglichen.

* Cache-Speicher;

* Externe FibreChannel-Port-Controller

2. Die externe Schnittstelle von FC; wie wir sehen, gibt es 2 von ihnen für jedes Prozessormodul;

3. Festplatten - Die Kapazität wird durch zusätzliche Festplattenfächer erweitert.

4. Der Cache-Speicher in einem solchen Schema wird normalerweise gespiegelt, um die dort gespeicherten Daten nicht zu verlieren, wenn ein Modul ausfällt.

In Bezug auf die Hardware können Festplatten-Racks unterschiedliche Schnittstellen zum Verbinden von Hosts, unterschiedliche Schnittstellen von Festplatten, unterschiedliche Verbindungsschemata für zusätzliche Regale, die zur Erhöhung der Anzahl der Festplatten im System dienen, sowie andere reine „Eisenparameter“ aufweisen.

Speichersoftware

Natürlich muss die Hardwareleistung der Speichersysteme in irgendeiner Weise verwaltet werden, und die Speichersysteme selbst müssen lediglich einen Servicegrad und eine Funktionalität bereitstellen, die in herkömmlichen Server-Client-Schemata nicht verfügbar sind. In der Abbildung „Strukturdiagramm eines Datenspeichersystems“ wird deutlich, dass der Server, wenn er auf zwei Arten direkt mit dem Rack verbunden ist, mit den FC-Ports verschiedener Prozessormodule verbunden werden muss, damit der Server weiterhin funktioniert, wenn das gesamte Prozessormodul sofort ausfällt. Um Multipathing nutzen zu können, sollte diese Funktionalität natürlich von Hardware und Software auf allen Ebenen, die an der Datenübertragung beteiligt sind, unterstützt werden. Natürlich ist eine vollständige Sicherung ohne Überwachungs- und Warnwerkzeuge nicht sinnvoll - daher verfügen alle seriösen Speichersysteme über solche Funktionen. Zum Beispiel kann die Benachrichtigung über kritische Ereignisse auf verschiedene Weise erfolgen: durch eine E-Mail-Warnung, einen automatischen Modem-Anruf beim technischen Support, eine Nachricht an einen Pager (der jetzt relevanter als SMS ist), SNMP-Mechanismen und vieles mehr.

Nun, und wie wir bereits erwähnt haben, gibt es leistungsstarke Steuerelemente für all diese Großartigkeit. In der Regel ist dies eine webbasierte Oberfläche, eine Konsole, die Fähigkeit, Skripte zu schreiben und die Steuerung in externe Softwarepakete zu integrieren. Über die Mechanismen, die Hochleistungsspeicher bereitstellen, wird nur kurz gesprochen - nicht blockierende Architektur mit mehreren internen Bussen und viel Festplatten, leistungsstarke Zentralprozessoren, ein spezialisiertes Steuerungssystem (OS), viel Cache-Speicher und viele externe E / A-Schnittstellen.

Die von Speichersystemen bereitgestellten Dienste werden in der Regel von der Software bestimmt, die auf dem Festplatten-Rack selbst ausgeführt wird. Fast immer handelt es sich um komplexe Softwarepakete, die unter separaten Lizenzen erworben wurden und nicht in den Kosten des Speichers selbst enthalten sind. Wir werden sofort die bekannte Software für Multipathing erwähnen - sie funktioniert nur auf Hosts, nicht im Rack.

Die am weitesten verbreitete Lösung ist Software zur Erstellung sofortiger und vollständiger Kopien von Daten. Verschiedene Hersteller haben unterschiedliche Namen für ihre Softwareprodukte und Mechanismen zum Erstellen dieser Kopien. Zusammenfassend können wir die Wörter snapshot und clone bearbeiten. Ein Klon wird mithilfe des Festplatten-Racks im Rack selbst erstellt. Hierbei handelt es sich um eine vollständige interne Kopie der Daten. Der Anwendungsbereich ist recht breit - von der Sicherung bis zur Erstellung einer „Testversion“ der Quelldaten, zum Beispiel für riskante Upgrades, bei denen kein Vertrauen besteht und deren Verwendung für aktuelle Daten nicht sicher ist. Jeder, der den Charme des Speichers, den wir hier analysiert haben, genau verfolgt hat, wird sich fragen: Warum benötigen Sie eine Datensicherung im Rack, wenn diese so zuverlässig ist? Die Antwort auf diese Frage ist, dass niemand vor menschlichen Fehlern gefeit ist. Die Daten werden zuverlässig gespeichert, aber wenn der Bediener selbst etwas falsch gemacht hat, zum Beispiel die gewünschte Tabelle in der Datenbank gelöscht hat, konnten ihn keine Hardwaretricks retten. Das Klonen von Daten erfolgt normalerweise auf LUN-Ebene. Weitere interessante Funktionen bietet der Snapshot-Mechanismus. Bis zu einem gewissen Grad erhalten wir alle Reize einer vollständigen internen Kopie der Daten (Klon), während wir nicht 100% der im Rack selbst kopierten Datenmenge in Anspruch nehmen, da uns ein solches Volume nicht immer zur Verfügung steht. Tatsächlich ist ein Schnappschuss ein sofortiger "Schnappschuss" von Daten, der keine Zeit und Prozessorressourcen für die Speicherung benötigt.

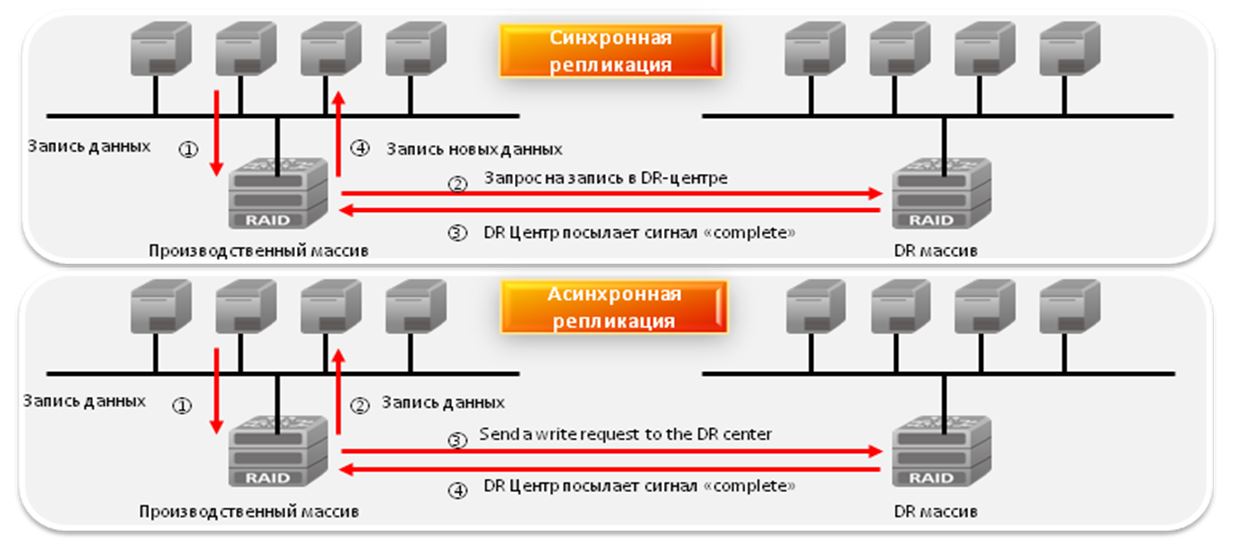

Natürlich kann man die Datenreplikationssoftware, die oft als Spiegelung bezeichnet wird, nicht verpassen. Dies ist ein Mechanismus für die synchrone oder asynchrone Replikation (Vervielfältigung) von Informationen von einem Speichersystem zu einem oder mehreren Remotespeichersystemen. Die Replikation kann über verschiedene Kanäle erfolgen. So können beispielsweise Racks mit FibreChannel-Schnittstellen asynchron, über das Internet und über große Entfernungen auf ein anderes Speichersystem repliziert werden. Diese Lösung bietet zuverlässige Informationsspeicherung und Schutz vor Katastrophen.

Zusätzlich zu all dem gibt es eine Vielzahl weiterer Softwaremechanismen zur Datenmanipulation ...

DAS & NAS & SAN

Nachdem Sie sich mit den Datenspeichersystemen selbst, den Prinzipien ihres Aufbaus, den von ihnen bereitgestellten Fähigkeiten und den funktionierenden Protokollen vertraut gemacht haben, ist es an der Zeit, das erworbene Wissen in einem Arbeitsschema zu kombinieren. Lassen Sie uns versuchen, die Arten von Speichersystemen und die Topologie ihrer Verbindung zu einer einzigen funktionierenden Infrastruktur zu betrachten.

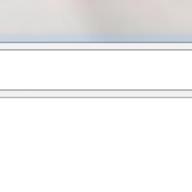

Geräte DAS (Direct Attached Storage) - Speichersysteme, die direkt mit dem Server verbunden sind. Dies umfasst sowohl die einfachsten SCSI-Systeme, die an den SCSI / RAID-Controller des Servers angeschlossen sind, als auch FibreChannel-Geräte, die direkt an den Server angeschlossen sind, obwohl sie für SANs ausgelegt sind. In diesem Fall ist die DAS-Topologie ein entartetes SAN (Storage Area Network):

images \\ RAID \\ 12.gif

In diesem Schema hat einer der Server Zugriff auf Daten, die auf dem Speichersystem gespeichert sind. Clients greifen auf Daten zu, indem sie über das Netzwerk auf diesen Server zugreifen. Das heißt, der Server hat Blockzugriff auf Daten im Speichersystem, und Clients verwenden bereits den Dateizugriff. Dieses Konzept ist für das Verständnis sehr wichtig. Die Nachteile einer solchen Topologie liegen auf der Hand:

* Geringe Zuverlässigkeit - Im Falle von Netzwerkproblemen oder Serverabstürzen können nicht alle gleichzeitig auf Daten zugreifen.

* Hohe Latenz aufgrund der Verarbeitung aller Anforderungen durch einen Server und des verwendeten Transports (meistens - IP).

* Hohe Netzwerkauslastung, häufig Definieren von Skalierbarkeitsgrenzen durch Hinzufügen von Clients.

* Schlechte Verwaltbarkeit - Die gesamte Kapazität steht einem Server zur Verfügung, wodurch die Flexibilität der Datenverteilung verringert wird.

* Geringe Auslastung der Ressourcen - Es ist schwierig, die erforderlichen Datenmengen vorherzusagen. Einige DAS-Geräte in der Organisation verfügen möglicherweise über einen Kapazitätsüberschuss (Festplatten), andere möglicherweise nicht. Eine Neuverteilung ist häufig unmöglich oder zeitaufwendig.

Geräte NAS (Network Attached Storage) - Speichergeräte, die direkt mit dem Netzwerk verbunden sind. Im Gegensatz zu anderen Systemen bietet NAS Dateizugriff auf Daten und sonst nichts. NAS-Geräte sind eine Kombination aus dem Speichersystem und dem Server, mit dem es verbunden ist. In seiner einfachsten Form ist ein regulärer Netzwerkserver, der Dateiressourcen bereitstellt, ein NAS-Gerät:

images \\ RAID \\ 13.gif

Alle Nachteile eines solchen Schemas ähneln mit einigen Ausnahmen der DAS-Topologie. Von den Minuspunkten, die hinzugefügt wurden, bemerken wir die erhöhten und oftmals beträchtlichen Kosten - die Kosten sind jedoch proportional zur Funktionalität, und hier ist oft "es gibt etwas zu bezahlen". NAS-Geräte können die einfachsten "Boxen" mit einem Ethernet-Port und zwei Festplatten in RAID1 sein und ermöglichen den Zugriff auf Dateien mit nur einem CIFS-Protokoll (Common Internet File System) auf große Systeme, in denen Hunderte von Festplatten installiert werden können, sowie den Dateizugriff bereitgestellt von einem Dutzend spezialisierter Server innerhalb des NAS-Systems. Die Anzahl der externen Ethernet-Ports kann mehrere zehn betragen, und die Kapazität der gespeicherten Daten kann mehrere hundert Terabyte betragen (z. B. EMC Celerra CNS). Zuverlässigkeit und Leistung solcher Modelle können viele SAN-Midrange-Geräte umgehen. Interessanterweise können NAS-Geräte Teil eines SAN-Netzwerks sein und haben keine eigenen Laufwerke, sondern bieten nur Dateizugriff auf Daten, die sich auf Blockspeichergeräten befinden. In diesem Fall übernimmt der NAS die Funktion eines leistungsstarken spezialisierten Servers, und das SAN übernimmt das Speichergerät. Das heißt, wir erhalten die DAS-Topologie, die aus NAS- und SAN-Komponenten besteht.

NAS-Geräte eignen sich sehr gut für heterogene Umgebungen, in denen für viele Clients gleichzeitig ein schneller Dateizugriff auf Daten erforderlich ist. Darüber hinaus bietet es eine hervorragende Speicherzuverlässigkeit und Systemverwaltungsflexibilität bei gleichzeitig einfacher Wartung. Wir werden uns nicht mit Zuverlässigkeit befassen - dieser Aspekt der Speicherung wird oben erörtert. In einer heterogenen Umgebung kann der Zugriff auf Dateien innerhalb eines einzelnen NAS-Systems über TCP / IP, CIFS, NFS, FTP, TFTP und andere erfolgen, einschließlich der Möglichkeit, als NAS-iSCSI-Ziel zu arbeiten, wodurch der Betrieb mit verschiedenen Betriebssystemen sichergestellt wird. auf Hosts installiert. Um die Wartung zu vereinfachen und die Verwaltung zu flexibilisieren, werden diese Funktionen von einem speziellen Betriebssystem bereitgestellt, das nur schwer zu deaktivieren ist und nicht gewartet werden muss, sowie von der einfachen Differenzierung der Zugriffsrechte auf Dateien. Beispielsweise ist es möglich, in einer Windows Active Directory-Umgebung mit Unterstützung der erforderlichen Funktionen zu arbeiten. Dies können LDAP, Kerberos-Authentifizierung, dynamisches DNS, ACLs, Kontingente (Kontingente), Gruppenrichtlinienobjekte und der SID-Verlauf sein. Da der Zugriff auf Dateien gewährt wird und deren Namen Zeichen in verschiedenen Sprachen enthalten können, bieten viele NAS Unterstützung für UTF-8- und Unicode-Codierungen. Die Wahl des NAS sollte noch sorgfältiger getroffen werden als bei DAS-Geräten, da diese Geräte möglicherweise nicht die Dienste unterstützen, die Sie benötigen, z. B. Encrypting File Systems (EFS) von Microsoft und IPSec. Sie sehen übrigens, dass NAS viel seltener als SAN-Geräte sind, aber der Prozentsatz solcher Systeme wächst immer noch, wenn auch langsam - hauptsächlich aufgrund der Verdrängung von DAS.

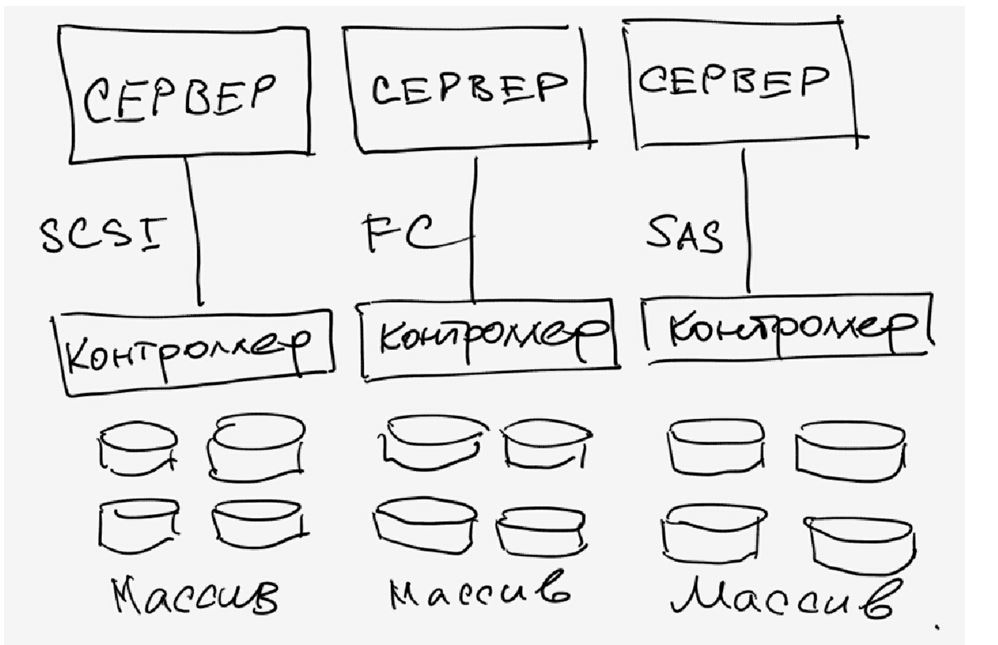

Geräte, mit denen eine Verbindung hergestellt werden kann SAN (Storage Area Network) - Geräte zum Anschluss an ein Datenspeichernetz. Ein Storage Area Network (SAN) sollte nicht mit einem lokalen Netzwerk verwechselt werden - dies sind verschiedene Netzwerke. In den meisten Fällen basiert das SAN auf dem FibreChannel-Protokollstack und besteht im einfachsten Fall aus Speichersystemen, Switches und Servern, die über optische Kommunikationskanäle verbunden sind. In der Abbildung sehen wir eine äußerst zuverlässige Infrastruktur, in der Server gleichzeitig mit dem lokalen Netzwerk (links) und dem Speichernetzwerk (rechts) verbunden sind:

images \\ RAID \\ 14.gif

Nach einer ausführlichen Beschreibung der Geräte und ihrer Funktionsprinzipien wird es für uns recht einfach, die SAN-Topologie zu verstehen. In der Abbildung sehen wir ein einziges Speichersystem für die gesamte Infrastruktur, an das zwei Server angeschlossen sind. Server haben redundante Zugriffspfade - jeder hat zwei HBAs (oder einen Dual-Port, wodurch die Fehlertoleranz verringert wird). Das Speichergerät verfügt über 4 Ports, über die es mit 2 Switches verbunden ist. Unter der Annahme, dass sich zwei redundante Prozessormodule im Inneren befinden, ist es leicht zu erraten, dass das beste Verbindungsschema besteht, wenn jeder Switch sowohl mit dem ersten als auch mit dem zweiten Prozessormodul verbunden ist. Ein solches Schema ermöglicht den Zugriff auf alle auf dem Speichersystem befindlichen Daten, wenn ein Prozessormodul, ein Switch oder ein Zugriffspfad ausfällt. Wir haben bereits die Zuverlässigkeit von Speichersystemen untersucht. Zwei Switches und zwei Fabriken erhöhen die Verfügbarkeit der Topologie weiter. Wenn also eine der Switches aufgrund eines Fehlers oder eines Administratorfehlers plötzlich ausfällt, funktioniert die zweite Einheit normal, da diese beiden Geräte nicht miteinander verbunden sind.

Die angezeigte Serververbindung wird als Hochverfügbarkeitsverbindung bezeichnet, obwohl bei Bedarf eine noch größere Anzahl von HBAs auf dem Server installiert werden kann. Physikalisch hat jeder Server nur zwei Verbindungen im SAN, aber logischerweise kann auf das Speichersystem über vier Pfade zugegriffen werden - jeder HBA bietet für jedes Prozessormodul einen separaten Zugriff auf zwei Verbindungspunkte im Speichersystem (diese Funktion ermöglicht eine doppelte Verbindung des Switches mit dem Speichersystem). In diesem Diagramm ist der Server das unzuverlässigste Gerät. Zwei Switches bieten eine Zuverlässigkeit in der Größenordnung von 99,99%, der Server kann jedoch aus verschiedenen Gründen ausfallen. Wenn ein äußerst zuverlässiger Betrieb des gesamten Systems erforderlich ist, werden die Server zu einem Cluster zusammengefasst. Das obige Diagramm erfordert keine zusätzliche Hardware, um solche Arbeiten zu organisieren, und wird als Referenzorganisation des SAN angesehen. Der einfachste Fall ist, dass die Server auf eine einzige Weise über einen Switch mit dem Speichersystem verbunden sind. Das Speichersystem mit zwei Prozessormodulen muss jedoch mit mindestens einem Kanal pro Modul an den Switch angeschlossen werden - die verbleibenden Ports können für den direkten Anschluss von Servern an das Speichersystem verwendet werden, was manchmal erforderlich ist. Und vergessen Sie nicht, dass das SAN nicht nur auf der Basis von FibreChannel, sondern auch auf der Basis des iSCSI-Protokolls erstellt werden kann. Gleichzeitig können Sie nur Standard-Ethernet-Geräte für das Switching verwenden, was die Systemkosten senkt, aber eine Reihe zusätzlicher Minuspunkte aufweist (siehe Abschnitt zu iSCSI) ) Interessant ist auch die Möglichkeit, Server vom Speichersystem zu laden - es ist nicht einmal erforderlich, interne Festplatten im Server zu haben. Die Aufgabe, Daten zu speichern, entfällt somit endgültig auf den Servern. Theoretisch kann aus einem spezialisierten Server ein gewöhnlicher Zahlenbrecher ohne Laufwerke gemacht werden, dessen definierende Blöcke Zentralprozessoren, Speicher sowie Schnittstellen für die Interaktion mit der Außenwelt wie Ethernet- und FibreChannel-Ports sind. Bei ähnlichen Geräten handelt es sich um moderne Blade-Server.

Ich möchte darauf hinweisen, dass die Geräte, die an das SAN angeschlossen werden können, nicht nur auf Plattenspeichersysteme beschränkt sind - es können Plattenbibliotheken, Bandbibliotheken (Bandlaufwerke), Geräte zum Speichern von Daten auf optischen Platten (CD / DVD usw.) und viele andere sein.

Von den Vorteilen von SAN sind nur die hohen Kosten seiner Komponenten zu nennen, aber die Vorteile sind unbestreitbar:

* Hohe Zuverlässigkeit beim Zugriff auf Daten auf externen Speichersystemen. Unabhängigkeit der SAN-Topologie von verwendeten Speichersystemen und Servern.

* Zentralisierte Datenspeicherung (Zuverlässigkeit, Sicherheit).

* Bequeme zentrale Verwaltung von Switching und Daten.

* Übertragen Sie intensiven E / A-Verkehr in ein separates Netzwerk und entlasten Sie das LAN.

* Hohe Geschwindigkeit und geringe Latenz.

* Skalierbarkeit und Flexibilität logische Struktur San

* Geografisch sind die SAN-Größen im Gegensatz zu klassischem DAS praktisch unbegrenzt.

* Fähigkeit, Ressourcen schnell zwischen Servern zu verteilen.

* Möglichkeit, fehlertolerante Cluster-Lösungen ohne zusätzliche Kosten basierend auf dem vorhandenen SAN zu erstellen.

* Einfaches Backup-Schema - alle Daten befinden sich an einem Ort.

* Vorhandensein zusätzlicher Funktionen und Dienste (Snapshots, Remote-Replikation).

* Hochsicherheits-SAN.

Abschließend

Ich denke, wir haben die wichtigsten Fragen im Zusammenhang mit modernen Speichersystemen angemessen abgedeckt. Hoffen wir, dass sich solche Geräte noch schneller funktional entwickeln und die Anzahl der Datenverwaltungsmechanismen nur wächst.

Zusammenfassend lässt sich sagen, dass NAS- und SAN-Lösungen derzeit einen regelrechten Boom erleben. Die Anzahl der Hersteller und die Vielfalt der Lösungen nimmt zu, und die technische Kompetenz der Verbraucher nimmt zu. Wir können davon ausgehen, dass in naher Zukunft in fast jeder Computerumgebung das eine oder andere Speichersystem auftauchen wird.

Alle Daten erscheinen vor uns in Form von Informationen. Die Bedeutung der Arbeit eines Computergeräts ist die Informationsverarbeitung. In in letzter Zeit Die Wachstumsvolumina sind mitunter erschreckend, weshalb Speichersysteme und Spezialsoftware in den kommenden Jahren zweifellos die gefragtesten Produkte auf dem IT-Markt sein werden.

Was ist das?

Datenspeichernetzwerkoder Storage Area Network ist ein System, das aus tatsächlichen Speichergeräten - Festplatten oder RAID - Arrays, Bandbibliotheken und anderen Dingen, einem Datenübertragungsmedium und damit verbundenen Servern besteht. Es wird in der Regel von ausreichend großen Unternehmen mit einer gut ausgebauten IT-Infrastruktur für eine zuverlässige Datenspeicherung und einen Hochgeschwindigkeitszugriff auf diese verwendet.

Storage ist ein vereinfachtes System, mit dem Sie zuverlässige Server verteilen können schnelle Fahrten variable Kapazität mit verschiedene Geräte Datenspeicherung.

Ein bisschen Theorie.

Der Server kann auf verschiedene Arten mit dem Data Warehouse verbunden werden.

Die erste und einfachste ist DAS, Direct Attached Storage (direkte Verbindung), wir stecken Laufwerke in den Server oder ein Array in den Serveradapter und wir bekommen relativ viel Gigabyte Festplattenspeicher schneller Zugriffund bei Verwendung eines RAID-Arrays - ausreichende Zuverlässigkeit, obwohl es Speere zum Thema Zuverlässigkeit schon lange gibt.

Diese Nutzung des Speicherplatzes ist jedoch nicht optimal - auf einem Server ist der Speicherplatz knapp, auf dem anderen ist noch viel Speicherplatz vorhanden. Die Lösung für dieses Problem ist NAS, Network Attached Storage (Netzwerkspeicher). Bei all den Vorteilen dieser Lösung - Flexibilität und zentrales Management - gibt es jedoch einen wesentlichen Nachteil - die Zugriffsgeschwindigkeit - ein Netzwerk von 10 Gigabit wurde noch nicht in allen Organisationen implementiert. Und wir kommen zum Speichernetzwerk.

Der Hauptunterschied zwischen SAN und NAS (zusätzlich zur Reihenfolge der Buchstaben in Abkürzungen) besteht darin, wie die verbundenen Ressourcen auf dem Server angezeigt werden. Wenn die NAS-Ressourcen mit den NFS- oder SMB-Protokollen verbunden sind, erhalten wir im SAN eine Verbindung zur Festplatte, mit der wir auf der Ebene der Block-E / A-Vorgänge arbeiten können, was viel schneller ist als eine Netzwerkverbindung (plus ein Array-Controller mit großem Cache beschleunigt viele Vorgänge).

Mit SAN kombinieren wir die Vorteile von DAS - Geschwindigkeit und Einfachheit sowie NAS - Flexibilität und Steuerbarkeit. Außerdem können wir Speichersysteme skalieren, bis genug Geld vorhanden ist, und gleichzeitig mehrere Fliegen mit einer Klappe schlagen, die nicht sofort sichtbar sind:

* Einschränkungen für den Anschlussbereich von SCSI-Geräten aufheben, die normalerweise auf ein Kabel von 12 Metern begrenzt sind.

* Backup-Zeit reduzieren,

* Wir können von SAN booten,

* im Falle einer Ablehnung von NAS entladen wir ein Netzwerk,

* wir bekommen eine hohe Input-Output-Geschwindigkeit durch Optimierung auf der Speicherseite,

* die Möglichkeit bekommen, mehrere Server mit einer Ressource zu verbinden, dann gibt es uns die folgenden zwei Fliegen mit einer Klappe:

o die Möglichkeiten von VMWare voll ausschöpfen - zum Beispiel VMotion (Migration virtueller Maschinen zwischen physischen Maschinen) und ähnliche,

o Wir können fehlertolerante Cluster aufbauen und geografisch verteilte Netzwerke organisieren.

Was gibt es?

Zusätzlich zur Nutzung des Budgets für die Optimierung des Speichersystems erhalten wir zusätzlich zu dem, was ich oben geschrieben habe:

* Steigerung der Produktivität, des Lastausgleichs und der Hochverfügbarkeit von Speichersystemen durch verschiedene Arten des Zugriffs auf Arrays;

* Einsparung von Festplatten durch Optimierung des Informationsstandorts;

* Beschleunigte Wiederherstellung nach Ausfällen - Sie können temporäre Ressourcen erstellen, ein Backup auf ihnen bereitstellen und Server mit ihnen verbinden sowie Informationen ohne Eile selbst wiederherstellen oder Ressourcen auf andere Server übertragen und in aller Ruhe mit toten Eisen umgehen.

* Reduzierte Sicherungszeit - Dank der hohen Übertragungsgeschwindigkeit können Sie schneller eine Sicherungskopie der Bandbibliothek erstellen oder sogar einen Schnappschuss (Snapshot) aus dem Dateisystem erstellen und sicher archivieren.

* Speicherplatz nach Bedarf - wenn wir ihn benötigen - Sie können dem Datenspeichersystem jederzeit ein paar Regale hinzufügen.

* Reduzieren Sie die Kosten für die Speicherung eines Megabytes an Informationen - natürlich gibt es einen bestimmten Schwellenwert, ab dem diese Systeme kostengünstig sind.

* Ein zuverlässiger Ort zum Speichern geschäftskritischer und geschäftskritischer Daten (ohne die die Organisation nicht existieren und normal funktionieren kann).

* Ich möchte VMWare separat erwähnen - alle Chips wie das Migrieren von virtuellen Maschinen von Server zu Server und andere Extras sind nur im SAN verfügbar.

Woraus besteht es?

Wie ich oben geschrieben habe, besteht der Speicher aus Speichergeräten, Übertragungsmedien und verbundenen Servern. Betrachten wir in der Reihenfolge:

Datenspeichersysteme bestehen in der Regel aus festplatten und Controller, in einem System mit Selbstachtung, normalerweise nur 2 - 2 Controller, 2 Pfade zu jedem Laufwerk, 2 Schnittstellen, 2 Netzteile, 2 Administratoren. Unter den angesehensten Systemherstellern sind HP, IBM, EMC und Hitachi erwähnenswert. Hier zitiere ich einen Vertreter von EMC auf dem Seminar: „HP macht ausgezeichnete Drucker. Lass sie sie machen! “Ich vermute, dass HP auch EMC liebt. Der Wettbewerb zwischen den Herstellern ist jedoch ebenso ernst wie anderswo. Die Folgen des Wettbewerbs sind manchmal vernünftige Preise pro Megabyte Speichersystem und Probleme mit der Kompatibilität und Unterstützung von Wettbewerbsstandards, insbesondere für Altgeräte.

Datenträger. In der Regel basieren SANs auf einer Optik, die derzeit eine Geschwindigkeit von 4, manchmal 8 Gigabit pro Kanal bietet. Beim Bau wurden früher spezialisierte Hubs verwendet, jetzt gibt es mehr Switches, hauptsächlich von Qlogic, Brocade, McData und Cisco (die letzten beiden habe ich noch nie auf den Websites gesehen). Kabel werden traditionell für optische Netzwerke verwendet - Single-Mode und Multi-Mode, Single-Mode länger.

Im Inneren wird FCP verwendet - Fibre Channel Protocol, ein Transportprotokoll. In der Regel wird darin klassisches SCSI ausgeführt, und FCP bietet Adressierung und Übermittlung. Es gibt eine Option mit einer Verbindung über ein reguläres Netzwerk und iSCSI, die jedoch normalerweise ein lokales Netzwerk anstelle eines dedizierten Netzwerks für die Datenübertragung verwendet (und stark belastet) und Adapter mit iSCSI-Unterstützung erfordert. Die Geschwindigkeit ist also langsamer als in der Optik.

Es gibt auch eine Smart-Word-Topologie, die in allen Lehrbüchern zu SAN zu finden ist. Es gibt mehrere Topologien, die einfachste Option ist Punkt zu Punkt, wir verbinden 2 Systeme. Dies ist kein DAS, aber ein kugelförmiges Pferd im Vakuum ist die einfachste Version von SAN. Kommt als nächstes der Regelkreis (FC-AL), arbeitet er nach dem Prinzip des "Weiterleitens" - der Sender jedes Geräts ist mit dem Empfänger des nachfolgenden verbunden, die Geräte sind in einem Ring geschlossen. Lange Ketten neigen dazu, sich für eine lange Zeit zu initialisieren.

Nun, die letzte Option - eine geschaltete Struktur (Fabric), wird mit Schaltern erstellt. Die Struktur der Verbindungen hängt von der Anzahl der verbundenen Ports ab, wie beim Aufbau eines lokalen Netzwerks. Das Grundprinzip der Konstruktion ist, dass alle Pfade und Verbindungen dupliziert werden. Dies bedeutet, dass zu jedem Gerät im Netzwerk mindestens 2 verschiedene Pfade existieren. Hier wird auch das Wort Topologie verwendet, im Sinne der Organisation eines Geräteverbindungsplans und der Verbindung von Schaltern. In diesem Fall werden Switches in der Regel so konfiguriert, dass die Server nur die für sie bestimmten Ressourcen sehen. Dies wird durch das Erstellen virtueller Netzwerke erreicht und als Zoning bezeichnet. Die nächste Analogie ist VLAN. Jedem Gerät im Netzwerk wird eine analoge MAC-Adresse im Ethernet-Netzwerk zugewiesen, die als WWN (World Wide Name) bezeichnet wird. Sie wird jeder Schnittstelle und jeder Ressource (LUN) von Speichersystemen zugewiesen. Arrays und Switches können zwischen WWN-Zugriff für Server unterscheiden.

Server Stellen Sie über HBA-Host-Bus-Adapter eine Verbindung zum Speicher her. Analog zu Netzwerkkarten gibt es Adapter mit einem, zwei und vier Anschlüssen. Die besten Hundezüchter empfehlen die Installation von 2 Adaptern pro Server. Dies ermöglicht sowohl Lastausgleich als auch Zuverlässigkeit.

Und dann werden Ressourcen in die Speichersysteme geschnitten, sie sind die Festplatten (LUNs) für jeden Server, und es bleibt ein Platz in der Reserve, alles ist eingeschaltet, die Systeminstallateure schreiben die Topologie vor, fangen Störungen bei der Konfiguration der Switches und des Zugriffs an, alles beginnt und jeder lebt glücklich für immer *.

Ich berühre spezifisch nicht verschiedene Arten von Ports im optischen Netzwerk, wer es braucht - er kennt oder liest, wer es nicht braucht - hämmert nur seinen Kopf. Aber wie üblich, wenn der Port-Typ falsch eingestellt ist, funktioniert nichts.

Aus Erfahrung.

Normalerweise bestellen Sie beim Erstellen eines SAN Arrays mit verschiedenen Festplattentypen: FC für Hochgeschwindigkeitsanwendungen und SATA oder SAS für nicht sehr schnelle. Somit werden 2 Plattengruppen mit unterschiedlichen Megabyte-Kosten erhalten - teuer und schnell und langsam und traurig billig. Normalerweise hängen alle Datenbanken und andere Anwendungen mit aktiven und schnellen E / A-Vorgängen an der schnellen, während Dateiressourcen und alles andere an der langsamen.

Wenn ein SAN von Grund auf neu erstellt wird, ist es sinnvoll, es auf der Grundlage von Lösungen eines Herstellers zu erstellen. Tatsache ist, dass es trotz der erklärten Einhaltung der Normen zu Problemen mit der Gerätekompatibilität unter Wasser kommt und nicht, dass ein Teil der Geräte miteinander funktioniert, ohne mit einem Tamburin zu tanzen und mit den Herstellern Rücksprache zu halten. Um solche Probleme anzugehen, ist es normalerweise einfacher, einen Integrator anzurufen und ihm Geld zu geben, als mit Herstellern zu kommunizieren, die die Pfeile gegeneinander austauschen.

Wenn das SAN auf der Basis der vorhandenen Infrastruktur erstellt wird, kann alles kompliziert werden, insbesondere wenn es alte SCSI-Arrays und einen Zoo von alten Geräten gibt verschiedene Hersteller. In diesem Fall ist es sinnvoll, das schreckliche Biest eines Integrators um Hilfe zu bitten, der Kompatibilitätsprobleme lösen und eine dritte Villa auf den Kanarischen Inseln bauen wird.

Häufig bestellen Firmen beim Erstellen von Speichersystemen keine Herstellerunterstützung für das System. Dies ist in der Regel gerechtfertigt, wenn das Unternehmen über kompetente und kompetente Administratoren verfügt (die mich bereits 100 Mal als Teekanne bezeichnet haben) und über ein angemessenes Kapital, das den Kauf von Ersatzteilen in der erforderlichen Menge ermöglicht. Die kompetenten Administratoren werden in der Regel von Integratoren angelockt (ich habe es selbst gesehen), aber sie vergeben kein Geld für den Kauf, und nach Fehlern beginnt ein Zirkus mit dem Schrei "Ich werde alle entlassen!", Anstatt eines Anrufs zur Unterstützung und der Ankunft eines Ingenieurs mit einem Ersatzteil.

Die Unterstützung besteht in der Regel darin, tote Festplatten und Controller auszutauschen und Festplattenregale und neue Server zum System hinzuzufügen. Nach einer plötzlichen Verhinderung des Systems durch örtliche Spezialisten, insbesondere nach einem vollständigen Herunterfahren und Zerlegen des Systems (und dies geschieht), treten viele Probleme auf.

Über VMWare. Soweit ich weiß (Virtualisierungsspezialisten korrigieren mich), verfügen nur VMWare und Hyper-V über Funktionen, mit denen Sie virtuelle Maschinen im laufenden Betrieb zwischen physischen Servern übertragen können. Für die Implementierung ist es erforderlich, dass alle Server, zwischen denen die virtuelle Maschine verschoben wird, mit derselben Festplatte verbunden sind.

Über Cluster. Ähnlich wie bei VMWare benötigen die mir bekannten Systeme zum Erstellen von Failover-Clustern (Sun Cluster, Veritas Cluster Server) Speicher, der mit allen Systemen verbunden ist.

Beim Schreiben eines Artikels - fragten sie mich - in welchen RAIDs werden Laufwerke normalerweise kombiniert?

In meiner Praxis haben sie entweder RAID 1 + 0 auf jedem Plattenfach mit FC-Platten durchgeführt, wobei 1 Ersatzplatte (Hot Spare) übrig blieb und LUNs aus diesem Teil für Aufgaben herausgeschnitten wurden, oder RAID 5 von langsamen Platten, wobei wiederum 1 Platte übrig blieb zum austausch. Aber hier ist die Frage komplex und normalerweise wird die Art und Weise, wie Festplatten in einem Array organisiert werden, für jede Situation ausgewählt und gerechtfertigt. Die gleiche EMV geht zum Beispiel noch weiter und das haben sie auch zusätzliche Einstellung Array für Anwendungen, die damit arbeiten (z. B. unter OLTP, OLAP). Ich habe nicht so intensiv mit den anderen Anbietern zusammengearbeitet, aber ich denke, jeder hat eine Feinabstimmung.

* vor dem ersten schwerwiegenden Ausfall, nach dem Support normalerweise vom Hersteller oder Lieferanten des Systems gekauft wird.

Da es keine Kommentare in der Sandbox gibt, werde ich sie auf meinem persönlichen Blog veröffentlichen.

Tags: Tags hinzufügen

Wenn Server universelle Geräte sind, die in den meisten Fällen funktionieren

- entweder eine Anwendungsserverfunktion (bei Ausführung auf dem Server) spezielle Programmeund es gibt intensive Berechnungen)

- entweder eine Dateiserverfunktion (d. h. ein bestimmter Ort für die zentrale Speicherung von Datendateien)

dann SHD (Data Storage Systems) - Geräte, die speziell für Serverfunktionen wie Datenspeicherung entwickelt wurden.

Die Notwendigkeit zur Aufbewahrung

tritt normalerweise in ausreichend ausgereiften Unternehmen auf, d.h. diejenigen, die darüber nachdenken, wie

- Speichern und Verwalten von Informationen, dem wertvollsten Kapital des Unternehmens

- Gewährleistung der Geschäftskontinuität und des Schutzes vor Datenverlust

- Erhöhung der Anpassungsfähigkeit der IT-Infrastruktur

Speicher und Virtualisierung

Der Wettbewerb zwingt KMU, effizienter, ohne Ausfallzeiten und mit hoher Effizienz zu arbeiten. Produktionsmodelle, Tarifpläne und Leistungsarten ändern sich immer häufiger. Das ganze Geschäft moderner Unternehmen ist an etwas gebunden informationstechnologie. Geschäftsanforderungen ändern sich schnell und wirken sich sofort auf die IT aus - die Anforderungen an Zuverlässigkeit und Anpassungsfähigkeit der IT-Infrastruktur steigen. Virtualisierung bietet diese Funktionen, erfordert jedoch kostengünstige und einfach zu wartende Speichersysteme.

Speicherklassifizierung nach Verbindungstyp

Das. Die ersten Festplatten-Arrays, die über SCSI mit den Servern verbunden sind. Zur gleichen Zeit könnte ein Server mit nur einem Plattenarray arbeiten. Dies ist eine direkte Speicherverbindung (DAS - Direct Attached Storage).

NAS. Für eine flexiblere Organisation der Struktur des Rechenzentrums - damit jeder Benutzer ein beliebiges Speichersystem verwenden kann - ist es erforderlich, das Speichersystem mit dem lokalen Netzwerk zu verbinden. Dies ist NAS (Network Attached Storage). Der Datenaustausch zwischen dem Server und dem Speichersystem ist jedoch um ein Vielfaches intensiver als zwischen dem Client und dem Server. Daher gab es in dieser Version objektive Schwierigkeiten im Zusammenhang mit der Bandbreite des Ethernet-Netzwerks. Aus Sicherheitsgründen ist es nicht ganz richtig, Speichersysteme in einem gemeinsamen Netzwerk darzustellen.

San. Sie können jedoch ein eigenes, separates Hochgeschwindigkeitsnetzwerk zwischen Servern und Speicher erstellen. Ein solches Netzwerk wurde SAN (Storage Area Network) genannt. Die Leistung wird dadurch sichergestellt, dass das physikalische Übertragungsmedium dort eine Optik ist. Spezielle Adapter (HBA) und optische FC-Switches ermöglichen die Datenübertragung mit Geschwindigkeiten von 4 und 8 Gbit / s. Die Zuverlässigkeit eines solchen Netzwerks wurde durch Redundanz (Duplikation) von Kanälen (Adapter, Switches) erhöht. Der Hauptnachteil ist der hohe Preis.

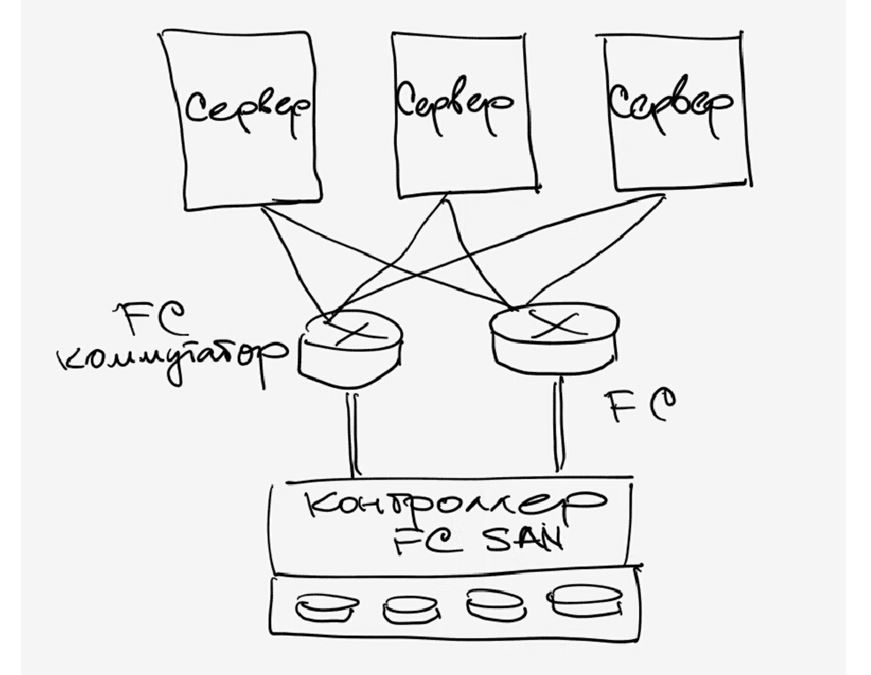

iSCSI. Mit dem Aufkommen der kostengünstigen Ethernet-Technologien 1 Gbit / s und 10 Gbit / s sieht die Optik mit einer Übertragungsgeschwindigkeit von 4 Gbit / s nicht mehr so \u200b\u200battraktiv aus, insbesondere in Anbetracht des Preises. Daher wird das iSCSI-Protokoll (Internet Small Computer System Interface) zunehmend als SAN-Umgebung verwendet. Ein iSCSI-SAN kann auf einer ausreichend schnellen physischen Basis erstellt werden, die das IP-Protokoll unterstützt.

Klassifizierung von Speichersystemen nach Anwendung:

| die Klasse | die Beschreibung |

| persönlich |

Meistens sind es normale 3,5 "oder 2,5" oder 1,8 " festplattein einem speziellen Fall untergebracht und mit USB- und / oder FireWire 1394- und / oder Ethernet- und / oder eSATA-Schnittstellen ausgestattet. |

kleine Arbeitsgruppe  |

In der Regel handelt es sich hierbei um ein stationäres oder tragbares Gerät, auf dem Sie mehrere (meistens 2 bis 5) SATA-Festplatten mit oder ohne Hot-Swap-Fähigkeit mit einer Ethernet-Schnittstelle installieren können. Die Festplatten können in RAID-Arrays mit verschiedenen Ebenen organisiert werden, um eine hohe Speicherzuverlässigkeit und Zugriffsgeschwindigkeit zu erzielen. Das Speichersystem verfügt über ein spezielles Betriebssystem, das in der Regel auf Linux basiert, und ermöglicht es Ihnen, die Zugriffsebene nach Benutzername und Kennwort zu differenzieren, Kontingente für Speicherplatz zu organisieren usw. |

|

arbeitsgruppe |

Das Gerät ist in der Regel in einem 19-Zoll-Rack (Rack-Mount) montiert, in dem Sie HotSwap-Laufwerke mit 12-24 SATA- oder SAS-Laufwerken installieren können. Es verfügt über eine externe Ethernet- und / oder iSCSI-Schnittstelle. Die Laufwerke sind in RAID-Arrays organisiert, um hohe Werte zu erzielen Zuverlässigkeit des Speichers und Zugriffsgeschwindigkeit Der Speicher wird mit einer speziellen Software geliefert, mit der Sie Zugriffsebenen unterscheiden, Kontingente für Speicherplatz organisieren, Backups (Sicherungsinformationen) organisieren usw. Solche Speichersysteme eignen sich für mittlere und große Unternehmen und werden in Verbindung mit einem oder mehreren Servern eingesetzt. |

Unternehmen   |

Ein stationäres Gerät oder Gerät, das in einem 19-Zoll-Rack (Rack-Mount) montiert ist und in dem Sie bis zu Hunderte von Festplatten installieren können. Zusätzlich zur vorherigen Klasse können Speichersysteme möglicherweise Komponenten erstellen, aktualisieren und ersetzen, ohne das Überwachungssystem zu stoppen. Die Software unterstützt Schnappschüsse und andere erweiterte Funktionen. Diese Speichersysteme eignen sich für große Unternehmen und bieten erhöhte Zuverlässigkeit, Geschwindigkeit und Schutz kritischer Daten. |

|

high-End-Unternehmen |

Zusätzlich zur vorherigen Klasse kann der Speicher Tausende von Festplatten unterstützen. |

Die Geschichte des Problems.

Die ersten Server bündelten alle Funktionen (wie Computer) in einem Paket - sowohl Computing (Anwendungsserver) als auch Datenspeicher (Dateiserver). Da jedoch einerseits der Bedarf an Anwendungen für die Rechenleistung und andererseits die Menge der verarbeiteten Daten zunimmt, ist es einfach unpraktisch geworden, alles in einem Paket unterzubringen. Es hat sich als effizienter herausgestellt, Festplatten-Arrays in separaten Fällen zu entfernen. Hier stellte sich jedoch die Frage, ob das Festplatten-Array mit dem Server verbunden werden soll. Die ersten Festplatten-Arrays, die über SCSI mit den Servern verbunden sind. In diesem Fall kann ein Server jedoch nur mit einem Plattenarray arbeiten. Die Leute wollten eine flexiblere Organisation der Struktur des Rechenzentrums - so dass jeder Server jedes Speichersystem verwenden kann. Der direkte Anschluss aller Geräte an das lokale Netzwerk und die Organisation des Datenaustauschs über Ethernet ist natürlich eine einfache und universelle Lösung. Der Datenaustausch zwischen Servern und Speicher ist jedoch um ein Vielfaches intensiver als zwischen Clients und Servern. In dieser Version (NAS - siehe unten) gab es daher objektive Probleme mit der Bandbreite des Ethernet-Netzwerks. Es gab die Idee, ein separates Hochgeschwindigkeitsnetzwerk zwischen Servern und Speicher zu erstellen. Ein solches Netzwerk wurde als SAN bezeichnet (siehe unten). Es ist ähnlich wie bei Ethernet, nur das physikalische Übertragungsmedium dort ist Optik. Es gibt auch Adapter (HBAs), die in Servern und Switches (optisch) installiert sind. Standards für die Datenübertragungsgeschwindigkeit für die Optik - 4 Gbit / s. Mit dem Aufkommen der Ethernet-Technologien 1 Gbit / s und 10 Gbit / s sowie des iSCSI-Protokolls wird Ethernet zunehmend als SAN-Umgebung verwendet.

Also, Problem Nummer 1 - "Datenspeichersysteme".

Datenspeichersysteme.

Auf Englisch werden sie in einem Wort genannt - Speicher, was sehr praktisch ist. Aber dieses Wort wird ziemlich unbeholfen ins Russische übersetzt - "Endlager". In der Umgangssprache von „IT Schnicks“ wird häufig das Wort „Geschäft“ in der russischen Transkription oder das Wort „Lagerhaus“ verwendet, aber dies ist bereits eine völlig schlechte Idee. Daher verwenden wir den Begriff "Speichersysteme", abgekürzt als SHD, oder einfach "Speichersysteme".

Speichergeräte umfassen alle Geräte zur Aufzeichnung von Daten: die sogenannten. "Flash-Laufwerke", CDs (CD, DVD, ZIP), Bandlaufwerke (Tape), festplatten (Festplatte, im alten Sinne auch „Winchesters“ genannt, da ihre ersten Modelle einem Clip mit Patronen des gleichnamigen Gewehrs aus dem 19. Jahrhundert ähnelten) usw. Festplatten werden nicht nur in Computern, sondern auch als externe USB-Geräte zum Aufzeichnen von Informationen und sogar als solche verwendet Einer der ersten iPods war beispielsweise eine kleine 1,8-Zoll-Festplatte mit Kopfhörerausgang und integriertem Bildschirm.

Vor kurzem wurde die sogenannte. SSD-Speichersysteme (Solid State Disk oder Solid State Drive), die im Prinzip dem Flash-Laufwerk einer Kamera oder eines Smartphones ähneln, verfügen nur über einen Controller und eine größere Menge gespeicherter Daten. Im Gegensatz zu festplatteDie SSD hat keine mechanisch beweglichen Teile. Bisher sind die Preise für solche Speichersysteme recht hoch, sinken aber rapide.

All dies sind Consumer-Geräte, und bei industriellen Systemen ist es notwendig, zunächst Hardware-Speichersysteme herauszugreifen: Arrays von Festplatten, die sogenannten RAID-Controller für sie, Bandspeichersysteme für sie langzeitlagerung Daten. Darüber hinaus gibt es eine separate Klasse: Controller für Speichersysteme, zum Verwalten der Datensicherung und zum Erstellen von „Snapshots“ im Speichersystem für deren spätere Wiederherstellung, Datenreplikation usw.). Zu den Speichersystemen gehören auch Netzwerkgeräte (HBA, Fibre Channel Switches, FC / SAS-Kabel usw.). Schließlich wurden umfangreiche Lösungen für Datenspeicherung, Archivierung, Datenwiederherstellung und Notfallwiederherstellung entwickelt.

Woher kommen die zu speichernden Daten? Von uns, Angehörigen, Benutzern, Anwendungsprogrammen, E-Mails sowie von verschiedenen Geräten - Dateiservern und Datenbankservern. Darüber hinaus ist der Lieferant eine große Anzahl Daten - die sogenannte M2M-Geräte (Machine-to-Machine-Kommunikation) - alle Arten von Sensoren, Sensoren, Kameras usw.

Entsprechend der Häufigkeit der Verwendung gespeicherter Daten können Speichersysteme in Kurzzeitspeichersysteme (Online-Speicher), Mittelzeitspeichersysteme (Near-Line-Speicher) und Langzeitspeichersysteme (Offline-Speicher) unterteilt werden.

Die ersten enthalten die Festplatte (oder SSD) von jedem pC. Das zweite und dritte sind externe DAS-Speichersysteme (Direct Attached Storage), bei denen es sich in Bezug auf den Computer um ein Array externer Festplatten (Disk Array) handeln kann. Sie können wiederum in „nur ein Array von Festplatten“, JBOD (Just a Bunch Of Disks), und ein Array mit einem iDAS-Controller (Intelligent Disk Array Storage) unterteilt werden.

Externe Speichersysteme gibt es in drei Arten von DAS (Direct Attached Storage), SAN (Storage Area Network) und NAS (Network Attached Storage). Leider können selbst viele erfahrene IT-Mitarbeiter den Unterschied zwischen SAN und NAS nicht erklären. Früher gab es diesen Unterschied, jetzt gibt es ihn angeblich nicht mehr. Tatsächlich gibt es einen Unterschied, und zwar einen signifikanten (siehe Abb. 1).

Abbildung 1. Der Unterschied zwischen SAN und NAS.

In einem SAN sind die Server selbst über das SAN-Speicherbereichsnetzwerk mit dem Speichersystem verbunden. Bei NAS werden Netzwerkserver über LAN mit einem gemeinsam genutzten Dateisystem in RAID verbunden.

Grundlegende Speicherkonnektivitätsprotokolle

SCSI-Protokoll (Small Computer System Interface), ausgesprochen "Squeeze", ein Protokoll, das Mitte der 80er Jahre entwickelt wurde, um externe Geräte an Mini-Mini-Computer anzuschließen. Seine Version von SCSI-3 ist die Basis für alle Speicherkommunikationsprotokolle und verwendet ein gemeinsames SCSI-Befehlssystem. Seine Hauptvorteile: Unabhängigkeit vom verwendeten Server, die Möglichkeit des Parallelbetriebs mehrerer Geräte, hohe Datenübertragungsgeschwindigkeit. Nachteile: Begrenzte Anzahl angeschlossener Geräte, die Reichweite der Verbindung ist sehr begrenzt.

FC-Protokoll(Fibre Channel), ein internes Protokoll zwischen Server und gemeinsam genutztem Speicher, Controller und Festplatten. Es ist ein weit verbreitetes serielles Kommunikationsprotokoll, das mit einer Geschwindigkeit von 4 oder 8 Gigabit pro Sekunde (Gbit / s) arbeitet. Es funktioniert, wie der Name schon sagt, durch Glasfaser, kann aber auch mit Kupfer arbeiten. Fibre Channel ist das primäre Protokoll für FC SAN-Speichersysteme.

ISCSI-Protokoll(Internet Small Computer System Interface), ein Standardprotokoll zum Übertragen von Datenblöcken über das bekannte TCP / IP-Protokoll, d.h. SCSI über IP iSCSI kann als kostengünstige Hochgeschwindigkeitslösung für remote verbundene Speichersysteme über das Internet angesehen werden. iSCSI kapselt SCSI-Befehle in TCP / IP-Paketen für die Übertragung über ein IP-Netzwerk.

SAS-Protokoll(Serial Attached SCSI). SAS verwendet die serielle Datenübertragung und ist mit SATA-Festplatten kompatibel. Derzeit kann SAS Daten mit 3Gpbs oder 6Gpbs übertragen und unterstützt den Vollduplex-Modus, d. H. kann Daten in beide Richtungen mit der gleichen Geschwindigkeit übertragen.

Arten von Speichersystemen.

Drei Haupttypen von Speichersystemen können unterschieden werden:

- DAS (Direct Attached Storage)

- NAS (Network Attached Storage)

- SAN (Storage Area Network)

Am Ende wurden Speichersysteme mit direktem Anschluss von DAS-Platten entwickelt

Abbildung 2. DAS

70-er Jahre, aufgrund des explosionsartigen Anstiegs der Benutzerdaten, die physisch einfach nicht in das interne Langzeitgedächtnis von Computern passen konnten große Computer, so genannte Großrechner). Die Datenübertragungsrate im DAS war mit 20 bis 80 Mbit / s nicht sehr niedrig, reichte aber für die damaligen Bedürfnisse aus.

SHD mit netzwerkverbindung NAS erschien in den frühen 90er Jahren. Der Grund war die rasche Entwicklung von Netzwerken und kritischen Anforderungen für teilen große Datenmengen innerhalb des Unternehmens- oder Betreibernetzwerks. Der NAS verwendete ein spezielles Netzwerk dateisystem CIFS (Windows) oder NFS (Linux), sodass verschiedene Server verschiedener Benutzer gleichzeitig dieselbe Datei vom NAS lesen können. Die Datenübertragungsgeschwindigkeit war bereits höher: 1 - 10 Gbit / s.

Abbildung 3. NAS

Mitte der 90er Jahre erschienen Netzwerke zum Anschließen von FC SAN-Speichergeräten. Ihre Entwicklung wurde durch die Notwendigkeit verursacht, über das Netzwerk verteilte Daten zu organisieren. Ein Speichergerät in einem SAN kann in mehrere kleine Knoten, LUNs (Logical Unit Number), unterteilt werden, von denen jeder zu einem Server gehört. Datenübertragungsrate auf 2-8 Gbit / s erhöht. Solche Speichersysteme könnten Technologien zum Schutz vor Datenverlust (Snapshot, Backup) bereitstellen.

Abbildung 4. FC SAN

Eine andere Art von SAN ist IP SAN (IP Storage Area Network), das Anfang der 2000er Jahre entwickelt wurde. FC-SAN-Systeme waren teuer, schwierig zu verwalten und IP-Netzwerke befanden sich auf dem Höhepunkt der Entwicklung. Aus diesem Grund erschien dieser Standard. Speicher, der mit einem iSCSI-Controller über IP-Switches mit Servern verbunden ist. Datenübertragungsrate: 1 - 10 Gbit / s.

5. IP SAN.

Die Tabelle zeigt einige vergleichende Eigenschaften Alle Speichersysteme überprüft:

| Das | NAS | San | ||

| FC SAN | IP SAN | |||

| Getriebetyp | SCSI, FC, SAS | IP | FC | IP |

| Datentyp | Datenblock | Datei | Datenblock | Datenblock |

| Typische Anwendung | Beliebig | Dateiserver | Datenbanken | Videoüberwachung |

| Vorteil | Verständlichkeit Überlegene Kompatibilität |

Einfach zu installieren, kostengünstig | Gute Skalierbarkeit | Gute Skalierbarkeit |

| Nachteile | Schwierigkeitsmanagement. Ineffiziente Ressourcennutzung. Schlechte Skalierbarkeit |

Geringe Produktivität. Gilt nicht für einige Anwendungen. |

Hohe Kosten. Komplexität der Konfiguration |

Geringe Produktivität |

Kurz gesagt, SANs dienen zum Übertragen großer Datenblöcke in den Speicher, während NASs den Zugriff auf Daten auf Dateiebene ermöglichen. Durch die Kombination von SAN + NAS erhalten Sie ein hohes Maß an Datenintegration, leistungsstarken Zugriff und Dateifreigabe. Solche Systeme werden als Unified Storage bezeichnet - "Unified Storage-Systeme".

Unified Storage-Systeme:netzwerkspeicherarchitektur, die sowohl dateibasiertes NAS als auch blockorientiertes SAN unterstützt. Solche Systeme wurden Anfang der 2000er Jahre entwickelt, um die Probleme der Verwaltung und die hohen Gesamtbetriebskosten einzelner Systeme in einem Unternehmen zu lösen. Ein solches Speichersystem unterstützt fast alle Protokolle: FC, iSCSI, FCoE, NFS, CIFS.

Festplatten

Alle Festplatten können in zwei Haupttypen unterteilt werden: Festplatte (Hard Disk Drive) und SSD (Solid State Drive). Das heißt, beide Festplatten sind hart. Was ist dann eine "Softdisk"? Ja, in der Vergangenheit gab es sogenannte "Floppy Disks" (wie sie genannt wurden, weil während des Betriebs im Laufwerk ein charakteristisches "Knallgeräusch" zu hören war). Laufwerke für sie sind immer noch in den Systemeinheiten alter Computer zu sehen, die in einigen Regierungsbehörden aufbewahrt wurden. Bei allem Wunsch können solche Magnetplatten jedoch kaum Speichersystemen zugeordnet werden. Dies waren einige Analoga der aktuellen "Flash-Laufwerke".

Der Unterschied zwischen Festplatte und SSD besteht darin, dass die Festplatte über mehrere koaxiale Magnetplatten und eine komplexe Mechanik verfügt, die die magnetischen Lese- / Schreibköpfe bewegt. Die SSD enthält keine mechanisch beweglichen Teile und ist in der Tat nur ein in Kunststoff gepresster Chip. Daher ist es streng genommen falsch, „Festplatten“ nur als Festplatte zu bezeichnen.

Festplatten können anhand der folgenden Parameter klassifiziert werden:

- Design: HDD, SSD;

- HDD-Durchmesser in Zoll: 5,25, 3,5, 2,5, 1,8 Zoll;

- Schnittstelle: ATA / IDE, SATA / NL-SAS, SCSI, SAS, FC

- Zu einer Nutzungsklasse: Individuell (Desktop-Klasse), Corporate (Entreprenesie-Klasse).

| SATA | SAS | NL-SAS | SSD | |

| Drehzahl (U / min) | 7200 | 15000/10000 | 7200 | NA |

| Typische Kapazität (TB) | 1T / 2T / 3T | 0,3T / 0,6T / 0,9T | 2T / 3T / 4T | 0,1T / 0,2T / 0,4T |

| MTBF (Stunde) | 1 200 000 | 1 600 000 | 1 200 000 | 2 000 000 |

| Hinweise | Die Entwicklung von seriellen ATA-Laufwerken. SATA 2.0 unterstützt Übertragungsraten von 300 MB / s, SATA3.0 unterstützt bis zu 600 MB / s. Die durchschnittliche jährliche Ausfallrate AFR (Annualized Failure Rate) für SATA-Laufwerke beträgt ca. 2%. |

Schwer sATA-Laufwerke mit SAS-Schnittstelle eignen sich für hierarchische (Tiering). Die durchschnittliche jährliche Ausfallrate AFR (Annualized Failure Rate) für NL-SAS-Laufwerke beträgt ca. 2%. | Festkörperlaufwerke aus elektronischen Speicherchips, einschließlich eines Steuergeräts und eines Chips (FLASH / DRAM). Die Spezifikation der Benutzeroberfläche, der Funktionen und der Verwendungsmethode ist die gleiche wie die der Festplatte, auch Größe und Form. |

Festplattenspezifikationen:

- Kapazität

In modern festplatten Die Kapazität wird in Gigabyte oder Terabyte gemessen. Bei Festplatten ist dieser Wert ein Vielfaches der Kapazität von eins magnetplatte in der Box, multipliziert mit der Anzahl der Magnete, die in der Regel mehrere ist.

- Drehzahl (nur HDD)

Die Umdrehungsgeschwindigkeit der Magnetplatten im Laufwerk, gemessen in Umdrehungen pro Minute (Rotation Per Minute), beträgt normalerweise 5400 U / min oder 7200 U / min. Festplatten mit SCSI / SAS-Schnittstellen haben eine Drehzahl von 10.000-15.000 U / min.

- Durchschnittliche Zugriffszeit \u003dMittlere Suchzeit + Mittlere Wartezeit, d.h. Zeit, um Informationen von der Festplatte zu extrahieren.

- Datenrate

Dies sind die Lese- und Schreibgeschwindigkeiten von Daten auf der Festplatte, gemessen in Megabyte pro Sekunde (MB / S). Sie unterscheiden sich normalerweise in der Größe.

- IOPS (Eingabe / Ausgabe pro Sekunde)

Die Anzahl der Eingabe- / Ausgabevorgänge (oder Lese- / Schreibvorgänge) pro Sekunde (Eingabe- / Ausgabevorgänge pro Sekunde), einer der Hauptindikatoren zur Messung der Festplattenleistung. Für Anwendungen mit häufigen Lese- und Schreibvorgängen, wie z. B. OLTP (Online Transaction Processing) - Online-Transaktionsverarbeitung, ist IOPS der wichtigste Indikator, weil Die Leistung der Geschäftsanwendung hängt davon ab. Ein weiterer wichtiger Indikator ist der Datendurchsatz, der grob als "Datendurchsatz" übersetzt werden kann, d. H. Wie viele Daten können pro Zeiteinheit übertragen werden?

RAID

Unabhängig davon, wie zuverlässig die Festplatten sind, gehen die darin enthaltenen Daten aus verschiedenen Gründen manchmal verloren. Daher wurde die RAID-Technologie (Redundant Array of Independent Disks) vorgeschlagen - ein Array unabhängiger Festplatten mit redundanter Datenspeicherung. Redundanz bedeutet, dass alle Datenbytes auf einem anderen Datenträger auf einem anderen Datenträger dupliziert werden und verwendet werden können, wenn der erste Datenträger ausfällt. Darüber hinaus trägt diese Technologie zur Erhöhung des IOPS bei.

Die Grundkonzepte von RAID sind das Strippen (sogenanntes "Streaming" oder Separieren) und das Spiegeln (sogenanntes "Spiegeln" oder Duplizieren) von Daten. Ihre Kombinationen bestimmen verschiedene Arten RAID-Arrays von Festplatten.

Folgende RAID-Level werden unterschieden:

Kombinationen dieser Typen führen zu mehreren neuen RAID-Typen:

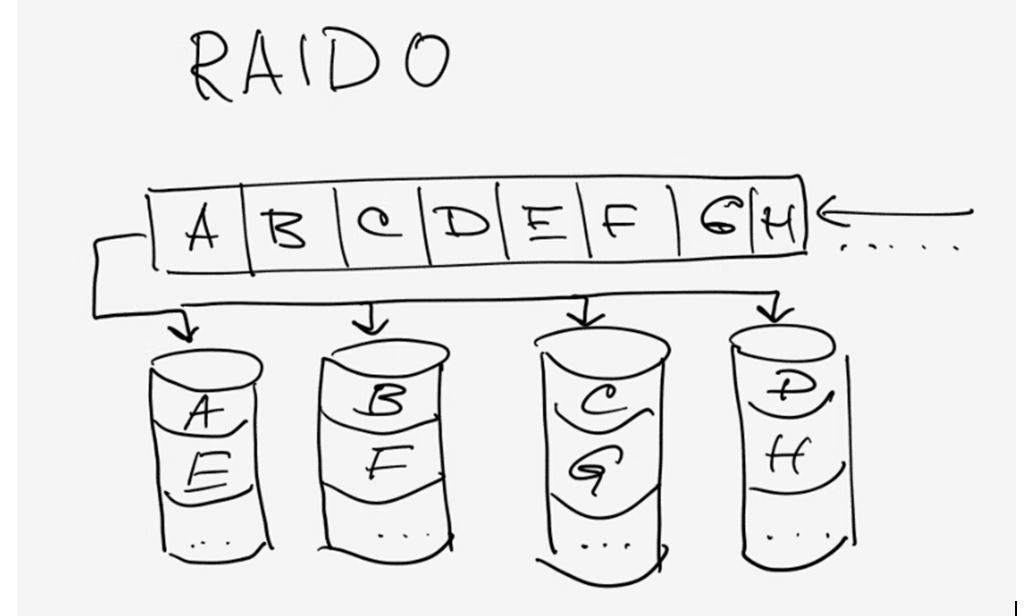

Die Abbildung zeigt das Prinzip von RAID 0 (Partitionierung):

Abb. 6. RAID 0.

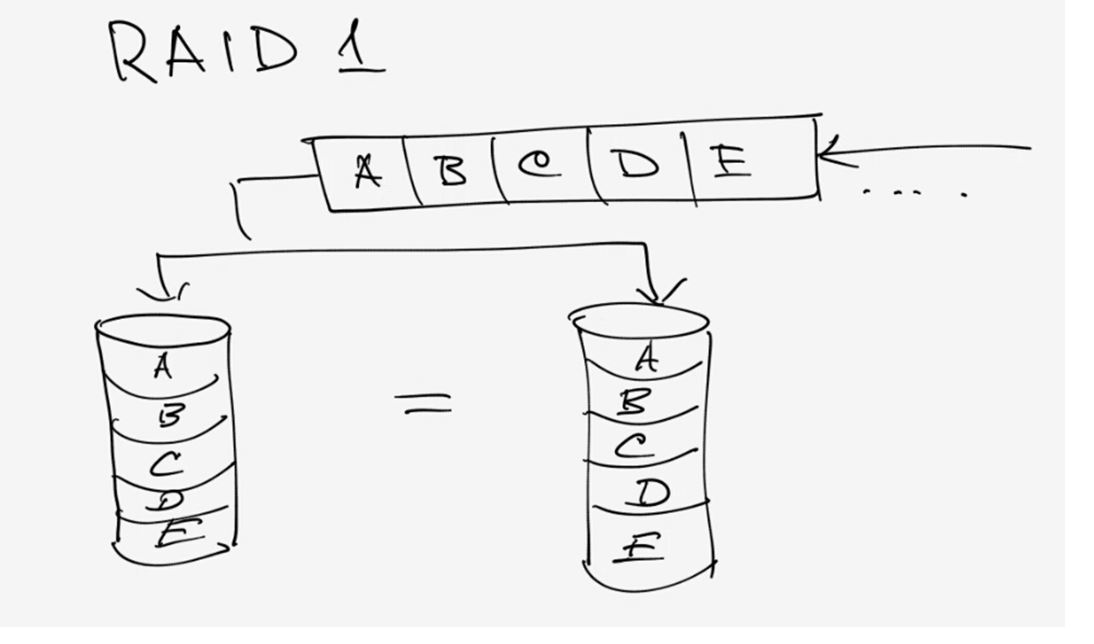

Und so wird RAID 1 (Duplikation) durchgeführt:

Abb. 7. RAID 1.

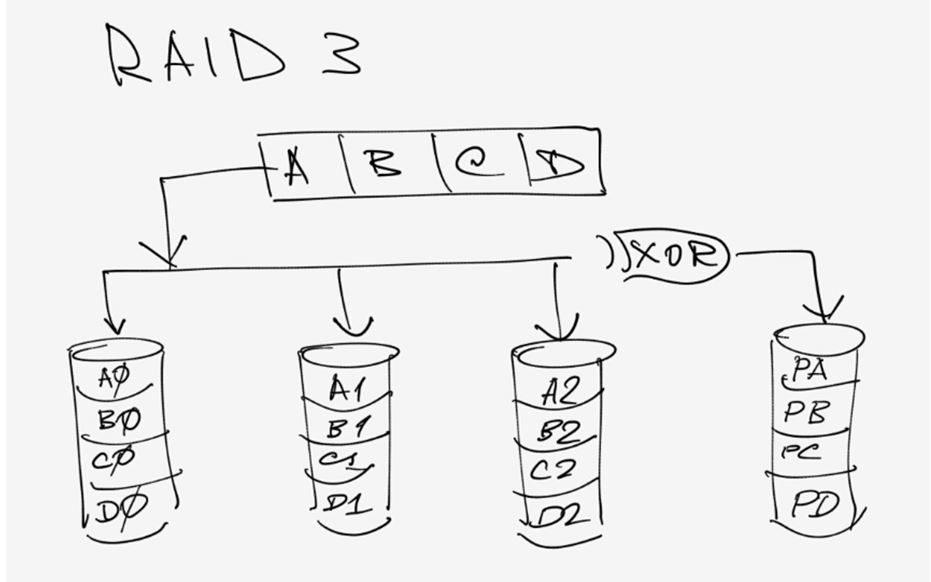

Und so funktioniert RAID 3. XOR ist ein Exklusiv-ODER (eXclusive OR) mit logischer Funktion. Mit ihm wird der Paritätswert für die Datenblöcke A, B, C, D ... berechnet, der auf einer separaten Platte aufgezeichnet wird.

Abb. 8. RAID 3.

Die obigen Schemata veranschaulichen gut das Prinzip des RAID-Betriebs und benötigen keine Kommentare. Wir werden die Betriebsschemata der verbleibenden RAID-Stufen nicht weitergeben, diejenigen, die dies wünschen, können sie im Internet finden.

Die Hauptmerkmale der RAID-Typen sind in der Tabelle aufgeführt.

Speichersoftware

Speichersoftware kann in die folgenden Kategorien unterteilt werden:

- Management und Administration (Management): Verwaltung und Einstellung von Infrastrukturparametern: Belüftung, Kühlung, Festplattenbetriebsarten usw., Tageszeitverwaltung usw.

- Datenschutz: Snapshot („Snapshot“ des Festplattenstatus), Kopieren des Inhalts der LUN, mehrfache Duplizierung (geteilter Spiegel), Remote-Datenkopie (Remote-Replizierung), kontinuierlicher Datenschutz CDP (Continuous Data Protection) usw.

- Verbesserung der Zuverlässigkeit:verschiedene Software zum mehrfachen Kopieren und Reservieren von Datenübertragungswegen innerhalb und zwischen Datenzentren.

- Effizienz steigern: Thin Provisioning-Technologie, mehrstufiger automatischer Speicher, Deduplizierung, Quality-of-Service-Management, Cache-Prefetch, Partitionierung, automatische Datenmigration , langsame Drehung der Festplatte

Sehr interessante Technologie " thin Provisioning". Wie es in der IT häufig der Fall ist, ist es häufig schwierig, die Begriffe angemessen ins Russische zu übersetzen. So ist es beispielsweise schwierig, das Wort „Bereitstellung“ („Bereitstellung“, „Unterstützung“, „Bereitstellung“) genau zu übersetzen. Keiner dieser Begriffe vermittelt die vollständige Bedeutung. Und wenn es "dünn" ist ...

Nach dem Prinzip der "Thin Provisioning" funktioniert beispielsweise ein Bankkredit. Wenn eine Bank zehntausend Kredite mit einer Obergrenze von 500.000 gewährt, muss sie keine 5 Milliarden auf dem Konto haben, da Kartennutzer normalerweise nicht das gesamte Guthaben auf einmal ausgeben. Trotzdem kann jeder Benutzer den gesamten oder fast den gesamten Kreditbetrag einzeln verwenden, wenn der Gesamtbetrag der Bankmittel noch nicht ausgeschöpft ist.

Wasser- und Elektrizitätsunternehmen arbeiten ebenfalls. Bei der Versorgung mit Wasser oder Strom erwarten sie, dass nicht alle Bewohner sofort alle Wasserhähne öffnen oder alle Elektrogeräte in ihren Häusern einschalten. Durch den flexibleren Ressourcenverbrauch können Preis und Ressourcenkapazität gespart werden.

Abb. 9. Thin Provisioning.

Die Verwendung von Thin Provisioning ermöglicht es uns, das Problem der ineffizienten Verteilung von Speicherplatz im SAN zu lösen, Speicherplatz zu sparen, Verwaltungsverfahren für die Zuweisung von Speicherplatz zu Anwendungen im Speicher zu vereinfachen und mithilfe der so genannten Überzeichnung mehr Speicherplatz für Anwendungen zuzuweisen, als wir physisch haben Diese Anwendungen erfordern nicht den gesamten Speicherplatz gleichzeitig. Je nach Bedarf ist es später möglich, die physische Kapazität des Speichers zu erhöhen.

Die Unterteilung des Speichersystems in gestufte Speicherebenen setzt voraus, dass verschiedene Daten in Speichergeräten gespeichert sind, deren Geschwindigkeit der Häufigkeit des Zugriffs auf diese Daten entspricht. Beispielsweise können häufig verwendete Daten in einem "Online-Speicher" abgelegt werden sSD-Laufwerke mit hoher Zugriffsgeschwindigkeit, hohe Leistung. Der Preis für solche Datenträger ist jedoch immer noch hoch, so dass es ratsam ist, sie (vorerst) nur für die Online-Speicherung zu verwenden.

FC / SAS-Laufwerke sind auch recht schnell und der Preis ist moderat. Daher eignen sich solche Platten gut für die "Near-Line-Speicherung", bei der Daten gespeichert werden, auf die nicht so oft, aber gleichzeitig und nicht so selten zugegriffen wird.

Schließlich weisen SATA / NL-SAS-Laufwerke eine relativ niedrige Zugriffsgeschwindigkeit auf, sie zeichnen sich jedoch durch eine hohe Kapazität und einen relativ niedrigen Preis aus. Aus diesem Grund werden normalerweise Offline-Speicher für selten genutzte Daten verwendet.

Sobald das Steuerungssystem feststellt, dass der Datenzugriff auf Offlinespeicher häufiger geworden ist, überträgt es diese in den Near-Line-Speicher und mit der weiteren Aktivierung seiner Verwendung auch in den Onlinespeicher auf SSD-Festplatten.

Deduplizierung (Wiederholungseliminierung) von Daten (Deduplizierung, DEDUP): Wie der Name schon sagt, wird die Wiederholung von Daten auf der Festplatte vermieden, die normalerweise für die Datensicherung verwendet wird. Obwohl das System nicht feststellen kann, welche Informationen redundant sind, kann es feststellen, ob Daten dupliziert wurden. Dadurch können die Anforderungen an die Kapazität des Backup-Systems deutlich reduziert werden.

Reduzierung der Festplattenabsenkung) - Was normalerweise als "Ruhezustand" (Einschlafen) der Festplatte bezeichnet wird. Daten auf einem Laufwerk werden möglicherweise nicht verwendet lange ZeitIn diesem Fall versetzt die Technologie des Reduzierens der Geschwindigkeit der Platte sie in den Ruhezustand, um den Energieverbrauch für eine nutzlose Drehung der Platte mit normaler Geschwindigkeit zu verringern. Dies erhöht auch die Lebensdauer der Festplatte und die Zuverlässigkeit des gesamten Systems. Wenn Sie die erste Anforderung für Daten auf dieser Festplatte erhalten, "wacht" sie auf, und ihre Rotationsgeschwindigkeit erhöht sich. Die Kosten für die Energieeinsparung und die Erhöhung der Zuverlässigkeit verzögern sich, wenn Sie zum ersten Mal auf die Daten auf der Festplatte zugreifen. Diese Karte ist jedoch gerechtfertigt.

Momentaufnahme des Zustands der Festplatte () Der Schnappschuss ist eine vollständig verwendbare Kopie eines bestimmten Datensatzes auf der Festplatte zum Zeitpunkt der Erstellung dieser Kopie (weshalb er als „Schnappschuss“ bezeichnet wird). Eine solche Kopie wird verwendet, um den Zustand des Systems zum Zeitpunkt des Kopierens teilweise wiederherzustellen. Gleichzeitig wird die Kontinuität des Systems überhaupt nicht beeinträchtigt und die Leistung wird nicht beeinträchtigt.