Сетевые хранилища данных NAS

Объемы информации и данных, с которыми работают современные компании, значительно превышают уровень десятилетней и даже пятилетней давности. Технические решения,

позволяющие сегодня оперативно обрабатывать такие масштабы корпоративных данных существенно отличаются от схем, работающих в условиях "бытового пользования". Для жизнедеятельности

бизнеса необходимы уже несколько серверов, одновременно выполняющих разные задачи: терминальные, почтовые, DNS, прокси-серверы и другие, часто не объединенные в кластерную систему.

При таком распределении возникает проблема оперативной обработки и резервировании данных с различных устройств. Для решения этой задачи используются системы хранения данных (СХД), выбрать и купить которые предлагает наша компания.

Преимущества использования внешнего сетевого хранилища данных

Подобная система хранения данных (СХД) для работы с данными являются комплексным решением, позволяющим централизованно хранить любые объемы информации, обеспечивая надежность её защиты, оперативность обработки и полное архивирование. Сетевое хранилище данных имеет ещё несколько преимуществ перед классическими решениями распределения информации между несколькими серверами. Отказоустойчивость достигается возможностью как частичного, так и полного резервирования составляющих сетевой СХД. Внешнее сетевое хранилище данных отличается более мощной производительностью и оперативностью передачи данных, легко адаптируется под бизнес-потребности компании, так как имеет возможность легко масштабироваться и подстраиваться под изменения объема информационных потоков данных в компании. Хранилище данных в отличие от стандартных баз данных можно использовать не только для обработки транзакций, но и для анализа динамики продаж за несколько лет, формирования отчетов в различных форматах, интегрирования данных из различных регистрирующих систем.

Существует четыре вида хранения данных:

- NAS. Надёжные, недорогие и легко настраиваемые комплексы.

- DAS. Схемы с внешней магистралью, дающей возможность подключения неограниченного количества дисков.

- SAN. Хорошо подходят для хранения почтовой базы данных и обеспечивают оперативный доступ к информации.

- Отказоустойчивые хранилища данных. Объединяются в кластерную схему и обеспечивают наибольшую надежность и скорость передачи данных.

Внешние хранилища данных применяются в целях экономии внутреннего дискового пространства, предотвращения потери данных, обеспечения безопасности и доступности содержимого в любое время.

Купить сетевое хранилище данных за хорошую стоимость? Вам сюда!

Если вы решили купить сетевое хранилище данных для своей организации, компания Тринити обеспечит Ваш бизнес надежными и мощными системами хранения данных. В нашем ассортименте есть различные конфигурации СХД. Мы являемся официальными представителями лидирующих на мировом рынке производителей IT-оборудования и имеем возможность оперативно укомплектовать хранилище данных любой конфигурации. Мы предлагаем системы хранения данных от таких производителей как Dell , HP, Lenovo, EMC и др.

Для каждой конкретной компании в зависимости её требований и задач, наши специалисты помогут выбрать или собрать систему хранения данных в индивидуальной комплектации, оптимальной для её масштабов, бюджета и уже работающей сетевой инфраструктуры. Цена на выбранную систему хранения данных будет зависеть от комплектации, стоимость проектирования хранилища данных в зависимости от поставленных задач, вы можете уточнить у наших специалистов.

Все работы по анализу текущего состояния технической базы, подбору нужной комплектации и установке оборудования наша компания берет на себя. Вам необходимо просто оставить заявку нашим специалистам.

Кроме того, мы обеспечиваем техническую поддержку поставляемого оборудования. Наши сотрудники - это высококвалифицированные инженеры, монтажники, IT-специалисты окажут Вам квалифицированную помощь в любое время. От профессиональной консультации до модернизации и разработки оборудования.

Еще никогда проблема хранения файлов не стояла так остро, как сегодня.

Появление жестких дисков объемом в 3 и даже 4ТБ, Blu-Ray дисков емкостью от 25 до 50ГБ, облачных хранилищ - не решает проблему. Вокруг нас становится все больше устройств, порождающих тяжеловесный контент вокруг: фото и видео-камеры, смартфоны, HD-телевидение и видео, игровые консоли и т.п. Мы генерируем и потребляем (в основном из интернета) сотни и тысячи гигабайт.

Это приводит к тому, что на компьютере среднестатистического пользователя хранится огромное количество файлов, на сотни гигабайт: фотоархив, коллекция любимых фильмов, игр, программ, рабочие документы и т.д.

Это все нужно не просто хранить, но и уберечь от сбоев и прочих угроз.

Псевдо-решения проблемы

Можно оснастить свой компьютер емким жестким диском. Но в этом случае встает вопрос: как и куда архивировать, скажем, данные с 3-терабайтного диска?!

Можно поставить два диска и использовать их в режиме RAID «зеркало» или просто регулярно выполнять резервное копирование с одного на другой. Это тоже не лучший вариант. Предположим, компьютер атакован вирусами: скорее всего, они заразят данные на обеих дисках.

Можно хранить важные данные на оптических дисках, организовав домашний Blu-Ray архив. Но пользоваться им будет крайне неудобно.

Сетевое хранилище - решение проблемы! Отчасти…

Network attached storage (NAS) - сетевое файловое хранилище. Но можно объяснить еще проще:

Предположим, у вас дома два или три компьютера. Скорее всего, они подключены к локальной сети (проводной или беспроводной) и к интернету. Сетевое хранилище - это специализированный компьютер, который встраивается в вашу домашнюю сеть и подключается к интернету.

В результате этого - NAS может хранить какие-либо Ваши данные, а вы можете получать к нему доступ с любого домашнего ПК или ноутбука. Забегая вперед, стоит сказать, что локальная сеть должна быть достаточно современной для того, чтобы вы могли быстро и без проблем «прокачивать» по ней десятки и сотни гигабайт между сервером и компьютерами. Но об этом - позже.

Где взять NAS?

Способ первый: покупка. Более-менее приличный NAS на 2 или 4 жестких диска можно купить за 500-800 долларов. Такой сервер будет упакован в небольшой корпус и готов к работе, что называется, «из коробки».

Способ первый: покупка. Более-менее приличный NAS на 2 или 4 жестких диска можно купить за 500-800 долларов. Такой сервер будет упакован в небольшой корпус и готов к работе, что называется, «из коробки».

Однако, ПЛЮС к этим 500-800 долларов добавляется еще стоимость жестких дисков! Так как обычно NAS продаются без них.

Плюсы: вы получаете готовое устройство и тратите минимум времени.

Минусы такого решения: NAS стоит как настольный компьютер, но при этом обладает несравнимо меньшими возможностями. Фактически это просто сетевой внешний диск за большие деньги. За довольно большие деньги вы получаете ограниченный, невыгодный набор возможностей.

Мое решение: самостоятельная сборка!

Это намного дешевле покупки отдельного NAS, хоть и чуть дольше ведь вы собираете машину самостоятельно). Однако, вы получаете полноценный домашний сервер, который при желании можно использовать во всем спектре его возможностей.

ВНИМАНИЕ! Я настоятельно не рекомендую собирать домашний сервер, используя старый компьютер или старые, отработавшие свое комплектующие. Не забывайте, что файловый сервер - это хранилище ваших данных. Не поскупитесь сделать его максимально надежным, чтобы в один прекрасный день все ваши файлы не «сгорели» вместе с жесткими дисками, например, из-за сбоя в цепи питания системной платы…

Итак, мы решили собрать домашний файловый сервер. Компьютер, жесткие диски которого доступны в домашней локальной сети для использования. Соответственно, нам нужно чтобы такой компьютер был экономичным в плане энергопотребления, тихим, компактным, не выделял много тепла и обладал достаточной производительностью.

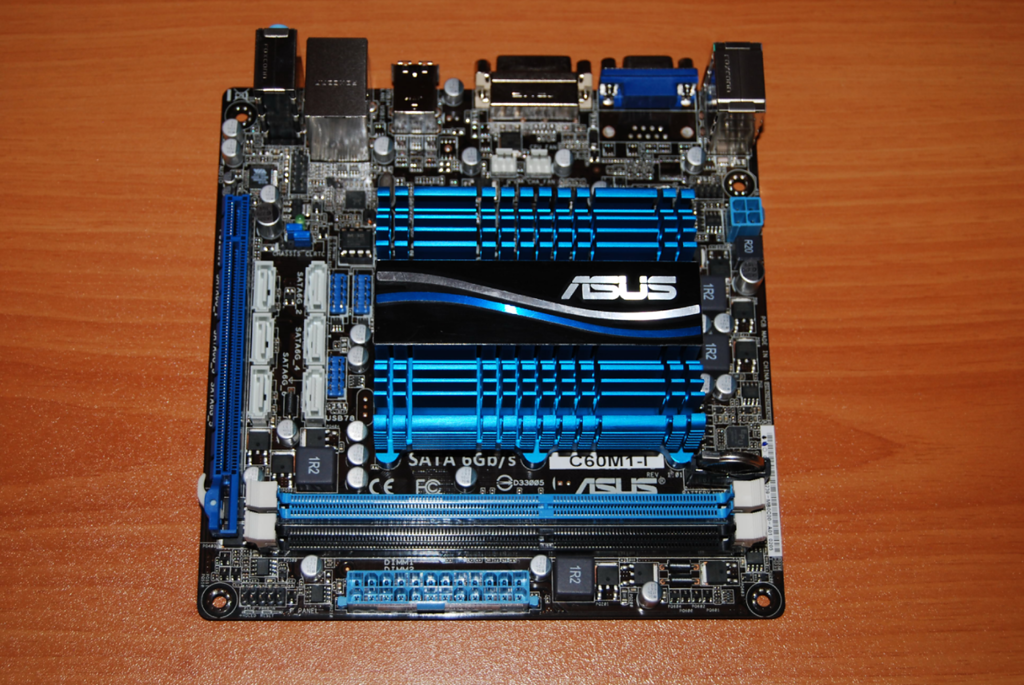

Идеальным решением исходя из этого является системная плата со встроенным в нее процессором и пассивным охлаждением, компактных размеров.

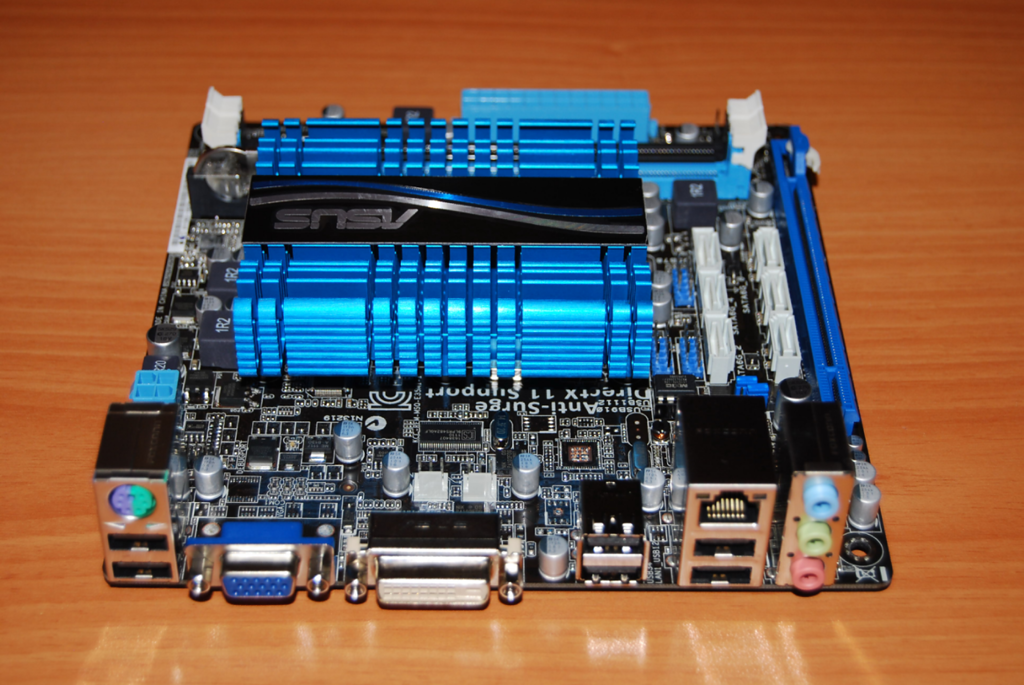

Я выбрал системную плату ASUS С-60M1-I . Она была куплена в интернет-магазине dostavka.ru:

В комплекте поставки качественное руководство пользователя, диск с драйверами, наклейка на корпус, 2 кабеля SATA и задняя панель для корпуса:

ASUS, как впрочем и всегда, укомплектовал плату очень щедро. Полные спецификации платы вы можете узнать здесь: http://www.asus.com/Motherboard/C60M1I/#specifications . Я скажу лишь о некоторых важных моментах.

При стоимости всего в 3300 рублей - она обеспечивает 80% всего того, что нам нужно для сервера.

На борту платы находится двухъядерный процессор AMD C-60 со встроенным графическим чипом. Процессор имеет частоту 1 ГГц (автоматически может увеличиваться до 1,3 ГГц). На сегодня он устанавливается в некоторые нетбуки и даже ноутбуки. Процессор класса Intel Atom D2700. Но всем известно, что Atom имеет проблемы с параллельными вычислениями, что часто сводит его производительность на «нет». А вот C-60 - лишен этого недостатка, и в добавок оснащен довольно мощной для этого класса графикой.

В наличии два слота для памяти DDR3-1066 , с возможностью установки до 8 ГБ памяти.

Плата содержит на борту 6 портов SATA 6 Гбит . Что позволяет подключить к системе целых 6 дисков(!), а не только 4, как в обычном NAS для дома.

Что САМОЕ важное - плата построена на базе UEFI , а не привычного нам BIOS. Это значит, что система сможет нормально работать с жесткими дисками более 2,2 ТБ. Она «увидит» весь их объем. Системные платы на BIOS не могут работать с жесткими дисками более 2,2 ГБ без специальных «утилит-костылей». Разумеется, использование такого рода утилит недопустимо, если мы ведем речь о надежности хранения данных и о серверах.

С-60 довольно холодный процессор, поэтому он охлаждается с помощью одного только алюминиевого радиатора. Этого достаточно, чтобы даже в момент полной загрузки температура процессора не повышалась более 50-55 градусов. Что является нормой.

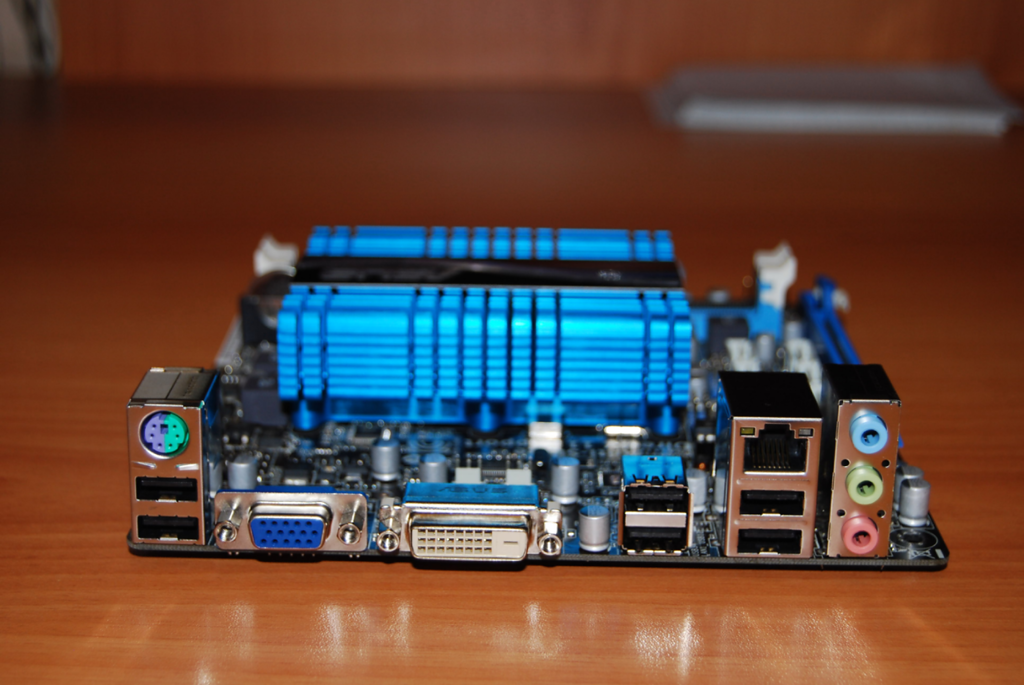

Набор портов вполне стандартный, огорчает только отсутствие нового USB 3.0. А особо хочется ответить наличие полноценного гигабитного сетевого порта:

На эту плату я установил 2 модуля по 2 ГБ DDR3-1333 от Patriot:

Система Windows 7 Ultimate устанавливалась на жесткий диск WD 500GB Green, а для данных я приобрел HDD Hitachi-Toshiba на 3 ТБ:

Все это оборудование у меня питается от БП FSP на 400 Ватт, что, разумеется - с запасом.

Финальным этапом была сборка всего этого оборудования в корпус mini-ATX.

Сразу после сборки я установил на компьютер Windows 7 Ultimate (установка заняла порядка 2 часов, что нормально, учитывая низкое быстродействие процессора).

После всего этого я отключил от компьютера клавиатуру, мышь и монитор. Фактически, остался один системный блок подключенный к локальной сети по кабелю.

Достаточно запомнить локальный IP этого ПК в сети, чтобы подключатся к нему с любой машины через стандартную Windows-утилиту «Подключение к удаленному рабочему столу»:

Я намеренно не стал устанавливать специализированные операционные системы для организации файлового хранилища, типа FreeNAS. Ведь в таком случае, не было бы особого смысла собирать отдельный ПК под эти нужды. Можно было бы просто купить NAS.

А вот отдельный домашний сервер, который можно загрузить работой на ночь и оставить - это интереснее. К тому же, привычным интерфейсом Windows 7 удобно управлять.

Итого общая стоимость домашнего сервера БЕЗ жестких дисков составила 6 000 рублей.

Важное дополнение

При использовании любого сетевого хранилища очень важна пропускная способность сети. Причем, даже обычная 100 Мегабитная кабельная сеть не приводит в восторг, когда вы, скажем, выполняете архивацию со своего компьютера на домашний сервер. Передать 100 ГБ по 100 Мегабитной сети - это уже несколько часов.

Что уж говорить о Wi-Fi. Хорошо, если вы используете Wi-Fi 802.11n - в этом случае скорость сети держится в районе 100 Мегабит. А если стандарт 802.11g, где скорость редко бывает больше 30 Мегабит? Это очень, очень мало.

Идеальный вариант, когда взаимодействие с сервером происходит по кабельной сети Gigabit Ethernet . В этом случае - это действительно быстро.

Но о том, как создать такую сеть быстро и с минимальными затратами - я расскажу в отдельной статье.

Каким образом нужно классифицировать архитектурные схемы СХД? Мне кажется, актуальность этого вопроса в дальнейшем будет только расти. Как разобраться во всём этом многообразии предложений, имеющихся на рынке? Сразу хочу предупредить, что этот пост не предназначен для ленивых или не желающих много читать.

Можно вполне успешно классифицировать системы хранения, наподобие того, как биологи выстраивают родственные связи между видами живых организмов. Если хотите, можно назвать это «древом жизни» мира технологий хранения информации.

Построение подобных древ помогает лучше понимать окружающий мир. В частности, можно выстроить схему происхождения и развития любых видов СХД, и быстро понять, что же лежит в основе любой новой технологии, появляющейся на рынке. Это позволяет сразу определить сильные и слабые стороны того или иного решения.

Хранилища, позволяющие работать с информацией любого вида, архитектурно можно разделить на 4 основные группы. Главное, не зацикливаться на некоторых вещах, которые сбивают с толку. Многие склонны классифицировать платформы на основе таких «физических» критериев, как межкомпонентное соединение (interconnect) («У них у всех есть внутренняя шина между нодами!»), или протокол («Это блок, или NAS, или многопротокольная система!»), или делят на аппаратные и программные («Это же просто ПО на сервере!»).

Это совершенно неправильный подход к классифицированию. Единственно верным критерием является программная архитектура, используемая в том или ином решении, поскольку от этого зависят все основные характеристики системы. Остальные компоненты СХД зависят от того, какая именно программная архитектура была выбрана разработчиками. И с этой точки зрения «аппаратные» и «программные» системы могут быть лишь вариациями той или иной архитектуры.

Но не поймите меня неправильно, я не хочу сказать, что разница между ними невелика. Просто она не фундаментальна.

И хочу ещё кое-что уточнить, прежде чем перейти к делу. Для нашей натуры свойственно задавать вопросы «А что из этого самое лучшее/правильное?». Ответить на это можно только одно: «Есть лучшие решения для каких-то конкретных ситуаций или видов нагрузки, но не существует универсального идеального решения». Именно особенности нагрузки диктуют выбор архитектуры , и больше ничто другое.

К слову, недавно я участвовал в забавной беседе на тему ЦОД, работающих исключительно на флэш-накопителях. Мне импонирует страстность в любых проявлениях, и совершенно очевидно, что флэш вне конкуренции в ситуациях, когда производительность и время задержки играют решающую роль (помимо многих других факторов). Но должен признать, что мои собеседники были неправы. У нас есть один клиент, его услугами, даже не подозревая об этом, ежедневно пользуется множество людей. Может ли он полностью перейти на флэш? Нет.

Это большой клиент. А вот другой, ОГРОМНЫЙ, раз в 10 больше. И я опять не могу согласиться с тем, что этот клиент может перейти исключительно на флэш:

Обычно в качестве контраргумента заявляют, что в конце концов флэш достигнет такого уровня развития, что затмит магнитные накопители. С оговоркой, что флэш будет применяться с паре с дедупликацией. Но не во всех случаях целесообразно применять дедупликацию, как и компрессию.

Ну, с одной стороны, флэш-память будет дешеветь, до определённого предела. Мне казалось, что это будет происходить несколько быстрее, но уже доступны SSD-накопители ёмкостью 1 Тб за $550, это большой прогресс. Конечно, разработчики традиционных винчестеров тоже не сидят сложа руки. В районе 2017-2018 годов конкуренция должна усилиться, поскольку будут внедряться новые технологии (вероятнее всего, фазовый сдвиг и углеродные нанотрубки). Но дело вовсе не в противостоянии флэш и винчестеров, или даже программных и аппаратных решений, главное - архитектура .

Она настолько важна, что практически невозможно поменять архитектуру СХД, не переделав практически всё. То есть, по сути, не создав новую систему. Поэтому хранилища обычно создаются, развиваются и умирают в рамках какой-то одной изначально выбранной архитектуры.

Четыре типа систем хранения данных

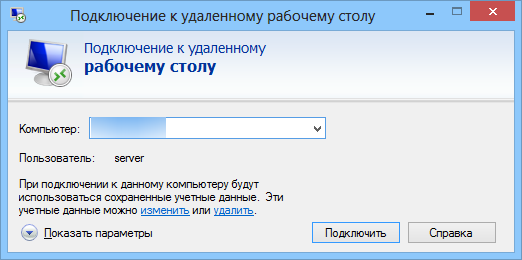

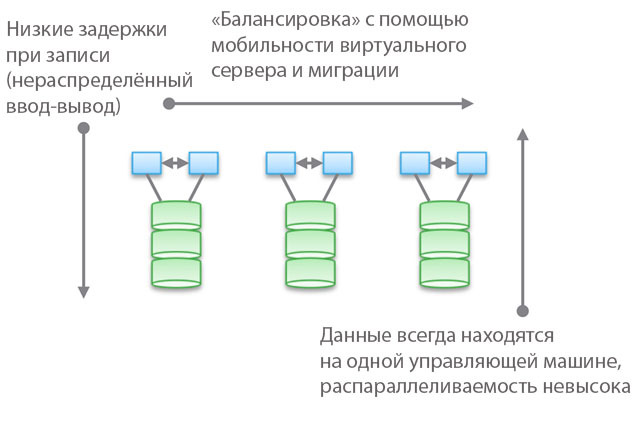

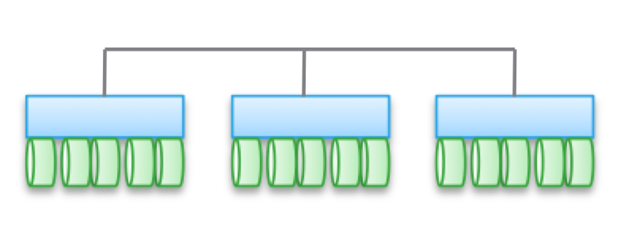

Тип 1. Кластеризованные архитектуры . Они не рассчитаны на совместное использование памяти нодами, по сути, все данные находятся в одном ноде. Одной из особенностей архитектуры является то, что иногда устройства «пересекаются» (trespass), даже если они «доступны из нескольких нодов». Другая особенность заключается в том, что вы можете выбрать машину, указать ей какие-то накопители и сказать «эта машина имеет доступ к данным на этих носителях». Синим на рисунке обозначены ЦПУ/память/система ввода-вывода, а зелёным - носители, на которых хранятся данные (флэш или магнитные накопители).

Для данного типа архитектур характерен прямой и очень быстрый доступ к данным. Между машинами будут возникать небольшие задержки, поскольку для обеспечения высокой доступности применяется зеркалирование ввода-вывода и кэширование. Но в целом обеспечивается относительно прямой доступ по ветви кода. Программные хранилища достаточно просты и имеют малое время задержки, поэтому зачастую обладают богатым функционалом, службы данных легко добавляются. Неудивительно, что большинство стартапов начинают с подобных хранилищ.

Обратите внимание, что одной из разновидностей этого типа архитектур является PCIe-оборудование для не HA-серверов (карты расширения Fusion-IO, XtremeCache). Если добавить к нему ПО для распределённого хранилища, когерентность и HA-модель, то подобное программное хранилище будет соответствовать одному из четырёх типов архитектур, описываемых в этом посте.

Применение «федеративных моделей» помогает улучшить горизонтальную масштабируемость архитектур этого типа с точки зрения менеджмента. В данных моделях могут использоваться разные подходы к повышению мобильности данных для перебалансировки между управляющими машинами и хранилищами. Например, в рамках VNX это означает «мобильность VDM». Но я считаю, что называть это «горизонтально масштабируемой архитектурой» будет натяжкой. И, по моему опыту, большинство клиентов разделяют эту точку зрения. Причиной тому расположение данных на одной управляющей машине, иногда - «в аппаратном шкафе» (behind an enclosure). Их можно перемещать, но они всегда будут в каком-то одном месте. С одной стороны, это позволяет снизить количество циклов и задержку при записи. С другой стороны, все ваши данные обслуживаются единственной управляющей машиной (возможен непрямой доступ с другой машины). В отличие от второго и третьего типов архитектур, о которых поговорим ниже, здесь балансировка и настройка играют важную роль.

Объективно говоря, этот абстрактный федеративный уровень влечёт за собой и некоторое увеличение задержки, поскольку использует программное перенаправление. Это аналогично усложнению кода и увеличению задержки в типах архитектур 2 и 3, и отчасти нивелирует преимущества первого типа. В качестве конкретного примера можно привести UCS Invicta, этакий «Silicon Storage Routers». В случае с NetApp FAS 8.x, работающим в кластерном режиме, код изрядно усложнён внедрением федеративной модели.

Продукты, использующие кластерные архитектуры - VNX или NetApp FAS, Pure, Tintri, Nimble, Nexenta и (я думаю) UCS Invicta/UCS. Одни представляют собой «аппаратные» решения, другие - «чисто программные», третьи - «программные в виде аппаратных комплексов». Все они ОЧЕНЬ сильно различаются с точки зрения обработки данных (в Pure и UCS Invicta/Whiptail подразумевается использование только флэш-накопителей). Но архитектурно все перечисленные продукты родственны. Например, вы настраиваете службы обработки данных исключительно для резервного копирования, программный стек становится Data Domain, ваш NAS работает как лучший в мире инструмент для бэкапа - и это тоже архитектура «первого типа».

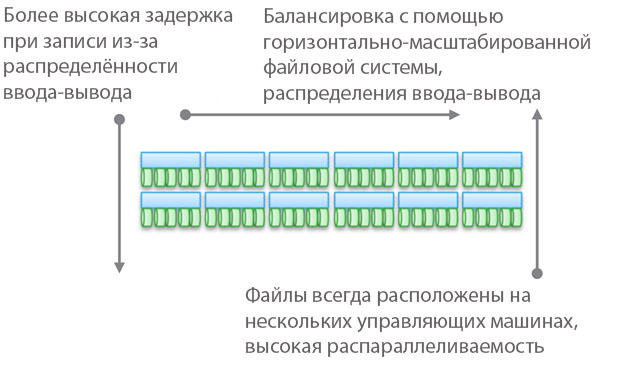

Тип 2. Слабо сопряжённые, горизонтально масштабированные архитектуры . Ноды не используют память совместно, но сами данные по нескольким нодам. Эта архитектура подразумевает использование большего количества межнодовых связей для записи данных, что увеличивает количество циклов. Хоть операции записи и распределены, но всегда когерентны.

Обратите внимание, что в этих архитектурах не обеспечивается высокая доступность нода в связи с операциями копирования и распределения данных. По той же причине здесь всегда больше операций ввода-вывода по сравнению с простыми кластерными архитектурами. Так что производительность получается несколько ниже, несмотря на небольшой уровень задержки при записи (NVRAM, SSD и т.д.).

В некоторых разновидностях архитектур часто нодов собираются в подгруппы, а остальные используются для управления подгруппами (ноды метаданных). Но здесь проявляются эффекты, описанные выше для «федеративных моделей».

Подобные архитектуры довольно просто масштабируются. Поскольку данные хранятся в нескольких местах и могут обрабатываться многочисленными нодами, эти архитектуры могут отлично подойти для задач, когда требуется распределённое чтение. Кроме того, они хорошо сочетаются с ПО для серверов/хранилищ. Но лучше всего применять подобные архитектуры в условиях транзакционных нагрузок: благодаря их распределённости вы можете не использовать HA-сервер, а слабая сопряжённость позволяет обойтись Ethernet.

Этот тип архитектур используется в таких продуктах, как EMC ScaleIO и Isilon, VSAN, Nutanix и Simplivity. Как в случае с Типом 1, все эти решения совершенно непохожи друг на друга.

Слабая сопряжённость означает, что зачастую эти архитектуры позволяют заметно увеличивать количество нодов. Но, напомню, они НЕ используют память совместно, код каждого нода работает независимо от других. Но дьявол, как говорится, в деталях:

- Чем больше распределены операции записи, тем выше задержки и ниже эффективность IOP. Например, в Isilon уровень распределённости очень высок файлов, и хотя с каждым обновлением задержки уменьшаются, но всё же он никогда не продемонстрирует высочайшей производительности. Зато Isilon чрезвычайно силён с точки зрения распаралеллеливания.

- Если уменьшить степень распределённости (пусть и при большом количестве нодов), то задержки могут снизиться, но при этом вы урежете свои возможности по распараллеливанию чтения данных. Например, во VSAN используется модель «виртуальная машина как объект», что позволяет запускать многочисленные копии. Казалось бы, виртуальная машина должна быть доступна определённому хосту. Но, по факту, во VSAN она «сдвигается» по направлению к ноду, который хранит её данные. Если вы используете это решение, то можете сами посмотреть, как увеличение количества копий объекта влияет на задержку и операции ввода-вывода в рамках всей системы. Подсказка: больше копий = выше нагрузка на систему в целом, причём зависимость нелинейная, как вы могли бы ожидать. Но для VSAN это не проблема благодаря преимуществам модели «виртуальная машина как объект».

- Можно добиться низкой задержки в условиях высокого масштабирования и распараллеливания при чтении, но только при условии точного разделения данных и записи небольшого количества копий. Этот подход используется в ScaleIO. Каждый том разделён на большое количество фрагментов (по умолчанию по 1 Мб), которые распределены по всем задействованным нодам. В результате достигается чрезвычайно высокая скорость чтения и перераспределения наряду с мощным распараллеливанием. Задержка при записи может быть менее 1 мсек при использовании соответствующей сетевой инфраструктуры и SSD/PCIe Flash в нодах кластера. Однако каждая операция записи производится в двух нодах. Конечно, в отличие от VSAN здесь виртуальная машина не рассматривается как объект. Но если бы рассматривалась, то масштабируемость была бы хуже.

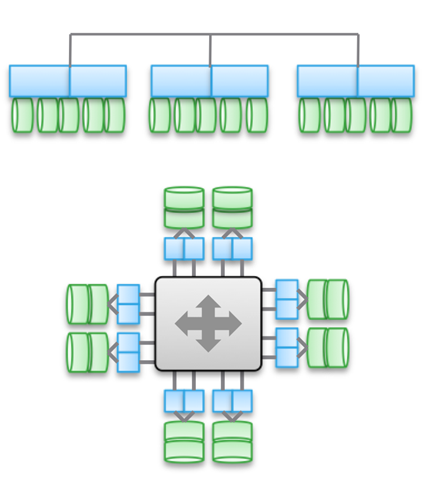

Тип 3. Сильно сопряжённые, горизонтально масштабированные архитектуры . Здесь применяется совместное использование памяти (для кэширования и некоторых типов метаданных). Данные распределены по различным нодам. Этот тип архитектур подразумевает использование очень большого количества межнодовых соединений для всех видов операций.

Совместное использование памяти является краеугольным камнем этих архитектур. Исторически сложилось, что через все управляющие машины могут осуществляться симметричные операции ввода-вывода (см. иллюстрацию). Это позволяет перебалансировать нагрузку в случае возникновения каких-либо сбоев. Данная идея закладывалась в основу таких продуктов, как Symmetrix, IBM DS, HDS USP и VSP. В них осуществляется совместны доступ к кэшу, поэтому процедура ввод-вывода можно управлять с любой машины.

Верхняя диаграмма на иллюстрации отражает архитектуру EMC XtremIO. На первый взгляд, она аналогична Типу 2, но это не так. В данном случае модель совместно используемых распределённых метаданных подразумевает использование IB и удалённого прямого доступа к памяти, чтобы все ноды имели доступ к метаданным. При этом каждый нод представляет собой HA-пару. Как видите, Isilon и XtremIO сильно различаются архитектурно, хотя это и не так очевидно. Да, у обоих горизонтально масштабированные архитектуры, в обоих для межкомпонентного соединения используется IB. Но в Isilon, в отличие от XtremIO, это делается для максимального снижения задержки при обмене данными между нодами. Также в Isilon для связи между нодами можно использовать Ethernet (фактически, именно так на нём работает виртуальная машина), но это увеличивает задержки при операциях ввода-вывода. Что касается XtremIO, то для его производительности большое значение имеет удалённый прямой доступ к памяти.

Кстати, пусть вас не вводит в заблуждение наличие двух диаграмм на иллюстрации - на самом деле, архитектурно они одинаковые. В обоих случаях используются пары HA-контроллеров, совместный доступ к памяти и межкомпонентные соединение с очень низким уровнем задержки. Кстати, в VMAX используется проприетарная межкомпонентная шина, но в будущем появится возможность применения IB.

Для сильно сопряжённых архитектур характерна высокая сложность программного кода. Это одна из причин их невысокой распространённости. Излишняя сложность ПО влияет и на количество добавляемых служб обработки данных, поскольку это представляет собой более трудную вычислительную задачу.

К преимуществам этого типа архитектур можно отнести устойчивость к сбоям (симметричные операции ввода-вывода во всех управляющих машинах), а также, в случае с XtremIO, большие возможности в сфере AFA. Раз речь снова зашла об XtremIO, то стоит упомянуть, что его архитектура подразумевает распределённость всех служб обработки данных. Также это единственное на рынке AFA-решение с горизонтально масштабированной архитектурой, хотя динамическое добавление/отключение нодов ещё не внедрено. Помимо прочего, в XtremIO используется «естественная» дедупликация, то есть она постоянно активна и «бесплатна» с точки зрения производительности. Правда, всё это повышает сложность обслуживания системы.

Важно понимать принципиальную разницу между Типом 2 и Типом 3. Чем более сопряжённая архитектура, тем лучше и более прогнозируемо она позволяет обеспечивать низкий уровень задержек. С другой стороны, в рамках подобной архитектуры сложнее добавлять ноды и масштабировать систему. Ведь когда вы используете совместный доступ к памяти, она представляет собой единую сильно сопряжённую распределённую систему. Сложность решений растёт, а вместе с этим и вероятность ошибок. Поэтому VMAX может иметь до 16 управляющих машин в 8 движках, а XtemIO - до 8 машин в 4 X-Brick (скоро увеличится до 16 машин в 8 блоках). Учетверение, или даже удвоение этих архитектур представляет собой невероятно трудную инженерную проблему. Для сравнения, VSAN может быть масштабирован до «размера кластеров vSphere» (сейчас 32 нода), Isilon может содержать более 100 нодов, а ScaleIO позволяет создать систему из более чем 1000 нодов. При этом всё это архитектуры второго типа.

Снова хочу подчеркнуть - архитектура не зависит от реализации. В вышеупомянутых продуктах используется и Ethernet, и IB. Одни представляют собой чисто программные решения, другие являются программно-аппаратными комплексами, но при этом их объединяют архитектурные схемы.

Несмотря на разнообразие межкомпонентных соединений, во всех приведённых примерах важнейшую роль играет использование распределённой записи. Это позволяет достичь транзакционности и атомарности, но при этом необходим тщательный контроль целостности данных. Также приходится решать проблему разрастания «области отказов». Эти два момента ограничивают максимально возможную степень масштабирования описанных типов архитектур.

Небольшая проверка того, насколько внимательно вы прочитали всё вышеизложенное : к какому типу относится Cisco UCS Invicta - 1 или 3? Физически выглядит как Тип 3, но ведь это набор USC-серверов серии С, соединённых по Ethernet, на которых работает программный стек Invicta (бывший Whiptail). Подсказываю: смотрите на архитектуру, а не конкретную реализацию 🙂

В случае с UCS Invicta данные хранятся в каждом ноде (UCS-сервер с флэш-накопителями на базе MLC). Единственный нод, не HA, представляющий собой отдельный сервер, может напрямую передавать номер логического устройства (LUN). Если вы решите добавить ещё ноды, возможно система масштабируется слабосопряжённо, как ScaleIO или VSAN. Всё это подводит нас к Типу 2.

Однако увеличение количества нодов, судя во всему, производится с помощью конфигурирования и миграции на “Invicta Scaling Appliance”. При такой конфигурации у вас есть несколько “Silicon Storage Routers” (SSR) и адресное хранилище из нескольких аппаратных нодов. Доступ к данным осуществляется через единственный SSR-нод, но это можно сделать и через другой нод, работающий как HA-пара. Сами данные всегда находятся на единственном UCS-ноде серии С. Так какой же это тип архитектуры? Не важно, как выглядит решение физически, - это Тип 1. SSR представляет собой кластер (может быть больше 2). В конфигурации Scaling Appliance каждый UCS-сервер с MLC-накопителями выполняет функцию, аналогичную VNX или NetApp FAS - дисковое хранилище. Хоть и не подключён через SAS, но архитектура аналогичная.

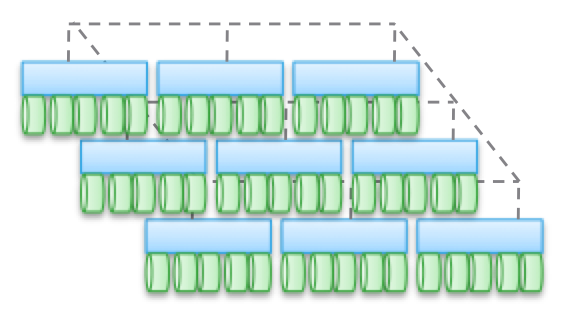

Тип 4. Распределённые архитектуры без совместно использования каких-либо ресурсов . Несмотря на то, что данные распределяются по разным нодам, делается это безо всякой транзакционности. Обычно данные складируются на каком-то одном ноде и там живут, и время от времени делаются копии на других нодах, ради обеспечения безопасности. Но эти копии не транзакционные. Это является ключевым отличием данного типа архитектур от Типа 2 и 3.

Связь между не-HA-нодами осуществляется с помощью Ethernet, поскольку это дёшево и универсально. Распределение по нодам делается принудительно и время от времени. «Корректность» данных соблюдается не всегда, но программный стек проверяется довольно часто, чтобы обеспечивать правильность используемых данных. При некоторых видах нагрузки (например, HDFS) данные распределяются так, чтобы находиться в памяти одновременно с тем процессом, для которого они требуются. Это свойство позволяет считать данный тип архитектур наиболее масштабируемым среди всех четырёх.

Но это далеко не единственное преимущество. Подобные архитектуры чрезвычайно просты, ими очень легко управлять. Они никоим образом не зависят от оборудования и могут быть развёрнуты на самом дешёвом «железе». Это почти всегда исключительно программные решения. Архитектурам этого типа оперировать петабайтами данных так же просто, как дргугим - терабайтами. Здесь применяются объекты и неPOSIX-файловые системы, причём и те, и другие зачастую располагаются поверх локальной файловой системы каждого рядового нода.

Эти архитектуры можно совмещать с блоками и транзакционными моделями представления данных на базе NAS, но это сильно ограничивает их возможности. Не надо создавать транзакционный стек, помещая Тип 1, 2 или 3 поверх Типа 4.

Лучше всего эти архитектуры «раскрываются» на тех задачах, для которых не свойственны какие-то ограничения.

Выше я приводил пример с очень большим клиентом, у которого 200 000 накопителей. В основе таких сервисов, как Dropbox, Syncplicity, iCloud, Facebook, eBay, YouTube и почти всех Web 2.0-проектов лежат хранилища, построенные по архитектурам четвёртого типа. Вся обрабатываемая информация в Hadoop-кластерах также содержится в хранилищах на базе Типа 4. В целом, в корпоративном сегменте это не очень распространённые архитектуры, но они очень быстро завоёвывают популярность.

Тип 4 лежит в основе таких продуктов, как AWS S3 (кстати, никто за пределами AWS не знает, как устроен EBS, но готов спорить, что это Тип 3), Haystack (используется в Facebook), Atmos, ViPR, Ceph, Swift (используется в Openstack), HDFS, Centera. Многие из перечисленных продуктов могут обретать разную форму, вид конкретной реализации определяется с помощью их API. Например, объектный стек ViPR можно реализовать через объектные API S3, Swift, Atmos, и даже HDFS! А в будущем в этот список попадёт и Centera. Для кого-то это будет очевидно, но Atmos и Centera будут использоваться ещё долго, правда, в виде API, а не конкретных продуктов. Реализации могут меняться, но API остаются чем-то незыблемым, что очень хорошо для клиентов.

Хочу ещё раз обратить ваше внимание на то, что «физическое воплощение» может сбить вас с толку, и архитектуры Типа 4 вы ошибочно отнесёте к Типу 2, поскольку они, зачастую, выглядят одинаково. На физическом уровне какое-от решение может выглядеть как ScaleIO, VSAN или Nutanix, хотя это будут просто серверы с Ethernet. И правильно классифицировать то или иное решение поможет наличие или отсутствие транзакционности.

А теперь я предлагаю вам второй проверочный тест. Давайте рассмотрим архитектуру UCS Invicta. Физически этот продукт выглядит как Тип 4 (серверы, соединённые по Ethernet), но архитектурно его невозможно масштабировать под соответствующие нагрузки, поскольку на самом деле это Тип 1. Причём Invicta, как и Pure, разрабатывался для AFA.

Примите мою искреннюю благодарность за уделённое время и внимание, если вы дочитали до этого места. Перечитал написанное выше - удивительно, что мне удалось жениться и завести детей 🙂

Для чего я всё это расписал?

В мире IT хранилища занимают очень важное место, этакое «царство грибов». Разнообразие предлагаемых продуктов очень велико, и это идёт только на пользу всему делу. Но нужно уметь разбираться во всём этом, не позволять затуманить себе разум маркетинговыми слоганами и нюансами позиционирования. Ради блага как клиентов, так и самой индустрии, необходимо упростить процесс построения хранилищ. Поэтому мы прилагаем столько усилий, чтобы сделать из контроллера ViPR открытую бесплатную платформу.

Но сами по себе хранилища трудно назвать захватывающими. Что я имею в виду? Представим некую абстрактную пирамиду, на вершине которой находится «пользователь». Ниже расположены «приложения», предназначенные для обслуживания «пользователя». Ещё ниже - «инфраструктура» (включая SDDC), обслуживающая «приложения» и, соответственно, «пользователя». А в самом низу «инфраструктуры» находится хранилище.

То есть можно представить иерархию в таком виде: Пользователь->Приложение/SaaS->PaaS->IaaS->Инфраструктура. Так вот: в конце концов, любое приложение, любой PaaS-стек должны вычислять или обрабатывать какую-то информацию. И эти четыре типа архитектур предназначены для работы с разными типами информации, разными видами нагрузки. В иерархии важности информация следует сразу за пользователем. Цель существования приложения заключается в том, чтобы дать пользователю возможность взаимодействовать с нужной ему информацией. Именно поэтому архитектуры систем хранения данных имеют столь важное значение в нашем мире.

Запись опубликована автором в рубрике Без рубрики. Добавьте в закладки .SAS, NAS, SAN: шаг к сетям хранения данных

Вступление

С повседневным усложнением сетевых компьютерных систем и глобальных корпоративных решений мир начал требовать технологий, которые бы дали толчок к возрождению корпоративных систем хранения информации (сторедж-систем). И вот, одна единая технология приносит в мировую сокровищницу достижений в области сторедж невиданное ранее быстродействие, колоссальные возможности масштабирования и исключительные преимущества общей стоимости владения. Обстоятельства, которые сформировались с появлением стандарта FC-AL (Fibre Channel — Arbitrated Loop) и SAN (Storage Area Network), которая развивается на его основе, обещают революцию в дата-ориентированных технологиях компьютинга.

«The most significant development in storage we"ve seen in 15 years»

Data Communications International, March 21, 1998

Формальное определение SAN в трактовке Storage Network Industry Association (SNIA):

«Сеть, главной задачей которой является передача данных между компьютерными системами и устройствами хранения данных, а также между самими сторедж-системами. SAN состоит из коммуникационной инфраструктуры, которая обеспечивает физическую связь, а также отвечает за уровень управления (management layer), который объединяет связи, сторедж и компьютерные системы, осуществляя передачу данных безопасно и надежно».

SNIA Technical Dictionary, copyright Storage Network Industry Association, 2000

Варианты организации доступа к сторедж-системам

Различают три основных варианта организации доступа к системам хранения:

- SAS (Server Attached Storage), сторедж, присоединенный к серверу;

- NAS (Network Attached Storage), сторедж, подсоединенный к сети;

- SAN (Storage Area Network), сеть хранения данных.

Рассмотрим топологии соответствующих сторедж-систем и их особенности.

SAS

Сторедж-система, присоединенная к серверу. Знакомый всем, традиционный способ подключения системы хранения данных к высокоскоростному интерфейсу в сервере, как правило, к параллельному SCSI интерфейсу.

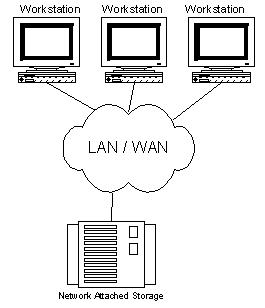

Рисунок 1. Server Attached Storage

Использование отдельного корпуса для сторедж-системы в рамках топологии SAS не является обязательным.

Основное преимущество сторедж, подсоединенного к серверу, в сравнении с другими вариантами — низкая цена и высокое быстродействие из расчета один сторедж для одного сервера. Такая топология является самой оптимальной в случае использования одного сервера, через который организуется доступ к массиву данных. Но у нее остается ряд проблем, которые побудили проектировщиков искать другие варианты организации доступа к системам хранения данных.

К особенностям SAS можно отнести:

- Доступ к данных зависит от ОС и файловой системы (в общем случае);

- Сложность организации систем с высокой готовностью;

- Низкая стоимость;

- Высокое быстродействие в рамках одной ноды;

- Уменьшение скорости отклика при загрузке сервера, который обслуживает сторедж.

NAS

Сторедж-система, подсоединенная к сети. Этот вариант организации доступа появился сравнительно недавно. Основным его преимуществом является удобство интеграции дополнительной системы хранения данных в существующие сети, но сам по себе он не привносит сколь-нибудь радикальных улучшений в архитектуру сторедж. Фактически NAS есть чистый файл-сервер, и сегодня можно встретить немало новых реализаций сторедж типа NAS на основе технологии тонкого сервера (Thin Server).

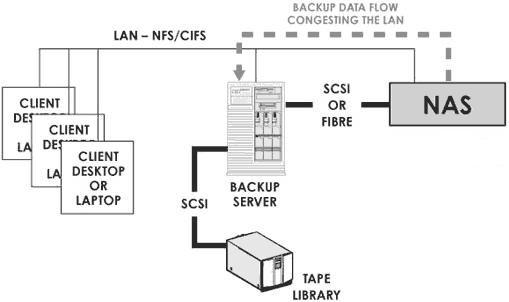

Рисунок 2. Network Attached Storage.

Особенности NAS:

- Выделенный файл-сервер;

- Доступ к данным не зависит от ОС и платформы;

- Удобство администрирования;

- Максимальная простота установки;

- Низкая масштабируемость;

- Конфликт с трафиком LAN/WAN.

Сторедж, построенный по технологии NAS, является идеальным вариантом для дешевых серверов с минимальным набором функций.

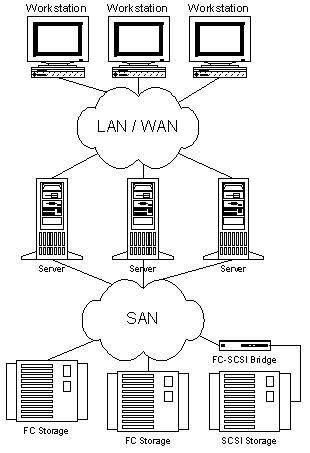

SAN

Сети хранения данных начали интенсивно развиваться и внедряться лишь с 1999 года. Основой SAN является отдельная от LAN/WAN сеть, которая служит для организации доступа к данным серверов и рабочих станций, занимающихся их прямой обработкой. Такая сеть создается на основе стандарта Fibre Channel, что дает сторедж-системам преимущества технологий LAN/WAN и возможности по организации стандартных платформ для систем с высокой готовностью и высокой интенсивностью запросов. Почти единственным недостатком SAN на сегодня остается относительно высокая цена компонент, но при этом общая стоимость владения для корпоративных систем, построенных с использованием технологии сетей хранения данных, является довольно низкой.

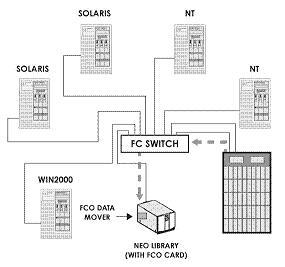

Рисунок 3. Storage Area Network.

К основным преимуществам SAN можно отнести практически все ее особенности:

- Независимость топологии SAN от сторедж-систем и серверов;

- Удобное централизованное управление;

- Отсутствие конфликта с трафиком LAN/WAN;

- Удобное резервирование данных без загрузки локальной сети и серверов;

- Высокое быстродействие;

- Высокая масштабируемость;

- Высокая гибкость;

- Высокая готовность и отказоустойчивость.

Следует также заметить, что технология эта еще довольно молодая и в ближайшее время она должна пережить немало усовершенствований в области стандартизации управления и способов взаимодействия SAN подсетей. Но можно надеяться, что это угрожает пионерам лишь дополнительными перспективами первенства.

FC как основа построения SAN

Подобно LAN, SAN может создаваться с использованием различных топологий и носителей. При построении SAN может использоваться как параллельный SCSI интерфейс, так и Fibre Channel или, скажем, SCI (Scalable Coherent Interface), но своей все возрастающей популярностью SAN обязана именно Fibre Channel. В проектировании этого интерфейса принимали участие специалисты со значительным опытом в разработке как канальных, так и сетевых интерфейсов, и им удалось объединить все важные положительные черты обеих технологий для того, чтобы получить что-то в самом деле революционно новое. Что именно?

Основные ключевые особенности канальных:

- Низкие задержки

- Высокие скорости

- Высокая надежность

- Топология точка-точка

- Небольшие расстояния между нодами

- Зависимость от платформы

- Многоточечные топологии

- Большие расстояния

- Высокая масштабируемость

- Низкие скорости

- Большие задержки

- Высокие скорости

- Независимость от протокола (0-3 уровни)

- Большие расстояния

- Низкие задержки

- Высокая надежность

- Высокая масштабируемость

- Многоточечные топологии

Традиционно сторедж интерфейсы (то, что находится между хостом и устройствами хранения информации) были преградой на пути к росту быстродействия и увеличению объема систем хранения данных. В то же время прикладные задачи требуют значительного прироста аппаратных мощностей, которые, в свою очередь, тянут за собой потребность в увеличении пропускной способности интерфейсов для связи со сторедж-системами. Именно проблемы построения гибкого высокоскоростного доступа к данным помогает решить Fibre Channel.

Стандарт Fibre Channel был окончательно определен за последние несколько лет (с 1997-го по 1999-й), на протяжении которых была проведена колоссальная работа по согласованию взаимодействия производителей различных компонент, и было сделано все необходимое, чтобы Fibre Channel превратился из чисто концептуальной технологии в реальную, которая получила поддержку в виде инсталляций в лабораториях и вычислительных центрах. В году 1997 были спроектированы первые коммерческие образцы краеугольных компонент для построения SAN на базе FC, таких как адаптеры, хабы, свичи и мосты. Таким образом, уже начиная с 1998-го года FC используется в коммерческих целях в деловой сфере, на производстве и в масштабных проектах реализации систем, критичных к отказам.

Fibre Channel — это открытый промышленный стандарт высокоскоростного последовательного интерфейса. Он обеспечивает подключение серверов и сторедж-систем на расстоянии до 10 км (при использовании стандартного оснащения) на скорости 100 MB/s (на выставке Cebit"2000 были представлены образцы продукции, которые используют новый стандарт Fibre Channel со скоростями 200 MB/s на одно кольцо, а в лабораторных условиях уже эксплуатируются реализации нового стандарта со скоростями 400 MB/s, что составляет 800 MB/s при использовании двойного кольца). (На момент публикации статьи ряд производителей уже начал отгружать сетевые карточки и свичи на FC 200 MB/s.) Fibre Channel одновременно поддерживает целый ряд стандартных протоколов (среди которых TCP/IP и SCSI-3) при использовании одного физического носителя, который потенциально упрощает построение сетевой инфраструктуры, к тому же это предоставляет возможности для уменьшения стоимости монтажа и обслуживания. Тем не менее использование отдельных подсетей для LAN/WAN и SAN имеет ряд преимуществ и является рекомендованным по умолчанию.

Одним из важнейших преимуществ Fibre Channel наряду со скоростными параметрами (которые, кстати, не всегда являются главными для пользователей SAN и могут быть реализованы с помощью других технологий) является возможность работы на больших расстояниях и гибкость топологии, которая пришла в новый стандарт из сетевых технологий. Таким образом, концепция построения топологии сети хранения данных базируется на тех же принципах, что и традиционные сети, как правило, на основе концентраторов и коммутаторов, которые помогают предотвратить падение скорости при возрастании количества нод и создают возможности удобной организации систем без единой точки отказов.

Для лучшего понимания преимуществ и особенностей этого интерфейса приведем сравнительную характеристику FC и Parallel SCSI в виде таблицы.

Таблица 1. Сравнение технологий Fibre Channel и параллельного SCSI

В стандарте Fibre Channel предполагается использование разнообразных топологий, таких как точка-точка (Point-to-Point), кольцо или FC-AL концентратор (Loop или Hub FC-AL), магистральный коммутатор (Fabric/Switch).

Топология point-to-point используется для подсоединения одиночной сторедж-системы к серверу.

Loop или Hub FC-AL — для подсоединения множественных сторедж устройств к нескольким хостам. При организации двойного кольца увеличивается быстродействие и отказоустойчивость системы.

Коммутаторы используются для обеспечения максимального быстродействия и отказоустойчивости для сложных, больших и разветвленных систем.

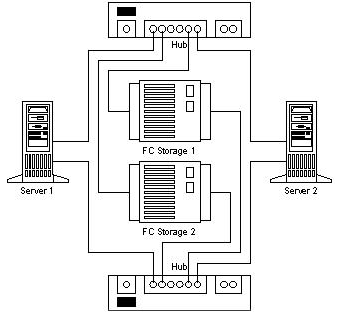

Благодаря сетевой гибкости в SAN заложена чрезвычайно важная особенность — удобная возможность построения отказоустойчивых систем.

Предлагая альтернативные решения для систем хранения данных и возможности по объединению нескольких сторедж для резервирования аппаратных средств, SAN помогает обеспечивать защиту аппаратно-программных комплексов от аппаратных сбоев. Для демонстрации приведем пример создания двухнодовой системы без точек отказов.

Рисунок 4. No Single Point of Failure.

Построение трех- и более нодовых систем осуществляется простым добавлением в FC сеть дополнительных серверов и подключением их к обоим концентраторам/ коммутаторам).

При использовании FC построение устойчивых к сбоям (disaster tolerant) систем становится прозрачным. Сетевые каналы и для сторедж, и для локальной сети можно проложить на основе оптоволокна (до 10 км и больше с использованием усилителей сигнала) как физического носителя для FC, при этом используется стандартная аппаратура, которая дает возможность значительно уменьшить стоимость подобных систем.

Благодаря возможности доступа ко всем компонентам SAN из любой ее точки мы получаем чрезвычайно гибко управляемую сеть данных. При этом следует заметить, что в SAN обеспечивается прозрачность (возможность видеть) всех компонентов вплоть до дисков в сторедж-системах. Эта особенность подтолкнула производителей компонентов к использованию своего значительного опыта в построении систем управления для LAN/WAN с тем, чтобы заложить широкие возможности по мониторингу и управлению во все компоненты SAN. Эти возможности включают в себя мониторинг и управление отдельных нод, сторедж компонентов, корпусов, сетевых устройств и сетевых подструктур.

В системе управления и мониторинга SAN используются такие открытые стандарты, как:

- SCSI command set

- SCSI Enclosure Services (SES)

- SCSI Self Monitoring Analysis and Reporting Technology (S.M.A.R.T.)

- SAF-TE (SCSI Accessed Fault-Tolerant Enclosures)

- Simple Network Management Protocol (SNMP)

- Web-Based Enterprise Management (WBEM)

Системы, построенные с использованием технологий SAN, не только обеспечивают администратору возможность следить за развитием и состоянием сторедж ресурсов, но и открывают возможности по мониторингу и контролю трафика. Благодаря таким ресурсам программные средства управления SAN реализуют наиболее эффективные схемы планирования объема сторедж и балансирование нагрузки на компоненты системы.

Сети хранения данных прекрасно интегрируются в существующие информационные инфраструктуры. Их внедрение не требует каких-либо изменений в уже существующих сетях LAN и WAN, а лишь расширяет возможности существующих систем, избавляя их от задач, ориентированных на передачу больших объемов данных. Причем при интеграции и администрировании SAN очень важным является то, что ключевые элементы сети поддерживают горячую замену и установку, с возможностями динамического конфигурирования. Так что добавить тот или другой компонент или осуществить его замену администратор может, не выключая систему. И весь этот процесс интеграции может быть визуально отображен в графической системе управления SAN.

Рассмотрев вышеперечисленные преимущества, можно выделить ряд ключевых моментов, которые непосредственно влияют на одно из основных преимуществ Storage Area Network — общую стоимость владения (Total Cost Ownership).

Невероятные возможности масштабирования позволяют предприятию, которое использует SAN, вкладывать деньги в серверы и сторедж по мере необходимости. А также сохранить свои вложения в уже инсталлированную технику при смене технологических поколений. Каждый новый сервер будет иметь возможность высокоскоростного доступа к сторедж и каждый дополнительный гигабайт сторедж будет доступен всем серверам подсети по команде администратора.

Прекрасные возможности по построению отказоустойчивых систем могут приносить прямую коммерческую выгоду от минимизации простоев и спасать систему в случае возникновения стихийного бедствия или каких-нибудь других катаклизмов.

Управляемость компонентов и прозрачность системы предоставляют возможность осуществлять централизованное администрирование всех сторедж ресурсов, а это, в свою очередь, значительно уменьшает затраты на их поддержку, стоимость которой, как правило, составляет более 50% от стоимости оснащения.

Влияние SAN на прикладные задачи

Для того чтобы нашим читателям стало понятней, насколько практически полезны технологии, которые рассматриваются в этой статье, приведем несколько примеров прикладных задач, которые без использования сетей хранения данных решались бы неэффективно, требовали бы колоссальных финансовых вложений или же вообще не решались бы стандартными методами.

Резервирование и восстановление данных (Data Backup and Recovery)

Используя традиционный SCSI интерфейс, пользователь при построении систем резервирования и восстановления данных сталкивается с рядом сложных проблем, которые можно очень просто решить, используя технологии SAN и FC.

Таким образом, использование сетей хранения данных выводит решение задачи резервирования и восстановления на новый уровень и предоставляет возможность осуществлять бэкап в несколько раз быстрее, чем раньше, без загрузки локальной сети и серверов работой по резервированию данных.

Кластеризация серверов (Server Clustering)

Одной из типичных задач, для которых эффективно используется SAN, является кластеризация серверов. Поскольку один из ключевых моментов в организации высокоскоростных кластерных систем, которые работают с данными — это доступ к сторедж, то с появлением SAN построение многонодовых кластеров на аппаратном уровне решается простым добавлением сервера с подключением к SAN (это можно сделать, даже не выключая системы, поскольку свичи FC поддерживают hot-plug). При использовании параллельного SCSI интерфейса, возможности по подсоединению и масштабируемость которого значительно хуже, чем у FC, кластеры, ориентированные на обработку данных, было бы тяжело сделать с количеством нод больше двух. Коммутаторы параллельного SCSI — весьма сложные и дорогие устройства, а для FC это стандартный компонент. Для создания кластера, который не будет иметь ни единой точки отказов, достаточно интегрировать в систему зеркальную SAN (технология DUAL Path).

В рамках кластеризации одна из технологий RAIS (Redundant Array of Inexpensive Servers) кажется особенно привлекательной для построения мощных масштабируемых систем интернет-коммерции и других видов задач с повышенными требованиями к мощности. По словам Alistair A. Croll, сооснователя Networkshop Inc, использование RAIS оказывается достаточно эффективным:«Например, за $12000-15000 вы можете купить около шести недорогих одно-двухпроцессорных (Pentium III) Linux/Apache серверов. Мощность, масштабируемость и отказоустойчивость такой системы будет значительно выше, чем, например, у одного четырехпроцессорного сервера на базе процессоров Xeon, а стоимость одинаковая».

Одновременный доступ к видео и распределение данных (Concurrent video streaming, data sharing)

Вообразите себе задачу, когда вам нужно на нескольких (скажем, >5) станциях редактировать видео или просто работать над данными огромного объема. Передача файла размером 100GB по локальной сети займет у вас несколько минут, а общая работа над ним будет очень сложной задачей. При использовании SAN каждая рабочая станция и сервер сети получают доступ к файлу на скорости, эквивалентной локальному высокоскоростному диску. Если вам нужны еще одна станция/сервер для обработки данных, вы сможете ее прибавить к SAN, не выключая сети, простым подсоединением станции к SAN коммутатору и предоставлением ей прав доступа к сторедж. Если же вас перестанет удовлетворять быстродействие подсистемы данных, вы сможете просто прибавить еще один сторедж и с использованием технологии распределения данных (например, RAID 0) получить вдвое большее быстродействие.

Основные компоненты SAN

Среда

Для соединения компонентов в рамках стандарта Fibre Channel используют медные и оптические кабели. Оба типа кабелей могут использоваться одновременно при построении SAN. Конверсия интерфейсов осуществляется с помощью GBIC (Gigabit Interface Converter) и MIA (Media Interface Adapter). Оба типа кабеля сегодня обеспечивают одинаковую скорость передачи данных. Медный кабель используется для коротких расстояний (до 30 метров), оптический — как для коротких, так и для расстояний до 10 км и больше. Используют многомодовый и одномодовый оптические кабели. Многомодовый (Multimode) кабель используется для коротких расстояний (до 2 км). Внутренний диаметр оптоволокна мультимодового кабеля составляет 62,5 или 50 микрон. Для обеспечения скорости передачи 100 МБ/с (200 МБ/с в дуплексе) при использовании многомодового оптоволокна длина кабеля не должна превышать 200 метров. Одномодовый кабель используется для больших расстояний. Длина такого кабеля ограничена мощностью лазера, который используется в передатчике сигнала. Внутренний диаметр оптоволокна одномодового кабеля составляет 7 или 9 микрон, он обеспечивает прохождение одиночного луча.

Коннекторы, адаптеры

Для подсоединения медных кабелей используются коннекторы типа DB-9 или HSSD. HSSD считается более надежным, но DB-9 используется так же часто, потому что он более простой и дешевый. Стандартным (наиболее распространенным) коннектором для оптических кабелей является SC коннектор, он обеспечивает качественное, четкое соединение. Для обычного подключения используются многомодовые SC коннекторы, а для отдаленного — одномодовые. В многопортовых адаптерах используются микроконнекторы.

Наиболее распространены адаптеры для FC под шину PCI 64 bit. Также много FC адаптеров вырабатывается под шину S-BUS, для специализированного использования выпускаются адаптеры под MCA, EISA, GIO, HIO, PMC, Compact PCI. Самые популярные — однопортовые, встречаются двух- и четырехпортовые карточки. На PCI адаптерах, как правило, используют DB-9, HSSD, SC коннекторы. Также часто встречаются GBIC-based адаптеры, которые поставляются как с модулями GBIC, так и без них. Fibre Channel адаптеры отличаются классами, которые они поддерживают, и разнообразными особенностями. Для понимания отличий приведем сравнительную таблицу адаптеров производства фирмы QLogic.

| Fibre Channel Host Bus Adapter Family Chart | ||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| SANblade | 64 Bit | FCAL Publ. Pvt Loop | FL Port | Class 3 | F Port | Class 2 | Point to Point | IP/ SCSI | Full Duplex | FC Tape | PCI 1.0 Hot Plug Spec | Solaris Dynamic Reconfig | VIВ | 2Gb |

| 2100 Series | 33 & 66MHz PCI | X | X | X | ||||||||||

| 2200 Series | 33 & 66MHz PCI | X | X | X | X | X | X | X | X | X | ||||

| 33MHz PCI | X | X | X | X | X | X | X | X | X | X | ||||

| 25 MHZ Sbus | X | X | X | X | X | X | X | X | X | X | ||||

| 2300 Series | 66 MHZ PCI/ 133MHZ PCI-X | X | X | X | X | X | X | X | X | X | X | X | ||

Концентраторы

Fibre Channel HUBs (концентраторы) используются для подключения нод к FC кольцу (FC Loop) и имеют структуру, похожую на Token Ring концентраторы. Поскольку разрыв кольца может привести к прекращению функционирования сети, в современных FC концентраторах используются порты обхода кольца (PBC-port bypass circuit), которые разрешают автоматически открывать/закрывать кольцо (подключать/отключать системы, присоединенные к концентратору). Обычно FC HUBs поддерживают до 10 подключений и могут стекироваться до 127 портов на кольцо. Все устройства, подключенные к HUB, получают общую полосу пропускания, которую они могут разделять между собой.

Коммутаторы

Fibre Channel Switches (коммутаторы) имеют те же функции, что и привычные читателю LAN коммутаторы. Они обеспечивают полноскоростное неблокированное подключение между нодами. Любая нода, подключенная к FC коммутатору, получает полную (с возможностями масштабирования) полосу пропускания. При увеличении количества портов коммутированной сети ее пропускная способность увеличивается. Коммутаторы могут использоваться вместе с концентраторами (которые используют для участков, не требующих выделенной полосы пропуска для каждой ноды) для достижения оптимального соотношения цена/производительность. Благодаря каскадированию свичи потенциально могут использоваться для создания FC сетей с количеством адресов 2 24 (свыше 16 миллионов).

Мосты

FC Bridges (мосты или мультиплексоры) используются для подключения устройств с параллельным SCSI к сети на базе FC. Они обеспечивают трансляцию SCSI пакетов между Fibre Channel и Parallel SCSI устройствами, примерами которых могут служить Solid State Disk (SSD) или библиотеки на магнитных лентах. Следует заметить, что в последнее время практически все устройства, которые могут быть утилизированы в рамках SAN, производители начинают выпускать с вмонтированным FC интерфейсом для прямого их подключения к сетям хранения данных.

Серверы и Сторедж

Несмотря на то что серверы и сторедж — далеко не последние по важности компоненты SAN, мы на их описании останавливаться не будем, поскольку уверены, что с ними хорошо знакомы все наши читатели.

В конце хочется добавить, что эта статья — лишь первый шаг к сетям хранения данных. Для полного понимания темы читателю следует уделить немало внимания особенностям реализации компонент производителями SAN и программным средствам управления, поскольку без них Storage Area Network — это всего лишь набор элементов для коммутации сторедж-систем, которые не принесут вам полноты преимуществ от реализации сети хранения данных.

Заключение

Сегодня Storage Area Network является довольно новой технологией, которая в скором времени может стать массовой в кругу корпоративных заказчиков. В Европе и США предприятия, которые имеют достаточно большой парк инсталлированных сторедж-систем, уже начинают переходить на сети хранения данных для организации сторедж с наилучшим показателем общей стоимости владения.

По прогнозам аналитиков, в 2005 году значительное количество серверов среднего и верхнего уровня будут поставляться с предварительно установленным интерфейсом Fibre Channel (такую тенденцию можно заметить уже сегодня), и лишь для внутреннего подключения дисков в серверах будет использоваться параллельный SCSI интерфейс. Уже сегодня при построении сторедж-систем и приобретении серверов среднего и верхнего уровня следует обратить внимание на эту перспективную технологию, тем более, что уже сегодня она дает возможность реализовать ряд задач куда дешевле, чем с помощью специализированных решений. Кроме того, вкладывая в технологию SAN сегодня, вы не потеряете свои вложения завтра, поскольку особенности Fibre Channel создают прекрасные возможности для использования в будущем вложенных сегодня инвестиций.

P.S.

Предыдущая версия статьи была написана в июне 2000 года, но в связи с отсутствием массового интереса к технологии сетей хранения данных публикация была отложена на будущее. Это будущее настало сегодня, и я надеюсь, что данная статья побудит читателя осознать необходимость перехода на технологию сетей хранения данных, как передовую технологию построения сторедж-систем и организации доступа к данным.

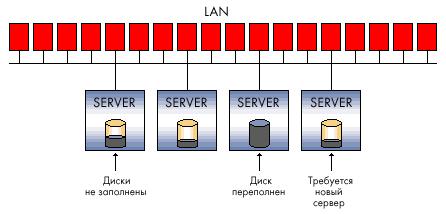

DAS, SAN, NAS - магические аббревиатуры, без которых не обходится ни одна из статей и ни одно аналитическое исследование по системам хранения. Они служат обозначением основных типов соединения систем хранения с вычислительными системами.

DAS (direct-attached storage) - устройство внешней памяти, напрямую подсоединенное к основному компьютеру и используемое только им. Простейший пример DAS - встроенный жесткий диск. Для связи хоста с внешней памятью в типовой конфигурации DAS используется SCSI, команды которого позволяют выделить определенный блок данных на специфицированном диске или смонтировать определенный картридж в ленточной библиотеке.

Конфигурация DAS приемлема для применений, нетребовательных к объемам, производительности и надежности систем хранения. DAS не обеспечивает возможности совместного использования емкости хранения разными хостами и тем более возможности разделения данных. Установка таких устройств хранения - более дешевый вариант по сравнению с сетевыми конфигурациями, однако, если иметь в виду большие организации, этот тип инфраструктуры хранения нельзя считать оптимальным. Много DAS-подключений означает разрозненные и разбросанные по всей компании островки внешней памяти, избытки которой не могут использоваться другими хост-компьютерами, что приводит к неэффективной трате емкости хранения в целом.

Кроме того, при такой организации хранения нет никакой возможности создать единую точку управления внешней памятью, что неизбежно усложняет процессы резервирования/восстановления данных и создает серьезную проблему защиты информации. В итоге общая стоимость владения подобной системой хранения может оказаться значительно выше, чем более сложная на первый взгляд и изначально более дорогая сетевая конфигурация.

SAN

Сегодня, говоря о системе хранения корпоративного уровня, мы имеем в виду сетевое хранение (storage networking). Больше известны широкой публике сети хранения - SAN (storage area network). SAN представляет собой выделенную сеть устройств хранения, которая позволяет множеству серверов использовать совокупный ресурс внешней памяти без нагрузки на локальную сеть.

SAN не зависит от среды передачи, но на данный момент фактическим стандартом является технология Fibre Channel (FC), обеспечивающая скорость передачи данных 1-2 Гбит/с. В отличие от традиционных сред передачи на базе SCSI, обеспечивающих подключение на расстояние не более чем на 25 метров, Fibre Channel позволяет работать на удалении до 100 км. Средой передачи в сети Fibre Channel могут служить как медный кабель, так и оптоволокно.

В сеть хранения могут подключаться дисковые массивы RAID, простые массивы дисков, (так называемые Just a Bunch of Disks - JBOD), ленточные или магнитооптические библиотеки для резервирования и архивирования данных. Основными компонентами для организации сети SAN помимо самих устройств хранения являются адаптеры для подключения серверов к сети Fibre Channel (host bus adapter - НВА), cетевые устройства для поддержки той или иной топологии FC-сети и специализированный программный инструментарий для управления сетью хранения. Эти программные системы могут выполняться как на сервере общего назначения, так и на самих устройствах хранения, хотя иногда часть функций выносится на специализированный тонкий сервер для управления сетью хранения (SAN appliance).

Задача программного обеспечения для SAN - это прежде всего централизованное управление сетью хранения, включая конфигурирование, мониторинг, контроль и анализ компонентов сети. Одной из наиболее важных является функция управления доступом к дисковым массивам, если в SAN хранятся данные разнородных серверов. Сети хранения обеспечивают одновременный доступ множества серверов к множеству дисковых подсистем, привязывая каждый хост к определенным дискам на определенном дисковом массиве. Для разных операционных систем необходимо расслоение дискового массива на «логические области» (logical unit - LUN), которыми они будут пользоваться без возникновения конфликтов. Выделение логических областей может понадобиться и для организации доступа к одним и тем же данным для некоторого пула серверов, например, серверов одной рабочей группы. За поддержку всех этих операций отвечают специальные программные модули.

Привлекательность сетей хранения объясняется теми преимуществами, которые они могут дать организациям, требовательным к эффективности работы с большими объемами данных. Выделенная сеть хранения разгружает основную (локальную или глобальную) сеть вычислительных серверов и клиентских рабочих станций, освобождая ее от потоков ввода/вывода данных.

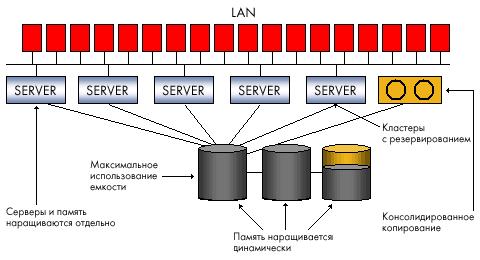

Этот фактор, а также высокоскоростная среда передачи, используемая для SAN, обеспечивают повышение производительности процессов обмена данными с внешними системами хранения. SAN означает консолидацию систем хранения, создание на разных носителях единого пула ресурсов, который будет разделяться всеми вычислительными мощностями, и в результате необходимую емкость внешней памяти можно будет обеспечить меньшим числом подсистем. В SAN резервирование данных с дисковых подсистем на ленты происходит вне локальной сети и потому становится более производительным - одна ленточная библиотека может служить для резервирования данных с нескольких дисковых подсистем. Кроме того, при поддержке соответствующего ПО можно реализовать прямое резервирование в SAN без участия сервера, тем самым, разгружая процессор. Возможность разнесения серверов и памяти на большие расстояния отвечает потребностям повышения надежности корпоративных хранилищ данных. Консолидированное хранение данных в SAN лучше масштабируется, поскольку позволяет наращивать емкость хранения независимо от серверов и без прерывания их работы. Наконец, SAN дает возможность централизованного управления единым пулом внешней памяти, что упрощает администрирование.

Безусловно, сети хранения, недешевое и непростое решение и, несмотря на то, что все ведущие поставщики выпускают сегодня устройства для SAN на базе Fibre Channel, их совместимость не гарантируется, и выбор подходящего оборудования создает проблему для пользователей. Понадобятся дополнительные расходы на организацию выделенной сети и покупку управляющего ПО, и начальная стоимость SAN окажется выше организации хранения с помощью DAS, однако совокупная стоимость владения должна быть ниже.

NAS

В отличие от SAN, NAS (network attached storage) - не сеть, а сетевое устройство хранения, точнее, выделенный файловый сервер с подсоединенной к нему дисковой подсистемой. Иногда в конфигурацию NAS может входить оптическая или ленточная библиотека. NAS-устройство (NAS appliance) напрямую подключается в сеть и предоставляет хостам доступ к файлам на своей интегрированной подсистеме внешней памяти. Появление выделенных файловых серверов связано с разработкой в начале 90-х годов компанией Sun Microsystems сетевой файловой системы NFS, которая позволяла клиентским компьютерам в локальной сети использовать файлы на удаленном сервере. Затем у Microsoft появилась аналогичная система для среды Windows - Common Internet File System. Конфигурации NAS поддерживают обе эти системы, а также другие протоколы на базе IP, обеспечивая разделение файлов клиентскими приложениями.

NAS-устройство напоминает конфигурацию DAS, но принципиально отличается от нее тем, что обеспечивает доступ на уровне файлов, а не блоков данных, и позволяет всем приложениям в сети совместно использовать файлы на своих дисках. NAS специфицирует файл в файловой системе, сдвиг в этом файле (который представляется как последовательность байт) и число байт, которое необходимо прочитать или записать. Запрос к NAS-устройству не определяет том или сектор на диске, где находится файл. Задача операционной системы NAS-устройства транслировать обращение к конкретному файлу в запрос на уровне блоков данных. Файловый доступ и возможность разделения информации удобны для приложений, которые должны обслуживать множество пользователей одновременно, но не требуют загрузки очень больших объемов данных по каждому запросу. Поэтому обычной практикой становится использование NAS для Internet-приложений, Web-cлужб или CAПР, в которых над одним проектом работают сотни специалистов.

Вариант NAS прост в установке и управлении. В отличие от сети хранения, установка NAS-устройства не требует специального планирования и затрат на дополнительное управляющее ПО - достаточно просто подключить файловый сервер в локальную сеть. NAS освобождает серверы в сети от задач управления хранением, но не разгружает сетевой трафик, поскольку обмен данными между серверами общего назначения и NAS идет по той же локальной сети. На NAS-устройстве может быть сконфигурирована одна или несколько файловых систем, каждой из которых отводится определенный набор томов на диске. Всем пользователям одной и той же файловой системы по требованию выделяется некоторое дисковое пространство. Таким образом, NAS обеспечивает более эффективные по сравнению с DAS организацию и использование ресурсов памяти, поскольку подключенная напрямую подсистема хранения обслуживает только один вычислительный ресурс, и может случиться так, что у одного сервера в локальной сети будет слишком много внешней памяти, в то время как другой испытывает нехватку пространства на дисках. Но из нескольких NAS-устройств нельзя создать единый пул ресурсов хранения и потому увеличение числа NAS-узлов в сети усложнит задачу управления.

NAS + SAN = ?

Какую из форм инфраструктуры хранения выбрать: NAS или SAN? Ответ зависит от возможностей и потребностей организации, однако сравнивать или тем более противопоставлять их в принципе неверно, поскольку эти две конфигурации решают разные задачи. Файловый доступ и совместное использование информации для приложений на разнородных серверных платформах в локальной сети - это NAS. Высокопроизводительный блоковый доступ к базам данных, консолидация хранения, гарантирующая его надежность и эффективность - это SAN. В жизни, правда, все сложнее. NAS и SAN часто уже сосуществуют или должны быть одновременно реализованы в распределенной ИТ-инфраструктуре компании. Это неизбежно порождает проблемы управления и оптимального использования ресурсов хранения.

Сегодня производители ищут пути объединения обеих технологий в единую сетевую инфраструктуру хранения, которая обеспечит консолидацию данных, централизацию резервного копирования, упростит общее администрирование, масштабируемость и защиту данных. Конвергенция NAS и SAN - одна из самых важных тенденций последнего времени.

Сеть хранения позволяет создать единый пул ресурсов памяти и выделять на физическом уровне необходимую квоту дискового пространства каждому из хостов, подключенных к SAN. NAS-сервер обеспечивает разделение данных в файловой системе приложениями на разных операционных платформах, решая проблемы интерпретации структуры файловой системы, синхронизации и контроля доступа к одним и тем же данным. Поэтому, если мы хотим добавить в сеть хранения возможность разделения не только физических дисков, но и логической структуры файловых систем, нам необходим промежуточный управляющий сервер для реализации всех функций сетевых протоколов обработки запросов на уровне файлов. Отсюда общий подход к объединению SAN и NAS с помощью NAS-устройства без интегрированной дисковой подсистемы, но с возможностью подключения компонентов сети хранения. Такие устройства, которые у одних производителей называются NAS-шлюзами, у других головными NAS-устройствами, становятся своеобразным буфером между локальной сетью и SAN, обеспечивая доступ к данным в SAN на уровне файлов и разделение информации в сети хранения.

Резюме

Построение единых сетевых систем, объединяющих возможности SAN и NAS, - лишь один из шагов в направлении глобальной интеграции корпоративных систем хранения. Дисковые массивы, подключенные напрямую к отдельным серверам, перестали удовлетворять потребностям больших организаций с сложными распределенными ИТ-инфраструктурами. Сегодня просто сети хранения на основе высокопроизводительной, но специализированной технологии Fibre Channel рассматриваются не только как прорыв, но и как источник головной боли из-за сложности инсталляции, проблем с поддержкой оборудования и ПО от разных поставщиков. Однако то, что ресурсы хранения должны быть едиными и сетевыми, сомнения уже не вызывает. Ищутся пути оптимальной консолидации. Отсюда и активизация производителей решений, поддерживающих различные варианты переноса сетей хранения на IP-протокол]. Отсюда и большой интерес к различным реализациям концепции виртуализации хранения. Ведущие игроки рынка систем хранения не просто объединяют все свои продукты под общей «шапкой» (TotalStorage у IBM или SureStore у НР), но формулируют собственные стратегии создания консолидированных, сетевых инфраструктур хранения и защиты корпоративных данных. Ключевую роль в этих стратегиях будет играть идея виртуализации, поддержанная главным образом на уровне мощных программных решений централизованного управления распределенными хранилищами. В таких инициативах, как StorageTank от IBM, Federated Storage Area Management от НР, E-Infrostructure от ЕМС, программное обеспечение играет решающую роль.