Что такое системы хранения данных (СХД) и для чего они нужны? В чём разница между iSCSI и FibreChannel? Почему данное словосочетание только в последние годы стало известно широкому кругу IT-специалистов и почему вопросы систем хранения данных всё больше и больше тревожат вдумчивые умы?

Думаю, многие заметили тенденции развития в окружающем нас компьютерном мире – переход от экстенсивной модели развития к интенсивной. Наращивание мегагерц процессоров уже не даёт видимого результата, а развитие накопителей не поспевает за объёмом информации. Если в случае процессоров всё более или менее понятно – достаточно собирать многопроцессорные системы и/или использовать несколько ядер в одном процессоре, то в случае вопросов хранения и обработки информации так просто от проблем не избавиться. Существующая на данный момент панацея от информационной эпидемии – СХД. Название расшифровывается как Сеть Хранения Данных (Storage Area Network) или Система Хранения Данных. В любом случае – это спе

Основные проблемы, решаемые СХД

Итак, какие же задачи призвана решить СХД? Рассмотрим типичные проблемы, связанные с растущими объёмами информации в любой организации. Предположим, что это хотя бы несколько десятков компьютеров и несколько разнесённых территориально офисов.

1. Децентрализация информации – если раньше все данные могли храниться буквально на одном жёстком диске, то сейчас любая функциональная система требует отдельного хранилища – к примеру, серверов электронной почты, СУБД, домена и так далее. Ситуация усложняется в случае распределённых офисов (филиалов).

2. Лавинообразный рост информации

– зачастую количество жёстких дисков, которые вы можете установить в конкретный сервер, не может покрыть необходимую системе ёмкость. Как следствие:

Невозможность полноценно защитить хранимые данные – действительно, ведь довольно трудно произвести даже backup данных, которые находятся не только на разных серверах, но и разнесены территориально.

Недостаточная скорость обработки информации – каналы связи между удалёнными площадками пока оставляют желать лучшего, но даже при достаточно «толстом» канале не всегда возможно полноценное использование существующих сетей, например, IP, для работы.

Сложность резервного копирования – если данные читаются и записываются небольшими блоками, то произвести полное архивирование информации с удалённого сервера по существующим каналам может быть нереально – необходима передача всего объёма данных. Архивирование на местах зачастую нецелесообразно по финансовым соображениям – необходимы системы для резервного копирования (ленточные накопители, например), специальное ПО (которое может стоить немалых денег), обученный и квалифицированный персонал.

3. Сложно или невозможно предугадать требуемый объём

дискового пространства при развертывании компьютерной системы. Как следствие:

Возникают проблемы расширения дисковых ёмкостей – довольно сложно получить в сервере ёмкости порядков терабайт, особенно если система уже работает на существующих дисках небольшой ёмкости – как минимум, требуется остановка системы и неэффективные финансовые вложения.

Неэффективная утилизация ресурсов – порой не угадать, в каком сервере данные будут расти быстрее. В сервере электронной почты может быть свободен критически малый объём дискового пространства, в то время как другое подразделение будет использовать всего лишь 20% объёма недешёвой дисковой подсистемы (например, SCSI).

4. Низкая степень конфиденциальности распределённых данных – невозможно проконтролировать и ограничить доступ в соответствии с политикой безопасности предприятия. Это касается как доступа к данным по существующим для этого каналам (локальная сеть), так и физического доступа к носителям – к примеру, не исключены хищения жёстких дисков, их разрушение (с целью затруднить бизнес организации). Неквалифицированные действия пользователей и обслуживающего персонала могут нанести ещё больший вред. Когда компания в каждом офисе вынуждена решать мелкие локальные проблемы безопасности, это не даёт желаемого результата.

5. Сложность управления распределёнными потоками информации – любые действия, которые направлены на изменения данных в каждом филиале, содержащем часть распределённых данных, создает определённые проблемы, начиная от сложности синхронизации различных баз данных, версий файлов разработчиков и заканчивая ненужным дублированием информации.

6. Низкий экономический эффект внедрения «классических» решений – по мере роста информационной сети, больших объёмов данных и всё более распределённой структуры предприятия финансовые вложения оказываются не столь эффективны и зачастую не могут решить возникающих проблем.

7. Высокие затраты используемых ресурсов для поддержания работоспособности всей информационной системы предприятия – начиная от необходимости содержать большой штат квалифицированного персонала и заканчивая многочисленными недешёвыми аппаратными решениями, которые призваны решить проблему объёмов и скоростей доступа к информации вкупе с надёжностью хранения и защитой от сбоев.

В свете вышеперечисленных проблем, которые рано или поздно, полностью или частично настигают любую динамично развивающуюся компанию, попробуем обрисовать системы хранения данных – такими, какими они должны быть. Рассмотрим типовые схемы подключения и виды систем хранения данных.

Мегабайты/транзакции?

Если раньше жёсткие диски находились внутри компьютера (сервера), то теперь им там стало тесно и не очень надёжно. Самое простое решение (разработанное достаточно давно и применяемое повсеместно) – технология RAID .

images\RAID\01.jpg

При организации RAID в любых системах хранения данных дополнительно к защите информации мы получаем несколько неоспоримых преимуществ, одно из которых – скорость доступа к информации.

С точки зрения пользователя или ПО, скорость определяется не только пропускной способностью системы (Мбайт/с), но и числом транзакций – то есть числом операций ввода-вывода в единицу времени (IOPS). Увеличению IOPS способствует, что вполне логично, большее число дисков и те методики повышения производительности, которые предоставляет контроллер RAID (к примеру, кэширование).

Если для просмотра потокового видео или организации файл-сервера больше важна общая пропускная способность, то для СУБД, любых OLTP (online transaction processing) приложений критично именно число транзакций, которые способна обрабатывать система. А с этим параметром у современных жёстких дисков всё не так радужно, как с растущими объёмами и, частично, скоростями. Все эти проблемы призвана решить сама система хранения данных.

Уровни защиты

Нужно понимать, что в основе всех систем хранения данных лежит практика защиты информации на базе технологии RAID – без этого любая технически продвинутая СХД будет бесполезна, потому что жёсткие диски в этой системе являются самым ненадёжным компонентом. Организация дисков в RAID – это «нижнее звено», первый эшелон защиты информации и повышения скорости обработки.

Однако, кроме схем RAID, существует и более низкоуровневая защита данных, реализованная «поверх» технологий и решений, внедрённых в сам жёсткий диск его производителем. К примеру, у одного из ведущих производителей СХД – компании EMC – существует методика дополнительного анализа целостности данных на уровне секторов накопителя.

Разобравшись с RAID, перейдём к структуре самих СХД. Прежде всего, СХД разделяются по типу используемых интерфейсов подключения хостов (серверов). Внешние интерфейсы подключения – это, в основном SCSI или FibreChannel, а также довольно молодой стандарт iSCSI. Также не стоит сбрасывать со счетов небольшие интеллектуальные хранилища, которые могут подключаться даже по USB или FireWire. Мы не станем рассматривать более редкие (порой просто неудачные в том или ином плане) интерфейсы, как SSA от IBM или интерфейсы, разработанные для мейнфреймов – к примеру, FICON/ESCON. Особняком стоят хранилища NAS, подключаемые в сеть Ethernet. Под словом «интерфейс» в основном понимается внешний разъём, но не стоит забывать, что разъём не определяет протокол связи двух устройств. На этих особенностях мы остановимся чуть ниже.

images\RAID\02.gif

Расшифровывается как Small Computer System Interface (читается «скази») – полудуплексный параллельный интерфейс. В современных системах хранения данных чаще всего представлен разъёмом SCSI:

images\RAID\03.gif

images\RAID\04.gif

И группой протоколов SCSI, а конкретнее – SCSI-3 Parallel Interface. Отличие SCSI от знакомого нам IDE – бОльшее число устройств на канал, бОльшая длина кабеля, бОльшая скорость передачи данных, а также «эксклюзивные» особенности типа high voltage differential signaling, command quequing и некоторые другие – углубляться в этот вопрос мы не станем.

Если говорить об основных производителях компонент SCSI, например SCSI-адаптеров, RAID-контроллеров с интерфейсом SCSI, то любой специалист сразу вспомнит два названия – Аdaptec и LSI Logic . Думаю, этого достаточно, революций на этом рынке не было уже давно и, вероятно, не предвидится.

Интерфейс FibreChannel

Полнодуплексный последовательный интерфейс. Чаще всего в современном оборудовании представлен внешними оптическими разъёмами типа LC или SC (LC – меньше по размерам):

images\RAID\05.jpg

images\RAID\06.jpg

…и протоколами FibreChannel Protocols (FCP). Существует несколько схем коммутации устройств FibreChannel:

Point-to-Point – точка-точка, прямое соединение устройств между собой:

images\RAID\07.gif

Crosspoint Switched – подключение устройств в коммутатор FibreChannel (аналогичное реализации сети Ethernet на коммутаторах):

images\RAID\08.gif

Arbitrated loop – FC-AL, петля с арбитражным доступом – все устройства связаны друг с другом в кольцо, схема чем-то напоминает Token Ring. Также может использоваться коммутатор – тогда физическая топология будет реализована по схеме «звезда», а логическая – по схеме «петля» (или «кольцо»):

images\RAID\09.gif

Подключение по схеме FibreChannel Switched является самой распространённой схемой, в терминах FibreChannel такое подключение называется Fabric – в русском языке существует калька с него – «фабрика». Следует учесть, что коммутаторы FibreChannel – это довольно продвинутые устройства, по сложности наполнения близкие к IP-коммутаторам уровня 3. Если коммутаторы соединены между собой, то они функционируют в единой фабрике, имея пул настроек, действующих для всей фабрики сразу. Изменение каких-то опций на одном из коммутаторов может приводить к перекоммутации всей фабрики, не говоря уже о настройках авторизации доступа, к примеру. С другой стороны, существуют схемы SAN, которые подразумевают несколько фабрик внутри единой сети SAN. Таким образом, фабрикой можно называть только группу объединённых между собой коммутаторов – два или более не объединённых между собой устройства, введённые в SAN для повышения отказоустойчивости, образуют две или более различные фабрики.

Компоненты, позволяющие объединять хосты и системы хранения данных в единую сеть, принято обозначать термином «connectivity». Connectivity – это, конечно же, дуплексные соединительные кабели (обычно с интерфейсом LC), коммутаторы (switches) и адаптеры FibreChannel (HBA, Host Base Adapters) – то есть те платы расширения, которые, будучи установленными в хосты, позволяют подключить хост в сеть SAN. HBA обычно реализованы в виде плат стандарта PCI-X или PCI-Express.

images\RAID\10.jpg

Не стоит путать fibre и fiber – среда распространения сигнала может быть различной. FibreChannel может работать по «меди». Например, все жёсткие диски FibreChannel имеют металлические контакты, да и обычная коммутация устройств по «меди» – не редкость, просто постепенно все переходят на оптические каналы как наиболее перспективную технологию и функциональную замену «меди».

Интерфейс iSCSI

Обычно представлен внешним разъёмом RJ-45 для подключения в сеть Ethernet и собственно самим протоколом iSCSI (Internet Small Computer System Interface). По определению SNIA: «iSCSI - это протокол, который базируется на TCP/IP и разработан для установления взаимодействия и управления системами хранения данных, серверами и клиентами». На этом интерфейсе остановимся немножко подробней, хотя бы в силу того, что каждый пользователь способен использовать iSCSI даже в обычной «домашней» сети.

Необходимо знать, что протокол iSCSI определяет, как минимум, транспортный протокол для SCSI, который работает поверх TCP, и технологию инкапсуляции SCSI-команд в сеть на базе IP. Проще говоря, iSCSI – это протокол, позволяющий получить блочный доступ к данным с помощью команд SCSI, пересылаемых через сеть со стеком TCP/IP. iSCSI появился как замена FibreChannel и в современных СХД имеет перед ним несколько преимуществ – способность объединять устройства на огромных расстояниях (используя существующие сети IP), возможность обеспечивать заданный уровень QoS (Quality of Service, качество обслуживания), более низкую стоимость connectivity. Однако основная проблема использования iSCSI как замены FibreChannel – большое время задержек, возникающих в сети из-за особенностей реализации стека TCP/IP, что сводит на нет одно из важных преимуществ использования СХД – скорость доступа к информации и низкую латентность. Это серьёзный минус.

Маленькое замечание по поводу хостов – они могут использовать как обычные сетевые карты (тогда обработка стека iSCSI и инкапсуляция команд будет осуществляться программными средствами), так и специализированные карты с поддержкой технологий аналогичных TOE (TCP/IP Offload Engines). Такая технология обеспечивает аппаратную обработку соответствующей части стека протокола iSCSI. Программный метод дешевле, однако больше загружает центральный процессор сервера и в теории может приводить к бОльшим задержкам, чем аппаратный обработчик. При современной скорости сетей Ethernet в 1 Гбит/с можно предположить, что iSCSI будет работать ровно в два раза медленнее FibreChannel со скоростью 2 Гбит, однако в реальном применении разница будет ещё заметнее.

Помимо уже рассмотренных, кратко упомянем ещё пару протоколов, которые встречаются более редко и предназначены для предоставления дополнительных сервисов уже существующим сетям хранения данных (SAN):

FCIP (Fibre Channel over IP)

– туннельный протокол, построенный на TCP/IP и предназначенный для соединения географически разнесённых сетей SAN через стандартную среду IP. Например, можно объединить две сети SAN в одну через Интернет. Достигается это использованием FCIP-шлюза, который прозрачен для всех устройств в SAN.

iFCP (Internet Fibre Channel Protocol)

– протокол, позволяющий объединять устройства с интерфейсами FC через IP-сети. Важное отличие от FCIP в том, что возможно объединять именно FC-устройства через IP-сеть, что позволяет для разной пары соединений иметь разный уровень QoS, что невозможно при туннелировании через FCIP.

Мы кратко рассмотрели физические интерфейсы, протоколы и типы коммутации для систем хранения данных, не останавливаясь на перечислении всех возможных вариантов. Теперь попытаемся представить какие же параметры характеризуют системы хранения данных?

Основные аппаратные параметры СХД

Некоторые из них были перечислены выше – это тип внешних интерфейсов подключения и типы внутренних накопителей (жёстких дисков). Следующий параметр, который есть смысл рассматривать после двух вышеперечисленных при выборе дисковой системы хранения, – её надёжность. Надёжность можно оценить не по банальному времени наработки на отказ каких-то отдельных компонент (факт, что это время примерно равно у всех производителей), а по внутренней архитектуре. «Обычная» система хранения часто «внешне» представляет собой дисковую полку (для монтажа в 19-дюймовый шкаф) с жёсткими дисками, внешними интерфейсами для подключения хостов, несколькими блоками питания. Внутри обычно установлено всё то, что обеспечивает работу системы хранения – процессорные блоки, контроллеры дисков, портов ввода-вывода, кэш-память и так далее. Обычно управление стойкой осуществляется из командной строки или по web-интерфейсу, начальная конфигурация часто требует подключения по последовательному интерфейсу. Пользователь может «разбить» имеющиеся в системе диски на группы и объединить их в RAID (различных уровней), получившееся дисковое пространство разделяется на один или несколько логических блоков (LUN), к которым и имеют доступ хосты (серверы) и «видят» их как локальные жёсткие диски. Количество RAID-групп, LUN-ов, логика работы кэша, доступность LUN-ов конкретным серверам и всё остальное настраивается администратором системы. Обычно СХД предназначены для подключения к ним не одного, а нескольких (вплоть до сотен, в теории) серверов – посему такая система должна обладать высокой производительностью, гибкой системой управления и мониторинга, продуманными средствами защиты данных. Защита данных обеспечивается многими способами, самый простой из которых вы уже знаете – объединение дисков в RAID. Однако данные должны быть ещё и постоянно доступны – ведь остановка одной системы хранения данных, центральной на предприятии, способна нанести ощутимые убытки. Чем больше систем хранит данные на СХД, тем более надёжный доступ к системе должен быть обеспечен – потому что при аварии СХД останавливается работа сразу всех серверов, хранящих там данные. Высокая доступность стойки обеспечивается полным внутренним дублированием всех компонент системы – путей доступа к стойке (портов FibreChannel), процессорных модулей, кэш-памяти, блоков питания и т.д. Попытаемся принцип 100%-го резервирования (дублирования) объяснить следующим рисунком:

images\RAID\11.gif

1. Контроллер (процессорный модуль) СХД, включающий в себя:

*центральный процессор (или процессоры) – обычно на системе работает специальное ПО, выполняющее роль «операционной системы»;

*интерфейсы для коммутации с жёсткими дисками – в нашем случае это платы, обеспечивающие подключение дисков FibreChannel по схеме петли с арбитражным доступом (FC-AL);

*кэш-память;

*контроллеры внешних портов FibreChannel

2. Внешний интерфейс FC; как мы видим, тут их по 2 штуки на каждый процессорный модуль;

3. Жёсткие диски – ёмкость расширяется дополнительными дисковыми полками;

4. Кэш-память в такой схеме обычно зеркалируется, чтобы не потерять сохранённые там данные при выходе любого модуля из строя.

Касательно аппаратной части – дисковые стойки могут иметь различные интерфейсы для подключения хостов, различные интерфейсы жёстких дисков, различные схемы подключения дополнительных полок, служащих для увеличения числа дисков в системе, а также другие чисто «железные параметры».

Программное обеспечение СХД

Естественно, аппаратная мощь систем хранения должна как-то управляться, а сами СХД просто обязаны предоставлять уровень сервиса и функциональность, недоступную в обычных схемах «сервер-клиент». Если рассмотреть рисунок «Структурная схема системы хранения данных», становится понятно, что при прямом подключении сервера к стойке двумя путями они должны быть подключены к FC-портам различных процессорных модулей, для того чтобы сервер продолжал работать при выходе из строя сразу всего процессорного модуля. Естественно, для использования multipathing должна быть обеспечена поддержка этой функциональности аппаратными и программными средствами всех уровней, участвующих в передаче данных. Конечно же, полное резервирование без средств мониторинга и оповещения не имеет смысла – поэтому все серьёзные системы хранения имеют такие возможности. К примеру, оповещение о каких-либо критических событиях может происходить различными средствами – это оповещение по e-mail, автоматический модемный звонок в центр техподдержки, сообщение на пейджер (сейчас актуальнее SMS), SNMP-механизмы и прочее.

Ну и как мы уже упоминали, существуют мощные средства управления всем этим великолепием. Обычно это web-интерфейс, консоль, возможность писать скрипты и встраивать управление во внешние программные пакеты. Про механизмы, обеспечивающие высокую производительность СХД, упомянем лишь вкратце – неблокируемая архитектура с несколькими внутренними шинами и большим количеством жёстких дисков, мощные центральные процессоры, специализированная система управления (ОС), большой объём кэш-памяти, множество внешних интерфейсов ввода-вывода.

Сервисы, предоставляемые системами хранения, обычно определяются программным обеспечением, функционирующим на самой дисковой стойке. Практически всегда это сложные программные пакеты, приобретаемые по отдельным лицензиям, не входящим в стоимость самой СХД. Сразу упомянем уже знакомое вам ПО для обеспечения multipathing – вот оно как раз функционирует на хостах, а не на самой стойке.

Следующее по популярности решение – ПО для создания мгновенных и полных копий данных. Различные производители по-разному называют свои программные продукты и механизмы создания этих копий. Мы для обобщения можем манипулировать словами снапшот (snapshot) и клон (clone). Клон делается средствами дисковой стойки внутри самой стойки – это полная внутренняя копия данных. Сфера применения довольно широка – от бэкапа (backup) до создания «тестовой версии» исходных данных, к примеру, для рискованных модернизаций, в которых нет уверенности и применять которые на актуальных данных небезопасно. Тот, кто внимательно следил за всеми прелестями СХД, которые мы тут разбирали, спросит – для чего же нужен бэкап данных внутри стойки, если она обладает такой высокой надёжностью? Ответ на этот вопрос на поверхности – никто не застрахован от человеческих ошибок. Данные сохранены надёжно, но если сам оператор сделал что-то не так, к примеру, удалил нужную таблицу в базе данных, от этого не спасут никакие аппаратные ухищрения. Клонирование данных обычно выполняется на уровне LUN. Более интересная функциональность обеспечивается механизмом снапшотов. В какой-то мере мы получаем все прелести полной внутренней копии данных (клона), при этом не занимая 100% объёма копируемых данных внутри самой стойки, ведь такой объём нам не всегда доступен. По сути снапшот – мгновенный «снимок» данных, который не занимает времени и процессорных ресурсов СХД.

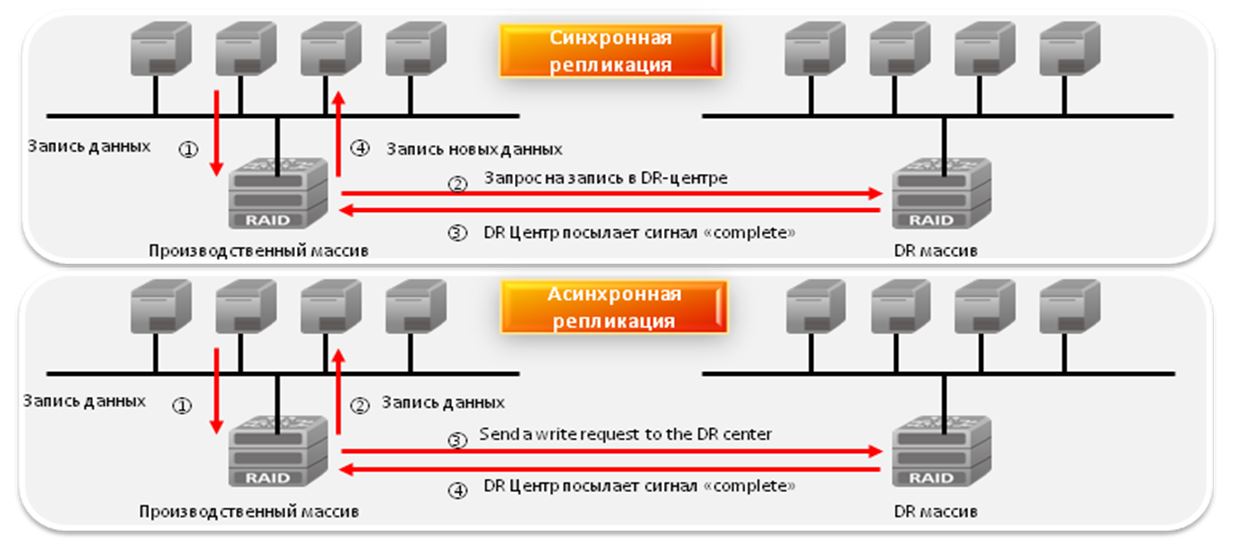

Конечно нельзя не упомянуть ПО для репликации (replication) данных, которое часто называют зеркалированием (mirroring). Это механизм синхронного или асинхронного реплицирования (дублирования) информации с одной системы хранения на одну или несколько удалённых систем хранения. Репликация возможна по различных каналам – к примеру, стойки с интерфейсами FibreChannel могут асинхронно, через Интернет и на большие расстояния, реплицироваться на другую СХД. Такое решение обеспечивает надёжность хранения информации и защиту от катастроф.

Кроме всех перечисленных, существует большое число других программных мехонизмов манипуляций данными...

DAS & NAS & SAN

После знакомства с самими системами хранения данных, принципами их построения, предоставляемыми ими возможностями и протоколами функционирования самое время попробовать объединить полученные знания в работающую схему. Попробуем рассмотреть типы систем хранения и топологии их подключения в единую работающую инфраструктуру.

Устройства DAS (Direct Attached Storage) – системы хранения, подключаемые напрямую к серверу. Сюда относятся как самые простые SCSI-системы, подключаемые к SCSI/RAID-контроллеру сервера, так и устройства FibreChannel, подключенные прямо к серверу, хотя и предназначены они для сетей SAN. В этом случае топология DAS является вырожденной SAN (сетью хранения данных):

images\RAID\12.gif

В этой схеме один из серверов имеет доступ к данным, хранящимся на СХД. Клиенты получают доступ к данным, обращаясь к этому серверу через сеть. То есть сервер имеет блочный доступ к данным на СХД, а уже клиенты пользуются файловым доступом – эта концепция очень важна для понимания. Минусы такой топологии очевидны:

*Низкая надежность – при проблемах сети или аварии сервера данные становятся недоступны всем сразу.

*Высокая латентность, обусловленная обработкой всех запросов одним сервером и использующимся транспортом (чаще всего – IP).

*Высокая загрузка сети, часто определяющая пределы масштабируемости путём добавления клиентов.

*Плохая управляемость – вся ёмкость доступна одному серверу, что снижает гибкость распределения данных.

*Низкая утилизация ресурсов – трудно предсказать требуемые объёмы данных, у одних устройств DAS в организации может быть избыток ёмкости (дисков), у других её может не хватать – перераспределение часто невозможно или трудоёмко.

Устройства NAS (Network Attached Storage) – устройства хранения, подключённые напрямую в сеть. В отличие от других систем NAS обеспечивает файловый доступ к данным и никак иначе. NAS-устройства представляют из себя комбинацию системы хранения данных и сервера, к которому она подключена. В простейшем варианте обычный сетевой сервер, предоставляющий файловые ресурсы, является устройством NAS:

images\RAID\13.gif

Все минусы такой схемы аналогичны DAS-топологии, за некоторым исключением. Из добавившихся минусов отметим возросшую, и часто значительно, стоимость – правда, стоимость пропорциональна функциональности, а тут уже часто «есть за что платить». NAS-устройства могут быть простейшими «коробочками» с одним портом ethernet и двумя жёсткими дисками в RAID1, позволяющими доступ к файлам по лишь одному протоколу CIFS (Common Internet File System) до огромных систем в которых могут быть установлены сотни жёстких дисков, а файловый доступ обеспечивается десятком специализированных серверов внутри NAS-системы. Число внешних Ethernet-портов может достигать многих десятков, а ёмкость хранимых данных – несколько сотен терабайт (например EMC Celerra CNS). Такие модели по надёжности и производительности могут далеко обходить многие midrange-устройства SAN. Что интересно, NAS-устройства могут быть частью SAN-сети и не иметь собственных накопителей, а лишь предоставлять файловый доступ к данным, находящимся на блочных устройствах хранения. В таком случае NAS берёт на себя функцию мощного специализированного сервера, а SAN – устройства хранения данных, то есть мы получаем топологию DAS, скомпонованную из NAS- и SAN-компонентов.

NAS-устройства очень хороши в гетерогенной среде, где необходим быстрый файловый доступ к данным для многих клиентов одновременно. Также обеспечивается отличная надёжность хранения и гибкость управления системой вкупе с простотой обслуживания. На надёжности особо останавливаться не будем – этот аспект СХД рассмотрен выше. Что касается гетерогенной среды, доступ к файлам в рамках единой NAS-системы может быть получен по протоколам TCP/IP, CIFS, NFS, FTP, TFTP и другим, включая возможность работы NAS, как iSCSI-target, что обеспечивает функционирование с различным ОС, установленными на хостах. Что касается лёгкости обслуживания и гибкости управления, то эти возможности обеспечиваются специализированной ОС, которую трудно вывести из строя и не нужно обслуживать, а также простотой разграничения прав доступа к файлам. К примеру, возможна работа в среде Windows Active Directory с поддержкой требуемой функциональности – это может быть LDAP, Kerberos Authentication, Dynamic DNS, ACLs, назначение квот (quotas), Group Policy Objects и SID-истории. Так как доступ обеспечивается к файлам, а их имена могут содержать символы различных языков, многие NAS обеспечивают поддержку кодировок UTF-8, Unicode. К выбору NAS стоит подходить даже тщательнее, чем к DAS-устройствам, ведь такое оборудование может не поддерживать необходимые вам сервисы, например, Encrypting File Systems (EFS) от Microsoft и IPSec. К слову можно заметить, что NAS распространены намного меньше, чем устройства SAN, но процент таких систем всё же постоянно, хотя и медленно, растёт – в основном за счёт вытеснения DAS.

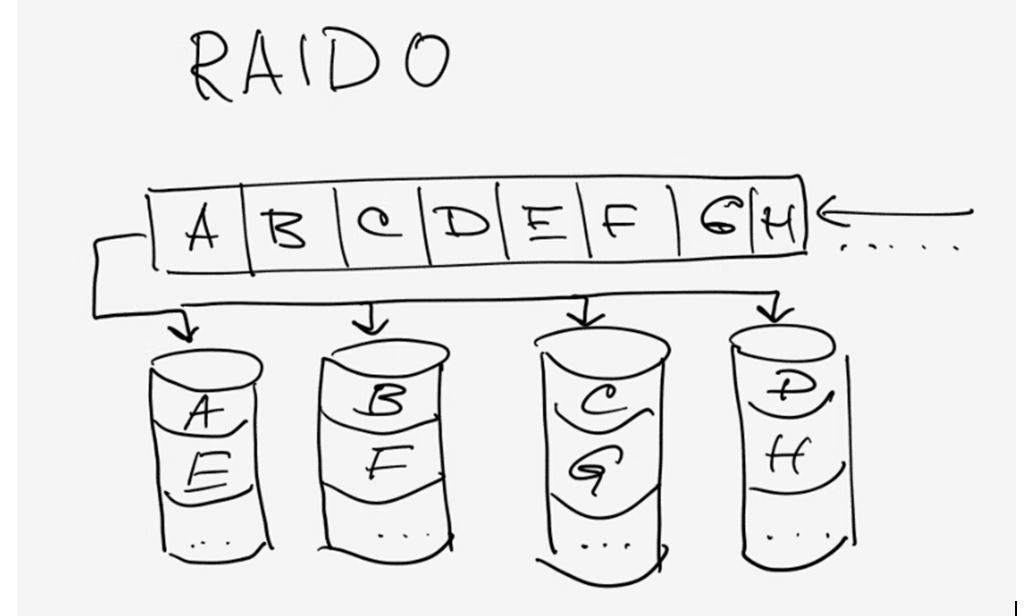

Устройства для подключения в SAN (Storage Area Network) – устройства для подключения в сеть хранения данных. Сеть хранения данных (SAN) не стОит путать с локальной сетью – это различные сети. Чаще всего SAN основывается на стеке протоколов FibreChannel и в простейшем случае состоит из СХД, коммутаторов и серверов, объединённых оптическими каналами связи. На рисунке мы видим высоконадёжную инфраструктуру, в которой серверы включены одновременно в локальную сеть (слева) и в сеть хранения данных (справа):

images\RAID\14.gif

После довольно детального рассмотрения устройств и принципов их функционирования нам будет довольно легко понять топологию SAN. На рисунке мы видим единую для всей инфраструктуры СХД, к которой подключены два сервера. Серверы имеют резервированные пути доступа – в каждом установлено по два HBA (или один двухпортовый, что снижает отказоустойчивость). Устройство хранения имеет 4 порта, которыми оно подключено в 2 коммутатора. Предполагая, что внутри имеется два резервируемых процессорных модуля, легко догадаться, что лучшая схема подключения – когда каждый коммутатор подключён и в первый, и во второй процессорный модуль. Такая схема обеспечивает доступ к любым данным, находящимся на СХД, при выходе из строя любого процессорного модуля, коммутатора или пути доступа. Надёжность СХД нами уже изучена, два коммутатора и две фабрики ещё более увеличивают доступность топологии, так что если из-за сбоя или ошибки администратора один из коммутационных блоков вдруг отказал, второй будет функционировать нормально, ведь эти два устройства не связаны между собой.

Показанное подключение серверов называется подключением с высокой доступностью (high availability), хотя в сервере при необходимости может быть установлено ещё большее число HBA. Физически каждый сервер имеет только два подключения в SAN, однако логически система хранения доступна через четыре пути – каждая HBA предоставляет доступ к двум точкам подключения на СХД, к каждому процессорному модулю раздельно (эту возможность обеспечивает двойное подключение коммутатора к СХД). На данной схеме самое ненадежной устройство – это сервер. Два коммутатора обеспечивают надежность порядка 99,99%, а вот сервер может отказать по разным причинам. Если необходима высоконадёжная работа всей системы, серверы объединяются в кластер, приведённая схема не требует никакого аппаратного дополнения для организации такой работы и считается эталонной схемой организации SAN. Простейший же случай – серверы, подключённые единственным путем через один свитч к системе хранения. Однако система хранения при наличии двух процессорных модулей должна подключаться в коммутатор как минимум одним каналом на каждый модуль – остальные порты могут быть использованы для прямого подключения серверов к СХД, что иногда необходимо. И не стоит забывать, что SAN возможно построить не только на базе FibreChannel, но и на базе протокола iSCSI – при этом можно использовать только стандартные ethernet-устройства для коммутации, что удешевляет систему, но имеет ряд дополнительных минусов (оговоренных в разделе, рассматривающем iSCSI). Также интересна возможность загрузки серверов с системы хранения – не обязательно даже наличие внутренних жёстких дисков в сервере. Таким образом, с серверов окончательно снимается задача хранения каких-либо данных. В теории специализированный сервер может быть превращён в обычную числодробилку без каких-либо накопителей, определяющими блоками которого являются центральные процессоры, память, а так же интерфейсы взаимодействия с внешним миром, например порты Ethernet и FibreChannel. Какое-то подобие таких устройств являют собой современные blade-серверы.

Хочется отметить, что устройства, которые возможно подключить в SAN, не ограничены только дисковыми СХД – это могут быть дисковые библиотеки, ленточные библиотеки (стримеры), устройства для хранения данных на оптических дисках (CD/DVD и прочие) и многие другие.

Из минусов SAN отметим лишь высокую стоимость её компонент, однако плюсы неоспоримы:

* Высокая надёжность доступа к данным, находящимся на внешних системах хранения. Независимость топологии SAN от используемых СХД и серверов.

* Централизованное хранение данных (надёжность, безопасность).

* Удобное централизованное управление коммутацией и данными.

* Перенос интенсивного трафика ввода-вывода в отдельную сеть, разгружая LAN.

* Высокое быстродействие и низкая латентность.

* Масштабируемость и гибкость логической структуры SAN

* Географически размеры SAN, в отличие от классических DAS, практически не ограничены.

* Возможность оперативно распределять ресурсы между серверами.

* Возможность строить отказоустойчивые кластерные решения без дополнительных затрат на базе имеющейся SAN.

* Простая схема резервного копирования – все данные находятся в одном месте.

* Наличие дополнительных возможностей и сервисов (снапшоты, удаленная репликация).

* Высокая степень безопасности SAN.

В заключение

Думаю, мы достаточно полно осветили основной круг вопросов, связанных с современными системами хранения. Будем надеяться, что такие устройства будут ещё стремительнее развиваться функционально, а число механизмов управления данными будет только расти.

В заключение можно сказать, что NAS и SAN-решения в данный момент переживают настоящий бум. Число производителей и разнообразие решений увеличивается, техническая грамотность потребителей растёт. Смело можно предполагать, что в ближайшем будущем практически в каждой вычислительной среде появятся те или иные системы хранения данных.

Любые данные предстают перед нами в виде информации. Смысл работы любых вычислительных устройств – обработка информации. В последнее время объёмы её роста порой пугают, поэтому системы хранения данных и специализированное программное обеспечение, несомненно, будут самым востребованными продуктами IT-рыка в ближайшие годы.

Что это?

Сеть хранения данных

, или Storage Area Network - это система, состоящая из собственно устройств хранения данных - дисковых, или RAID - массивов, ленточных библиотек и прочего, среды передачи данных и подключенных к ней серверов. Обычно используется достаточно крупными компаниями, имеющими развитую IT инфраструктуру, для надежного хранения данных и скоростного доступа к ним.

Упрощенно, СХД - это система, позволяющая раздавать серверам надежные быстрые диски изменяемой емкости с разных устройств хранения данных.

Немного теории.

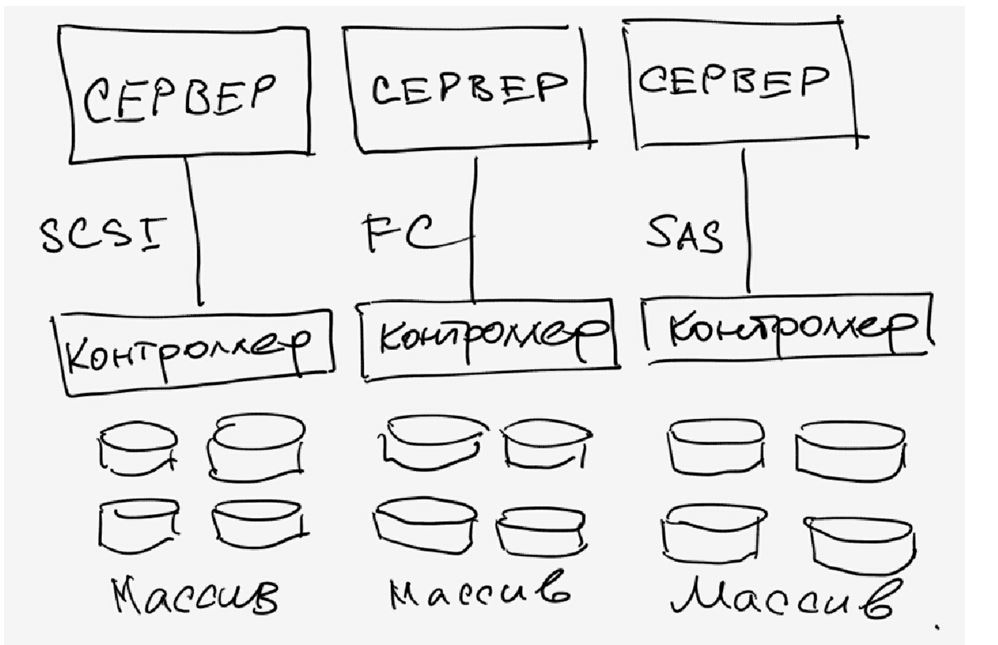

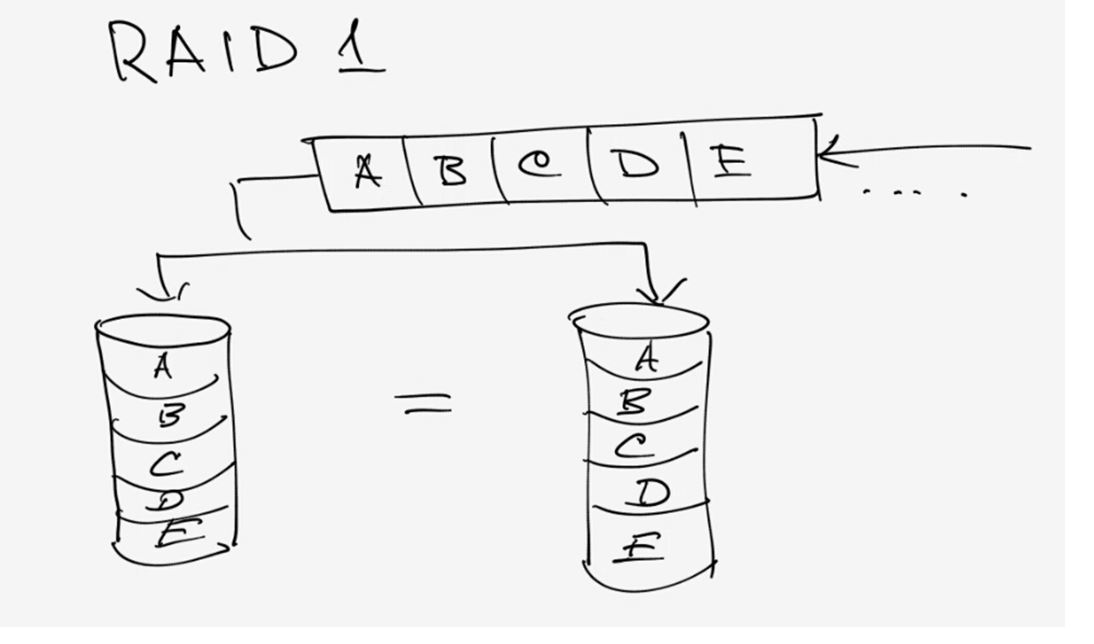

Сервер к хранилищу данных можно подключить несколькими способами.

Первый и самый простой - DAS, Direct Attached Storage (прямое подключение), без затей ставим диски в сервер, или массив в адаптер сервера - и получаем много гигабайт дискового пространства со сравнительно быстрым доступом, и при использовании RAID-массива - достаточную надежность, хотя копья на тему надежности уже давно.

Однако такое использование дискового пространства не оптимально - на одном сервере место кончается, на другом его еще много. Решение этой проблемы - NAS, Network Attached Storage (хранилище, подключенное по сети). Однако при всех преимуществах этого решения - гибкости и централизованного управления - есть один существенный недостаток - скорость доступа, еще не во всех организациях внедрена сеть 10 гигабит. И мы подходим к сети хранения данных.

Главное отличие SAN от NAS (помимо порядка букв в аббревиатурах) - это то, каким образом видятся подключаемые ресурсы на сервере. Если в NAS ресурсы подключаются протоколам NFS или SMB , в SAN мы получаем подключение к диску, с которым можем работать на уровне операций блочного ввода-вывода, что гораздо быстрее сетевого подключения (плюс контроллер массива с большим кэшем добавляет скорости на многих операциях).

Используя SAN, мы сочетаем преимущества DAS - скорость и простоту, и NAS - гибкость и управляемость. Плюс получаем возможность масштабирования систем хранения до тех пор, пока хватает денег, параллельно убивая одним выстрелом еще несколько зайцев, которых сразу не видно:

* снимаем ограничения на дальность подключения SCSI -устройств, которые обычно ограничены проводом в 12 метров,

* уменьшаем время резервного копирования,

* можем грузиться с SAN,

* в случае отказа от NAS разгружаем сеть,

* получаем большую скорость ввода-вывода за счет оптимизации на стороне системы хранения,

* получаем возможность подключать несколько серверов к одному ресурсу, то нам дает следующих двух зайцев:

o на полную используем возможности VMWare - например VMotion (миграцию виртуальной машины между физическими) и иже с ними,

o можем строить отказоустойчивые кластеры и организовывать территориально распределенные сети.

Что это дает?

Помимо освоения бюджета оптимизации системы хранения данных, мы получаем, вдобавок к тому что я написал выше:

* увеличение производительности, балансировку нагрузки и высокую доступность систем хранения за счет нескольких путей доступа к массивам;

* экономию на дисках за счет оптимизации расположения информации;

* ускоренное восстановление после сбоев - можно создать временные ресурсы, развернуть на них backup и подключить к ним сервера, а самим без спешки восстанавливать информацию, или перекинуть ресурсы на другие сервера и спокойно разбираться с умершим железом;

* уменьшение время резервного копирования - благодаря высокой скорости передачи можно бэкапиться на ленточную библиотеку быстрее, или вообще сделать snapshot (мгновенный снимок) с файловой системы и спокойно архивировать его;

* дисковое место по требованию - когда нам нужно - всегда можно добавить пару полок в систему хранения данных.

* уменьшаем стоимость хранения мегабайта информации - естественно, есть определенный порог, с которого эти системы рентабельны.

* надежное место для хранения mission critical и business critical данных (без которых организация не может существовать и нормально работать).

* отдельно хочу упомянуть VMWare - полностью все фишки вроде миграции виртуальных машин с сервера на сервер и прочих вкусностей доступны только на SAN.

Из чего это состоит?

Как я писал выше - СХД состоит из устройств хранения, среды передачи и подключенных серверов. Рассмотрим по порядку:

Системы хранения данных обычно состоят из жестких дисков и контроллеров, в уважающей себя системе как правило всего по 2 - по 2 контроллера, по 2 пути к каждому диску, по 2 интерфейса, по 2 блока питания, по 2 администратора. Из наиболее уважаемых производителей систем следует упомянуть HP, IBM, EMC и Hitachi. Тут процитирую одного представителя EMC на семинаре - «Компания HP делает отличные принтеры. Вот пусть она их и делает!» Подозреваю, что в HP тоже очень любят EMC. Конкуренция между производителями нешуточная, впрочем, как и везде. Последствия конкуренции - иногда вменяемые цены за мегабайт системы хранения и проблемы с совместимостью и поддержкой стандартов конкурентов, особенно у старого оборудования.

Среда передачи данных

. Обычно SAN строят на оптике, это дает на текущий момент скорость в 4, местами в 8 гигабит на канал. При построении раньше использовались специализированные хабы, сейчас больше свитчи, в основном от Qlogic, Brocade, McData и Cisco (последние два на площадках не видел ни разу). Кабели используются традиционные для оптических сетей - одномодовые и многомодовые , одномодовые более дальнобойные.

Внутри используется FCP - Fibre Channel Protocol , транспортный протокол. Как правило внутри него бегает классический SCSI, а FCP обеспечивает адресацию и доставку. Есть вариант с подключением по обычной сети и iSCSI , но он обычно использует (и сильно грузит) локальную, а не выделенную под передачу данных сеть, и требует адаптеров с поддержкой iSCSI, ну и скорость помедленнее, чем по оптике.

Есть еще умное слово топология, которое встречается во всех учебниках по SAN. Топологий несколько, простейший вариант - точка-точка (point to point), соединяем между собой 2 системы. Это не DAS, а сферический конь в вакууме простейший вариант SAN. Дальше идет управляемая петля (FC-AL), она работает по принципу «передай дальше» - передатчик каждого устройства соединен с приемником последующего, устройства замкнуты в кольцо. Длинные цепочки имеют свойство долго инициализироваться.

Ну и заключительный вариант - коммутируемая структура (Fabric), она создается с помощью свитчей. Структура подключений строится в зависимости от количества подключаемых портов, как и при построении локальной сети. Основной принцип построения - все пути и связи дублируются. Это значит, что до каждого устройства в сети есть минимум 2 разных пути. Здесь тоже употребимо слово топология , в смысле организации схемы подключений устройств и соединения свитчей. При этом как правило свитчи настраиваются так, что сервера не видят ничего, кроме предназначенных им ресурсов. Это достигается за счет создания виртуальных сетей и называется зонированием, ближайшая аналогия - VLAN . Каждому устройству в сети присваивается аналог MAC -адреса в сети Ethernet, он называется WWN - World Wide Name . Он присваивается каждому интерфейсу и каждому ресурсу (LUN) систем хранения данных. Массивы и свитчи умеют разграничивать доступ по WWN для серверов.

Сервера подключают к СХД через HBA - Host Bus Adapter -ы. По аналогии с сетевыми картами существуют одно-, двух-, четырехпортовые адаптеры. Лучшие собаководы рекомендуют ставить по 2 адаптера на сервер, это позволяет как осуществлять балансировку нагрузки, так и обеспечивает надежность.

А дальше на системах хранения нарезаются ресурсы, они же диски (LUN) для каждого сервера и оставляется место в запас, все включается, установщики системы прописывают топологию, ловят глюки в настройке свитчей и доступа, все запускается и все живут долго и счастливо*.

Я специально не касаюсь разных типов портов в оптической сети, кому надо - тот и так знает или прочитает, кому не надо - только голову забивать. Но как обычно, при неверно установленном типе порта ничего работать не будет.

Из опыта.

Обычно при создании SAN заказывают массивы с несколькими типами дисков: FC для скоростных приложений, и SATA или SAS для не очень быстрых. Таким образом получаются 2 дисковые группы с различной стоимостью мегабайта - дорогая и быстрая, и медленная и печальная дешевая. На быструю вешаются обычно все базы данных и прочие приложения с активным и быстрым вводом-выводом, на медленную - файловые ресурсы и все остальное.

Если SAN создается с нуля - имеет смысл строить ее на основе решений от одного производителя. Дело в том, что, несмотря на заявленное соответствие стандартам, существуют подводные грабли проблемы совместимости оборудования, и не факт, что часть оборудования будет работать друг с другом без плясок с бубном и консультаций с производителями. Обычно для утряски таких проблем проще позвать интегратора и дать ему денег, чем общаться с переводящими друг на друга стрелки производителями.

Если SAN создается на базе существующей инфраструктуры - все может быть сложно, особенно если есть старые SCSI массивы и зоопарк старой техники от разных производителей. В этом случае имеет смысл звать на помощь страшного зверя интегратора, который будет распутывать проблемы совместимости и наживать третью виллу на Канарах.

Часто при создании СХД фирмы не заказывают поддержку системы производителем. Обычно это оправдано, если у фирмы есть штат грамотных компетентных админов (которые уже 100 раз назвали меня чайником) и изрядный капитал, позволяющий закупить запасные комплектующие в потребных количествах. Однако компетентных админов обычно переманивают интеграторы (сам видел), а денег на закупку не выделяют, и после сбоев начинается цирк с криками «Всех уволю!» вместо звонка в саппорт и приезда инженера с запасной деталью.

Поддержка обычно сводится к замене умерших дисков и контроллеров, ну и к добавлению в систему полок с дисками и новых серверов. Много хлопот бывает после внезапной профилактики системы силами местных специалистов, особенно после полного останова и разборки-сборки системы (и такое бывает).

Про VMWare. Насколько я знаю (спецы по виртуализации поправьте меня), только у VMWare и Hyper-V есть функционал, позволяющий «на лету» перекидывать виртуальные машины между физическими серверами. И для его реализации требуется, чтобы все сервера, между которыми перемещается виртуальная машина, были подсоединены к одному диску.

Про кластеры. Аналогично случаю с VMWare, известные мне системы построения отказоустойчивых кластеров (Sun Cluster, Veritas Cluster Server) - требуют подключенного ко всем системам хранилища.

Пока писал статью - у меня спросили - в какие RAIDы обычно объединяют диски?

В моей практике обычно делали или по RAID 1+0 на каждую дисковую полку с FC дисками, оставляя 1 запасной диск (Hot Spare) и нарезали из этого куска LUN-ы под задачи, или делали RAID5 из медленных дисков, опять же оставляя 1 диск на замену. Но тут вопрос сложный, и обычно способ организации дисков в массиве выбирается под каждую ситуацию и обосновывается. Та же EMC например идет еще дальше, и у них есть дополнительная настройка массива под приложения, работающие с ним (например под OLTP, OLAP). С остальными вендорами я так глубоко не копал, но догадываюсь, что тонкая настройка есть у каждого.

* до первого серьезного сбоя, после него обычно покупается поддержка у производителя или поставщика системы.

Поскольку в песочнице комментариев нет, закину в личный блог.

Метки: Добавить метки

Если Серверы - это универсальные устройства, выполняющие в большинстве случаев

- либо функцию сервера приложения (когда на сервере выполняются специальные программы, и идут интенсивные вычисления),

- либо функцию файл-сервера (т.е. некоего места для централизованного хранения файлов данных)

то СХД (Системы Хранения Данных) - устройства, специально спроектированные для выполнения таких серверных функций, как хранение данных.

Необходимость приобретения СХД

возникает обычно у достаточно зрелых предприятий, т.е. тех, кто задумывается над тем, как

- хранить и управлять информацией, самым ценным активом компании

- обеспечить непрерывность бизнеса и защиту от потери данных

- увеличить адаптируемость ИТ-инфраструктуры

СХД и виртуализация

Конкуренция заставляет компании МСБ работать эффективней, без простоев и с высоким КПД. Смена производственных моделей, тарифных планов, видов услуг происходит всё чаще. Весь бизнез современных компаний "завязан" на информационных технологиях. Потребности бизнеса меняются быстро, и мгновенно отражаются на ИТ - растут требования к надёжности и адаптируемости ИТ-инфраструктуры. Виртуализация предоставляет такие возможности, но для этого нужны недорогие и простые в обслуживании системы хранения данных.

Классификация СХД по типу подключения

DAS . Первые дисковые массивы соединялись с серверами по интерфейсу SCSI. При этом один сервер мог работать только с одним дисковым массивом. Это - прямое соединение СХД (DAS - Direct Attached Storage).

NAS . Для более гибкой организации структуры вычислительного центра - чтобы каждый пользователь мог использовать любую систему хранения - необходимо подключить СХД в локальную сеть. Это - NAS - Network Attached Storage). Но обмен данными между сервером и СХД во много раз более интенсивный чем между клиентом и сервером, поэтому в таком варианте варианте появились объективные трудности, связанные с пропускной способностью сети Ethernet. Да и с точки зрения безопасности не совсем правильно показывать СХД в общую сеть.

SAN . Но можно создать между серверами и СХД свою, отдельную, высокоскоростную сеть. Такую сеть назвали SAN (Storage Area Network). Быстродействие обеспечивается тем, что физической средой передачи там является оптика. Специальные адаптеры (HBA) и оптические FC-коммутаторы обеспечивают передачу данных на скорости 4 и 8Gbit/s. Надёжность такой сети повышалась резервированием (дупликацией) каналов (адаптеров, коммутаторов). Основным недостатком является высокая цена.

iSCSI . С появлением недорогих Ethernet-технологий 1Gbit/s и 10Gbit/s, оптика со скоростью передачи 4Gbit/s уже выглядит не так привлекательно, особенно с учетом цены. Поэтому всё чаще в качестве среды SAN используется протокол iSCSI (Internet Small Computer System Interface). Сеть iSCSI SAN может быть построена на любой достаточно быстрой физической основе, поддерживающей протокол IP.

Классификация Систем Хранения Данныхпо области применения:

| класс | описание |

|

personal |

Чаще всего представляют из себя обычный 3.5" или 2.5" или 1.8" жесткий диск, помещенный в специальный корпус и оснащенный интерфейсами USB и/или FireWire 1394 и/или Ethernet, и/или eSATA. |

small workgroup |

Обычно это стационарное или переносное устройство, в которое можно устанавливать несколько (чаще всего от 2 до 5) жестких дисков SATA, с возможностью горячей замены или без, имеющее интерфейс Ethernet. Диски можно организовывать в массивы - RAID различного уровня для достижения высокой надежности хранения и скорости доступа. СХД имеет специализированную ОС, обычно на основе Linux, и позволяет разграничивать уровень доступа по имени и паролю пользователей, организовывать квотирование дискового пространства и т.п. |

|

workgroup |

Устройство, обычно монтируемое в 19" стойку (rack-mount) в которое можно устанавливать 12-24 жестких дисков SATA или SAS с возможностью горячей замены HotSwap. Имеет внешний интерфейс Ethernet, и/или iSCSI. Диски организованы в массивы - RAID для достижения высокой надежности хранения и скорости доступа. СХД поставляется со специализированным программным обеспечением, которое позволяет разграничивать уровень доступа, организовывать квотирование дискового пространства, организовывать BackUp (резервное копирование информации) и т.п. Такие СХД подходят для средних и крупных предприятий, и используются совместно с одним или несколькими серверами. |

enterprise  |

Стационарное устройство или устройство, монтируемое в 19" стойку (rack-mount) в которое можно устанавливать до сотен жестких дисков. В дополнение к предыдущему классу СХД могут иметь возможность наращивания, модернизации и замены компонент без остановки системы, системы мониторинга. Программное обеспечение может поддерживать создание "моментальных снимков" и другие "продвинутые" функции. Такие СХД подходят для больших предприятий и обеспечивают повышенную надежность, скорость и защиту критически важных данных. |

|

high-end enterprise |

В дополнение к предыдущему классу СХД может поддерживать тысячи жестких дисков. |

История вопроса.

Первые серверы сочетали в одном корпусе все функции (как компьютеры) - и вычислительные (сервер приложений) и хранение данных (файл-сервер). Но по мере роста потребности приложений в вычислительных мощностях с одной стороны и по мере роста количества обрабатываемых данных с другой стороны - стало просто неудобно размещать все в одном корпусе. Эффективнее оказалось выносить дисковые массивы в отдельные корпуса. Но тут встал вопрос соединения дискового массива с сервером. Первые дисковые массивы соединялись с серверами по интерфейсу SCSI. Но в таком случае один сервер мог работать только с одним дисковым массивом. Народу захотелось более гибкой организации структуры вычислительного центра - чтобы любой сервер мог использовать любую систему хранения. Подключить все устройства напрямую в локальную сеть и организовать обмен данными по Ethernet - конечно, простое и универсальное решение. Но обмен данными между серверами и СХД во много раз более интенсивный чем между клиентами и серверами, поэтому в таком варианте варианте (NAS - см. ниже) появились объективные трудности, связанные с пропускной способностью сети Ethernet. Возникла идея создать между серверами и СХД свою, отдельную высокоскоростную сеть. Такую сеть назвали SAN (см. ниже). Она похожа на Ethernet, только физической средой передачи там является оптика. Там тоже есть адаптеры (HBA), которые устанавливаются в серверы и коммутаторы (оптические). Стандарты на скорость передачи данных по оптике - 4Gbit/s. С появлением технологий Ethernet 1Gbit/s и 10Gbit/s, а также протокола iSCSI всё чаще в качестве среды SAN используется Ethernet.

Итак, выпуск №1 – «Системы хранения данных».

Системы хранения данных.

По-английски они называются одним словом – storage, что очень удобно. Но на русский это слово переводится довольно коряво – «хранилище». Часто на слэнге «ИТ-шников» используют слово «сторадж» в русской транскрипции, или слово «хранилка», но это уже совсем моветон. Поэтому будем использовать термин «системы хранения данных», сокращенно СХД, или просто «системы хранения».

К устройствам хранения данных можно отнести любые устройства для записи данных: т.н. «флешки», компакт-диски (CD, DVD, ZIP), ленточные накопители (Tape), жесткие диски (Hard disk, их еще называют по старинке «винчестеры», поскольку первые их модели напоминали обойму с патронами одноименной винтовки 19 века) и пр. Жесткие диски используются не только внутри компьютеров, но и как внешние USB-устройства записи информации, и даже, например, одна из первых моделей iPod’а – это небольшой жесткий диск диаметром 1,8 дюйма, с выходом на наушники и встроенным экраном.

В последнее время все большую популярность набирают т.н. «твердотельные» системы хранения SSD (Solid State Disk, или Solid State Drive), которые по принципу действия схожи с «флешкой» для фотоаппарата или смартфона, только имеют контроллер и больший объем хранимых данных. В отличие от жесткого диска, SSD-диск не имеет механически движущихся частей. Пока цены на такие системы хранения достаточно высоки, но быстро снижаются.

Все это – потребительские устройства, а среди промышленных систем следует выделить, прежде всего, аппаратные системы хранения: массивы жестких дисков, т.н. RAID-контроллеры для них, ленточные системы хранения для долговременного хранения данных. Кроме того, отдельный класс: контроллеры для систем хранения, для управления резервированием данных, создания «мгновенных снимков» (Snapshot) в системе хранения для последующего их восстановления, репликации данных и т.д.). В системы хранения данных также входят сетевые устройства (HBА, коммутаторы Fiber Channel Switch, кабели FC/SAS и пр.). И, наконец, разработаны масштабные решения по хранению данных, архивации, восстановления данных и устойчивости к катастрофам (disater recovery).

Откуда берутся данные, которые необходимо хранить? От нас, любимых, пользователей, от прикладных программ, электронной почты, а также от различного оборудования – файловых серверов, и серверов баз данных. Кроме того, поставщик большого количества данных – т.н. устройства М2М (Machine-to-Machine communication) – разного рода датчики, сенсоры, камеры и пр.

По частоте использования хранимых данных, СХД можно подразделить на системы краткосрочного хранения (online storage), хранения средней продолжительности (near-line storage) и системы долговременного хранения (offline storage).

К первым можно отнести жесткий диск (или SSD) любого персонального компьютера. Ко вторым и третьим – внешние системы хранения DAS (Direct Attached Storage), которые могут представлять собой массив внешних, по отношению к компьютеру, дисков (Disk Array). Их, в свою очередь также можно подразделить на «просто массив дисков» JBOD (Just a Bunch Of Disks) и массив с управляющим контроллером iDAS (intelligent disk array storage).

Внешние системы хранения бывают трех типов DAS (Direct Attached Storage), SAN (Storage Area Network) и NAS (Network attached Storage). К сожалению, даже многие опытные ИТ-шники не могут объяснить разницу между SAN и NAS, говоря, что когда-то эта разница была, а теперь – ее, якобы, уже и нет. На самом деле, разница есть, и существенная (см. рис. 1).

Рисунок 1. Различие между SAN и NAS.

В SAN с системой хранения связаны фактически сами серверы через сеть области хранения данных SAN. В случае NAS – сетевые серверы связаны через локальную сеть LAN с общей файловой системой в RAID.

Основные протоколы подключения СХД

Протокол SCSI (Small Computer System Interface), произносится как «скáзи», протокол, разработанный в середине 80-х годов для подключения внешних устройств к мини мини-компьютерам. Его версия SCSI-3 является основой для всех протоколов связи систем хранения данных и использует общую систему команд SCSI. Его основные преимущества: независимость от используемого сервера, возможность параллельной работы нескольких устройств, высокая скорость передачи данных. Недостатки: ограниченность числа подключенных устройств, дальность соединения сильно ограничена.

Протокол FC (Fiber Channel), внутренний протокол между сервером и совместно используемой СХД, контроллером, дисками. Это широко используемый протокол последовательной связи, работающий на скоростях 4 или 8 Гигабит в секунду (Gbps). Он, как явствует из его названия, работает через оптоволокно (fiber), но и по меди тоже может работать. Fiber Channel – основной протокол для систем хранения FC SAN.

Протокол iSCSI (Internet Small Computer System Interface), стандартный протокол для передачи блоков данных поверх широко известного протокола TCP/IP т.е. «SCSI over IP». iSCSI может рассматриваться как высокоскоростное недорогое решение для систем хранения, подключаемые удаленно, через Интернет. iSCSI инкапсулирует команды SCSI в пакеты TCP/IP для передачи их по IP-сети.

Протокол SAS (Serial Attached SCSI). SAS использует последовательную передачу данных и совместим с жесткими дисками SATA. В настоящий момент SAS может передавать данные со скоростью 3Gpbs или 6Gpbs, и поддерживает режим полного дуплекса, т.е. может передавать данные в обе стороны с одинаковой скоростью.

Типы систем хранения.

Можно различить три основных типа систем хранения:

- DAS (Direct Attached Storage)

- NAS (Network attached Storage)

- SAN (Storage Area Network)

СХД c непосредственном подключением дисков DAS были разработаны еще в конце

Рисунок 2. DAS

70-х годов, вследствие взрывного увеличения пользовательских данных, которые уже просто физически не помещались во внутренней долговременной памяти компьютеров (для молодых сделаем примечание, что здесь речь идет не о персоналках, их тогда еще не было, а больших компьютерах, т.н. мейнфреймах). Скорость передачи данных в DAS была не очень невысокой, от 20 до 80 Мбит/с, но для тогдашних нужд ее вполне хватало.

СХД с сетевым подключением NAS появились в начале 90-х годов. Причиной стало быстрое развитие сетей и критические требования к совместному использованию больших массивов данных в пределах предприятия или сети оператора. В NAS использовалась специальная сетевая файловая система CIFS (Windows) или NFS (Linux), поэтому разные серверы разных пользователей могли считывать один и тот же файл из NAS одновременно. Скорость передачи данных была уже повыше: 1 — 10Gbps.

Рисунок 3. NAS

В середине 90-х появились сети для подключения устройств хранения FC SAN. Разработка их была вызвана необходимостью организации разбросанных по сети данных. Одно устройство хранения в SAN может быть разбито на несколько небольших узлов, называемых LUN (Logical Unit Number), каждый из которых принадлежит одному серверу. Скорость передачи данных возросла до 2-8 Gbps. Такие СХД могли обеспечивать технологии защиты данных от потерь (snapshot, backup).

Рисунок 4. FC SAN

Другая разновидность SAN – IP SAN(IP Storage Area Network), разработанная в начале 2000-х. Системы FC SAN были дороги, сложны в управлении, а сети протокола IP находились на пике развития, поэтому и появился этот стандарт. СХД подключались к серверам при помощи iSCSI-контроллера через IP-коммутаторы. Скорость передачи данных: 1 — 10 Гбит/с.

Рис.5. IP SAN.

В таблице показаны некоторые сравнительные характеристики всех рассмотренных систем хранения:

| DAS | NAS | SAN | ||

| FC SAN | IP SAN | |||

| Тип передачи | SCSI, FC, SAS | IP | FC | IP |

| Тип данных | Блок данных | Файл | Блок данных | Блок данных |

| Типичное приложение | Любое | Файл-сервер | Базы данных | Видео-наблюдение |

| Преимущество | Легкость понимания,

Превосходная совместимость |

Легкость установки, низкая стоимость | Хорошая масштабиру-емость | Хорошая масштабиру-емость |

| Недостатки | Трудность управления.

Неэффективное использование ресурсов. Плохая масштабиру-емость |

Низкая производительность.

Неприменимо для некоторых приложений |

Высокая стоимость.

Сложность конфигурации |

Низкая производи-тельность |

Кратко, SAN предназначены для передачи массивных блоков данных в СХД, в то время как NAS обеспечивают доступ к данным на уровне файлов. Комбинацией SAN + NAS можно получить высокую степень интеграции данных, высокопроизводительный доступ и совместный доступ к файлам. Такие системы получили название unified storage – «унифицированные системы хранения».

Унифицированные системы хранения: архитектура сетевых СХД, которая поддерживает как файлово-ориентированную систему NAS, так и блоко-ориентированную систему SAN. Такие системы были разработаны в начале 2000-х годов с целью разрешить проблемы администрирования и высокой суммарной стоимости владения раздельными системами на одном предприятии. Такая СХД поддерживает практически все протоколы: FC, iSCSI, FCoE, NFS, CIFS.

Жесткие диски

Все жесткие диски можно подразделить на два основных типа: HDD (Нard Disk Drive, что, собственно, и переводится как «жесткий диск») и SSD (Solid State Drive, — т.н. «твердотельный диск»). Т.е., и тот и другой диск – жесткие. Что же тогда «мягкий диск», такие бывают? Да, в прошлом были, назывались «флоппи-диски» (так их прозвали из-за характерного «хлопающего» звука в дисководе при работе). Приводы для них ещё можно увидеть в системных блоках старых компьютеров, которые сохранились в некоторых госучреждениях. Однако, при всем желании, такие магнитные диски их вряд ли можно отнести к СИСТЕМАМ хранения. Это были некие аналоги теперешних «флешек».

Различие HDD и SSD в том, что HDD имеет несколько соосных магнитных дисков внутри и сложную механику, перемещающую магнитные головки считывания-записи, а SSD не имеет механически движущихся частей, и представляет собой, по сути, просто микросхему, запрессованную в пластик. Поэтому называть «жесткими дисками» только HDD, строго говоря, некорректно.

Жесткие диски можно классифицировать по следующим параметрам:

- Конструктивное исполнение: HDD, SSD;

- Диаметру HDD в дюймах: 5.25, 3.5 , 2.5, 1.8 дюйма;

- Интерфейсу: ATA/IDE, SATA/NL SAS, SCSI, SAS, FC

- Классу использования: индивидуальные (desktop class), корпоративные (enterprsie class).

| SATA | SAS | NL-SAS | SSD | |

| Скорость вращения (RPM) | 7200 | 15000/10000 | 7200 | NA |

| Типичная ёмкость (TБ) | 1T/2T/3T | 0.3T/0.6T/0.9T | 2T/3T/4T | 0.1T/0.2T/0.4T |

| MTBF (час) | 1 200 000 | 1 600 000 | 1 200 000 | 2 000 000 |

| Примечания | Развитие жестких дисков ATA с последовательной передачей данных.

SATA 2.0 поддерживает скорости передачи 300MБ/с, SATA3.0 поддерживает до 600MБ/с. Среднегодовой % отказов AFR (Annualized Failure Rate) для дисков SATA – около 2%. |

Жесткие диски SATA с интерфейсом SAS подходят для иерархических (tiering). Среднегодовой % отказов AFR (Annualized Failure Rate) для дисков NL-SAS около 2%. | Твердотельные диски выполненные из электронных микросхем памяти, включая устройство управления и чип (FLASH/DRAM). Спецификация интерфейса, функции и метод использования такие же, как у HDD, размер и форма – тоже. |

Характеристики жестких дисков :

- Ёмкость

В современных жестких дисках емкость измеряется в гигабайтах или терабайтах. Для HDD эта величина кратна ёмкости одного магнитного диска внутри коробки, умноженной на число магнитных, которых обычно бывает несколько.

- Скорость вращения (только для HDD)

Скорость вращения магнитных дисков внутри привода, измеряется в оборотах в минуту RPМ (Rotation Per Minute), обычно составляет 5400 RPM или 7200 RPM. HDD с интерфейсами SCSI/SAS имеют скорость вращения 10000-15000 RPM.

- Среднее время доступа = Среднее время поиска (Mean seek time) + Среднее время ожидания (Mean wait time), т.е. время извлечения информации с диска.

- Скорость передачи данных

Это скорости считывания и записи данных на жестком диске, измеряемая в мегабайтах в секунду (MB/S). Они обычно отличаются друг от друга по величине.

- IOPS (Input/Output Per Second)

Число операций ввода-вывода (или чтения-записи) в секунду (Input/Output Operations Per Second), один из основных индикаторов измерения производительности диска. Для приложений с частые операции чтения и записи, таких как OLTP (Online Transaction Processing) – онлайн-обработка транзакций, IOPS – самый важный показатель, т.к. именно от него зависит быстродействие бизнес-приложения. Другой важный показатель – data throughput, что примерно можно перевести как «пропускная способность данных», т.е. какой объем данных можно передать за единицу времени.

RAID

Как бы ни были надежны жесткие диски, а все же данные в них иногда теряются, по разным причинам. Поэтому была предложена технология RAID (Redundant Array of Independent Disks) – массив независимых дисков с избыточностью хранения данных. Избыточность означает то, что все байты данных при записи на один диск дублируются на другом диске, и могут быть использованы в том случае, если первый диск откажет. Кроме того, эта технология помогает увеличить IOPS.

Основные понятия RAID – stripping (т.н. «располосование» или разделение) и mirroring (т.н. «зеркалирование», или дублирование) данных. Их сочетания определяют различные виды RAID-массивов жестких дисков.

Различают следующие уровни RAID-массивов:

Комбинации этих видов порождают еще несколько новых видов RAID:

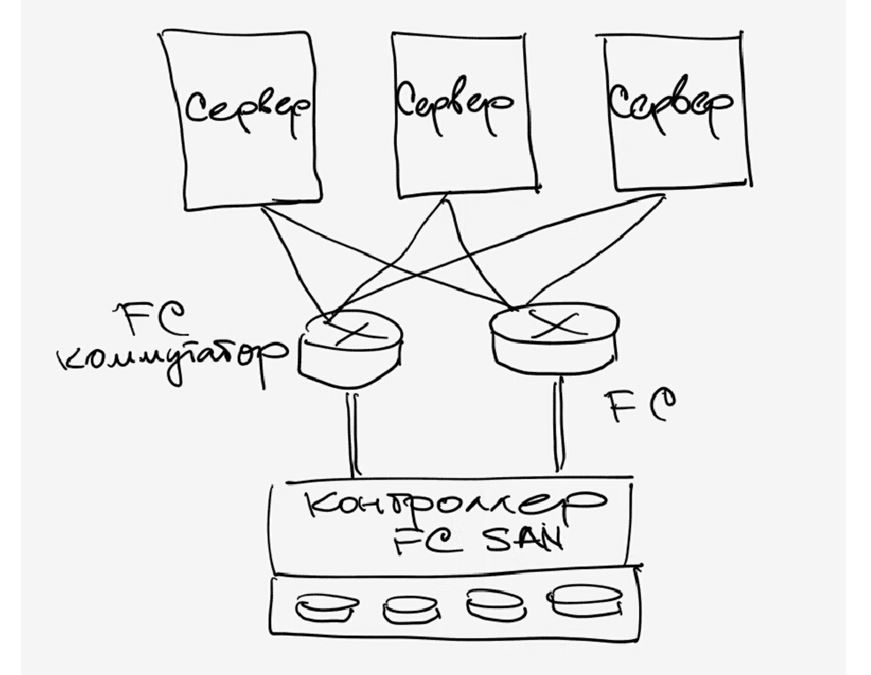

Рисунок поясняет принцип выполнения RAID 0 (разделение):

Рис. 6. RAID 0.

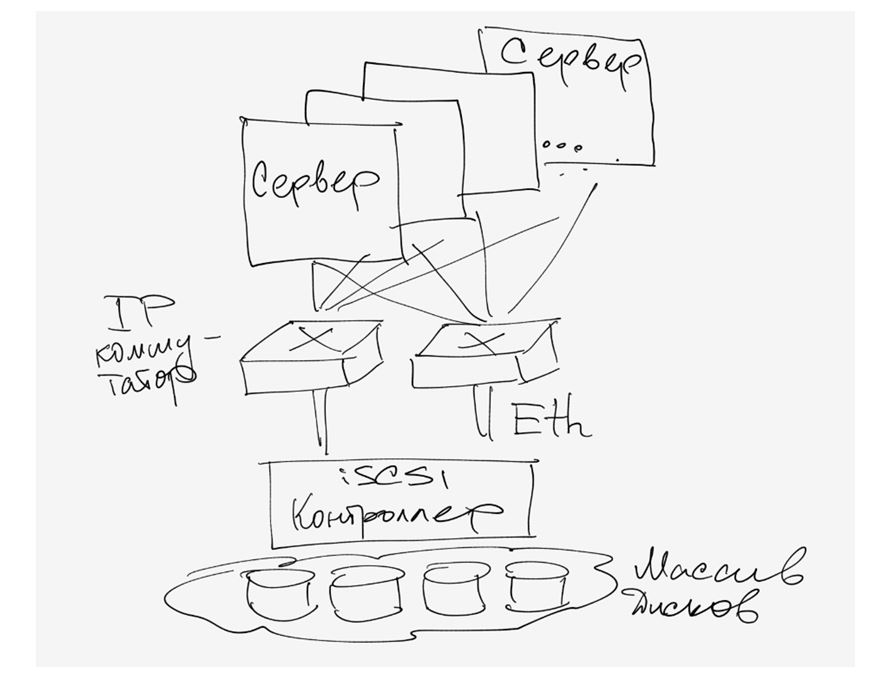

А так выполняется RAID 1 (дублирование):

Рис. 7. RAID 1.

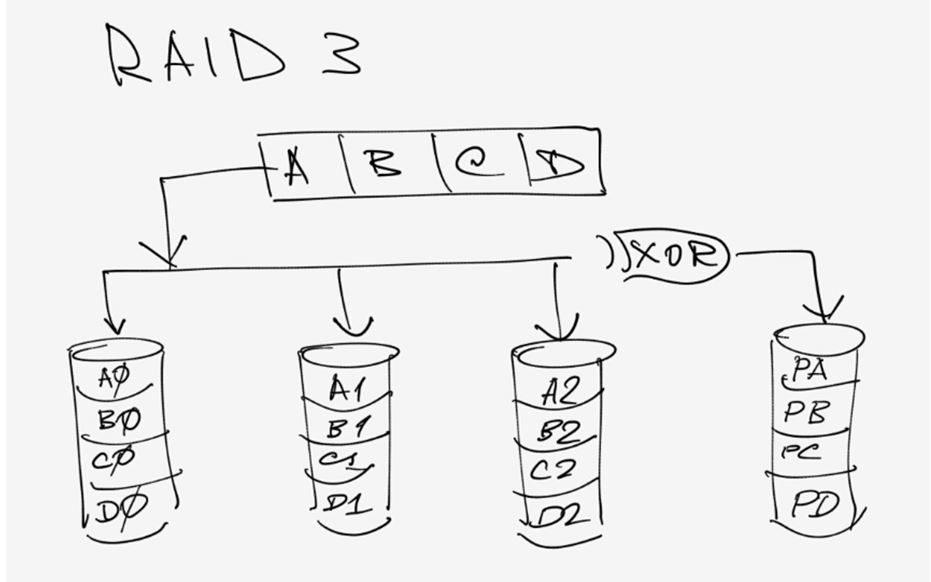

А вот так работает RAID 3. XOR – логическая функция исключающее ИЛИ (eXclusive OR). При помощи нее вычисляется значение паритета для блоков данных A, B, C, D… , который записывается на отдельный диск.

Рис. 8. RAID 3.

Вышеприведенные схемы хорошо иллюстрируют принцип действия RAID и в комментариях не нуждаются. Мы не будем приводить схемы работы остальных уровней RAID, желающие могут их найти в Интернете.

Основные характеристики видов RAID приведены в таблице.

Программное обеспечение систем хранения

Программное обеспечение для систем хранения можно подразделить на следующие категории:

- Управление и администрирование (Management): управление и задание параметров инфраструктуры: вентиляции, охлаждения, режимы работы дисков и пр., управление по времени суток и пр.

- Защита данных: Snapshot («моментальный снимок» состояния диска), копирование содержимого LUN, множественное дублирование (split mirror), удаленное дублирование данных (Remote Replication), непрерывная защита данных CDP (Continuous Data Protection) и др.

- Повышение надежности: различное ПО для множественного копирования и резервирования маршрутов передачи данных внутри ЦОД и между ними.

- Повышение эффективности: Технология тонкого резервирования (Thin Provisioning), автоматическое разделение системы хранения на уровни (tiered storage), устранение повторений данных (deduplication), управление качеством сервиса, предварительное извлечение из кэш-памяти (cache prefetch), разделение данных (partitioning), автоматическая миграция данных, снижение скорости вращения диска (disk spin down)

Очень интересна технология «thin provisioning ». Как это часто бывает в ИТ, термины часто трудно поддаются адекватному переводу на русский язык, например, трудно точно перевести слово «provisioning» («обеспечение», «поддержка», «предоставление» – ни один из этих терминов не передает смысл полностью). А уж когда оно – «тонкое» (thin)…

По принципу «thin provisioning», например, работает банковский кредит. Когда банк выдает десять тысяч кредитов лимитом в 500 тысяч, ему не нужно иметь на счету 5 миллиардов, так как пользователи карточек обычно не тратят весь кредит сразу. Тем не менее, каждый пользователь в отдельности может воспользоваться всей или почти всей суммой кредита, если общий объем средств банка не исчерпан.

Так же работают водопроводные и электрические компании. Предоставляя услуги водо- или электро-снабжения, они рассчитывают, что все жители не станут разом открывать все краны или включать все имеющие в домах электроприборы. За счет более гибкого потребления ресурсов удается сэкономить на их цене и мощности ресурса.

Рис. 9. Thin provisioning .

Таким образом, использование thin provisioning позволяет решить проблему неэффективного распределения пространства в SAN, сэкономить место, облегчить административные процедуры распределения пространства приложениям на хранилище, и использовать так называемый oversubscribing, то есть выделить приложениям места больше, чем мы располагаем физически, в расчете на то, что приложения не затребуют одновременно все пространство. По мере же возникновения в нем потребности позже возможно увеличить физическую емкость хранилища.

Разделение системы хранения на уровни (tiered storage) предполагает, что различные данные хранятся в устройствах хранения, быстродействие которых соответствует частоте обращения к этим данным. Например, часто используемые данные можно размещать в «online storage» на дисках SSD с высокой скоростью доступа, высокой производительностью. Однако, цена таких дисков пока высока, поэтому их целесообразно использовать только для online storage (пока).

Скорость дисков FC/SAS также достаточно высока, а цена умерена. Поэтому такие диски хорошо походят для «near-line storage», где хранятся данные, обращения к которым происходят не так часто, но в то же время и не так редко.

Наконец, диски SATA/NL-SAS имеют относительно невысокую скорость доступа, но зато отличаются большой емкостью и относительно дешевы. Поэтому на них обычно делают offline storage, для данных редкого использования.

Как только система управления замечает, что обращения к данным в offline storage участились, она переводит их в near-line storage, а при дальнейшей активизации их использования – и в online storage» на дисках SSD.

Дедупликация (устранение повторений) данных (deduplication, DEDUP): как следует из названия, устраняет повторы данных на пространстве диска, обычно используемого в части резервирования данных. Хотя система неспособна определить, какая информация избыточна, она может определить наличие повторов данных. За счет этого становится возможным значительно сократить требования к емкости системы резевирования.

Снижение скорости вращения диска (Disk spin-down ) – то, что обычно называют «гибернацией» (засыпанием) диска. Данные на каком-то диске могут не использоваться долгое время, в этом случае технология снижения скорости диска переводит их в режим гибернации, чтобы снизить потребление энергии на бесполезное вращение диска на обычной скорости. При этом также повышается срок службы диска, и увеличивается надежность системы в целом. При поступлении первого запроса к данным на этом диске, он «просыпается», скорость его вращения увеличивается. Платой за экономию энергии и повышение надежности является некоторая задержка при первом обращении к данным на диске, но эта плата вполне оправдана.

«Моментальный снимок» состояния диска (Snapshot ). Snapshot – это полностью пригодная к использованию копия определенного набора данных на диске на момент съема этой копии (поэтому она и называется «моментальным снимком»). Такая копия используется для частичного восстановления состояния системы на момент копирования. При этом непрерывность работы системы совершенно не затрагивается, и быстродействие не ухудшается.

Удаленная репликация данных (Remote Replication) : работает с использованием технологии зеркалирования. Может поддерживать несколько копий данных на двух или более сайтах для предотвращения потери данных в случае стихийных бедствий. Существует два типа репликации: синхронная и асинхронная, различие между ними пояснено на рисунке.

Рис. 10. Удаленная репликация данных (Remote Replication).

Непрерывная защита данных CDP (Continuous data protection) , также известная как continuous backup или real-time backup, представляет собой создание резервной копии автоматически при каждом изменении данных. При этом становится возможным восстановление данных при любых авариях в любой момент времени, причем при этом доступны актуальная копия данных, а не тех, что были несколько минут или часов назад.

Программы управления и администрирования (Management Software): сюда входит разнообразное программное обеспечение по управлению и администрированию различных устройств: простые программы конфигурации (cofiguration wizards), программы централизованного мониторинга: отображение топологии, мониторинг в реальном времени механизмы формирования отчетов о сбоях. Также сюда входят программы «гарантии непрерывности бизнеса» (Business Guarantee): многоразмерная статистика производительности, отчеты и запросы производительности и пр.

Восстановление при стихийных бедствиях (DR, Disaster Recovery) . Это довольно важная составляющая серьезных промышленных СХД, хотя и достаточно затратная. Но эти затраты необходимо нести, чтобы не потерять в одночасье «то, что нажито непосильным трудом» и куда и так уже вложены значительные средства. Рассмотренные выше системы защиты данных (Snapshot, Remote Replication, CDP) хороши до тех пор, пока в населенном пункте, где расположена система хранения не произошло какое-либо стихийное бедствие: цунами, наводнение, землетрясение или (тьфу-тьфу-тьфу) – ядерная война. Да и любая война тоже способна сильно подпортить жизнь людям, которые занимаются полезными делами, например, хранением данных, а не беганием с автоматом с целью оттяпать себе чужие территории или наказать каких-нибудь «неверных». Удаленная репликация подразумевает, что реплицирующая СХД находится в том же самом городе, или как минимум поблизости. Что, например, при цунами не спасает.

Технология Disaster Recovery предполагает, что центр резервирования, используемый для восстановления данных при стихийных бедствиях, располагается на значительном удалении от места основного ЦОД, и взаимодействует с ним по сети передачи данных, наложенной на транспортную сеть, чаще всего оптическую. Использовать при таком расположении основного и резервного ЦОД, например, технологию CDP будет просто невозможно технически.

В технологии DR используются три основополагающих понятия:

- BW (Backup Window) – «окно резевирования», время, необходимое для системы резевирования для того, чтобы скопировать принятый объем данных рабочей системы.

- RPO (Recovery Point Objective) – «Допустимая точка восстановления», максимальный период времени и соответствующий объем данных, который допустимо потерять для пользователя СХД.

- RTO (Recovery Time Objective) – «допустимое время недоступности», максимальное время, в течение которого СХД может быть недоступной, без критического воздействия на основной бизнес.

Рис. 11. Три основополагающих понятия технологии DR.

Данное эссе не претендует на полноту изложения и лишь поясняет основные принципы работы СХД, хотя и далеко не в полном объеме. В различных источниках в Интернете содержится много документов, более подробно описывающих все изложенные (и не изложенные) здесь моменты.

Система хранения данных (СХД) - это конгломерат специализированного оборудования и программного обеспечения , который предназначен для хранения и передачи больших массивов информации. Позволяет организовать хранение информации на дисковых площадках с оптимальным распределением ресурсов.

Еще один фактор - появление на рынке множества компаний, которые предлагают свои решения для поддержки бизнеса предприятий: ERP , биллинговые системы , системы поддержки принятия решений и т. д. Все они позволяют собирать детальные данные самого разного характера в огромных объемах. При наличии в организации развитой ИТ-инфраструктуры эти данные можно собрать вместе и проанализировать их.

Следующий фактор - технологического характера. До некоторого времени производители приложений самостоятельно разрабатывали разные версии своих решений для разных серверных платформ или предлагали открытые решения. Важной для отрасли технологической тенденцией стало создание адаптируемых платформ для решения различных аналитических задач, которые включают аппаратную составляющую и СУБД . Пользователей уже не волнует, кто сделал для их компьютера процессор или оперативную память, - они рассматривают хранилище данных как некую услугу. И это важнейший сдвиг в сознании.

Технологии, которые позволяют использовать хранилища данных для оптимизации операционных бизнес-процессов практически в реальном времени не только для высококвалифицированных аналитиков и топ-менеджеров, но и для сотрудников фронт-офиса, в частности для сотрудников офисов продаж и контактных центров. Принятие решений делегируется сотрудникам, стоящим на более низких ступенях корпоративной лестницы. Необходимые им отчеты, как правило, просты и кратки, но их требуется очень много, а время формирования должно быть невелико.

Сферы применения СХД

Традиционные хранилища данных можно встретить повсеместно. Они предназначены для формирования отчетности, помогающей разобраться с тем, что произошло в компании. Однако это первый шаг, базис.

Людям становится недостаточно знать, что произошло, им хочется понять, почему это случилось. Для этого используются инструменты бизнес-аналитики, которые помогают понять то, что говорят данные.

Вслед за этим приходит использование прошлого для предсказания будущего, построение прогностических моделей: какие клиенты останутся, а какие уйдут; какие продукты ждет успех, а какие окажутся неудачными и т.д.

Некоторые организации уже находятся на стадии, когда хранилища данных начинают использовать для понимания того, что происходит в бизнесе в настощее время. Поэтому следующий шаг - это «активация» фронтальных систем при помощи решений, основанных на анализе данных, зачастую в автоматическом режиме.

Объемы цифровой информации растут лавинообразно. В корпоративном секторе этот рост вызван, с одной стороны, ужесточением регулирования и требованием сохранять все больше информации, относящейся к ведению бизнеса. С другой стороны, ужесточение конкуренции требует все более точной и подробной информации о рынке, клиентах, их предпочтениях, заказах, действиях конкурентов и т.д .

В государственном секторе рост объемов хранимых данных поддерживает повсеместный переход к межведомственному электронному документообороту и создание ведомственных аналитических ресурсов, основой которых являются разнообразные первичные данные.

Не менее мощную волну создают и обычные пользователи, которые выкладывают в интернет свои фотографии, видеоролики и активно обмениваются мультимедийным контентом в социальных сетях.

Требования к СХД

Какой критерий выбора дисковых СХД для Вас важнее? Результат опроса на сайте www.timcompany.ru, февраль 2012 года