NAS NAS

Los volúmenes de información y datos con los que trabajan las empresas modernas superan con creces el nivel de hace una década o incluso cinco años. Las soluciones técnicas que nos permiten procesar eficientemente tal escala de datos corporativos hoy en día son significativamente diferentes de los esquemas que operan en las condiciones de "uso doméstico". Para la vida de la empresa, ya se necesitan varios servidores que realizan simultáneamente diferentes tareas: terminal, correo, DNS, servidores proxy y otros, a menudo no combinados en un sistema de clúster. Con esta distribución, existe un problema de procesamiento en línea y copia de seguridad de datos de varios dispositivos. Para resolver este problema, se utilizan sistemas de almacenamiento de datos (SHD), que nuestra empresa ofrece para elegir y comprar.

Beneficios de usar almacenamiento externo conectado a la red

Tal sistema de almacenamiento de datos (SHD) para trabajar con datos es una solución integral que le permite almacenar de manera centralizada cualquier cantidad de información, asegurando la confiabilidad de su protección, la velocidad de procesamiento y el archivo completo. El almacenamiento en red tiene varias ventajas más que las soluciones clásicas para distribuir información entre varios servidores. La tolerancia a fallos se logra mediante la posibilidad de redundancia parcial y total de los componentes de almacenamiento de red. El almacenamiento externo de datos de red se caracteriza por un rendimiento más potente y la velocidad de transferencia de datos, se adapta fácilmente a las necesidades comerciales de la empresa, ya que tiene la capacidad de escalar y adaptarse fácilmente a los cambios en el volumen de flujos de datos de información en la empresa. El almacén de datos, a diferencia de las bases de datos estándar, puede usarse no solo para procesar transacciones, sino también para analizar la dinámica de ventas durante varios años, generar informes en varios formatos, integrar datos de varios sistemas de registro.

Hay cuatro tipos de almacenamiento de datos:

- NAS Sistemas confiables, económicos y fácilmente personalizables.

- DAS Esquemas con un enlace externo, lo que permite conectar un número ilimitado de discos.

- SAN. Muy adecuado para almacenar bases de datos de correo y proporcionar acceso rápido a la información.

- Almacenes de datos tolerantes a fallas. Combinado en un esquema de clúster y proporcionar la mayor fiabilidad y velocidad de transferencia de datos.

Los almacenes de datos externos se utilizan para guardar archivos internos. espacio en disco, evitar la pérdida de datos, garantizar la seguridad y la disponibilidad del contenido en cualquier momento.

¿Comprar almacenamiento en línea a buen precio? Para ti aquí!

Si decide comprar un almacenamiento de red para su organización, Trinity le proporcionará a su empresa sistemas de almacenamiento de datos confiables y potentes. En nuestro surtido hay varias configuraciones de sistemas de almacenamiento. Somos los representantes oficiales de los principales fabricantes de equipos de TI en el mercado mundial y podemos completar rápidamente el almacén de datos de cualquier configuración. Ofrecemos sistemas de almacenamiento de fabricantes como Dell, HP, Lenovo, EMC, etc.

Para cada empresa específica, según sus requisitos y tareas, nuestros expertos lo ayudarán a elegir o ensamblar un sistema de almacenamiento de datos individual que sea óptimo para su tamaño, presupuesto e infraestructura de red existente. El precio del sistema de almacenamiento de datos seleccionado dependerá de la configuración, el costo del diseño del almacén de datos, dependiendo de las tareas, puede consultar con nuestros especialistas.

Nuestra empresa realiza todo el trabajo en el análisis del estado actual de la base técnica, la selección del equipo necesario y la instalación del equipo. Solo necesita dejar una solicitud a nuestros especialistas.

Además, brindamos soporte técnico para el equipo suministrado. Nuestros empleados son ingenieros altamente calificados, instaladores, especialistas en TI que le brindarán asistencia calificada en cualquier momento. Desde asesoramiento profesional hasta la modernización y desarrollo de equipos.

Nunca antes el problema del almacenamiento de archivos había sido tan grave como lo es hoy.

Apariencia discos duros con un volumen de 3 o incluso 4 TB, discos Blu-ray con una capacidad de 25 a 50 GB, almacenamiento en la nube - No resuelve el problema. A nuestro alrededor, hay cada vez más dispositivos que generan contenido pesado: fotos y cámaras de video, teléfonos inteligentes, HD-TV y video, consolas de juegos, etc. Generamos y consumimos (principalmente de Internet) cientos y miles de gigabytes.

Esto lleva al hecho de que la computadora del usuario promedio almacena una gran cantidad de archivos, cientos de gigabytes: un archivo fotográfico, una colección de películas, juegos, programas, documentos de trabajo favoritos, etc.

Todo esto no solo debe almacenarse, sino también protegerse de fallas y otras amenazas.

Pseudo-Soluciones

Puede equipar su computadora con capacidad disco duro. Pero en este caso surge la pregunta: ¿cómo y dónde archivar, digamos, datos de una unidad de 3 terabytes?

Puede colocar dos discos y utilizarlos en modo "espejo" RAID o simplemente realizar copias de seguridad de uno a otro. Esta tampoco es la mejor opción. Supongamos que una computadora es atacada por virus: lo más probable es que infecten datos en ambos discos.

Puede almacenar datos importantes en discos ópticos organizando un archivo de Blu-ray doméstico. Pero usarlo será extremadamente inconveniente.

Almacenamiento conectado a la red - ¡Solución! En parte ...

Almacenamiento conectado a la red (NAS): almacenamiento de archivos de red. Pero se puede explicar aún más fácilmente:

Suponga que tiene dos o tres computadoras en casa. Lo más probable es que estén conectados a la red local (por cable o inalámbrica) y a Internet. El almacenamiento en red es una computadora especializada que se integra en su red doméstica y se conecta a Internet.

Como resultado de esto, el NAS puede almacenar cualquiera de sus datos, y usted puede acceder a ellos desde cualquier PC o computadora portátil. Mirando hacia el futuro, debe decirse que la red local debe ser lo suficientemente moderna como para que pueda descargar rápida y fácilmente a través de ella decenas y cientos de gigabytes entre el servidor y las computadoras. Pero más sobre eso más tarde.

¿Dónde conseguir un NAS?

La primera forma: compra. Más o menos decente NAS 2 o 4 disco duro Se puede comprar por 500-800 dólares. Dicho servidor estará empaquetado en una pequeña caja y listo para funcionar, como dicen, "listo para usar".

La primera forma: compra. Más o menos decente NAS 2 o 4 disco duro Se puede comprar por 500-800 dólares. Dicho servidor estará empaquetado en una pequeña caja y listo para funcionar, como dicen, "listo para usar".

Sin embargo, ¡ADEMÁS, el costo de los discos duros se agrega a estos 500-800 dólares! Dado que NAS generalmente se vende sin ellos.

Pros: obtienes un dispositivo terminado y pasas un mínimo de tiempo.

Las desventajas de esta solución: NAS es como una computadora de escritorio, pero tiene capacidades incomparablemente menores. En realidad es solo una red unidad externa por mucho dinero Por mucho dinero obtienes un conjunto limitado y desventajoso de características.

Mi solución: autoensamblaje!

Esto es mucho más barato que comprar un NAS separado, aunque un poco más porque ensamblas el auto tú mismo). Sin embargo, te llenas servidor de casa, que, si se desea, se puede utilizar en todo el espectro de sus capacidades.

ATENCION!Desaconsejo crear un servidor doméstico usando computadora vieja o partes viejas y usadas. No olvide que el servidor de archivos es el repositorio de sus datos. No sea tacaño para hacerlo lo más confiable posible para que un día todos sus archivos no se "quemen" junto con los discos duros, por ejemplo, debido a una falla en el circuito de alimentación de la placa del sistema ...

Entonces, decidimos construir un servidor de archivos de inicio. Computadora discos duros que está disponible en la LAN de su hogar para su uso. En consecuencia, necesitamos una computadora de este tipo que sea económica en términos de consumo de energía, silenciosa, compacta, que no produzca mucho calor y que tenga un rendimiento suficiente.

La solución ideal sobre esta base es una placa base con un procesador incorporado y refrigeración pasiva, tamaño compacto.

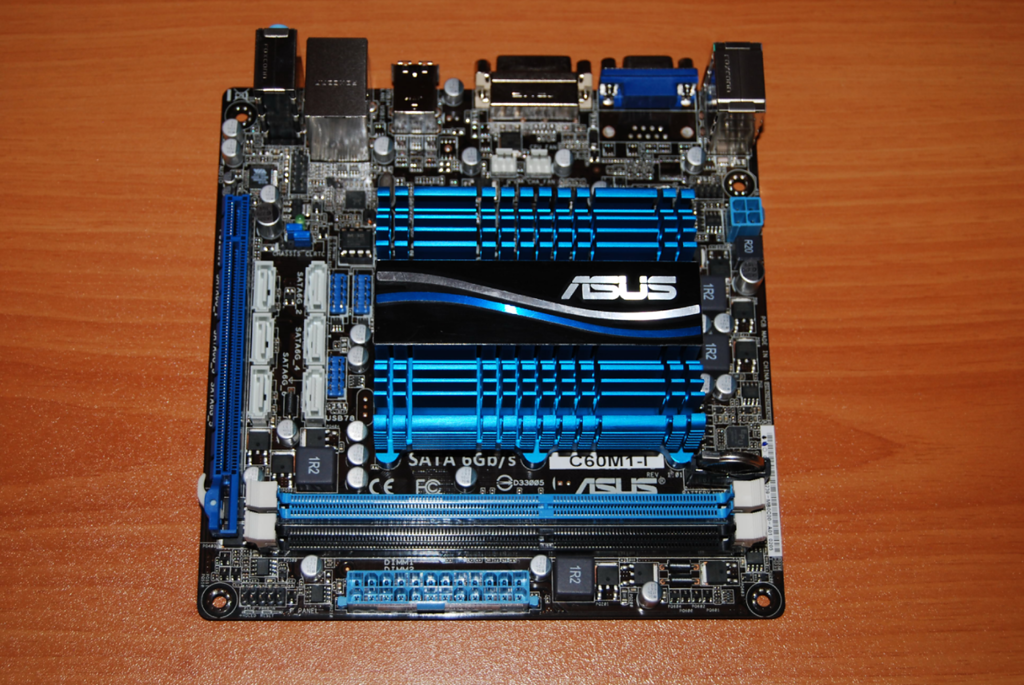

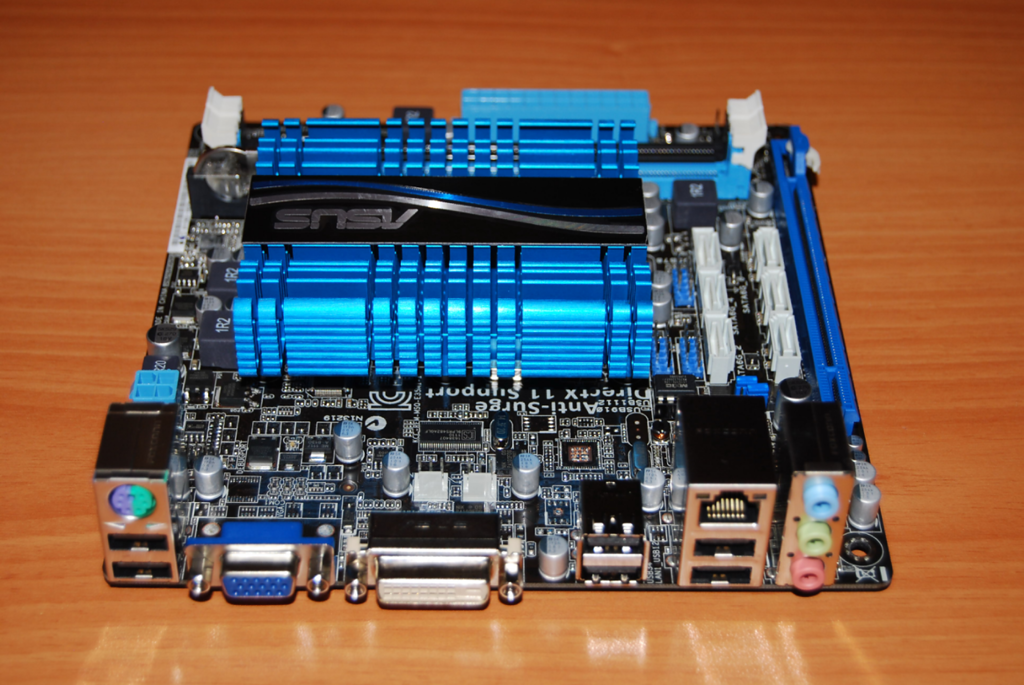

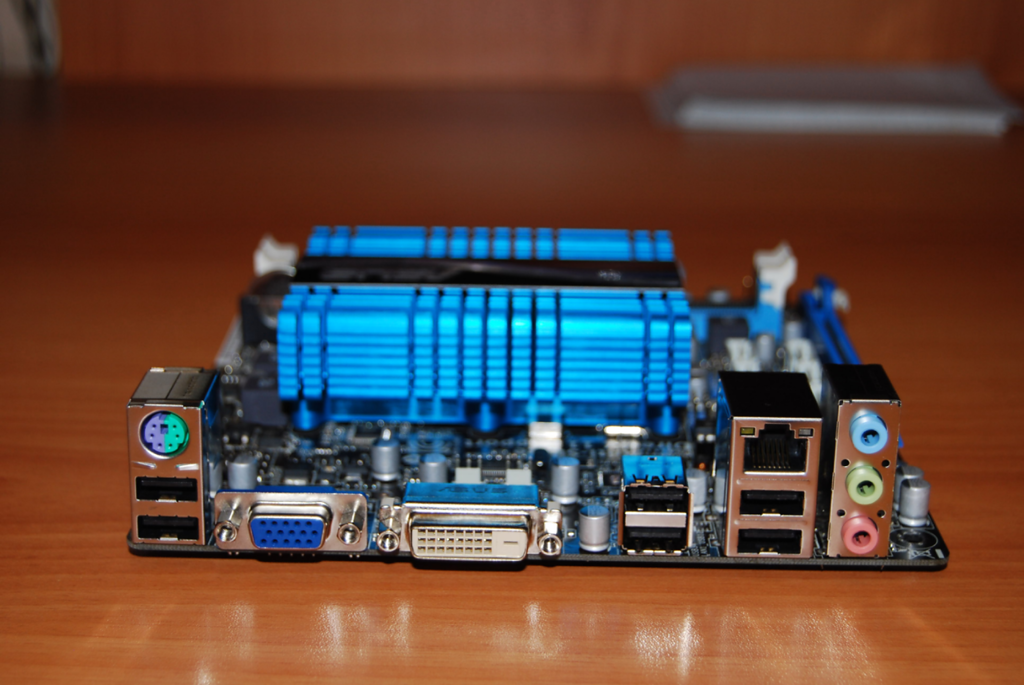

Elegí la placa base ASUS S-60M1-I . Fue comprado en la tienda en línea dostavka.ru:

El paquete incluye una guía de usuario de calidad, un disco de controlador, una pegatina en el estuche, 2 cables SATA y un panel posterior para el estuche:

ASUS, como siempre, ha equipado el tablero de manera muy generosa. Las especificaciones completas de la placa se pueden encontrar aquí: http://www.asus.com/Motherboard/C60M1I/#specifications. Solo hablaré sobre algunos puntos importantes.

A un costo de solo 3300 rublos - Proporciona el 80% de todo lo que necesitamos para el servidor.

Hay un procesador de doble núcleo a bordo AMD C-60 Con chip gráfico integrado. El procesador tiene una frecuencia 1 GHz(puede aumentar automáticamente a 1.3 GHz). Hoy está instalado en algunas netbooks e incluso laptops. Clase de procesador Intel Atom D2700. Pero todos saben que Atom tiene problemas con la computación paralela, lo que a menudo reduce su rendimiento a nada. Pero el C-60 carece de este inconveniente, y además está equipado con gráficos bastante potentes para esta clase.

Dos ranuras de memoria disponibles. DDR3-1066, con la capacidad de instalar hasta 8 GB de memoria.

La placa contiene 6 puertos. SATA 6 Gbps. Eso le permite conectar hasta 6 discos al sistema (!), Y no solo 4, como en un NAS normal para el hogar.

¿Qué es lo más importante? - el tablero se basa en UEFI, pero no el BIOS habitual. Esto significa que el sistema podrá funcionar normalmente con discos duros de más de 2.2 TB. Ella "verá" todo su volumen. Las placas base BIOS no pueden funcionar con discos duros de más de 2.2 GB sin "utilidades de muletas" especiales. Por supuesto, el uso de tales utilidades es inaceptable si hablamos de la confiabilidad del almacenamiento de datos y los servidores.

El S-60 es un procesador bastante frío, por lo que se enfría usando solo un radiador de aluminio. Esto es suficiente para que, incluso en el momento de la carga completa, la temperatura del procesador no aumente más de 50-55 grados. Cual es la norma

El conjunto de puertos es bastante estándar, solo la falta de un nuevo USB 3.0 trastorna. Y especialmente quiero responder a la presencia de un puerto de red gigabit completo:

En esta placa, instalé 2 módulos DDR3-1333 de 2 GB de Patriot:

Windows 7 Ultimate se instaló en disco duro WD 500GB Green, y para los datos compré un HDD Hitachi-Toshiba de 3 TB:

Todo este equipo está alimentado por una fuente de alimentación FSP de 400 W, que, por supuesto, es un margen.

El paso final fue ensamblar todo este equipo en un chasis mini-ATX.

Inmediatamente después del ensamblaje, instalé en computadora con Windows 7 Ultimate (la instalación tomó aproximadamente 2 horas, lo cual es normal, dada la baja velocidad del procesador).

Después de todo esto, desconecté el teclado, el mouse y el monitor de la computadora. De hecho, solo había una unidad del sistema conectada a la LAN mediante un cable.

Es suficiente recordar la IP local de esta PC en la red para conectarse desde cualquier máquina a través de la utilidad estándar de Windows "Conexión de escritorio remoto":

No instalé intencionalmente sistemas operativos especializados para organizar el almacenamiento de archivos, como FreeNAS. De hecho, en este caso, no tendría mucho sentido ensamblar una PC separada para estas necesidades. Uno podría comprar un NAS.

Pero un servidor doméstico separado, que se puede cargar con trabajo por la noche y dejarlo, es más interesante. Además, la interfaz familiar de Windows 7 es conveniente de administrar.

El costo total total de un servidor doméstico SIN discos duros fue de 6,000 rublos.

Adición importante

Cuando se utiliza cualquier almacenamiento de red, el ancho de banda de la red es muy importante. Además, incluso la red de cable habitual de 100 megabits no se entusiasma cuando, por ejemplo, realiza el archivado desde su computadora al servidor de su hogar. La transferencia de 100 GB a través de una red de 100 Mbps ya lleva varias horas.

Qué decir sobre el wifi. Bueno, si usa Wi-Fi 802.11n, en este caso, la velocidad de la red es de alrededor de 100 megabits. Y si el estándar es 802.11g, ¿dónde la velocidad rara vez es mayor a 30 megabits? Es muy, muy pequeño.

Ideal cuando el servidor interactúa a través de una red de cable Ethernet Gigabit. En este caso, es realmente rápido.

Pero hablaré sobre cómo crear una red de este tipo rápidamente y a un costo mínimo en un artículo separado.

¿Cómo clasificar la arquitectura de los sistemas de almacenamiento? Me parece que la relevancia de este problema solo crecerá en el futuro. ¿Cómo entender toda esta variedad de ofertas disponibles en el mercado? Quiero advertirte de inmediato que esta publicación no está destinada a los perezosos o aquellos que no quieren leer mucho.

Es posible clasificar los sistemas de almacenamiento con bastante éxito, de forma similar a cómo los biólogos construyen lazos familiares entre especies de organismos vivos. Si lo desea, puede llamarlo el "árbol de la vida" del mundo de las tecnologías de almacenamiento de información.

La construcción de tales árboles ayuda a comprender mejor el mundo. En particular, puede crear un diagrama del origen y desarrollo de cualquier tipo de sistema de almacenamiento, y comprender rápidamente lo que está en la base de cualquier nueva tecnología que aparezca en el mercado. Esto le permite determinar inmediatamente las fortalezas y debilidades de una solución.

Los repositorios que le permiten trabajar con información de cualquier tipo, arquitectónicamente, se pueden dividir en 4 grupos principales. Lo principal es no obsesionarse con algunas cosas que son confusas. Muchas personas tienden a clasificar las plataformas en función de criterios "físicos" como la interconexión ("¡Todos tienen un bus interno entre nodos!"), O un protocolo ("¡Esto es un bloque, o NAS, o sistema multiprotocolo!"), o dividido en hardware y software ("¡Esto es solo software en el servidor!").

Es enfoque completamente equivocado a la clasificación El único criterio verdadero es la arquitectura de software utilizada en una solución particular, ya que todas las características básicas del sistema dependen de ello. Los componentes restantes del sistema de almacenamiento dependen de la arquitectura de software elegida por los desarrolladores. Y desde este punto de vista, los sistemas de "hardware" y "software" solo pueden ser variaciones de esta o aquella arquitectura.

Pero no me malinterpreten, no quiero decir que la diferencia entre ellos es pequeña. Simplemente no es fundamental.

Y quiero aclarar algo más antes de ponerme manos a la obra. Es común que nuestra naturaleza haga las preguntas "¿Y cuál de estas es la mejor / correcta?". Solo hay una respuesta a esto: "Existen mejores soluciones para situaciones específicas o tipos de carga de trabajo, pero no existe una solución ideal universal". Exactamente las características de la carga dictan la elección de la arquitectura.Y nada más.

Por cierto, recientemente participé en una conversación divertida sobre el tema de los centros de datos que funcionan exclusivamente en unidades flash. Estoy impresionado con la pasión en cualquier manifestación, y está claro que el flash está más allá de la competencia en situaciones donde el rendimiento y la latencia juegan un papel decisivo (entre muchos otros factores). Pero debo admitir que mis interlocutores estaban equivocados. Tenemos un cliente, muchas personas usan sus servicios todos los días sin siquiera darse cuenta. ¿Puede cambiar a flash por completo? No

Este es un gran cliente. Y aquí hay otro, ENORME, 10 veces más. Y nuevamente, no puedo aceptar que este cliente pueda cambiar exclusivamente a flash:

Por lo general, como contraargumento, dicen que al final el flash alcanzará un nivel de desarrollo tal que eclipsará accionamientos magnéticos. Con la advertencia de que el flash se utilizará junto con la deduplicación. Pero no en todos los casos es recomendable aplicar la deduplicación, así como la compresión.

Bueno, por un lado, la memoria flash se volverá más barata, hasta cierto límite. Me pareció que esto sucedería un poco más rápido, pero los SSD con una capacidad de 1 TB por $ 550 ya están disponibles, este es un gran progreso. Por supuesto, los desarrolladores de discos duros tradicionales tampoco están inactivos. En la región 2017-2018, la competencia debería intensificarse, ya que se introducirán nuevas tecnologías (muy probablemente, cambio de fase y nanotubos de carbono). Pero el punto no es en absoluto la confrontación entre unidades flash y discos duros, o incluso soluciones de software y hardware, lo principal es arquitectura.

Es tan importante que es casi imposible cambiar la arquitectura de almacenamiento sin modificar casi todo. Eso es, de hecho, sin crear un nuevo sistema. Por lo tanto, los almacenamientos generalmente se crean, desarrollan y mueren dentro del marco de una única arquitectura inicialmente seleccionada.

Cuatro tipos de almacenamiento

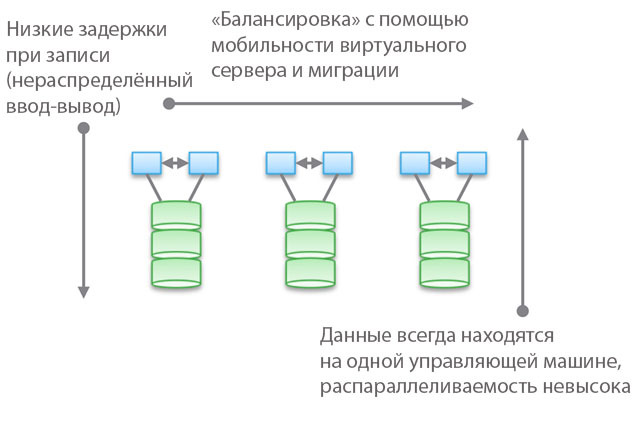

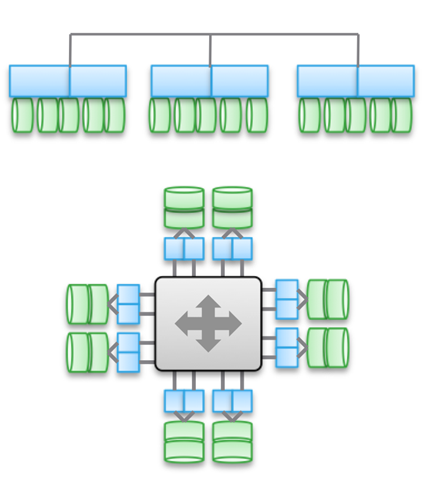

Tipo 1. Arquitectura agrupada. No están diseñados para compartiendo nodos de memoria, de hecho, todos los datos están en un nodo. Una de las características de la arquitectura es que a veces los dispositivos "se cruzan" (traspasan), incluso si son "accesibles desde varios nodos". Otra característica es que puede seleccionar una máquina, indicarle algunas unidades y decir "esta máquina tiene acceso a los datos en estos medios". El azul en la figura indica el sistema de CPU / memoria / entrada-salida, y el verde indica el medio en el que se almacenan los datos (unidades flash o magnéticas).

Este tipo de arquitectura se caracteriza por ser directa y muy acceso rápido a los datos. Habrá ligeros retrasos entre las máquinas porque se utiliza la duplicación y el almacenamiento en caché de E / S para garantizar una alta disponibilidad. Pero, en general, se proporciona un acceso relativamente directo a lo largo de la rama de código. Los almacenamientos de software son bastante simples y tienen una baja latencia, por lo que a menudo tienen una funcionalidad rica, los servicios de datos se agregan fácilmente. No es sorprendente que la mayoría de las startups comiencen con dichos repositorios.

Tenga en cuenta que una de las variedades de este tipo de arquitectura es el equipo PCIe para servidores que no son HA (tarjetas de expansión Fusion-IO, XtremeCache). Si le agregamos software de almacenamiento distribuido, coherencia y un modelo de alta disponibilidad, entonces dicho almacenamiento de software corresponderá a uno de los cuatro tipos de arquitecturas descritas en esta publicación.

El uso de "modelos federados" ayuda a mejorar la escalabilidad horizontal de este tipo de arquitectura desde el punto de vista de la administración. Estos modelos pueden usar diferentes enfoques para aumentar la movilidad de datos para reequilibrar entre las máquinas host y el almacenamiento. Por ejemplo, dentro de VNX, esto significa "movilidad VDM". Pero creo que llamarlo "arquitectura escalable horizontalmente" será una exageración. Y, en mi experiencia, la mayoría de los clientes comparten esta opinión. La razón de esto es la ubicación de los datos en una máquina de control, a veces, "en un gabinete de hardware" (detrás de un gabinete). Se pueden mover, pero siempre estarán en un solo lugar. Por un lado, esto le permite reducir el número de ciclos y el retraso de grabación. Por otro lado, todos sus datos son servidos por una sola máquina de control (es posible el acceso indirecto desde otra máquina). A diferencia del segundo y tercer tipo de arquitecturas, que discutiremos a continuación, el equilibrio y el ajuste juegan un papel importante aquí.

Hablando objetivamente, este nivel federal abstracto implica un ligero aumento en la latencia porque utiliza la redirección de software. Esto es similar a complicar el código y aumentar la latencia en los tipos de arquitecturas 2 y 3, y en parte elimina las ventajas del primer tipo. Como ejemplo concreto, UCS Invicta, una especie de "enrutadores de almacenamiento de silicio". En el caso de NetApp FAS 8.x, que funciona en modo de clúster, el código es bastante complicado por la introducción de un modelo federado.

Productos que utilizan arquitecturas de clúster: VNX o NetApp FAS, Pure, Tintri, Nimble, Nexenta y (creo) UCS Invicta / UCS. Algunas son soluciones de "hardware", otras son "puramente software" y otras son "software en forma de complejos de hardware". Todos ellos son MUY diferentes en términos de procesamiento de datos (en Pure y UCS Invicta / Whiptail, solo se utilizan unidades flash). Pero arquitectónicamente, todos los productos enumerados están relacionados. Por ejemplo, configura servicios de datos exclusivamente para copia de seguridad, la pila de software se convierte en Data Domain, su NAS funciona como la mejor herramienta de copia de seguridad del mundo, y esta también es la arquitectura de "primer tipo".

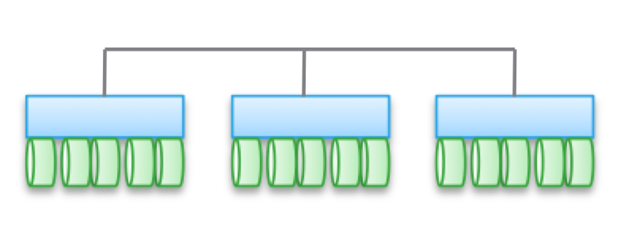

Tipo 2. Arquitecturas débilmente interconectadas, escaladas horizontalmente. Los nodos no comparten memoria, pero los datos en sí son para varios nodos. Esta arquitectura implica el uso de mas conexiones internas para registrar datos, lo que aumenta el número de ciclos. Aunque las operaciones de escritura están distribuidas, siempre son coherentes.

Tenga en cuenta que estas arquitecturas no proporcionan alta disponibilidad para el nodo debido a las operaciones de copia y distribución de datos. Por la misma razón, siempre hay más operaciones de E / S en comparación con arquitecturas de clúster simples. Por lo tanto, el rendimiento es ligeramente inferior, a pesar del pequeño nivel de retraso de grabación (NVRAM, SSD, etc.).

En algunas variedades de arquitecturas, los nodos a menudo se ensamblan en subgrupos, mientras que el resto se usa para administrar subgrupos (nodos de metadatos). Pero los efectos descritos anteriormente para los "modelos federados" se manifiestan aquí.

Tales arquitecturas son bastante fáciles de escalar. Dado que los datos se almacenan en varios lugares y pueden ser procesados \u200b\u200bpor múltiples nodos, estas arquitecturas pueden ser excelentes para tareas cuando se requiere lectura distribuida. Además, combinan bien con el software de servidor / almacenamiento. Pero es mejor usar arquitecturas similares bajo cargas transaccionales: debido a su naturaleza distribuida, no puede usar un servidor HA, y la conjugación débil le permite evitar Ethernet.

Este tipo de arquitectura se utiliza en productos como EMC ScaleIO e Isilon, VSAN, Nutanix y Simplivity. Como en el caso del Tipo 1, todas estas soluciones son completamente diferentes entre sí.

La conectividad débil significa que a menudo estas arquitecturas pueden aumentar significativamente el número de nodos. Pero, permítame recordarle que NO usan la memoria juntos, el código de cada nodo funciona independientemente de los demás. Pero el diablo, como dicen, en detalle:

- Cuantas más operaciones de grabación se distribuyan, mayor será la latencia y menor la eficiencia de la PIO. Por ejemplo, en Isilon, el nivel de distribución es muy alto para los archivos, y aunque con cada actualización se reducen los retrasos, aún así nunca demostrará el rendimiento más alto. Pero Isilon es extremadamente fuerte en términos de paralelización.

- Si reduce el grado de distribución (aunque con un gran número de nodos), los retrasos pueden disminuir, pero al mismo tiempo reducirá su capacidad de paralelizar la lectura de datos. Por ejemplo, VSAN utiliza el modelo de "máquina virtual como un objeto", que le permite ejecutar múltiples copias. Parece que una máquina virtual debería ser accesible para un host específico. Pero, de hecho, en VSAN "se desplaza" hacia el nodo que almacena sus datos. Si utiliza esta solución, puede ver por sí mismo cómo el aumento del número de copias de un objeto afecta la latencia y las operaciones de E / S en todo el sistema. Sugerencia: más copias \u003d mayor carga en el sistema en su conjunto, y la dependencia no es lineal, como es de esperar. Pero para VSAN, esto no es un problema debido a las ventajas de la máquina virtual como modelo de objetos.

- Es posible lograr una baja latencia en condiciones de gran escalamiento y paralelización durante la lectura, pero solo si los datos y la escritura están separados con precisión. un gran número copias Este enfoque se usa en ScaleIO. Cada volumen se divide en una gran cantidad de fragmentos (1 MB por defecto), que se distribuyen en todos los nodos involucrados. El resultado es una velocidad extremadamente alta de lectura y redistribución junto con una poderosa paralelización. El retraso de escritura puede ser inferior a 1 ms cuando se utiliza la infraestructura de red adecuada y SSD / PCIe Flash en los nodos del clúster. Sin embargo, cada operación de escritura se realiza en dos nodos. Por supuesto, a diferencia de VSAN, una máquina virtual no se considera un objeto aquí. Pero si se considera, la escalabilidad sería peor.

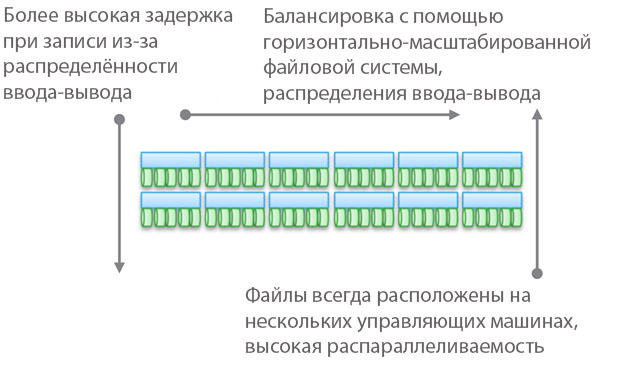

Tipo 3. Arquitecturas fuertemente interconectadas, escaladas horizontalmente. Utiliza el uso compartido de memoria (para el almacenamiento en caché y algunos tipos de metadatos). Los datos se distribuyen en varios nodos. Este tipo de arquitectura implica el uso de una gran cantidad de conexiones de entrenudos para todo tipo de operaciones.

Compartir memoria es la piedra angular de estas arquitecturas. Históricamente, a través de todas las máquinas de control se pueden llevar a cabo operaciones de E / S simétricas (ver ilustración). Esto le permite reequilibrar la carga en caso de mal funcionamiento. Esta idea se estableció en la base de productos como Symmetrix, IBM DS, HDS USP y VSP. Proporcionan acceso compartido a la memoria caché, por lo que el procedimiento de E / S se puede controlar desde cualquier máquina.

El diagrama superior de la ilustración refleja la arquitectura EMC XtremIO. A primera vista, es similar al Tipo 2, pero no lo es. En este caso, el modelo de metadatos distribuidos compartidos implica el uso de IB y acceso directo a memoria remota para que todos los nodos tengan acceso a los metadatos. Además, cada nodo es un par HA. Como puede ver, Isilon y XtremIO son muy diferentes arquitectónicamente, aunque esto no es tan obvio. Sí, ambos tienen arquitecturas a escala horizontal, y ambos usan IB para la interconexión. Pero en Isilon, a diferencia de XtremIO, esto se hace para minimizar la latencia al intercambiar datos entre nodos. También es posible usar Ethernet en Isilon para la comunicación entre nodos (de hecho, así es como funciona una máquina virtual en él), pero esto aumenta los retrasos en las operaciones de entrada-salida. En cuanto a XtremIO, el acceso remoto directo a la memoria es de gran importancia para su rendimiento.

Por cierto, no se deje engañar por la presencia de dos diagramas en la ilustración; de hecho, son los mismos arquitectónicamente. En ambos casos, se utilizan pares de controladores HA, memoria compartida e interconexiones de muy baja latencia. Por cierto, VMAX usa un bus entre componentes patentado, pero en el futuro será posible usar IB.

Las arquitecturas altamente acopladas se caracterizan por la alta complejidad del código del programa. Esta es una de las razones de su baja prevalencia. La complejidad excesiva del software también afecta la cantidad de servicios de procesamiento de datos que se agregan, ya que esta es una tarea informática más difícil.

Las ventajas de este tipo de arquitectura incluyen tolerancia a fallas (E / S simétricas en todas las máquinas de control), así como, en el caso de XtremIO, grandes oportunidades en el campo de AFA. Una vez que volvamos a hablar de XtremIO, vale la pena mencionar que su arquitectura implica la distribución de todos los servicios de procesamiento de datos. También es la única solución AFA en el mercado con una arquitectura a escala horizontal, aunque todavía no se han implementado nodos dinámicos de adición / desactivación. Entre otras cosas, XtremIO utiliza la deduplicación "natural", es decir, está constantemente activa y "libre" en términos de rendimiento. Es cierto que todo esto aumenta la complejidad del mantenimiento del sistema.

Es importante comprender la diferencia fundamental entre el Tipo 2 y el Tipo 3. Cuanto más interconectada esté la arquitectura, mejor y más predecible será garantizar una baja latencia. Por otro lado, dentro del marco de dicha arquitectura, es más difícil agregar nodos y escalar el sistema. Después de todo, cuando usa el acceso compartido a la memoria, es un sistema distribuido único y altamente conjugado. La complejidad de las decisiones está creciendo y, con ello, la probabilidad de errores. Por lo tanto, VMAX puede tener hasta 16 autos de control en 8 motores, y XtemIO - hasta 8 autos en 4 X-Brick (pronto aumentará a 16 autos en 8 bloques). Cuadruplicar o incluso duplicar estas arquitecturas es un desafío de ingeniería increíblemente difícil. A modo de comparación, VSAN se puede escalar a "tamaño de clúster vSphere" (ahora 32 nodos), Isilon puede contener más de 100 nodos y ScaleIO le permite crear un sistema de más de 1000 nodos. Además, todo esto es una arquitectura del segundo tipo.

Nuevamente, quiero enfatizar que la arquitectura es independiente de la implementación. Los productos anteriores usan Ethernet e IB. Algunas son soluciones puramente de software, otras son complejos de hardware y software, pero al mismo tiempo están unidos por esquemas arquitectónicos.

A pesar de la variedad de interconexiones, el uso de grabación distribuida juega un papel importante en todos los ejemplos dados. Esto le permite lograr la transaccionalidad y la atomicidad, pero es necesario un monitoreo cuidadoso de la integridad de los datos. También es necesario resolver el problema del crecimiento del "área de falla". Estos dos puntos limitan el máximo grado posible de escala de los tipos de arquitecturas descritos.

Una pequeña comprobación de cuán cuidadosamente lees todo lo anterior: ¿A qué tipo de Cisco UCS Invicta - 1 o 3 pertenece? Físicamente, parece Tipo 3, pero este es un conjunto de servidores USC de la serie C conectados a través de Ethernet, que ejecutan la pila de software Invicta (anteriormente Whiptail). Sugerencia: mire la arquitectura, no la implementación específica 🙂

En el caso de UCS Invicta, los datos se almacenan en cada nodo (servidor UCS con unidades flash basadas en MLC). Un único nodo que no sea HA, que es un servidor separado, puede transmitir directamente un número de unidad lógica (LUN). Si decide agregar más nodos, es posible que el sistema escale mal, como ScaleIO o VSAN. Todo esto nos lleva al Tipo 2.

Sin embargo, el aumento en el número de nodos, aparentemente, se realiza a través de la configuración y la migración al "Invicta Scaling Appliance". Con esta configuración, tiene varios "Enrutadores de almacenamiento de silicio" (SSR) y un almacenamiento de direcciones de varios nodos de hardware. Se accede a los datos a través de un único nodo SSR, pero esto se puede hacer a través de otro nodo que funciona como un par HA. Los datos en sí siempre están en el único nodo UCS en la serie C. Entonces, ¿qué tipo de arquitectura es esta? No importa cómo se vea físicamente la solución, es Tipo 1. El SSR es un clúster (quizás más de 2). En la configuración de Scaling Appliance, cada servidor UCS con unidades MLC realiza una función similar a VNX o NetApp FAS: almacenamiento en disco. Aunque no está conectado a través de SAS, la arquitectura es similar.

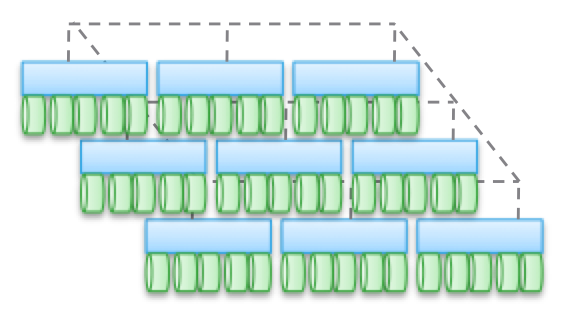

Tipo 4. Arquitecturas distribuidas sin compartir recursos. A pesar de que los datos se distribuyen a través de diferentes nodos, esto se hace sin ninguna transaccionalidad. Por lo general, los datos se almacenan en un nodo y viven allí, y de vez en cuando se hacen copias en otros nodos, en aras de la seguridad. Pero estas copias no son transaccionales. Esta es la diferencia clave entre este tipo de arquitectura y los tipos 2 y 3.

La comunicación entre nodos que no son HA es a través de Ethernet, ya que es barata y universal. La distribución por nodos es obligatoria y de vez en cuando. La "exactitud" de los datos no siempre se respeta, pero la pila de software se verifica con bastante frecuencia para garantizar la exactitud de los datos utilizados. Para algunos tipos de carga (por ejemplo, HDFS), los datos se distribuyen para que estén en la memoria al mismo tiempo que el proceso para el que se requieren. Esta propiedad nos permite considerar este tipo de arquitectura como la más escalable entre las cuatro.

Pero esto está lejos de ser la única ventaja. Dichas arquitecturas son extremadamente simples; son muy fáciles de administrar. De ninguna manera dependen del equipo y pueden implementarse en el hardware más barato. Estas son casi siempre soluciones de software exclusivamente. Este tipo de arquitectura es tan fácil de manejar con petabytes de datos como terabytes con otros datos. Aquí se utilizan objetos y sistemas de archivos que no son POSIX, y ambos a menudo se encuentran en la parte superior del sistema de archivos local de cada nodo ordinario.

Estas arquitecturas se pueden combinar con bloques y modelos transaccionales de presentación de datos basados \u200b\u200ben NAS, pero esto limita en gran medida sus capacidades. No es necesario crear una pila transaccional colocando el Tipo 1, 2 o 3 encima del Tipo 4.

Lo mejor de todo, estas arquitecturas se "revelan" en aquellas tareas para las cuales algunas restricciones no son peculiares.

Arriba, di un ejemplo con un cliente muy grande con 200,000 unidades. Servicios como Dropbox, Syncplicity, iCloud, Facebook, eBay, YouTube y casi todos los proyectos Web 2.0 se basan en repositorios creados con el cuarto tipo de arquitectura. Toda la información procesada en los clústeres de Hadoop también se encuentra en las instalaciones de almacenamiento de Tipo 4. En general, en el segmento corporativo, estas no son arquitecturas muy comunes, pero rápidamente ganan popularidad.

El Tipo 4 subyace a productos como AWS S3 (por cierto, nadie fuera de AWS sabe cómo funciona EBS, pero estoy dispuesto a argumentar que es Tipo 3), Haystack (usado en Facebook), Atmos, ViPR, Ceph, Swift ( utilizado en Openstack), HDFS, Centera. Muchos de los productos enumerados pueden tomar una forma diferente, el tipo de implementación específica se determina utilizando su API. Por ejemplo, la pila de objetos ViPR se puede implementar a través de las API de objetos S3, Swift, Atmos e incluso HDFS. Y en el futuro, Centera también estará en esta lista. Para algunos, esto será obvio, pero Atmos y Centera se utilizarán durante mucho tiempo, sin embargo, en forma de API y no de productos específicos. Las implementaciones pueden cambiar, pero las API siguen siendo inquebrantables, lo cual es muy bueno para los clientes.

Quiero llamar su atención una vez más sobre el hecho de que la "encarnación física" puede confundirlo, y clasificará erróneamente las arquitecturas Tipo 4 como Tipo 2, ya que a menudo se ven iguales. A nivel físico, una solución puede parecerse a ScaleIO, VSAN o Nutanix, aunque estos serán solo servidores Ethernet. Y la presencia o ausencia de transaccionalidad ayudará a clasificar una solución particular correctamente.

Y ahora te ofrezco una segunda prueba de verificación. Echemos un vistazo a la arquitectura UCS Invicta. Físicamente, este producto se parece al Tipo 4 (servidores conectados a través de Ethernet), pero no se puede escalar arquitectónicamente a las cargas apropiadas, ya que en realidad es el Tipo 1. Además, Invicta, como Pure, se desarrolló para AFA.

Acepte mi sincera gratitud por su tiempo y atención si ha leído hasta este lugar. Vuelvo a leer lo anterior: es sorprendente que logré casarme y tener hijos 🙂

¿Por qué escribí todo esto?

En el mundo del almacenamiento de TI, ocupan un lugar muy importante, una especie de "reino de los hongos". La variedad de productos que se ofrecen es muy grande, y esto solo beneficia a todo el negocio. Pero debe ser capaz de comprender todo esto, no se permita nublar su mente con lemas de marketing y matices de posicionamiento. Para el beneficio de los clientes y de la industria misma, es necesario simplificar el proceso de creación de almacenamiento. Por lo tanto, estamos trabajando duro para hacer que el controlador ViPR sea una plataforma abierta y gratuita.

Pero el repositorio en sí mismo no es emocionante. A que me refiero Imagine una especie de pirámide abstracta, sobre la cual hay un "usuario". A continuación se encuentran las "aplicaciones" diseñadas para servir al "usuario". Aún más baja es la "infraestructura" (incluyendo SDDC) que sirve a las "aplicaciones" y, en consecuencia, al "usuario". Y en el fondo de la "infraestructura" se encuentra el repositorio.

Es decir, puede imaginar la jerarquía de esta forma: Usuario-\u003e Aplicación / SaaS-\u003e PaaS-\u003e IaaS-\u003e Infraestructura. Entonces: al final, cualquier aplicación, cualquier pila de PaaS debe calcular o procesar algún tipo de información. Y estos cuatro tipos de arquitecturas están diseñados para trabajar con diferentes tipos de información, diferentes tipos de carga. En la jerarquía de importancia, la información sigue inmediatamente al usuario. El propósito de la existencia de la aplicación es permitir al usuario interactuar con la información que necesita. Es por eso que la arquitectura de almacenamiento es tan importante en nuestro mundo.

Esta entrada fue publicada en Uncategorized por el autor. Marcarlo como favoritoSAS, NAS, SAN: un paso hacia las redes de almacenamiento

Entrada

Con la complicación cotidiana de los sistemas informáticos de red y las soluciones corporativas globales, el mundo comenzó a exigir tecnologías que impulsen la reactivación de los sistemas corporativos de almacenamiento de información (sistemas de almacenamiento). Y ahora, una tecnología unificada brinda un rendimiento sin precedentes, una escalabilidad tremenda y ventajas excepcionales del costo total de propiedad al tesoro mundial de logros en el campo de las ventas. Las circunstancias que han surgido con el advenimiento del estándar FC-AL (Fibre Channel - Arbitrated Loop) y el SAN (Storage Area Network), que se desarrolla sobre esta base, prometen una revolución en las tecnologías informáticas orientadas a los datos.

"El desarrollo más significativo en almacenamiento que hemos visto en 15 años"

Data Communications International, 21 de marzo de 1998

La definición formal de SAN en la interpretación de la Storage Network Industry Association (SNIA):

“Una red cuya tarea principal es transferir datos entre sistemas informáticos y dispositivos de almacenamiento de datos, así como entre los propios sistemas de almacenamiento. La SAN consta de una infraestructura de comunicaciones que proporciona conectividad física, y también es responsable de la capa de administración, que integra las comunicaciones, el almacenamiento y los sistemas informáticos, transmitiendo datos de manera segura ".

Diccionario técnico de SNIA, Asociación de la industria de redes de almacenamiento con derechos de autor, 2000

Opciones para organizar el acceso a los sistemas de almacenamiento.

Hay tres opciones principales para organizar el acceso a los sistemas de almacenamiento:

- SAS (Server Attached Storage), almacenamiento conectado al servidor;

- NAS (almacenamiento conectado a la red), almacenamiento conectado a la red;

- SAN (Storage Area Network), una red de área de almacenamiento.

Consideremos las topologías de los sistemas de almacenamiento correspondientes y sus características.

SAS

Sistema de almacenamiento conectado al servidor. Familiar para todos, la forma tradicional de conectar el sistema de almacenamiento a una interfaz de alta velocidad en el servidor, generalmente a una interfaz SCSI paralela.

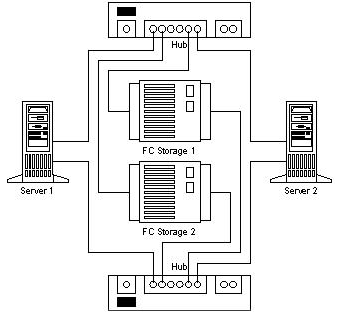

Figura 1. Almacenamiento conectado al servidor

El uso de un gabinete separado para el sistema de almacenamiento dentro de la topología SAS es opcional.

La principal ventaja del almacenamiento conectado al servidor en comparación con otras opciones es el bajo precio y la alta velocidad del cálculo de un almacenamiento para un servidor. Dicha topología es más óptima cuando se utiliza un único servidor a través del cual se organiza el acceso a la matriz de datos. Pero todavía tiene varios problemas que llevaron a los diseñadores a buscar otras opciones para organizar el acceso a los sistemas de almacenamiento.

Las características de SAS incluyen:

- El acceso a los datos depende del sistema operativo y del sistema de archivos (en general);

- La complejidad de organizar sistemas con alta disponibilidad;

- Bajo costo;

- Alto rendimiento en un solo nodo;

- Reducir la velocidad de respuesta al cargar el servidor que sirve el almacenamiento.

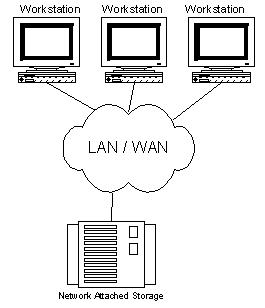

NAS

Sistema de almacenamiento conectado a la red. Esta opción para organizar el acceso ha aparecido relativamente recientemente. Su principal ventaja es la facilidad de integración. sistema adicional almacenamiento de datos en redes existentes, pero en sí mismo no aporta mejoras radicales a la arquitectura del almacenamiento. De hecho, el NAS es un servidor de archivos limpio, y hoy puede ver muchas implementaciones nuevas de NAS de tipo de almacenamiento basadas en la tecnología de servidor delgado (Thin Server).

Figura 2. Almacenamiento conectado a la red.

Características del NAS:

- Servidor de archivos dedicado;

- El acceso a los datos no depende del sistema operativo y la plataforma;

- Conveniencia de administración;

- Máxima facilidad de instalación;

- Baja escalabilidad;

- Conflicto con el tráfico LAN / WAN.

El almacenamiento, basado en la tecnología NAS, es ideal para servidores de bajo costo con un conjunto mínimo de características.

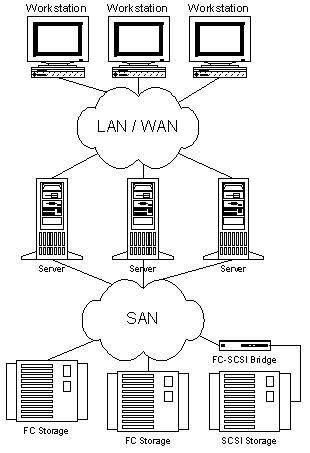

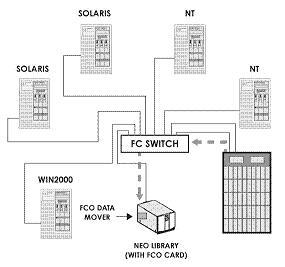

San

Las redes de almacenamiento comenzaron a desarrollarse intensamente y se introdujeron solo en 1999. La base de la SAN es una red separada de la LAN / WAN, que sirve para organizar el acceso a los datos de servidores y estaciones de trabajo que participan en su procesamiento directo. Dicha red se crea sobre la base del estándar Fibre Channel, que brinda a los sistemas de almacenamiento las ventajas de las tecnologías LAN / WAN y la capacidad de organizar plataformas estándar para sistemas con alta disponibilidad y alta intensidad de consulta. Casi el único inconveniente de SAN hoy en día es el costo relativamente alto de los componentes, pero el costo total de propiedad de los sistemas empresariales creados con tecnología de red de área de almacenamiento es bastante bajo.

Figura 3. Red de área de almacenamiento.

Las principales ventajas de SAN incluyen casi todas sus características:

- Independencia de la topología SAN de los sistemas y servidores de almacenamiento;

- Conveniente gestión centralizada;

- No hay conflicto con el tráfico LAN / WAN;

- Respaldo de datos conveniente sin cargar la red local y los servidores;

- Alta velocidad;

- Alta escalabilidad

- Alta flexibilidad;

- Alta disponibilidad y tolerancia a fallos.

También debe tenerse en cuenta que esta tecnología aún es bastante joven y que en un futuro próximo debería sufrir muchas mejoras en el campo de la estandarización de la gestión y los métodos de interacción de las subredes SAN. Pero podemos esperar que esto amenace a los pioneros solo con perspectivas adicionales para el campeonato.

FC como base para construir una SAN

Al igual que una LAN, se puede crear una SAN utilizando varias topologías y operadores. Al construir una SAN, puede usar una interfaz SCSI paralela o un Fibre Channel o, por ejemplo, SCI (Interfaz coherente escalable), pero Fibre Channel debe su creciente popularidad a la SAN. Los especialistas con experiencia significativa en el desarrollo de interfaces de canal y de red participaron en el diseño de esta interfaz, y lograron combinar todas las características positivas importantes de ambas tecnologías para obtener algo verdaderamente revolucionario. Que exactamente

El principal características clave canal:

- Baja latencia

- Altas velocidades

- Alta fiabilidad

- Topología punto a punto

- Distancias cortas entre nodos

- Adicción a la plataforma

- Topologías multipunto

- Largas distancias

- Alta escalabilidad

- Bajas velocidades

- Grandes retrasos

- Altas velocidades

- Independencia de protocolo (niveles 0-3)

- Largas distancias

- Baja latencia

- Alta fiabilidad

- Alta escalabilidad

- Topologías multipunto

Tradicionalmente, las interfaces de almacenamiento (lo que hay entre el host y los dispositivos de almacenamiento) han sido un obstáculo para el crecimiento de la velocidad y el aumento del volumen de los sistemas de almacenamiento. Al mismo tiempo, las tareas aplicadas requieren un aumento significativo en las capacidades de hardware, lo que, a su vez, elimina la necesidad de aumentar el rendimiento de las interfaces para la comunicación con los sistemas de almacenamiento. Son los problemas de construir un acceso flexible a datos de alta velocidad lo que Fibre Channel ayuda a resolver.

El estándar de Fibre Channel se definió finalmente en los últimos años (de 1997 a 1999), durante el cual se realizó un gran trabajo para coordinar la interacción de los fabricantes de varios componentes, y se hizo todo lo posible para garantizar que Fibre Channel se convirtiera de una tecnología puramente conceptual en real, que recibió apoyo en forma de instalaciones en laboratorios y centros informáticos. En el año 1997, se diseñaron los primeros diseños comerciales de los componentes básicos para construir SAN basadas en FC, como adaptadores, concentradores, interruptores y puentes. Por lo tanto, desde 1998, FC se ha utilizado con fines comerciales en el sector empresarial, en la producción y en proyectos a gran escala para la implementación de sistemas de fallas críticas.

Fibre Channel es un estándar abierto de la industria para la interfaz serial de alta velocidad. Proporciona conexión de servidores y sistemas de almacenamiento a una distancia de hasta 10 km (utilizando equipo estándar) a una velocidad de 100 MB / s (Cebit "2000 presentó muestras de productos que utilizan el nuevo estándar Fibre Channel con velocidades de 200 MB / s por uno un anillo, y en el laboratorio, implementaciones del nuevo estándar con velocidades de 400 MB / s, que es de 800 MB / s cuando se usa un anillo doble, ya están en uso). .) Canal de fibra simultáneamente o admite varios protocolos estándar (incluidos TCP / IP y SCSI-3) cuando se usa uno medios físicos, lo que potencialmente simplifica la construcción de infraestructura de red, además, brinda oportunidades para reducir el costo de instalación y mantenimiento. Sin embargo, el uso de subredes separadas para LAN / WAN y SAN tiene varias ventajas y se recomienda de manera predeterminada.

Una de las ventajas más importantes de Fibre Channel junto con los parámetros de alta velocidad (que, por cierto, no siempre son importantes para los usuarios de SAN y se pueden implementar utilizando otras tecnologías) es la capacidad de trabajar a largas distancias y la flexibilidad de la topología, que ha llegado a un nuevo estándar de las tecnologías de red. Por lo tanto, el concepto de construir una topología de red de almacenamiento se basa en los mismos principios que las redes tradicionales, generalmente basadas en concentradores y conmutadores, que ayudan a evitar una caída de velocidad con un aumento en el número de nodos y crean oportunidades para una organización conveniente de sistemas sin un solo punto de falla.

Para una mejor comprensión de las ventajas y características de esta interfaz, ofrecemos característica comparativa FC y Parallel SCSI como tabla.

Tabla 1. Comparación de canal de fibra y tecnologías paralelas SCSI

El estándar Fibre Channel supone el uso de una variedad de topologías, como punto a punto, anillo o concentrador FC-AL (bucle o concentrador FC-AL), conmutador troncal (Fabric / Switch).

La topología punto a punto se utiliza para conectar un único sistema de almacenamiento al servidor.

Loop o Hub FC-AL: para conectar varios dispositivos de almacenamiento a varios hosts. Con la organización de un anillo doble, aumenta la velocidad y la tolerancia a fallas del sistema.

Los interruptores se utilizan para proporcionar el máximo rendimiento y tolerancia a fallas para sistemas complejos, grandes y ramificados.

Gracias a la flexibilidad de la red, SAN tiene una característica extremadamente importante: una capacidad conveniente para construir sistemas tolerantes a fallas.

Al ofrecer soluciones de almacenamiento alternativas y la capacidad de combinar múltiples almacenamientos de redundancia de almacenamiento, SAN ayuda a proteger los sistemas de hardware y software de fallas de hardware. Para demostrarlo, damos un ejemplo de cómo crear un sistema de dos sistemas sin puntos de falla.

Figura 4. Sin punto único de falla.

Se crean tres o más sistemas de nodos simplemente agregando servidores adicionales a la red FC y conectándolos a ambos concentradores / conmutadores).

Con FC, la construcción de sistemas tolerantes a desastres se vuelve transparente. Los canales de red tanto para el almacenamiento como para la red local pueden establecerse sobre la base de fibra óptica (hasta 10 km o más utilizando amplificadores de señal) como medio físico para FC, utilizando equipos estándar que permiten reducir significativamente el costo de dichos sistemas.

Con la capacidad de acceder a todos los componentes SAN desde cualquier lugar, obtenemos una red de datos extremadamente flexible. Cabe señalar que la SAN proporciona transparencia (la capacidad de ver) todos los componentes hasta los discos en los sistemas de almacenamiento. Esta característica alentó a los fabricantes de componentes a usar su experiencia significativa en la construcción de sistemas de administración para LAN / WAN para establecer amplias capacidades de monitoreo y administración en todos los componentes SAN. Estas características incluyen monitoreo y administración de nodos individuales, almacenamientos de componentes, gabinetes, dispositivos de red y subestructuras de red.

El sistema de gestión y monitoreo de SAN utiliza estándares abiertos como:

- Conjunto de comandos SCSI

- Servicios de gabinete SCSI (SES)

- Análisis de autocontrol SCSI y tecnología de informes (S.M.A.R.T.)

- SAF-TE (Gabinetes con tolerancia a fallas con acceso SCSI)

- Protocolo simple de administración de red (SNMP)

- Gestión empresarial basada en web (WBEM)

Los sistemas creados con tecnologías SAN no solo brindan al administrador la capacidad de monitorear el desarrollo y el estado de los recursos, sino que también brindan oportunidades para monitorear y controlar el tráfico. Gracias a dichos recursos, el software de administración SAN implementa los esquemas más efectivos para planificar el volumen de ventas y equilibrar la carga en los componentes del sistema.

Las redes de almacenamiento se integran perfectamente con las infraestructuras de información existentes. Su implementación no requiere ningún cambio en las redes LAN y WAN existentes, sino que solo expande las capacidades de los sistemas existentes, salvándolos de las tareas destinadas a transferir grandes cantidades de datos. Además, al integrar y administrar la SAN, es muy importante que los elementos clave de la red admitan el intercambio en caliente y la instalación, con capacidades configuración dinámica. Por lo tanto, el administrador puede agregar uno u otro componente o reemplazarlo sin apagar el sistema. Y todo este proceso de integración puede mostrarse visualmente en un sistema gráfico de gestión SAN.

Una vez consideradas las ventajas anteriores, podemos destacar una serie de puntos clave que afectan directamente a una de las principales ventajas de la red de área de almacenamiento: el costo total de propiedad (costo total de propiedad).

La escalabilidad increíble permite a una empresa que utiliza SAN invertir en servidores y almacenamiento según sea necesario. Y también para ahorrar sus inversiones en equipos ya instalados al cambiar las generaciones tecnológicas. Cada nuevo servidor Tendrá la capacidad de proporcionar acceso de alta velocidad a los almacenamientos y cada gigabyte adicional de almacenamientos estará disponible para todos los servidores de subred por el comando del administrador.

Las excelentes capacidades de creación de resiliencia pueden traer beneficios comerciales directos al minimizar el tiempo de inactividad y salvar el sistema en caso de un desastre natural o algún otro desastre.

La capacidad de control de los componentes y la transparencia del sistema brindan la capacidad de administrar de manera centralizada todos los recursos, y esto, a su vez, reduce significativamente el costo de su soporte, cuyo costo, por regla general, es más del 50% del costo del equipo.

Impacto SAN en aplicaciones

Para dejar en claro a nuestros lectores cuán útiles son las tecnologías discutidas en este artículo, damos algunos ejemplos de tareas aplicadas que se resolverían de manera ineficiente sin usar redes de almacenamiento, requerirían grandes inversiones financieras o no se resolverían en absoluto por métodos estándar.

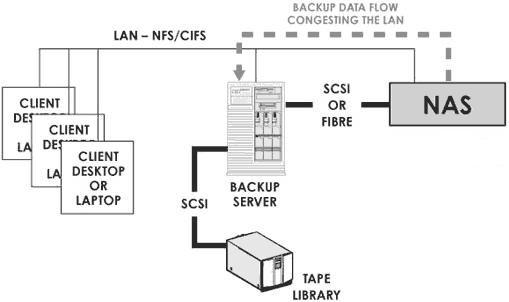

Copia de seguridad y recuperación de datos

Al usar la interfaz SCSI tradicional, el usuario, al construir sistemas de copia de seguridad y recuperación, se encuentra con una serie de problemas complejos que pueden resolverse fácilmente con las tecnologías SAN y FC.

Por lo tanto, el uso de redes de almacenamiento lleva la solución a las tareas de copia de seguridad y restauración a un nuevo nivel y proporciona la capacidad de realizar copias de seguridad varias veces más rápido que antes, sin cargar la red local y los servidores con el trabajo de copia de seguridad de datos.

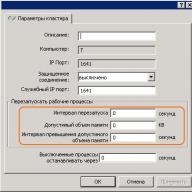

Agrupación de servidores

Una de las tareas típicas para las cuales se usa SAN de manera efectiva es la agrupación de servidores. Dado que uno de los puntos clave en la organización de sistemas de clúster de alta velocidad que funcionan con datos es el acceso al almacenamiento, con el advenimiento de SAN, la construcción de clústeres multimodo a nivel de hardware se resuelve simplemente agregando un servidor con una conexión a la SAN (esto puede hacerse sin siquiera apagar el sistema, ya que Los interruptores FC admiten conexión en caliente). Cuando se utiliza una interfaz SCSI paralela, cuya conectividad y escalabilidad es mucho peor que la de FC, sería difícil crear clústeres orientados a datos con más de dos nodos. Los conmutadores SCSI paralelos son dispositivos muy complejos y costosos, y para FC es un componente estándar. Para crear un clúster que no tendrá un solo punto de falla, es suficiente integrar una SAN duplicada (tecnología DUAL Path) en el sistema.

En el contexto de la agrupación, una de las tecnologías RAIS (Redundant Array of Inexpensive Servers) parece especialmente atractiva para construir potentes sistemas de comercio por Internet escalables y otros tipos de tareas con altos requisitos de potencia. Según Alistair A. Croll, cofundador de Networkshop Inc, el uso de RAIS es bastante efectivo: “Por ejemplo, por $ 12,000-15,000 puedes comprar unos seis servidores Linux / Apache de procesador único doble (Pentium III) de bajo costo. La potencia, la escalabilidad y la tolerancia a fallas de un sistema de este tipo será significativamente mayor que, por ejemplo, un único servidor de cuatro procesadores basado en procesadores Xeon, pero el costo es el mismo ”.

Acceso simultáneo a video y distribución de datos (transmisión simultánea de video, intercambio de datos)

Imagine una tarea cuando necesite editar video o simplemente trabajar en grandes cantidades de datos en varias (digamos\u003e 5) estaciones. Transferir un archivo de 100GB a través de una red de área local tomará varios minutos, y trabajar juntos en él será una tarea muy difícil. Cuando se usa SAN, cada estación de trabajo y servidor de red accede al archivo a una velocidad equivalente a un disco local de alta velocidad. Si necesita otra estación / servidor para el procesamiento de datos, puede agregarlo a la SAN sin apagar la red, simplemente conectando la estación al conmutador SAN y otorgándole derechos de acceso al almacenamiento. Si ya no está satisfecho con el rendimiento del subsistema de datos, simplemente puede agregar un almacenamiento más y usar la tecnología de distribución de datos (por ejemplo, RAID 0) obtiene el doble de rápido rendimiento.

Componentes principales de SAN

Miercoles

Fibre Channel utiliza cables de cobre y ópticos para conectar componentes. Ambos tipos de cables se pueden usar simultáneamente al construir una SAN. La conversión de la interfaz se lleva a cabo utilizando GBIC (Gigabit Interface Converter) y MIA (Media Interface Adapter). Ambos tipos de cable hoy en día proporcionan la misma velocidad de datos. El cable de cobre se utiliza para distancias cortas (hasta 30 metros), el cable óptico para distancias cortas y de hasta 10 km y más. Utilice cables ópticos multimodo y monomodo. El cable multimodo se utiliza para distancias cortas (hasta 2 km). El diámetro interno del cable de fibra óptica multimodo es 62.5 o 50 micras. Para garantizar una velocidad de transferencia de 100 MB / s (200 MB / s en dúplex) cuando se utiliza fibra multimodo, la longitud del cable no debe superar los 200 metros. El cable monomodo se utiliza para largas distancias. La longitud de dicho cable está limitada por la potencia del láser utilizado en el transmisor de señal. El diámetro interno de un cable monomodo es de 7 o 9 micras, proporciona una ruta de haz único.

Conectores, adaptadores

Para conectar cables de cobre, se utilizan conectores DB-9 o HSSD. HSSD se considera más confiable, pero el DB-9 se usa con la misma frecuencia porque es más simple y económico. El conector estándar (más común) para cables ópticos es el conector SC, que proporciona una conexión clara y de alta calidad. Para conexiones normales, se usan conectores SC multimodo, y para conexiones remotas, se usan conectores SC monomodo. Los adaptadores multipuerto utilizan microconectores.

Los adaptadores más comunes para FC están bajo el bus PCI de 64 bits. Además, muchos adaptadores FC se producen bajo el S-BUS, para los que están disponibles adaptadores de uso especializado para MCA, EISA, GIO, HIO, PMC, Compact PCI. Los más populares son los de puerto único, hay tarjetas de dos y cuatro puertos. En los adaptadores PCI, por regla general, usan conectores DB-9, HSSD, SC. Los adaptadores basados \u200b\u200ben GBIC también son comunes, que vienen con o sin módulos GBIC. Los adaptadores Fibre Channel se distinguen por las clases que admiten y una variedad de características. Para comprender las diferencias, ofrecemos una tabla comparativa de adaptadores fabricados por QLogic.

| Cuadro de familia de adaptadores de bus de host de canal de fibra | ||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Sanblade | 64 bit | FCAL Publ. Lazo Pvt | Puerto fl | Clase 3 | Puerto F | Clase 2 | Punto a punto | IP / SCSI | Dúplex completo | Cinta FC | Especificaciones de conexión en caliente PCI 1.0 | Reconfiguración dinámica de Solaris | VIB | 2gb |

| Serie 2100 | PCI de 33 y 66MHz | X | X | X | ||||||||||

| Serie 2200 | PCI de 33 y 66MHz | X | X | X | X | X | X | X | X | X | ||||

| PCI de 33MHz | X | X | X | X | X | X | X | X | X | X | ||||

| 25 MHZ Sbus | X | X | X | X | X | X | X | X | X | X | ||||

| Serie 2300 | PCI de 66 MHZ / PCI-X de 133MHZ | X | X | X | X | X | X | X | X | X | X | X | ||

Hubs

Los HUB de canal de fibra (hubs) se utilizan para conectar nodos al anillo FC (FC Loop) y tienen una estructura similar a los centros Token Ring. Dado que la ruptura del anillo puede provocar la interrupción de la red, los concentradores FC modernos utilizan circuitos de derivación de puerto PBC, que le permiten abrir / cerrar automáticamente el anillo (conectar / desconectar sistemas conectados al concentrador). Por lo general, los HUB FC admiten hasta 10 conexiones y pueden apilar hasta 127 puertos por anillo. Todos los dispositivos conectados al HUB reciben un ancho de banda común que pueden compartir entre ellos.

Interruptores

Los conmutadores de canal de fibra (conmutadores) tienen las mismas funciones que los conmutadores LAN del lector. Proporcionan una conexión a velocidad completa sin bloqueo entre nodos. Cualquier nodo conectado a un conmutador FC recibe ancho de banda completo (con escalabilidad). Con un aumento en el número de puertos de una red conmutada, aumenta su rendimiento. Los conmutadores se pueden usar junto con concentradores (que se usan para secciones que no requieren una banda de paso dedicada para cada nodo) para lograr la relación precio / rendimiento óptima. Debido a la conexión en cascada, los conmutadores pueden utilizarse potencialmente para crear redes FC con 2 24 direcciones (más de 16 millones).

Puentes

Los puentes FC (puentes o multiplexores) se utilizan para conectar dispositivos con SCSI paralelo a la red basada en FC. Proporcionan traducción de paquetes SCSI entre Fibre Channel y dispositivos SCSI paralelos, ejemplos de los cuales son discos de estado sólido (SSD) o bibliotecas de cintas. Cabe señalar que en recientemente Casi todos los dispositivos que se pueden eliminar como parte de la SAN, los fabricantes están comenzando a producir con una interfaz FC incorporada para la conexión directa a las redes de almacenamiento.

Servidores y Almacenamiento

A pesar de que los servidores y el almacenamiento están lejos de ser los componentes SAN menos importantes, no nos detendremos en su descripción, porque estamos seguros de que todos nuestros lectores están familiarizados con ellos.

Al final, quiero agregar que este artículo es solo el primer paso para las redes de almacenamiento. Para comprender completamente el tema, el lector debe prestar mucha atención a las características de la implementación de componentes por parte de los fabricantes de SAN y el software de administración, ya que sin ellos, la Red de área de almacenamiento es solo un conjunto de elementos para cambiar los sistemas de almacenamiento que no le brindarán todos los beneficios de implementar una red de almacenamiento.

Conclusión

Hoy, la red de área de almacenamiento es una tecnología bastante nueva que pronto puede generalizarse entre los clientes corporativos. En Europa y EE. UU., Las empresas que tienen una flota bastante grande de sistemas de almacenamiento instalados ya están comenzando a cambiar a redes de almacenamiento para organizar el almacenamiento con el mejor indicador del costo total de propiedad.

Según los analistas, en 2005 se enviará un número significativo de servidores de nivel medio y superior con una interfaz Fibre Channel preinstalada (esta tendencia se puede ver hoy), y solo se utilizará una interfaz SCSI paralela para la conexión interna del disco en los servidores. Hoy en día, cuando se construyen sistemas de almacenamiento y se adquieren servidores de nivel medio y superior, se debe prestar atención a esta prometedora tecnología, especialmente porque hoy hace posible implementar una cantidad de tareas mucho más económicas que el uso de soluciones especializadas. Además, invirtiendo en tecnología SAN hoy, no perderá sus inversiones mañana, porque las características de Fibre Channel crean excelentes oportunidades para el uso futuro de inversiones hoy.

P.S.

La versión anterior del artículo se escribió en junio de 2000, pero debido a la falta de interés masivo en la tecnología de las redes de almacenamiento, la publicación se pospuso para el futuro. Este futuro ha llegado hoy, y espero que este artículo anime al lector a darse cuenta de la necesidad de cambiar a la tecnología de red de almacenamiento como una tecnología avanzada para construir sistemas de almacenamiento y organizar el acceso a los datos.

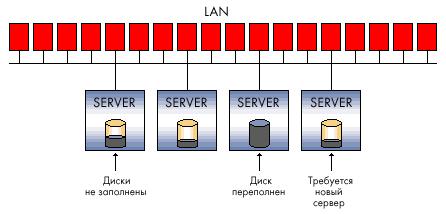

DAS, SAN, NAS: abreviaturas mágicas, sin las cuales ni un solo artículo ni un solo estudio analítico de sistemas de almacenamiento pueden hacer. Sirven como la designación de los principales tipos de conexión entre los sistemas de almacenamiento y los sistemas informáticos.

Das (almacenamiento de conexión directa) - dispositivo memoria externadirectamente conectado a la computadora principal y utilizado solo por él. El ejemplo más simple de DAS es un disco duro integrado. Para conectar el host con memoria externa en una configuración DAS típica, se utiliza SCSI, cuyos comandos le permiten seleccionar un bloque de datos específico en un disco específico o montar un cartucho específico en una biblioteca de cintas.

Las configuraciones DAS son aceptables para los requisitos de almacenamiento, capacidad y confiabilidad. DAS no proporciona la capacidad de compartir la capacidad de almacenamiento entre diferentes hosts, y menos aún la capacidad de compartir datos. La instalación de dichos dispositivos de almacenamiento es una opción más barata en comparación con las configuraciones de red, sin embargo, dadas las grandes organizaciones, este tipo de infraestructura de almacenamiento no puede considerarse óptima. Muchas conexiones DAS significan islas de memoria externa que están dispersas y dispersas por toda la empresa, cuyo exceso no puede ser utilizado por otras computadoras host, lo que conduce a un desperdicio ineficiente de la capacidad de almacenamiento en general.

Además, con una organización de almacenamiento de este tipo, no hay forma de crear un único punto de administración de la memoria externa, lo que inevitablemente complica los procesos de copia de seguridad / recuperación de datos y crea un grave problema de protección de la información. Como resultado, el costo total de propiedad de dicho sistema de almacenamiento puede ser significativamente más alto que el más complejo a primera vista y la configuración de red inicialmente más costosa.

San

Hoy, hablando de un sistema de almacenamiento de nivel empresarial, nos referimos al almacenamiento en red. Mejor conocido por el público en general es la red de almacenamiento - SAN (red de área de almacenamiento). SAN es una red dedicada de dispositivos de almacenamiento que permite que varios servidores utilicen el recurso total de la memoria externa sin la carga en la red local.

SAN es independiente del medio de transmisión, pero en este momento el estándar real es la tecnología Fibre Channel (FC), que proporciona una velocidad de transferencia de datos de 1-2 Gb / s. A diferencia de los medios de transmisión tradicionales basados \u200b\u200ben SCSI, que proporcionan una conectividad de no más de 25 metros, Fibre Channel le permite trabajar a distancias de hasta 100 km. Los medios de red Fibre Channel pueden ser cobre o fibra.

El disco puede conectarse a la red de almacenamiento matrices RAID, matrices de discos simples, (las llamadas Just a Bunch of Disks - JBOD), bibliotecas de cintas o magnetoópticas para el respaldo y archivo de datos. Los principales componentes de una organización. sAN Además de los dispositivos de almacenamiento en sí, hay adaptadores para conectar servidores a la red Fibre Channel (adaptador de bus host - NVA), dispositivos de red para admitir una u otra topología de red FC y herramientas de software especializadas para administrar la red de almacenamiento. Estos sistemas de software se puede realizar tanto en un servidor de propósito general como en los dispositivos de almacenamiento, aunque a veces algunas de las funciones se transfieren a un servidor delgado especializado para administrar la red de almacenamiento (dispositivo SAN).

El objetivo del software SAN es principalmente administrar de forma centralizada la red de almacenamiento, incluida la configuración, el monitoreo, el control y el análisis de los componentes de la red. Una de las más importantes es la función de control de acceso a matrices de discos, si se almacenan servidores heterogéneos en la SAN. Las redes de almacenamiento permiten que varios servidores accedan simultáneamente a múltiples subsistemas de disco, asignando cada host a discos específicos en una matriz de discos específica. Para diferentes sistemas operativos, es necesario estratificar la matriz de discos en "unidades lógicas" (unidades lógicas - LUN), que utilizarán sin conflictos. La asignación de áreas lógicas puede ser necesaria para organizar el acceso a los mismos datos para un determinado grupo de servidores, por ejemplo, servidores del mismo grupo de trabajo. Los módulos de software especiales son responsables de soportar todas estas operaciones.

El atractivo de las redes de almacenamiento se explica por las ventajas que pueden brindar a las organizaciones que exigen la eficiencia de trabajar con grandes volúmenes de datos. Una red de almacenamiento dedicada descarga la red principal (local o global) de servidores informáticos y estaciones de trabajo del cliente, liberándola de los flujos de entrada / salida de datos.

Este factor, así como el medio de transmisión de alta velocidad utilizado para SAN, proporciona una mayor productividad de los procesos de intercambio de datos con sistemas de almacenamiento externo. SAN significa la consolidación de los sistemas de almacenamiento, la creación de un único grupo de recursos en diferentes medios, que serán compartidos por toda la potencia informática, y como resultado, la capacidad de memoria externa requerida se puede proporcionar con menos subsistemas. En SAN, se realiza una copia de seguridad de los datos de los subsistemas de disco en cintas fuera de la red local y, por lo tanto, se vuelve más eficiente: se puede usar una biblioteca de cintas para hacer una copia de seguridad de los datos de varios subsistemas de disco. Además, con el soporte del software apropiado, es posible implementar una copia de seguridad directa en la SAN sin la participación del servidor, descargando así el procesador. La capacidad de implementar servidores y memoria a largas distancias satisface las necesidades de mejorar la confiabilidad de los almacenes de datos empresariales. El almacenamiento de datos consolidado en la SAN se escala mejor porque le permite aumentar la capacidad de almacenamiento independientemente de los servidores y sin interrumpir su trabajo. Finalmente, la SAN permite la administración centralizada de un único grupo de memoria externa, lo que simplifica la administración.

Por supuesto, las redes de almacenamiento son una solución costosa y difícil, y a pesar del hecho de que todos los proveedores líderes de la actualidad producen dispositivos SAN basados \u200b\u200ben Fibre Channel, su compatibilidad no está garantizada, y la elección del equipo adecuado plantea un problema para los usuarios. Se requerirán costos adicionales para la organización de una red dedicada y la compra de software de administración, y el costo inicial de la SAN será mayor que la organización del almacenamiento utilizando DAS, pero el costo total de propiedad debería ser menor.

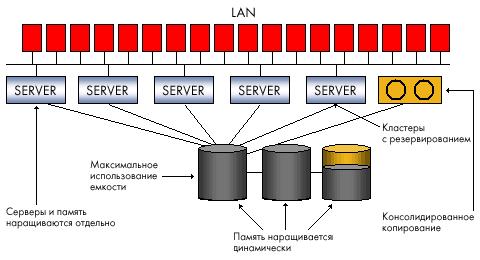

NAS

A diferencia de SAN, NAS (almacenamiento conectado a la red) no es una red, sino un dispositivo de almacenamiento en red, más precisamente, un servidor de archivos dedicado con un subsistema de disco conectado a él. En ocasiones, se puede incluir una biblioteca óptica o de cintas en la configuración del NAS. El dispositivo NAS (dispositivo NAS) está conectado directamente a la red y brinda a los hosts acceso a los archivos en su subsistema de memoria externa integrado. La aparición de servidores de archivos dedicados está asociada con el desarrollo del sistema de archivos de red NFS por parte de Sun Microsystems a principios de los años 90, lo que permitió a las computadoras cliente en la red local usar archivos en un servidor remoto. Luego, a Microsoft se le ocurrió un sistema similar para el entorno de Windows: el Sistema de archivos de Internet común. Las configuraciones NAS son compatibles con estos dos sistemas, así como con otros protocolos basados \u200b\u200ben IP, lo que permite compartir archivos para las aplicaciones del cliente.

El dispositivo NAS se asemeja a la configuración DAS, pero difiere fundamentalmente de eso en que proporciona acceso a nivel de archivo, no a bloques de datos, y permite que todas las aplicaciones en la red compartan archivos en sus discos. NAS especifica un archivo en el sistema de archivos, el desplazamiento en este archivo (que se representa como una secuencia de bytes) y el número de bytes para leer o escribir. Una solicitud a un dispositivo NAS no determina el volumen o sector en el disco donde se encuentra el archivo. Desafío sistema operativo Los dispositivos NAS traducen el acceso a un archivo específico en una solicitud a nivel de bloque de datos. El acceso a archivos y la capacidad de compartir información son convenientes para aplicaciones que deberían servir a muchos usuarios al mismo tiempo, pero no requieren la descarga de grandes cantidades de datos para cada solicitud. Por lo tanto, se está convirtiendo en una práctica común usar NAS para aplicaciones de Internet, servicios web o CAD, en el que cientos de especialistas trabajan en un proyecto.

La opción NAS es fácil de instalar y administrar. A diferencia de la red de almacenamiento, la instalación de un dispositivo NAS no requiere una planificación especial y el costo de un software de administración adicional: solo conecte el servidor de archivos a la red local. El NAS libera a los servidores de la red de las tareas de administración de almacenamiento, pero no descarga el tráfico de red, ya que los datos se intercambian entre los servidores de uso general y el NAS en la misma red local. Se pueden configurar uno o más en el NAS sistemas de archivos, cada uno de los cuales tiene asignado un conjunto específico de volúmenes en el disco. A todos los usuarios del mismo sistema de archivos se les asigna algo de espacio en disco a pedido. Por lo tanto, el NAS proporciona una organización y uso más eficiente de los recursos de memoria en comparación con DAS, ya que el subsistema de almacenamiento conectado directamente solo sirve a un recurso informático, y puede suceder que un servidor en la red local tenga demasiada memoria externa, mientras que otro se está quedando sin espacio en disco. Pero no puede crear un único grupo de recursos de almacenamiento a partir de varios dispositivos NAS y, por lo tanto, un aumento en el número de nodos NAS en la red complicará la tarea de administración.

NAS + SAN \u003d?

¿Qué tipo de infraestructura de almacenamiento elegir: NAS o SAN? La respuesta depende de las capacidades y necesidades de la organización, sin embargo, es básicamente incorrecto compararlas o incluso contrastarlas, ya que estas dos configuraciones resuelven problemas diferentes. El acceso a archivos y el intercambio de información para aplicaciones en plataformas de servidor heterogéneas en la red local es el NAS. Acceso en bloque de alto rendimiento a bases de datos, consolidación de almacenamiento, que garantiza su fiabilidad y eficiencia: estas son SAN. En la vida, sin embargo, todo es más complicado. NAS y SAN a menudo ya coexisten o deben implementarse simultáneamente en la infraestructura de TI distribuida de la empresa. Esto inevitablemente crea problemas de gestión y utilización del almacenamiento.

Hoy en día, los fabricantes buscan formas de integrar ambas tecnologías en una única infraestructura de almacenamiento de red que consolidará los datos, centralizará las copias de seguridad, simplificará la administración general, la escalabilidad y la protección de datos. La convergencia de NAS y SAN es una de las tendencias más importantes de los últimos tiempos.

La red de almacenamiento le permite crear un grupo único de recursos de memoria y asignar en el nivel físico la cuota de espacio en disco necesaria para cada uno de los hosts conectados a la SAN. El servidor NAS proporciona el intercambio de datos en el sistema de archivos mediante aplicaciones en diferentes plataformas operativas, resolviendo los problemas de interpretación de la estructura del sistema de archivos, sincronizando y controlando el acceso a los mismos datos. Por lo tanto, si queremos agregar a la red de almacenamiento la capacidad de separar no solo discos físicos, sino también estructura lógica sistemas de archivos, necesitamos un servidor de administración intermedio para implementar todas las funciones de los protocolos de red para procesar solicitudes a nivel de archivo. De ahí el enfoque general para combinar SAN y NAS utilizando un dispositivo NAS sin un subsistema de disco integrado, pero con la capacidad de conectar componentes de red de almacenamiento. Dichos dispositivos, que son llamados puertas de enlace NAS por algunos fabricantes y por otros dispositivos de cabeza NAS, se convierten en una especie de amortiguación entre red de área local y SAN, que proporciona acceso a nivel de archivo a los datos en la SAN y comparte información a través de la red de almacenamiento.

Resumen