¿Quién hubiera pensado que apareció un disco duro hace casi 60 años? El primer HDD fue inventado por IBM y se llamaba IBM 350 y hasta ese momento no había otros prototipos de discos. La oportunidad de comprar un disco duro apareció en septiembre de 1956 y era parte de un nuevo sistema informático 305 RAMAC. El disco constaba de cincuenta discos de veinte pulgadas de aluminio. Velocidad de rotación disco duro fue igual a 1200 rpm. El volumen de este dispositivo, según los estándares actuales, fue realmente divertido. En total, el disco contenía 5 megabytes. Pero, a pesar de esto, los ingenieros consideran que la IBM 350 es un verdadero avance técnico, ya que estos discos, o más bien uno de ellos, podrían reemplazar fácilmente 62.5 mil tarjetas perforadas. Además, el "tornillo" duro fue mucho más rápido, porque para obtener acceso a la información necesaria, los usuarios necesitaban fracciones de segundo, mientras que el uso de cintas magnéticas les llevó varios minutos esperar.

Disco duro IBM Ramac 305. Un gran número de unidades

Ray Jones inventó y fabricó estos discos. En 1930, trabajó como profesor en una escuela e incluso entonces inventó una máquina que podía leer automáticamente las pruebas que distribuía a sus alumnos. Más tarde, IBM compró el disco duro e invitó a Jones a su equipo. Entonces se volvió a capacitar como ingeniero en una empresa de TI. En enero de 1952, Ray recibió ofertas para abrir un laboratorio de investigación en el que podría hacer su negocio favorito, las nuevas tecnologías. Solo un mes después, un ingeniero talentoso arrendó un edificio entero en San José. Además, tenía planes globales, porque lo alquiló de inmediato por 5 años. Comenzó a equipar su laboratorio y, al mismo tiempo, buscó empleados y realizó entrevistas.

Tres meses después, ya había 30 empleados en su laboratorio. Todos ellos se dedicaron a resolver problemas fascinantes, entre los cuales se encontraban proyectos como un dispositivo que permitía el acceso a información arbitraria registrada en una tarjeta perforada. Además, los expertos intentaron hacer una impresora matricial, relojes especiales que pudieran marcar automáticamente el momento en que una persona llega y sale del trabajo. La idea del primer disco duro, es decir, el uso sistemas magnéticos para almacenar información, apareció durante el trabajo con la mejora de las tarjetas perforadas. Los especialistas pensaron en todo y comenzaron a experimentar con posibles portadores, entre los que se encontraban anillos de cinta, cables, varillas, tambores y mucho más. Sin embargo, los medios magnéticos se reconocieron como la mejor opción, ya que permitieron colocar más información y, gracias a la rotación, el acceso a la información necesaria fue muy simple.

Más tarde, en 1953, seis ingenieros profesionales se unieron al equipo de Jones. Anteriormente, trabajaron en McDonnell Douglas y crearon un sistema para el procesamiento automático de datos. En el mismo año, la Fuerza Aérea de los EE. UU. Ordenó un dispositivo que pudiera proporcionar almacenamiento simultáneo de un archivador, que consta de 50 mil registros. Una de las condiciones principales era el acceso instantáneo a cualquiera de los registros en los discos. Pero en ese momento, los ingenieros aún no habían decidido sobre el material y las tecnologías que luego se utilizaron para crear el IBM 350.

Tomó más de un año resolver los problemas, y en mayo de 1955, el liderazgo de IBM anunció por primera vez la aparición de una nueva y revolucionaria forma de almacenar datos, y en febrero de 1956, la primera discos duros salió a la venta.

La popularidad de hoy discos duros genial, aunque lentamente se están convirtiendo en algo del pasado. El tiempo de los discos duros está llegando a su fin y están siendo reemplazados por unidades de estado sólido, más rápidas y más confiables.

Ya usamos varios tipos de computadoras sin "discos duros": teléfonos inteligentes, tabletas, computadoras portátiles, cualquier dispositivo en el que en lugar de cajas con placas giratorias en el interior, se instalen unidades basadas en chips de memoria flash. Y a pesar de que en términos de unidades de estado sólido de 1 GB aún no pueden competir en precio con los discos duros clásicos, el resultado de esta confrontación parece estar predeterminado: alta velocidad, bajo consumo de energía, alta resistencia al estrés mecánico, miniatura: todo sugiere que tarde o temprano SSD terminará la mecánica.

Para comprender cómo llegamos a esto, veamos cómo ha evolucionado la historia de las unidades en los últimos 50 años.

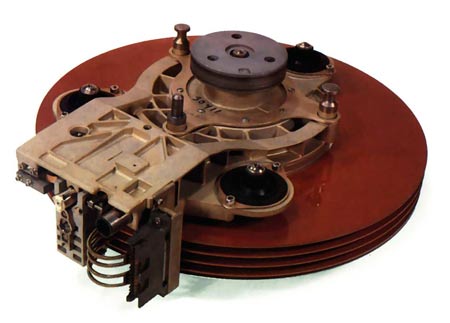

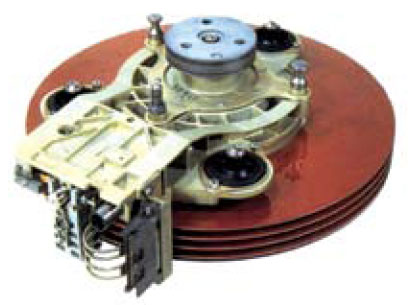

El primer disco duro IBM 350 Almacenamiento en disco La unidad se mostró al mundo el 4 de septiembre de 1956. Era un gabinete enorme de 1.5 m de ancho, 1.7 m de alto, 0.74 m de grosor, pesaba casi una tonelada y costaba una fortuna. Su eje contenía 50 discos de 24 "(61 cm) recubiertos con pintura que contenía material ferromagnético. D

las reclamaciones giraban a una velocidad de 1200 rpm, y la cantidad total de información almacenada en ellas era igual a fantástica en ese momento 4.4 Mb. La unidad en la que se montaron las cabezas pesaba casi 1,5 kg, pero le llevó menos de un segundo moverse de la pista interna del disco superior a la pista interna de la inferior. Imagine lo rápido que se suponía que este mecanismo no tan fácil debía moverse.

Inventado por un pequeño equipo de ingenieros, la unidad de almacenamiento en disco IBM 350 era parte del sistema de computación de tubo IBM 305 RAMAC. Tales sistemas en los años 50 y 60 se usaron exclusivamente en grandes corporaciones y organizaciones gubernamentales. Es interesante que todas las ideas integradas en el primer disco duro, que apareció en la era de las computadoras con lámpara, hayan sobrevivido hasta nuestros días: en las unidades modernas, el mismo conjunto de discos recubiertos con una capa ferromagnética, en la que se escriben las pistas de datos, y un bloque de cabezales de lectura y registros colocados en el "brazo" con un accionamiento electromecánico. Por cierto, la idea de cabezas que se elevan por encima de la superficie del disco debido al flujo de aire creado por la rotación de los discos también fue propuesta por los ingenieros de IBM, y esto sucedió en 1961. Y casi hasta finales de los años 60, todo lo relacionado con los discos duros, de una forma u otra, provino de IBM.

Carrera de disco

En 1979, Alan Schugart, quien trabajó anteriormente en IBM y participó en el desarrollo de la Unidad de almacenamiento en disco IBM 350, anunció la creación de Seagate Technology, y tal vez desde ese momento comenzó la historia del disco duro como un producto masivo.

En el mismo 1979, Seagate creó el primer disco del factor de forma ST-506 de 5,25 "con una capacidad de 5 MB, y un año después se puso en producción. Un año después, se lanzó el ST-412 de 10 MB. Estos discos fueron utilizados en las legendarias computadoras personales IBM PC / AT e IBM PC / XT.

Western Digital, que más tarde se convirtió en el principal competidor de Seagate, se fundó nueve años antes y se llamó General Digital Corporation (fue renombrada en 1971, un año después de su fundación) en el momento de su fundación. Ella se dedicaba a la producción de controladores de un solo chip y varios productos electrónicos. Western Digital fabricó el primer controlador de disco duro Seagate ST-506 / ST-412 en un solo chip en 1981, y se llamó WD1010. Los siguientes siete años, WD participó en el desarrollo conjunto del estándar ATA, se dedicó al desarrollo de chips para discos SCSI y ATA, y en 1988 adquirió la división de discos de Tandon Corporation y ya en 1990 introdujo sus propios discos duros en la serie Caviar. Se discuten más detalles sobre esta técnica en el foro de electrónica: http://www.tehnari.ru/f30/.

En general, en el período de 20 años, de 1985 a 2005, hubo un verdadero auge producción de disco, y apareció una gran cantidad de empresas, la mayoría de las cuales se han convertido en parte de los principales gigantes Seagate y Western Digital, o simplemente dejaron de existir. Piense en al menos las conocidas marcas de discos de antaño: Conner, Fuji, IBM, Quantum, Maxtor, Fujitsu, Hitachi, Toshiba, que se han establecido como fabricantes de buena tecnología. De una forma u otra, todos participaron en la "carrera del disco", que comenzó desde el momento en que el HDD se convirtió en una parte integral de una computadora personal.

Universo paralelo

Casi desde el principio, las computadoras usaron varias varios tipos memoria, pero solo porque todavía no se ha inventado un dispositivo de almacenamiento perfecto. Si imagina que pudimos obtener chips que funcionan tan rápido como la RAM, no volátiles como flash, pero con un gran recurso de reescritura y un volumen tal como resistente moderno unidades, entonces no necesitaríamos dividir esta memoria en dispositivos separados. Cada uno de los tipos de dispositivos de almacenamiento existentes es imperfecto y, en relación con la miniaturización total, los discos duros son especialmente imperfectos debido a su naturaleza mecánica. Provienen de la idea de que es relativamente económico obtener una gran cantidad de memoria y, por lo tanto, los requisitos iniciales para otros parámetros, como la velocidad y la confiabilidad, de alguna manera se desvanecieron en el fondo. Por lo tanto, no es sorprendente que siempre se haya buscado una alternativa al HDD.

En los años 70-80, se hicieron intentos repetidos para crear unidades de estado sólido (Unidad de estado sólido, SSD) basadas en memoria dinámica, que estaban equipadas con un controlador especial y una batería en caso de apagón. Luego fueron proyectos casi locos, que costaron mucho dinero, y recibieron su realización exclusivamente en supercomputadoras (IBM, Cray) y en sistemas utilizados para el procesamiento de datos en tiempo real (por ejemplo, en estaciones sísmicas). Más tarde, cuando los volúmenes de chips memoria RAM aumentó significativamente y su costo disminuyó, tales unidades aparecieron como soluciones para computadoras personales (por ejemplo, el conocido i-RAM fabricado por Gigabyte), pero seguía siendo el grupo de geeks, y no recibió distribución en masa debido al alto costo relativo y al pequeño volumen.

Otra área de SSD nació de la idea de crear un chip EEPROM de gran capacidad. El problema era que las celdas grabadas se pueden colocar muy bien en el chip, pero si necesita no solo grabar, sino también borrar y luego volver a grabar, entonces necesita una cadena responsable del borrado, lo que aumenta enormemente el tamaño de la celda de memoria.

Un científico que trabajó en Toshiba, el Dr. Fujio Masuoka, encontró una solución a la situación a principios de los 80. Propuso cruzar dos formas de borrar las celdas de memoria permanentes y, en lugar de borrar todo el chip o, por el contrario, solo una celda, borrar la memoria con bloques suficientemente grandes. En 1984, Masuoka presentó su desarrollo en el IEEE 1984 International Electron Devices Meeting (IEDM), y en 1989 en la Conferencia Internacional de Circuitos de Estado Sólido, Toshiba mostró el concepto de flash NAND desarrollado. Entonces, incluso en mis sueños más salvajes, casi nadie hubiera pensado que un pequeño chip con un complejo esquema de acceso a datos podría competir con discos duros que ya estaban ganando impulso.

Fundada en el mismo 1989, la compañía israelí M-Systems comenzó a trabajar en la idea de una unidad flash, y en 1995 lanzó DiskOnChip, una unidad de un solo chip. Tenía memoria flash y un controlador. Además, este disco de un solo chip de 8.16 y 32 MB ya contenía algoritmos para monitorear el desgaste de la celda y detectar y redistribuir bloques dañados en su firmware. Por cierto, fue M-Systems en 1999, el primero en lanzar unidades flash USB: DiskOnKey, e IBM firmará un contrato con la compañía y las venderá en los Estados Unidos bajo su propia marca.

Pero para que los SSD basados \u200b\u200ben flash se conviertan en un producto masivo, tomó alrededor de otros 10 años. En 2006, Samsung, para entonces el mayor fabricante de chips de memoria, lanzó la primera computadora portátil del mundo con una unidad SSD de 32 GB. Dos años más tarde, Apple mostró el MacBook Air, que opcionalmente podría instalarse SSD, y en 2010 este portátil se produjo exclusivamente con unidades de estado sólido.

Los SSD modernos ciertamente tienen fallas. Aunque, si comprende con cuidado, no hay tantos: pero en general solo hay uno: el alto costo de 1 GB en comparación con los discos duros clásicos. Pero la industria de los semiconductores se está desarrollando muy rápidamente, se están desarrollando nuevos tipos de memoria, se están mejorando los algoritmos de los controladores, los volúmenes están creciendo rápidamente y el costo está disminuyendo gradualmente. Pero eso no es todo.

Existe otro argumento importante debido al cual existe una fuerte competencia y los precios se convierten rápidamente en una facilidad atractiva para fabricar unidades de estado sólido. De hecho, ensamblar un SSD es lo mismo que ensamblar solo una placa controladora para un disco duro, y todo lo que se necesita es una línea de ensamblaje para placas de montaje en superficie. Esto, por supuesto, es muy simplista, pero generalmente cierto. Ensamblar un disco duro clásico es un proceso mucho más complicado, lo que significa que es costoso. Es por eso que nadie duda de que quedan muy pocos hasta el momento en que los SSD comienzan a suplantar activamente los "discos duros". El proceso ya ha comenzado.

¡50 años de discos duros!

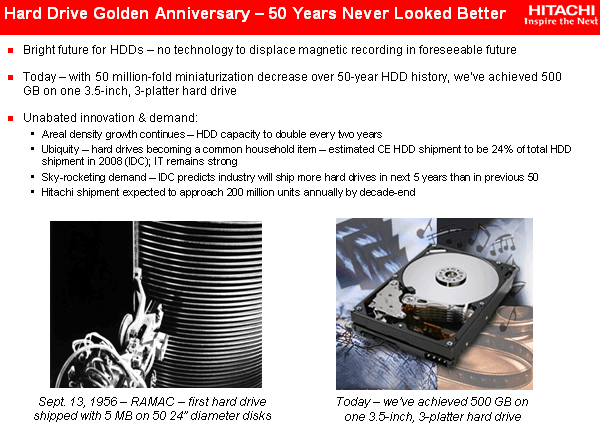

IBM / Hitachi conmemora la historia de medio siglo de toda la industria del almacenamiento magnético

Hace aproximadamente un año y medio, la comunidad de TI, dirigida por Intel, celebró el cuadragésimo aniversario de la famosa "Ley de Moore", que durante muchos años predijo el ritmo tecnológico de desarrollo de la industria para crear circuitos integrados de semiconductores (memoria, microprocesadores, etc.) y hasta el día de hoy sigue siendo uno de los pilares para aquellos que manejan el negocio de TI.

Pero hoy no tenemos menos, y quizás una razón más importante para celebrar aniversarios: 13 de septiembre de 1956, es decir exactamente hace medio siglo IBM presentó su primer disco en magnético duro unidades (más tarde estos dispositivos recibieron el apodo semioficial "Winchester").

Y esta invención con el tiempo en realidad creó una gran industria accionamientos magnéticos, sin el cual ningún dispositivo informático más o menos potente es ahora impensable, ya que la gran mayoría de la información con la que operan estos dispositivos informáticos se almacena en medios magnéticos.

De hecho, más de medio siglo de discos duros. discos magnéticos se ha convertido el principalun medio de almacenamiento y salida operativa, la información rápidamente acumulada por la humanidad, derrotando las unidades de cinta y los medios ópticos, y las EPROM / flash semiconductoras. Y aunque el futuro de los accionamientos magnéticos ha sido cuestionado más de una vez (debido a varias limitaciones físicas que los científicos lograron superar con éxito con la ayuda de nuevos efectos y tecnologías), durante las próximas décadas seguirán en servicio debido a su singularidad. combinacionesimportantes propiedades de consumo. Y los discos magnéticos sobrevivirán a su centenario, lo sabremos muy pronto, después de los próximos 50 años. ;)

Y recordamos la ley de Moore por una razón: el desarrollo de la industria del almacenamiento magnético ha estado acompañado de la industria de los semiconductores durante todos estos años. Hay mucho más en común entre ellos de lo que parece a primera vista. Incluso las tasas de miniaturización (aumento de la densidad de elementos), "predeterminadas" por la ley de Moore para microcircuitos, son casi exactamente las mismas para medios magnéticos información Baste decir que los tamaños mínimos de los bits de grabación magnética en las placas Winchester son ahora (y en los últimos años) los tamaños mínimos de los elementos de transistores de silicio en los microprocesadores y la memoria más modernos.

Curiosamente, el primer microcircuito, que predeterminó una rama principal diferente del desarrollo de la industria de la información y la tecnología informática (TIC), apareció incluso más tarde que el primer "disco duro": se ganó el 12 de septiembre de 1958 en Texas Instruments (Jack Kilby y cofundador de Intel Robert Noyce). Por cierto, el Premio Nobel de Física fue otorgado por su invención en 2000, aunque había pocos físicos como tales al crear el microcircuito. Es solo que Kilby y Noyce "solo" idearon una tecnología que hizo una revolución completa en la industria electrónica. Desafortunadamente, todavía no se ha dado a nadie por la invención del disco duro Nobel. Y es poco probable que den ...

Entonces, el primer disco duro resultó tener 2 años sobreprimer chip! (Por cierto, prepárese, exactamente 2 años después, el 12 de septiembre de 2008, la industria celebrará el aniversario de medio siglo de los microcircuitos .;)) ¿Cuál fue la primera unidad de disco magnético? A diferencia de un microcircuito pequeño (un cristal, que luego cabe en un dedo en 1958), el primer disco duro era un gran gabinete que contenía un paquete de 50 placas grandes con un diámetro de 24 pulgadas (más de 60 cm) cada una.

El disco se llamaba RAMAC (Método de control y contabilidad de acceso aleatorio) y se desarrolló en un laboratorio de IBM en la ciudad de San José, California (que luego se convirtió en el corazón de Silicon Valley). Las placas del disco estaban recubiertas con "pintura" hecha de óxido de hierro magnético, similar al que se usó para construir el mundialmente famoso Puente Golden Gate en San Francisco.

La capacidad de información de este gigante era de 5 MB (5 millones de bytes), lo que según los conceptos actuales parece una cifra ridícula, pero luego era un segmento de High-End Enterprise. ;) Las placas se montaron en un husillo giratorio, y el soporte mecánico (¡uno!) Contenía cabezales de lectura y escritura y se movía hacia arriba y hacia abajo en una barra vertical, y el tiempo de entrega del cabezal a la pista magnética deseada fue inferior a un segundo.

Como puede ver, este concepto sirvió en gran medida como un prototipo para todos los discos duros posteriores: placas duras giratorias ("panqueques") con un recubrimiento magnético, pistas de grabación concéntricas, acceso rápido a cualquier pista seleccionada al azar (vea el nombre RAMAC). Solo ahora para cada superficie magnética se usa un par separado de cabezales de lectura y escritura, y no es común a todo el disco. Método acceso rápido a una ubicación arbitraria del operador (acceso aleatorio) hizo una verdadera revolución en los dispositivos de almacenamiento, porque en comparación con las cintas magnéticas prevalecientes en ese momento, permitió aumentar drásticamente el rendimiento del acceso. ¡Uno de esos RAMAC pesaba casi una tonelada (971 kg) y se alquiló a un precio de $ 35,000 por año (entonces era igual al costo de 17 autos nuevos)!

En estos días, Hitachi Global Storage Technologies, que es el sucesor del negocio de discos duros de IBM, y ha absorbido su sabia experiencia en el desarrollo de discos duros, está celebrando rápidamente el 50 aniversario de este gigante en DISKCON USA 2006 en Santa Clara, California.

El siguiente paso significativo de IBM en este campo fue la creación de la unidad IBM 3340. Este "casillero" ya era más pequeño (aproximadamente un metro de altura),

y durante su aparición en junio de 1973 fue considerado como un "milagro" científico. Con una densidad de grabación magnética de 1.7 Mbps por pulgada cuadrada, estaba equipado con pequeños cabezales aerodinámicos (es decir, los cabezales comenzaron a "flotar" por encima de una superficie magnética giratoria bajo la influencia de las fuerzas aerodinámicas) y una "caja" sellada ("banco") en la cual las placas con cabezas Esto protegió los discos del polvo y los contaminantes y permitió reducir drásticamente la distancia de trabajo entre la cabeza y la placa (la altura del "vuelo"), lo que condujo a un aumento significativo en la densidad de la grabación magnética. IBM 3340 es considerado con razón el padre de los discos duros modernos, porque es sobre estos principios que se construyen. Estas unidades tenían una capacidad no reemplazable de 30 MB más la misma cantidad (30 MB) en un compartimento extraíble.

Lo que dio una razón para llamarlo "Winchester", por analogía con el famoso rifle Winchester 30-30. El progreso, por cierto, tocó no solo el diseño y la densidad de grabación, sino también el tiempo de acceso, que los desarrolladores lograron reducir a 25 milisegundos (¡compárelo con 10-20 ms para discos duros modernos mucho más en miniatura!)

Más tarde, en el mismo 1973, IBM lanzó el primer disco duro FHD50 de pequeño tamaño del mundo, basado en los principios de IBM 3340: las placas magnéticas con cabezales estaban encerradas en una caja completamente cerrada, y las cabezas no se movían entre las placas.

Por cierto, la introducción del principio de "una superficie magnética - un par de cabezas" (es decir, la negativa a mover las cabezas entreplacas) sucedió un poco antes: en 1971, IBM lanzó el modelo Merlin 3330-1 (llamado así por el mítico mago medieval), donde aplicó este principio. La primera implementación de servo tecnología para posicionar cabezales en placas, que luego se transformó en la tecnología TrueTrack Servo de IBM (solo IBM tiene más de 40 patentes, pertenece al mismo evento). En unidades modernas Las servoetiquetas están ubicadas a una distancia de aproximadamente 240 nm entre sí y le permiten colocar la cabeza en la pista con una precisión de 7 nanómetros.

Es curioso que las unidades IBM 3340 fueran para uso colectivo, es decir, las empresas podrían alquilar espacio en este disco duro a un precio de $ 7.81 por megabyte por mes. Por lo tanto, la necesidad de unidades individuales de pequeño tamaño también estaba allí.

En 1979, IBM introdujo la tecnología de cabeza magnética de película delgada. Esto permitió aumentar la densidad de grabación magnética a 7,9 millones de bits por pulgada cuadrada.

En 1982, Hitachi, Ltd. sorprendió al mundo al lanzar por primera vez un disco H-8598 de 1GB, es decir, rompiendo un hito psicológicamente significativo.

Esta unidad de 1,2 GB contenía diez obleas de 14 pulgadas y dos conjuntos de cabezales de lectura / escritura en una configuración de doble actuador. Con una velocidad de lectura de 3 MB por segundo (en comparación, en los discos duros de escritorio esta velocidad se alcanzó solo una década más tarde), el modelo H-8598 fue un 87% más rápido que los productos de la generación anterior. Después de 6 años, Hitachi volvió a establecer un récord al lanzar una unidad con una capacidad de 1.89 GB, utilizando 8 discos con un diámetro de 9.5 pulgadas. Este H-6586 fue la primera unidad de clase mainframe que una persona podía transportar (pesaba unos 80 kg).

En los años 80 del siglo pasado, tuvieron lugar otros dos eventos importantes para la industria del almacenamiento magnético. Primero, se lanzaron unidades compactas de 5,25 pulgadas, que se colocaron en los compartimentos apropiados de las computadoras personales de PC de IBM (la primera computadora portátil IBM 5100 se creó en 1975, y durante algún tiempo se utilizaron los productos de esta línea 51x0, y más tarde la famosa PC 5150 de IBM unidades de cassette). Y luego, a fines de los años 80, la compañía estadounidense Conner Peripherals, fundada en 1986 por el cofundador de Seagate, Finis Conner, fue la primera en el mundo en lanzar unidades de solenoide de 3.5 pulgadas en el mercado. Esto marcó el comienzo de una nueva era en la industria de los discos magnéticos: este factor de forma se ha considerado durante mucho tiempo el principal para los discos duros, y los discos duros más grandes (en tamaño) pronto dejaron de lanzarse como poco prometedores.

IBM ha sido pionero en la producción de discos duros para computadoras portátiles en miniatura, y el primero en el mundo introdujo en 1999 un disco duro de una pulgada: el famoso Microdirve.

Es curioso que estos discos ultraminiatura usaran la misma velocidad de rotación de la placa (3600 rpm) que los modelos gigantes H-8598 y H-6586, ¡pero su capacidad y velocidad resultaron ser mucho más altas! ¡Y este progreso se ha logrado en solo 10-15 años! Si comparamos Microdrive con RAMAC, entonces 323 mil microdrives caben en el espacio de este último, ¡y su capacidad total será de 2,500 terabytes! En 2005, Hitachi GST lanzó el Microdrive número 10 millones. Y el primer disco duro de 2.5 pulgadas fue lanzado por IBM, en 1991, y llevaba el nombre de Tanba-1 (la apariencia de la línea Travelstar). Tenía una capacidad de 63 MB, pesaba solo 215 gramos (las unidades de 3,5 pulgadas de la época pesaban 3 veces más). Aunque la resistencia al impacto de estos bebés portátiles era inútil para los estándares actuales, 60 veces menos que la de sus homólogos modernos.

Por cierto, el Hitachi GST sigue siendo un primer lugar confiable en el mundo en la producción de discos duros de pequeño tamaño.

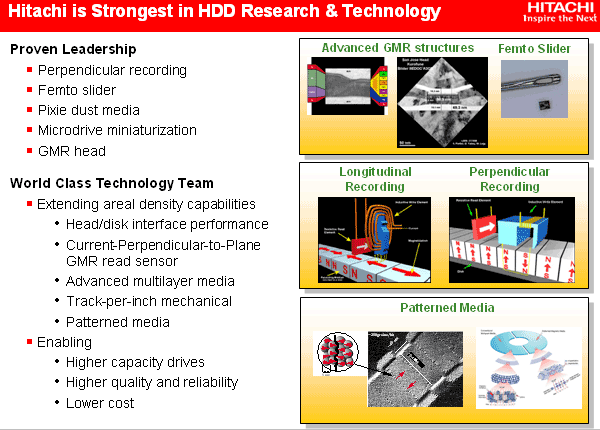

A mediados de los 90 del siglo pasado, IBM ofreció al menos dos tecnologías más revolucionarias que ahora utilizan todos los fabricantes de discos duros. En primer lugar, se trata de cabezales magnéticos con un efecto magnetorresistivo gigante (los llamados cabezales GMR, que aparecieron por primera vez en los discos Deskstar 16GP en 1997), que permitieron aumentar considerablemente la densidad de grabación (hasta 2.7 Gbit / pulgada cuadrada) en la próxima década. a veces aumenta la densidad de grabación incluso más rápido que "según la ley de Moore". :) He dicho esto repetidamente, así que no me repetiré. Y en segundo lugar, este es el denominado formato de sector Sin ID (una nueva forma de formatear placas magnéticas), que le permite aumentar la densidad en otro 10%. Ahora también es utilizado por todos los fabricantes.

Casi al mismo tiempo, las velocidades de rotación de las placas magnéticas de los discos duros de 3.5 pulgadas comenzaron a aumentar bruscamente: las unidades de PC "se activaron" de manera unificada a 5400, y luego a 7200 rpm. (este último es el estándar durante una década), y las unidades del segmento Enterprise hicieron girar hasta 10,000 y luego hasta 15,000 rpm. Por cierto, tampoco está exento, aunque Seagate cree que fue ella quien hizo la primera quincena mil de la industria. ;) Sin embargo, es interesante que Hitachi fue el primero en aumentar la velocidad de rotación por encima de 10,000, hasta 12,000 rpm. en su modelo DK3F-1 de 9.2 GB, lanzado en 1998 y rompiendo récords de rendimiento. Utilizó nuevas placas de un diseño único con un diámetro de 2.5 pulgadas (más tarde se convirtieron en el estándar en 15 milésimas).

En 2003, IBM introdujo el llamado, cuyas dimensiones son significativamente más pequeñas que antes. Esto permitió a la compañía, que ya se había convertido en Hitachi GST, lanzar varias nuevas e interesantes series de discos. Por cierto, el vuelo de las cabezas modernas sobre la superficie de las placas es de tamaño proporcional al vuelo de un avión gigante a una altitud de ... ¡1 milímetro sobre el suelo!

La industria celebró el 50 aniversario del disco duro con otro logro notable: por primera vez en 50 años, aparecieron unidades que utilizan un principio de grabación magnética diferente al utilizado en RAMAC. Es decir, grabación magnética perpendicular (PMR), cuando los dominios magnéticos están orientados no a lo largo, sino a través de la delgada película magnética en la superficie de la placa. Hitachi GST demostró la grabación magnética perpendicular en abril de 2005 en muestras con una densidad de grabación de 233 Gbps por metro cuadrado. pulgada La orientación transversal de los dominios magnéticos en una película delgada (aunque algo más gruesa que para modelos similares con grabación longitudinal) aumenta significativamente la estabilidad del almacenamiento de información, que es necesario para superar las consecuencias del llamado efecto superparamagnético. Es cierto, no Hitachi o Toshiba, pero Seagate fue la primera compañía en lanzarse en el invierno de 2006. Pero Hitachi equipado, lanzado en el verano de 2006, con la segunda generación de tecnología PMR. Sin embargo, rindiendo homenaje al tiempo, observamos que tanto el registro magnético longitudinal como el perpendicular se consideraron para RAMAC, y luego se prefirió el longitudinal, lo que determinó el desarrollo de la industria durante medio siglo. :)

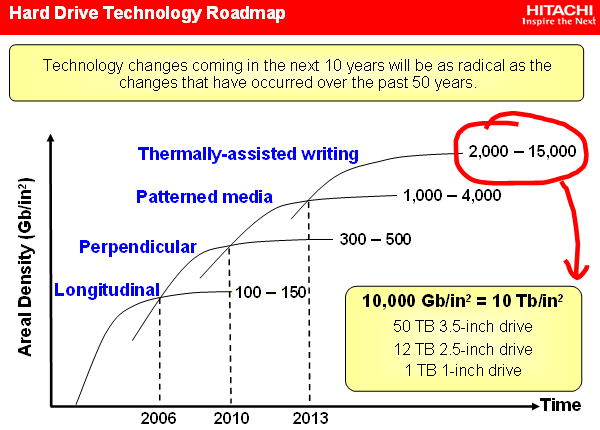

Teóricamente, PMR puede aumentar la densidad de grabación magnética a 500 Gbps por cuadrado. pulgadas (esto es aproximadamente 500 GB para la capacidad de un disco duro de 2.5 pulgadas). Hitachi conecta otros planes para aumentar la densidad de la grabación magnética con la denominada tecnología de medios estampados (cuando la película se "granula" inicialmente al nivel deseado de densidad de grabación), lo que aumentará la capacidad de almacenamiento en un orden de magnitud. Luego viene el turno de la grabación magnética activada térmicamente con un límite de densidad estimado de hasta 15,000 Gbit por metro cuadrado. pulgadas, lo que extenderá la vida útil de las unidades de disco magnético del año hasta 2020, e incluso más.

Según una investigación realizada por científicos de la Universidad de California en Berkeley, se crean alrededor de 400,000 terabytes cada año. nueva informacion solo debido correo electronico. Una población de 6,3 mil millones de personas anualmente crea 800 MB de información cada uno, es decir, alrededor de 5,000,000 terabytes de datos nuevos por año, el 92% de los cuales se almacenan en discos duros. Esto, por supuesto, no incluye información repetidamente copiada y replicada. Los analistas industriales pronostican un crecimiento anual en las ventas de discos duros de 409 millones de unidades en 2006 a más de 650 millones de unidades en 2010, es decir, 12-15% anual.

Una gran parte de este crecimiento estará en el mercado de electrónica de consumo en rápido crecimiento, es decir, pronto el disco duro se convertirá en un atributo indispensable de los dispositivos electrónicos domésticos típicos. Y la demanda, como saben, crea oferta. Por lo tanto, no hay razón para dudar de las perspectivas y la viabilidad de la industria de unidades de disco magnético.

La industria se ha acercado a romper otro hito psicológicamente importante, esta vez a 1 Terabyte para la capacidad de una sola unidad (factor de forma de 3,5 pulgadas). ¿Quién será el primero en lanzar tal disco? Lo más cercano a esto fue Seagate, que ya había lanzado un disco duro de 750 gigabytes, y Hitachi. Ambos fabricantes ya están vendiendo discos duros en obleas de 160 GB (hasta 187.5 con Seagate). Sin embargo, Hitachi ha dominado durante mucho tiempo el diseño de cinco placas, mientras que Seagate todavía está limitado a 4 placas (y lejos de las placas de 250 gigabytes hasta ahora). Por lo tanto, fue Hitachi quien se acercó más al terabyte. ¡Además, los empleados de Hitachi GST dicen que para finales de este año comenzarán a enviar la unidad de 1 TB! ¿Cuándo ocurrirá el anuncio oficial de este modelo? ¿No es el 50 aniversario de Winchester? ..;)

El sector defectuoso en el disco duro es un pequeño grupo espacio en discodefectuoso sector duro Un disco que no responde a los intentos de leer o escribir.

Por ejemplo, si tomas lo habitual Disco DVD en las manos, puede tener rasguños o grietas, que no se pueden reparar de ninguna manera, o una gota de suciedad, que se pueden quitar con cuidado y que la unidad vuelva a funcionar. Entonces con disco duro, independientemente de si se trata de una unidad de estado sólido o magnético, existen dos tipos de sectores defectuosos: algunos debido a daños físicos que no pueden repararse y otros debido a errores de software que pueden repararse.

Tipos de sectores defectuosos

Hay dos tipos de sectores defectuosos: físicos y lógicos, o de lo contrario se los puede llamar "duros" y "blandos".

Físico (duro): un sector defectuoso es un clúster de almacenamiento en un disco duro que está dañado físicamente. Tal vez su computadora (computadora portátil) se cayó, o debido a sobretensiones se apagó incorrectamente, o tal vez el disco ya está desgastado, hay varios daño físicoDesafortunadamente, no hay forma de arreglarlo ...

Lógico (suave): un sector defectuoso es un clúster de almacenamiento en un disco duro que no funciona correctamente. Quizás el sistema operativo, mientras leía desde el disco duro, por alguna razón recibió una falla (falla) y marcó este clúster como un sector defectuoso. Puede corregir estos sectores defectuosos sobrescribiendo la unidad con ceros o realizando un formateo de bajo nivel.

Causas de los sectores defectuosos del disco duro

Desafortunadamente, entre los nuevos dispositivos, hay muchos defectos de fábrica y muy a menudo el disco duro ya viene con sectores defectuosos ... Y como se escribió anteriormente, los sectores defectuosos podrían ser causados \u200b\u200bpor caídas o podría entrar polvo. Sí, debido a una pequeña mota de polvo, puede comenzar la destrucción gradual de su disco duro. Hay muchas razones y, de hecho, saber que su disco duro se estaba cayendo debido al polvo no resolverá el problema y no lo pondrá de buen humor.

Nuevamente, como se describió anteriormente, un sector puede marcarse como malo, pero no así. Los virus solían hacer esto, pero además de ellos podría haber algún tipo de mal funcionamiento del sistema, tal vez en el momento de registrar la electricidad se perderá y el sistema marcará el sector como malo, y puede haber muchas razones, ¡pero algunas de ellas son reparables!

Pérdida de datos y fracaso duro conducir

Si crees que el problema es con sectores defectuosos y pérdidas salud dura el disco es una rareza, ¡entonces estás muy equivocado! Nadie está a salvo de esto, por lo tanto, se recomienda hacer copias de información importante, por ejemplo, en almacenamiento en la nube, allí sus datos están más protegidos contra pérdidas.

Incluso si el disco duro usa programas especiales para llegar a cero: esto no guardará la información que contenía.

Siempre haga una copia de seguridad de la información importante en otro medio o en la nube, y si cada vez que enciende la computadora ve que hay un escaneo en busca de errores, o si el disco duro emite algunos sonidos, haga una copia urgente de los datos y comience a diagnosticar el disco duro, mira cual es el problema. Después de todo, él pronto puede despedirte ...

Cómo verificar y reparar sectores defectuosos

Uno de los programas más populares para prueba dura conducir Victoria, es gratis, hay un montón de gratuitos y de pago, entre los cuales veremos regenerador de disco duro.

En cada sistema operativohay un tipo incorporado verificación dura conducir Puede ver si su computadora se apagó incorrectamente, o si su disco duro ya está funcionando, cada vez que lo encienda, se escaneará. Puede comenzar a escanear con las manos: haga clic en cualquier disco con el botón derecho del mouse \u003d\u003e vaya a Propiedades \u003d\u003e Herramientas \u003d\u003e en el campo "Escanear disco" y haga clic en "Ejecutar escaneo".

Utilizando programa estándar Puede averiguar el estado de su disco duro y se solucionarán problemas menores durante el escaneo.

Verificación con Victoria

Este programa es gratuito y no hay problemas para descargarlo, por lo que si intenta utilizarlo por dinero, puede cerrar el sitio de forma segura. Se puede escanear tanto en el shell de Windows como en Dos (con Live Cd). ¡Escanee mis recomendaciones desde un disco de arranque, en cuyo caso verificar y reparar el disco será más efectivo!

Además: no olvide que durante la corrección o sobrescritura de sectores defectuosos, ¡toda la información del disco duro puede desaparecer! Por lo tanto, si decide intentar reparar su disco duro, haga copia de seguridad sus datos Durante los diagnósticos de rutina, los datos no irán a ninguna parte 🙂

Como ya dije, es mejor escanear el disco duro de LiveCD, se puede descargar en cualquier rastreador de torrents y tendrá todos los programas necesarios para trabajar con el disco duro.

1.Descargue el reanimador: no es necesario descargarlo en el recurso tfile, también puede descargarlo en otros. Pero si está descargando desde tfile, no haga clic en el botón azul grande "Descargar torrent", ya que se instalará software innecesario adicional, sino debajo del botón "descargar torrent" como en la imagen

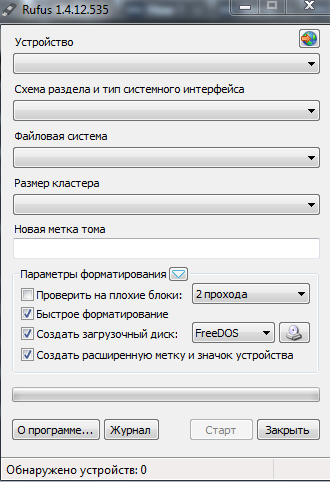

2. Escribimos la imagen descargada en un disco o unidad flash: recomiendo hacer esta accion usando la aplicación Rufus.

Descargar Rufus \u003d\u003e ejecutar esta utilidad \u003d\u003e conecte una unidad flash USB (puede escribir un disco de la misma manera que la tarjeta SD) \u003d\u003e en el campo "dispositivo" seleccione una unidad flash USB \u003d\u003e en "Crear" disco de arranque»Seleccione \u003d\u003e busque el archivo de imagen del reanimador descargado anteriormente (con la extensión iso) \u003d\u003e selecciónelo, haga clic en" Aceptar "y seleccione" Iniciar "en la ventana principal \u003d\u003e espere a que se complete el proceso.

3. Cuando encienda la computadora con vaya al BIOS o al menú de inicio, y;

4. Cuándo iniciar su computadora desde el reanimador - seleccione programa deseado para trabajar con un disco duro. En este ejemplo, Victoria.

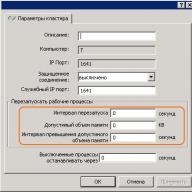

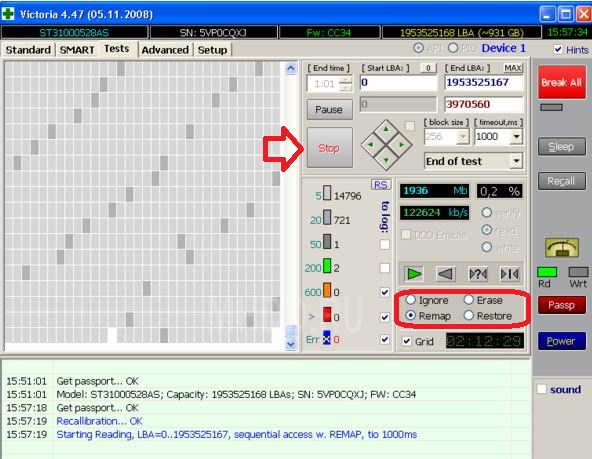

5. En la lista de unidades detectadas, seleccione la que desea probar y vaya a la pestaña Prueba

En la pestaña Prueba, determinamos las acciones durante la exploración:

Ignoraromitir sector roto;

Remap -reasignaciones malos sectores;

Borrar - restablece los sectores defectuosos, los sobrescribe muchas veces hasta que este sector se reemplaza de la zona de respaldo.

Para visualización normal estado duro conduzca para averiguar si hay sectores defectuosos, marque Ignorar y comience a escanear. Si desea restaurar sectores defectuosos, coloque Borrar y haga clic en Inicio (en este metodo posible pérdida de datos del disco duro!). Puede intentar usar Remap para reasignar sectores defectuosos.

¡Este procedimiento puede llevar de varias horas a varios días!

En este ensamblaje del regenerador hay muchos más programas para trabajar con el disco duro, por ejemplo regenerador de disco duro.Con el programa regenerador de disco duro, puede realizar las mismas acciones que en Victoria, es decir, arreglar malos sectores. Durante el inicio del programa, se le pedirá que seleccione el tipo de escaneo:

1. Escanee y restaure la unidad;

2. Escanear sin recuperación;

3. Sobrescribir sectores defectuosos para la victoria 🙂

Al final del escaneo, verá estadísticas y posiblemente obtendrá más tiempo de vida para su disco duro.

Si Victoria y HDD regenerator no lo ayudaron, en el mismo ensamblaje puede usar el programa para formatear a bajo nivel HD Low Level Format Tool. El programa formateará su disco duro, limpiará la tabla de particiones, MBR y cada byte de datos, y bloqueará la ruta a los sectores defectuosos, lo que puede darle a su disco duro más tiempo para vivir.

Estos métodos deberían ser suficientes para que usted entienda si tiene sectores defectuosos, y también utilizando estos métodos restaurará el disco duro, o comprenderá que es hora de comprar uno nuevo. Si hay complementos y otras formas, ¡escriba comentarios! Buena suerte 🙂