Apa itu sistem penyimpanan (SHD) dan untuk apa mereka? Apa perbedaan antara iSCSI dan FiberChannel? Mengapa frasa ini hanya dalam beberapa tahun terakhir dikenal oleh kalangan luas spesialis TI dan mengapa masalah sistem penyimpanan data semakin mengkhawatirkan pikiran?

Saya pikir banyak orang memperhatikan tren perkembangan di dunia komputer yang mengelilingi kita - transisi dari model pengembangan yang luas ke yang intensif. Peningkatan prosesor megahertz tidak lagi memberikan hasil yang terlihat, dan pengembangan drive tidak mengikuti jumlah informasi. Jika dalam hal prosesor semuanya lebih atau kurang jelas - cukup untuk merakit sistem multiprosesor dan / atau menggunakan beberapa inti dalam satu prosesor, maka jika terjadi masalah penyimpanan dan pemrosesan informasi, tidak mudah untuk menyingkirkan masalah. Obat mujarab saat ini untuk epidemi informasi adalah penyimpanan. Nama singkatan dari Storage Area Network atau Storage System. Bagaimanapun, ini spesial

Masalah utama diselesaikan dengan penyimpanan

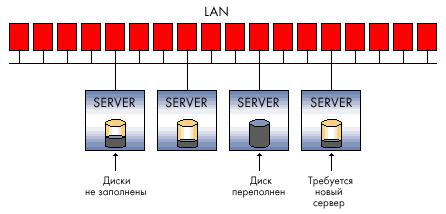

Jadi, tugas apa yang dirancang untuk diselesaikan oleh sistem penyimpanan? Pertimbangkan masalah khas yang terkait dengan meningkatnya volume informasi di organisasi mana pun. Misalkan ini setidaknya beberapa komputer dan beberapa kantor yang berjarak secara geografis.

1. Desentralisasi informasi - jika sebelumnya semua data dapat disimpan secara harfiah di satu hard disk, sekarang setiap sistem fungsional memerlukan penyimpanan yang terpisah - misalnya, server email, DBMS, domain dan sebagainya. Situasinya rumit dalam kasus kantor yang didistribusikan (cabang).

2. Pertumbuhan informasi yang seperti longsoran salju - Seringkali jumlah hard drive yang dapat Anda instal di server tertentu tidak dapat menutupi kapasitas sistem. Sebagai hasilnya:

Ketidakmampuan untuk sepenuhnya melindungi data yang disimpan memang, karena cukup sulit untuk bahkan membuat cadangan data yang tidak hanya pada server yang berbeda, tetapi juga tersebar secara geografis.

Kecepatan pemrosesan informasi yang tidak mencukupi - saluran komunikasi antara situs jarak jauh masih menyisakan banyak yang diinginkan, tetapi bahkan dengan saluran yang cukup "tebal" tidak selalu mungkin untuk menggunakan jaringan yang ada sepenuhnya, misalnya, IP, untuk bekerja.

Kompleksitas cadangan - jika data dibaca dan ditulis dalam blok-blok kecil, maka mungkin tidak realistis untuk membuat pengarsipan informasi lengkap dari server jauh melalui saluran yang ada - perlu untuk mentransfer seluruh jumlah data. Pengarsipan lokal sering tidak praktis karena alasan keuangan - sistem cadangan (tape drive, misalnya), perangkat lunak khusus (yang dapat menghabiskan banyak biaya), dan tenaga terlatih dan berkualitas diperlukan.

3. Sulit atau tidak mungkin untuk memprediksi volume yang diperlukan ruang disk saat menggunakan sistem komputer. Sebagai hasilnya:

Ada masalah memperluas kapasitas disk - cukup sulit untuk mendapatkan kapasitas terabyte di server, terutama jika sistem sudah berjalan pada disk berkapasitas kecil yang ada - minimal, shutdown sistem dan investasi keuangan yang tidak efisien diperlukan.

Pemanfaatan sumber daya yang tidak efisien - terkadang Anda tidak dapat menebak server mana data akan tumbuh lebih cepat. Sejumlah kecil ruang disk bisa kosong di server e-mail, sementara unit lain hanya akan menggunakan 20% volume subsistem disk yang mahal (misalnya, SCSI).

4. Kerahasiaan rendah dari data yang didistribusikan - tidak mungkin untuk mengontrol dan membatasi akses sesuai dengan kebijakan keamanan perusahaan. Ini berlaku untuk kedua akses ke data pada saluran yang ada untuk ini (jaringan area lokal) dan akses fisik ke media - misalnya, pencurian hard drive dan perusakannya tidak dikecualikan (untuk menyulitkan bisnis organisasi). Tindakan yang tidak memenuhi syarat oleh pengguna dan personel pemeliharaan bisa lebih berbahaya. Ketika sebuah perusahaan di setiap kantor terpaksa memecahkan masalah keamanan lokal kecil, ini tidak memberikan hasil yang diinginkan.

5. Kompleksitas pengelolaan arus informasi yang didistribusikan - setiap tindakan yang bertujuan untuk mengubah data di setiap cabang yang berisi bagian dari data yang didistribusikan menciptakan masalah tertentu, mulai dari kompleksitas sinkronisasi berbagai database, versi file pengembang hingga duplikasi informasi yang tidak perlu.

6. Efek ekonomi rendah dari pengenalan solusi "klasik" - dengan pertumbuhan jaringan informasi, data dalam jumlah besar dan struktur perusahaan yang semakin terdistribusi, investasi keuangan tidak begitu efektif dan seringkali tidak dapat menyelesaikan masalah yang muncul.

7. Tingginya biaya sumber daya yang digunakan untuk menjaga efisiensi seluruh sistem informasi perusahaan - dari kebutuhan untuk mempertahankan staf besar yang memenuhi syarat hingga berbagai solusi perangkat keras mahal yang dirancang untuk menyelesaikan masalah volume dan kecepatan akses ke informasi, ditambah dengan penyimpanan yang andal dan perlindungan dari kegagalan.

Mengingat masalah di atas, yang cepat atau lambat, sepenuhnya atau sebagian menyalip perusahaan yang berkembang secara dinamis, kami akan mencoba menggambarkan sistem penyimpanan - sebagaimana mestinya. Pertimbangkan skema koneksi tipikal dan jenis sistem penyimpanan.

Megabita / transaksi?

Jika sebelumnya hard disk ada di dalam komputer (server), sekarang mereka menjadi sempit dan tidak terlalu dapat diandalkan di sana. Solusi paling sederhana (dikembangkan sejak dulu dan digunakan di mana-mana) adalah teknologi RAID.

images \\ RAID \\ 01.jpg

Saat mengatur RAID dalam sistem penyimpanan apa pun, selain melindungi informasi, kami mendapatkan beberapa keuntungan yang tidak dapat disangkal, salah satunya adalah kecepatan akses ke informasi.

Dari sudut pandang pengguna atau perangkat lunak, kecepatan ditentukan tidak hanya oleh kapasitas sistem (MB / s), tetapi juga oleh jumlah transaksi - yaitu, jumlah operasi I / O per unit waktu (IOPS). Secara logis, sejumlah besar disk dan teknik peningkatan kinerja yang disediakan oleh pengontrol RAID (seperti caching) berkontribusi pada IOPS.

Jika keseluruhan throughput lebih penting untuk melihat video streaming atau mengatur file server, maka untuk DBMS dan aplikasi OLTP (pemrosesan transaksi online) apa pun, itu adalah jumlah transaksi yang mampu diproses oleh sistem yang kritis. Dan dengan opsi ini, hard drive modern tidak begitu cerah seperti volume yang terus bertambah dan, sebagian, kecepatan. Semua masalah ini dimaksudkan untuk diselesaikan oleh sistem penyimpanan itu sendiri.

Tingkat perlindungan

Anda perlu memahami bahwa dasar dari semua sistem penyimpanan adalah praktik melindungi informasi berdasarkan teknologi RAID - tanpa ini, sistem penyimpanan yang canggih secara teknis tidak akan berguna, karena hard drive dalam sistem ini adalah komponen yang paling tidak dapat diandalkan. Disk pengorganisasian dalam RAID adalah "tautan bawah", eselon pertama perlindungan informasi dan kecepatan pemrosesan yang meningkat.

Namun, selain skema RAID, ada perlindungan data tingkat rendah yang diterapkan "di atas" teknologi dan solusi yang tertanam dalam hard drive itu sendiri oleh pabrikannya. Misalnya, salah satu produsen penyimpanan terkemuka, EMC, memiliki metodologi untuk analisis integritas data tambahan di tingkat sektor penggerak.

Setelah berurusan dengan RAID, mari beralih ke struktur sistem penyimpanan itu sendiri. Pertama-tama, sistem penyimpanan dibagi menurut jenis antarmuka koneksi host (server) yang digunakan. Antarmuka koneksi eksternal terutama SCSI atau FibreChannel, serta standar iSCSI yang cukup muda. Juga, jangan diskon toko cerdas kecil yang bahkan dapat terhubung melalui USB atau FireWire. Kami tidak akan menganggap antarmuka yang lebih jarang (kadang-kadang tidak berhasil dengan satu atau lain cara), seperti IBM SSA atau antarmuka yang dikembangkan untuk mainframe - misalnya, FICON / ESCON. Penyimpanan NAS yang berdiri sendiri, terhubung ke jaringan Ethernet. Kata "antarmuka" pada dasarnya berarti konektor eksternal, tetapi jangan lupa bahwa konektor tidak menentukan protokol komunikasi kedua perangkat. Kami akan memikirkan fitur-fitur ini sedikit lebih rendah.

images \\ RAID \\ 02.gif

Ini adalah singkatan dari Small Computer System Interface (baca "kirim") - antarmuka paralel setengah dupleks. Dalam sistem penyimpanan modern, ini paling sering diwakili oleh konektor SCSI:

images \\ RAID \\ 03.gif

images \\ RAID \\ 04.gif

Dan sekelompok protokol SCSI, dan lebih khusus lagi - SCSI-3 Parallel Interface. Perbedaan antara SCSI dan IDE yang biasa adalah jumlah perangkat yang lebih besar per saluran, panjang kabel yang lebih panjang, kecepatan transfer data yang lebih tinggi, serta fitur "eksklusif" seperti pensinyalan diferensial tegangan tinggi, quequing perintah dan beberapa lainnya - kami tidak akan membahas masalah ini.

Jika kita berbicara tentang produsen utama komponen SCSI, seperti adaptor SCSI, pengontrol RAID dengan antarmuka SCSI, maka spesialis apa pun akan segera mengingat dua nama - Adaptec dan LSI Logic. Saya pikir ini sudah cukup, tidak ada revolusi di pasar ini untuk waktu yang lama dan mungkin tidak diharapkan.

Antarmuka FiberChannel

Antarmuka serial dupleks penuh. Paling sering, dalam peralatan modern diwakili oleh konektor optik eksternal seperti LC atau SC (LC - lebih kecil dalam ukuran):

images \\ RAID \\ 05.jpg

images \\ RAID \\ 06.jpg

... dan Protokol FibreChannel (FCP). Ada beberapa skema pengalihan perangkat FibreChannel:

Poin-ke-poin - koneksi point-to-point, mengarahkan perangkat satu sama lain:

images \\ RAID \\ 07.gif

Crosspoint beralih - menghubungkan perangkat ke sakelar FibreChannel (mirip dengan implementasi jaringan Ethernet pada sakelar):

images \\ RAID \\ 08.gif

Lingkaran arbitrase - FC-AL, loop dengan akses arbitrasi - semua perangkat terhubung satu sama lain dalam sebuah cincin, sirkuit ini sedikit mengingatkan pada Token Ring. Switch juga dapat digunakan - maka topologi fisik akan diimplementasikan sesuai dengan skema "bintang", dan yang logis - sesuai dengan skema "lingkaran" (atau "cincin"):

images \\ RAID \\ 09.gif

Koneksi menurut skema Switched FibreChannel adalah skema yang paling umum, dalam hal koneksi FibreChannel disebut Fabric - dalam bahasa Rusia ada kertas kalkir dari sana - "pabrik". Perlu dicatat bahwa sakelar FibreChannel adalah perangkat yang cukup canggih yang memiliki kompleksitas yang dekat dengan sakelar IP tingkat-IP 3. Jika sakelar-sakelar tersebut saling berhubungan, sakelar-sakelar tersebut beroperasi dalam satu pabrik dengan kumpulan pengaturan yang berlaku untuk seluruh pabrik sekaligus. Mengubah beberapa opsi pada salah satu sakelar dapat menyebabkan pengalihan kembali seluruh pabrik, belum lagi pengaturan otorisasi akses, misalnya. Di sisi lain, ada skema SAN yang melibatkan beberapa pabrik dalam satu sAN. Dengan demikian, sebuah pabrik hanya dapat disebut sekelompok sakelar yang saling terhubung - dua atau lebih perangkat yang tidak terhubung diperkenalkan ke SAN untuk meningkatkan toleransi kesalahan dari dua atau lebih pabrik yang berbeda.

Komponen yang memungkinkan menggabungkan host dan sistem penyimpanan ke dalam satu jaringan biasa disebut sebagai "konektivitas". Konektivitas, tentu saja, kabel penghubung dupleks (biasanya dengan antarmuka LC), sakelar (sakelar) dan adaptor FibreChannel (HBA, Host Base Adapters) - yaitu, kartu ekspansi yang, ketika dipasang di host, memungkinkan Anda untuk menghubungkan host ke jaringan SAN. HBA biasanya diimplementasikan sebagai kartu PCI-X atau PCI-Express.

images \\ RAID \\ 10.jpg

Jangan bingung serat dan serat - media perambatan sinyal bisa berbeda. FiberChannel dapat bekerja pada "tembaga". Sebagai contoh, semua hard drive FibreChannel memiliki kontak logam, dan pergantian perangkat biasa melalui tembaga tidak jarang, mereka hanya secara bertahap beralih ke saluran optik sebagai teknologi yang paling menjanjikan dan penggantian fungsional tembaga.

Antarmuka ISCSI

Biasanya diwakili oleh konektor RJ-45 eksternal untuk menghubungkan ke jaringan Ethernet dan protokol itu sendiri iSCSI (Internet Small Computer System Interface). Dengan definisi SNIA: "iSCSI adalah protokol yang didasarkan pada TCP / IP dan dirancang untuk membangun interoperabilitas dan mengelola sistem penyimpanan, server dan klien." Kami akan membahas antarmuka ini secara lebih rinci, jika saja karena setiap pengguna dapat menggunakan iSCSI bahkan pada jaringan "rumah" biasa.

Anda perlu tahu bahwa iSCSI mendefinisikan setidaknya protokol transport untuk SCSI, yang berjalan di atas TCP, dan teknologi untuk mengenkapsulasi perintah SCSI dalam jaringan berbasis IP. Sederhananya, iSCSI adalah protokol yang memungkinkan memblokir akses ke data menggunakan perintah SCSI yang dikirim melalui jaringan dengan tumpukan TCP / IP. iSCSI muncul sebagai pengganti FibreChannel dan dalam sistem penyimpanan modern memiliki beberapa keunggulan di atasnya - kemampuan untuk menggabungkan perangkat jarak jauh (menggunakan jaringan IP yang ada), kemampuan untuk memberikan tingkat QoS yang ditentukan (Kualitas Layanan, kualitas layanan), konektivitas dengan biaya lebih rendah. Namun, masalah utama menggunakan iSCSI sebagai pengganti FibreChannel adalah penundaan lama yang terjadi pada jaringan karena kekhasan implementasi TCP / IP stack, yang meniadakan salah satu keuntungan penting menggunakan sistem penyimpanan - kecepatan akses ke informasi dan latensi rendah. Ini adalah minus yang serius.

Sebuah komentar kecil tentang host - mereka dapat menggunakan kedua kartu jaringan biasa (kemudian pemrosesan tumpukan iSCSI dan enkapsulasi perintah akan dilakukan oleh perangkat lunak), serta kartu khusus yang mendukung teknologi yang mirip dengan TOE (TCP / IP Offload Engine). Teknologi ini menyediakan pemrosesan perangkat keras dari bagian yang sesuai dari tumpukan protokol iSCSI. Metode perangkat lunak lebih murah, tetapi lebih banyak memuat prosesor sentral server dan, secara teori, dapat menyebabkan penundaan yang lebih lama daripada prosesor perangkat keras. Dengan kecepatan jaringan Ethernet saat ini pada 1 Gbit / s, dapat diasumsikan bahwa iSCSI akan bekerja tepat dua kali lebih lambat dari FibreChannel pada kecepatan 2 Gbit, tetapi dalam penggunaan nyata perbedaannya akan semakin terlihat.

Selain yang sudah dibahas, kami menyebutkan secara singkat beberapa protokol yang lebih jarang dan dirancang untuk memberikan layanan tambahan ke jaringan area penyimpanan yang ada (SAN):

FCIP (Fibre Channel over IP) - Protokol tunneling yang dibangun pada TCP / IP dan dirancang untuk menghubungkan SAN yang tersebar secara geografis melalui lingkungan IP standar. Misalnya, Anda dapat menggabungkan dua SAN menjadi satu melalui Internet. Ini dicapai dengan menggunakan gateway FCIP yang transparan untuk semua perangkat di SAN.

iFCP (Protokol Saluran Serat Internet) - Protokol yang memungkinkan Anda untuk menggabungkan perangkat dengan antarmuka FC melalui jaringan IP. Perbedaan penting dari FCIP adalah bahwa dimungkinkan untuk menggabungkan perangkat FC melalui jaringan IP, yang memungkinkan pasangan koneksi yang berbeda untuk memiliki tingkat QoS yang berbeda, yang tidak mungkin ketika melakukan tunneling melalui FCIP.

Kami secara singkat memeriksa antarmuka fisik, protokol, dan jenis switching untuk sistem penyimpanan, tanpa berhenti pada daftar semua opsi yang memungkinkan. Sekarang mari kita coba bayangkan parameter apa yang menjadi ciri sistem penyimpanan data?

Parameter perangkat keras utama penyimpanan

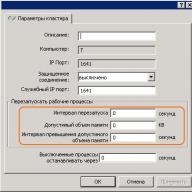

Beberapa dari mereka tercantum di atas - ini adalah jenis antarmuka dan jenis koneksi eksternal drive internal (hard drive). Parameter berikutnya, yang masuk akal untuk dipertimbangkan setelah kedua hal di atas ketika memilih sistem penyimpanan disk, adalah keandalannya. Keandalan dapat dinilai bukan oleh jam berjalan dangkal kegagalan setiap komponen individu (fakta bahwa waktu ini kira-kira sama untuk semua produsen), tetapi oleh arsitektur internal. Sistem penyimpanan "reguler" yang sering "eksternal" adalah rak disk (untuk pemasangan di kabinet 19 inci) dengan hard drive, antarmuka eksternal untuk menghubungkan host, beberapa catu daya. Di dalam, biasanya semua yang menyediakan sistem penyimpanan diinstal - unit prosesor, pengontrol disk, port input-output, memori cache, dan sebagainya. Biasanya, rak dikendalikan dari baris perintah atau melalui antarmuka web, konfigurasi awal seringkali memerlukan koneksi serial. Pengguna dapat "membagi" disk dalam sistem menjadi kelompok-kelompok dan menggabungkannya ke dalam RAID (dari level yang berbeda), ruang disk yang dihasilkan dibagi menjadi satu atau lebih unit logis (LUN), di mana host (server) memiliki akses dan "melihatnya" sebagai hard drive lokal. Jumlah grup RAID, LUNs, logika cache, ketersediaan LUNs untuk server tertentu dan yang lainnya dikonfigurasi oleh administrator sistem. Biasanya, sistem penyimpanan dirancang untuk terhubung dengan mereka bukan hanya satu, tetapi beberapa (hingga ratusan, dalam teori) server - karena itu, sistem seperti itu harus memiliki kinerja tinggi, sistem kontrol dan pemantauan yang fleksibel, dan alat perlindungan data yang dipikirkan dengan matang. Perlindungan data disediakan dalam banyak cara, yang termudah yang sudah Anda ketahui - kombinasi disk di RAID. Namun, data juga harus selalu dapat diakses - setelah semua, menghentikan satu sistem penyimpanan data pusat perusahaan dapat menyebabkan kerugian yang signifikan. Semakin banyak sistem menyimpan data pada sistem penyimpanan, semakin banyak akses yang dapat diandalkan ke sistem harus disediakan - karena jika terjadi kecelakaan, sistem penyimpanan berhenti bekerja segera di semua server yang menyimpan data di sana. Ketersediaan rak yang tinggi dipastikan dengan duplikasi internal lengkap dari semua komponen sistem - jalur akses ke rak (port FibreChannel), modul prosesor, memori cache, catu daya, dll. Kami akan mencoba menjelaskan prinsip redundansi 100% (duplikasi) dengan gambar berikut:

gambar \\ RAID \\ 11.gif

1. Pengontrol (modul prosesor) dari sistem penyimpanan, termasuk:

* prosesor sentral (atau prosesor) - biasanya perangkat lunak khusus berjalan pada sistem, menjalankan peran " sistem operasi»;

* antarmuka untuk beralih dengan hard disk - dalam kasus kami, ini adalah papan yang menyediakan koneksi disk FibreChannel sesuai dengan skema loop akses arbitrasi (FC-AL);

* memori cache;

* Pengontrol port eksternal FibreChannel

2. Antarmuka eksternal FC; seperti yang kita lihat, ada 2 dari mereka untuk setiap modul prosesor;

3. Hard drive - kapasitas diperluas dengan rak disk tambahan;

4. Memori cache dalam skema seperti itu biasanya dicerminkan agar tidak kehilangan data yang disimpan di sana ketika ada modul yang gagal.

Mengenai perangkat keras, rak disk dapat memiliki antarmuka yang berbeda untuk menghubungkan host, antarmuka hard drive yang berbeda, skema koneksi berbeda untuk rak tambahan, yang berfungsi untuk meningkatkan jumlah disk dalam sistem, serta “parameter besi” murni lainnya.

Perangkat lunak SHD

Secara alami, kekuatan perangkat keras dari sistem penyimpanan harus dikelola entah bagaimana, dan sistem penyimpanan itu sendiri hanya diwajibkan untuk menyediakan tingkat layanan dan fungsionalitas yang tidak tersedia dalam skema server-klien konvensional. Jika Anda melihat gambar “Blok diagram sistem penyimpanan data”, menjadi jelas bahwa ketika server terhubung langsung ke rak dengan dua cara, mereka harus terhubung ke port FC dari berbagai modul prosesor agar server dapat terus bekerja jika seluruh modul prosesor gagal dengan segera. Secara alami, untuk menggunakan multipathing, dukungan untuk fungsi ini harus disediakan oleh perangkat keras dan perangkat lunak di semua tingkatan yang terlibat dalam transfer data. Tentu saja, pencadangan penuh tanpa pemantauan dan peringatan tidak masuk akal - karena itu, semua sistem penyimpanan yang serius memiliki kemampuan seperti itu. Misalnya, pemberitahuan tentang peristiwa penting dapat terjadi dengan berbagai cara - peringatan e-mail, panggilan modem otomatis ke pusat dukungan teknis, pesan ke pager (sekarang lebih relevan daripada SMS), mekanisme SNMP, dan banyak lagi.

Nah, dan seperti yang telah kami sebutkan, ada kontrol yang kuat untuk semua keindahan ini. Biasanya ini adalah antarmuka berbasis web, konsol, kemampuan untuk menulis skrip dan mengintegrasikan kontrol ke dalam paket perangkat lunak eksternal. Kami hanya akan menyebutkan secara singkat tentang mekanisme yang memastikan kinerja tinggi sistem penyimpanan - arsitektur non-blocking dengan beberapa bus internal dan sejumlah besar hard drive, prosesor sentral yang kuat, sistem kontrol khusus (OS), sejumlah besar memori cache, dan banyak antarmuka I / O eksternal.

Layanan yang disediakan oleh sistem penyimpanan biasanya ditentukan oleh perangkat lunak yang berjalan di rak disk itu sendiri. Hampir selalu, ini adalah paket perangkat lunak kompleks yang dibeli di bawah lisensi terpisah yang tidak termasuk dalam biaya penyimpanan itu sendiri. Segera sebutkan perangkat lunak yang dikenal untuk menyediakan multipathing - ini dia hanya berfungsi pada host, dan bukan pada rak itu sendiri.

Solusi paling populer berikutnya adalah perangkat lunak untuk membuat salinan data instan dan lengkap. Pabrikan yang berbeda memiliki nama berbeda untuk produk perangkat lunak mereka dan mekanisme untuk membuat salinan ini. Untuk meringkas, kita dapat memanipulasi kata-kata snapshot dan klon. Klon dibuat menggunakan rak disk di dalam rak itu sendiri - ini adalah salinan internal lengkap dari data. Cakupan aplikasi cukup luas - mulai dari cadangan hingga membuat "versi uji" dari data sumber, misalnya, untuk peningkatan berisiko di mana tidak ada kepastian dan yang tidak aman untuk digunakan pada data saat ini. Siapa pun yang dengan cermat mengikuti semua pesona penyimpanan yang kami analisis di sini akan bertanya - mengapa Anda memerlukan cadangan data di dalam rak jika memiliki keandalan yang begitu tinggi? Jawaban atas pertanyaan ini di permukaan adalah bahwa tidak ada yang kebal dari kesalahan manusia. Data disimpan dengan andal, tetapi jika operator melakukan kesalahan, misalnya, menghapus tabel yang diinginkan dalam database, tidak ada trik perangkat keras yang akan menyelamatkannya. Kloning data biasanya dilakukan pada level LUN. Fungsionalitas yang lebih menarik disediakan oleh mekanisme snapshot. Hingga taraf tertentu, kami mendapatkan semua pesona dari salinan data internal penuh (klon), sementara tidak mengambil 100% dari jumlah data yang disalin di dalam rak itu sendiri, karena volume seperti itu tidak selalu tersedia bagi kami. Bahkan, snapshot adalah "snapshot" instan data yang tidak memakan waktu dan sumber daya prosesor penyimpanan.

Tentu saja, orang tidak dapat gagal untuk menyebutkan perangkat lunak replikasi data, yang sering disebut mirroring. Ini adalah mekanisme untuk replikasi sinkron atau asinkron (duplikasi) informasi dari satu sistem penyimpanan ke satu atau lebih sistem penyimpanan jarak jauh. Replikasi dimungkinkan melalui berbagai saluran - misalnya, rak dengan antarmuka FibreChannel dapat direplikasi ke sistem penyimpanan lain secara serempak, melalui Internet dan jarak jauh. Solusi ini memberikan penyimpanan informasi yang andal dan perlindungan terhadap bencana.

Selain semua hal di atas, ada sejumlah besar mekanisme perangkat lunak lain untuk manipulasi data ...

DAS & NAS & SAN

Setelah berkenalan dengan sistem penyimpanan data sendiri, prinsip-prinsip konstruksi mereka, kemampuan yang disediakan oleh mereka dan protokol yang berfungsi, saatnya untuk mencoba menggabungkan pengetahuan yang diperoleh ke dalam skema kerja. Mari kita coba mempertimbangkan jenis sistem penyimpanan dan topologi koneksi mereka ke satu infrastruktur kerja.

Perangkat DAS (Direct Attached Storage) - sistem penyimpanan yang terhubung langsung ke server. Ini termasuk sistem SCSI paling sederhana yang terhubung ke pengontrol SCSI / RAID server, dan perangkat FibreChannel yang terhubung langsung ke server, meskipun mereka dirancang untuk SAN. Dalam hal ini, topologi DAS adalah SAN yang merosot (jaringan area penyimpanan):

gambar \\ RAID \\ 12.gif

Dalam skema ini, salah satu server memiliki akses ke data yang disimpan di sistem penyimpanan. Klien mengakses data dengan mengakses server ini melalui jaringan. Artinya, server memiliki blokir akses ke data pada sistem penyimpanan, dan klien sudah menggunakan akses file - konsep ini sangat penting untuk dipahami. Kerugian dari topologi seperti itu jelas:

* Keandalan rendah - dalam kasus masalah jaringan atau server crash, data menjadi tidak dapat diakses oleh semua orang sekaligus.

* Latensi tinggi karena pemrosesan semua permintaan oleh satu server dan transportasi yang digunakan (paling sering - IP).

* Beban jaringan tinggi, sering kali mendefinisikan batas skalabilitas dengan menambahkan klien.

* Pengelolaan yang buruk - seluruh kapasitas tersedia untuk satu server, yang mengurangi fleksibilitas distribusi data.

* Pemanfaatan sumber daya yang rendah - sulit untuk memprediksi volume data yang diperlukan, beberapa perangkat DAS dalam suatu organisasi mungkin memiliki kelebihan kapasitas (disk), yang lain mungkin kekurangannya - redistribusi seringkali tidak mungkin atau memakan waktu.

Perangkat NAS (Penyimpanan Terlampir Jaringan) - perangkat penyimpanan yang terhubung langsung ke jaringan. Tidak seperti sistem lain, NAS menyediakan akses file ke data dan tidak ada yang lain. Perangkat NAS adalah kombinasi dari sistem penyimpanan dan server yang terhubung. Dalam bentuknya yang paling sederhana, server jaringan biasa yang menyediakan sumber daya file adalah perangkat NAS:

gambar \\ RAID \\ 13.gif

Semua kerugian dari skema semacam itu mirip dengan topologi DAS, dengan beberapa pengecualian. Dari minus yang telah ditambahkan, kami mencatat peningkatan, dan sering kali secara signifikan, biaya - namun, biaya sebanding dengan fungsi, dan di sini sudah sering ada "sesuatu yang harus dibayar". Perangkat NAS dapat menjadi "kotak" paling sederhana dengan satu port ethernet dan dua hard drive di RAID1, yang memungkinkan akses ke file menggunakan hanya satu protokol CIFS (Common Internet File System) ke sistem besar di mana ratusan hard drive dapat dipasang, dan akses file disediakan oleh selusin server khusus di dalam sistem NAS. Jumlah port Ethernet eksternal dapat mencapai puluhan, dan kapasitas data yang disimpan adalah beberapa ratus terabyte (misalnya, EMC Celerra CNS). Keandalan dan kinerja model seperti itu dapat mem-bypass banyak perangkat midrange SAN. Menariknya, perangkat NAS dapat menjadi bagian dari jaringan SAN dan tidak memiliki drive sendiri, tetapi hanya menyediakan akses file ke data yang disimpan pada perangkat penyimpanan blok. Dalam hal ini, NAS mengasumsikan fungsi server khusus yang kuat, dan SAN mengasumsikan perangkat penyimpanan, yaitu, kita mendapatkan topologi DAS yang terdiri dari komponen NAS dan SAN.

Perangkat NAS sangat baik dalam lingkungan yang heterogen di mana Anda memerlukan akses file cepat ke data untuk banyak klien pada saat yang bersamaan. Ini juga memberikan keandalan penyimpanan yang sangat baik dan fleksibilitas manajemen sistem yang digabungkan dengan kemudahan perawatan. Kami tidak akan memikirkan keandalan - aspek penyimpanan ini dibahas di atas. Sedangkan untuk lingkungan yang heterogen, akses ke file dalam satu sistem NAS dapat diperoleh melalui TCP / IP, CIFS, NFS, FTP, TFTP, dan lainnya, termasuk kemampuan untuk bekerja sebagai target NAS iSCSI, yang memastikan operasi dengan berbagai sistem operasi, diinstal pada host. Adapun kemudahan pemeliharaan dan fleksibilitas manajemen, kemampuan ini disediakan oleh OS khusus, yang sulit untuk dinonaktifkan dan tidak perlu dipertahankan, serta kemudahan membatasi izin file. Misalnya, dimungkinkan untuk bekerja di lingkungan Windows Active Directory dengan dukungan untuk fungsionalitas yang diperlukan - bisa berupa LDAP, Otentikasi Kerberos, DNS Dinamis, ACL, kuota, Objek Kebijakan Grup dan riwayat SID. Karena akses diberikan ke file, dan namanya mungkin berisi simbol berbagai bahasa, banyak NAS menyediakan dukungan untuk pengkodean UnicF, UTF-8. Pilihan NAS harus didekati lebih hati-hati daripada ke perangkat DAS, karena peralatan tersebut mungkin tidak mendukung layanan yang Anda butuhkan, misalnya, Encrypting File Systems (EFS) dari Microsoft dan IPSec. Ngomong-ngomong, orang bisa melihat bahwa NAS jauh lebih luas daripada perangkat SAN, tetapi persentase sistem seperti itu masih terus-menerus, meskipun lambat, tumbuh - terutama karena crowding out dari DAS.

Perangkat yang akan dihubungkan SAN (Jaringan Area Penyimpanan) - perangkat untuk menghubungkan ke jaringan penyimpanan data. Jaringan area penyimpanan (SAN) tidak boleh disamakan dengan jaringan area lokal - ini adalah jaringan yang berbeda. Paling sering, SAN didasarkan pada tumpukan protokol FibreChannel dan dalam kasus paling sederhana terdiri dari sistem penyimpanan, sakelar, dan server yang terhubung oleh saluran komunikasi optik. Pada gambar ini kita melihat infrastruktur yang sangat andal di mana server disertakan secara bersamaan jaringan lokal (kiri) dan ke jaringan penyimpanan (kanan):

gambar \\ RAID \\ 14.gif

Setelah diskusi yang cukup terperinci tentang perangkat dan prinsip operasinya, akan sangat mudah bagi kita untuk memahami topologi SAN. Pada gambar, kita melihat sistem penyimpanan tunggal untuk seluruh infrastruktur, yang terhubung dengan dua server. Server memiliki jalur akses yang berlebihan - masing-masing memiliki dua HBA (atau satu port ganda, yang mengurangi toleransi kesalahan). Perangkat penyimpanan memiliki 4 port yang terhubung ke 2 switch. Dengan asumsi bahwa ada dua modul prosesor yang berlebihan, mudah untuk menebak bahwa skema koneksi terbaik adalah ketika masing-masing sakelar terhubung ke modul prosesor pertama dan kedua. Skema semacam itu menyediakan akses ke data apa pun yang terletak pada sistem penyimpanan jika terjadi kegagalan modul prosesor, sakelar, atau jalur akses apa pun. Kami telah mempelajari keandalan sistem penyimpanan, dua sakelar, dan dua pabrik lebih lanjut meningkatkan ketersediaan topologi, jadi jika salah satu unit sakelar tiba-tiba gagal karena kegagalan atau kesalahan administrator, yang kedua akan berfungsi secara normal, karena kedua perangkat ini tidak saling berhubungan.

Koneksi server yang ditunjukkan disebut koneksi ketersediaan tinggi, meskipun jumlah HBA yang lebih besar dapat diinstal di server jika perlu. Secara fisik, setiap server hanya memiliki dua koneksi di SAN, tetapi secara logis, sistem penyimpanan dapat diakses melalui empat jalur - setiap HBA menyediakan akses ke dua titik koneksi pada sistem penyimpanan, secara terpisah untuk setiap modul prosesor (fitur ini menyediakan koneksi ganda dari saklar ke sistem penyimpanan). Dalam diagram ini, perangkat yang paling tidak dapat diandalkan adalah server. Dua sakelar menyediakan keandalan urutan 99,99%, tetapi server mungkin gagal karena berbagai alasan. Jika diperlukan operasi keseluruhan sistem yang sangat andal, server digabungkan ke dalam cluster, diagram di atas tidak memerlukan penambahan perangkat keras untuk mengatur pekerjaan seperti itu dan dianggap sebagai skema referensi organisasi SAN. Kasus paling sederhana adalah server terhubung dalam satu cara melalui satu saklar ke sistem penyimpanan. Namun, sistem penyimpanan dengan dua modul prosesor harus terhubung ke sakelar dengan setidaknya satu saluran untuk setiap modul - port yang tersisa dapat digunakan untuk koneksi langsung server ke sistem penyimpanan, yang kadang-kadang diperlukan. Dan jangan lupa bahwa adalah mungkin untuk membangun SAN tidak hanya berdasarkan FibreChannel, tetapi juga berdasarkan protokol iSCSI - pada saat yang sama, Anda dapat menggunakan hanya perangkat ethernet standar untuk beralih, yang mengurangi biaya sistem, tetapi memiliki sejumlah minus tambahan (ditentukan pada bagian iSCSI di ) Yang juga menarik adalah kemampuan memuat server dari sistem penyimpanan - bahkan tidak perlu memiliki hard drive internal di server. Dengan demikian, tugas menyimpan data apa pun akhirnya dihapus dari server. Secara teori, server khusus dapat diubah menjadi penghancur angka biasa tanpa drive apa pun, blok yang menentukan di antaranya adalah prosesor pusat, memori, serta antarmuka untuk berinteraksi dengan dunia luar, seperti port Ethernet dan FibreChannel. Beberapa kemiripan perangkat tersebut adalah server blade modern.

Saya ingin mencatat bahwa perangkat yang dapat dihubungkan ke SAN tidak terbatas hanya pada sistem penyimpanan disk - mereka dapat menjadi perpustakaan disk, perpustakaan tape (streamer), perangkat untuk menyimpan data pada disk optik (CD / DVD, dll.) Dan banyak lainnya.

Dari minus SAN, kami hanya mencatat tingginya biaya komponennya, tetapi keuntungannya tidak bisa dipungkiri:

* Keandalan tinggi dari akses ke data yang terletak pada sistem penyimpanan eksternal. Kemandirian topologi SAN dari sistem penyimpanan dan server yang digunakan.

* Penyimpanan data terpusat (keandalan, keamanan).

* Manajemen switching dan data terpusat yang nyaman.

* Transfer lalu lintas I / O intensif ke jaringan terpisah, offloading LAN.

* Kecepatan tinggi dan latensi rendah.

* Skalabilitas dan fleksibilitas struktur logis San

* Secara geografis, ukuran SAN, tidak seperti DAS klasik, sebenarnya tidak terbatas.

* Kemampuan untuk dengan cepat mendistribusikan sumber daya antar server.

* Kemampuan untuk membangun solusi cluster toleran-kesalahan tanpa biaya tambahan berdasarkan SAN yang ada.

* Skema pencadangan sederhana - semua data ada di satu tempat.

* Kehadiran fitur dan layanan tambahan (foto, replikasi jarak jauh).

* SAN keamanan tinggi.

Kesimpulannya

Saya pikir kami telah membahas secara memadai berbagai masalah utama yang terkait dengan sistem penyimpanan modern. Mari berharap perangkat seperti itu akan berkembang lebih cepat secara fungsional, dan jumlah mekanisme pengelolaan data hanya akan bertambah.

Kesimpulannya, kita dapat mengatakan bahwa solusi NAS dan SAN saat ini sedang mengalami booming nyata. Jumlah produsen dan beragam solusi meningkat, dan literasi teknis konsumen meningkat. Kita dapat dengan aman berasumsi bahwa dalam waktu dekat di hampir setiap lingkungan komputasi, satu atau beberapa sistem penyimpanan data akan muncul.

Data apa pun muncul di hadapan kita dalam bentuk informasi. Arti kerja perangkat komputasi apa pun adalah pemrosesan informasi. Masuk baru-baru ini volume pertumbuhannya terkadang menakutkan, sehingga sistem penyimpanan dan perangkat lunak khusus tidak diragukan lagi akan menjadi produk IT yang paling dicari di tahun-tahun mendatang.

Bagaimana cara mengklasifikasikan arsitektur sistem penyimpanan? Tampak bagi saya bahwa relevansi masalah ini hanya akan tumbuh di masa depan. Bagaimana memahami semua jenis penawaran yang tersedia di pasaran? Saya ingin segera memperingatkan Anda bahwa posting ini tidak ditujukan untuk orang malas atau mereka yang tidak ingin banyak membaca.

Dimungkinkan untuk mengklasifikasikan sistem penyimpanan dengan cukup berhasil, mirip dengan bagaimana ahli biologi membangun ikatan keluarga antara spesies organisme hidup. Jika mau, Anda bisa menyebutnya "pohon kehidupan" dari dunia teknologi penyimpanan informasi.

Pembangunan pohon seperti itu membantu untuk lebih memahami dunia. Secara khusus, Anda dapat membangun diagram asal dan pengembangan semua jenis sistem penyimpanan, dan dengan cepat memahami apa yang menjadi dasar dari setiap teknologi baru yang muncul di pasar. Ini memungkinkan Anda untuk segera menentukan kekuatan dan kelemahan suatu solusi.

Gudang yang memungkinkan Anda bekerja dengan informasi dalam bentuk apa pun, secara arsitektur, dapat dibagi menjadi 4 kelompok utama. Hal utama adalah jangan terpaku pada beberapa hal yang membingungkan. Banyak orang cenderung mengklasifikasikan platform berdasarkan kriteria "fisik" seperti interkoneksi ("Mereka semua memiliki bus internal antar node!"), Atau protokol ("Ini adalah blok, atau NAS, atau sistem multi-protokol!"), atau dibagi menjadi perangkat keras dan perangkat lunak ("Ini hanya perangkat lunak di server!").

Itu pendekatan yang sepenuhnya salah untuk klasifikasi. Satu-satunya kriteria yang benar adalah arsitektur perangkat lunak yang digunakan dalam solusi tertentu, karena semua karakteristik dasar sistem bergantung padanya. Komponen yang tersisa dari sistem penyimpanan tergantung pada arsitektur perangkat lunak mana yang dipilih oleh pengembang. Dan dari sudut pandang ini, sistem "perangkat keras" dan "perangkat lunak" hanya dapat variasi arsitektur ini atau itu.

Tapi jangan salah paham, saya tidak ingin mengatakan bahwa perbedaan di antara mereka kecil. Itu tidak mendasar.

Dan saya ingin mengklarifikasi sesuatu yang lain sebelum saya memulai bisnis. Sudah lazim bagi sifat kita untuk mengajukan pertanyaan, "Dan manakah di antara ini yang terbaik / benar?". Hanya ada satu jawaban untuk ini: "Ada solusi yang lebih baik untuk situasi tertentu atau jenis beban kerja, tetapi tidak ada solusi ideal universal." Tepat fitur beban menentukan pilihan arsitektur, dan tidak ada yang lain.

Ngomong-ngomong, saya baru-baru ini berpartisipasi dalam percakapan lucu tentang topik pusat data yang bekerja secara eksklusif pada flash drive. Saya terkesan dengan hasrat dalam manifestasi apa pun, dan jelas bahwa flash melebihi kompetisi dalam situasi di mana kinerja dan latensi memainkan peran yang menentukan (di antara banyak faktor lain). Tetapi saya harus mengakui bahwa lawan bicara saya salah. Kami memiliki satu klien, banyak orang menggunakan layanannya setiap hari tanpa menyadarinya. Bisakah dia beralih ke flash sepenuhnya? Tidak.

Ini adalah pelanggan yang hebat. Dan ini satu lagi, BESAR, 10 kali lebih banyak. Dan lagi, saya tidak bisa setuju bahwa klien ini dapat beralih secara eksklusif ke flash:

Biasanya, sebagai tandingan, mereka mengatakan bahwa pada akhirnya flashdisk akan mencapai tingkat perkembangan yang sedemikian rupa sehingga akan menghilang drive magnetik. Dengan peringatan bahwa flash akan digunakan berpasangan dengan deduplikasi. Tetapi tidak dalam semua kasus disarankan untuk menerapkan deduplikasi, serta kompresi.

Nah, di satu sisi, memori flash akan menjadi lebih murah, hingga batas tertentu. Bagi saya sepertinya ini akan terjadi agak lebih cepat, tetapi SSD dengan kapasitas 1 TB seharga $ 550 sudah tersedia, ini adalah kemajuan besar. Tentu saja, pengembang hard drive tradisional juga tidak menganggur. Di wilayah 2017-2018, persaingan harus meningkat, karena teknologi baru akan diperkenalkan (kemungkinan besar, pergeseran fasa dan karbon nanotube). Tetapi intinya sama sekali bukan konfrontasi antara flash dan hard drive, atau bahkan solusi perangkat lunak dan perangkat keras, yang utama adalah arsitektur.

Sangat penting bahwa hampir tidak mungkin untuk mengubah arsitektur penyimpanan tanpa mengubah hampir semuanya. Itu sebenarnya, tanpa membuat sistem baru. Oleh karena itu, penyimpanan biasanya dibuat, dikembangkan, dan mati dalam kerangka arsitektur tunggal yang awalnya dipilih.

Empat jenis penyimpanan

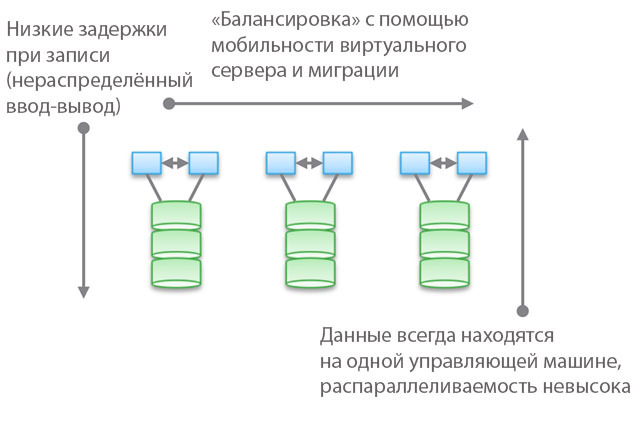

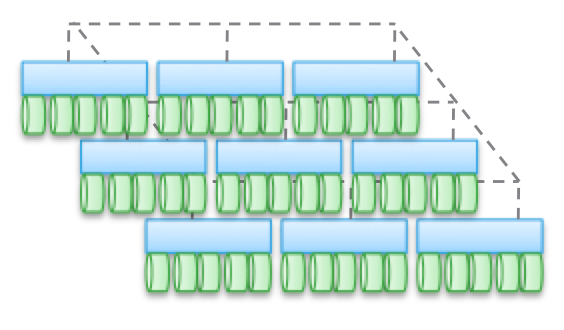

Tipe 1. Arsitektur Berkelompok. Mereka tidak dirancang untuk berbagi node memori, pada kenyataannya, semua data dalam satu node. Salah satu fitur arsitektur adalah bahwa kadang-kadang perangkat "memotong" (pelanggaran), bahkan jika mereka "dapat diakses dari beberapa node". Fitur lain adalah Anda dapat memilih mesin, memberi tahu beberapa drive dan mengatakan "mesin ini memiliki akses ke data di media ini." Warna biru pada gambar menunjukkan sistem CPU / memori / input-output, dan warna hijau menunjukkan media tempat data disimpan (flash atau drive magnetik).

Jenis arsitektur ini ditandai dengan akses langsung dan sangat cepat ke data. Akan ada sedikit keterlambatan antara mesin karena mirroring I / O dan caching digunakan untuk memastikan ketersediaan tinggi. Tetapi secara umum, akses yang relatif langsung disediakan di sepanjang cabang kode. Penyimpanan perangkat lunak cukup sederhana dan memiliki latensi rendah, sehingga seringkali memiliki fungsionalitas yang kaya, layanan data mudah ditambahkan. Tidak mengherankan, kebanyakan startup memulai dengan repositori seperti itu.

Harap dicatat bahwa salah satu jenis arsitektur ini adalah peralatan PCIe untuk server non-HA (Fusion-IO, kartu ekspansi XtremeCache). Jika kita menambahkan perangkat lunak penyimpanan terdistribusi, koherensi, dan model HA ke dalamnya, maka penyimpanan perangkat lunak tersebut akan sesuai dengan salah satu dari empat jenis arsitektur yang dijelaskan dalam posting ini.

Penggunaan "model gabungan" membantu meningkatkan skalabilitas horizontal dari jenis arsitektur ini dari sudut pandang manajemen. Model-model ini dapat menggunakan pendekatan berbeda untuk meningkatkan mobilitas data untuk menyeimbangkan kembali antara mesin host dan penyimpanan. Misalnya, dalam VNX, ini berarti "mobilitas VDM". Tapi saya pikir menyebutnya "arsitektur yang dapat diskalakan secara horizontal" akan menjadi hal yang berat. Dan, dalam pengalaman saya, sebagian besar pelanggan berbagi pandangan ini. Alasan untuk ini adalah lokasi data pada satu mesin kontrol, kadang-kadang - "dalam kabinet perangkat keras" (di belakang selungkup). Mereka dapat dipindahkan, tetapi mereka akan selalu berada di satu tempat. Di satu sisi, ini memungkinkan Anda untuk mengurangi jumlah siklus dan penundaan perekaman. Di sisi lain, semua data Anda dilayani oleh mesin kontrol tunggal (akses tidak langsung dari mesin lain dimungkinkan). Berbeda dengan jenis arsitektur kedua dan ketiga, yang akan kita bahas di bawah ini, menyeimbangkan dan menyetel memainkan peran penting di sini.

Secara obyektif, tingkat federal abstrak ini memerlukan sedikit peningkatan latensi karena menggunakan pengalihan perangkat lunak. Ini mirip dengan menyulitkan kode dan meningkatkan latensi dalam jenis arsitektur 2 dan 3, dan sebagian menghilangkan kelebihan dari tipe pertama. Sebagai contoh nyata, UCS Invicta, semacam "Silicon Storage Routers". Dalam kasus NetApp FAS 8.x, bekerja dalam mode cluster, kodenya cukup rumit dengan diperkenalkannya model gabungan.

Produk yang menggunakan arsitektur cluster - VNX atau NetApp FAS, Pure, Tintri, Nimble, Nexenta, dan (saya pikir) UCS Invicta / UCS. Beberapa adalah "perangkat keras" solusi, yang lain adalah "perangkat lunak murni", dan yang lain adalah "perangkat lunak dalam bentuk kompleks perangkat keras". Semuanya sangat berbeda dalam hal pemrosesan data (dalam Pure dan UCS Invicta / Whiptail, hanya flash drive yang digunakan). Namun secara arsitektur, semua produk yang terdaftar terkait. Misalnya, Anda mengonfigurasikan layanan pemrosesan data khusus untuk cadangan, tumpukan perangkat lunak menjadi Domain Data, NAS Anda bertindak sebagai alat cadangan terbaik di dunia - dan ini juga merupakan arsitektur "tipe pertama".

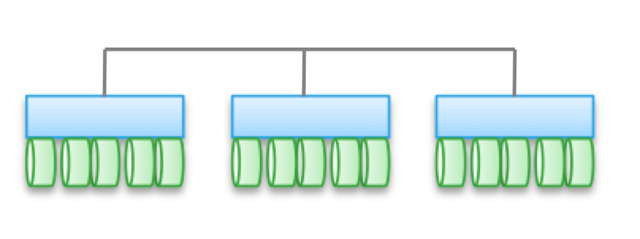

Tipe 2. Arsitektur lemah, skala horizontal. Node tidak berbagi memori, tetapi data itu sendiri untuk beberapa node. Arsitektur ini mengimplikasikan penggunaan lebih lanjut koneksi internal untuk merekam data, yang meningkatkan jumlah siklus. Meskipun operasi tulis didistribusikan, mereka selalu koheren.

Perhatikan bahwa arsitektur ini tidak menyediakan ketersediaan tinggi untuk node karena menyalin dan operasi distribusi data. Untuk alasan yang sama, selalu ada lebih banyak operasi I / O dibandingkan dengan arsitektur cluster sederhana. Jadi kinerjanya sedikit lebih rendah, meskipun tingkat penundaan perekaman kecil (NVRAM, SSD, dll.).

Dalam beberapa jenis arsitektur, node sering dirakit menjadi subkelompok, sedangkan sisanya digunakan untuk mengelola subkelompok (metadata node). Tetapi efek yang dijelaskan di atas untuk "model gabungan" dimanifestasikan di sini.

Arsitektur seperti itu cukup mudah untuk diukur. Karena data disimpan di beberapa tempat dan dapat diproses oleh banyak node, arsitektur ini dapat menjadi sangat bagus untuk tugas-tugas ketika pembacaan terdistribusi diperlukan. Selain itu, mereka bergabung dengan baik dengan perangkat lunak server / penyimpanan. Tetapi yang terbaik adalah menggunakan arsitektur serupa di bawah beban transaksional: karena sifatnya yang terdistribusi, Anda tidak dapat menggunakan server HA, dan konjugasi yang lemah memungkinkan Anda untuk mem-bypass Ethernet.

Jenis arsitektur ini digunakan dalam produk-produk seperti EMC ScaleIO dan Isilon, VSAN, Nutanix, dan Simplivity. Seperti dalam kasus Tipe 1, semua solusi ini sangat berbeda satu sama lain.

Konektivitas yang lemah berarti bahwa seringkali arsitektur ini dapat secara signifikan meningkatkan jumlah node. Tapi, izinkan saya mengingatkan Anda, mereka TIDAK menggunakan memori bersama, kode setiap node bekerja secara independen dari yang lain. Tetapi iblis, sebagaimana yang mereka katakan, secara terperinci:

- Semakin banyak operasi perekaman didistribusikan, semakin tinggi latensi dan semakin rendah efisiensi TIO. Misalnya, di Isilon, tingkat distribusi sangat tinggi untuk file, dan meskipun dengan setiap pembaruan penundaan berkurang, tetapi tetap saja tidak akan pernah menunjukkan kinerja tertinggi. Tetapi Isilon sangat kuat dalam hal paralelisasi.

- Jika Anda mengurangi tingkat distribusi (meskipun dengan sejumlah besar node), maka penundaan mungkin berkurang, tetapi pada saat yang sama Anda akan mengurangi kemampuan Anda untuk memparalelkan pembacaan data. Sebagai contoh, VSAN menggunakan model "mesin virtual sebagai objek", yang memungkinkan Anda untuk menjalankan banyak salinan. Tampaknya mesin virtual harus dapat diakses oleh host tertentu. Tetapi, pada kenyataannya, dalam VSAN itu "bergeser" ke arah simpul yang menyimpan datanya. Jika Anda menggunakan solusi ini, Anda dapat melihat sendiri bagaimana meningkatkan jumlah salinan suatu objek mempengaruhi operasi latensi dan I / O di seluruh sistem. Petunjuk: lebih banyak salinan \u003d beban yang lebih tinggi pada sistem secara keseluruhan, dan ketergantungannya adalah non-linear, seperti yang Anda harapkan. Tetapi untuk VSAN, ini bukan masalah karena keunggulan mesin virtual sebagai model objek.

- Dimungkinkan untuk mencapai latensi rendah dalam kondisi skala tinggi dan paralelisasi selama membaca, tetapi hanya jika data dan penulisan dipisahkan secara tepat. sejumlah besar salinan. Pendekatan ini digunakan dalam ScaleIO. Setiap volume dibagi menjadi sejumlah besar fragmen (1 MB secara default), yang didistribusikan di semua node yang terlibat. Hasilnya adalah kecepatan baca dan redistribusi yang sangat tinggi bersama dengan paralelisasi yang kuat. Penundaan penulisan dapat kurang dari 1 ms saat menggunakan infrastruktur jaringan yang sesuai dan SSD / PCIe Flash di node cluster. Namun, setiap operasi penulisan dilakukan dalam dua node. Tentu saja, tidak seperti VSAN, mesin virtual tidak dianggap objek di sini. Tetapi jika dipertimbangkan, maka skalabilitas akan lebih buruk.

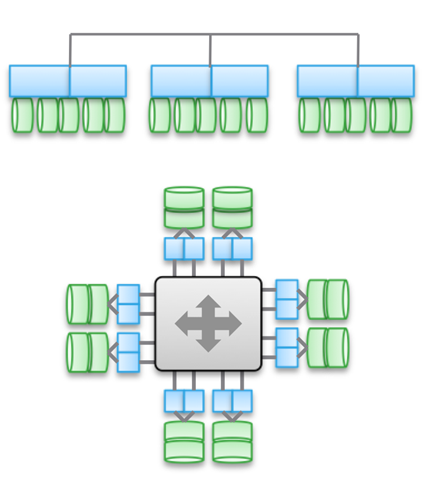

Tipe 3. Arsitektur yang sangat terhubung, berskala horizontal. Ini menggunakan berbagi memori (untuk caching dan beberapa jenis metadata). Data didistribusikan di berbagai node. Jenis arsitektur ini melibatkan penggunaan sejumlah besar koneksi internode untuk semua jenis operasi.

Berbagi memori adalah landasan arsitektur ini. Secara historis, melalui semua mesin kontrol, operasi I / O simetris dapat dilakukan (lihat ilustrasi). Ini memungkinkan Anda untuk menyeimbangkan kembali beban jika terjadi kerusakan. Gagasan ini diletakkan di dasar produk seperti Symmetrix, IBM DS, HDS USP dan VSP. Mereka menyediakan akses bersama ke cache, sehingga prosedur I / O dapat dikontrol dari mesin apa pun.

Diagram teratas dalam ilustrasi mencerminkan arsitektur EMC XtremIO. Sepintas, mirip dengan Tipe 2, tetapi sebenarnya tidak. Dalam hal ini, model metadata terdistribusi bersama menyiratkan penggunaan IB dan akses memori langsung jarak jauh sehingga semua node memiliki akses ke metadata. Selain itu, setiap node adalah pasangan HA. Seperti yang Anda lihat, Isilon dan XtremIO sangat berbeda secara arsitektur, meskipun ini tidak begitu jelas. Ya, keduanya memiliki arsitektur skala horizontal, dan keduanya menggunakan IB untuk interkoneksi. Tetapi di Isilon, tidak seperti XtremIO, ini dilakukan untuk meminimalkan latensi saat bertukar data antar node. Dimungkinkan juga untuk menggunakan Ethernet di Isilon untuk komunikasi antar node (pada kenyataannya, ini adalah bagaimana mesin virtual bekerja di dalamnya), tetapi ini meningkatkan penundaan dalam operasi input-output. Sedangkan untuk XtremIO, akses memori langsung jarak jauh sangat penting untuk kinerjanya.

Ngomong-ngomong, jangan tertipu oleh kehadiran dua diagram dalam ilustrasi - pada kenyataannya, mereka adalah sama secara arsitektur. Dalam kedua kasus, pasangan pengontrol HA, memori bersama, dan interkoneksi latensi sangat rendah digunakan. By the way, VMAX menggunakan bus antar-komponen berpemilik, tetapi di masa depan akan mungkin untuk menggunakan IB.

Arsitektur berpasangan tinggi ditandai oleh kompleksitas tinggi kode program. Ini adalah salah satu alasan rendahnya prevalensi mereka. Kompleksitas perangkat lunak yang berlebihan juga memengaruhi jumlah layanan pemrosesan data yang ditambahkan, karena ini adalah tugas komputasi yang lebih sulit.

Keuntungan dari jenis arsitektur ini termasuk toleransi kesalahan (I / O simetris di semua mesin kontrol), serta, dalam kasus XtremIO, peluang besar di bidang AFA. Setelah kita berbicara tentang XtremIO lagi, perlu disebutkan bahwa arsitekturnya menyiratkan distribusi semua layanan pemrosesan data. Ini juga satu-satunya solusi AFA di pasaran dengan arsitektur yang diskalakan secara horizontal, meskipun node penambah / penonaktifan dinamis belum diterapkan. Antara lain, XtremIO menggunakan deduplikasi "alami", yaitu, ia selalu aktif dan "bebas" dalam hal kinerja. Benar, semua ini meningkatkan kompleksitas pemeliharaan sistem.

Penting untuk memahami perbedaan mendasar antara Tipe 2 dan Tipe 3. Semakin banyak arsitektur yang saling berhubungan, semakin baik dan lebih dapat diprediksi untuk memastikan latensi rendah. Di sisi lain, dalam kerangka arsitektur seperti itu, lebih sulit untuk menambahkan node dan skala sistem. Lagi pula, ketika Anda menggunakan akses bersama ke memori, itu adalah sistem terdistribusi tunggal, sangat terkonjugasi. Kompleksitas keputusan tumbuh, dan dengan itu kemungkinan kesalahan. Karenanya, VMAX dapat memiliki hingga 16 mobil kontrol dalam 8 mesin, dan XtemIO - hingga 8 mobil dalam 4 X-Brick (akan segera meningkat menjadi 16 mobil dalam 8 blok). Melipatgandakan, atau bahkan menggandakan arsitektur ini adalah tantangan teknik yang sangat sulit. Sebagai perbandingan, VSAN dapat diskalakan ke "vSphere cluster size" (sekarang 32 node), Isilon dapat berisi lebih dari 100 node, dan ScaleIO memungkinkan Anda untuk membuat sistem lebih dari 1000 node. Apalagi semua ini adalah arsitektur tipe kedua.

Sekali lagi, saya ingin menekankan bahwa arsitektur adalah implementasi yang independen. Produk di atas menggunakan Ethernet dan IB. Beberapa murni solusi perangkat lunak, yang lain kompleks perangkat keras-perangkat lunak, tetapi pada saat yang sama mereka disatukan oleh skema arsitektur.

Meskipun beragam interkoneksi, penggunaan rekaman yang didistribusikan memainkan peran penting dalam semua contoh yang diberikan. Ini memungkinkan Anda untuk mencapai transaksionalitas dan atomisitas, tetapi pemantauan integritas data yang cermat diperlukan. Hal ini juga diperlukan untuk menyelesaikan masalah pertumbuhan “area kegagalan”. Kedua titik ini membatasi tingkat penskalaan maksimum yang mungkin dari jenis arsitektur yang dijelaskan.

Cek kecil tentang seberapa cermat Anda membaca semua hal di atas: Apa jenis Cisco UCS Invicta - 1 atau 3? Secara fisik, sepertinya Tipe 3, tetapi ini adalah satu set server USC C-series yang terhubung melalui Ethernet, menjalankan tumpukan perangkat lunak Invicta (sebelumnya Whiptail). Petunjuk: lihat arsitektur, bukan implementasi spesifik 🙂

Dalam kasus UCS Invicta, data disimpan di setiap node (server UCS dengan flash drive berdasarkan MLC). Node tunggal non-HA, yang merupakan server terpisah, dapat langsung mengirimkan nomor unit logis (LUN). Jika Anda memutuskan untuk menambahkan lebih banyak node, ada kemungkinan sistem ini memiliki skala yang buruk, seperti ScaleIO atau VSAN. Semua ini membawa kita ke Tipe 2.

Namun, peningkatan jumlah node, tampaknya, dilakukan melalui konfigurasi dan migrasi ke "Invicta Scaling Appliance". Dengan konfigurasi ini, Anda memiliki beberapa "Silicon Storage Routers" (SSR) dan penyimpanan alamat beberapa node perangkat keras. Data diakses melalui node SSR tunggal, tetapi ini dapat dilakukan melalui node lain yang berfungsi sebagai pasangan HA. Data itu sendiri selalu pada satu-satunya simpul UCS dalam seri C. Jadi, arsitektur seperti apa ini? Tidak peduli seperti apa solusinya secara fisik, itu adalah Tipe 1. SSR adalah sebuah cluster (mungkin lebih dari 2). Dalam konfigurasi Scaling Appliance, setiap server UCS dengan drive MLC melakukan fungsi yang mirip dengan penyimpanan disk VNX atau NetApp FAS. Meskipun tidak terhubung melalui SAS, arsitekturnya mirip.

Tipe 4. Arsitektur terdistribusi tanpa berbagi sumber daya apa pun. Terlepas dari kenyataan bahwa data didistribusikan di berbagai node, ini dilakukan tanpa transaksionalitas. Biasanya, data disimpan pada satu node dan tinggal di sana, dan dari waktu ke waktu salinan dibuat pada node lain, demi keamanan. Tetapi salinan ini tidak transaksional. Ini adalah perbedaan utama antara tipe arsitektur ini dan Tipe 2 dan 3.

Komunikasi antara non-HA node adalah melalui Ethernet, karena murah dan universal. Distribusi berdasarkan node adalah wajib dan dari waktu ke waktu. "Kebenaran" data tidak selalu dihormati, tetapi tumpukan perangkat lunak diperiksa cukup sering untuk memastikan kebenaran data yang digunakan. Untuk beberapa jenis beban (misalnya, HDFS), data didistribusikan sehingga berada di memori pada saat yang sama dengan proses yang diperlukan. Properti ini memungkinkan kami untuk mempertimbangkan jenis arsitektur ini sebagai yang paling terukur di antara keempatnya.

Tapi ini jauh dari keuntungan satu-satunya. Arsitektur seperti itu sangat sederhana, sangat mudah dikelola. Mereka sama sekali tidak bergantung pada peralatan dan dapat digunakan pada perangkat keras termurah. Ini hampir selalu merupakan solusi perangkat lunak eksklusif. Jenis arsitektur ini mudah ditangani dengan petabyte data seperti terabyte dengan data lainnya. Objek dan sistem file non-POSIX digunakan di sini, dan keduanya sering terletak di atas sistem file lokal setiap node biasa.

Arsitektur ini dapat dikombinasikan dengan blok dan model transaksional dari presentasi data berdasarkan NAS, tetapi ini sangat membatasi kemampuan mereka. Tidak perlu membuat tumpukan transaksional dengan menempatkan Tipe 1, 2, atau 3 di atas Tipe 4.

Terbaik dari semua, arsitektur ini adalah "terungkap" pada tugas-tugas yang beberapa batasannya tidak aneh.

Di atas, saya memberi contoh dengan klien yang sangat besar dengan 200.000 drive. Layanan seperti Dropbox, Syncplicity, iCloud, Facebook, eBay, YouTube dan hampir semua proyek Web 2.0 didasarkan pada repositori yang dibangun menggunakan jenis arsitektur keempat. Semua informasi yang diproses dalam kelompok Hadoop juga terkandung dalam fasilitas penyimpanan Tipe 4. Secara umum, di segmen perusahaan ini bukan arsitektur yang sangat umum, tetapi mereka dengan cepat mendapatkan popularitas.

Tipe 4 adalah dasar dari produk-produk seperti AWS S3 (omong-omong, tidak ada orang di luar AWS yang tahu cara kerja EBS, tetapi saya bersedia menyatakan bahwa itu adalah Tipe 3), Haystack (digunakan di Facebook), Atmos, ViPR, Ceph, Swift ( digunakan dalam Openstack), HDFS, Centera. Banyak produk yang terdaftar dapat mengambil bentuk yang berbeda, jenis implementasi spesifik ditentukan menggunakan API mereka. Misalnya, tumpukan objek ViPR dapat diimplementasikan melalui S3, Swift, Atmos, dan bahkan API objek HDFS! Dan di masa depan, Centera juga akan ada dalam daftar ini. Untuk beberapa orang, ini akan menjadi jelas, tetapi Atmos dan Centera akan digunakan untuk waktu yang lama, dalam bentuk API, dan bukan produk tertentu. Implementasi dapat berubah, tetapi API tetap tidak tergoyahkan, yang sangat baik untuk pelanggan.

Saya ingin menarik perhatian Anda sekali lagi pada kenyataan bahwa "perwujudan fisik" dapat membingungkan Anda, dan Anda akan keliru mengklasifikasikan arsitektur Tipe 4 sebagai Tipe 2, karena mereka sering terlihat sama. Pada tingkat fisik, solusi mungkin terlihat seperti ScaleIO, VSAN, atau Nutanix, meskipun ini hanya akan menjadi server Ethernet. Dan ada atau tidak adanya transaksionalitas akan membantu untuk mengklasifikasikan solusi tertentu dengan benar.

Dan sekarang saya menawarkan tes verifikasi kedua. Mari kita lihat arsitektur UCS Invicta. Secara fisik, produk ini terlihat seperti Tipe 4 (server yang terhubung melalui Ethernet), tetapi tidak mungkin untuk menskalakannya secara arsitektural dengan beban yang sesuai, karena sebenarnya adalah Tipe 1. Selain itu, Invicta, seperti Pure, dikembangkan untuk AFA.

Mohon terima kasih yang tulus atas waktu dan perhatian Anda jika Anda telah membaca di tempat ini. Saya membaca ulang di atas - sungguh menakjubkan bahwa saya berhasil menikah dan punya anak 🙂

Mengapa saya menulis semua ini?

Di dunia penyimpanan TI, mereka menempati tempat yang sangat penting, semacam "kerajaan jamur." Variasi produk yang ditawarkan sangat besar, dan ini hanya menguntungkan seluruh bisnis. Tetapi Anda harus bisa memahami semua ini, jangan biarkan diri Anda dikaburkan oleh slogan pemasaran dan nuansa positioning. Untuk kepentingan pelanggan dan industri itu sendiri, perlu untuk menyederhanakan proses penyimpanan bangunan. Oleh karena itu, kami bekerja keras untuk menjadikan pengendali ViPR platform terbuka dan bebas.

Tetapi repositori itu sendiri tidak mengasyikkan. Apa yang saya maksud Bayangkan semacam piramida abstrak, yang di atasnya adalah "pengguna". Di bawah ini adalah "aplikasi" yang dirancang untuk melayani "pengguna". Bahkan yang lebih rendah adalah "infrastruktur" (termasuk SDDC) yang melayani "aplikasi" dan, oleh karena itu, "pengguna". Dan di bagian paling bawah dari "infrastruktur" adalah repositori.

Artinya, Anda dapat membayangkan hierarki dalam bentuk ini: Pengguna-\u003e Aplikasi / SaaS-\u003e PaaS-\u003e IaaS-\u003e Infrastruktur. Jadi: pada akhirnya, aplikasi apa pun, tumpukan PaaS apa pun harus menghitung atau memproses beberapa jenis informasi. Dan keempat jenis arsitektur ini dirancang untuk bekerja dengan berbagai jenis informasi, berbagai jenis muatan. Dalam hierarki kepentingan, informasi segera mengikuti pengguna. Tujuan dari keberadaan aplikasi adalah untuk memungkinkan pengguna untuk berinteraksi dengan informasi yang dibutuhkannya. Itulah sebabnya arsitektur penyimpanan sangat penting di dunia kita.

Entri ini diposting di Uncategorized oleh penulis. Tandai itu.Dan hal-hal lain, media transmisi data dan server yang terhubung dengannya. Ini biasanya digunakan oleh perusahaan yang cukup besar dengan infrastruktur TI yang dikembangkan dengan baik untuk penyimpanan data yang andal dan akses berkecepatan tinggi untuk mereka.

Sederhana, penyimpanan adalah sistem yang memungkinkan Anda mendistribusikan server yang andal drive cepat kapasitansi variabel dengan perangkat yang berbeda penyimpanan data.

Sedikit teori.

Server dapat dihubungkan ke gudang data dalam beberapa cara.

Yang pertama dan paling sederhana adalah DAS, Direct Attached Storage (koneksi langsung), kami memasukkan drive ke server, atau array ke adaptor server, dan kami mendapatkan banyak gigabytes ruang disk dengan relatif akses cepat, dan saat menggunakan array RAID - keandalan yang memadai, meskipun tombak pada topik keandalan telah rusak sejak lama.

Namun, penggunaan ruang disk ini tidak optimal - di satu server tempat habis, di sisi lain masih banyak. Solusi untuk masalah ini adalah NAS, Network Attached Storage (penyimpanan yang terpasang di jaringan). Namun, dengan semua keunggulan solusi ini - fleksibilitas dan manajemen terpusat - ada satu kelemahan signifikan - kecepatan akses, jaringan 10 gigabit belum diimplementasikan di semua organisasi. Dan kami mendekati jaringan penyimpanan.

Perbedaan utama antara SAN dan NAS (selain urutan huruf dalam singkatan) adalah bagaimana sumber daya yang terhubung terlihat di server. Jika sumber daya NAS terhubung ke protokol NFS atau SMB, di SAN kami mendapatkan koneksi ke disk, yang dengannya kami dapat bekerja di tingkat operasi blok I / O, yang jauh lebih cepat koneksi jaringan (ditambah pengontrol array dengan cache besar menambah kecepatan pada banyak operasi).

Menggunakan SAN, kami menggabungkan keunggulan DAS - kecepatan dan kesederhanaan, dan NAS - fleksibilitas dan kemampuan kontrol. Plus, kami mendapatkan kemampuan untuk skala sistem penyimpanan sampai ada cukup uang, sementara secara bersamaan membunuh beberapa burung dengan satu batu, yang tidak segera terlihat:

* menghapus batasan pada jangkauan koneksi perangkat SCSI, yang biasanya terbatas pada kabel 12 meter,

* mengurangi waktu cadangan,

* kita bisa boot dari SAN,

* Dalam hal penolakan dari NAS kami membongkar jaringan,

* kami mendapatkan kecepatan input-output tinggi karena optimasi di sisi sistem penyimpanan,

* kami mendapat kesempatan untuk menghubungkan beberapa server ke satu sumber daya, ini memberi kami dua burung berikut dengan satu batu:

- Kami sepenuhnya menggunakan kemampuan VMWare - misalnya, VMotion (migrasi mesin virtual antara mesin fisik) dan lainnya seperti mereka,

- kita dapat membangun cluster yang toleran terhadap kesalahan dan mengatur jaringan yang didistribusikan secara geografis.

Apa yang diberikannya?

Selain mengembangkan anggaran untuk mengoptimalkan sistem penyimpanan, kami mendapatkan, di samping apa yang saya tulis di atas:

* peningkatan produktivitas, penyeimbangan muatan, dan ketersediaan tinggi sistem penyimpanan karena beberapa cara untuk mengakses array;

* penghematan pada disk dengan mengoptimalkan lokasi informasi;

* pemulihan yang dipercepat dari kegagalan - Anda dapat membuat sumber daya sementara, menyebarkan cadangan ke mereka dan menghubungkan server ke mereka, dan memulihkan informasi sendiri tanpa tergesa-gesa, atau mentransfer sumber daya ke server lain dan dengan tenang menangani besi mati;

* Pengurangan waktu cadangan - berkat kecepatan transfer yang tinggi, Anda dapat membuat cadangan ke perpustakaan tape lebih cepat, atau bahkan mengambil snapshot (snapshot) dari sistem file dan mengarsipkannya dengan aman;

* ruang disk sesuai permintaan - saat kami membutuhkannya - Anda selalu dapat menambahkan beberapa rak ke sistem penyimpanan.

* mengurangi biaya penyimpanan satu megabyte informasi - tentu saja, ada batas tertentu dari mana sistem ini hemat biaya.

* Tempat yang dapat diandalkan untuk menyimpan data penting misi dan bisnis kritis (tanpanya organisasi tidak dapat eksis dan berfungsi secara normal).

* Saya ingin menyebutkan VMWare secara terpisah - semua chip seperti migrasi mesin virtual dari server ke server dan barang lainnya hanya tersedia di SAN.

Terdiri dari apa itu?

Seperti yang saya tulis di atas - SHD terdiri dari perangkat penyimpanan, media transmisi dan server yang terhubung. Mari kita pertimbangkan secara berurutan:

Sistem penyimpanan data biasanya terdiri dari hard drive dan pengontrol, dalam sistem yang menghargai diri sendiri, biasanya hanya 2 - 2 pengontrol, 2 jalur untuk setiap drive, 2 antarmuka, 2 catu daya, 2 administrator. Di antara produsen sistem yang paling dihormati, disebutkan harus dibuat dari HP, IBM, EMC, dan Hitachi. Di sini saya akan mengutip salah satu perwakilan EMC di seminar - “HP membuat printer yang sangat baik. Baiklah, biarkan dia membuatnya! ”Saya curiga HP juga menyukai EMC. Akan tetapi, persaingan antara produsen sangat serius, seperti di tempat lain. Konsekuensi dari persaingan kadang-kadang harga waras per megabyte sistem penyimpanan dan masalah dengan kompatibilitas dan dukungan standar pesaing, terutama untuk peralatan lama.

Media transfer data.

Biasanya, SAN dibangun di atas optik, yang saat ini memberikan kecepatan 4, kadang-kadang 8 gigabit per saluran. Ketika membangun, hub khusus digunakan sebelumnya, sekarang ada lebih banyak switch, terutama dari Qlogic, Brocade, McData, dan Cisco (saya belum pernah melihat dua yang terakhir di situs). Kabel digunakan secara tradisional untuk jaringan optik - mode tunggal dan multi mode, mode tunggal lebih lama.

Di dalam, FCP digunakan - Fibre Channel Protocol, sebuah protokol transport. Biasanya, SCSI klasik berjalan di dalamnya, dan FCP menyediakan pengalamatan dan pengiriman. Ada opsi dengan menghubungkan melalui jaringan biasa dan iSCSI, tetapi biasanya menggunakan (dan banyak memuat) lokal, dan tidak didedikasikan untuk jaringan transfer data, dan memerlukan adaptor dengan dukungan iSCSI, well, kecepatannya lebih lambat daripada di optik.

Ada juga topologi kata yang cerdas, yang ditemukan di semua buku teks di SAN. Ada beberapa topologi, opsi paling sederhana adalah point to point, kami menghubungkan 2 sistem. Ini bukan DAS, tetapi kuda bulat dalam ruang hampa adalah versi paling sederhana dari SAN. Berikutnya adalah loop terkontrol (FC-AL), ia bekerja dengan prinsip "meneruskan" - pemancar setiap perangkat terhubung ke penerima yang berikutnya, perangkat ditutup dalam sebuah cincin. Rantai panjang cenderung diinisialisasi untuk waktu yang lama.

Nah, opsi terakhir adalah fabric diaktifkan (Fabric), dibuat menggunakan switch. Struktur koneksi dibangun tergantung pada jumlah port yang terhubung, seperti dalam pembangunan jaringan lokal. Prinsip dasar konstruksi adalah bahwa semua jalur dan koneksi digandakan. Ini berarti bahwa setidaknya ada 2 jalur berbeda untuk setiap perangkat di jaringan. Di sini, kata topologi juga digunakan, dalam arti mengatur diagram koneksi perangkat dan menghubungkan switch. Dalam hal ini, sebagai suatu peraturan, switch dikonfigurasikan sehingga server tidak melihat apa pun selain sumber daya yang ditujukan untuk mereka. Ini dicapai dengan membuat jaringan virtual dan disebut zonasi, analoginya yang paling dekat adalah VLAN. Setiap perangkat di jaringan diberi alamat MAC analog pada jaringan Ethernet, itu disebut WWN - World Wide Name. Ini ditugaskan untuk setiap antarmuka dan setiap sumber daya (LUN) dari sistem penyimpanan. Susunan dan sakelar dapat membedakan antara akses WWN untuk server.

Server Terhubung ke penyimpanan melalui HBA - Host Bus Adapters. Dengan analogi dengan kartu jaringan, ada satu, dua, dan empat port adaptor. "Peternak anjing" terbaik merekomendasikan untuk memasang 2 adapter per server, ini memungkinkan penyeimbangan muatan dan keandalan.

Dan kemudian sumber daya dipotong ke dalam sistem penyimpanan, mereka adalah LUN untuk setiap server dan tempat tersisa di cadangan, semuanya dihidupkan, installer sistem meresepkan topologi, menangkap gangguan dalam konfigurasi sakelar dan akses, semuanya dimulai dan semua orang hidup bahagia selamanya *.

Saya secara khusus tidak menyentuh berbagai jenis port di jaringan optik, siapa pun yang membutuhkannya - dia sudah tahu atau membaca, siapa yang tidak membutuhkannya - cukup palu kepalanya. Tapi seperti biasa, jika jenis port tidak diatur dengan benar, tidak ada yang akan berhasil.

Dari pengalaman.

Biasanya, ketika membuat SAN, array dengan beberapa jenis disk dipesan: FC untuk aplikasi kecepatan tinggi, dan SATA atau SAS untuk yang tidak terlalu cepat. Dengan demikian, 2 kelompok disk dengan biaya megabyte berbeda diperoleh - mahal dan cepat, dan lambat dan sedih murah. Biasanya, semua database dan aplikasi lain dengan I / O yang aktif dan cepat digantung pada yang cepat, sementara sumber daya file dan yang lainnya digantung pada yang lambat.

Jika SAN dibuat dari awal, masuk akal untuk membangunnya berdasarkan solusi dari satu produsen. Faktanya adalah bahwa, meskipun dinyatakan sesuai dengan standar, ada garu bawah air dari masalah kompatibilitas peralatan, dan bukan fakta bahwa bagian dari peralatan akan bekerja satu sama lain tanpa menari dengan rebana dan berkonsultasi dengan produsen. Biasanya, untuk mengatasi masalah seperti itu, lebih mudah untuk memanggil integrator dan memberinya uang daripada berkomunikasi dengan produsen yang mengganti panah.

Jika SAN dibuat berdasarkan infrastruktur yang ada, semuanya bisa rumit, terutama jika ada array SCSI lama dan kebun binatang teknologi lama dari produsen yang berbeda. Dalam hal ini, masuk akal untuk meminta bantuan dari binatang buas integrator yang akan mengungkap masalah kompatibilitas dan membuat vila ketiga di Kepulauan Canary.

Seringkali saat membuat sistem penyimpanan, perusahaan tidak memesan dukungan pabrikan untuk sistem tersebut. Ini biasanya dibenarkan jika perusahaan memiliki staf admin kompeten yang kompeten (yang telah memanggil saya teko 100 kali) dan jumlah modal yang wajar, yang memungkinkan untuk membeli suku cadang dalam jumlah yang diperlukan. Namun, administrator yang kompeten biasanya dibujuk oleh integrator (saya melihatnya sendiri), tetapi mereka tidak mengalokasikan uang untuk pembelian, dan setelah kegagalan, sebuah sirkus dimulai dengan teriakan "Biarkan saya memecat semua orang!" Alih-alih memanggil dukungan dan insinyur tiba dengan suku cadang.

Dukungan biasanya muncul untuk mengganti disk dan pengontrol yang mati, dan menambahkan rak disk dan server baru ke sistem. Banyak masalah terjadi setelah pencegahan mendadak sistem oleh spesialis lokal, terutama setelah shutdown total dan perakitan-pembongkaran sistem (dan ini terjadi).

Tentang VMWare. Sejauh yang saya tahu (spesialis virtualisasi mengoreksi saya), hanya VMWare dan Hyper-V yang memiliki fungsi yang memungkinkan Anda untuk mentransfer mesin virtual antara server fisik dengan cepat. Dan untuk implementasinya, diperlukan bahwa semua server di mana mesin virtual bergerak terhubung ke disk yang sama.

Tentang cluster. Mirip dengan kasus dengan VMWare, sistem yang saya tahu membangun cluster failover (Sun Cluster, Veritas Cluster Server) yang saya tahu memerlukan penyimpanan yang terhubung ke semua sistem.

Saat menulis artikel - mereka bertanya kepada saya - di mana RAID drive biasanya menggabungkan?

Dalam praktik saya, mereka biasanya membuat RAID 1 + 0 pada setiap rak disk dengan disk FC, meninggalkan 1 disk cadangan (Hot Spare) dan memotong LUN dari bagian ini untuk tugas, atau melakukan RAID5 dari disk lambat, lagi-lagi menyisakan 1 disk untuk penggantian. Tapi di sini pertanyaannya kompleks, dan biasanya cara mengatur disk dalam array dipilih untuk setiap situasi dan dibenarkan. EMC yang sama, misalnya, bahkan melangkah lebih jauh, dan mereka memiliki pengaturan array tambahan untuk aplikasi yang bekerja dengannya (misalnya, di bawah OLTP, OLAP). Saya tidak menggali terlalu dalam dengan vendor lain, tapi saya kira setiap orang memiliki penyesuaian.

* sebelum kegagalan besar pertama, setelah itu biasanya dukungan dibeli dari pabrikan atau pemasok sistem.

DAS, SAN, NAS - singkatan ajaib, yang tanpanya tidak satu artikel atau studi analitik tunggal dari sistem penyimpanan dapat dilakukan. Mereka berfungsi sebagai penunjukan jenis koneksi utama antara sistem penyimpanan dan sistem komputasi.

Das (penyimpanan terpasang langsung) - perangkat memori eksternalterhubung langsung ke komputer utama dan hanya digunakan olehnya. Contoh paling sederhana dari DAS adalah built-in hard drive. Untuk menghubungkan host dengan memori eksternal dalam konfigurasi DAS tipikal, SCSI digunakan, perintah yang memungkinkan Anda untuk memilih blok data tertentu pada disk yang ditentukan atau memasang kartrid tertentu di perpustakaan tape.

Konfigurasi DAS dapat diterima untuk persyaratan penyimpanan, kapasitas, dan keandalan. DAS tidak menyediakan kemampuan untuk berbagi kapasitas penyimpanan antara host yang berbeda, dan bahkan lebih sedikit lagi kemampuan untuk berbagi data. Menginstal perangkat penyimpanan semacam itu adalah opsi yang lebih murah dibandingkan dengan konfigurasi jaringan, namun, mengingat organisasi besar, jenis infrastruktur penyimpanan ini tidak dapat dianggap optimal. Banyak koneksi DAS berarti pulau-pulau memori eksternal yang tersebar dan tersebar di seluruh perusahaan, kelebihan yang tidak dapat digunakan oleh komputer host lain, yang mengarah pada pemborosan kapasitas penyimpanan secara umum.

Selain itu, dengan organisasi penyimpanan seperti itu, tidak ada cara untuk membuat satu titik pengelolaan memori eksternal, yang mau tidak mau mempersulit proses pencadangan / pemulihan dan menciptakan masalah serius perlindungan informasi. Akibatnya, total biaya kepemilikan sistem penyimpanan seperti itu dapat secara signifikan lebih tinggi daripada yang lebih kompleks pada pandangan pertama dan pada awalnya konfigurasi jaringan lebih mahal.

San

Hari ini, berbicara tentang sistem penyimpanan tingkat perusahaan, yang kami maksud adalah penyimpanan jaringan. Lebih dikenal oleh masyarakat umum adalah jaringan penyimpanan - SAN (jaringan area penyimpanan). SAN adalah jaringan khusus perangkat penyimpanan yang memungkinkan banyak server menggunakan sumber daya total memori eksternal tanpa memuat jaringan lokal.

SAN tidak tergantung pada media transmisi, tetapi saat ini standar sebenarnya adalah teknologi Fibre Channel (FC), memberikan kecepatan transfer data 1-2 Gb / s. Tidak seperti media transmisi berbasis SCSI tradisional, yang menyediakan konektivitas tidak lebih dari 25 meter, Fibre Channel memungkinkan Anda bekerja pada jarak hingga 100 km. Media jaringan Fibre Channel dapat berupa tembaga atau fiber.

Disk dapat terhubung ke jaringan penyimpanan array RAID, array disk sederhana, (yang disebut Just a Bunch of Disks - JBOD), tape atau perpustakaan magneto-optical untuk backup dan pengarsipan data. Komponen utama untuk mengatur jaringan SAN selain perangkat penyimpanan itu sendiri adalah adaptor untuk menghubungkan server ke jaringan Fibre Channel (host bus adapter - NVA), perangkat jaringan untuk mendukung satu atau lain topologi jaringan FC, dan alat perangkat lunak khusus untuk mengelola jaringan penyimpanan. Sistem perangkat lunak ini dapat berjalan baik pada server serba guna dan pada perangkat penyimpanan itu sendiri, meskipun kadang-kadang beberapa fungsi ditransfer ke server tipis khusus untuk manajemen jaringan penyimpanan (alat SAN).

Tujuan perangkat lunak SAN terutama untuk mengelola jaringan penyimpanan secara terpusat, termasuk mengonfigurasi, memantau, mengendalikan, dan menganalisis komponen jaringan. Salah satu yang paling penting adalah fungsi kontrol akses ke array disk, jika server heterogen disimpan di SAN. Jaringan penyimpanan memungkinkan beberapa server untuk secara bersamaan mengakses beberapa subsistem disk, memetakan setiap host ke disk tertentu pada array disk tertentu. Untuk sistem operasi yang berbeda, perlu untuk mengelompokkan array disk menjadi "unit logis" (unit logis - LUN), yang akan mereka gunakan tanpa konflik. Alokasi area logis mungkin diperlukan untuk mengatur akses ke data yang sama untuk kumpulan server tertentu, misalnya, server dari kelompok kerja yang sama. Modul perangkat lunak khusus bertanggung jawab untuk mendukung semua operasi ini.

Daya tarik jaringan penyimpanan dijelaskan oleh keuntungan yang dapat mereka berikan pada organisasi yang menuntut efisiensi bekerja dengan volume data yang besar. Jaringan penyimpanan khusus melepaskan jaringan utama server komputasi dan workstation klien (lokal atau global), membebaskannya dari aliran input / output data.

Faktor ini, serta media transmisi berkecepatan tinggi yang digunakan untuk SAN, memberikan peningkatan produktivitas proses pertukaran data dengan sistem penyimpanan eksternal. SAN berarti konsolidasi sistem penyimpanan, penciptaan kumpulan sumber daya tunggal pada media yang berbeda, yang akan digunakan bersama oleh semua kekuatan komputasi, dan sebagai hasilnya, kapasitas memori eksternal yang diperlukan dapat disediakan dengan lebih sedikit subsistem. Dalam SAN, data dicadangkan dari subsistem disk ke kaset di luar jaringan lokal dan karenanya menjadi lebih efisien - satu tape library dapat digunakan untuk membuat cadangan data dari beberapa subsistem disk. Selain itu, dengan dukungan perangkat lunak yang sesuai, dimungkinkan untuk mengimplementasikan cadangan langsung di SAN tanpa partisipasi server, sehingga menurunkan prosesor. Kemampuan untuk menyebarkan server dan memori jarak jauh memenuhi kebutuhan untuk meningkatkan keandalan gudang data perusahaan. Penyimpanan data yang dikonsolidasikan dalam SAN berskala lebih baik karena memungkinkan Anda untuk meningkatkan kapasitas penyimpanan secara independen dari server dan tanpa mengganggu pekerjaan mereka. Akhirnya, SAN memungkinkan manajemen terpusat satu kumpulan memori eksternal, yang menyederhanakan administrasi.

Tentu saja, jaringan penyimpanan adalah solusi yang mahal dan sulit, dan terlepas dari kenyataan bahwa semua pemasok terkemuka saat ini memproduksi perangkat SAN yang berbasis Fiber Channel, kompatibilitasnya tidak dijamin, dan memilih peralatan yang tepat menimbulkan masalah bagi pengguna. Biaya tambahan akan diperlukan untuk organisasi jaringan khusus dan pembelian perangkat lunak manajemen, dan biaya awal SAN akan lebih tinggi daripada organisasi penyimpanan menggunakan DAS, tetapi total biaya kepemilikan harus lebih rendah.

NAS

Tidak seperti SAN, NAS (penyimpanan yang terpasang jaringan) bukan jaringan, tetapi perangkat penyimpanan jaringan, lebih tepatnya, server file khusus dengan subsistem disk yang terhubung dengannya. Kadang-kadang perpustakaan optik atau tape dapat dimasukkan dalam konfigurasi NAS. Perangkat NAS (alat NAS) terhubung langsung ke jaringan dan memberikan host akses ke file pada subsistem memori eksternal terintegrasi. Munculnya server file khusus dikaitkan dengan pengembangan sistem file jaringan NFS oleh Sun Microsystems di awal 90-an, yang memungkinkan komputer klien di jaringan lokal untuk menggunakan file di server jauh. Kemudian Microsoft muncul dengan sistem serupa untuk lingkungan Windows - Sistem File Internet Umum. Konfigurasi NAS mendukung kedua sistem ini, serta protokol berbasis IP lainnya, yang menyediakan berbagi file untuk aplikasi klien.