რა არის შენახვის სისტემები (SHD) და რას წარმოადგენს ისინი? რა განსხვავებაა iSCSI- ს და FiberChannel- ს შორის? რატომ გახდა ეს ფრაზა მხოლოდ ბოლო წლებში ცნობილი IT- სპეციალისტების ფართო წრისთვის და რატომ არის მონაცემთა შენახვის სისტემების საკითხები უფრო და უფრო მეტად შემაშფოთებელი მოაზროვნე გონებით?

ვფიქრობ, ბევრმა ადამიანმა შეამჩნია განვითარების ტენდენციები კომპიუტერულ სამყაროში, რომელიც გვხვდება ჩვენს გარშემო - ფართო განვითარების მოდელიდან ინტენსიურზე გადასვლა. მეგაჰერცული პროცესორების ზრდა აღარ იძლევა აშკარა შედეგს, ხოლო დრაივების განვითარება არ შეესაბამება ინფორმაციას ინფორმაციის რაოდენობასთან. თუ პროცესორების შემთხვევაში ყველაფერი მეტ-ნაკლებად ნათელია - საკმარისია მულტიპროცესორული სისტემების შეკრება ან / და რამდენიმე ბირთვის გამოყენება ერთ პროცესორში, მაშინ ინფორმაციის შენახვისა და დამუშავების საკითხების შემთხვევაში, პრობლემებისგან თავის დაღწევა არც ისე ადვილია. ინფორმაციის ეპიდემიის ამჟამინდელი პანაცეა არის საცავი. სახელწოდებაა Storage Area Network ან Storage System. ნებისმიერ შემთხვევაში, ეს განსაკუთრებულია

ძირითადი პრობლემები შენახვის გზით

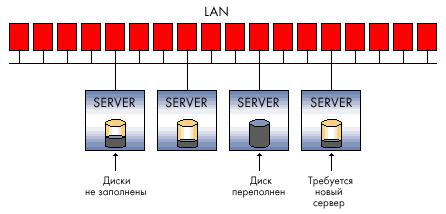

რა ამოცანები არის შესანახად შენახვის სისტემა? განვიხილოთ ტიპიური პრობლემები, რომლებიც დაკავშირებულია ნებისმიერი ორგანიზაციაში ინფორმაციის მზარდ მოცულობასთან. დავუშვათ, ეს არის სულ მცირე, რამდენიმე ათეული კომპიუტერი და გეოგრაფიულად დაშორებული რამდენიმე ოფისი.

1. ინფორმაციის დეცენტრალიზაცია - თუ ადრე ყველა მონაცემი შეიძლება ინახებოდეს სიტყვასიტყვით ერთ მყარ დისკზე, ახლა ნებისმიერი ფუნქციური სისტემა მოითხოვს ცალკე შენახვას - მაგალითად, ელ.ფოსტის სერვერები, DBMS, დომენი და ა.შ. სიტუაცია გართულებულია განაწილებული ოფისების (ფილიალების) შემთხვევაში.

2. ზვავი მსგავსი ინფორმაციის ზრდა - ხშირად მყარი დისკის რაოდენობა, რომელიც შეგიძლიათ დააყენოთ კონკრეტულ სერვერზე, ვერ დაფარავს სისტემის საჭირო სიმძლავრეს. შედეგად:

შენახული მონაცემების სრულად დასაცავად უუნარობა ნამდვილად არის, რადგან საკმაოდ რთულია სარეზერვო მონაცემების გადაღებაც კი, რომელიც არამარტო სხვადასხვა სერვერზეა, არამედ გეოგრაფიულად იშლება.

არასაკმარისი ინფორმაციის დამუშავების სიჩქარე - დისტანციურ საიტებს შორის საკომუნიკაციო არხები მაინც სასურველს ტოვებს, მაგრამ საკმარისად „სქელი“ არხის საშუალებით კი ყოველთვის შეუძლებელია არსებული ქსელების, მაგალითად, IP– ის სრულად გამოყენება.

სარეზერვო სირთულე - თუ მონაცემები იკითხება და იწერება მცირე ბლოკებში, მაშინ არსებული არხების საშუალებით დისტანციური სერვერისგან ინფორმაციის სრული არქივირების გაკეთება შეიძლება არარეალური იყოს - აუცილებელია მონაცემების მთლიანი თანხის გადაცემა. ადგილობრივი დაარქივება ხშირად არაპრაქტიკულია ფინანსური მიზეზების გამო - თქვენ გჭირდებათ სარეზერვო სისტემები (მაგალითად, ფირზე დრაივები), სპეციალური პროგრამული უზრუნველყოფა (რომლის ღირებულება შეიძლება ბევრი თანხის გადახდა), და გამოცდილი და გამოცდილი პერსონალი.

3. ძნელია ან შეუძლებელი საჭირო მოცულობის პროგნოზირება დისკის სივრცე კომპიუტერული სისტემის განლაგებისას. შედეგად:

დისკის შესაძლებლობების გაფართოების პრობლემები არსებობს - სერვერზე ტერაბიტიანი სიმძლავრეების მოპოვება საკმაოდ რთულია, მით უმეტეს, თუ სისტემა უკვე მუშაობს მცირე სიმძლავრის დისკებზე - მინიმუმამდე, საჭიროა სისტემის გამორთვა და არაეფექტური ფინანსური ინვესტიციები.

რესურსების არაეფექტური გამოყენება - ზოგჯერ ვერ მიხვდებით რომელ სერვერზე მონაცემები უფრო სწრაფად გაიზრდება. კრიტიკულად მცირე რაოდენობით დისკის ადგილი შეიძლება უფასო იყოს ელ.ფოსტის სერვერში, ხოლო სხვა განყოფილება გამოიყენებს ძვირადღირებული დისკის ქვესისტემის მოცულობის მხოლოდ 20% -ს (მაგალითად, SCSI).

4. განაწილებული მონაცემების დაბალი კონფიდენციალურობა - საწარმოს უსაფრთხოების პოლიტიკის შესაბამისად შეუძლებელია წვდომის კონტროლი და შეზღუდვა. ეს ეხება როგორც ამაზე არსებულ არხებზე მონაცემების დაშვებას (ადგილობრივი ქსელის ქსელში), ისე მედიის ფიზიკურ წვდომას - მაგალითად, მყარი დისკების ქურდობა და მათი განადგურება არ არის გამორიცხული (ორგანიზაციის ბიზნესის გართულების მიზნით). მომხმარებლებისა და მოვლის პერსონალის არაკვალიფიციური ქმედებები შეიძლება კიდევ უფრო საზიანო იყოს. როდესაც კომპანია თითოეულ ოფისში იძულებულია ადგილობრივი მცირე უსაფრთხოების პრობლემების მოგვარება, ეს არ იძლევა სასურველ შედეგს.

5. განაწილებული ინფორმაციის ნაკადის მართვის სირთულე - ნებისმიერი მოქმედება, რომელიც მიმართულია თითოეულ ფილიალში მონაცემების შეცვლაზე, რომელიც შეიცავს განაწილებულ მონაცემთა ნაწილს, ქმნის გარკვეულ პრობლემებს, დაწყებული სხვადასხვა მონაცემთა მონაცემთა სინქრონიზაციის სირთულეებიდან, დეველოპერების ფაილების ვერსიებიდან, ინფორმაციის ზედმეტი დუბლირებისას.

6. "კლასიკური" გადაწყვეტილებების დანერგვის დაბალი ეკონომიკური ეფექტი - საინფორმაციო ქსელის ზრდით, დიდი რაოდენობით მონაცემებით და საწარმოს უფრო ფართოდ განაწილებული სტრუქტურით, ფინანსური ინვესტიციები არც თუ ისე ეფექტურია და ხშირად ვერ გადაჭრის წარმოშობილ პრობლემებს.

7. რესურსების მაღალი ხარჯები, რომლებიც გამოიყენება მთელი საწარმოს ინფორმაციული სისტემის ეფექტურობის შესანარჩუნებლად - გამოცდილი პერსონალის დიდი პერსონალის შენარჩუნების საჭიროებიდან, მრავალრიცხოვან ძვირადღირებულ აპარატურულ გადაწყვეტილებებამდე, რომლებიც შექმნილია ინფორმაციის მოცულობისა და სიჩქარის პრობლემის გადასაჭრელად, საიმედო შენახვასთან და შეცდომებისგან დაცვისგან.

ზემოხსენებული პრობლემების გათვალისწინებით, რომლებიც ადრე თუ გვიან, მთლიანად ან ნაწილობრივ გადალახავს რომელიმე დინამიურად განვითარებად კომპანიას, შევეცდებით აღვწეროთ შესანახი სისტემები - როგორც ეს უნდა იყოს. განვიხილოთ კავშირის ტიპიური სქემები და შენახვის სისტემების ტიპები.

მეგაბაიტი / გარიგებები?

თუ ადრე მყარი დისკები კომპიუტერის (სერვერის) შიგნით იყო, ახლა ისინი იქ ხალხმრავლობენ და არც თუ ისე საიმედოდ. უმარტივესი გამოსავალი (დიდი ხნის წინ შემუშავებული და ყველგან გამოიყენება) არის RAID ტექნოლოგია.

სურათები \\ RAID \\ 01.jpg

RAID– ს ნებისმიერ საცავ სისტემაში ორგანიზებისას, გარდა ინფორმაციის დაცვისა, ვიღებთ რამდენიმე უდაო უპირატესობას, რომელთაგან ერთ – ერთია ინფორმაციის ხელმისაწვდომობის სიჩქარე.

მომხმარებლის ან პროგრამული უზრუნველყოფის თვალსაზრისით, სიჩქარე განისაზღვრება არა მხოლოდ სისტემის სიმძლავრით (MB / s), არამედ გარიგების რაოდენობებით - ანუ, I / O ოპერაციების რაოდენობა თითო ერთეულზე (IOPS). ლოგიკურად, დისკების უფრო დიდი რაოდენობა და იმ შესრულების გაუმჯობესების ტექნიკა, რომელსაც RAID კონტროლერი უზრუნველყოფს (მაგალითად, ქეშირება), ხელს უწყობს IOPS- ს.

თუ მთლიანი გამტარუნარიანობა უფრო მნიშვნელოვანია ნაკადიანი ვიდეოს სანახავად ან ფაილური სერვერის ორგანიზებისთვის, DBMS და OLTP (ონლაინ ტრანზაქციების დამუშავების) პროგრამებისთვის, ეს არის ტრანზაქციების რაოდენობა, რომლის საშუალებითაც სისტემას გადამუშავება ძალზე მნიშვნელოვანია. და ამ პარამეტრით, თანამედროვე მყარი დისკები არ არის ისეთი ვარდისფერი, როგორც მზარდი მოცულობებით და, ნაწილობრივ, სიჩქარით. ყველა ეს პრობლემა შექმნილია თავად შენახვის სისტემის მოსაგვარებლად.

დაცვის დონე

თქვენ უნდა გესმოდეთ, რომ ყველა საცავის სისტემის საფუძველი არის RAID ტექნოლოგიაზე დაფუძნებული ინფორმაციის დაცვის პრაქტიკა - ამის გარეშე, ტექნიკურად მოწინავე საცავის სისტემა უსარგებლო იქნება, რადგან ამ სისტემაში მყარი დისკები ყველაზე საიმედო კომპონენტია. RAID– ში დისკების ორგანიზება არის „ქვედა რგოლი“, ინფორმაციის დაცვის პირველი ეშელონი და გაზრდილი დამუშავების სიჩქარე.

ამასთან, RAID სქემების გარდა, არსებობს უფრო დაბალი დონის მონაცემთა დაცვა, რომელიც ხორციელდება ტექნოლოგიების და ზემოდან დამონტაჟებული ტექნოლოგიებისა და გადაწყვეტილებების შესახებ, რომელიც ჩადებულია მყარ დისკზე თავად მისი მწარმოებლის მიერ. მაგალითად, ერთ-ერთი წამყვანი საცავის მწარმოებელ კომპანიას, EMC, გააჩნია მონაცემთა დამატებითი მთლიანობის ანალიზის მეთოდი დისკის სექტორის დონეზე.

RAID– სთან დაკავშირებით, მოდით, თავად გადავიდეთ შენახვის სისტემების სტრუქტურაზე. პირველ რიგში, შენახვის სისტემები დაყოფილია გამოყენებული მასპინძლის (სერვერის) კავშირის ინტერფეისის ტიპის მიხედვით. გარე კავშირის ინტერფეისი ძირითადად SCSI ან FibreChannel, ასევე საკმაოდ ახალგაზრდა iSCSI სტანდარტია. ასევე, ნუ ააწყობთ მცირე ინტელექტუალურ მაღაზიებს, რომელთა საშუალებითაც შესაძლებელია USB ან FireWire საშუალებით დაკავშირება. ჩვენ არ განვიხილავთ იშვიათი (ზოგჯერ ამა თუ იმ გზით წარუმატებელი) ინტერფეისებს, მაგალითად IBM SSA ან მთავარ ჩარჩოებზე შექმნილი ინტერფეისები - მაგალითად, FICON / ESCON. დგომა მარტო NAS საცავში, რომელიც დაკავშირებულია Ethernet ქსელთან. სიტყვა "ინტერფეისი" ძირითადად ნიშნავს გარე კონექტორს, მაგრამ არ უნდა დაგვავიწყდეს, რომ კონექტორი არ განსაზღვრავს ორი მოწყობილობის საკომუნიკაციო ოქმს. ჩვენ ვისაუბრებთ ამ მახასიათებლებზე ცოტა უფრო დაბლა.

სურათები \\ RAID \\ 02.gif

იგი დგას მცირე კომპიუტერული სისტემის ინტერფეისით (წაიკითხეთ "ვუთხრა") - ნახევრად დუპლექსური პარალელური ინტერფეისი. თანამედროვე შენახვის სისტემებში, იგი ყველაზე ხშირად წარმოდგენილია SCSI კონექტორით:

სურათები \\ RAID \\ 03.gif

სურათები \\ RAID \\ 04.gif

და SCSI ოქმების ჯგუფი და უფრო კონკრეტულად - SCSI-3 პარალელური ინტერფეისი. SCSI- სა და ნაცნობ IDE- ს შორის განსხვავებაა იმაში, რომ უფრო მეტი მოწყობილობაა თითოეულ არხზე, საკაბელო გრძელი სიგრძე, მონაცემთა გადაცემის უფრო სწრაფი ტემპი და ასევე "ექსკლუზიური" ფუნქციები, როგორიცაა მაღალი ძაბვის დიფერენციალური სიგნალი, ბრძანების დახვევა და სხვა დანარჩენი - ჩვენ არ მივიღებთ ამ საკითხს.

თუ ვსაუბრობთ SCSI კომპონენტების მთავარ მწარმოებლებზე, როგორიცაა SCSI გადამყვანები, RAID კონტროლერები SCSI ინტერფეისით, მაშინ ნებისმიერი სპეციალისტი დაუყოვნებლივ დაიმახსოვრებს ორ სახელს - Adaptec და LSI Logic. ვფიქრობ, ეს საკმარისია, ამ ბაზარზე დიდი ხნის განმავლობაში რევოლუციები არ მომხდარა და ალბათ არც არის მოსალოდნელი.

FiberChannel ინტერფეისი

სრული დუპლექსის სერიული ინტერფეისი. ყველაზე ხშირად თანამედროვე აღჭურვილობაში იგი წარმოდგენილია გარე ოპტიკური კონექტორებით, როგორიცაა LC ან SC (LC - უფრო მცირე ზომის):

სურათები \\ RAID \\ 05.jpg

სურათები \\ RAID \\ 06.jpg

... და FibreChannel ოქმები (FCP). არსებობს რამდენიმე FibreChannel მოწყობილობის გადართვის სქემა:

წერტილიდან წერტილამდე - წერტილიდან წერტილამდე, მოწყობილობების პირდაპირ შეერთებას ერთმანეთთან:

სურათები \\ RAID \\ 07.gif

ჯვარედინი გადართვა - მოწყობილობების დამაკავშირებელი FibreChannel შეცვლაზე (კონცენტრატორებზე Ethernet ქსელის განხორციელების მსგავსია):

სურათები \\ RAID \\ 08.gif

საარბიტრაჟო მარყუჟი - FC-AL, საარბიტრაჟო დაშვების მარყუჟი - ყველა მოწყობილობა ერთმანეთთან დაკავშირებულია რგოლში, წრე გარკვეულწილად ახსენებს Token Ring- ს. ასევე შეიძლება გამოყენებულ იქნას შეცვლა - მაშინ ფიზიკური ტოპოლოგია განხორციელდება "ვარსკვლავის" სქემის მიხედვით, ხოლო ლოგიკური - "მარყუჟის" (ან "ბეჭდის") სქემის მიხედვით:

სურათები \\ RAID \\ 09.gif

FibreChannel Switched სქემის მიხედვით კავშირი ყველაზე გავრცელებული სქემაა, FibreChannel- ის თვალსაზრისით ასეთ კავშირს უწოდებენ ნაჭუჭს - რუსულად არსებობს მისგან ნაჭრის კვალი - ”ქარხანა”. უნდა აღინიშნოს, რომ FibreChannel კონცენტრატორები საკმაოდ მოწინავე მოწყობილობებია, შევსების სირთულის თვალსაზრისით, ისინი ახლოს არიან დონის IP- კონცენტრატორებთან. 3. თუ კონცენტრატორები ერთმანეთთან არის დაკავშირებული, მაშინ ისინი მუშაობენ ერთ ქარხანაში, აქვთ პარამეტრების აუზი, რომელიც ერთდროულად მოქმედებს მთელი ქარხნისთვის. ზოგიერთი კონცენტრატორის რამდენიმე ვარიანტის შეცვლამ შეიძლება გამოიწვიოს მთელი ქარხნის ხელახლა შეცვლა, მაგალითად, წვდომის ნებართვის პარამეტრებზე აღარაფერი ვთქვათ. მეორეს მხრივ, არსებობს SAN სქემა, რომელიც მოიცავს რამდენიმე ქარხანას ერთიანი SAN- ის ფარგლებში. ამრიგად, ქარხანას შეიძლება ეწოდოს მხოლოდ ურთიერთდაკავშირებული კონცენტრატორების ჯგუფი - ორი ან მეტი არაკონტაქტური მოწყობილობა, რომელიც შეიტანეს SAN– ში, რათა გაზარდოს ხარვეზების ტოლერანტობა ორი ან მეტი სხვადასხვა ქარხნისგან.

კომპონენტებს, რომლებიც საშუალებას აძლევენ მასპინძელებისა და შენახვის სისტემების ერთ ქსელში გაერთიანებას, ჩვეულებრივ მოიხსენიება "კავშირი". დაკავშირება, რა თქმა უნდა, არის დუპლექსის კავშირის კაბელები (ჩვეულებრივ LC ინტერფეისით), კონცენტრატორები (კონცენტრატორები) და FibreChannel გადამყვანები (HBA, Host Base Adapters) - ეს არის ის გაფართოების ბარათები, რომლებიც მასპინძლებზე დამონტაჟებისას, საშუალებას გაძლევთ ქსელში ჩართოთ მასპინძელი. სან. HBAs ჩვეულებრივ ხორციელდება როგორც PCI-X ან PCI-Express ბარათები.

სურათები \\ RAID \\ 10.jpg

არ აღრეული ბოჭკოვანი და ბოჭკოვანი - სიგნალის გამრავლების საშუალო საშუალება შეიძლება იყოს განსხვავებული. FiberChannel- ს შეუძლია მუშაობა "სპილენძზე". მაგალითად, ყველა FibreChannel მყარ დისკს აქვს ლითონის კონტაქტები, და ჩვეულებრივი მოწყობილობების "სპილენძით" გადატანა იშვიათი არაა, ისინი თანდათანობით გადადიან ოპტიკურ არხებზე, როგორც ყველაზე პერსპექტიული ტექნოლოგია და "სპილენძის" ფუნქციური ჩანაცვლება.

ISCSI ინტერფეისი

ჩვეულებრივ, წარმოდგენილია გარე RJ-45 კონექტორით Ethernet ქსელთან და თვითონ პროტოკოლით iSCSI (ინტერნეტ მცირე კომპიუტერული სისტემის ინტერფეისი) დასაკავშირებლად. SNIA- ს განმარტებით: ”iSCSI არის პროტოკოლი, რომელიც დაფუძნებულია TCP / IP და შექმნილია ურთიერთთანამშრომლობის დამყარებისა და შენახვის სისტემების, სერვერებისა და კლიენტების მართვისთვის.” მოდით განვიხილოთ ეს ინტერფეისი უფრო დეტალურად, თუ მხოლოდ იმიტომ, რომ თითოეულ მომხმარებელს შეუძლია გამოიყენოს iSCSI თუნდაც რეგულარული „სახლის“ ქსელში.

თქვენ უნდა იცოდეთ, რომ iSCSI განსაზღვრავს მინიმუმ სატრანსპორტო პროტოკოლს SCSI– სთვის, რომელიც გადის TCP– ს თავზე, ასევე IPSI– ს ქსელში SCSI ბრძანებების გადაბმის ტექნოლოგიას. მარტივად რომ ვთქვათ, iSCSI არის პროტოკოლი, რომლის საშუალებითაც შესაძლებელია მონაცემების ბლოკზე წვდომა SCSI ბრძანებების გამოყენებით, რომელიც ქსელში გაგზავნილია TCP / IP დასტის საშუალებით. iSCSI გამოჩნდა, როგორც FibreChannel– ის შემცვლელად, ხოლო თანამედროვე შენახვის სისტემებში მას აქვს რამდენიმე უპირატესობა - დიდი მანძილის მქონე მოწყობილობების გაერთიანების შესაძლებლობა (არსებული IP ქსელების გამოყენებით), QoS– ის განსაზღვრული დონის მიწოდების შესაძლებლობა (მომსახურების ხარისხი, მომსახურების ხარისხი), დაბალი ღირებულების კავშირი. თუმცა, iSCSI– ს, როგორც FibreChannel– ის შემცვლელად გამოყენების მთავარი პრობლემა არის ქსელში დიდი ხნის შეფერხებები, რაც ხდება ქსელში TCP / IP დასტის შესრულების თავისებურებების გამო, რაც უარყოფს შესანახი სისტემების გამოყენების ერთ – ერთ მნიშვნელოვან უპირატესობას - ინფორმაციის დაშვების სიჩქარე და დაბალი ლატენტურობა. ეს სერიოზული მინუსია.

მცირე შენიშვნა მასპინძლებთან დაკავშირებით - მათ შეუძლიათ გამოიყენონ როგორც რეგულარული ქსელის ბარათები (შემდეგ iSCSI დასტის დამუშავება და ბრძანებების გადაფარვა მოხდება პროგრამული უზრუნველყოფით), ასევე სპეციალიზებული ბარათები, რომლებიც ხელს უწყობენ TOE– ს მსგავსი ტექნოლოგიების (TCP / IP Offload Engines). ეს ტექნოლოგია უზრუნველყოფს iSCSI პროტოკოლის დასტის შესაბამისი ნაწილის აპარატების დამუშავებას. პროგრამული მეთოდი უფრო იაფია, მაგრამ ის უფრო იტვირთებს სერვერის ცენტრალურ პროცესორს და, თეორიულად, შეიძლება გამოიწვიოს უფრო შეფერხებამ, ვიდრე აპარატურულმა პროცესორმა. Ethernet ქსელების ამჟამინდელი სიჩქარით 1 გბიტ / წმ – ზე, შეიძლება ვივარაუდოთ, რომ iSCSI იმუშავებს ზუსტად ორჯერ ნელა, ვიდრე FibreChannel– ით 2 გბიტის სიჩქარით, მაგრამ რეალურ გამოყენებაში სხვაობა კიდევ უფრო შესამჩნევი იქნება.

გარდა ზემოთ უკვე განხილული, მოკლედ ვახსენებთ რამდენიმე პროტოკოლს, რომლებიც უფრო იშვიათია და შექმნილია დამატებითი სერვისების უზრუნველსაყოფად არსებული შენახვის არეალის ქსელებისთვის (SAN):

FCIP (ოპერატიული არხი IP- ზე მეტი) - TCP / IP- ზე აშენებული გვირაბის პროტოკოლი და შექმნილია გეოგრაფიულად დაარბენილი სანტექნიკის დასაკავშირებლად სტანდარტული IP გარემოს მეშვეობით. მაგალითად, შეგიძლიათ ერთმანეთთან ორი SAN დააკავშიროთ ინტერნეტით. ეს მიიღწევა FCIP კარიბჭის გამოყენებით, რომელიც გამჭვირვალეა ყველა მოწყობილობაში SAN.

iFCP (ინტერნეტ ბოჭკოვანი არხის პროტოკოლი) - პროტოკოლი, რომლის საშუალებითაც შეგიძლიათ დააკავშიროთ მოწყობილობები FC ინტერფეისებს IP ქსელების საშუალებით. FCIP– სგან მნიშვნელოვანი განსხვავებაა ის, რომ შესაძლებელია FC მოწყობილობების გაერთიანება IP ქსელის საშუალებით, რაც საშუალებას აძლევს სხვადასხვა წყაროს კავშირი ჰქონდეს QoS– ს განსხვავებულ დონეს, რაც შეუძლებელია FCIP– ის მეშვეობით გვირაბის მიღებისას.

ჩვენ მოკლედ მიმოვიხილეთ ფიზიკური ინტერფეისები, პროტოკოლები და შენახვის სისტემების შეცვლის ტიპები, ყველა შესაძლო ვარიანტის ჩამონათვალის შეჩერების გარეშე. ახლა მოდით შევეცადოთ წარმოვიდგინოთ, რა პარამეტრებით ახასიათებს მონაცემთა შენახვის სისტემები?

შენახვის ძირითადი ტექნიკის პარამეტრები

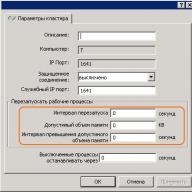

ზოგიერთი მათგანი ზემოთ ჩამოთვლილი იყო - ეს არის გარე კავშირის ინტერფეისების ტიპები და შიდა დისკების ტიპები (მყარი დისკები). შემდეგი პარამეტრი, რომელიც აზრი აქვს განიხილოს დისკის შესანახი სისტემის არჩევის დროს ზემოთ მოყვანილი ორი მათგანი, არის მისი საიმედოობა. საიმედოობა შეიძლება შეფასდეს არა ბანალური საოპერაციო დროის მიერ, რომელიმე ცალკეული კომპონენტის წარუმატებლობას შორის (ის ფაქტი, რომ ამ დროისთვის დაახლოებით ტოლია ყველა მწარმოებლისთვის), არამედ შიდა არქიტექტურის მიხედვით. "რეგულარული" შესანახი სისტემა ხშირად "გარედან" არის დისკის თარო (19-დიუმიანი კაბინეტის დასაყენებლად) მყარი დისკებით, მასპინძლების დასაკავშირებლად გარე ინტერფეისებით, რამდენიმე ელექტრომომარაგებით. შიგნით, როგორც წესი, დამონტაჟებულია ყველაფერი, რაც უზრუნველყოფს შენახვის სისტემას - პროცესორის ერთეულები, დისკის კონტროლერები, შეყვანის / გამოსვლის პორტები, ქეში მეხსიერება და ა.შ. როგორც წესი, თაროს მართვა ბრძანების სტრიქონიდან ან ვებ – ინტერფეისის საშუალებით ხვდებათ, თავდაპირველი კონფიგურაცია ხშირად მოითხოვს სერიულ კავშირს. მომხმარებელს შეუძლია "დაყოს" დისკი სისტემაში ჯგუფებად და დააკავშიროს ისინი RAID (სხვადასხვა დონის), შედეგად დისკის ადგილი იყოფა ერთ ან მეტ ლოგიკურ ერთეულებად (LUN), რომელზეც მასპინძლებს (სერვერებს) აქვთ წვდომა და "ხედავენ" მათ ადგილობრივი მყარი დისკები. RAID ჯგუფების რაოდენობა, LUN, ქეშის ლოგიკა, კონკრეტული სერვერებისთვის LUN- ების ხელმისაწვდომობა და სხვა ყველაფერი კონფიგურებულია სისტემის ადმინისტრატორის მიერ. როგორც წესი, შენახვის სისტემები შექმნილია იმისთვის, რომ დაუკავშირონ ისინი არა ერთ, არამედ რამდენიმე (ასობით ასამდე) სერვერს - შესაბამისად, ასეთ სისტემას უნდა ჰქონდეს მაღალი ხარისხის, კონტროლისა და მონიტორინგის მოქნილი სისტემა და კარგად გააზრებული მონაცემთა დაცვის საშუალებები. მონაცემთა დაცვა მრავალი გზით არის გათვალისწინებული, რომელთაგან ყველაზე მარტივი თქვენ უკვე იცით - დისკების კომბინაცია RAID– ში. ამასთან, მონაცემები მუდმივად ხელმისაწვდომი უნდა იყოს - ყოველივე ამის შემდეგ, საწარმოსთვის მთავარი მონაცემთა შენახვის ერთი სისტემის გაჩერებამ შეიძლება გამოიწვიოს მნიშვნელოვანი ზარალი. რაც უფრო მეტი სისტემა ინახავს მონაცემებს შესანახ სისტემაზე, უფრო საიმედო უნდა იყოს სისტემაში შესვლა - რადგან უბედური შემთხვევის შემთხვევაში, შენახვის სისტემა დაუყოვნებლივ წყვეტს მუშაობას ყველა სერვერზე, რომელიც იქ ინახავს მონაცემებს. თაროს მაღალი ხელმისაწვდომობა უზრუნველყოფილია სისტემის ყველა კომპონენტის სრული შიდა დუბლირებით - საკიდების დაშვების ბილიკებით (FibreChannel პორტები), პროცესორის მოდულები, ქეში მეხსიერება, კვების წყარო და ა.შ. ჩვენ შევეცდებით აგიხსნათ 100% -ით ზედმეტი (პრინციპი) შემცირების პრინციპი შემდეგი ფიგურით:

სურათები \\ RAID \\ 11.gif

1. სასაწყობო სისტემის კონტროლერი (პროცესორის მოდული), მათ შორის:

* ცენტრალური პროცესორი (ან პროცესორები) - როგორც წესი, სისტემაში გადის სპეციალური პროგრამა, რომელიც მოქმედებს როგორც "ოპერაციული სისტემა";

* მყარი დისკების გადართვის ინტერფეისი - ჩვენს შემთხვევაში, ეს არის დაფები, რომლებიც უზრუნველყოფენ FibreChannel დისკების დაკავშირებას საარბიტრაჟო დაშვების მარყუჟის სქემის მიხედვით (FC-AL);

* ქეში მეხსიერება;

* FibreChannel გარე პორტის კონტროლერები

2. FC– ს გარე ინტერფეისი; როგორც ვხედავთ, თითოეული პროცესორის მოდულისთვის არის 2 მათგანი;

3. მყარი დისკები - ტევადობა გაფართოვებულია დამატებითი დისკის თაროებით;

4. ქეშ მეხსიერება ასეთ სქემაში ჩვეულებრივ ხდება ისე, რომ არ დაიკარგოს იქ შენახული მონაცემები, როდესაც რაიმე მოდული ვერ მოხდება.

ტექნიკურთან დაკავშირებით, დისკის თაროებს შეიძლება ჰქონდეთ განსხვავებული ინტერფეისი მასპინძლების დასაკავშირებლად, მყარი დისკების სხვადასხვა ინტერფეისები, დამატებითი თაროების სხვადასხვა კავშირის სქემები, რომლებიც ემსახურება სისტემაში დისკების რაოდენობის გაზრდას, ისევე როგორც სხვა ”რკინის პარამეტრების” სხვაობას.

შენახვის პროგრამა

ბუნებრივია, შენახვის სისტემების აპარატების სიმძლავრე როგორღაც უნდა მოხდეს მართვა, ხოლო თავად შენახვის სისტემები უბრალოდ ვალდებულნი არიან უზრუნველყონ სერვისისა და ფუნქციონირების ის დონე, რომელიც მიუწვდომელია ჩვეულებრივი სერვერ-კლიენტის სქემებში. თუ გადავხედავთ ფიგურას „მონაცემთა შენახვის სისტემის სტრუქტურული დიაგრამა“, ცხადი ხდება, რომ როდესაც სერვერი პირდაპირ უკავშირდება თაროს ორი გზით, ისინი უნდა იყოს დაკავშირებული სხვადასხვა პროცესორის მოდულის FC პორტებთან, რათა სერვერმა გააგრძელოს მუშაობა, თუ დაუყოვნებლივ ვერ მოხდება მთელი პროცესორის მოდული. ბუნებრივია, რომ მრავალჯერადი გამოყენებისას, ამ ფუნქციონალური მხარდაჭერა უნდა იყოს უზრუნველყოფილი აპარატურით და პროგრამულ უზრუნველყოფით, მონაცემთა გადაცემის პროცესში ჩართულ ყველა დონეზე. რა თქმა უნდა, სრული სარეზერვო მონიტორინგისა და გამაფრთხილებელი ხელსაწყოს გარეშე აზრი არ აქვს - აქედან გამომდინარე, ყველა სერიოზულ შენახვის სისტემას აქვს ასეთი შესაძლებლობები. მაგალითად, ნებისმიერი კრიტიკული მოვლენის შესახებ შეტყობინება შეიძლება მოხდეს სხვადასხვა გზით - ელ.ფოსტის სიგნალი, ტექნიკური დახმარების ცენტრში მოდემი ავტომატური ზარი, გზავნილის შემქმნელისთვის გაგზავნა (ახლა უფრო აქტუალურია ვიდრე SMS), SNMP მექანიზმები და სხვა.

და, როგორც უკვე აღვნიშნეთ, არსებობს ძლიერი კონტროლი მთელი ამ ბრწყინვალებისთვის. ჩვეულებრივ, ეს არის ვებზე დაფუძნებული ინტერფეისი, კონსოლი, სკრიპტების დაწერა და კონტროლის ინტეგრირება გარე პროგრამულ პაკეტებში. მოკლედ აღვნიშნავთ მხოლოდ იმ მექანიზმებს, რომლებიც უზრუნველყოფენ საცავის სისტემების მაღალ შესრულებას - არა ბლოკირების არქიტექტურას რამდენიმე შიდა ავტობუსით და მყარ დისკზე დიდი რაოდენობით, მძლავრი ცენტრალური პროცესორებით, სპეციალიზირებული კონტროლის სისტემით (OS), ქეშ მეხსიერების დიდი რაოდენობით და მრავალი გარე I / O ინტერფეისით.

შენახვის სისტემებით უზრუნველყოფილი სერვისები, როგორც წესი, განისაზღვრება თავად დისკის თაროს პროგრამით. თითქმის ყოველთვის, ეს არის რთული პროგრამული პაკეტები, რომლებიც შეიძინა ცალკეული ლიცენზიით, რომლებიც არ შედის თავად შენახვის ღირებულებაში. ჩვენ დაუყოვნებლივ ვახსენებთ ნაცნობ პროგრამას მულტიპლიკაციისთვის - ის უბრალოდ მუშაობს მასპინძლებზე და არა თავად თაროზე.

შემდეგი ყველაზე პოპულარული გამოსავალი არის პროგრამული უზრუნველყოფა მონაცემთა მყისიერი და სრული ასლების შესაქმნელად. სხვადასხვა მწარმოებლებს აქვთ სხვადასხვა სახელები თავიანთი პროგრამული პროდუქტებისთვის და ამ ასლების შექმნის მექანიზმები. მოკლედ რომ ვთქვათ, ჩვენ შეგვიძლია მანიპულირება მოვახდინოთ სიტყვების ფოტოგრაფია და კლონი. კლონი მზადდება დისკის თაროს გამოყენებით თავად თაროს შიგნით - ეს არის მონაცემების სრული შიდა ასლი. განაცხადის ფარგლები საკმაოდ ფართოა - სარეზერვო ასლიდან დაწყებული წყაროების მონაცემების „გამოცდის ვერსიის“ შექმნით, მაგალითად, სარისკო განახლებებისთვის, რომლებშიც არ არსებობს ნდობა და რომელია უსაფრთხო, რომ გამოიყენოთ მიმდინარე მონაცემებზე. ვინც ყურადღებით აკვირდებოდა შენახვის ყველა ხიბლს, რომელსაც ჩვენ აქ ვაანალიზებდით, იკითხავთ - რატომ გჭირდებათ მონაცემების სარეზერვო თაროს შიგნით, თუ მას აქვს ასეთი მაღალი საიმედოობა? ზედაპირზე ამ კითხვის პასუხი არის ის, რომ არავინ არ არის იმუნიტეტი ადამიანის შეცდომებისგან. მონაცემები საიმედოდ ინახება, მაგრამ თუ თავად ოპერატორმა შეცდომა დაუშვა, მაგალითად, მონაცემთა ბაზაში სასურველი ცხრილი წაშლა, ვერ ხერხდება ტექნიკის ხრიკები. მონაცემთა კლონირება ჩვეულებრივ ხდება LUN დონეზე. უფრო საინტერესო ფუნქციონირება მოცემულია ფოტოგრაფიის მექანიზმით. გარკვეულწილად, ჩვენ ვიღებთ მონაცემების სრული შინაგანი ასლის (კლონას) ყველა ხიბლს, მაშინ როდესაც თავად არ ვიღებთ თაროს შიგნით გადაწერილი მონაცემების რაოდენობას 100%, რადგან ასეთი მოცულობა ყოველთვის არ არის ხელმისაწვდომი ჩვენთვის. სინამდვილეში, ფოტოგრაფია არის მონაცემების დაუყოვნებელი "ფოტოგრაფია", რომელიც არ მოითხოვს დროსა და პროცესორის რესურსების შენახვას.

რასაკვირველია, არ შეიძლება აღვნიშნოთ მონაცემთა რეპლიკაციის პროგრამული უზრუნველყოფა, რომელსაც ხშირად სარკისებურად უწოდებენ. ეს არის ინფორმაციის სინქრონული ან ასინქრონული რეპლიკაციის (დუბლირების) მექანიზმი ერთი შენახვის სისტემადან ერთ ან მეტ დისტანციურ საცავში. რეპლიკაცია შესაძლებელია სხვადასხვა არხის საშუალებით - მაგალითად, თაროები FibreChannel ინტერფეისებით, შესაძლებელია სხვა შენახვის სისტემაში ასინქრონული, ინტერნეტის საშუალებით და დიდი დისტანციებით. ეს გამოსავალი უზრუნველყოფს საიმედო ინფორმაციის შენახვას და დაცვას კატასტროფებისგან.

ყოველივე ზემოაღნიშნულის გარდა, არსებობს უამრავი სხვა პროგრამული უზრუნველყოფის მექანიზმი, მონაცემთა მანიპულირებისთვის ...

DAS & NAS & SAN

თავად მონაცემთა შენახვის სისტემებს, მათ მშენებლობის პრინციპებს, მათ მიერ მოწოდებულ შესაძლებლობებს და ფუნქციონალურ ოქმებს გაეცანით, დროა შევეცადოთ მიღებული ცოდნა სამუშაო სქემაში გაერთიანდეს. შევეცადოთ განვიხილოთ შენახვის სისტემების ტიპები და მათი დაკავშირების ტოპოლოგია ერთ სამუშაო ინფრასტრუქტურასთან.

მოწყობილობები DAS (პირდაპირი თანდართული შენახვა) - შენახვის სისტემები, რომლებიც უშუალოდ უკავშირდებიან სერვერს. ეს მოიცავს როგორც უმარტივეს SCSI სისტემას, რომელიც უკავშირდება სერვერის SCSI / RAID კონტროლერს და FibreChannel მოწყობილობებს, რომლებიც პირდაპირ უკავშირდება სერვერს, თუმცა ისინი განკუთვნილია SAN– ებისთვის. ამ შემთხვევაში, DAS ტოპოლოგია არის დეგენერატული SAN (შენახვის არეალის ქსელი):

სურათები \\ RAID \\ 12.გფ

ამ სქემაში, ერთ-ერთ სერვერს აქვს წვდომა შენახვის სისტემაში შენახულ მონაცემებზე. მომხმარებლები მონაცემებს წვდომენ ამ სერვერზე ქსელის საშუალებით. ანუ, სერვერს აქვს ბლოკზე წვდომა შენახვის სისტემის მონაცემებზე, და კლიენტები უკვე იყენებენ ფაილების წვდომას - ეს კონცეფცია ძალიან მნიშვნელოვანია გაგებისთვის. აშკარაა ასეთი ტოპოლოგიის უარყოფითი მხარეები:

* დაბალი საიმედოობა - ქსელის პრობლემების ან სერვერის დაშლის შემთხვევაში, მონაცემები ერთდროულად მიუწვდომელი ხდება.

* მაღალი შეფერხება ერთი სერვერის მიერ ყველა მოთხოვნის დამუშავებისა და გამოყენებული ტრანსპორტის გამო (ყველაზე ხშირად - IP).

* ქსელის მაღალი დატვირთვა, ხშირად განსაზღვრავს მასშტაბურობის შეზღუდვებს კლიენტების დამატებით.

* ცუდი მართვა - მთელი ტევადობა ხელმისაწვდომია ერთ სერვერზე, რაც ამცირებს მონაცემთა განაწილების მოქნილობას.

* რესურსების დაბალი ათვისება - ძნელია მონაცემების საჭირო მოცულობის პროგნოზირება, ორგანიზაციაში DAS მოწყობილობის ზოგიერთ მოწყობილობას შეიძლება ჰქონდეს სიმძლავრის ჭარბი რაოდენობა (დისკზე), ზოგიერთს შეიძლება არ ჰქონდეს საკმარისი - გადანაწილება ხშირად შეუძლებელია ან დროს მოითხოვს.

მოწყობილობები NAS (ქსელის მიმაგრებული შენახვა) - უშუალო ქსელთან დაკავშირებული საცავის მოწყობილობები. სხვა სისტემებისგან განსხვავებით, NAS უზრუნველყოფს ფაილების წვდომას მონაცემებზე და სხვა არაფერი. NAS მოწყობილობები არის შენახვის სისტემის და სერვერის ერთობლიობა, რომელთანაც იგი არის დაკავშირებული. მისი უმარტივესი ფორმით, რეგულარული ქსელის სერვერი, რომელიც უზრუნველყოფს ფაილურ რესურსებს, არის NAS მოწყობილობა:

სურათები \\ RAID \\ 13.gif

ასეთი სქემის ყველა უარყოფითი მხარეა DAS ტოპოლოგიის მსგავსი, გარკვეული გამონაკლისით. დამატებული მინუსებიდან, ჩვენ აღვნიშნავთ, რომ გაზრდილი და ხშირად მნიშვნელოვნად, ღირებულებაც - თუმცა, ღირებულება პროპორციულია ფუნქციონალურობისთვის, და აქ ხშირად "არის რამე გადასახადი". NAS მოწყობილობები შეიძლება იყოს ყველაზე მარტივი „ყუთები“ ერთი Ethernet პორტით და ორი მყარი დისკი RAID1- ში, რაც საშუალებას აძლევს ფაილებზე წვდომა მხოლოდ ერთი CIFS (Common Internet File System) ოქმის გამოყენებით უზარმაზარ სისტემებში, რომლებშიც შესაძლებელია ასობით მყარი დისკის დაყენება და ფაილების წვდომა. გათვალისწინებულია ათეული სპეციალიზირებული სერვერის მიერ NAS სისტემის შიგნით. გარე Ethernet პორტების რაოდენობამ შეიძლება მიაღწიოს მრავალ ათეულს, ხოლო შენახული მონაცემების სიმძლავრე შეიძლება იყოს რამდენიმე ასეული ტერაბაიტი (მაგალითად, EMC Celerra CNS). ამგვარი მოდელების საიმედოობა და შესრულება შეუძლია გვერდის ავლით მრავალი SAN midrange მოწყობილობისთვის. საინტერესოა, რომ NAS მოწყობილობები შეიძლება იყოს SAN ქსელის ნაწილი და არ გააჩნდეთ საკუთარი დისკები, მაგრამ მხოლოდ ფაილების წვდომას უზრუნველყოფენ ბლოკის შესანახი მოწყობილობებზე. ამ შემთხვევაში, NAS იკავებს ძლიერი სპეციალიზირებული სერვერის ფუნქციას, ხოლო SAN იძენს შენახვის მოწყობილობას, ანუ ვიღებთ DAS ტოპოლოგიას, რომელიც შედგება NAS და SAN კომპონენტებისგან.

NAS მოწყობილობები ძალიან კარგია ჰეტეროგენულ გარემოში, სადაც ერთდროულად გჭირდებათ მრავალი ფაილის მონაცემების სწრაფი ფაილის წვდომა. იგი ასევე უზრუნველყოფს შესანახი საიმედოობის შენარჩუნებას და სისტემის მართვის მოქნილობას, თან ერთვის მარტივი მოვლა. ჩვენ არ ვილაპარაკებთ საიმედოობაზე - შენახვის ამ ასპექტზე განხილულია ზემოთ. რაც შეეხება ჰეტეროგენულ გარემოს, ფაილების წვდომა ერთი NAS სისტემის საშუალებით შეგიძლიათ მიიღოთ TCP / IP, CIFS, NFS, FTP, TFTP და სხვათა საშუალებით, მათ შორის, NAS iSCSI- ის სამიზნეზე მუშაობის უნარის ჩათვლით, რაც უზრუნველყოფს ოპერაციას სხვადასხვა OS- ით, დამონტაჟებულია მასპინძლებზე. რაც შეეხება მენეჯმენტის გამარტივებას და მენეჯმენტის მოქნილობას, ამ შესაძლებლობებს უზრუნველყოფილია სპეციალიზებული ოპერაციული სისტემა, რომლის გამორთვა რთულია და მისი შენარჩუნება არ არის საჭირო, ასევე ფაილებზე წვდომის უფლების დიფერენციაციის სიმარტივე. მაგალითად, შესაძლებელია Windows Active Directory- ის გარემოში მუშაობა საჭირო ფუნქციონირების მხარდაჭერით - ეს შეიძლება იყოს LDAP, Kerberos Authentication, Dynamic DNS, ACLs, კვოტები (კვოტები), ჯგუფური პოლიტიკის ობიექტები და SID- ისტორია. ვინაიდან ფაილებზე წვდომა ხორციელდება, მათი სახელები შეიძლება შეიცავდეს სხვადასხვა ენების სიმბოლოებს, ბევრი NAS უზრუნველყოფს მხარდაჭერას UTF-8, Unicode კოდირებისთვის. NAS– ის არჩევანს კიდევ უფრო ფრთხილად უნდა მიუახლოვდეთ ვიდრე DAS მოწყობილობებს, რადგან ასეთმა მოწყობილობამ შეიძლება არ დაუჭიროს თქვენთვის საჭირო სერვისების მხარდაჭერა, მაგალითად, ფაილური სისტემების დაშიფვრა (EFS) Microsoft– დან და IPSec– დან. სხვათა შორის, თქვენ ხედავთ, რომ NAS ბევრად უფრო იშვიათია ვიდრე SAN მოწყობილობები, მაგრამ ასეთი სისტემების პროცენტული მაჩვენებელი კვლავ მუდმივად, თუმც ნელა იზრდება, იზრდება - ძირითადად DAS– ის ხალხმრავლობის გამო.

მოწყობილობების დასაკავშირებლად SAN (შენახვის არეალის ქსელი) - მოწყობილობების მონაცემთა შენახვის ქსელში დასაკავშირებლად. შენახვის არეალის ქსელი (SAN) არ უნდა იყოს დაბნეული ადგილობრივ ქსელთან - ეს არის სხვადასხვა ქსელი. ყველაზე ხშირად, SAN დაფუძნებულია FibreChannel– ის პროტოკოლის დასტაზე და უმარტივეს შემთხვევაში შედგება შენახვის სისტემების, კონცენტრატორებისა და სერვერებისგან, რომლებიც დაკავშირებულია ოპტიკური საკომუნიკაციო არხებით. ფიგურაში ვხედავთ ძალიან საიმედო ინფრასტრუქტურას, რომელშიც სერვერები ერთდროულად უკავშირდებიან ადგილობრივ ქსელს (მარცხნივ) და შენახვის ქსელს (მარჯვნივ):

სურათები \\ RAID \\ 14.gif

მოწყობილობებისა და მათი მუშაობის პრინციპების შესახებ საკმაოდ დეტალური განხილვის შემდეგ, ჩვენთვის ადვილი იქნება სან ტოპოლოგიის გაგება. ფიგურაში ვხედავთ ერთიანი საცავის სისტემას მთელი ინფრასტრუქტურისთვის, რომელსაც ორი სერვერი უკავშირდება. სერვერებს ზედმეტი წვდომის გზა აქვთ - თითოეულს აქვს ორი HBA (ან ერთი ორმაგი პორტი, რაც ამცირებს შეცდომების ტოლერანტობას). შენახვის მოწყობილობას აქვს 4 პორტი, რომლითაც იგი დაკავშირებულია 2 კონცენტრატორთან. თუ ვივარაუდებთ, რომ შიგნით არის ორი ზედმეტი პროცესორის მოდული, ადვილი გამოსაცნობია, რომ საუკეთესო კავშირის სქემაა, როდესაც თითოეული შეცვლა უკავშირდება როგორც პირველ, ისე მეორე პროცესორის მოდულს. ასეთი სქემა უზრუნველყოფს საცავის სისტემაზე განთავსებულ ნებისმიერ მონაცემს წვდომის პროცესორის მოდულის, შეცვლის ან წვდომის გზის შემთხვევაში. ჩვენ უკვე შევისწავლეთ საცავის სისტემების საიმედოობა, ორი კონცენტრატორის და ორი ქარხნის შემდგომი გაზრდა ტოპოლოგიის ხელმისაწვდომობა, ასე რომ, თუ გადართვის ერთ-ერთი ერთეული მოულოდნელად ჩავარდნის ან ადმინისტრატორის შეცდომის გამო ვერ მოხდება, მეორე ნორმალურად იმუშავებს, რადგან ეს ორი მოწყობილობა ერთმანეთთან არ არის დაკავშირებული.

ნაჩვენები სერვერის კავშირი ეწოდება მაღალი ხელმისაწვდომობის კავშირს, თუმცა HBA- ების კიდევ უფრო დიდი რაოდენობის დაყენება შესაძლებელია საჭიროების შემთხვევაში სერვერზე. ფიზიკურად, თითოეულ სერვერს აქვს მხოლოდ ორი კავშირი SAN- ში, მაგრამ ლოგიკურად, შენახვის სისტემა ოთხი ბილიკით არის ხელმისაწვდომი - თითოეული HBA უზრუნველყოფს შესანახ სისტემაზე ორ კავშირის წერტილს, ცალკე თითოეული პროცესორის მოდულისთვის (ეს მახასიათებელი უზრუნველყოფს შეცვლის ორმაგ კავშირს შესანახ სისტემასთან). ამ დიაგრამაში ყველაზე სანდო მოწყობილობაა სერვერი. ორი კონცენტრატორის საშუალებით ხდება შეკვეთის საიმედოობა 99,99%, მაგრამ სერვერი შეიძლება სხვადასხვა მიზეზის გამო ვერ აღმოჩნდეს. თუ საჭიროა მთელი სისტემის საიმედო ფუნქციონირება, სერვერები გაერთიანებულია კლასტერში, ზემოთ ნახსენები დიაგრამა არ საჭიროებს რაიმე აპარატურულ დამატებას ამგვარი მუშაობის ორგანიზებისთვის, და ითვლება SAN– ის საცნობარო ორგანიზაციად. უმარტივესი შემთხვევაა სერვერები, რომლებიც დაკავშირებულია ერთი გზით, ერთი გადართვის საშუალებით, შენახვის სისტემაში. ამასთან, ორი პროცესორის მოდულის მქონე საცავის სისტემა უნდა იყოს დაკავშირებული კომუტატორთან მინიმუმ ერთი არხით თითო მოდულთან - დანარჩენი პორტები შეიძლება გამოყენებულ იქნას სერვერების შენახვის სისტემაში უშუალო კავშირისთვის, რაც ზოგჯერ აუცილებელია. და არ უნდა დაგვავიწყდეს, რომ SAN შეიძლება აშენდეს არა მხოლოდ FibreChannel- ის საფუძველზე, არამედ iSCSI პროტოკოლის საფუძველზეც - ამავდროულად, გადართვისთვის შეგიძლიათ გამოიყენოთ მხოლოდ სტანდარტული Ethernet მოწყობილობები, რაც ამცირებს სისტემის ღირებულებას, მაგრამ აქვს რამდენიმე დამატებითი მინუსი (მითითებულია განყოფილებაში, რომელიც განიხილავს iSCSI ) ასევე საინტერესოა სერვერების შენახვის სისტემიდან დატვირთვის შესაძლებლობა - სერვერებში შიდა მყარი დისკის არსებობა არც კი არის საჭირო. ამრიგად, საბოლოოდ ამოღებულია ნებისმიერი მონაცემების შენახვის ამოცანა სერვერებიდან. თეორიულად, სპეციალიზებული სერვერი შეიძლება გადავიდეს ჩვეულებრივი რიცხვის გამანადგურებლად, ყოველგვარი დისკის გარეშე, რომლის განმსაზღვრელი კორპუსებია ცენტრალური პროცესორები, მეხსიერება, ასევე ინტერფეისი, რათა ურთიერთქმედდეს გარე სამყაროსთან, მაგალითად, Ethernet და FibreChannel პორტები. მსგავსი ტიპის მოწყობილობები თანამედროვე ბლეიდის სერვერებია.

აქვე მინდა აღვნიშნო, რომ მოწყობილობები, რომელთანაც SAN– თან დაკავშირება შესაძლებელია, არ შემოიფარგლება მხოლოდ დისკის შესანახი სისტემებით - ეს შეიძლება იყოს დისკის ბიბლიოთეკა, ფირის ბიბლიოთეკა (ფირზე დრაივები), ოპტიკური დისკებზე მონაცემების შესანახი მოწყობილობები (CD / DVD და ა.შ.) და მრავალი სხვა.

SAN– ს მინუსებიდან ჩვენ აღვნიშნავთ მხოლოდ მისი კომპონენტების მაღალ ფასს, მაგრამ უპირატესობა უდავოა:

* გარე საცავის სისტემებზე განთავსებულ მონაცემებზე წვდომის მაღალი საიმედოობა. SAN ტოპოლოგიის დამოუკიდებლობა გამოყენებული შენახვის სისტემებისა და სერვერებისგან.

* მონაცემთა ცენტრალიზებული შენახვა (საიმედოობა, დაცვა).

* გადართვისა და მონაცემთა მოსახერხებელი ცენტრალიზებული მართვა.

* ინტენსიური I / O ტრაფიკის გადატანა ცალკე ქსელში, ქსელის გადატვირთვა.

* მაღალი სიჩქარე და დაბალი ლატენტურობა.

* ლოგიკური SAN სტრუქტურის მასშტაბურობა და მოქნილობა

* გეოგრაფიულად, SAN- ის ზომები, განსხვავებით კლასიკური DAS- სგან, პრაქტიკულად შეუზღუდავია.

* სერვერებს შორის რესურსების სწრაფად განაწილების შესაძლებლობა.

* ბრტყელი ტოლერანტული კასეტური გადაწყვეტილებების შექმნის შესაძლებლობა, არსებული დამატებითი SAN– ს საფუძველზე.

* მარტივი სარეზერვო სქემა - ყველა მონაცემი ერთ ადგილზეა.

* დამატებითი ფუნქციების და სერვისების არსებობა (ფოტოების გადაღება, დისტანციური რეპლიკაცია).

* მაღალი უსაფრთხოების SAN.

დასკვნაში

ვფიქრობ, ჩვენ ადეკვატურად გავაშუქეთ თანამედროვე შენახვის სისტემებთან დაკავშირებული საკითხების ძირითადი ასორტიმენტი. იმედი ვიქონიოთ, რომ ასეთი მოწყობილობები კიდევ უფრო სწრაფად განვითარდება ფუნქციურად, ხოლო მონაცემთა მართვის მექანიზმების რაოდენობა მხოლოდ გაიზრდება.

დასასრულს, შეგვიძლია ვთქვათ, რომ NAS და SAN გადაწყვეტილებები რეალურ ბუმს განიცდიან. იზრდება მწარმოებლების რაოდენობა და მრავალფეროვანი გადაწყვეტილებები, იზრდება მომხმარებელთა ტექნიკური ცოდნა. ჩვენ შეგვიძლია უსაფრთხოდ ვივარაუდოთ, რომ უახლოეს მომავალში თითქმის ყველა გამოთვლილ გარემოში გამოჩნდება ერთი ან სხვა საცავი სისტემა.

ნებისმიერი მონაცემი ჩნდება ჩვენს წინაშე ინფორმაციის სახით. ნებისმიერი კომპიუტერული მოწყობილობის მუშაობის მნიშვნელობა ინფორმაციის დამუშავებაა. ბოლო დროს, მისი ზრდის მოცულობა ზოგჯერ საშინელი იყო, ამიტომ შენახვის სისტემები და სპეციალიზირებული პროგრამული უზრუნველყოფა უდავოდ იქნება IT ბაზრის ყველაზე პოპულარული პროდუქტები მომდევნო წლებში.

როგორ დავაყენოთ შენახვის სისტემების არქიტექტურა? მეჩვენება, რომ ამ საკითხის აქტუალობა მხოლოდ მომავალში გაიზრდება. როგორ გავიგოთ ყველა ამ ტიპის შეთავაზება, რომელიც ხელმისაწვდომია ბაზარზე? მინდა გავაფრთხილო დაუყოვნებლივ, რომ ეს პოსტი არ არის განკუთვნილი ზარმაცებისთვის ან მათთვის, ვისაც ბევრი რამის კითხვა არ სურს.

შესაძლებელია შენახვის სისტემების საკმაოდ წარმატებით კლასიფიკაცია, ისევე, როგორც ბიოლოგები ქმნიან ოჯახურ კავშირებს ცოცხალ ორგანიზმების სახეობებს შორის. თუ გსურთ, შეგიძლიათ მას უწოდოთ ინფორმაციის შენახვის ტექნოლოგიების სამყაროს "სიცოცხლის ხე".

ასეთი ხეების მშენებლობა ხელს უწყობს მიმდებარე სამყაროს უკეთეს გაგებას. კერძოდ, თქვენ შეგიძლიათ შექმნათ ნებისმიერი ტიპის საცავის სისტემების წარმოშობისა და განვითარების დიაგრამა, და სწრაფად გაითვალისწინოთ რა დევს ბაზარზე არსებული ნებისმიერი ახალი ტექნოლოგიის საფუძველზე. ეს საშუალებას გაძლევთ დაუყოვნებლივ განსაზღვროთ გამოსავლის სიძლიერე და სისუსტე.

საცავი, რომელიც საშუალებას გაძლევთ იმუშაოთ ნებისმიერი სახის ინფორმაციასთან, შეიძლება არქიტექტურულად დაიყოს 4 მთავარ ჯგუფად. მთავარი ის არის, რომ არ დაიხრჩოთ ზოგი რამ, რაც დამაბნეველია. მრავალი ადამიანი ცდილობს პლატფორმების კლასიფიკაციას ისეთი ”ფიზიკური” კრიტერიუმების საფუძველზე, როგორიცაა ურთიერთდაკავშირება (”მათ ყველა აქვთ შიდა ავტობუსი კვანძებს შორის!”), ან პროტოკოლი (”ეს არის ბლოკი, ან NAS, ან მრავალ პროტოკოლის სისტემა!”), ან დაყოფილია აპარატურასა და პროგრამულ უზრუნველყოფაზე ("ეს მხოლოდ პროგრამაა სერვერზე!").

ეს არის სრულიად არასწორი მიდგომა კლასიფიკაციისკენ. ერთადერთი ჭეშმარიტი კრიტერიუმია პროგრამული უზრუნველყოფის არქიტექტურა, რომელიც გამოიყენება კონკრეტულ გადაწყვეტაში, რადგან სისტემის ყველა ძირითადი მახასიათებელი მასზეა დამოკიდებული. შენახვის სისტემის დანარჩენი კომპონენტები დამოკიდებულია იმაზე, თუ რომელი პროგრამული უზრუნველყოფის არქიტექტურა შეირჩა დეველოპერებმა. და ამ თვალსაზრისით, "აპარატურა" და "პროგრამული" სისტემები შეიძლება იყოს მხოლოდ ერთი ან სხვა არქიტექტურის ვარიაციები.

მაგრამ არ შემიშალოთ, არ მინდა ვთქვა, რომ განსხვავება მათ შორის მცირეა. ეს არ არის მხოლოდ ფუნდამენტური.

მე მინდა კიდევ რამის გარკვევა, სანამ საქმიანობას არ დავიწყებ. ჩვენი ბუნებისთვის ჩვეულებრივია ისმის კითხვები, "და რომელია ეს საუკეთესო / სწორი?". ამაზე მხოლოდ ერთი პასუხი არსებობს: "არსებობს უკეთესი გადაწყვეტილებები კონკრეტული სიტუაციებისთვის ან დატვირთვის ტიპებისთვის, მაგრამ არ არსებობს უნივერსალური იდეალური გამოსავალი." ზუსტად დატვირთვის თვისებები კარნახობს არჩევანის არქიტექტურასდა სხვა არაფერი.

სხვათა შორის, მე ცოტა ხნის წინ მონაწილეობა მივიღე სასაცილო საუბარში მონაცემთა ცენტრების თემასთან დაკავშირებით, რომლებიც ექსკლუზიურად მუშაობენ Flash დისკებზე. აღფრთოვანებული ვარ ვნებიანი ნებისმიერი გამოვლინებით და აშკარაა, რომ ბლიკი კონკურენციის მიღმაა იმ სიტუაციებში, როდესაც შესრულება და ლატენტობა გადამწყვეტ როლს თამაშობენ (სხვა მრავალ ფაქტორს შორის). მაგრამ უნდა ვაღიარო, რომ ჩემი თანამოსაუბრეები შეცდნენ. ჩვენ გვყავს ერთი კლიენტი, უამრავი ადამიანი იყენებს მის მომსახურებებს ყოველდღე და მისი გაცნობიერების გარეშე. შეუძლია თუ არა მას მთლიანად გადახვიდეს Flash? არა.

ეს შესანიშნავი მომხმარებელია. და აქ არის კიდევ ერთი, დიდი, 10-ჯერ მეტი. ისევ და ისევ, არ შემიძლია ვეთანხმები, რომ ამ კლიენტს შეუძლია ექსკლუზიურად ჩართოს flash:

ჩვეულებრივ, როგორც კონტრარგუმენტი, ისინი ამბობენ, რომ საბოლოო ჯამში, flash მიაღწევს განვითარების ისეთ დონეს, რომ იგი დაბნელება მოახდინოს მაგნიტურ დისკებზე. ამ სიფრთხილით გამოყენებული იქნება flash გამოყენებული დაწყნარებით. მაგრამ ყველა შემთხვევაში არაა მიზანშეწონილი დედუქციის გამოყენება, ასევე კომპრესიის გამოყენება.

ისე, ერთი მხრივ, ფლეშ მეხსიერება გახდება იაფი, გარკვეულ ზღვრამდე. მეჩვენებოდა, რომ ეს მოხდებოდა გარკვეულწილად სწრაფად, მაგრამ SSD- ები, რომელთა მოცულობა 1 ტბა-ს შეადგენს 550 დოლარად, უკვე არის შესაძლებელი, ეს დიდი პროგრესია. რა თქმა უნდა, ტრადიციული მყარი დისკის შემქმნელები ასევე არ არიან უსაქმურები. 2017-2018 წლის რეგიონში კონკურენცია უნდა გამწვავდეს, რადგან დაინერგება ახალი ტექნოლოგიები (სავარაუდოდ, ფაზური ცვლა და ნახშირბადის ნანოტუბები). ეს საერთოდ არ არის დაპირისპირება Flash და მყარ დისკებს შორის, ან თუნდაც პროგრამულ და აპარატურულ გადაწყვეტილებებს შორის არქიტექტურა.

ეს იმდენად მნიშვნელოვანია, რომ თითქმის შეუძლებელია შენახვის არქიტექტურის შეცვლა თითქმის ყველაფრის გადაკეთების გარეშე. ეს არის, ფაქტობრივად, ახალი სისტემის შექმნის გარეშე. ამიტომ, საწყობები, როგორც წესი, იქმნება, ვითარდება და იღუპება ერთიან თავდაპირველად შერჩეული არქიტექტურის ფარგლებში.

ოთხი ტიპის საცავი

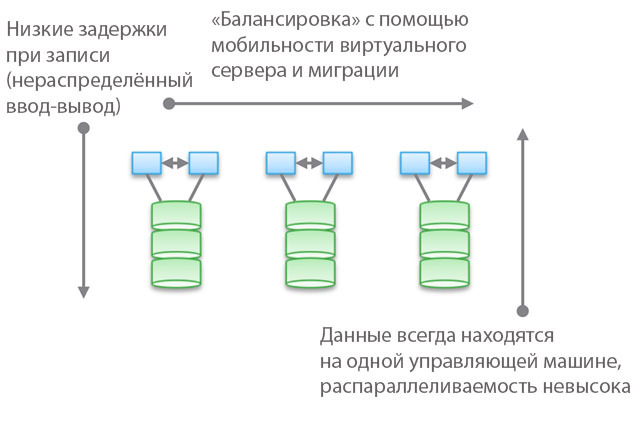

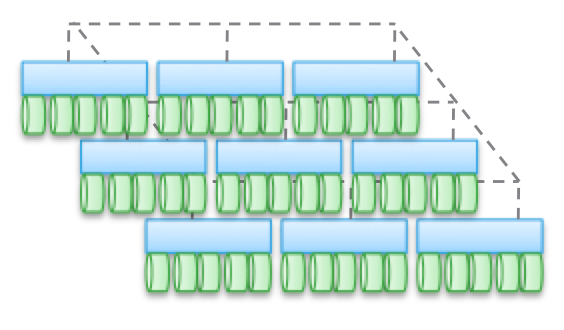

ტიპი 1. კლასტერული არქიტექტურა. ისინი არ არის შექმნილი კვანძებისთვის საერთო მეხსიერებისათვის, ფაქტობრივად, ყველა მონაცემი ერთ კვანძშია. არქიტექტურის ერთ – ერთი მახასიათებელია ის, რომ ზოგჯერ მოწყობილობები „კვეთავენ“ (მაშინაც კი), თუნდაც „რამდენიმე კვანძიდან“ მისასვლელი. კიდევ ერთი თვისება ის არის, რომ თქვენ შეგიძლიათ აირჩიოთ მანქანა, უთხარით მას რამდენიმე დისკი და თქვით "ამ აპარატს აქვს წვდომა ამ მედიაზე მონაცემებზე". ფიგურაში ლურჯი მიუთითებს CPU / მეხსიერების / input-გამომავალი სისტემის, ხოლო მწვანეში - მედიაში, რომელზედაც მონაცემები ინახება (ფლეშ ან მაგნიტური დისკები).

ამ ტიპის არქიტექტურა ხასიათდება მონაცემების პირდაპირი და ძალიან სწრაფი დაშვებით. მანქანებს შორის მცირე შეფერხებები იქნება, რადგან I / O სარკეობა და ქეშირება გამოიყენება მაღალი ხელმისაწვდომობის უზრუნველსაყოფად. ზოგადად, შედარებით პირდაპირი წვდომა მოცემულია კოდი ფილიალის გასწვრივ. პროგრამული უზრუნველყოფის შენახვა საკმაოდ მარტივია და აქვთ დაბალი ლატენტურობა, ამიტომ მათ ხშირად აქვთ მდიდარი ფუნქციონირება, მონაცემთა სერვისები მარტივად ემატება. გასაკვირი არ არის, რომ ყველაზე მეტი სტარტაპი იწყება ასეთი საცავებით.

გთხოვთ გაითვალისწინოთ, რომ ამ ტიპის არქიტექტურის ერთ – ერთი სახეობაა PCIe მოწყობილობა არაჰა-სერვერებისთვის (Fusion-IO, XtremeCache გაფართოების ბარათები). თუ ჩვენ დავამატებთ პროგრამებს განაწილებულ შენახვას, თანმიმდევრულობას და მას HA- ს მოდელს, მაშინ ასეთი პროგრამული უზრუნველყოფის შენახვა შეესაბამება ამ პოსტში აღწერილ ოთხი ტიპის არქიტექტურას.

"ფედერალური მოდელების" გამოყენება ხელს უწყობს ამ ტიპის არქიტექტურის ჰორიზონტალური მასშტაბურობის გაუმჯობესებას მენეჯმენტის თვალსაზრისით. ამ მოდელებს შეუძლიათ გამოიყენონ სხვადასხვა მიდგომები მონაცემთა გადაადგილების გაზრდის მიზნით, მასპინძელ აპარატებსა და შენახვას შორის რუბალანსისთვის მაგალითად, VNX- ის ფარგლებში, ეს ნიშნავს "VDM მობილობას". მაგრამ ვფიქრობ, რომ მას "ჰორიზონტალურად მასშტაბურ არქიტექტურად" უწოდებენ. ჩემი გამოცდილებით, მომხმარებლების უმეტესობა იზიარებს ამ შეხედულებას. ამის მიზეზია მონაცემების ადგილმდებარეობა ერთ საკონტროლო მანქანაზე, ზოგჯერ - „აპარატურულ კაბინეტში“ (დანართის უკან). მათი გადატანა შესაძლებელია, მაგრამ ისინი ყოველთვის ერთ ადგილზე იქნებიან. ერთი მხრივ, ეს ამცირებს ციკლების რაოდენობას და ჩაწერის შეფერხებას. მეორეს მხრივ, თქვენს ყველა მონაცემს ერთ საკონტროლო მანქანა ემსახურება (სხვა აპარატისგან არაპირდაპირი წვდომა შესაძლებელია). მეორე და მესამე ტიპის არქიტექტურისგან განსხვავებით, რომელზეც ქვემოთ ვისაუბრებთ, აქ დაბალანსება და დარეგულირება მნიშვნელოვან როლს ასრულებს.

ობიექტურად რომ ვთქვათ, ეს აბსტრაქტული ფედერალური დონე გულისხმობს ლატენტაციის უმნიშვნელო ზრდას, რადგან ის იყენებს პროგრამული უზრუნველყოფის გადამისამართებას. ეს ჰგავს გართულებულ კოდს და იზრდება 2 და 3 ტიპის არქიტექტურის ტიპური ლატენტურობა და ნაწილობრივ გამორიცხავს პირველი ტიპის უპირატესობებს. როგორც კონკრეტული მაგალითი, UCS Invicta, ერთგვარი "სილიკონის საცავის მარშრუტიზატორები". NetApp FAS 8.x– ის შემთხვევაში, რომელიც მუშაობს კლასტერულ რეჟიმში, კოდი საკმაოდ რთულია ფედერალური მოდელის შემოღებით.

კასეტური ხუროთმოძღვრების გამოყენებით პროდუქტები - VNX ან NetApp FAS, Pure, Tintri, Nimble, Nexenta და (ვფიქრობ) UCS Invicta / UCS. ზოგი "ტექნიკის" გადაწყვეტილებებია, ზოგი "მხოლოდ პროგრამული უზრუნველყოფა", ზოგი კი "პროგრამული უზრუნველყოფა ტექნიკის კომპლექსების სახით". ყველა მათგანი მონაცემების დამუშავების თვალსაზრისით ძალიან განსხვავებულია (Pure და UCS Invicta / Whiptail, მხოლოდ ფლეშ დრაივები გამოიყენება). მაგრამ არქიტექტურულად ყველა ჩამოთვლილი პროდუქტი უკავშირდება. მაგალითად, თქვენ კონფიგურაციას უტარებთ მონაცემთა დამუშავების სერვისებს ექსკლუზიურად სარეზერვო პროგრამისთვის, პროგრამული უზრუნველყოფის დასტა ხდება მონაცემთა დომენი, თქვენი NAS მუშაობს როგორც საუკეთესო სარეზერვო ინსტრუმენტი მსოფლიოში - და ეს არის ასევე პირველი ტიპის ტიპის არქიტექტურა.

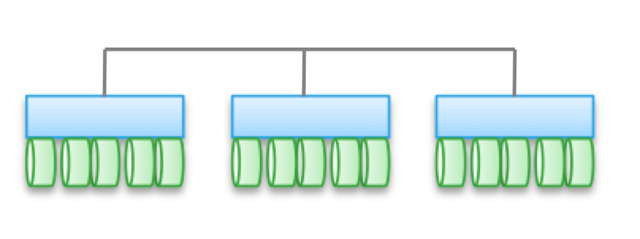

ტიპი 2. სუსტი ურთიერთდამოკიდებულ, ჰორიზონტალურად მასშტაბური არქიტექტურები. კვანძები არ იზიარებენ მეხსიერებას, მაგრამ მონაცემები თავად არის რამდენიმე კვანძისთვის. ეს არქიტექტურა გულისხმობს მონაცემების ჩაწერისთვის უფრო მეტი ინტეროდის ბმულების გამოყენებას, რაც ზრდის ციკლების რაოდენობას. მიუხედავად იმისა, რომ წერის ოპერაციები ნაწილდება, ისინი ყოველთვის თანმიმდევრულია.

გაითვალისწინეთ, რომ ეს არქიტექტურები არ იძლევა კოდის მაღალ ხელმისაწვდომობას კოპირების და მონაცემთა განაწილების ოპერაციების გამო. ამავე მიზეზით, ყოველთვის უფრო მეტი I / O ოპერაციაა, ვიდრე შედარებით მარტივი კასეტური არქიტექტურები. ასე რომ, შესრულება ოდნავ დაბალია, ჩაწერის დაგვიანების მცირე დონის მიუხედავად (NVRAM, SSD და ა.შ.).

არქიტექტურის ზოგიერთ სახეობაში, კვანძები ხშირად იყოფა ქვეჯგუფებად, დანარჩენებს კი ქვეჯგუფების (მეტამონაცემების კვანძების) მართვისთვის იყენებენ. მაგრამ აქ ვლინდება ზემოაღნიშნული ეფექტები „ფედერალურ მოდელებზე“.

ასეთი არქიტექტურები საკმაოდ მარტივია მასშტაბური. მას შემდეგ, რაც მონაცემები ინახება რამდენიმე ადგილას და შეიძლება მრავალი კვანძის დამუშავება, ეს არქიტექტურები შეიძლება იყოს შესანიშნავი ამოცანებისთვის, როდესაც საჭიროა კითხვის განაწილება. გარდა ამისა, ისინი კარგად ერწყმის სერვერის / შენახვის პროგრამას. მაგრამ უმჯობესია გამოიყენოთ მსგავსი არქიტექტურები გარიგების დატვირთვის პირობებში: მათი განაწილებული ხასიათის გამო, თქვენ არ შეგიძლიათ გამოიყენოთ HA სერვერი, ხოლო სუსტი კონჯუზია საშუალებას გაძლევთ გვერდის ავლით Ethernet.

ამ ტიპის არქიტექტურაში გამოიყენება ისეთი პროდუქტები, როგორიცაა EMC ScaleIO და Isilon, VSAN, Nutanix და Simplivity. როგორც ტიპი 1-ის შემთხვევაში, ყველა ეს გადაწყვეტილება ერთმანეთისაგან სრულიად განსხვავდება.

სუსტი კავშირი ნიშნავს, რომ ხშირად ამ არქიტექტურას შეუძლია მნიშვნელოვნად გაზარდოს კვანძების რაოდენობა. შეგახსენებთ, რომ ისინი არ იზიარებენ მეხსიერებას, თითოეული კვანძის კოდი სხვებისგან დამოუკიდებლად მუშაობს. მაგრამ ეშმაკი, როგორც ამბობენ, დეტალურად:

- რაც უფრო მეტი გავრცელებულია ჩაწერის ოპერაციები, მით უფრო მაღალია ლატენტურობა და ამცირებს IOP– ის ეფექტურობას. მაგალითად, Isilon- ში ფაილებისთვის განაწილების დონე ძალიან მაღალია და მიუხედავად იმისა, რომ ყოველ განახლებასთან ერთად შეფერხებები მცირდება, მაგრამ მაინც ვერასდროს აჩვენებს მაღალ შესრულებას. მაგრამ იზილონი ძალიან ძლიერია პარალელიზაციის თვალსაზრისით.

- თუ შეამცირებთ განაწილების ხარისხს (თუმცა დიდი კვანძების მიუხედავად), მაშინ შეფერხებები შეიძლება შემცირდეს, მაგრამ ამავე დროს თქვენ შეამცირებთ მონაცემთა კითხვის პარალელურად მუშაობის უნარს. მაგალითად, VSAN იყენებს "ვირტუალურ მანქანას, როგორც ობიექტს" მოდელს, რომლის საშუალებითაც შეგიძლიათ მრავალი ასლის გაშვება. როგორც ჩანს, ვირტუალური მანქანა უნდა იყოს ხელმისაწვდომი კონკრეტული მასპინძლისთვის. სინამდვილეში, VSAN- ში ის "გადადის" კვანძისკენ, რომელიც ინახავს თავის მონაცემებს. თუ ამ გადაწყვეტას იყენებთ, თქვენ თვითონ ნახავთ, თუ როგორ ახდენს ობიექტის ასლების გაზრდა გავლენას ლატენტურ და I / O ოპერაციებზე მთელ სისტემაში. მინიშნება: მეტი ეგზემპლარი \u003d უფრო მეტი დატვირთვა სისტემაზე მთლიანობაში, და დამოკიდებულება არის ხაზოვანი, როგორც ამას მოელით. მაგრამ VSAN- სთვის, ეს არ არის პრობლემა ვირტუალური აპარატის, როგორც ობიექტის მოდელის უპირატესობების გამო.

- კითხვის დროს მაღალი მასშტაბის და პარალელიზაციის პირობებში შესაძლებელია დაბალი ლატენტობის მიღწევა, მაგრამ მხოლოდ იმ შემთხვევაში, თუ მონაცემები ზუსტად არის გამოყოფილი და დაფიქსირებულია ასლების მცირე რაოდენობა. ეს მიდგომა გამოიყენება ScaleIO– ში. თითოეული ტომი იყოფა დიდი რაოდენობით ფრაგმენტად (1 მბ. ნაგულისხმევი), რომლებიც ნაწილდება ყველა ჩართულ კვანძში. შედეგი არის ძალიან მაღალი წაკითხვისა და გადანაწილების სიჩქარე, ძლიერი პარალელიზაციის გარდა. კასეტური კვანძებში შესაბამისი ქსელის ინფრასტრუქტურისა და SSD / PCIe Flash- ის გამოყენებისას წერის შეფერხება შეიძლება იყოს 1 ms-ზე ნაკლები. ამასთან, თითოეული წერის ოპერაცია ხორციელდება ორ კვანძში. რა თქმა უნდა, VSAN- სგან განსხვავებით, აქ ვირტუალური მანქანა არ განიხილება როგორც ობიექტი. თუ გავითვალისწინებთ, მაშინ მასშტაბურობა უფრო უარესი იქნება.

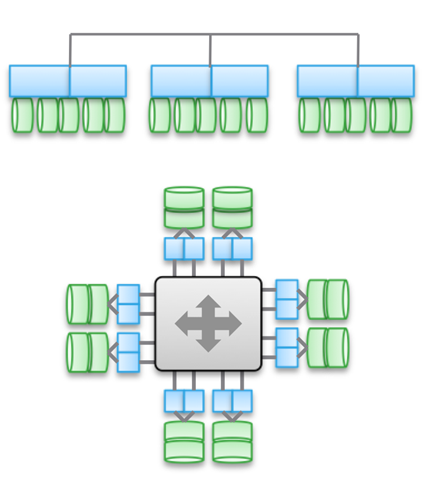

ტიპი 3. ძლიერ ურთიერთდაკავშირებული, ჰორიზონტალურად მასშტაბური არქიტექტურები. ეს იყენებს მეხსიერების გაზიარებას (ქეშირებისა და ზოგიერთი ტიპის მეტადატისთვის). მონაცემები ნაწილდება სხვადასხვა კვანძში. ამ ტიპის არქიტექტურა გულისხმობს ძალიან დიდი რაოდენობის ინტეროდური კავშირების გამოყენებას ყველა ტიპის ოპერაციისთვის.

მეხსიერების გაზიარება ამ არქიტექტურის ქვაკუთხედია. ისტორიულად, ყველა საკონტროლო აპარატის მეშვეობით შესაძლებელია სიმეტრიული I / O ოპერაციების ჩატარება (იხ. ილუსტრაცია). ეს საშუალებას გაძლევთ გადატვირთოთ დატვირთვა ნებისმიერი გაუმართაობის შემთხვევაში. ეს იდეა საფუძველი ჩაეყარა ისეთ პროდუქტებს, როგორიცაა Symmetrix, IBM DS, HDS USP და VSP. ისინი უზრუნველყოფენ ქეშზე გაზიარებულ წვდომას, ასე რომ, I / O პროცედურის კონტროლი შესაძლებელია ნებისმიერი აპარატისგან.

ილუსტრაციის ზედა დიაგრამა ასახავს EMC XtremIO არქიტექტურას. ერთი შეხედვით, მსგავსია ტიპი 2-ზე, მაგრამ ასე არ არის. ამ შემთხვევაში, განაწილებული მეტამონაცემების მოდელი გულისხმობს IB და დისტანციური პირდაპირი მეხსიერების დაშვებას, ისე რომ ყველა კვანძს ჰქონდეს წვდომა მეტამონაცემებზე. გარდა ამისა, თითოეული კვანძი არის HA წყვილი. როგორც ხედავთ, ისილონი და XtremIO ძალიან არქიტექტურულად განსხვავებულები არიან, თუმცა ეს არც ისე აშკარაა. დიახ, ორივეს ჰორიზონტალურად მასშტაბური ხუროთმოძღვრება აქვს, ორივე კი IB– ს ურთიერთდაკავშირებისთვის. მაგრამ Isilon- ში, XtremIO- სგან განსხვავებით, ეს კეთდება კვანძებს შორის მონაცემების გაცვლისას ლატენტაციის შესამცირებლად. ასევე, Isilon- ში, კვანძებს შორის კომუნიკაციისთვის შეგიძლიათ გამოიყენოთ Ethernet (ფაქტობრივად, ასე მუშაობს ვირტუალური მანქანა მასზე), მაგრამ ეს ზრდის ლატენტობას I / O ოპერაციების დროს. რაც შეეხება XtremIO- ს, დისტანციური პირდაპირი მეხსიერების წვდომას უდიდესი მნიშვნელობა აქვს მისი შესრულებისთვის.

სხვათა შორის, ნუ სულელობთ ილუსტრაციზე ორი დიაგრამის არსებობით - სინამდვილეში, ისინი იგივეა, რაც არქიტექტურულად. ორივე შემთხვევაში, გამოიყენება HA კონტროლერების წყვილი, საერთო მეხსიერება და ძალიან დაბალი ლატენტური ურთიერთკავშირი. სხვათა შორის, VMAX იყენებს მესაკუთრეთა ურთიერთდაკავშირებულ ავტობუსს, მაგრამ მომავალში შესაძლებელი იქნება IB- ის გამოყენება.

მაღალპროდუქტიულ არქიტექტურას ახასიათებს პროგრამის კოდის მაღალი სირთულე. ეს არის მათი დაბალი პრევალენტობის ერთ-ერთი მიზეზი. ზედმეტი პროგრამული სირთულე ასევე მოქმედებს დამატებული მონაცემების დამუშავების სერვისების რაოდენობაზე, რადგან ეს უფრო რთული კომპიუტერული დავალებაა.

ამ ტიპის არქიტექტურის უპირატესობებში შედის ხარვეზის ტოლერანტობა (სიმეტრიული I / O ყველა საკონტროლო მანქანაში), აგრეთვე XtremIO- ს შემთხვევაში, AFA- ს სფეროში დიდი შესაძლებლობები. მას შემდეგ, რაც ჩვენ კვლავ ვსაუბრობთ XtremIO- ზე, აღსანიშნავია, რომ მისი არქიტექტურა გულისხმობს მონაცემთა დამუშავების ყველა სერვისის განაწილებას. იგი ასევე ერთადერთი AFA გადაწყვეტაა ბაზარზე, რომელსაც აქვს ჰორიზონტალურად მასშტაბური არქიტექტურა, თუმცა დინამიური დამატება / გამორთვა კვანძები ჯერ არ განხორციელებულა. სხვა საკითხებთან ერთად, XtremIO იყენებს "ბუნებრივ" დედუქციას, ანუ ის მუდმივად აქტიური და "თავისუფალია" შესრულების თვალსაზრისით. მართალია, ეს ყველაფერი ზრდის სისტემის შენარჩუნების სირთულეს.

მნიშვნელოვანია გვესმოდეს ფუნდამენტური განსხვავება ტიპი 2-სა და მე –3 ტიპებს შორის, რაც უფრო მეტად არის დაკავშირებული ერთმანეთთან დაკავშირებული არქიტექტურა, მით უკეთესი და პროგნოზირებადი იქნება დაბალი ლატენტობის უზრუნველყოფა. მეორეს მხრივ, ამგვარი არქიტექტურის ფარგლებში უფრო რთულია კვანძების დამატება და მასშტაბის სისტემა. ყოველივე ამის შემდეგ, როდესაც თქვენ იყენებთ მეხსიერებას საერთო დაშვებას, ეს არის ერთჯერადი, უაღრესად კონჯუგირებული განაწილებული სისტემა. იზრდება გადაწყვეტილებების სირთულე და მასთან ერთად შეცდომების ალბათობაა. აქედან გამომდინარე, VMAX– ს შეიძლება ჰქონდეს 16 – მდე საკონტროლო მანქანა 8 ძრავში, ხოლო XtemIO– მდე 8 – მდე მანქანა 4 X – Brick– ში (ის მალე გაიზრდება 16 – მდე მანქანაში 8 ბლოკში). ოთხკუთხა ან კიდევ გაორმაგება ამ არქიტექტურებს წარმოუდგენლად რთულ ინჟინერულ გამოწვევას წარმოადგენს. შედარებისთვის, VSAN შეიძლება მასშტაბური იყოს “vSphere cluster size” (ახლა 32 კვანძი), Isilon შეიძლება შეიცავდეს 100 – ზე მეტ კვანძს, ხოლო ScaleIO საშუალებას გაძლევთ შექმნათ 1000 – ზე მეტი კვანძი. უფრო მეტიც, ეს ყველაფერი მეორე ტიპის არქიტექტურაა.

კიდევ ერთხელ მინდა ხაზგასმით აღვნიშნო, რომ არქიტექტურა დამოუკიდებლად განხორციელებულია. ზემოთ მოცემულ პროდუქტებში იყენებენ როგორც Ethernet- ს, ასევე IB- ს. ზოგი არის მხოლოდ პროგრამული გადაწყვეტილებები, ზოგი კი პროგრამული და აპარატების კომპლექსები, მაგრამ ამავე დროს ისინი გაერთიანებულია არქიტექტურული სქემებით.

ურთიერთკავშირების მრავალფეროვნების მიუხედავად, განაწილებული ჩანაწერის გამოყენება მნიშვნელოვან როლს თამაშობს მოცემულ ყველა მაგალითში. ეს საშუალებას გაძლევთ მიაღწიოთ გარიგების და ატომისობას, მაგრამ ამავე დროს აუცილებელია მონაცემთა მთლიანობის ფრთხილად მონიტორინგი. ასევე საჭიროა "მარცხის არეალის" ზრდის პრობლემის მოგვარება. ეს ორი წერტილი ზღუდავს აღწერილი ტიპების არქიტექტურის მასშტაბის მაქსიმალურ მასშტაბებს.

მცირე შემოწმება, თუ რამდენად ყურადღებით წაიკითხავთ ყველა ზემოთ: რომელი ტიპის Cisco UCS Invicta - 1 ან 3 ეკუთვნის? ფიზიკურად, ასე გამოიყურება მე -3 ტიპის, მაგრამ ეს არის მთელი რიგი C-Series USC სერვერები, რომლებიც დაკავშირებულია Ethernet- ით, აწარმოებენ Invicta პროგრამული უზრუნველყოფის დასტის (ადრე Whiptail) პროგრამას. მინიშნება: დააკვირდით არქიტექტურას და არა კონკრეტულ განხორციელებას

UCS Invicta- ს შემთხვევაში, მონაცემები ინახება თითოეულ კვანძში (UCS სერვერი ფლეშ დრაივებით, რომელიც დაფუძნებულია MLC). ცალკეულ არასამთავრობო HA კვანძს, რომელიც წარმოადგენს ცალკეულ სერვერს, შეუძლია პირდაპირ გადასცეს ლოგიკური ერთეულის ნომერი (LUN). თუ გადაწყვეტთ მეტი კვანძების დამატებას, შესაძლებელია, რომ სისტემა ცუდად მასშტაბუდეს, მაგალითად, ScaleIO ან VSAN. ყოველივე ეს მიგვიყვანს ტიპი 2-ში.

ამასთან, კვანძების რაოდენობის ზრდა, როგორც ჩანს, ხდება კონფიგურაციისა და მიგრაციის გზით "Invicta სკალირების მოწყობილობაში". ამ კონფიგურაციით, თქვენ გაქვთ რამდენიმე „სილიკონის საცავის მარშრუტი“ (SSR) და რამდენიმე აპარატის კვანძის მისამართი. მონაცემების წვდომა ხდება SSR ერთი კვანძის საშუალებით, მაგრამ ეს შეიძლება გაკეთდეს სხვა კვანძის მეშვეობით, რომელიც მუშაობს როგორც HA წყვილი. მონაცემები თავისთავად ყოველთვის არის C სერიის მხოლოდ UCS კვანძზე.ამიტომ რა ტიპის არქიტექტურაა? არ აქვს მნიშვნელობა რა გამოსავალს ჰგავს ფიზიკურად, ეს ტიპი 1. SSR არის მტევანი (შესაძლოა 2-ზე მეტი). სკალირების მოწყობილობის კონფიგურაციაში, თითოეული UCS სერვერი MLC დრაივებით ასრულებს ფუნქციას, რომელიც მსგავსია VNX ან NetApp FAS - დისკის შესანახად. მიუხედავად იმისა, რომ არ არის დაკავშირებული SAS– ს მეშვეობით, არქიტექტურა მსგავსია.

ტიპი 4. განაწილებული არქიტექტურები, რესურსების გაზიარების გარეშე. იმისდა მიუხედავად, რომ მონაცემები ნაწილდება სხვადასხვა კვანძში, ეს ხდება ყოველგვარი გარიგების გარეშე. როგორც წესი, მონაცემები ინახება ერთ კვანძზე და იქ ცხოვრობს, დროდადრო კი უსაფრთხოების ასლებისთვის ხდება სხვა კვანძებზე გაკეთება. მაგრამ ეს ასლები არ არის გარიგების. ეს არის მთავარი განსხვავება ამ ტიპის არქიტექტურასა და ტიპი 2-სა და მე -3 ტიპებს შორის.

არასამთავრობო HA კვანძებს შორის კომუნიკაცია ხდება Ethernet- ით, რადგან ის იაფი და უნივერსალურია. კვანძების გადანაწილება სავალდებულოა და დროდადრო. მონაცემთა „სისწორე“ ყოველთვის არ არის დაცული, მაგრამ პროგრამული უზრუნველყოფის დასტის შემოწმება საკმაოდ ხშირად ხდება გამოყენებული მონაცემების სისწორეზე. ზოგიერთი ტიპის დატვირთვისთვის (მაგალითად, HDFS), მონაცემები გადანაწილებულია ისე, რომ მეხსიერებაში იყოს ერთდროულად, როგორც ის პროცესი, რომლისთვისაც საჭიროა. ეს ქონება საშუალებას გვაძლევს განვიხილოთ ეს ტიპის არქიტექტურა, როგორც ყველაზე მასშტაბური, ოთხივედან.

მაგრამ ეს შორს არის ერთადერთი უპირატესობისა. ასეთი არქიტექტურები ძალიან მარტივია, მათი მართვა ძალიან ადვილია. ისინი არავითარ შემთხვევაში არ არიან დამოკიდებული აღჭურვილობაში და მათი განთავსება შესაძლებელია იაფი აპარატზე. ეს თითქმის ყოველთვის მხოლოდ პროგრამული უზრუნველყოფის გადაწყვეტილებებია. ამ ტიპის არქიტექტურა ისეთივე მარტივია, რომ გაუმკლავდეს petabytes მონაცემებს, როგორც ტერაბაიტი სხვა მონაცემებთან. აქ გამოიყენება ობიექტები და არა POSIX ფაილური სისტემები და ორივე მათგანი ხშირად მდებარეობს თითოეული ჩვეულებრივი კვანძის ადგილობრივი ფაილური სისტემის თავზე.

ეს არქიტექტურები შეიძლება შერწყმული იყოს NAS– ს საფუძველზე დაფუძნებული მონაცემების პრეზენტაციის ბლოკებთან და გარიგების მოდელებთან, მაგრამ ეს მნიშვნელოვნად ზღუდავს მათ შესაძლებლობებს. არ არის საჭირო გარიგების დასტის შექმნა, მე -4 ტიპი 2-ზე, ტიპი 1, 2 ან 3 განთავსებით.

ყველაზე უკეთესად, ეს არქიტექტურები „გამოვლენილია“ იმ ამოცანების შესახებ, რომელთა გარკვეული შეზღუდვები თავისებური არ არის.

ზემოთ, მაგალითი ძალიან დიდი კლიენტისთვის მივეცი, 200000 დისკი. სერვისები, როგორიცაა Dropbox, Syncplicity, iCloud, Facebook, eBay, YouTube და თითქმის ყველა ვებ 2.0 პროექტი ემყარება საცავებს, რომლებიც აშენებულია მეოთხე ტიპის არქიტექტურის გამოყენებით. Hadoop მტევნების ყველა დამუშავებული ინფორმაცია ასევე შეიცავს მე -4 ტიპის საცავებს. ზოგადად, კორპორატიულ სეგმენტში ეს არ არის ძალიან გავრცელებული არქიტექტურები, მაგრამ ისინი სწრაფად იძენენ პოპულარობას.

მე –4 ტიპის პროდუქტებს მოიცავს ისეთი პროდუქტები, როგორიცაა AWS S3 (სხვათა შორის, AWS- ს მიღმა არავინ იცის, როგორ მუშაობს EBS, მაგრამ მე მსურს ვიმტკიცო, რომ ეს არის ტიპი 3), Haystack (გამოიყენება Facebook- ზე), Atmos, ViPR, Ceph, Swift ( გამოიყენება Openstack), HDFS, Centera. ჩამოთვლილ ბევრ პროდუქტს შეუძლია განსხვავებული ფორმა მიიღოს, კონკრეტული განხორციელების ტიპი განისაზღვრება მათი API გამოყენებით. მაგალითად, ViPR ობიექტის დასტის განხორციელება შესაძლებელია S3, Swift, Atmos და კიდევ HDFS ობიექტის API– ების საშუალებით! და მომავალში, Centera ასევე მოხვდება ამ სიაში. ზოგისთვის ეს აშკარა იქნება, მაგრამ Atmos და Centera გამოყენებული იქნება დიდი ხნის განმავლობაში, თუმცა, API- ს ფორმაში და არა სპეციფიკური პროდუქტებისთვის. განხორციელებები შეიძლება შეიცვალოს, მაგრამ API– ები უცვლელი რჩება, რაც ძალიან კარგია მომხმარებლისთვის.

მინდა თქვენი ყურადღება კიდევ ერთხელ გავამახვილო იმ ფაქტზე, რომ ”ფიზიკური განსახიერება” შეიძლება დამაბნეველი იყოს და თქვენ შეცდომით დაასახელებთ მე -4 ტიპის არქიტექტურებს, როგორც ტიპ 2, რადგან ისინი ხშირად ერთნაირად გამოიყურება. ფიზიკურ დონეზე, გამოსავალი შეიძლება გამოიყურებოდეს ScaleIO, VSAN ან Nutanix, თუმცა ეს მხოლოდ Ethernet სერვერები იქნება. და გარიგების არსებობა ან არარსებობა ხელს შეუწყობს კონკრეტული გადაწყვეტილების სწორად კლასიფიკაციას.

ახლა კი გთავაზობთ მეორე ვერიფიკაციის ტესტს. მოდით შევხედოთ UCS Invicta- ს არქიტექტურას. ფიზიკურად, ამ პროდუქტს ჰგავს ტიპი 4 (სერვერები, რომლებიც დაკავშირებულია Ethernet– ს მეშვეობით), მაგრამ შეუძლებელია მისი არქიტექტურული მასშტაბის დატვირთვა შესაბამის დატვირთვებზე, რადგან ის სინამდვილეში ტიპი 1. უფრო მეტიც, Invicta, ისევე როგორც Pure, შეიქმნა AFA– სთვის.

გთხოვთ, მიიღოთ ჩემი გულწრფელი მადლობა თქვენი დროისა და ყურადღებისთვის, თუ ამ ადგილზე წაიკითხავთ. მე კიდევ ერთხელ წავიკითხე ზემოაღნიშნული - გასაოცარი ის არის, რომ მე შევძელი დაქორწინება და შვილები

რატომ დავწერე ეს ყველაფერი?

IT შენახვის სამყაროში ისინი ძალიან მნიშვნელოვან ადგილს იკავებენ, ერთგვარი "სოკოების სამეფო". შემოთავაზებული პროდუქციის მრავალფეროვნება ძალიან დიდია და ეს მხოლოდ სარგებელს მოაქვს მთელ ბიზნესში. მაგრამ თქვენ უნდა გქონდეთ ამ ყველაფრის გააზრება, ნუ დაუშვებთ საკუთარ თავს თქვენი გონების დაბნელება მარკეტინგული ლოზუნგებით და პოზიციონირების ნიუანსებით. როგორც მომხმარებლებისთვის, ისე თავად ინდუსტრიის სარგებლისთვის, აუცილებელია გამარტივდეს შენობის შენახვის პროცესი. ამიტომ, ჩვენ ვმუშაობთ იმისათვის, რომ ViPR კონტროლერი გავხსნათ უფასო, უფასო პლატფორმა.

მაგრამ საცავი თავისთავად ძნელად საინტერესოა. რას ვგულისხმობ? წარმოიდგინეთ ერთგვარი აბსტრაქტული პირამიდა, რომლის თავზე არის "მომხმარებელი". ქვემოთ მოცემულია "პროგრამები", რომლებიც შექმნილია "მომხმარებლის" მომსახურებისთვის. კიდევ უფრო დაბალია "ინფრასტრუქტურა" (SDDC ჩათვლით), რომელიც ემსახურება "პროგრამებს" და, შესაბამისად, "მომხმარებელს". და "ინფრასტრუქტურის" ბოლოში არის საცავი.

ანუ, თქვენ იერარქიის წარმოდგენა შეგიძლიათ ამ ფორმით: მომხმარებელი - პროგრამა / SaaS-\u003e PaaS-\u003e IaaS-\u003e ინფრასტრუქტურა. ასე რომ, საბოლოო ჯამში, ნებისმიერი პროგრამა, ნებისმიერი PaaS დასტის უნდა გამოთვალოს ან დაამუშავოს რაიმე სახის ინფორმაცია. და ამ ოთხი ტიპის არქიტექტურა შექმნილია სხვადასხვა ტიპის ინფორმაციასთან, სხვადასხვა ტიპის დატვირთვასთან მუშაობისთვის. მნიშვნელობის იერარქიაში, ინფორმაცია დაუყოვნებლივ მიჰყვება მომხმარებელს. აპლიკაციის არსებობის მიზანია მომხმარებელს შეუთავსოს მისთვის საჭირო ინფორმაცია. სწორედ ამიტომ არის შენახვა არქიტექტურა ჩვენს სამყაროში.

ამ ჩანაწერში იყო გამოქვეყნებული Uncategorized მიერ ავტორი. მონიშნე ის.და სხვა საკითხებს, მონაცემთა გადაცემის საშუალო და მასზე დაკავშირებულ სერვერებს. მას ჩვეულებრივ იყენებენ საკმარისად დიდი კომპანიები, რომლებსაც აქვთ კარგად განვითარებული IT ინფრასტრუქტურა მონაცემთა საიმედო შენახვისა და მათზე სწრაფი სიჩქარის შესაქმნელად.

გამარტივებული შენახვა არის სისტემა, რომლის საშუალებითაც სერვერებს შეუძლიათ განაწილონ ცვლადი სიმძლავრის საიმედო სწრაფი დისკი სხვადასხვა საცავი მოწყობილობიდან.

ცოტა თეორია.

სერვერს შეიძლება დაუკავშირდეს მონაცემთა საწყობი რამდენიმე გზით.

პირველი და უმარტივესი არის DAS, Direct Attached Storage (პირდაპირი კავშირი), ჩვენ დისკის სერვერებს ვათავსებთ სერვერზე, ან მასივს ვიღებთ სერვერის ადაპტერში და ვიღებთ უამრავ გიგაბაიტიანი დისკის სივრცეს შედარებით სწრაფი წვდომით, ხოლო RAID მასივის გამოყენებისას, გვაქვს საკმარისი საიმედოობა, თუმცა საიმედოობის საკითხზე შუბები დიდი ხნის განმავლობაში ირღვევა.

თუმცა, დისკის სივრცის ეს გამოყენება არ არის ოპტიმალური - ერთ სერვერზე სივრცე ამოიწურება, მეორეზე კი ეს კიდევ ბევრია. ამ პრობლემის მოგვარება არის NAS, Network Attached Storage (ქსელთან მიერთებული საცავი). ამასთან, ამ გადაწყვეტილების ყველა უპირატესობით - მოქნილობა და ცენტრალიზებული მართვა - არსებობს ერთი მნიშვნელოვანი ნაკლი - დაშვების სიჩქარე, 10 გიგაბიტის ქსელი ჯერ არ განხორციელებულა ყველა ორგანიზაციაში. და ჩვენ მივადექით შენახვის ქსელს.

SAN- სა და NAS- ს შორის მთავარი განსხვავებაა (დამატებით ასოების ბრძანებების გარდა) არის ის, თუ როგორ ხდება სერვერზე ნაჩვენები დაკავშირებული რესურსები. თუ NAS რესურსები უკავშირდება NFS ან SMB პროტოკოლებს, SAN- ში ვიღებთ დისკის კავშირს, რომელთანაც შეგვიძლია ვიმუშაოთ ბლოკის I / O ოპერაციების დონეზე, რაც ქსელურ კავშირზე გაცილებით სწრაფია (პლუს მასივი კონტროლერი, რომელსაც დიდი ქეში აქვს, ბევრ ოპერაციას უმატებს სიჩქარეს).

SAN– ის გამოყენებით ჩვენ ვაერთიანებთ DAS– ს უპირატესობას - სიჩქარესა და სიმარტივეს, ხოლო NAS– ს - მოქნილობა და კონტროლირებადი შესაძლებლობები. გარდა ამისა, ჩვენ შეგვიძლია შევინახოთ შესანახი საცავი სისტემები მანამ, სანამ არ იქნება საკმარისი თანხა, ამასთან ერთდროულად კიდევ ერთი ფრინველის მკვლელობას ერთი ქვის საშუალებით, რაც დაუყოვნებლივ არ ჩანს:

* ამოიღეთ შეზღუდვები SCSI მოწყობილობების კავშირის დიაპაზონში, რომლებიც, როგორც წესი, შემოიფარგლება 12 მეტრით მავთულზე,

* შეამცირეთ სარეზერვო დრო,

* ჩვენ შეგვიძლია ჩატვირთვა SAN– დან,

* NAS– სგან უარის თქმის შემთხვევაში, ჩვენ გადმოტვირთეთ ქსელი,

* ჩვენ ვიღებთ შესასვლელი და გამოშვების მაღალ სიჩქარეს შესანახი სისტემის ოპტიმიზაციის გამო,

* ჩვენ ვიღებთ შესაძლებლობას რამდენიმე სერვერზე დავუკავშიროთ ერთ რესურსს, ეს გვაძლევს შემდეგ ორ ფრინველს ერთი ქვით:

- ჩვენ სრულად ვიყენებთ VMWare- ს შესაძლებლობებს - მაგალითად VMotion (ვირტუალურ მანქანაში მიგრაცია ფიზიკურ აპარატებს შორის) და მათ მსგავს სხვა ადამიანებს,

- ჩვენ შეგვიძლია ავაშენოთ შეცდომების შემწყნარებელი მტევანი და მოვაწყოთ გეოგრაფიულად განაწილებული ქსელები.

რას იძლევა ეს?

შენახვის სისტემის ოპტიმიზაციის ბიუჯეტის გამოყენების გარდა, ჩვენ ვიღებთ დამატებით იმას, რაც ზემოთ დავწერე:

* პროდუქტიულობის გაზრდა, დატვირთვის დაბალანსება და შენახვის სისტემების მაღალი ხელმისაწვდომობა მასივებზე წვდომის რამდენიმე გზით;

* დაზოგავს დისკზე ინფორმაციის ადგილმდებარეობის ოპტიმიზაციით;

* დაჩქარებული აღდგენა წარუმატებლობისგან - შეგიძლიათ შექმნათ დროებითი რესურსები, განათავსოთ მათ სარეზერვო სისტემა და დაუკავშიროთ სერვერები მათთან და დააჩქაროთ ინფორმაცია საკუთარი თავის დაჩქარების გარეშე, ან რესურსების გადაცემა სხვა სერვერებზე და მშვიდად გაუმკლავდეთ მკვდარ რკინას;

* შემცირებული სარეზერვო დრო - დიდი გადაცემის სიჩქარის წყალობით, შეგიძლიათ სწრაფად დააბრუნოთ ფირზე ბიბლიოთეკა, ან თუნდაც ფაილური სისტემადან გადაიღოთ ფოტო (სურათი) და უსაფრთხოდ დაარქივოთ იგი;

* მოთხოვნილ დისკზე - როდესაც ეს გვჭირდება - მონაცემთა შენახვის სისტემაში ყოველთვის შეგიძლიათ დაამატოთ რამდენიმე თარო.

* შეამცირეთ მეგაბაიტი ინფორმაციის შენახვის ღირებულება - რა თქმა უნდა, არსებობს გარკვეული ბარიერი, საიდანაც ეს სისტემები ეფექტურია.

* საიმედო ადგილია მისიის კრიტიკულ და საქმიანი კრიტიკული მონაცემების შესანახად (რომელთა გარეშე ორგანიზაცია ვერ იარსებებს და ნორმალურად ფუნქციონირებს).

* ცალკე მინდა აღვნიშნო VMWare - ყველა ჩიპი, როგორიცაა ვირტუალური აპარატების მიგრაცია სერვერზე სერვერზე და სხვა სიკეთეებზე, მხოლოდ SAN- ზეა შესაძლებელი.

რისგან შედგება?

როგორც ზემოთ დავწერე, შენახვა მოიცავს საცავის მოწყობილობებს, გადამცემ მედიას და დაკავშირებულ სერვერებს. მოდით განვიხილოთ წესრიგი:

მონაცემთა შენახვის სისტემები როგორც წესი, შედგება მყარი დისკები და კონტროლერები, თვითპატივისცემის სისტემაში, როგორც წესი, მხოლოდ 2 - 2 კონტროლერი, 2 ბილიკი თითოეულ წამყვანზე, 2 ინტერფეისი, 2 კვების წყარო, 2 ადმინისტრატორი. ყველაზე პატივსაცემი სისტემის მწარმოებლებიდან აღსანიშნავია HP, IBM, EMC და Hitachi. აქ მე ციტატა EMC– ს ერთი წარმომადგენლის სემინარზე - ”HP– ს ქმნის შესანიშნავი პრინტერები. დაე, გააკეთოს ისინი! ” მეეჭვება რომ HP- ს ასევე უყვარს EMC. მწარმოებლები შორის კონკურენცია სერიოზულია, როგორც სხვაგან. კონკურენციის შედეგები ზოგჯერ ფასიანი ფასებია თითო მეგაბაიტი შენახვის სისტემაში და პრობლემები კონკურენტის სტანდარტებთან თავსებადობასთან და მხარდაჭერასთან, განსაკუთრებით ძველი აღჭურვილობისთვის.

მონაცემთა გადაცემის საშუალო.

როგორც წესი, SAN– ები აგებულია ოპტიკაზე, რომელიც ამჟამად იძლევა სიჩქარეს 4, ზოგჯერ 8 გიგაბიტს არხზე. მშენებლობის დროს, ადრე სპეციალიზირებული ჰაბები იყო გამოყენებული, ახლა უფრო მეტი კონცენტრატორები აქვთ, ძირითადად Qlogic, Brocade, McData და Cisco (საიტებზე ბოლო ორი არ მინახავს). კაბელები გამოიყენება ტრადიციული ოპტიკური ქსელებისთვის - ერთჯერადი და მრავალ რეჟიმიანი, ერთჯერადი ხანგრძლივობით.

შიგნით, FCP გამოიყენება - ბოჭკოვანი არხის პროტოკოლი, სატრანსპორტო პროტოკოლი. როგორც წესი, მასში კლასიკური SCSI გადის, ხოლო FCP უზრუნველყოფს მისამართით და მიწოდებით. არსებობს ვარიანტი, რომელსაც აქვს კავშირი რეგულარული ქსელისა და iSCSI– ს საშუალებით, მაგრამ ის ჩვეულებრივ იყენებს ადგილობრივ, და არა სპეციალურ ქსელს მონაცემთა გადაცემისთვის და მოითხოვს ადაპტერებს iSCSI– ს მხარდაჭერით, ასევე, სიჩქარე უფრო ნელია ვიდრე ოპტიკაში.

ასევე არსებობს ჭკვიანი სიტყვა ტოპოლოგია, რომელიც SAN- ის ყველა სახელმძღვანელოში გვხვდება. არსებობს რამდენიმე ტოპოლოგია, უმარტივესი ვარიანტია წერტილის აღნიშვნა, ჩვენ ვუკავშირდებით 2 სისტემას. ეს არ არის DAS, მაგრამ ვაკუუმში სფერული ცხენი SAN- ის ყველაზე მარტივი ვარიანტია. შემდეგ მოდის კონტროლირებადი მარყუჟი (FC-AL), იგი მუშაობს პრინციპით "გადადის" - თითოეული მოწყობილობის გადამცემი უკავშირდება შემდგომი რესივერით, მოწყობილობები დახურულია რგოლში. გრძელი ჯაჭვები დიდი ხნის განმავლობაში ინიცირებას ახდენენ.

კარგად, საბოლოო ვარიანტი - შეცვლილი სტრუქტურა (ნაჭერი), ის იქმნება კომუტატორების გამოყენებით. კავშირების სტრუქტურა აშენებულია დაკავშირებული დაკავშირებული პორტების მიხედვით, ისევე როგორც ადგილობრივი ქსელის მშენებლობაში. მშენებლობის ძირითადი პრინციპი არის ის, რომ ყველა ბილიკი და კავშირი დუბლირებულია. ეს ნიშნავს, რომ ქსელში თითოეული მოწყობილობისთვის მინიმუმ 2 განსხვავებული გზაა. აქ ასევე გამოიყენება სიტყვა ტოპოლოგია, მოწყობილობის კავშირის დიაგრამის ორგანიზებისა და კომუტატორების დასაკავშირებლად. ამ შემთხვევაში, როგორც წესი, გადართვის კონფიგურაცია ხდება ისე, რომ სერვერები ვერ ხედავენ არაფერს, ვიდრე მათთვის განკუთვნილი რესურსები. ეს მიიღწევა ვირტუალური ქსელების შექმნით და ეწოდება ზონირებას, უახლოესი ანალოგია VLAN. ქსელში არსებულ თითოეულ მოწყობილობას ენიჭება ანალოგური MAC მისამართი Ethernet ქსელზე, მას უწოდებენ WWN - მსოფლიო ქსელის სახელი. იგი ენიჭება შენახვის სისტემების თითოეულ ინტერფეისს და თითოეულ რესურსს (LUN). მასივსა და კონცენტრატორებს შეუძლიათ განასხვავონ სერვერებისთვის WWN წვდომა.

სერვერი დაკავშირება შესანახად HBA - მასპინძელი ავტობუსის ადაპტერებით. ქსელური ბარათების ანალოგიით, არსებობს ერთი, ორი და ოთხსპორტული გადამყვანები. საუკეთესო "ძაღლების სელექციონერები" გირჩევთ დააინსტალიროთ 2 ადაპტერი თითოეულ სერვერზე, ეს საშუალებას აძლევს დატვირთვის დაბალანსებას და საიმედოობას.

შემდეგ კი რესურსები იშლება შენახვის სისტემებში, ისინი არიან დისკები (LUNs) თითოეული სერვერისთვის და ადგილი დარჩა რეზერვში, ყველაფერი ჩართულია, სისტემის ინსტალატორები განსაზღვრავენ ტოპოლოგიას, სრიალებს დაჭერა კომუტატორებში და წვდომას, ყველაფერი იწყება და ყველა ადამიანი ბედნიერად ცხოვრობს მას შემდეგ.

მე კონკრეტულად არ ვუკავშირდები ოპტიკურ ქსელში არსებულ სხვადასხვა ტიპის პორტებს, ვისაც ეს სჭირდება - მან უკვე იცის ან წაიკითხა, ვის არ სჭირდება ეს - უბრალოდ თავში ჩაქუჩი. მაგრამ, როგორც ყოველთვის, თუ პორტის ტიპი არასწორედ არის მითითებული, არაფერი იმუშავებს.

გამოცდილებიდან.

ჩვეულებრივ, SAN– ს შექმნისას შეუკვეთეთ მასივები რამდენიმე ტიპის დისკით: FC– ით სწრაფი სიჩქარით პროგრამებისთვის, და SATA ან SAS– ს არც ისე სწრაფად. ამრიგად, მიიღება 2 დისკის ჯგუფი სხვადასხვა მეგაბაიტი ღირებულებით - ძვირი და სწრაფი და ნელი და სამწუხარო იაფი. ჩვეულებრივ, ყველა მონაცემთა ბაზა და სხვა პროგრამები, რომელზეც აქტიური და სწრაფი I / O აქტიურადაა დაკიდებული, სწრაფად დევს, ხოლო ფაილური რესურსები და ყველაფერი დანარჩენი ნელ – ნელა ეკიდება.

თუ SAN იქმნება ნულიდან, აზრი აქვს მის აშენებას ერთი მწარმოებლის გადაწყვეტილებების საფუძველზე. ფაქტია, რომ სტანდარტებთან მიმართებით, დეკლარაციის მიუხედავად, არსებობს წყალქვეშა ტალღები მოწყობილობების თავსებადობის პრობლემა და არა ის ფაქტი, რომ აღჭურვილობის ნაწილი ერთმანეთთან იმუშავებს ტამბურასთან ცეკვის გარეშე და მწარმოებლებთან კონსულტაციების გარეშე. ჩვეულებრივ, ამგვარი პრობლემების გადასაჭრელად, უფრო ადვილია ინტეგრატორის დარეკვა და მისთვის ფულის მიცემა, ვიდრე ერთმანეთთან ისრების გადასვლის მწარმოებლებთან.

თუ SAN შექმნილია არსებული ინფრასტრუქტურის საფუძველზე, ყველაფერი შეიძლება გართულდეს, განსაკუთრებით იმ შემთხვევაში, თუ არსებობს ძველი SCSI მასივები და ძველი აღჭურვილობის ზოოპარკი სხვადასხვა მწარმოებლისგან. ამ შემთხვევაში, აზრი აქვს დახმარების გამოძახებას ინტეგრატორის საშინელი მხეცისგან, რომელიც პრობლემების გადასაჭრელად და მესამე ვილა გახდება კანარის კუნძულებზე.

ხშირად, შენახვის სისტემების შექმნისას, ფირმები არ ბრძანებენ მწარმოებლის სისტემას. ეს ჩვეულებრივ გამართლებულია იმ შემთხვევაში, თუ კომპანიას ჰყავს კომპეტენტური კომპეტენტური ადმინისტრაციების თანამშრომლები (რომლებმაც უკვე 100-ჯერ დამირეკეს ქვაბი) და კაპიტალის საკმაოდ თანხა, რაც შესაძლებელს გახდის სათადარიგო ნაწილების შეძენა საჭირო რაოდენობით. თუმცა, კომპეტენტური ადმინისტრატორები, როგორც წესი, ინტეგრირებულნი არიან ინტეგრატორებით (მე თვითონ ვნახე ეს), მაგრამ ისინი თანხას არ გამოყოფენ შესყიდვისთვის და ჩავარდნების შემდეგ ცირკი იწყება და წამოიძახებს: "მე ყველას გავაფრენ! მხარდაჭერის დარეკვისა და ინჟინრის სათადარიგო ნაწილის ჩამოსვლის ნაცვლად.

ჩვეულებრივ, მხარდაჭერა ჩნდება მკვდარი დისკებისა და კონტროლერების შეცვლისა და დისკის თაროების და ახალი სერვერების სისტემის დამატებით. ბევრი უბედურება ხდება ადგილობრივი სპეციალისტების მიერ სისტემის უეცარი პროფილაქტიკის შემდეგ, განსაკუთრებით სისტემის სრული გამორთვისა და დაშლა-აწყობის შემდეგ (და ეს ხდება).

VMWare- ს შესახებ. რამდენადაც მე ვიცი (ვირტუალიზაციის სპეციალისტები მე ასწორებენ), მხოლოდ VMWare და Hyper-V აქვთ ფუნქციონალური ფუნქცია, რაც საშუალებას გაძლევთ ვირტუალური აპარატების გადატანა ფრენის დროს ფიზიკურ სერვერებს შორის. და მისი განხორციელებისთვის, აუცილებელია, რომ ყველა სერვერს შორის, რომელზეც ვირტუალური მანქანა მოძრაობს, დაკავშირებულია იმავე დისკზე.

მტევნების შესახებ. VMWare- ს მსგავსი შემთხვევის მსგავსად, ჩემთვის ცნობილი სისტემების მშენებლობის არასასურველი მტევანი სისტემები (Sun Cluster, Veritas Cluster Server) მოითხოვს შენახვას, რომელიც დაკავშირებულია ყველა სისტემასთან.

სტატიის დაწერისას - მათ მკითხეს - რა RAID- ებს იყენებენ დისკები ჩვეულებრივ?

ჩემს პრაქტიკაში, ისინი ჩვეულებრივ აკეთებდნენ RAID 1 + 0- ს თითოეულ დისკის შელფზე FC დისკებით, ტოვებდნენ 1 სათამაშო დისკს (Hot Spare) და ამ ნაწილისგან LUN– ებს წყვეტდნენ ამოცანებისთვის, ან RAID5 აკეთებდნენ ნელი დისკიდან, ისევ ტოვებდნენ 1 დისკს ჩანაცვლებისთვის. მაგრამ აქ საკითხი რთულია, და, როგორც წესი, მასივში დისკების ორგანიზების გზა შერჩეულია თითოეული სიტუაციისთვის და გამართლებულია. მაგალითად, იგივე EMC კიდევ უფრო შორს მიდის, მათ აქვთ დამატებითი მასივის პარამეტრები პროგრამებისთვის, რომლებიც მასზე მუშაობენ (მაგალითად, OLTP, OLAP– ის ქვეშ). მე ასე ღრმად არ ჩამიქსებია სხვა მოვაჭრეებთან, მაგრამ ვხვდები, რომ ყველას აქვს მოწესრიგებული.

* პირველ დიდ წარუმატებლობამდე, რის შემდეგაც მხარდაჭერა ჩვეულებრივ ხდება სისტემის მწარმოებლის ან მიმწოდებლისგან.

DAS, SAN, NAS - ჯადოსნური აბრევიატურა, რომლის გარეშეც ვერც ერთი სტატია ან შესანახი სისტემების ანალიტიკური შესწავლა არ შეიძლება. ისინი ემსახურებიან შენახვის სისტემებსა და გამოთვლილ სისტემებს შორის კავშირის ძირითადი ტიპების აღნიშვნას.

დასი (პირდაპირ თანდართული საცავი) - გარე მეხსიერების მოწყობილობა, რომელიც უშუალოდ უკავშირდება მთავარ კომპიუტერს და გამოიყენება მხოლოდ მის მიერ. DAS- ის უმარტივესი მაგალითია ინტეგრირებული მყარი დისკი. მასპინძელთან გარე მეხსიერებასთან ტიპიური DAS კონფიგურაციის დასაკავშირებლად, გამოიყენება SCSI, რომლის ბრძანებები საშუალებას გაძლევთ აირჩიოთ კონკრეტული მონაცემთა ბლოკი მითითებულ დისკზე, ან ჩაწეროთ კონკრეტული კარტრიჯი ფირის ბიბლიოთეკაში.

DAS კონფიგურაცია მისაღებია შენახვის, შესაძლებლობების და საიმედოობის მოთხოვნებისთვის. DAS არ ითვალისწინებს სხვადასხვა მასპინძლებს შორის შენახვისუნარიანობის გაზიარების შესაძლებლობას, და კიდევ უფრო ნაკლები მონაცემების გაზიარების შესაძლებლობას. ასეთი საცავის მოწყობილობების დაყენება უფრო იაფი ვარიანტია, ვიდრე ქსელის კონფიგურაცია, თუმცა, დიდი ორგანიზაციების გათვალისწინებით, ამ ტიპის შესანახი ინფრასტრუქტურა არ შეიძლება ჩაითვალოს ოპტიმალურად. მრავალი DAS კავშირი ნიშნავს გარე მეხსიერების კუნძულებს, რომლებიც მიმოფანტულია და მიმოფანტულია კომპანიის მასშტაბით, რომელთა უმეტესობა არ შეიძლება გამოყენებულ იქნას სხვა მასპინძელ კომპიუტერებთან, რაც ზოგადად იწვევს შენახვისუნარიანობის არაეფექტურ დაკარგვას.

გარდა ამისა, ასეთ საცავ ორგანიზაციასთან ერთად, არ არსებობს გზა, რომ შეიქმნას გარეგანი მეხსიერების მართვის ერთი პუნქტი, რაც გარდაუვალად ართულებს მონაცემების სარეზერვო / აღდგენის პროცესებს და ქმნის სერიოზული ინფორმაციის დაცვის პრობლემას. შედეგად, ასეთი შენახვის სისტემის საკუთრების მთლიანი ღირებულება შეიძლება მნიშვნელოვნად მაღალი იყოს, ვიდრე ერთი შეხედვით უფრო რთული, და თავდაპირველად უფრო ძვირი ქსელის კონფიგურაცია.

სან

დღეს, საწარმოს დონეზე შენახვის სისტემის შესახებ, ვგულისხმობთ ქსელის შენახვას. ფართო საზოგადოებისთვის უკეთ ცნობილია საცავის ქსელი - SAN (საცავის ქსელის ქსელი). SAN არის შენახვის მოწყობილობების სპეციალური ქსელი, რომლის საშუალებითაც მრავალ სერვერს შეუძლია გამოიყენოს გარე მეხსიერების მთლიანი რესურსი ადგილობრივ ქსელში დატვირთვის გარეშე.

SAN დამოუკიდებელია გადამცემი საშუალებისგან, მაგრამ ამ ეტაპზე ფაქტობრივი სტანდარტია Fiber Channel (FC) ტექნოლოგია, რომელიც უზრუნველყოფს მონაცემთა გადაცემის სიჩქარეს 1-2 გბ / წმ. განსხვავებით, ტრადიციული SCSI დაფუძნებული გადამცემი საშუალებებით, რომლებიც უზრუნველყოფენ არაუმეტეს 25 მეტრს, Fiber Channel საშუალებას გაძლევთ იმუშაოთ 100 კილომეტრამდე მანძილზე. ბოჭკოვანი არხის ქსელის მედია შეიძლება იყოს სპილენძი ან ბოჭკოვანი.

მონაცემთა სარეზერვო მასივები, მარტივი დისკის მასივები, (ე.წ. უბრალოდ დისკების რამოდენიმე ვარიანტი - JBOD), ფირზე ან მაგნიტო-ოპტიკური ბიბლიოთეკა მონაცემთა სარეზერვო და არქივირებისთვის შეიძლება დაკავშირებულ იქნას შენახვის ქსელში. სან-ქსელის ორგანიზების ძირითადი კომპონენტები, გარდა შენახვის მოწყობილობებისა, თავად არის ადაპტერები სერვერების დასაკავშირებლად Fiber Channel ქსელთან (მასპინძლის ავტობუსის ადაპტერი - NVA), ქსელის მოწყობილობები ერთი ან სხვა FC ქსელის ტოპოლოგიის მხარდასაჭერად და სპეციალური პროგრამული უზრუნველყოფის ხელსაწყოები საცავის ქსელის მართვისთვის. ამ პროგრამულ სისტემებს შეუძლიათ როგორც ზოგადი დანიშნულების სერვერზე, ისე თვითონ შენახვის მოწყობილობებზე გაშვება, თუმცა ზოგჯერ ზოგიერთი ფუნქცია სპეციალურ წვრილ სერვერზე გადადის საცავის ქსელის მართვისთვის (SAN აპარატურა).

SAN პროგრამული უზრუნველყოფის მიზანია, უპირველეს ყოვლისა, ცენტრალური მართოთ საცავის ქსელი, მათ შორის ქსელის კომპონენტების კონფიგურაცია, მონიტორინგი, კონტროლი და ანალიზი. ერთ-ერთი ყველაზე მნიშვნელოვანია დისკის მასივებზე წვდომის კონტროლის ფუნქცია, თუ ჰეტეროგენული სერვერები ინახება SAN- ში. საცავის ქსელები მრავალ სერვერს საშუალებას აძლევს ერთდროულად შეუშვან მრავალ დისკის ქვესისტემას, თითოეული მასპინძლის რუქას ახდენენ კონკრეტულ დისკებზე კონკრეტულ დისკზე. სხვადასხვა ოპერაციული სისტემისთვის, საჭიროა დისკის მასივის სტრატიფიკაცია "ლოგიკურ ერთეულებად" (ლოგიკური ერთეული - LUNs), რომელსაც ისინი გამოიყენებენ კონფლიქტების გარეშე. ლოგიკური ტერიტორიების გამოყოფა შეიძლება დაგჭირდეთ იმავე მონაცემებზე წვდომის ორგანიზებისთვის სერვერების გარკვეული აუზებისთვის, მაგალითად, იგივე სამუშაო ჯგუფის სერვერებისთვის. სპეციალური პროგრამულ მოდულებს ევალებათ ყველა ამ ოპერაციის მხარდაჭერა.

შენახვის ქსელების მიმზიდველობა აიხსნება იმ უპირატესობებით, რომელთა საშუალებითაც მათ შეუძლიათ ორგანიზაციებს მონაცემების დიდი მოცულობის მუშაობის ეფექტურობის მოთხოვნით. გამოყოფილი საცავის ქსელი ატვირთავს გამოთვლითი სერვერების და კლიენტის სამუშაო სადგურების მთავარ (ადგილობრივ ან გლობალურ) ქსელს, ათავისუფლებს მას მონაცემთა შეყვანის / გამომავალი ნაკადებისგან.

ეს ფაქტორი, ისევე როგორც მაღალსიჩქარიანი გადამცემი საშუალება, რომელიც გამოიყენება SAN– სთვის, უზრუნველყოფს მონაცემთა გაცვლის პროცესების გაზრდის პროდუქტიულობას გარე შენახვის სისტემებთან. SAN გულისხმობს შენახვის სისტემების კონსოლიდაციას, სხვადასხვა მედიაზე ერთი რესურსის აუზის შექმნას, რომელსაც ექნება მთელი კომპიუტერული ძალა და, შედეგად, მეხსიერების საჭირო სიმძლავრე შეიძლება ნაკლები ქვესისტემით იყოს უზრუნველყოფილი. SAN- ში, დისკის ქვესისტემებიდან და ფირზე მონაცემების სარეზერვო ადგილი ხდება ადგილობრივი ქსელის მიღმა და, შესაბამისად, უფრო ეფექტური ხდება - ერთი ფირის ბიბლიოთეკა შეიძლება გამოყენებულ იქნას დისკის რამდენიმე ქვესისტემის მონაცემების სარეზერვო ასლებისთვის. გარდა ამისა, შესაბამისი პროგრამული უზრუნველყოფის მხარდაჭერით, შესაძლებელია SAN- ში პირდაპირი სარეზერვო სისტემის განხორციელება, სერვერის მონაწილეობის გარეშე, ამით გადმოტვირთვის პროცესორი. სერვერების და მეხსიერების განლაგების შესაძლებლობა დიდი დისტანციებით, აკმაყოფილებს საწარმოს მონაცემთა საწყობების საიმედოობის გაუმჯობესების საჭიროებებს. მონაცემთა კონსოლიდირებული შენახვა SAN მასშტაბებში უკეთესია, რადგან ეს საშუალებას გაძლევთ გაზარდოთ შენახვის მოცულობა სერვერებისგან დამოუკიდებლად და მათი მუშაობის შეფერხების გარეშე. დაბოლოს, SAN საშუალებას აძლევს გარე მეხსიერების ერთი აუზის ცენტრალიზებულ მართვას, რაც ამარტივებს ადმინისტრირებას.

რა თქმა უნდა, შენახვის ქსელები ძვირი და რთული გამოსავალია და იმისდა მიუხედავად, რომ დღეს ყველა წამყვანი მომწოდებელი აწარმოებს ბოჭკოვანი არხზე დაფუძნებულ SAN მოწყობილობებს, მათი თავსებადობა არ არის გარანტირებული და სწორი აღჭურვილობის არჩევა მომხმარებლებისთვის პრობლემას უქმნის. დამატებითი ქსელის შექმნისა და შეძენის მენეჯმენტის პროგრამული უზრუნველყოფისთვის დამატებითი ხარჯები დაგჭირდებათ, ხოლო SAN– ს საწყისი ღირებულება უფრო მაღალი იქნება, ვიდრე DAS– ის გამოყენებით შენახვის ორგანიზაცია, მაგრამ საკუთრების საერთო ღირებულება უნდა იყოს უფრო დაბალი.

ნას

SAN- ისგან განსხვავებით, NAS (ქსელთან მიმაგრებული საცავი) არ არის ქსელი, არამედ ქსელის შესანახი მოწყობილობა, უფრო სწორედ, მასში შემავალი დისკის ქვესისტემით გამოყოფილი ფაილური სერვერი. ზოგჯერ ოპტიკური ან ფირის ბიბლიოთეკა შეიძლება შედიოდეს NAS– ს კონფიგურაციაში. NAS მოწყობილობა (NAS მოწყობილობა) პირდაპირ კავშირშია ქსელთან და მასპინძელებს აძლევს მის ინტეგრირებულ გარე მეხსიერების ქვესისტემაზე ფაილებს. გამოყოფილი ფაილების სერვერების გაჩენა დაკავშირებულია Sun Microsystems- ის მიერ 90-იანი წლების დასაწყისში NFS ქსელური ფაილური სისტემის შემუშავებასთან, რაც საშუალებას აძლევდა კლიენტ კომპიუტერებს ადგილობრივ ქსელში გამოიყენონ ფაილები დისტანციურ სერვერზე. შემდეგ Microsoft– მა წამოიწია მსგავსი სისტემა Windows გარემოსთვის - საერთო ინტერნეტ ფაილური სისტემა. NAS- ის კონფიგურაციები მხარს უჭერს როგორც ამ სისტემას, ასევე IP- ზე დაფუძნებულ სხვა პროტოკოლებს, რომლებიც უზრუნველყოფენ ფაილების გაზიარებას კლიენტის პროგრამებისთვის.